KDD 2025论文分享|一种用于城市动态预测的多任务时空大模型框架UrbanMind

本推文介绍了一个新颖的时空LLM框架UrbanMind。针对城市动态预测中多方面数据融合和分布偏移的关键问题,通过Muffin-MAE、语义感知的提示策略和测试时自适应机制,实现了对交通指标的精准预测。实验证明,该框架在零样本和标准预测场景下准确性和泛化能力提升明显,为复杂的城市时空数据挖掘提供了强大的解决方案。

本推文介绍的是KDD 2025收录的一篇论文《UrbanMind: Urban Dynamics Prediction with Multifaceted Spatial-Temporal Large Language Models》。理解和预测城市动态对于管理交通系统、优化城市规划和加强公共服务至关重要。尽管基于神经网络的方法已取得成功,但它们常依赖特定任务的架构和大量数据,限制了其泛化能力。同时,大语言模型(Large Language Model,简称LLM)提供了强大的推理和泛化能力,但其在时空城市动态中的应用仍未得到充分探索。现有的基于LLM的方法难以有效整合多方面时空数据,也未能解决训练和测试数据之间的分布偏移问题,限制了其在实际应用中的可靠性。为弥合这一差距,论文提出了UrbanMind,一个新颖的时空LLM框架,用于多方面城市动态预测,确保了预测的准确性和泛化鲁棒性。其核心是使用一种具有专门掩码策略的多方面融合掩码自动编码器Muffin-MAE,用于捕捉复杂的时空依赖关系和多方面城市动态间的相互关联。此外,论文设计了一种语义感知的提示与微调策略,以及一个带测试数据重构器的测试时自适应机制,使模型能动态适应未见过的数据。通过在多个城市的真实世界数据集上进行大量实验,结果显示UrbanMind在零样本与标准预测中均优于最先进的基线,体现了模型的准确性与泛化能力。

推文作者为韩煦,审校为邓镝。

论文链接:https://dl.acm.org/doi/10.1145/3711896.3737177

代码链接:https://doi.org/10.5281/zenodo.15484938

一、研究背景

城市动态预测,涉及使用历史时空数据预测人类流动模式,如交通速度和出行需求,对于优化交通管理、加强城市规划和改善公共服务具有重大潜力。

神经网络方法的局限性:近年来,多种深度神经网络方法被开发出来。基于图神经网络在建模时空依赖方面表现出色。包括GAN和扩散模型在内的生成模型因其建模复杂城市数据分布的能力而受到关注。元学习和迁移学习方法也因其灵活性和适应性被探索。尽管取得了这些进展,现有方法仍严重依赖特定任务的架构和大量数据,这限制了它们在不同城市环境中有效泛化或适应不断变化的条件的能力。

大语言模型方法的局限性:考虑到大语言模型(LLM)出色的泛化能力,研究转向了LLM。LLM以其卓越的推理、预测和泛化能力彻底改变了自然语言处理。尽管在其他领域取得了成功,但LLM在城市动态预测中的应用仍相对较少。一些尝试如UrbanGPT、ST-LLM和TPLLM试图将LLM应用于时空数据,但仍然存在局限。例如未能考虑不同城市动态间的相互关联,或者缺乏利用提示进行预测指导的能力,并且未能解决训练与测试数据间的分布偏移问题。

该论文旨在提出一种新方法,将LLM的优势应用于时空领域,以实现多方面城市动态预测的高准确度和强泛化能力。实现这一目标需要克服三个关键挑战:

(1)连接时空数据与LLM:时空数据具有复杂的结构化依赖性,而LLM并非为处理此类连续信号而设计,因此必须将原始时空数据转换为LLM可解释的离散语义标记。

(2)提示设计与微调:时空信息包含丰富的语义细节,如何有效设计提示词以指导LLM微调,使其能够理解特定城市背景下的时空动态是至关重要的。

(3)分布偏移:城市动态在训练和测试数据间常表现出显著的分布偏移,尤其是在模型需在未见过的设置中测试的零样本场景,这种偏移严重阻碍了模型的泛化和预测性能。

二、方法

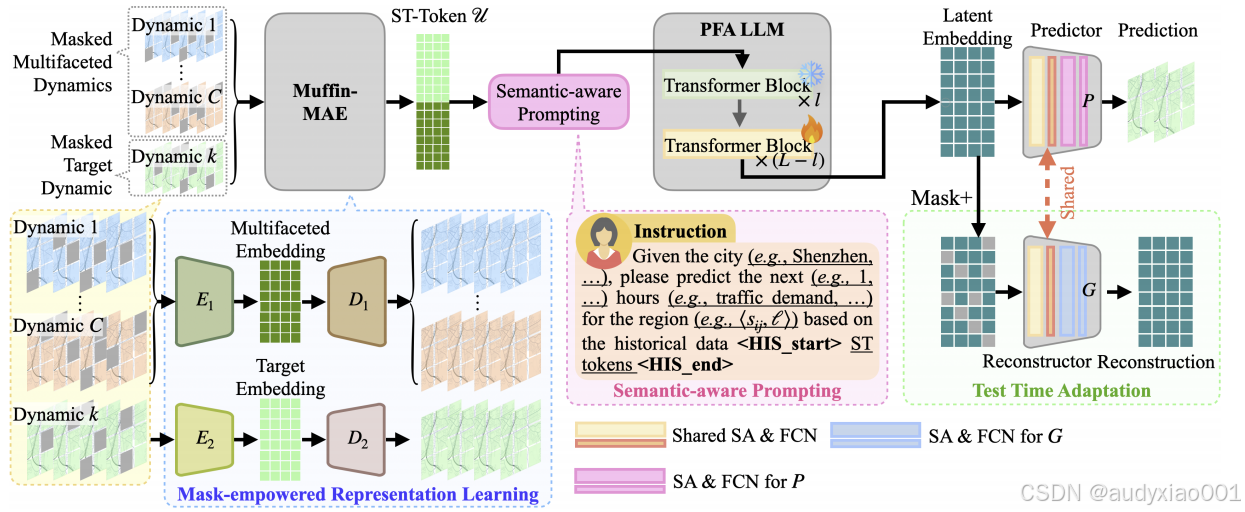

为应对上述挑战,本文提出了一个新颖的多方面时空LLM框架UrbanMind,旨在实现高预测精度和鲁棒的泛化能力。该框架由三个核心组件构成,如图1所示。

图1 UrbanMind框架的组成

2.1 Muffin-MAE掩码策略

LLM本质上是为处理自然语言数据而设计的,无法直接处理时空数据。为了利用LLM进行城市动态预测,关键是要将时空动态转换为LLM能够有效处理的潜在表示,同时必须保留时空依赖性和多方面动态间的相互关联。为此,本文提出了一个具有专门设计掩码机制的框架Muffin-MAE。该架构包含两个掩码自动编码器。

LLM 本质上是为处理自然语言数据而设计的,无法直接处理时空数据。为了利用 LLM 进行城市动态预测,关键是要将时空动态转换为 LLM 能够有效处理的潜在表示,同时必须保留时空依赖性和多方面动态间的相互关联。为此,本文提出了一个具有专门设计掩码机制的框架 Muffin-MAE。该架构包含两个掩码自动编码器。

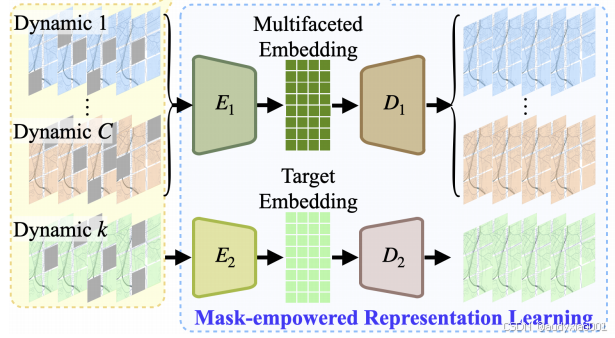

多方面嵌入:第一个 MAE 由编码器1和解码器1组成,它处理多方面的城市动态数据,以有效捕捉它们之间的相互依赖关系。

目标嵌入:第二个 MAE 由独立的编码器2和解码器2组成,它处理单个目标城市动态,以保留目标动态自身的时空依赖性。

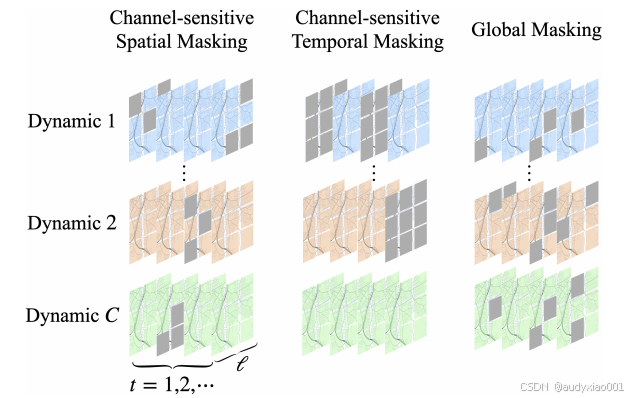

Muffin-MAE 掩码策略与标准 MAE 不同,Muffin-MAE 引入了三种专门的掩码策略,如图 2 所示,旨在跨不同城市动态捕捉空间和时间依赖性。

图2 掩码策略

(1)通道敏感空间掩码(Channel-Sensitive Spatial Masking):此机制在每个时间步随机选择一个通道(即一种动态,如交通速度),并随机掩码该通道内的部分空间特征。这确保了不同区域的网格单元在不同通道间被掩码,使Muffin-MAE能有效捕捉空间依赖。

(2)通道敏感时间掩码(Channel-Sensitive Temporal Masking):此策略随机采样比例p的时间步。对于每个被采样的时间步,它会随机选择一个通道,并掩码该通道在该时间点的所有信息。这使模型能灵活捕捉多方面动态间的时间依赖。

(3)全局掩码(Global Masking):此策略也随机采样时间步,但对于每个采样的时间步,它会跨所有通道随机掩码p比例的网格单元。全局掩码增强了Muffin-MAE捕捉跨动态的整体时空依赖的能力。

时空令牌生成训练完成后,使用编码器1生成多方面嵌入V,并使用编码器2生成目标嵌入Vk,过程如图三所示。通过在特征维度上连接这两种嵌入,该论文为每个时间步创建了最终的时空令牌ur,t,这些令牌封装了相关动态间的相互关联和目标动态的时空依赖性,非常适合LLM处理。

图3 嵌入过程

2.2语义感知的提示与微调

时空预测任务中的时间和空间信息携带了必要的语义细节,利用LLM先进的文本理解能力,将这些信息表示为提示指令文本。在UrbanMind中,通过将时间信息(如历史小时和目标小时)、区域信息(如城市、目标区域坐标)和任务特定信息(如预测“交通需求”)整合到指令输入中。如图1所示,这种结构化提示使UrbanMind能有效识别和吸收跨不同区域、时间和动态的时空模式。

为了使LLM适应时空预测任务,论文采用了部分冻结注意力(PFA)机制。使用LLAMA3.2作为基础LLM。其L个Transformer层被分为冻结层和可训练层。在可训练层中,只更新自注意力机制中的查询矩阵,以学习特定任务的时空依赖,同时保持键和值矩阵冻结,以保留模型预训练的关系编码。

LLM的输出是高维潜嵌入序列。该论文附加一个时空预测器模块P到LLM,它由自注意力层和全连接层组成。该模块处理LLM生成的嵌入,并预测未来m小时的城市动态。

2.3场景自适应

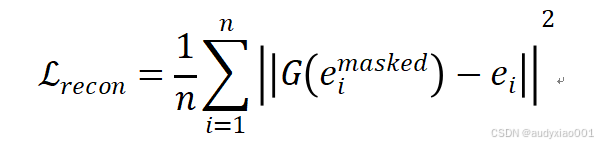

尽管LLM具有很强的泛化性,但在时空领域,测试数据常呈现出与训练数据截然不同的模式,尤其是在零样本场景中。为解决此问题,该论文提出了一种在新场景中进行测试时自适应策略。该策略的核心是一个新颖的测试数据重构器G,它与预测器P并行工作,并共享几个自注意力层。在测试期间,LLM为测试区域生成潜嵌入序列。在将ℰ传递给预测器之前,该论文首先随机掩码中的p比例的元素。然后,重构器G通过几个周期的快速更新来恢复被掩码的元素。此过程通过最小化重构损失来更新G和共享层。损失函数如下:

这个重构过程使G能够快速适应新数据和区域条件,微调共享层以更好地与测试数据分布对齐。一旦适应完成,更新后的共享层使预测器P能够为测试场景生成更准确的结果,从而有效缓解分布偏移,增强泛化能力。

三、实验结果

本文在三个城市的三个不同城市动态数据集上进行了广泛实验,以评估UrbanMind在不同场景下的有效性。

(1)数据集

城市:深圳,西安,成都。

动态:交通速度(Speed),出租车流入量(Inflow),出行需求(Demand)。

(2)任务

零样本预测(Zero-shot Prediction):在未见区域上测试泛化能力。

标准预测(Standard Prediction):在已见区域上测试预测精度。

(3)基线模型(Baselines)

LLM-based: UrbanGPT,TPLLM,ST-LLM,GCNGPT,LLAMA3等。

GNN-based: DYffusion(Diffusion),GCRN(GNN),TGC-LSTM等。

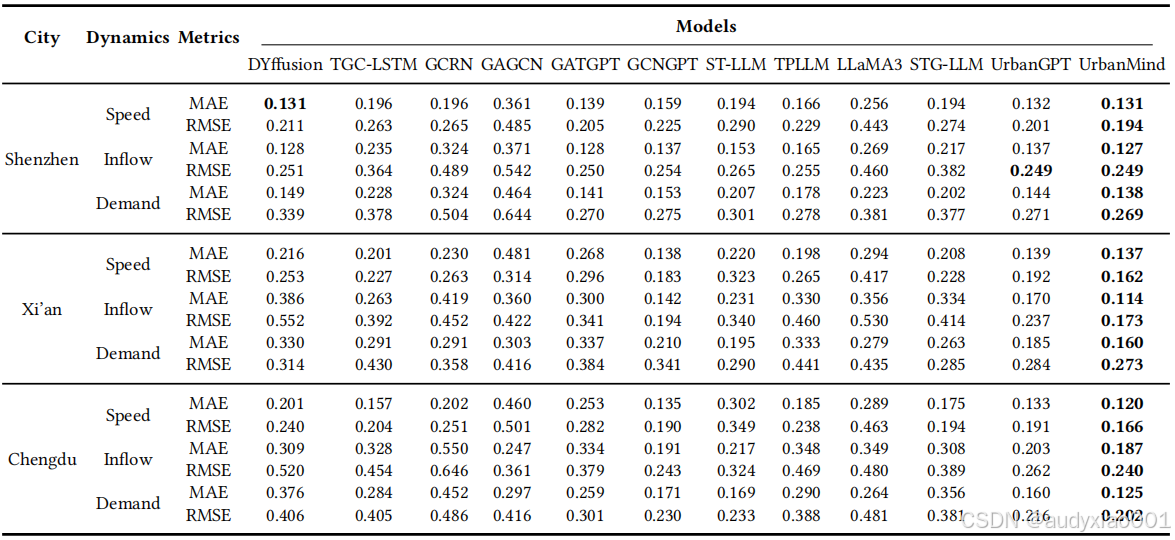

表1 零样本预测性能对比

在零样本预测任务中,所有测试区域在训练期间都是未见过的。如表1所示,UrbanMind在所有数据集和指标(MAE,RMSE)上均一致优于所有基线模型。这证明了UrbanMind卓越的泛化能力,其利用LLM的泛化性并通过测试时自适应机制进一步增强,确保了在零样本任务中的鲁棒性。

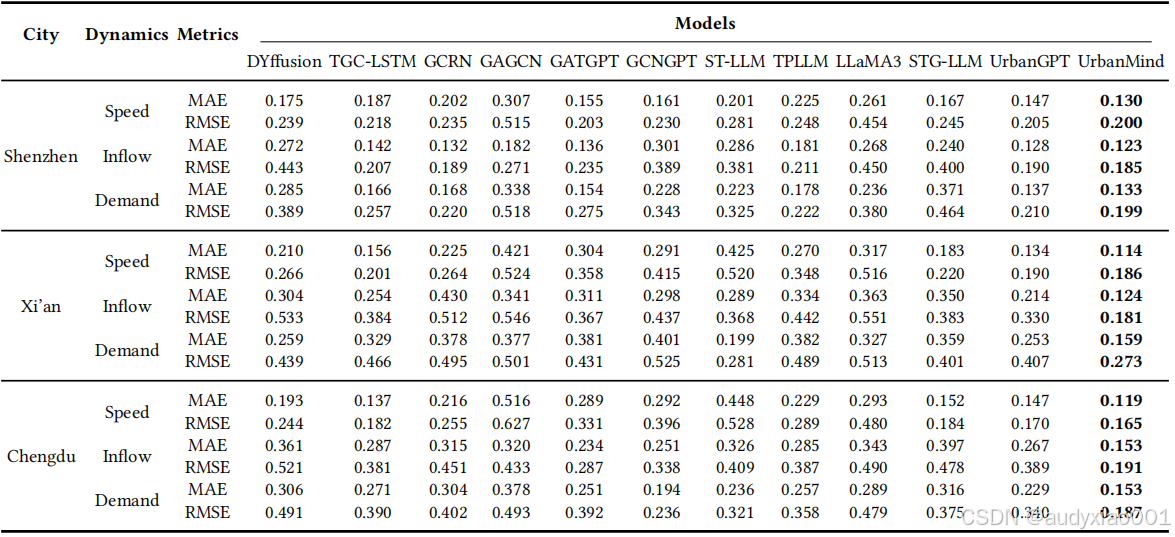

表2 标准预测性能对比

在标准预测任务中,模型在训练集包含的区域上预测未来动态。如表2所示,UrbanMind再次在所有数据集和指标上持续优于基线,取得了最低的MAE和RMSE。这证实了UrbanMind在建模复杂时空关系和动态间相互关联方面的强大能力。

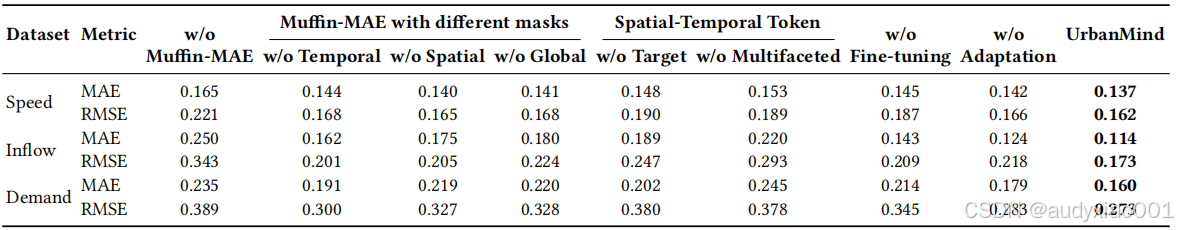

表3 消融实验结果

本实验进行了消融研究以评估UrbanMind中每个组件的贡献。如表3所示,移除Muffin-MAE会导致性能显著下降,表明其在捕捉相互关联的时空依赖方面的重要性。同样,省略LLM微调或测试时自适应也会导致严重的性能下降,凸显了它们在提高适应性和精度方面的关键作用。

四.总结

本推文介绍了一篇KDD 2025的论文。该论文介绍了一个为解决城市动态预测中泛化能力受限和分布偏移挑战而设计的新型时空大语言模型框架UrbanMind。该框架的核心在于其三大创新:通过Muffin-MAE及其专门的掩码策略捕捉多方面动态间的复杂时空依赖与相互关联;采用语义感知的提示与微调策略,使LLM能深入理解时空上下文;并引入一个测试时自适应机制,利用数据重构器动态适应未见数据的分布。实验结果显示,UrbanMind在零样本和标准预测场景下均展现了卓越的准确性与强大的泛化能力,为复杂的城市时空预测提供了高效且鲁棒的技术方案。

更多推荐

已为社区贡献42条内容

已为社区贡献42条内容

所有评论(0)