基于强化学习的虚拟发电厂平衡市场战略竞标

强化学习是一种通过智能体(agent)与环境进行交互,以最大化累积奖励为目标的机器学习范式。简单来说,智能体在环境中采取行动,环境根据智能体的行动给出奖励信号,智能体通过不断试错,学习到能够获得最大奖励的策略。# 定义环境类# 简单模拟环境根据行动改变状态并返回奖励else:reward = 1# 定义智能体类# 简单的epsilon - greedy策略选择行动else:# 主循环在这段代码中,

基于强化学习的虚拟发电厂平衡市场战略竞标 Reinforcement Learning based Strategic Bidding in the Balancing Market with a Virtual Power Plant

在当今电力行业不断变革的大背景下,虚拟发电厂(Virtual Power Plant, VPP)作为一种整合分布式能源资源的有效方式,正逐渐崭露头角。而在平衡市场中,如何进行战略竞标以获取最大收益,成为了VPP运营的关键问题。强化学习(Reinforcement Learning, RL)凭借其在动态决策问题上的优势,为解决这一难题提供了新的思路。

强化学习简介

强化学习是一种通过智能体(agent)与环境进行交互,以最大化累积奖励为目标的机器学习范式。简单来说,智能体在环境中采取行动,环境根据智能体的行动给出奖励信号,智能体通过不断试错,学习到能够获得最大奖励的策略。

下面用一段简单的Python代码示例来初步理解强化学习的基本结构:

import numpy as np

# 定义环境类

class Environment:

def __init__(self):

self.state = 0

def step(self, action):

# 简单模拟环境根据行动改变状态并返回奖励

if action == 0:

self.state -= 1

reward = -1

else:

self.state += 1

reward = 1

return self.state, reward

# 定义智能体类

class Agent:

def __init__(self):

self.q_table = np.zeros((10, 2))

def choose_action(self, state):

# 简单的epsilon - greedy策略选择行动

if np.random.uniform(0, 1) < 0.1:

action = np.random.choice([0, 1])

else:

action = np.argmax(self.q_table[state, :])

return action

def update_q_table(self, state, action, reward, next_state):

learning_rate = 0.1

discount_factor = 0.9

self.q_table[state, action] = (1 - learning_rate) * self.q_table[state, action] + \

learning_rate * (reward + discount_factor * np.max(self.q_table[next_state, :]))

# 主循环

env = Environment()

agent = Agent()

for episode in range(100):

state = env.state

for step in range(20):

action = agent.choose_action(state)

next_state, reward = env.step(action)

agent.update_q_table(state, action, reward, next_state)

state = next_state在这段代码中,Environment类模拟了环境,智能体在这个环境中采取行动(action),环境根据行动返回新的状态(nextstate)和奖励(reward)。Agent类包含了一个Q表(qtable)用于存储每个状态下采取不同行动的价值估计。chooseaction方法使用epsilon - greedy策略来决定采取何种行动,而updateq_table方法则根据强化学习的Q学习算法来更新Q表。

虚拟发电厂平衡市场战略竞标中的强化学习应用

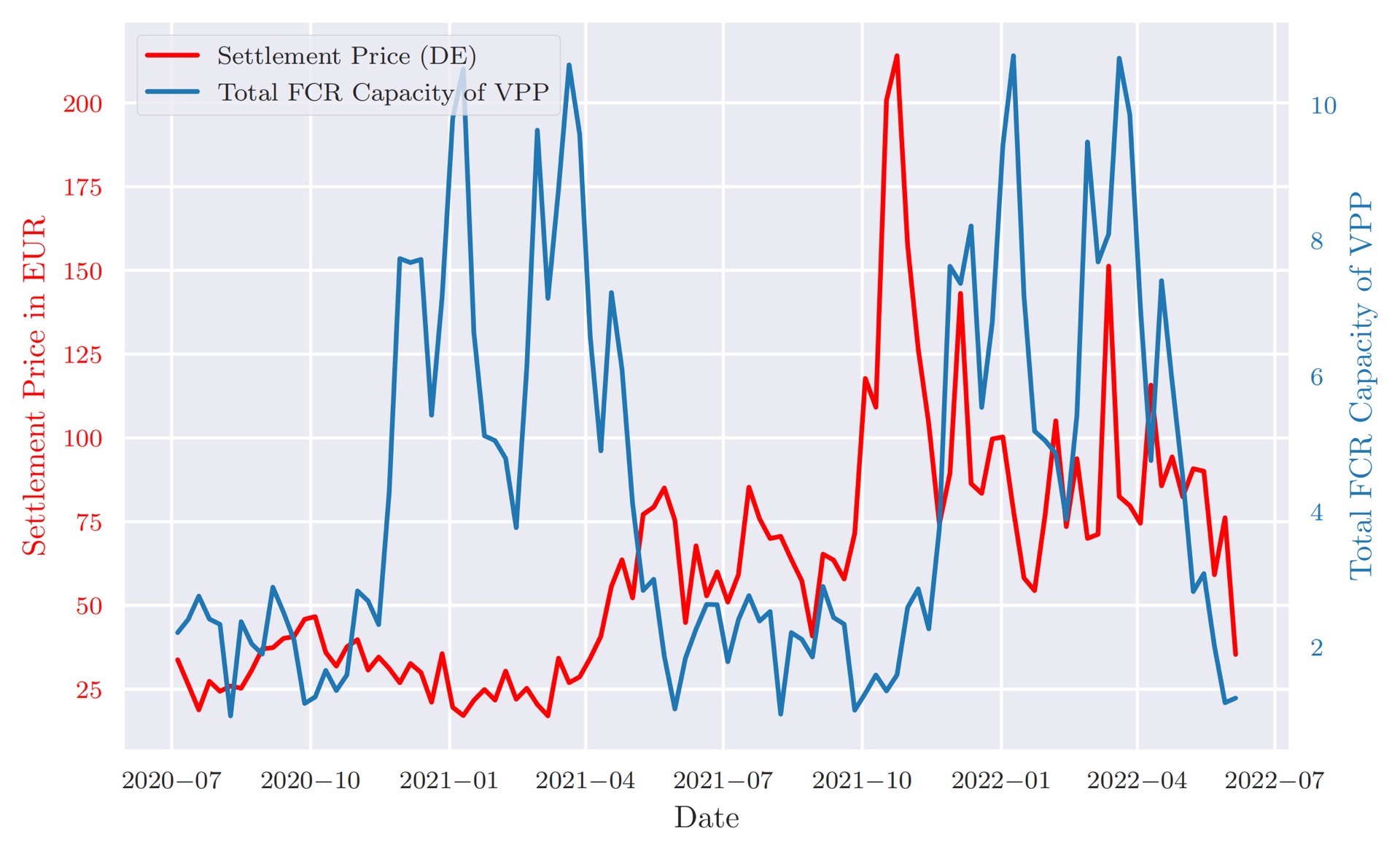

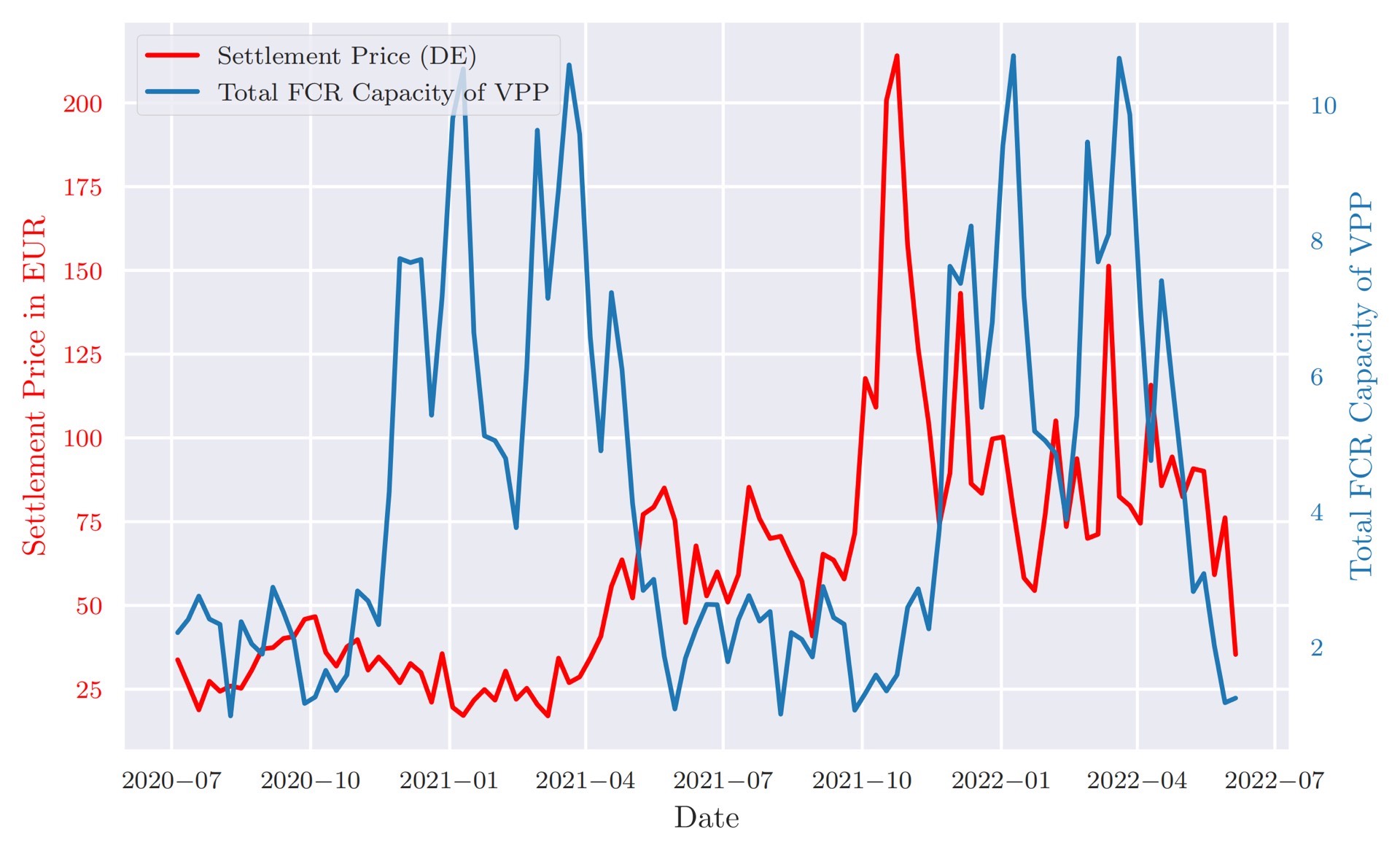

在虚拟发电厂的平衡市场战略竞标场景下,智能体就是VPP的竞标决策系统。环境则包含了市场价格波动、发电成本、负荷需求等多种因素。

- 状态定义:状态可以包括当前市场价格、VPP的发电容量、负荷预测值、储能状态等信息。例如,可以用一个向量来表示状态:

state = [marketprice, vppgenerationcapacity, loadforecast, storage_level]。 - 行动定义:行动通常是指VPP在平衡市场中的竞标电量和价格。比如

action = [biddingquantity, biddingprice]。 - 奖励设计:奖励需要反映VPP在平衡市场中的收益情况。简单的奖励函数可以设计为:

reward = biddingquantity * (marketprice - costprice),其中costprice是VPP的发电成本价格。

下面是一个简化的基于强化学习的VPP竞标代码框架:

import numpy as np

# 定义VPP环境类

class VPPEnvironment:

def __init__(self):

self.market_price = np.random.uniform(20, 50)

self.vpp_generation_capacity = np.random.uniform(100, 500)

self.load_forecast = np.random.uniform(50, 300)

self.storage_level = np.random.uniform(0, 100)

def step(self, action):

bidding_quantity, bidding_price = action

cost_price = 30 # 假设的发电成本价格

if bidding_quantity <= self.vpp_generation_capacity:

if bidding_price <= self.market_price:

reward = bidding_quantity * (self.market_price - cost_price)

# 根据竞标调整发电和储能状态等,这里简单省略

self.vpp_generation_capacity -= bidding_quantity

self.storage_level -= bidding_quantity * 0.1

else:

reward = -10 # 竞标价格过高,未中标惩罚

else:

reward = -20 # 竞标电量超过发电容量惩罚

new_state = [self.market_price, self.vpp_generation_capacity, self.load_forecast, self.storage_level]

return new_state, reward

# 定义VPP智能体类

class VPPAgent:

def __init__(self):

self.q_table = np.zeros((100, 100, 2))

def choose_action(self, state):

state_index1 = int(state[0] / 10)

state_index2 = int(state[1] / 10)

if np.random.uniform(0, 1) < 0.1:

action1 = np.random.choice([i for i in range(10)])

action2 = np.random.choice([i for i in range(10)])

else:

action1, action2 = np.unravel_index(np.argmax(self.q_table[state_index1, state_index2, :]), (10, 10))

bidding_quantity = action1 * 10

bidding_price = action2 * 5 + 20

return [bidding_quantity, bidding_price]

def update_q_table(self, state, action, reward, next_state):

state_index1 = int(state[0] / 10)

state_index2 = int(state[1] / 10)

next_state_index1 = int(next_state[0] / 10)

next_state_index2 = int(next_state[1] / 10)

learning_rate = 0.1

discount_factor = 0.9

action_index1 = int(action[0] / 10)

action_index2 = int((action[1] - 20) / 5)

self.q_table[state_index1, state_index2, action_index1, action_index2] = (1 - learning_rate) * \

self.q_table[state_index1, state_index2,

action_index1, action_index2] + \

learning_rate * (

reward + discount_factor * np.max(

self.q_table[next_state_index1,

next_state_index2, :]))

# 主循环

vpp_env = VPPEnvironment()

vpp_agent = VPPAgent()

for episode in range(1000):

state = [vpp_env.market_price, vpp_env.vpp_generation_capacity, vpp_env.load_forecast, vpp_env.storage_level]

for step in range(10):

action = vpp_agent.choose_action(state)

next_state, reward = vpp_env.step(action)

vpp_agent.update_q_table(state, action, reward, next_state)

state = next_state在这个代码框架中,VPPEnvironment类模拟了VPP面临的环境,step方法根据智能体的竞标行动返回新的状态和奖励。VPPAgent类通过Q表来学习最优的竞标策略,chooseaction方法根据当前状态选择竞标电量和价格,updateq_table方法则更新Q表。

挑战与展望

尽管基于强化学习的虚拟发电厂平衡市场战略竞标具有很大的潜力,但在实际应用中仍面临一些挑战。例如,市场环境的高度不确定性和复杂性可能导致强化学习模型难以准确建模。此外,数据的获取和预处理也是一个关键问题,准确的市场数据、发电数据和负荷数据对于训练有效的强化学习模型至关重要。

然而,随着技术的不断发展和研究的深入,相信强化学习在虚拟发电厂平衡市场战略竞标中的应用将不断完善,为VPP的高效运营和电力市场的稳定发展提供有力支持。

通过将强化学习引入虚拟发电厂平衡市场的战略竞标,我们有望在复杂多变的电力市场环境中找到最优的竞标策略,实现虚拟发电厂的经济效益最大化,同时也为电力系统的灵活性和稳定性做出贡献。希望这篇博文能让大家对这一有趣且具有重要实际意义的领域有更深入的了解。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)