别再忍受低效检索了!22.9k stars的LightRAG,让你的AI应用检索性能飙升10倍!

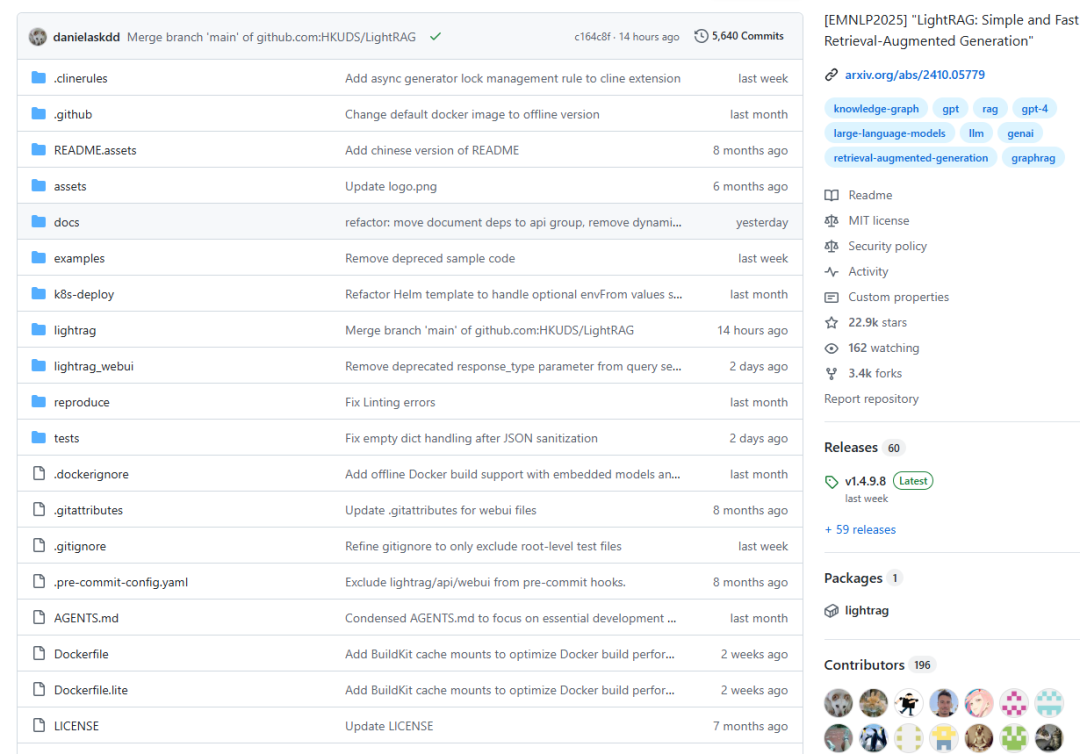

导语:在大语言模型蓬勃发展的今天,如何让AI更准确地理解和回答问题?香港大学团队开源的LightRAG项目给出了一个优雅的答案。这个在EMNLP 2025上发表的框架,已经获得了超过22,000个GitHub星标,成为RAG领域最受关注的项目之一。

导语:在大语言模型蓬勃发展的今天,如何让AI更准确地理解和回答问题?香港大学团队开源的LightRAG项目给出了一个优雅的答案。这个在EMNLP 2025上发表的框架,已经获得了超过22,000个GitHub星标,成为RAG领域最受关注的项目之一。

一、解决了什么问题?

想象一下,你在使用ChatGPT时问:"马斯克和特斯拉的关系是什么?"传统的RAG(检索增强生成)系统可能会给你返回一堆包含"马斯克"和"特斯拉"的文档片段,但这些片段往往是碎片化的,缺乏上下文关联。

传统RAG的三大痛点:

1. 扁平化数据表示

传统RAG系统将文档简单切块存储,就像把一本书撕成碎片。当你提问时,系统只能找到相关的"碎片",却无法理解这些碎片之间的关系。

2. 上下文意识不足

假设文档中提到"他创立了公司",传统系统很难知道"他"指的是谁,"公司"又是哪家公司。缺乏实体和关系的理解,导致回答常常答非所问。

3. 检索效率低下

面对海量文档,传统方法需要扫描大量数据才能找到相关信息,响应速度慢,而且容易遗漏重要信息。

LightRAG的解决方案:

通过构建知识图谱,LightRAG将文档中的实体(人物、地点、组织等)和它们之间的关系结构化地存储起来。就像给大脑建立神经网络一样,让AI不仅知道"是什么",还知道"有什么关系"。

二、LightRAG是什么?

LightRAG(Light Retrieval-Augmented Generation)是一个简单、快速的检索增强生成框架,它的核心创新在于将知识图谱与向量检索相结合。

核心特性

🔹 双模索引机制

- 知识图谱:存储实体和关系的结构化信息

- 向量嵌入:捕捉语义相似性

两者结合,既能理解"关系",又能匹配"语义"。

🔹 分层检索策略

LightRAG提供三种检索模式:

- 局部检索(Local):关注具体实体和直接关系

- 全局检索(Global):理解文档整体结构和主题

- 混合检索(Hybrid):结合局部和全局的优势

🔹 增量更新算法

新数据可以实时融入知识图谱,无需重建整个索引,特别适合动态变化的知识库。

🔹 多模型支持

支持OpenAI、Ollama、Hugging Face等主流大语言模型,还支持多种存储后端(Neo4j、PostgreSQL等)。

技术亮点

根据EMNLP 2025论文,LightRAG在多个基准测试中都显著超越了传统RAG方法:

- 检索准确率提升:通过图结构捕捉更多上下文信息

- 响应速度加快:图遍历比向量搜索更高效

- 答案质量提升:关系推理能力让回答更连贯完整

三、怎么用?三步上手LightRAG

Step 1:安装部署

方式一:使用PyPI(推荐新手)

pip install lightrag-hku

方式二:从源码安装(推荐开发者)

git clone https://github.com/HKUDS/LightRAG.gitcd LightRAGuv sync # 使用uv进行快速依赖管理source .venv/bin/activate # Linux/macOS# Windows用户使用: .venv\Scripts\activate

方式三:Docker一键部署

git clone https://github.com/HKUDS/LightRAG.gitcd LightRAGcp env.example .env # 配置环境变量docker compose up

Step 2:快速开始

这是一个使用OpenAI的简单示例:

import osfrom lightrag import LightRAG, QueryParamfrom lightrag.llm import openai_complete_if_cache# 设置OpenAI API密钥os.environ["OPENAI_API_KEY"] = "your-api-key"# 初始化LightRAGrag = LightRAG( working_dir="./dickens", llm_model_func=openai_complete_if_cache)# 插入文档with open("book.txt") as f: rag.insert(f.read())# 查询(局部模式)result = rag.query( "What is the relationship between Scrooge and Marley?", param=QueryParam(mode="local"))print(result)# 查询(全局模式)result = rag.query( "What are the main themes of the story?", param=QueryParam(mode="global"))print(result)

Step 3:启动Web界面

LightRAG提供了友好的Web UI,让非技术人员也能轻松使用:

# 安装API支持pip install "lightrag-hku[api]"# 配置环境cp env.example .env# 启动服务器lightrag-server

访问 http://localhost:8020,你将看到一个包含以下功能的界面:

- 📄 文档索引管理

- 🕸️ 知识图谱可视化

- 💬 RAG问答交互

- 📊 引用来源追溯

四、实战场景

场景1:企业知识库

将公司内部文档、产品手册、技术文档导入LightRAG,员工可以快速获取准确的信息,并追溯到原始文档。

场景2:学术研究助手

导入论文、研究报告,通过知识图谱理解作者、机构、研究主题之间的关系,快速生成文献综述。

场景3:客服智能问答

将产品FAQ、用户手册、政策文档结构化,客服系统能更准确地理解客户问题并给出关联的解决方案。

场景4:代码文档助手

将代码库和文档导入,开发者可以快速理解函数之间的调用关系和依赖关系。

五、最新进展

LightRAG团队持续在优化和扩展功能:

📅 2025年最新更新:

- ✅ 支持RAGAS评估框架和Langfuse可观测性

- ✅ 引用功能,实现来源追溯

- ✅ Reranker重排序支持,提升混合查询性能

- ✅ PostgreSQL存储支持

- ✅ 多模态数据处理(通过RAG-Anything集成)

社区活跃度:

- GitHub Star:22.6k+

- Fork:3.4k+

- 持续更新中

六、总结

LightRAG通过巧妙地结合知识图谱和向量检索,为检索增强生成带来了新的可能性。它不仅解决了传统RAG的碎片化问题,还提供了简单易用的API和丰富的功能。

核心优势回顾:

- 🎯 更准确:知识图谱理解实体关系

- ⚡ 更快速:高效的图检索算法

- 🔧 更灵活:多模型、多存储后端支持

- 📈 可扩展:增量更新,适合动态知识库

无论你是开发者想要构建智能问答系统,还是企业想要优化知识管理,LightRAG都是一个值得尝试的开源方案。

如何高效转型Al大模型领域?

作为一名在一线互联网行业奋斗多年的老兵,我深知持续学习和进步的重要性,尤其是在复杂且深入的Al大模型开发领域。为什么精准学习如此关键?

- 系统的技术路线图:帮助你从入门到精通,明确所需掌握的知识点。

- 高效有序的学习路径:避免无效学习,节省时间,提升效率。

- 完整的知识体系:建立系统的知识框架,为职业发展打下坚实基础。

AI大模型从业者的核心竞争力

- 持续学习能力:Al技术日新月异,保持学习是关键。

- 跨领域思维:Al大模型需要结合业务场景,具备跨领域思考能力的从业者更受欢迎。

- 解决问题的能力:AI大模型的应用需要解决实际问题,你的编程经验将大放异彩。

以前总有人问我说:老师能不能帮我预测预测将来的风口在哪里?

现在没什么可说了,一定是Al;我们国家已经提出来:算力即国力!

未来已来,大模型在未来必然走向人类的生活中,无论你是前端,后端还是数据分析,都可以在这个领域上来,我还是那句话,在大语言AI模型时代,只要你有想法,你就有结果!只要你愿意去学习,你就能卷动的过别人!

现在,你需要的只是一份清晰的转型计划和一群志同道合的伙伴。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献224条内容

已为社区贡献224条内容

所有评论(0)