Google 第七代 TPU Ironwood 上线:10 倍推理性能背后,AI 泡沫还是算力革命?

【摘要】Google Ironwood 以十倍性能提升重塑 AI 推理格局。Anthropic 百亿订单验证商业需求。技术飞跃与金融泡沫、能源瓶颈的博弈,正定义 AI 的未来。

【摘要】Google Ironwood 以十倍性能提升重塑 AI 推理格局。Anthropic 百亿订单验证商业需求。技术飞跃与金融泡沫、能源瓶颈的博弈,正定义 AI 的未来。

引言

人工智能产业正处在一个关键的十字路口。一方面,底层技术的迭代速度超乎想象,模型能力以前所未有的方式渗透进各行各业。另一方面,资本市场的狂热情绪与对估值泡沫的担忧交织,让从业者和观察者都感到一丝不安。

近期,两个标志性事件将这一矛盾推向了高潮。首先,Google Cloud 正式上线其第七代张量处理单元(TPU)“Ironwood”,专为生成式 AI 推理设计,性能指标实现了惊人的代际飞跃。紧接着,AI 独角兽 Anthropic 宣布了一项史无前例的采购计划,将在 Google Cloud 上部署最多 100 万颗 TPU,构建超过 1GW 的庞大算力集群。

这不再是纸面上的概念炒作。这是真金白银的投入,是硅基芯片的物理迭代。这些进展似乎在有力地回击“AI 泡沫论”。但与此同时,英国央行等全球金融监管机构的警示声不绝于耳,直指 AI 板块的高估值风险。

那么,我们究竟身处一场深刻的算力革命,还是正在见证一个巨大泡沫的形成?本文将从 Ironwood 的技术细节、Anthropic 的战略布局、金融市场的反应以及底层的能源约束等多个维度,对这一复杂局面进行深度剖析。

💠 一、Ironwood 技术解构,推理时代的算力新基石

Google TPU 家族的演进史,就是一部为特定 AI 负载定制硬件加速的编年史。Ironwood 的发布,标志着 Google 的设计哲学正从兼顾训练与推理,全面转向聚焦大规模推理这一核心战场。

1.1 性能指标的代际跃迁

Ironwood 的核心亮点在于其性能参数。官方数据显示,其整体推理性能相较前代产品提升了约 10 倍,这是一个巨大的飞跃。同时,其每瓦性能(Performance per Watt)提升了近 2 倍。这意味着在提供更强算力的同时,能耗效率也得到了显著优化。

为了更直观地理解 Ironwood 的市场定位,我们可以将其与业界主流的加速器进行一个简要的横向对比。

|

特性 |

Google TPU v7 (Ironwood) |

Google TPU v5e (上一代) |

NVIDIA B200 (参考) |

|---|---|---|---|

|

主要优化场景 |

大规模生成式 AI 推理 |

通用 AI 推理与训练 |

通用 AI 训练与推理 |

|

系统规模 |

单 Pod 支持 9,216 颗芯片 |

单 Pod 支持 256 颗芯片 |

NVL72 机柜支持 72 颗 GPU |

|

性能提升 (相对前代) |

推理性能提升 ~10x |

基准线 |

推理性能提升高达 30x (相对H100) |

|

能效提升 (相对前代) |

每瓦性能提升 ~2x |

基准线 |

能效提升显著 (具体数据待实测) |

|

散热技术 |

大规模液冷 |

风冷/液冷 |

液冷 |

从表格中可以看出,Ironwood 的设计思路非常明确。它通过极致的系统规模扩展和针对性的推理优化,构建了一个专门服务于超大规模语言模型(LLM)部署的“算力航母”。10 倍的性能提升,直接关系到服务成本的降低和用户响应速度的提升。

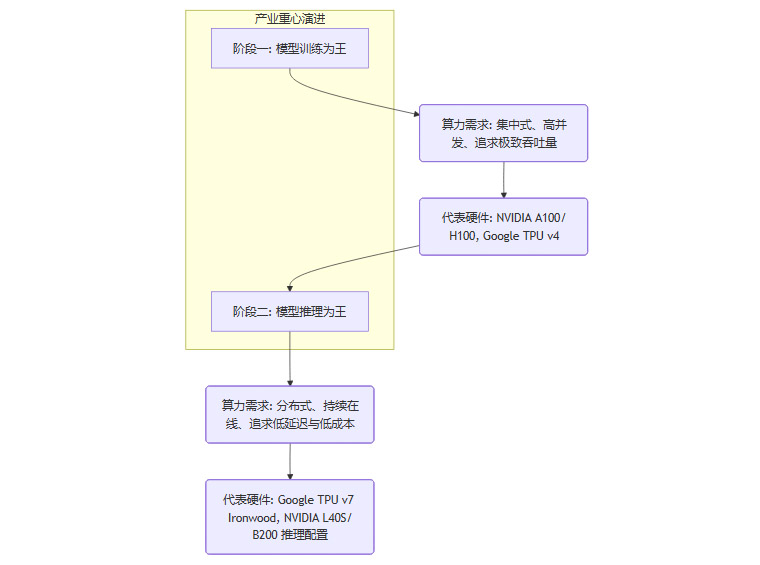

1.2 架构设计的转向,从训练到推理

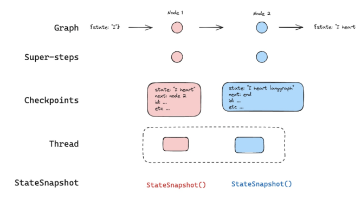

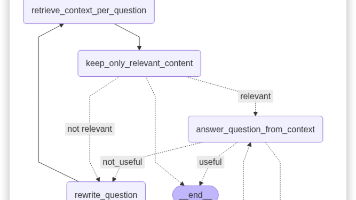

AI 模型的生命周期主要包含两个阶段,训练(Training)和推理(Inference)。这两个阶段对算力的需求截然不同。

-

训练。这是一个计算密集型过程,通常需要海量数据进行数周甚至数月的并行计算。它追求的是极致的吞吐量和并行效率。

-

推理。这是模型部署后提供服务的阶段,需要 7x24 小时在线。它追求的是低延迟、高并发和低单位成本。

随着 GPT-4、Claude 3 等基础模型的成熟,AI 产业的重心正在发生结构性转变。

Ironwood 正是这一转变的产物。它不再追求在训练性能上与对手全面抗衡,而是将所有设计资源都倾注在推理场景。这包括芯片内部的计算单元排布、内存带宽优化以及片间互联设计,一切都为了让大模型在响应用户请求时更快、更便宜。这种专注使其在特定领域获得了不对称的优势。

1.3 液冷与系统规模,挑战物理极限

Ironwood 单个 Pod 支持高达 9,216 颗芯片,这是一个惊人的密度。在如此高的密度下,传统的风冷散热方案早已失效。液冷技术从过去的“可选项”变成了“必需品”。

液冷不仅解决了散热问题,还带来了两个额外的好处。

-

提升系统稳定性。液体介质的温度控制更精确,可以确保数千颗芯片在长时间高负载下依然运行在最佳温度区间,减少因过热导致的降频或故障。

-

降低数据中心 PUE。PUE (Power Usage Effectiveness) 是衡量数据中心能源效率的指标。液冷系统相比风冷系统,在冷却环节的能耗更低,有助于压低整体数据中心的运营成本和碳足迹。

Ironwood 的大规模液冷部署,预示着未来超大规模 AI 计算中心的设计范式。数据中心正在从“服务器仓库”演变为一个高度集成的、由液体管道连接的“超级计算机”。

💠 二、Anthropic 百亿押注,AI 商业化的“真金白银”

如果说 Ironwood 的发布是供给侧的技术突破,那么 Anthropic 的采购大单则是需求侧的强力回应。这笔交易的规模和背后的战略意图,为我们揭示了 AI 头部玩家的真实想法。

2.1 百万 TPU 与 1GW 算力意味着什么

Anthropic 计划采购最多 100 万颗 TPU,并在 2026 年前构建超过 1GW(吉瓦) 的运算与电力容量。这些数字需要被正确解读。

-

100 万颗 TPU。这代表了 Anthropic 对其 Claude 系列模型未来市场需求极度乐观的预期。如此规模的算力储备,足以支撑数亿甚至数十亿级别的日活跃用户调用。这不再是小范围的实验,而是面向全球市场的商业化扩张。

-

1GW 电力容量。这是一个更为惊人的数字。1GW 的功率约等于一座中型核电站的发电量,可以满足一个中等规模城市(约 75 万户家庭)的用电需求。为这样一个算力集群提供稳定、可靠的电力供应,本身就是一个巨大的工程挑战。

这笔价值数百亿美元的合同,是 Anthropic 用真金白银为 AI 的未来投下的信任票。它向市场传递了一个清晰的信号,生成式 AI 的商业化需求是真实且庞大的。

2.2 多平台算力策略的深层考量

Anthropic 并没有将所有鸡蛋放在一个篮子里。其算力策略是典型的多平台并行。

|

平台 |

核心技术 |

优势 |

Anthropic 的战略用途 |

|---|---|---|---|

|

Google Cloud |

TPU (Ironwood) |

推理性价比高、能效优异、与 Google 生态深度集成 |

大规模 Claude 模型推理服务,降低运营成本 |

|

Amazon AWS |

Trainium/Inferentia |

训练性能强大、AWS 生态成熟、客户基础广泛 |

模型训练与研发,利用 AWS 的基础设施优势 |

|

NVIDIA (多云) |

GPU (H100/B200) |

生态系统最成熟、通用性强、软件栈(CUDA)完善 |

模型研究、算法验证、特定任务加速,保持技术灵活性 |

这种多元化布局背后,是 AI 头部公司对算力结构和供应链安全的深刻理解。

-

避免供应商锁定。依赖单一供应商存在巨大风险,包括价格波动、供应中断等。多平台策略赋予了 Anthropic 更强的议价能力和业务韧性。

-

技术与成本最优化。不同的硬件架构有不同的优势。通过将训练、推理等不同负载分配到最适合的平台上,可以实现整体成本和性能的最优化。

-

保持模型开发的灵活性。在不同架构上进行开发和测试,可以确保模型不被特定硬件“绑架”,未来可以更平滑地迁移到新的、更优的平台上。

2.3 价格性能比,TPU 的核心竞争力

Google Cloud CEO Thomas Kurian 和 Anthropic CFO Krishna Rao 的表态都指向了同一个核心,价格性能比。

在 AI 推理服务中,成本是决定商业模式能否成功的关键。每一分钱的成本节约,在亿万次调用中都会被指数级放大。Ironwood 的高能效(每瓦性能提升 2 倍)直接转化为更低的电费账单。其针对推理的优化则意味着可以用更少的芯片处理同样多的请求,从而降低硬件摊销成本。

Google 正试图通过 TPU 打造一条护城河。它不与 NVIDIA 在通用 GPU 市场进行正面竞争,而是选择在大规模云端推理服务这个细分赛道上,利用自研硬件和软件栈的协同优势,提供一个TCO(总拥有成本) 最优的解决方案。Anthropic 的大单,正是对这一策略的最好背书。

💠 三、泡沫的幽灵,金融市场的审慎与警示

尽管技术和商业层面看起来一片光明,但金融市场的视角却冷静得多,甚至带有一丝寒意。以英国央行为代表的监管机构,正在持续对 AI 领域的资产价格泡沫发出警告。

3.1 估值与现实的脱节

当前,头部 AI 科技公司的市值已经达到了惊人的高度。其估值水平,无论是市盈率(P/E)还是市销率(P/S),都已接近甚至超过了 2000 年互联网泡沫时期的峰值。

金融市场的核心担忧在于,资产价格的上涨速度,已经远远超过了企业盈利能力的增长速度。市场似乎在提前透支未来十年甚至更长时间的增长预期。这种建立在“信仰”而非“业绩”上的估值体系是极其脆弱的。一旦行业发展不及预期,或者出现意想不到的利空因素,就可能触发大规模的抛售,导致所谓的“突然修正”。

3.2 盈利兑现的漫长路径

AI 技术的商业化落地,远比想象中复杂。目前,除了少数头部企业,绝大多数 AI 公司仍处于“烧钱换增长”的阶段。一个成功的商业模式需要满足多个条件。

-

清晰的价值主张。技术能解决什么实际问题?

-

可行的成本结构。服务成本(主要是算力成本)是否足够低?

-

可持续的收入来源。用户是否愿意为之付费?

许多 AI 应用虽然技术上很酷,但在商业上却难以闭环。资本市场可以容忍短期的亏损,但无法接受遥遥无期的盈利预期。如果 AI 产业迟迟无法证明其大规模、可持续的盈利能力,投资者的耐心终将被耗尽。

3.3 “硬科技真,估值虚”的结构性矛盾

这里出现了一个核心的结构性矛盾。

-

硬科技是真实的。Ironwood 的性能提升是真实的。Anthropic 的用户增长和算力需求是真实的。AI 正在创造真实的生产力价值。

-

估值可能是虚高的。资本市场对这种真实价值的定价,可能包含了过多的乐观情绪和投机成分。

这两者并不矛盾,它们可以同时存在。一个行业可以既处于技术革命期,又处于金融泡沫期。互联网时代就是最好的例子。Amazon、Google 等公司最终活了下来,并成为巨头,但这并不能抹去无数公司在泡沫破裂中灰飞烟灭的事实。

当前 AI 产业的局面正是如此。技术周期与金融周期交织在一起,使得判断变得异常复杂。

💠 四、算力背后的“隐形成本”,能源与基建的硬约束

在讨论算力和估值的同时,一个更底层的、物理层面的约束正在浮出水面,那就是能源。

4.1 全球数据中心的能耗危机

根据国际能源署(IEA)和高盛等机构的预测,AI 将成为未来十年全球电力消耗增长的主要驱动力。数据中心,特别是用于 AI 训练和推理的超算中心,正在变成一个个“耗电巨兽”。

预计到 2030 年,全球数据中心的耗电量可能占到全球总用电量的 6% 到 10%,而在部分国家(如爱尔兰),这一比例可能高达 30%。Anthropic 的 1GW 算力集群,只是这场能源竞赛的一个缩影。

这种能耗的激增,带来了连锁反应。

-

电网压力。对现有电网的稳定性和容量提出了巨大挑战。

-

环境压力。如果新增电力主要来自化石燃料,将对全球碳中和目标构成威胁。

-

成本压力。电费将成为 AI 公司越来越沉重的运营负担。

4.2 高能效芯片的悖论

一个常见的误解是,像 Ironwood 这样能效更高的芯片可以解决能源问题。但这其实陷入了“杰文斯悖论”(Jevons Paradox)。

杰文斯悖论。当技术进步提高了资源使用的效率,反而会因为成本降低而导致该资源的总消耗量增加。

Ironwood 的高能效降低了单次 AI 推理的能源成本。这使得过去因成本过高而无法实现的应用变得可行,从而刺激了更多的 AI 应用部署,最终导致整体算力规模和总能耗的爆炸式增长。

因此,芯片能效的提升固然重要,但它无法从根本上扭转 AI 产业总能耗飙升的趋势。

4.3 能源成为新的战略瓶颈

未来,AI 产业的竞争,将不仅仅是算法和模型的竞争,更是能源和基础设施的竞争。能否获得稳定、廉价、清洁的电力资源,将成为决定一个公司甚至一个国家 AI 发展上限的关键因素。

能源瓶颈可能会以多种方式制约 AI 的发展。

-

直接成本。高昂的电价直接侵蚀 AI 服务的利润。

-

物理限制。在特定区域,电网容量可能无法支持新的数据中心建设。

-

社会与政策风险。公众和政府对高能耗的反对,可能导致更严格的监管和限制。

这个硬约束,是所有关于 AI 的美好叙事最终都必须面对的物理现实。

结论

回到最初的问题,我们正身处 AI 泡沫还是算力革命?答案或许是,两者都是。

Google Ironwood 的诞生和 Anthropic 的百亿订单,雄辩地证明了这是一场由硬核技术驱动的、拥有真实商业需求的产业革命。AI 正在从实验室走向工厂,从概念走向应用,其底层的基础设施正在以惊人的速度建设和完善。从这个角度看,我们正处在一场深刻的算力革命之中。

然而,这场革命并非没有阴影。资本市场的过度狂热,让相关资产的估值充满了泡沫的风险。盈利模式的不确定性,为未来的商业前景蒙上了一层迷雾。更重要的是,能源和基础设施的物理瓶颈,正成为悬在整个行业头顶的达摩克利斯之剑。

技术、资本、能源,这三个要素正在以前所未有的方式交织、碰撞。未来的赢家,不仅需要拥有最顶尖的模型和算法,还需要最精明的资本运作能力,以及对底层物理资源的掌控力。

对于身处其中的技术人而言,保持清醒和专注至关重要。一方面,要拥抱技术变革带来的巨大机遇。另一方面,也要深刻理解其背后的风险与约束。这场 AI 的“冰与火之歌”,才刚刚奏响序曲。

📢💻 【省心锐评】

Ironwood 以硬核算力驱动 AI 实体经济。但资本市场的狂热与能源的红线,共同决定了这场革命的最终走向,技术、资本、资源缺一不可。

更多推荐

已为社区贡献370条内容

已为社区贡献370条内容

所有评论(0)