windows本地部署大模型ollama+docker+dify(需联网)

小白教程,windows本地部署大模型,使用的技术架构为ollama+docker+dify,包含软件的安装、部署、模型接入等过程,部署过程需要联网。

本文档介绍ollama+docker+dify实现本地大模型部署的方案。使用ollama作为本地大模型服务,利用docker部署Dify平台,用于访问本地部署的大模型服务,整个部署流程主要为,部署ollama服务、部署docker并运行dify平台。

目录

1 ollama部署

1.1 ollama下载与安装

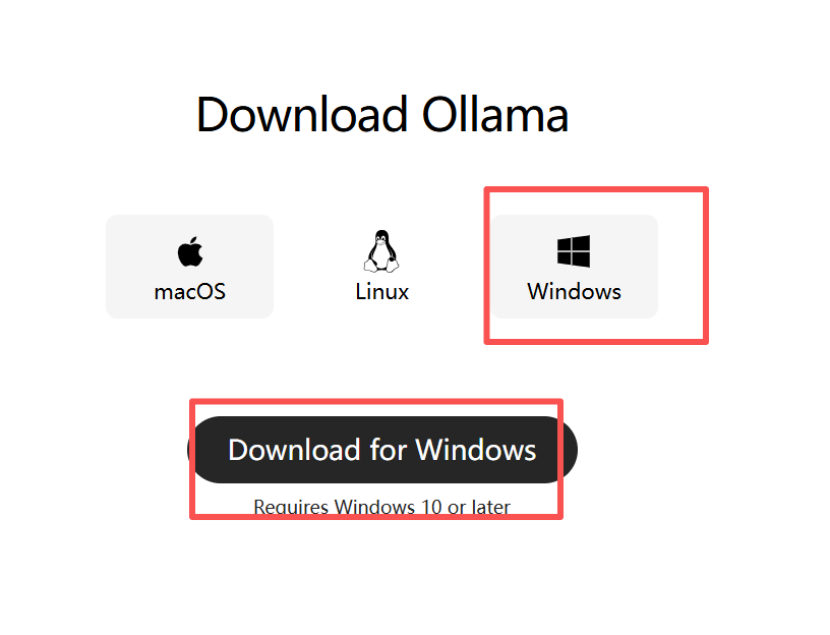

访问ollama官网

https://ollama.com/download/windows选择windows版本,点击下载。

由于软件是通过github进行下载,国内网络在访问时可能会出现无法访问的情况

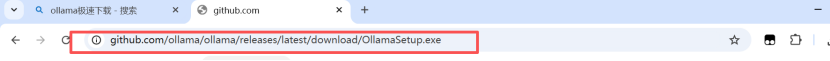

可将地址栏上的网址进行复制

20251124最新下载地址:

https://github.com/ollama/ollama/releases/latest/download/OllamaSetup.exe

使用迅雷或其它下载器进行下载

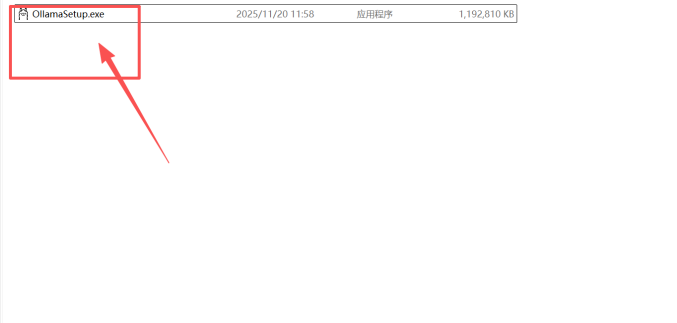

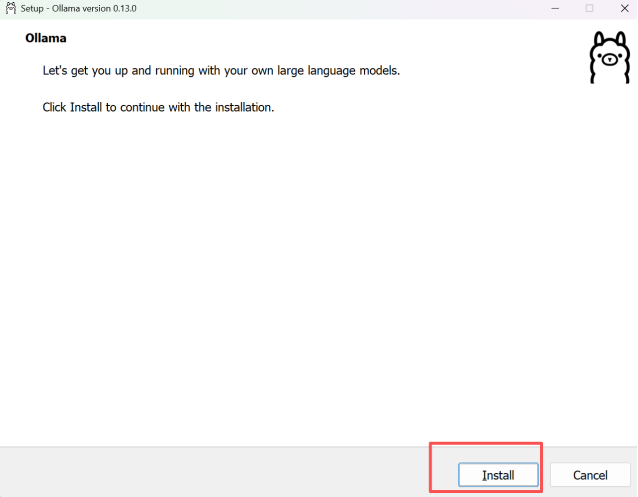

下载完成后双击软件安装包进行安装

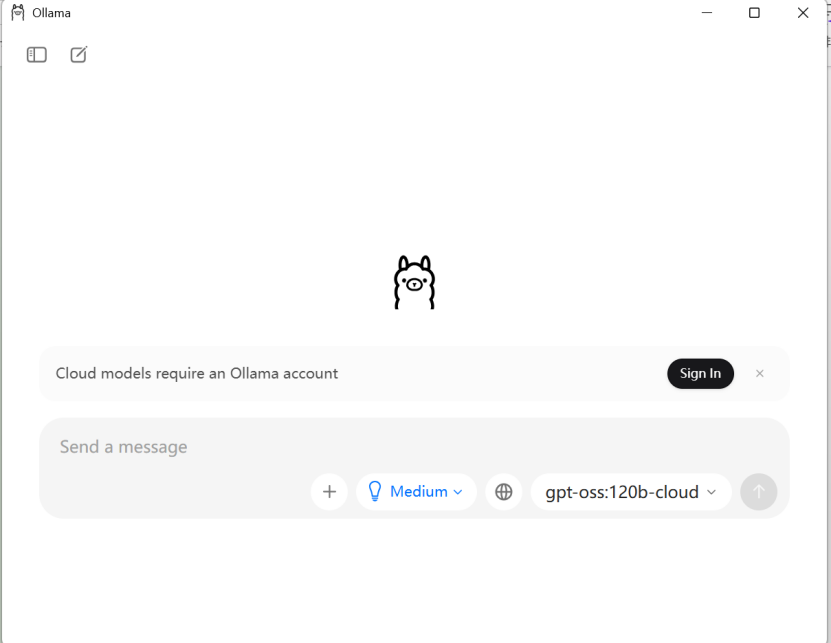

安装完成

1.2 模型下载

安装完成后,下载大模型并进行部署

下载模型的网站主要有

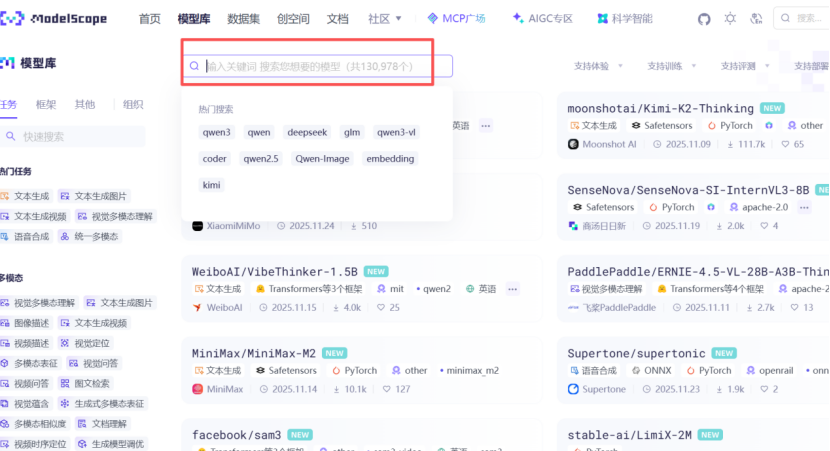

魔搭社区:https://modelscope.cn/models

Hugging Face:https://www.huggingfacecn.com/

本文档使用魔搭社区中提供的大模型文件

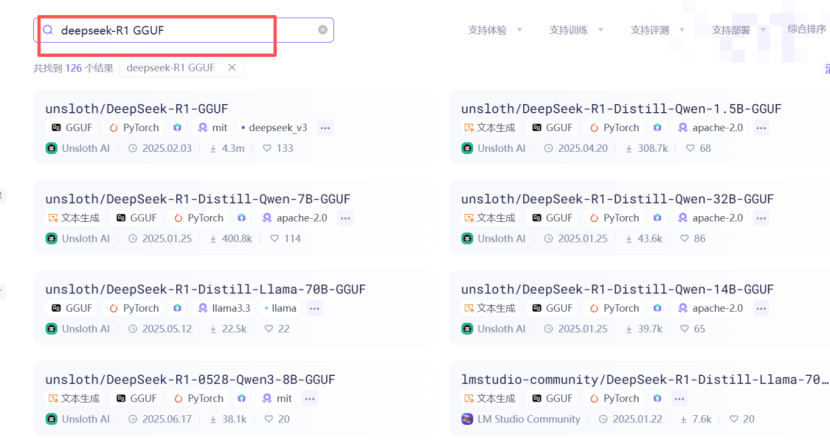

检索需要部署的大模型

由于ollama本地导入的模型中GGUF格式较好,所以在搜索时可加上GGUF进行筛选过滤

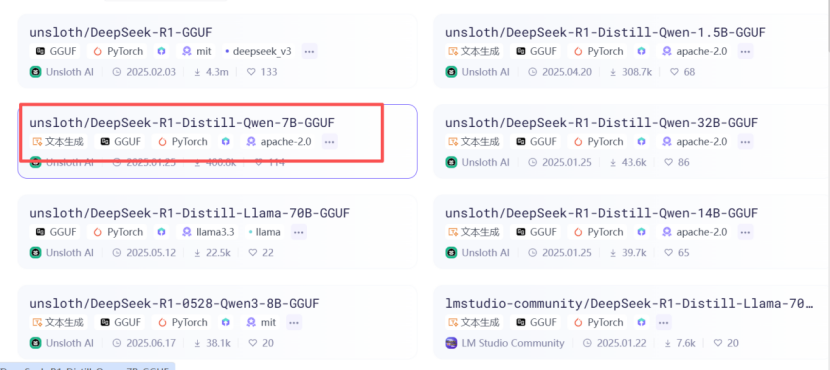

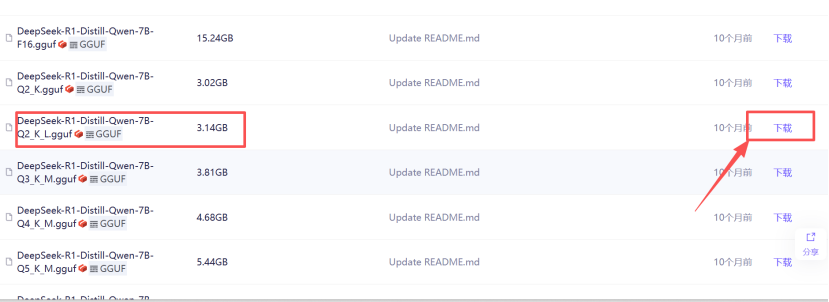

选择需要的大模型版本,点击进入下载页面

选择模型文件

选择适合的精度进行下载,精度越高,模型文件越大,体验越好。

1.3 导入模型运行

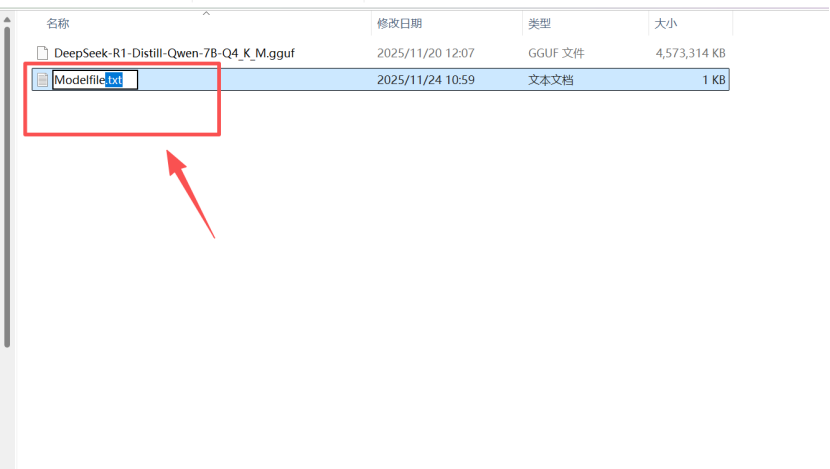

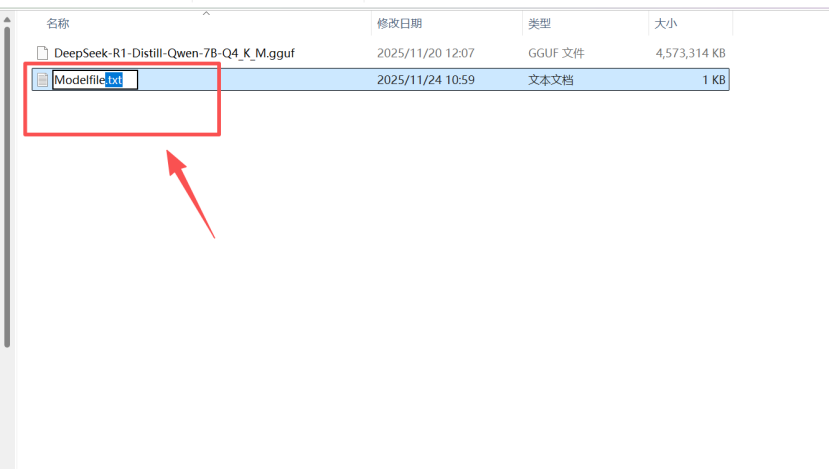

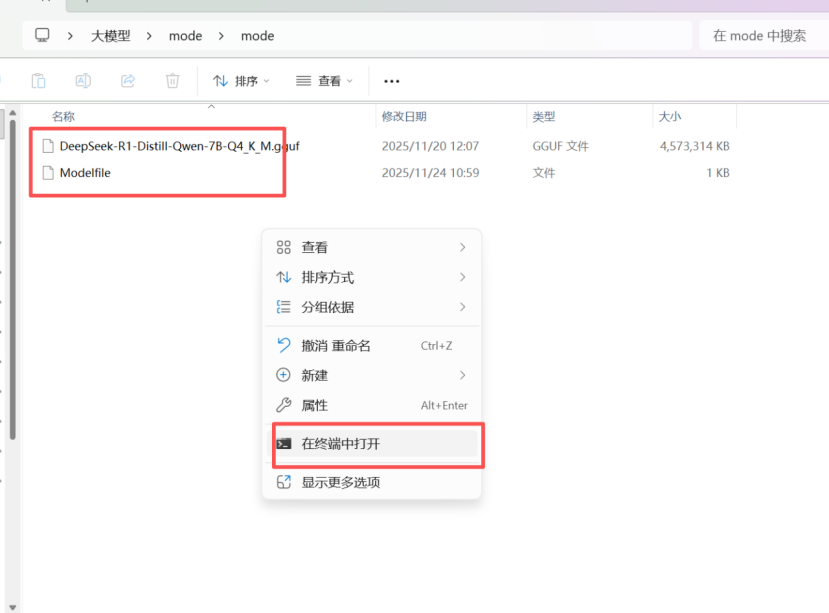

将下载好的模型文件放入一个新的文件夹中

创建一个名为Modelfile的txt文件

在文件内编辑以下格式内容(注意FROM和文件路径中间有空格)

FROM ./DeepSeek-R1-Distill-Qwen-7B-Q4_K_M.gguf

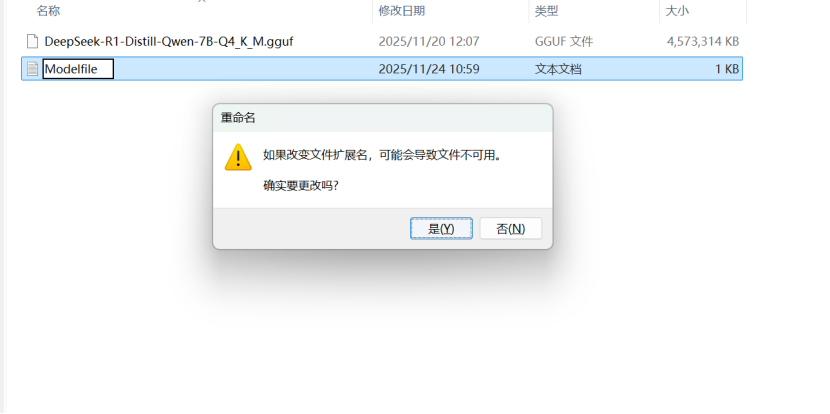

删除文件后缀

若没有看到文件名后缀,可点击查看-显示-文件扩展名 进行调整

在文件夹中,点击右键,选择在终端打开

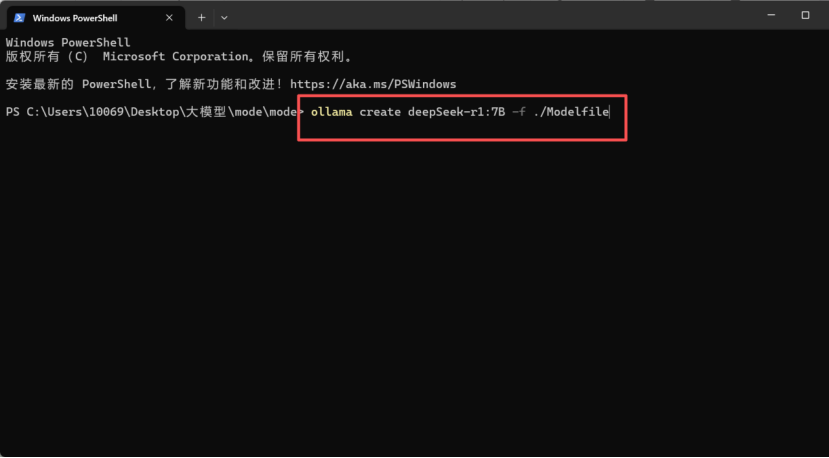

输入以下命令,将大模型文件导入ollama中(模型名称可自定义输入)

ollama create 模型名称 -f ./Modelfile

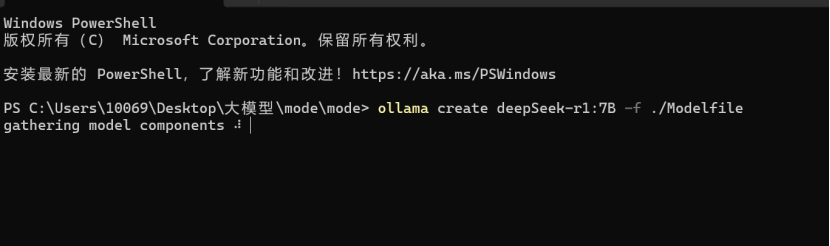

等待模型加载

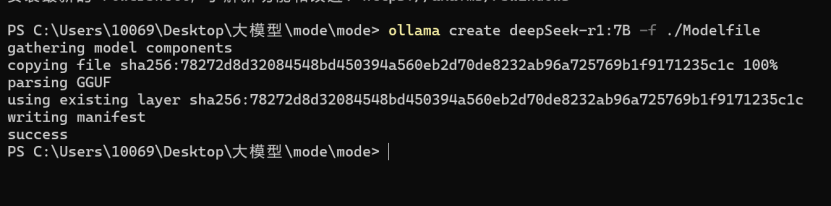

加载完成

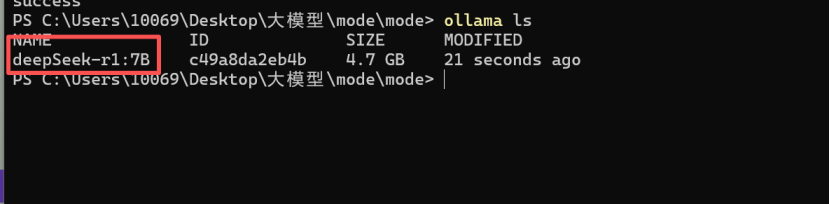

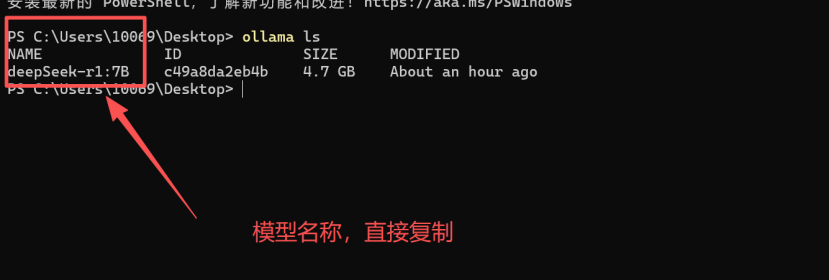

使用ollama ls命令查看已加载的模型文件

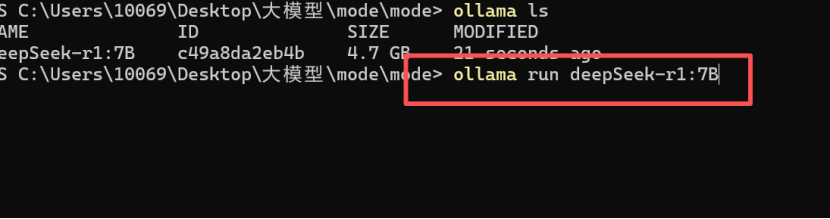

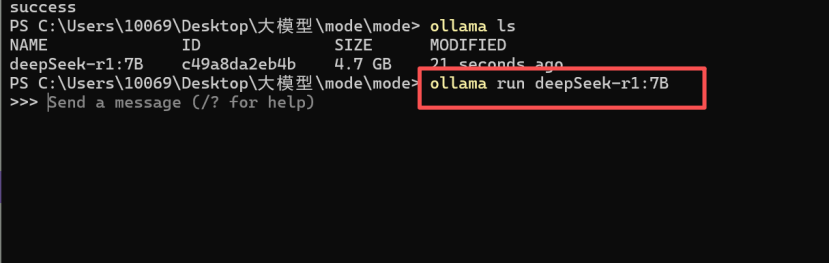

使用以下命令运行模型

ollama run 模型名称

模型运行

使用Ctrl+D可退出对话

2 安装docker

2.1 环境检查

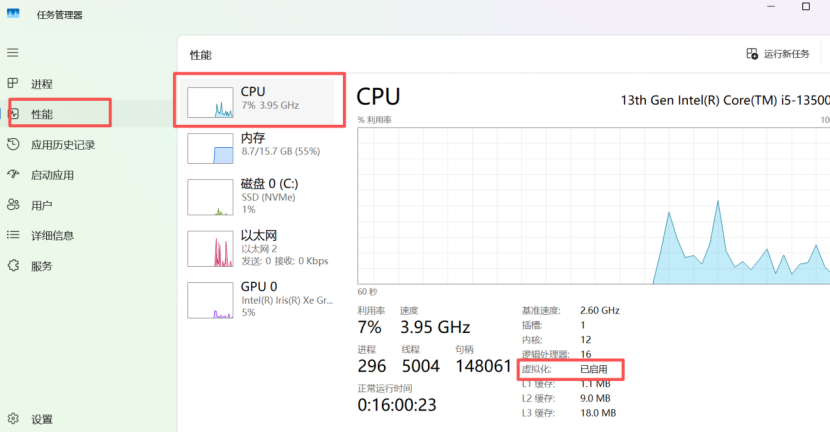

查看当前是否已开启虚拟化,若未开启,需要先开启虚拟化技术才能使用docker

在搜索框中输入任务管理器

点击任务管理器-性能-CPU查看是否开启虚拟化,若未开启需要先开启虚拟化

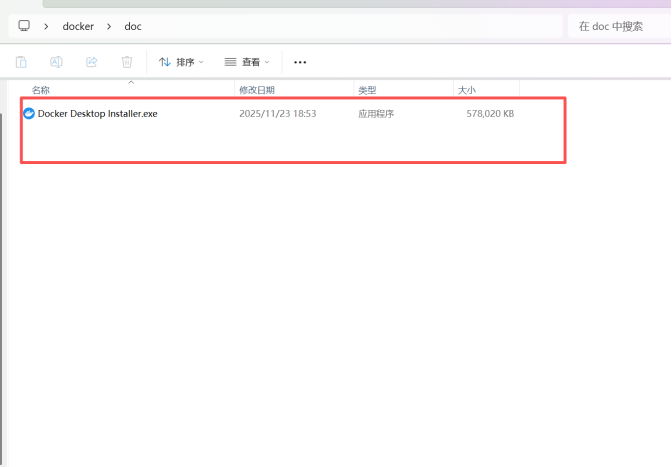

2.1 docker软件下载安装

虚拟化开启后下载docker文件进行安装

Docker下载地址

https://docker.github.net.cn/desktop/install/windows-install/#google_vignette

点击下载

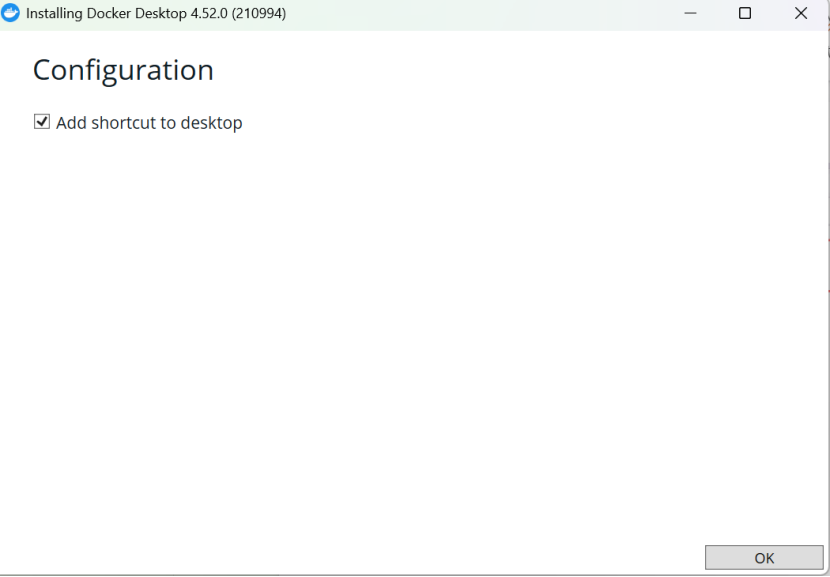

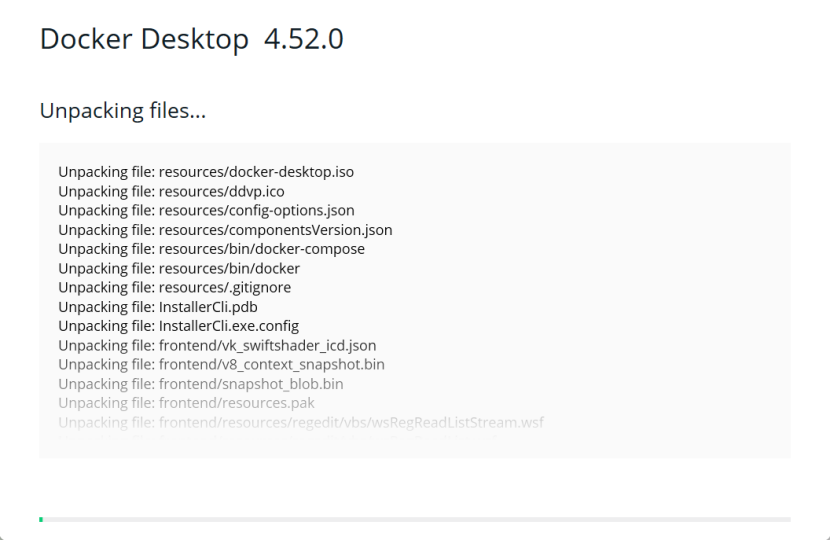

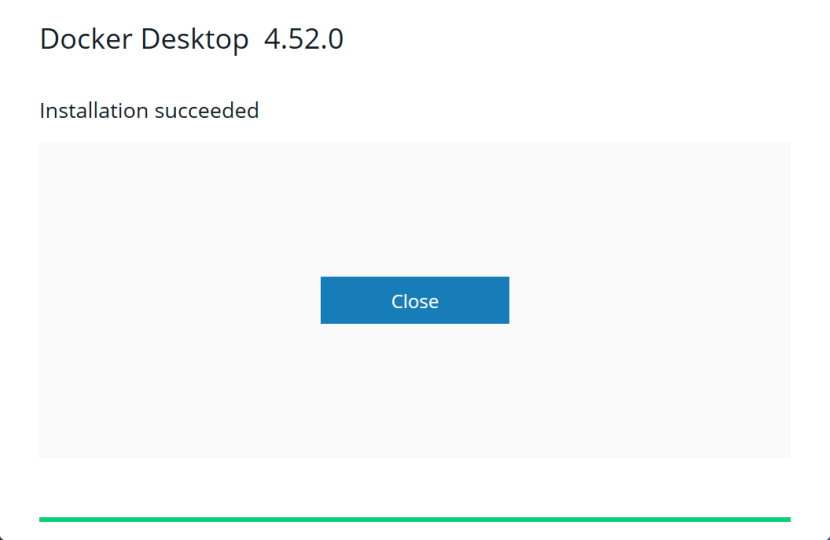

双击运行开始安装

安装完成后,在终端中输入以下命令,安装 Linux 子系统和 WSL2 内核

wsl --install

2.1 docker软件配置

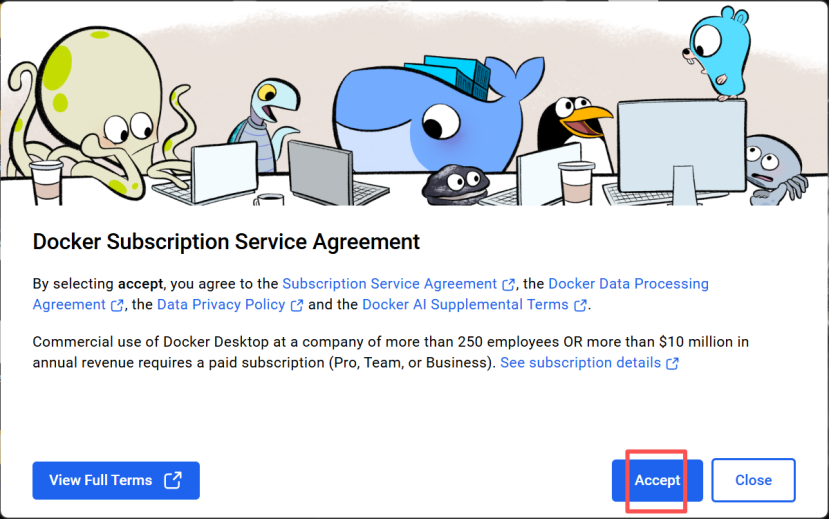

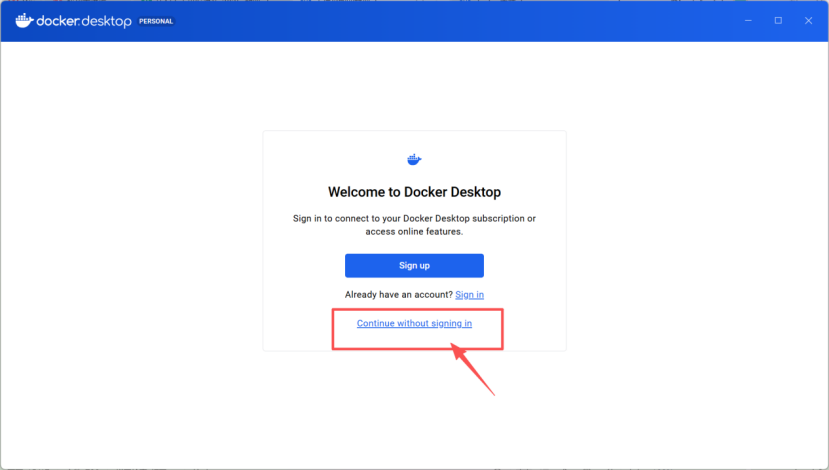

安装完成后,在桌面上打开docker应用

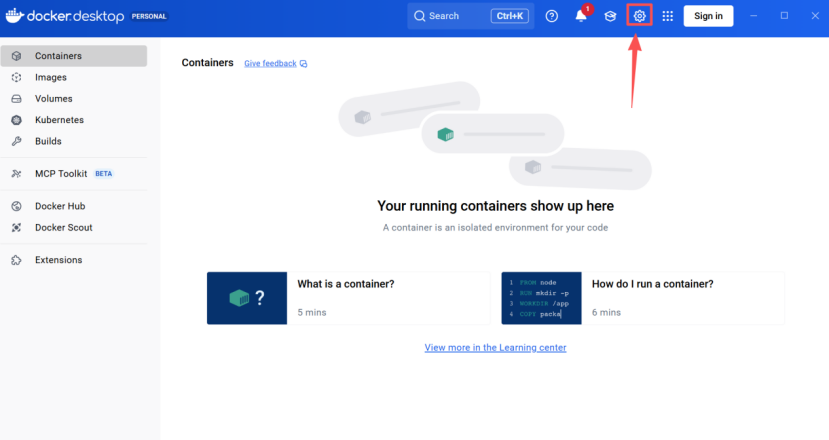

选择设置

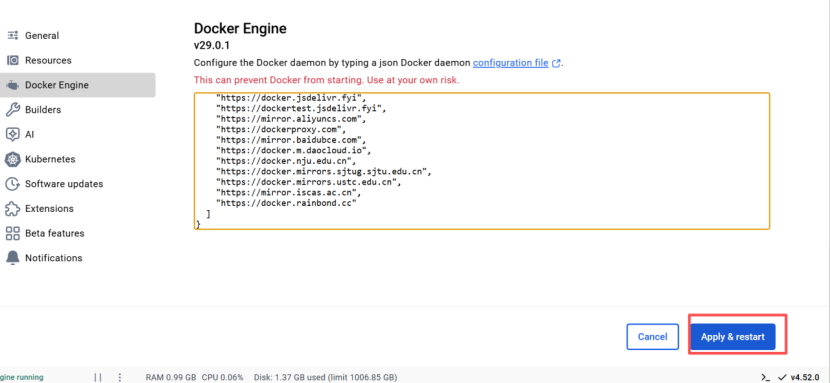

修改docker engine

将以下内容覆盖到docker engine中

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"registry-mirrors": [

"https://2a6bf1988cb6428c877f723ec7530dbc.mirror.swr.myhuaweicloud.com",

"https://docker.m.daocloud.io",

"https://hub-mirror.c.163.com",

"https://mirror.baidubce.com",

"https://your_preferred_mirror",

"https://dockerhub.icu",

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc"

]

}选择应用并重新启动

3 Dify部署与使用

3.1 代码下载

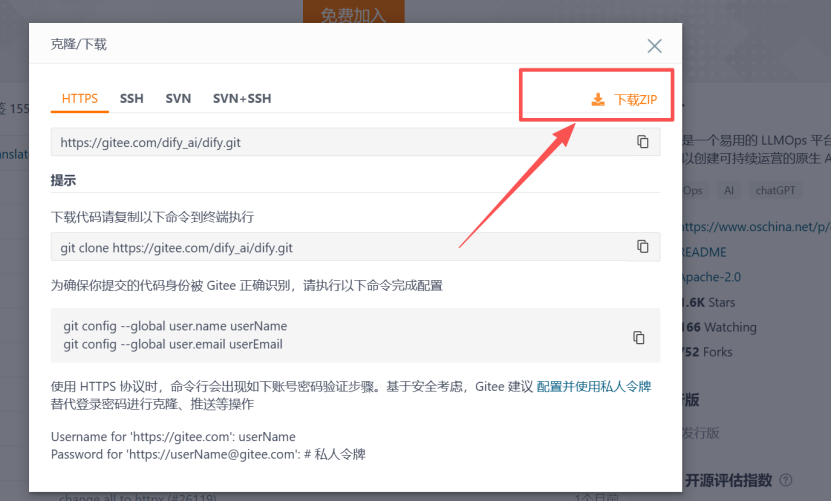

下载Dify相关代码,访问以下网站,点击克隆下载。

https://gitee.com/dify_ai/dify

选择下载zip格式

将下载的文件进行解压

3.2 运行dify平台

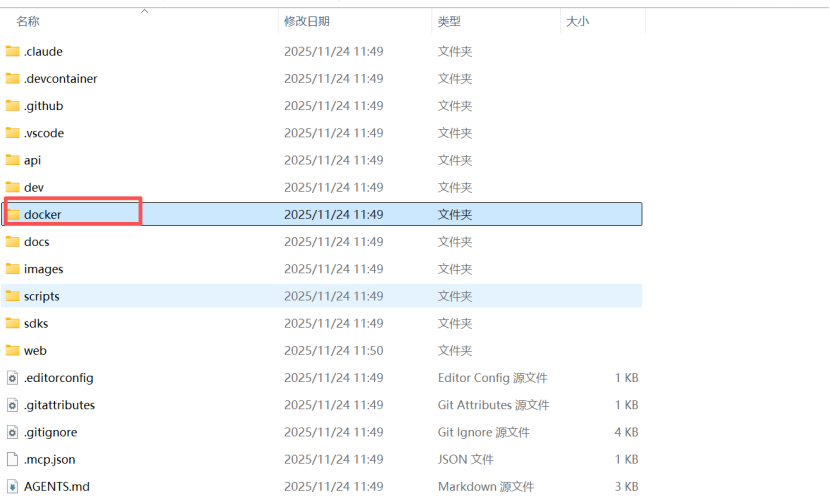

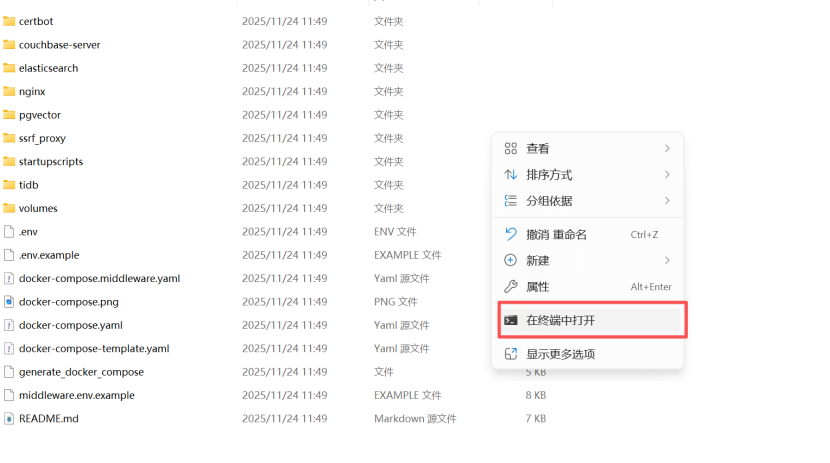

进入docker目录

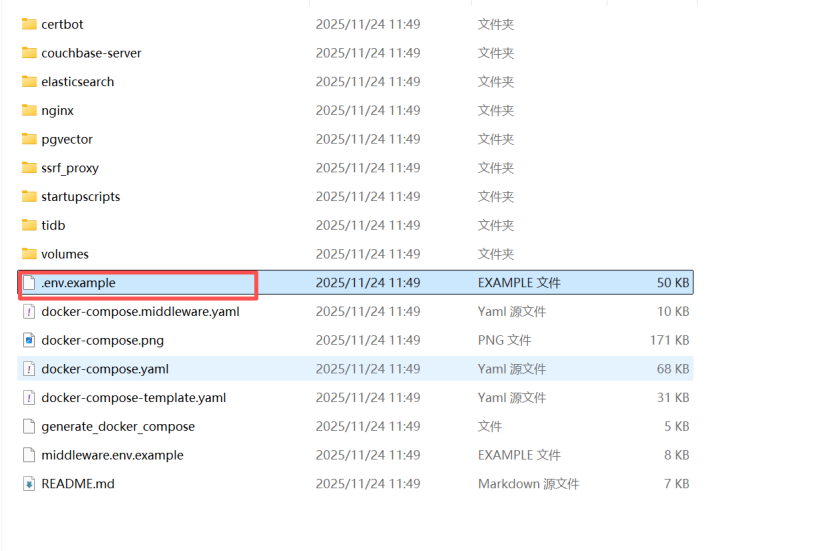

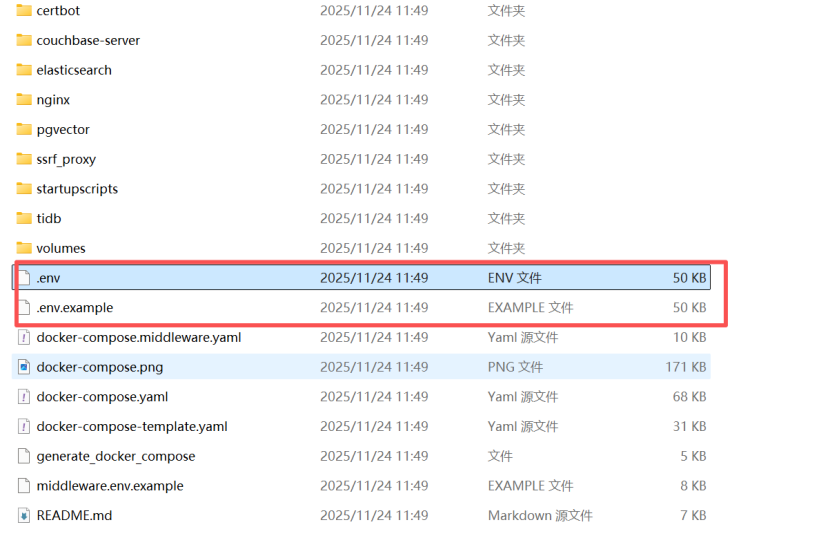

复制.env.example文件并重命名未.env文件

在该文件目录下,选择右键-在终端打开

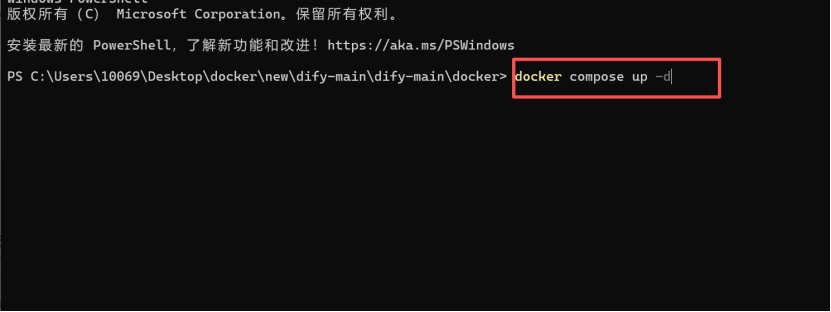

输入以下命令运行并加载dify相关组件

docker compose up -d

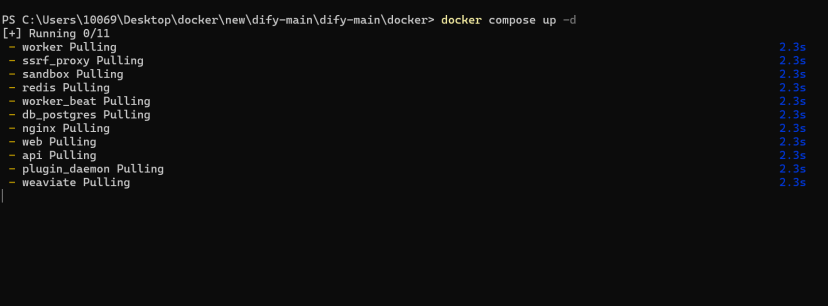

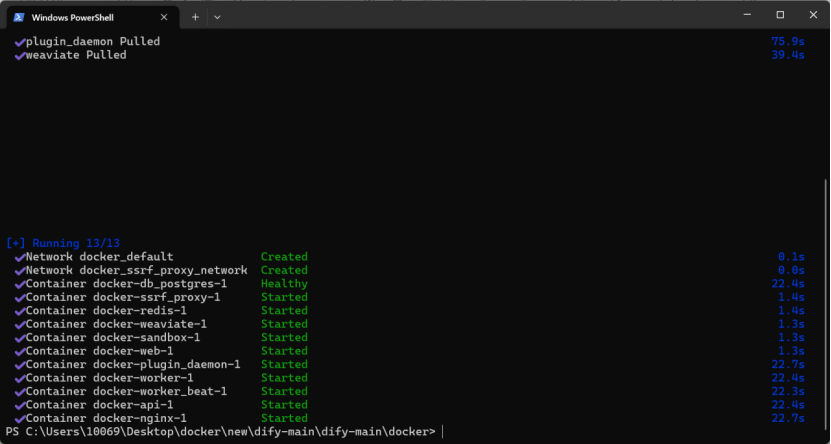

等待相关组件下载

运行完成

3.3 配置ollama

打开浏览器,访问http://127.0.0.1/install,配置dify用户密码

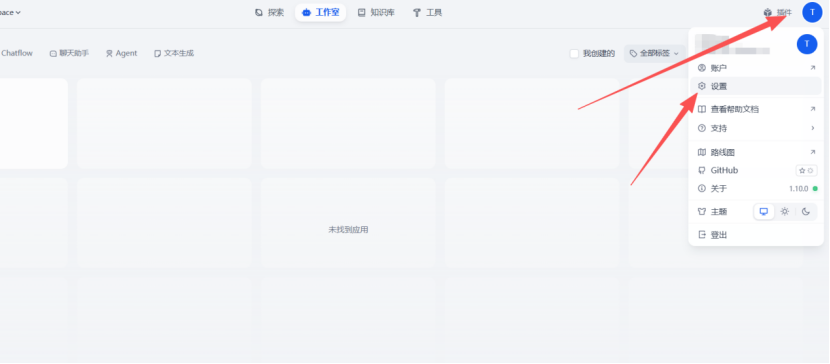

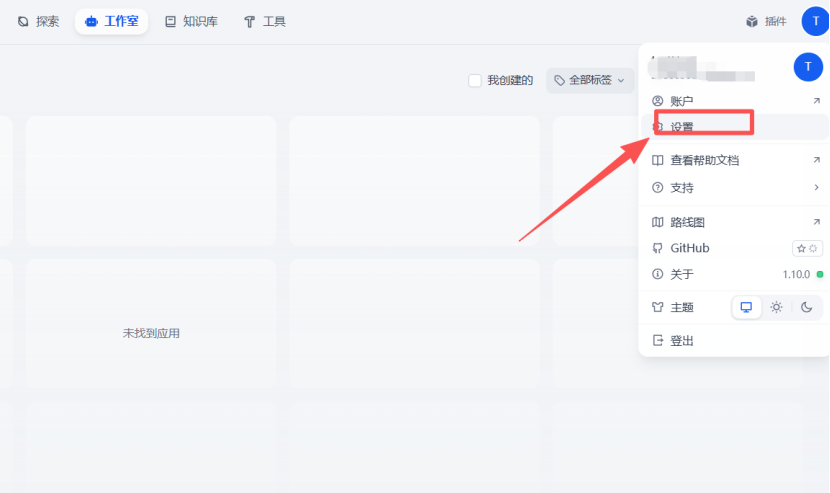

点击头像,选择设置

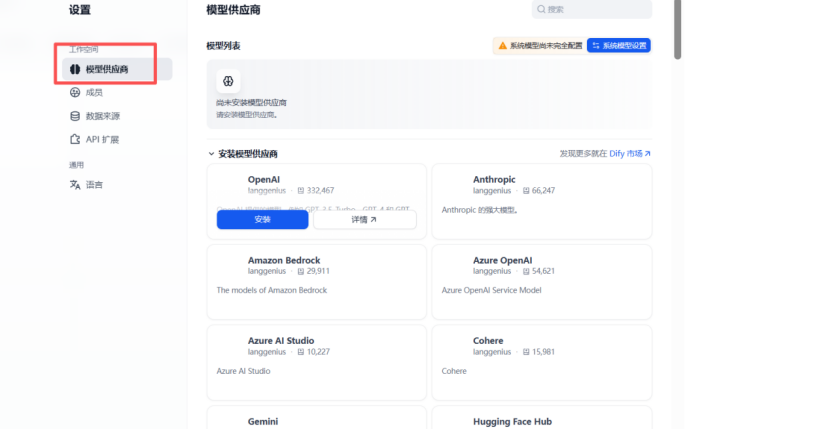

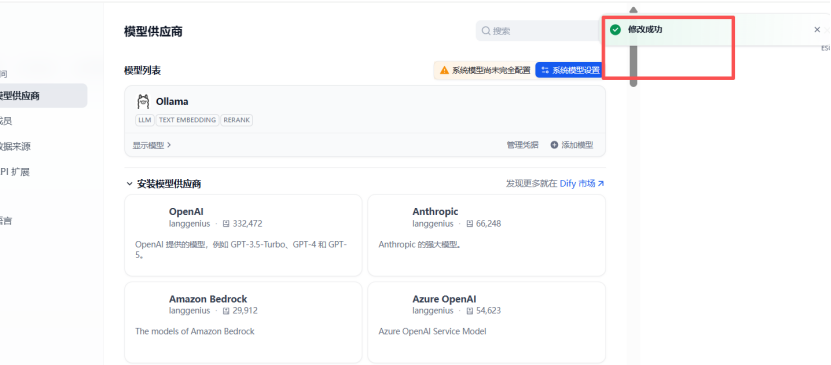

选择模型供应商

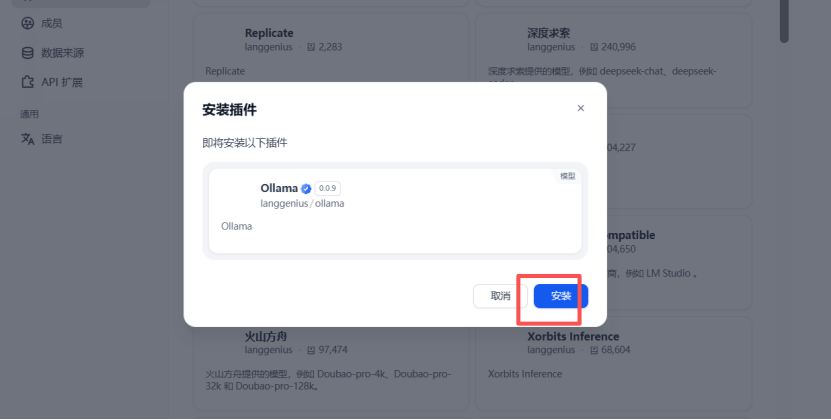

找到ollama,点击安装

安装完成

3.4 环境配置

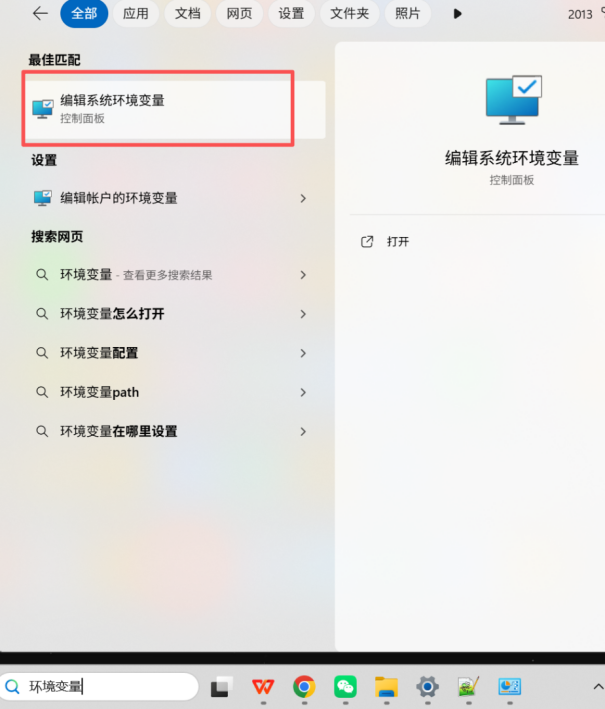

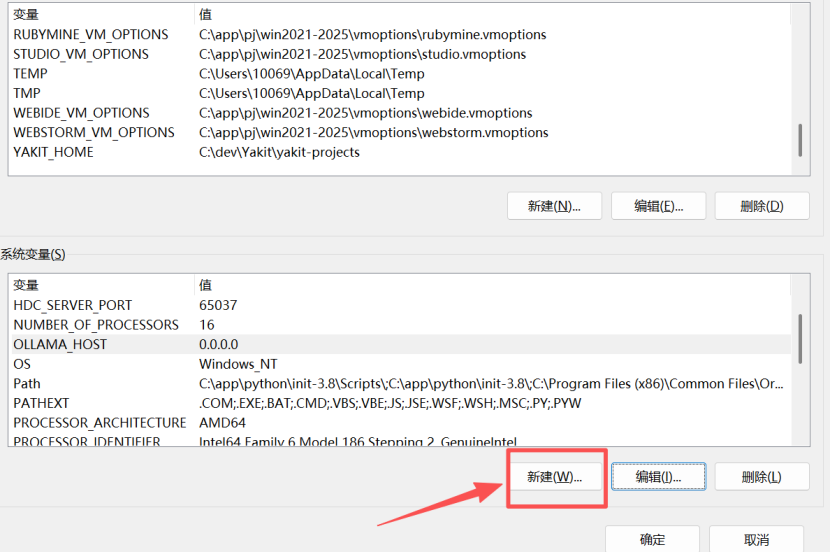

配置ollama环境变量,在搜索栏输入环境变量

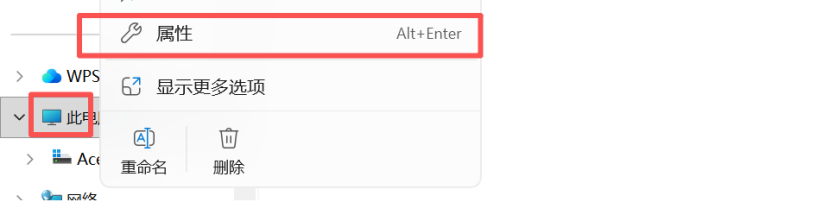

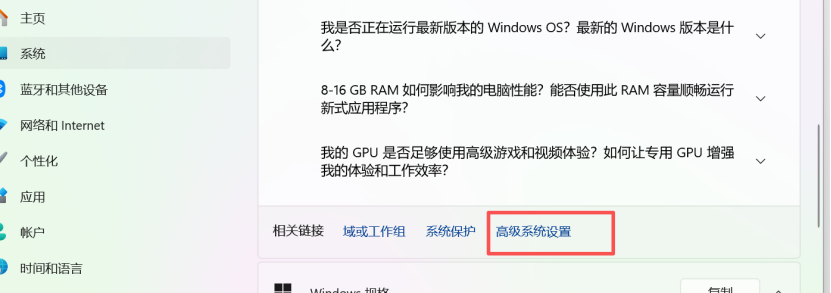

或点击电脑-右键属性中选择高级系统设置-环境变量

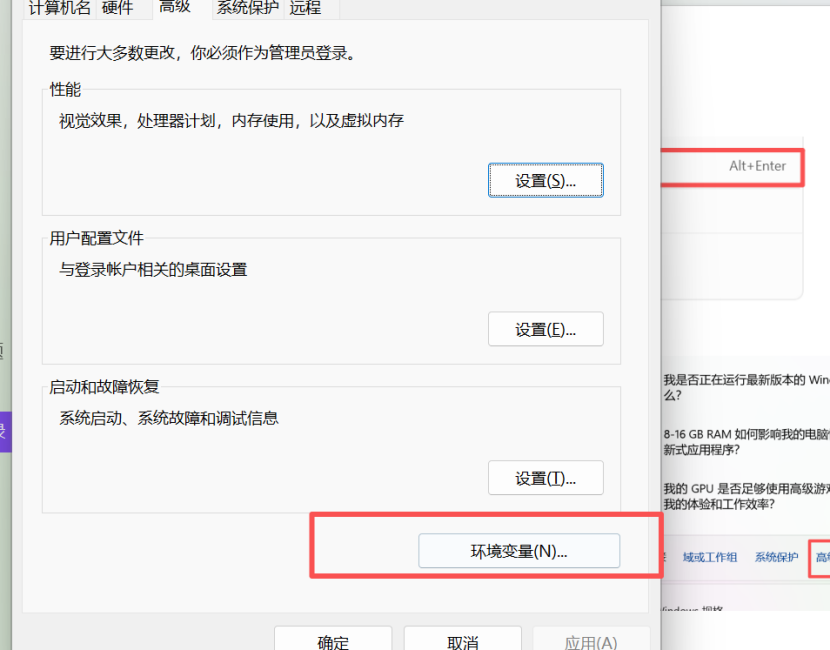

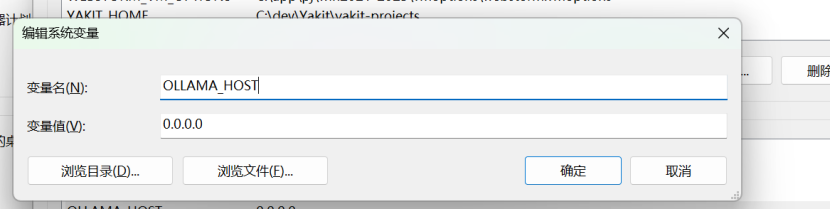

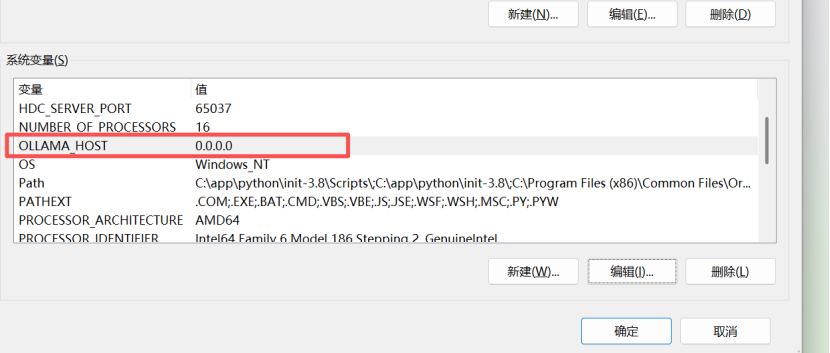

在系统变量中添加新的环境变量

变量:OLLAMA_HOST 值:0.0.0.0

环境变量添加完成后需要重启ollama服务

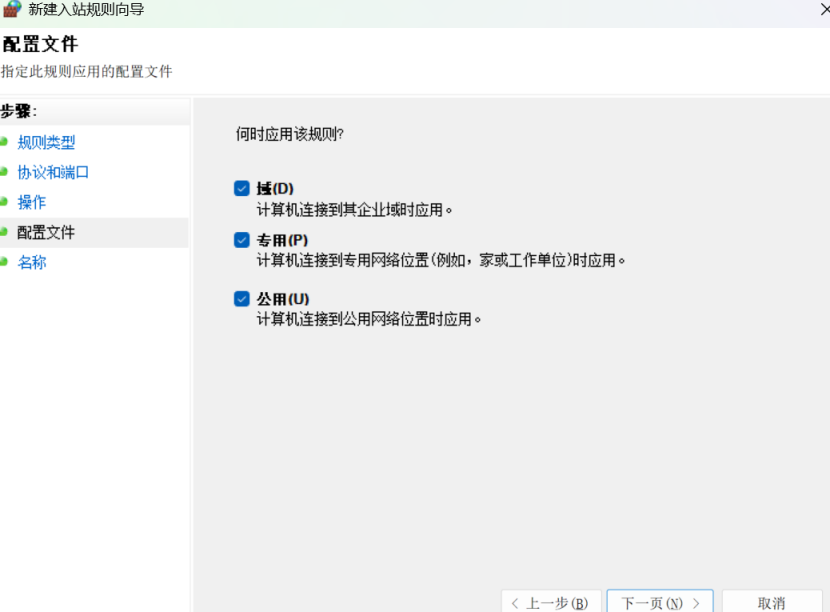

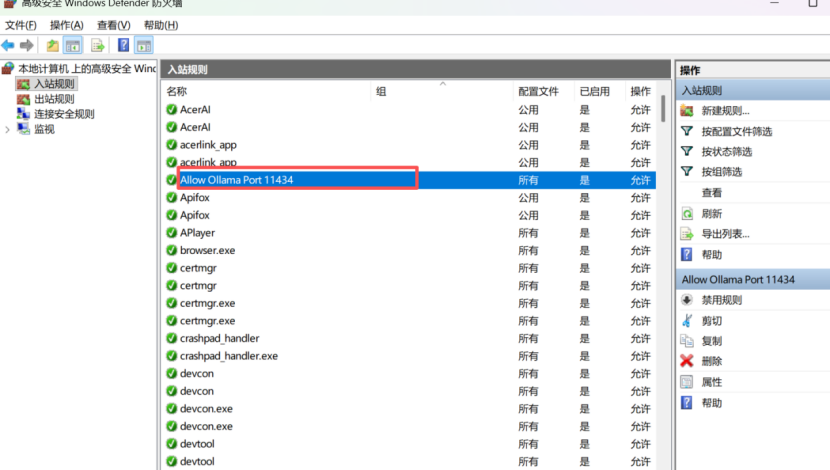

3.5 防火墙配置

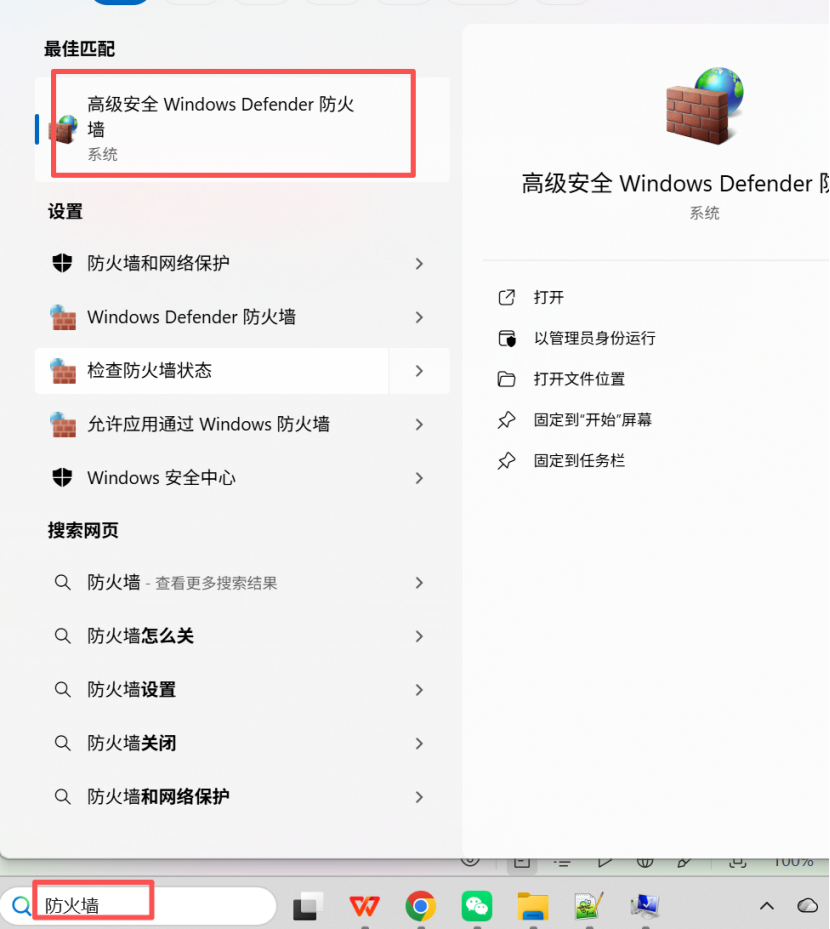

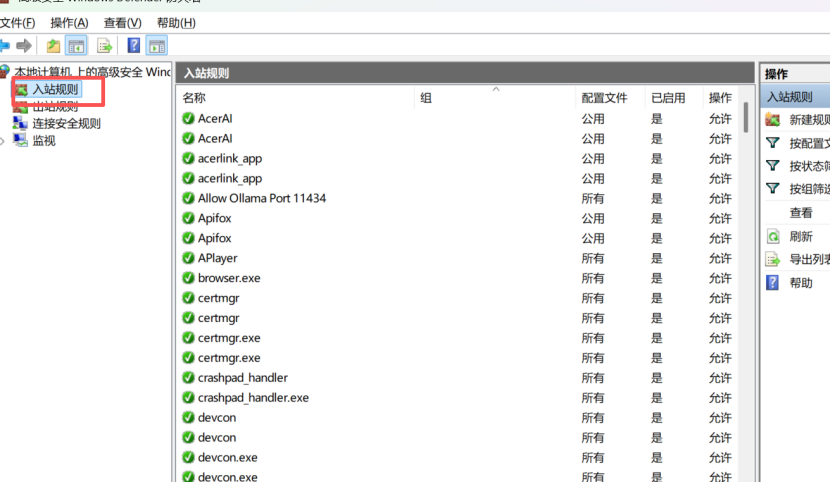

配置防火墙,在搜索栏中查找防火墙配置

选择入站规则

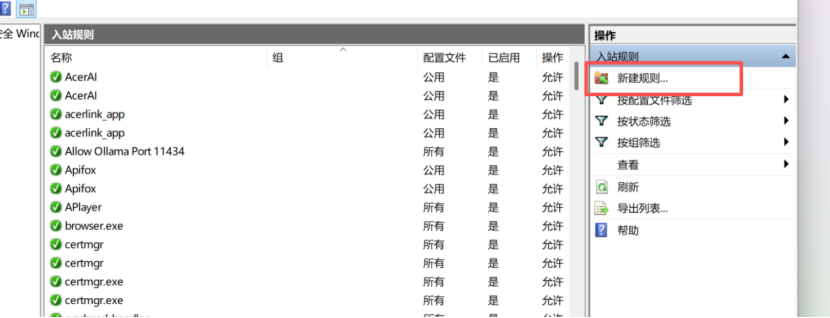

新建规则

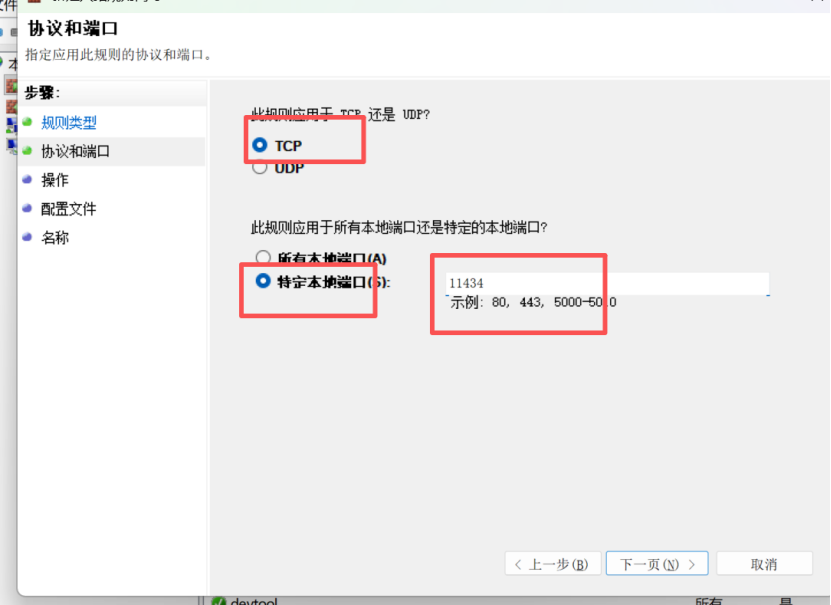

特定本地端口:11434

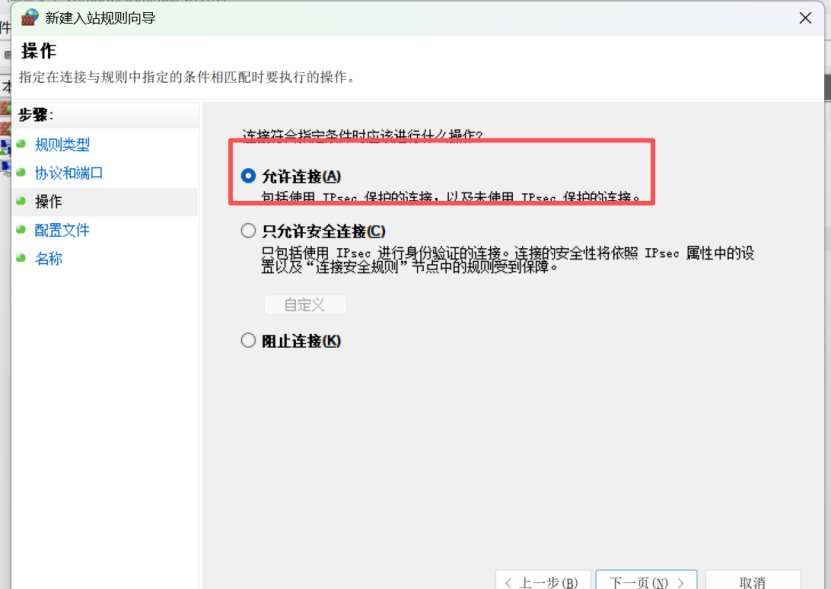

输入名称,点击确定,完成配置

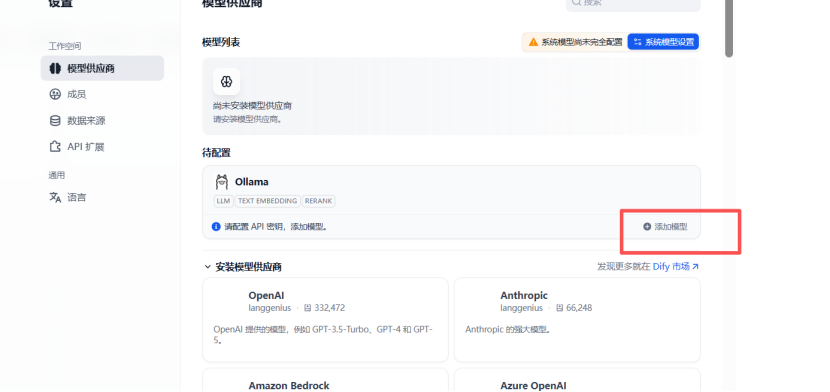

3.6 接入本地ollama

打开dify平台,在设置,供应商模型中点击已安装的ollama

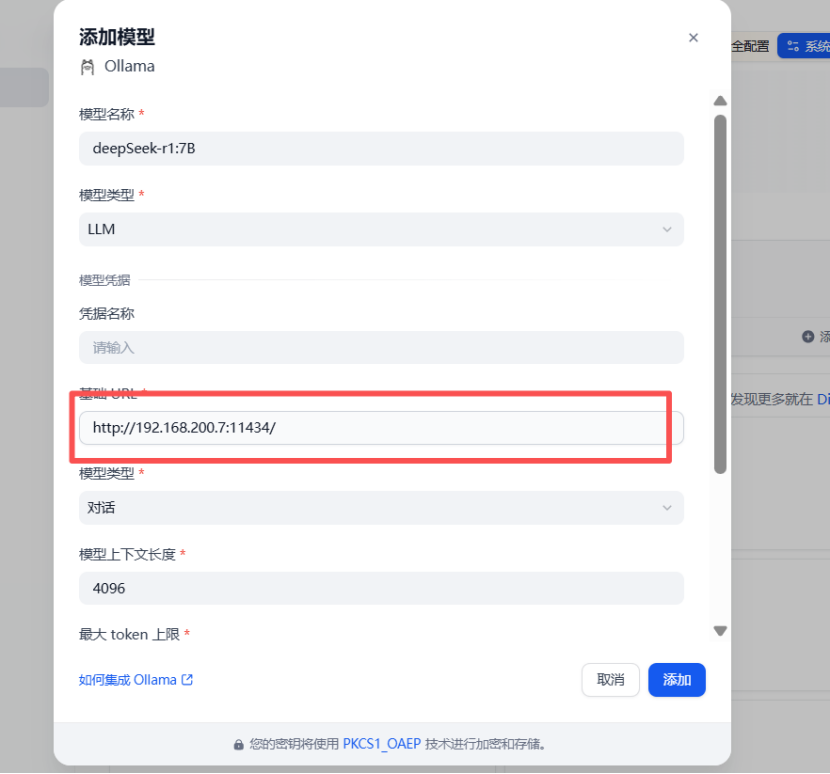

添加模型

输入模型名称,基础url并选择模型类型。

模型名称查看方式:

在终端,输入ollama ls

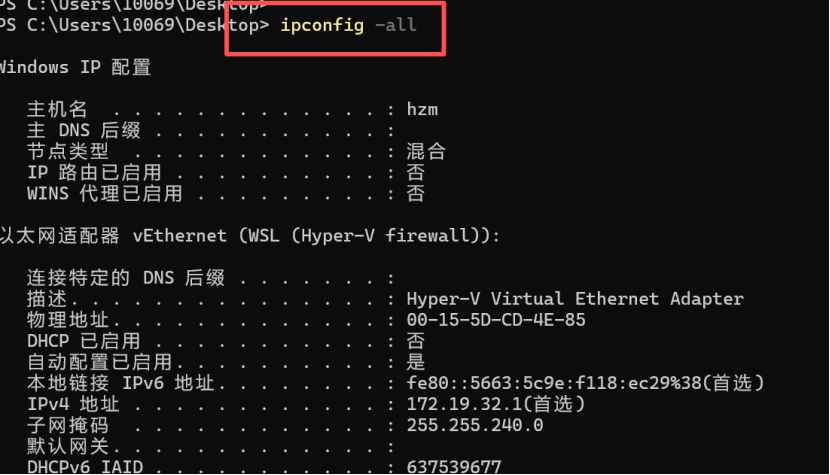

基础url查看方式:

在终端输入ipconfig -all

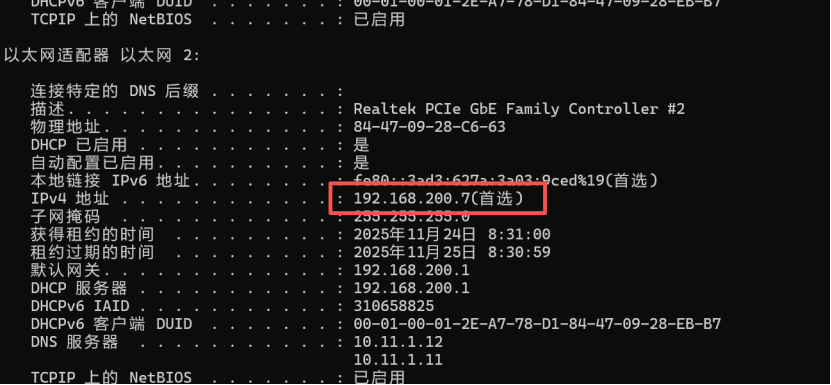

选择本机地址

Ip需替换为自己的ip地址,端口号默认为11434

http://192.168.200.7:11434/

添加成功

3.7 创建应用

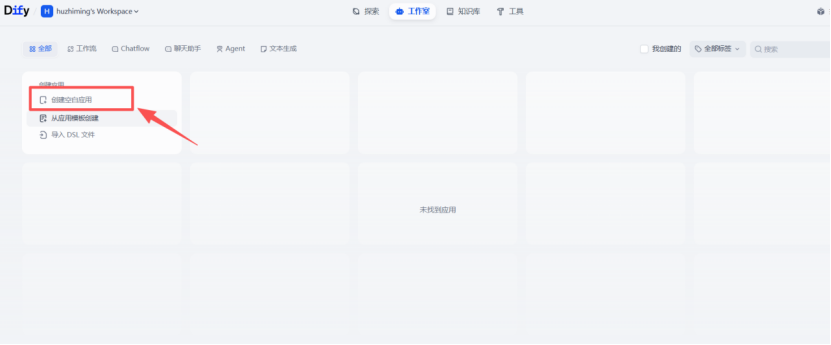

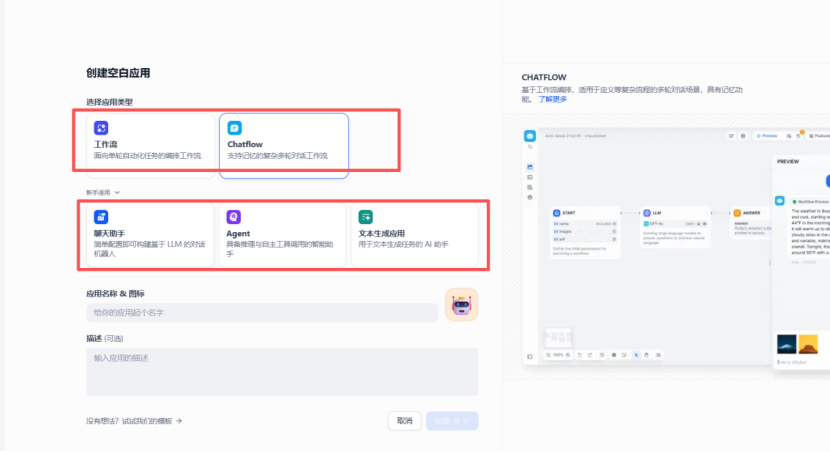

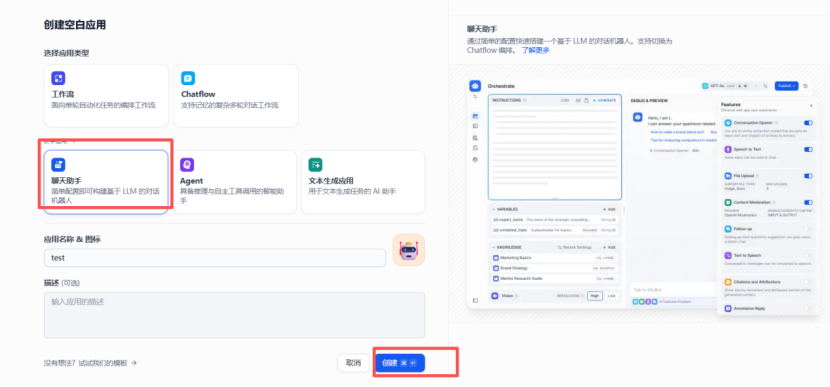

在dify平台首页,创建空白应用

可选择工作流或聊天助手

选择聊天助手并创建

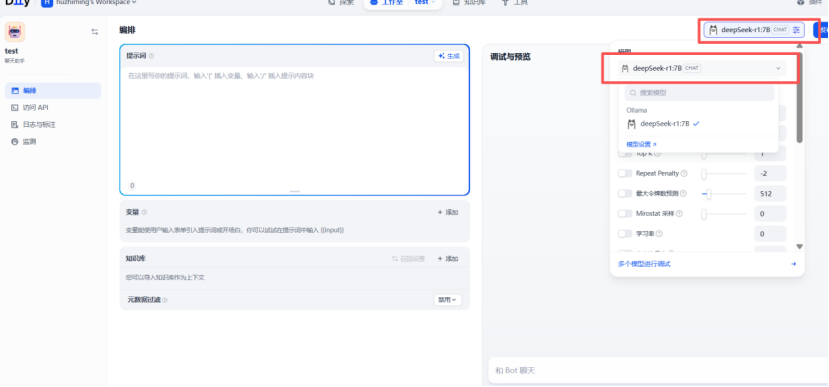

若部署有多个大模型,可在右上角选择切换

3.8 搭建本地知识库

在dify平台点击知识库

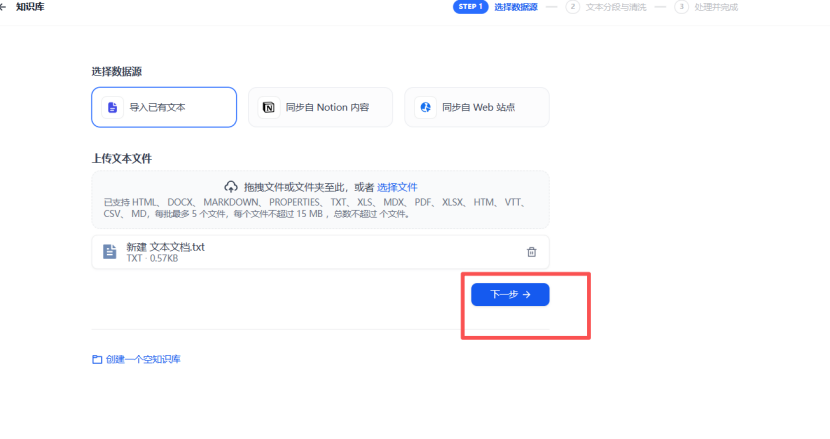

创建知识库

导入文件

点击下一步

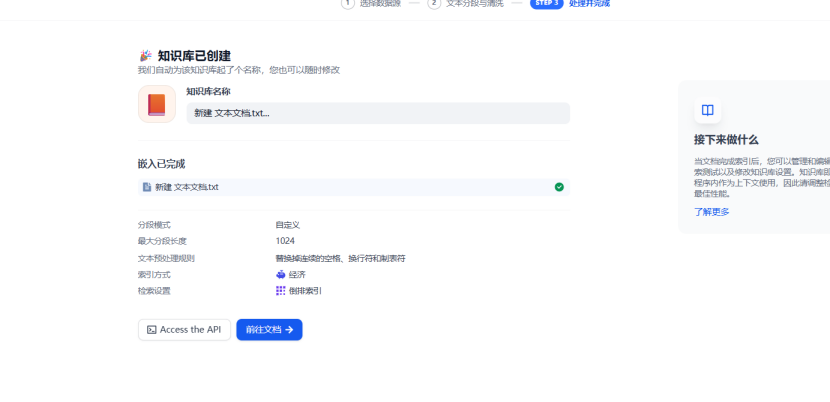

根据需要选择文本处理方式并点击保存

知识库创建完成

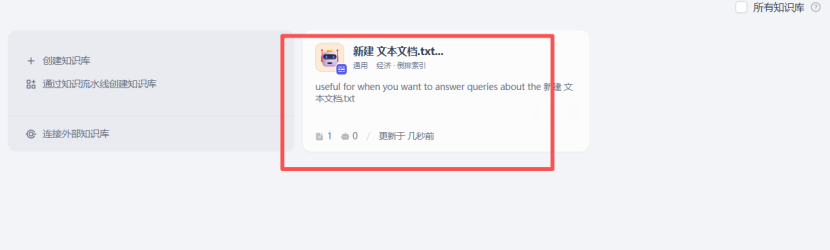

3.9 关联本地知识库

在dify首页,选择工作室,点击刚创建的应用

添加知识库

选择并添加

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)