“你的Agent又在‘一本正经地胡说八道’?” 别再调Prompt了,HaluMem正在精准“抓内鬼”!

近年来,大型语言模型(LLM)和Agent在个性化交互和长期学习方面展现出巨大潜力,但其核心挑战之一是如何有效管理“记忆”。想象一下,如果AI在与你多次对话后,仍然记错你的喜好、混淆事件细节,甚至虚构信息,这种“记忆幻觉”会严重破坏交互的连贯性和可信度。现有评估方法大多采用端到端的问答测试,就像只检查考试成绩而不分析错题原因,无法定位幻觉究竟发生在记忆的哪个环节——是提取时记错了?更新时没改对?还

近年来,大型语言模型(LLM)和Agent在个性化交互和长期学习方面展现出巨大潜力,但其核心挑战之一是如何有效管理“记忆”。想象一下,如果AI在与你多次对话后,仍然记错你的喜好、混淆事件细节,甚至虚构信息,这种“记忆幻觉”会严重破坏交互的连贯性和可信度。现有评估方法大多采用端到端的问答测试,就像只检查考试成绩而不分析错题原因,无法定位幻觉究竟发生在记忆的哪个环节——是提取时记错了?更新时没改对?还是回答时胡编乱造?

- 论文:HaluMem: Evaluating Hallucinations in Memory Systems of Agents

- 链接:https://arxiv.org/pdf/2511.03506

为此,这篇论文提出了HaluMem——首个面向记忆系统的操作级别幻觉评估基准。它通过三大任务(记忆提取、更新、问答)和两个大规模数据集(HaluMem-Medium和HaluMem-Long),系统性地揭示了记忆系统在不同操作阶段的幻觉行为。研究不仅构建了高质量的数据集,还通过实验验证了当前主流记忆系统的瓶颈,为未来开发更可靠的记忆机制提供了重要指导。接下来,我们将深入解读这项工作的设计、方法与发现。

一、研究动机与问题定义

记忆系统的作用与挑战

记忆系统是AI代理实现长期交互的核心组件,它能从多轮对话中提取用户信息(如个人资料、事件、偏好),并以结构化的方式存储和更新。例如,系统可能记录“用户喜欢咖啡”或“用户上周去了巴黎”,并在后续对话中检索这些信息以生成个性化回复。代表性系统包括MemOS、Mem0、Zep等,它们通过外部存储(如向量数据库或知识图谱)增强模型的记忆能力。

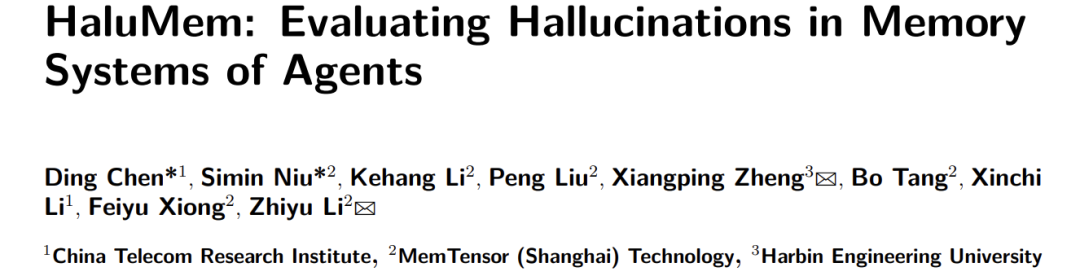

然而,记忆系统在运行中常出现幻觉,表现为四种类型:

- 虚构:系统添加了对话中未出现的信息。

- 错误:存储的信息与事实不符。

- 冲突:新旧记忆不一致。

- 遗漏:关键信息未被记录。

这些幻觉会像“传染”一样,在提取、更新和回答阶段不断累积和放大,最终导致生成内容不可靠。

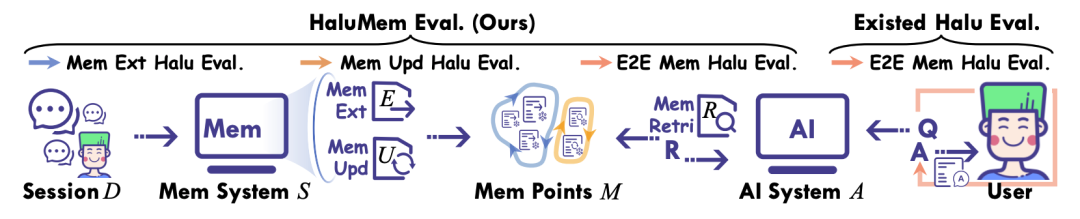

现有评估方法的不足

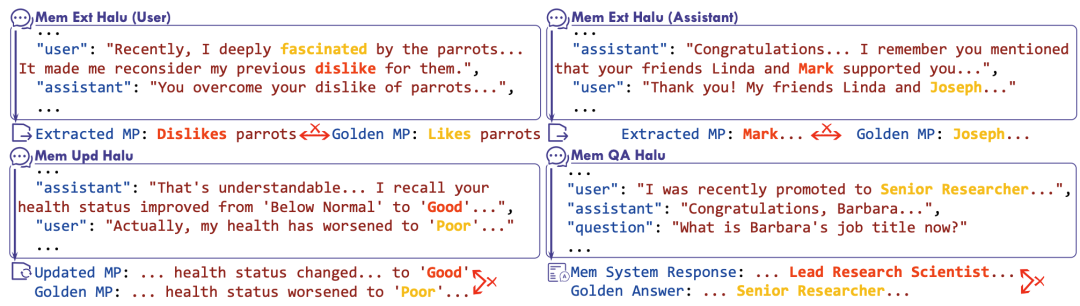

当前评估多采用端到端问答,例如向系统提问“用户喜欢什么?”,然后比较答案与标准答案的匹配度。这种方法无法 pinpoint 幻觉的具体来源——是提取时漏了信息?更新时没修正?还是回答时瞎猜?如表2所示,现有基准(如PersonaMem、LOCOMO)虽能测试记忆保留能力,但都是“黑箱”评估,缺乏操作级别的细粒度分析。

HaluMem的目标正是填补这一空白。它通过定义三个操作阶段(提取E、更新U、问答Q),并为每个阶段提供标准答案,使研究者能精准定位幻觉来源。例如,若系统在提取阶段未记录“用户讨厌香菜”,后续问答中就可能虚构答案,而HaluMem能明确识别这种错误源自提取环节。

二、HaluMem基准设计

三大评估任务

HaluMem的核心是三个任务,覆盖记忆系统的完整生命周期:

- 记忆提取:评估系统能否从对话中正确识别并存储关键信息,避免虚构或遗漏。

- 记忆更新:测试系统在接收到新信息时,能否正确修改、合并或替换旧记忆,保持一致性。

- 记忆问答:端到端测试系统能否基于记忆生成准确回答,反映整体性能。

数据集构建:六阶段流程

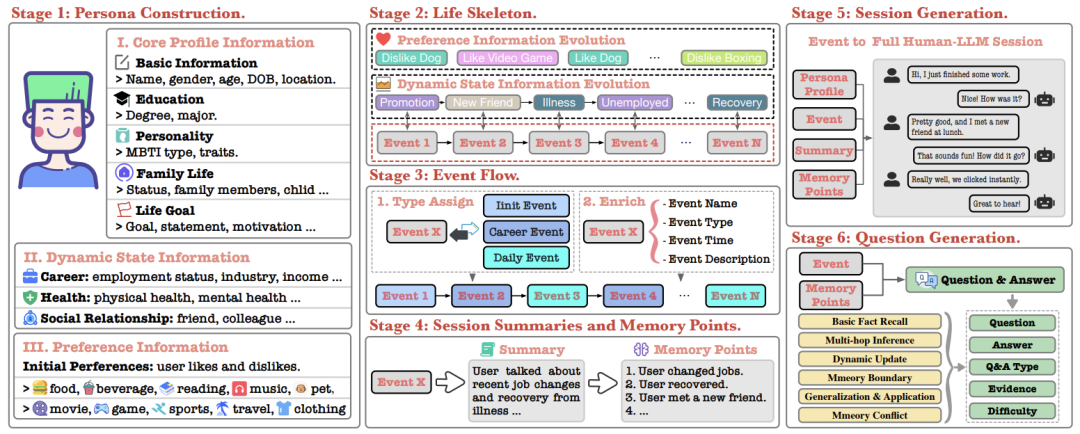

为了构建高质量数据,研究团队设计了一个用户中心的六阶段流程(图3),模拟真实用户的长期交互:

- 阶段1:用户画像构建:创建虚拟用户,包括核心资料(如职业、年龄)、动态状态(如健康、社交)和偏好(如食物、音乐)。

- 阶段2:人生骨架设计:定义用户的长期演变轨迹,如职业事件和偏好变化。

- 阶段3:事件流生成:将抽象骨架转化为具体事件序列,包括初始事件、职业事件和日常事件。

- 阶段4:会话摘要与记忆点:将事件转化为多轮对话,并标注标准记忆点。

- 阶段5:会话生成:生成包含干扰内容的对话,测试系统的抗干扰能力。

- 阶段6:问题生成:基于记忆点设计六类问题(如事实回忆、多跳推理等),用于评估。

数据集特点

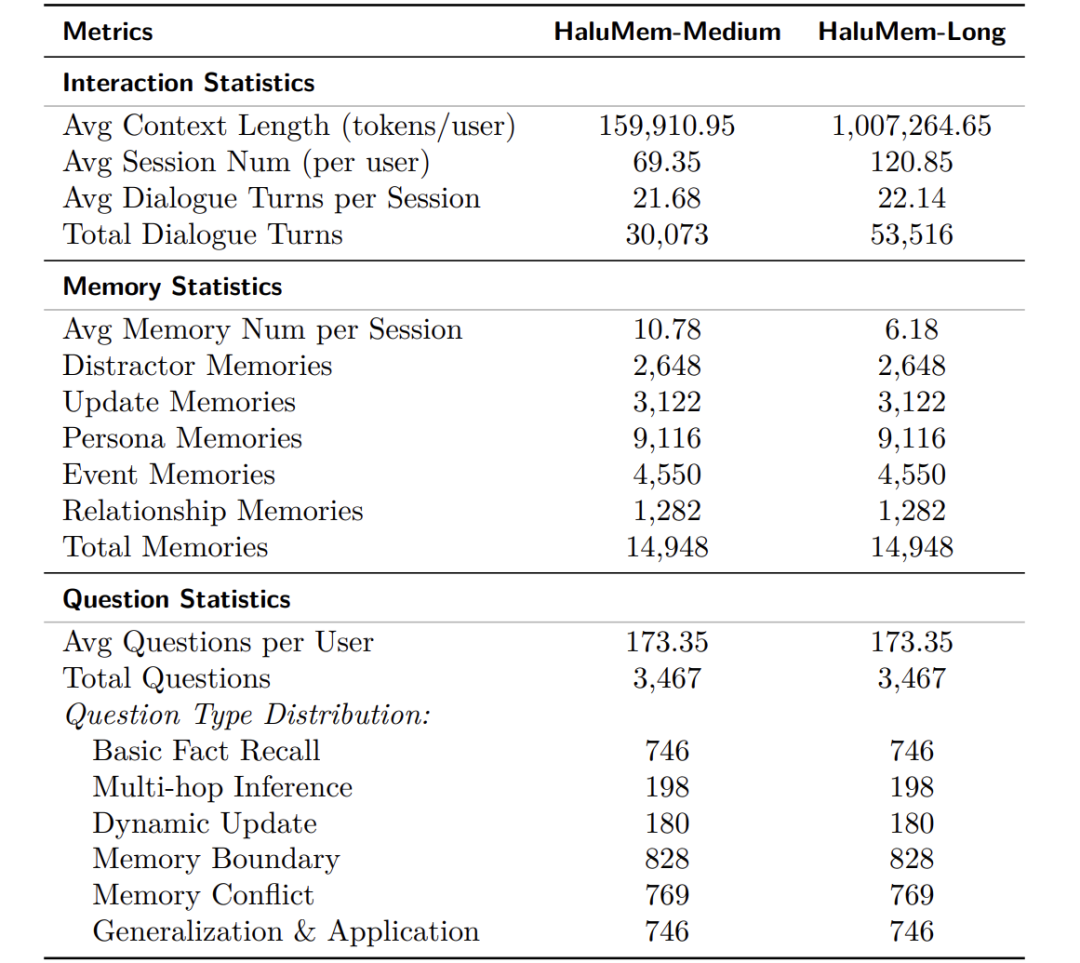

HaluMem包含两个数据集:

- HaluMem-Medium:平均对话长度1.5万词,包含约1.5万记忆点和3467个问题。

- HaluMem-Long:通过插入无关对话将上下文扩展至百万词级别,测试系统在超长对话中的鲁棒性。

如下表所示,数据集覆盖了多种记忆类型(人物、事件、关系)和问题类型,确保了评估的全面性。

三、评估框架与指标

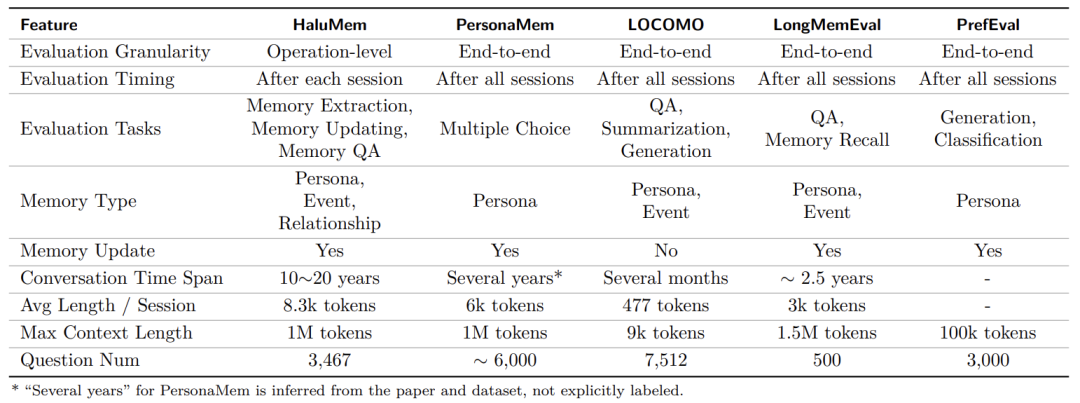

评估流程与API设计

HaluMem的评估是会话级别的:系统按顺序处理对话会话,并在每个会话后立即触发评估。系统需提供三个API:

- 添加对话API:输入对话并自动提取记忆。

- 获取对话记忆API:返回系统从指定会话提取的记忆点。

- 检索记忆API:根据查询返回最相关的记忆内容。

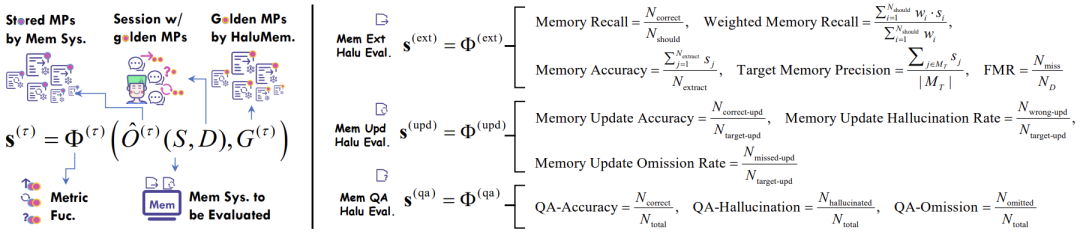

评估流程的简化视图

任务指标详解

每个任务都有针对性的指标,以下是关键公式的解释:

- 记忆提取任务:

- 记忆完整性:衡量系统是否遗漏关键信息。其中,是应提取的记忆数量,是正确提取的数量,是记忆重要性权重,是提取分数(完全提取为1,部分为0.5,遗漏为0)。

- 记忆准确性:评估提取的记忆是否真实、无幻觉。

- 错误记忆抵抗:测试系统抵抗干扰信息的能力。是干扰记忆总数,是被系统成功忽略的数量。

- 记忆更新任务:

- 更新准确率:正确更新项的比例。

- 更新幻觉率:错误或虚构更新的比例。

- 更新遗漏率:应更新但未更新的比例。

- 记忆问答任务:

- 问答准确率:正确答案的比例。

- 问答幻觉率:包含虚构或错误信息的比例。

- 问答遗漏率:因记忆缺失而未回答的比例。

这些公式使评估可量化,并能精准定位幻觉阶段。

四、实验与结果分析

实验设置

研究评估了五种主流记忆系统:Mem0(标准版和图版本)、Memobase、Supermemory和Zep。使用GPT-4o进行自动化评分,确保一致性。实验在HaluMem-Medium和HaluMem-Long上运行,并记录了时间消耗。

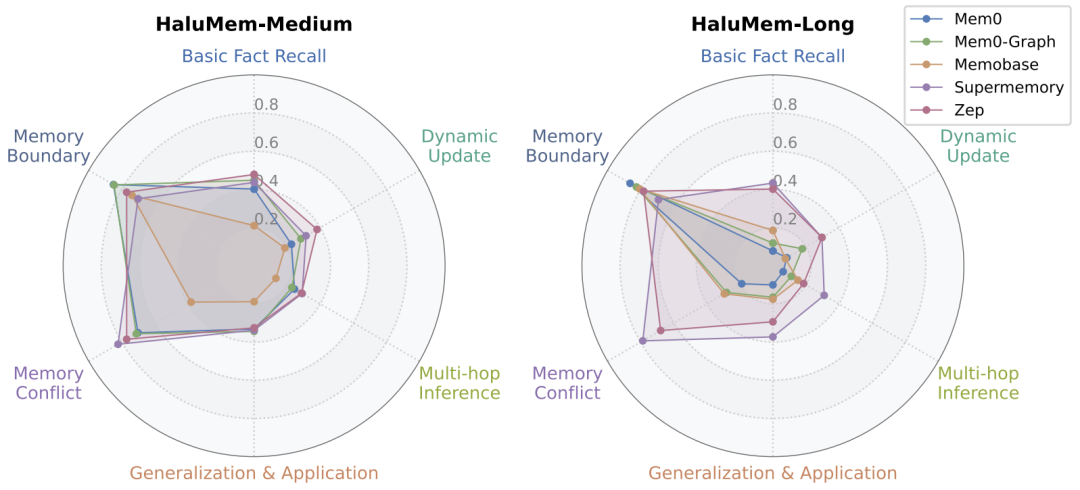

整体性能分析

整体来看,系统在HaluMem-Long上的性能普遍下降,尤其是Mem0和Memobase,提取的记忆数量显著减少。这表明当前系统在处理超长上下文时面临挑战。

所有系统在三大任务上的表现

关键发现:

- 记忆提取:所有系统的召回率低于60%,准确性低于62%,说明多数系统漏提关键信息或产生幻觉。Supermemory在错误记忆抵抗上表现最差,因其倾向于过度提取。

- 记忆更新:正确更新率低于50%,遗漏率超过50%。上游提取不足直接导致更新失败。

- 记忆问答:最佳系统的准确率仅56%,且幻觉和遗漏率较高,说明端到端性能严重依赖上游记忆质量。

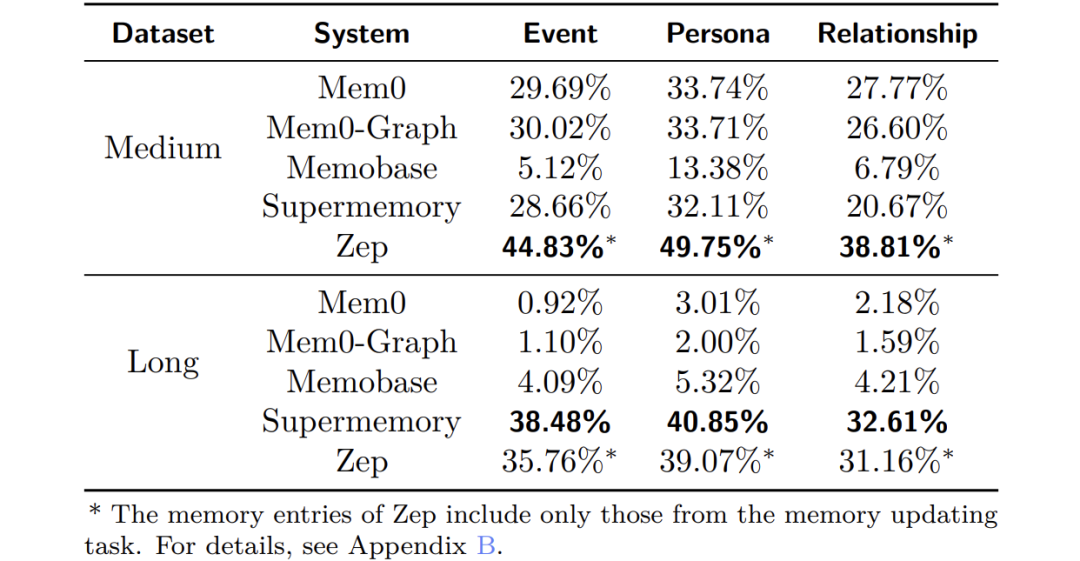

不同类型记忆的准确性

Zep在中等数据集上表现最佳,而Supermemory在长数据集上领先。人物记忆(静态特质)更容易捕获,事件和关系记忆(动态变化)则更具挑战性。

比较系统在事件、人物和关系记忆上的提取准确性。

不同问题类型的表现

图5显示,所有系统在多数问题类型上准确率较低,尤其在多跳推理和动态更新任务上。Mem0系列在长上下文下性能显著下降,而Supermemory和Zep表现稳定。系统在“记忆边界”和“记忆冲突”问题上相对较好,表明它们能识别未知或矛盾信息。

效率分析

对话添加时间远高于检索时间,表明记忆提取和更新是计算瓶颈。Supermemory在中等数据集上效率最高,而Mem0系列处理速度较慢。

对比系统的运行时效率

五、讨论与未来方向

主要发现与瓶颈

实验揭示了当前记忆系统的四大瓶颈:

- 提取覆盖不足:系统难以从长对话中识别高价值信息。

- 更新链路断裂:提取错误直接导致更新失败。

- 抗干扰能力弱:系统易受无关信息影响。

- 问答可靠性低:上游幻觉在生成阶段被放大。

未来研究方向

论文建议未来工作聚焦于:

- 开发更精细的提取机制,提升覆盖率和准确性。

- 设计强化的更新逻辑,确保记忆一致性。

- 增强语义理解能力,以处理复杂事件和关系。

- 优化系统效率,减少计算开销。

如何高效转型Al大模型领域?

作为一名在一线互联网行业奋斗多年的老兵,我深知持续学习和进步的重要性,尤其是在复杂且深入的Al大模型开发领域。为什么精准学习如此关键?

- 系统的技术路线图:帮助你从入门到精通,明确所需掌握的知识点。

- 高效有序的学习路径:避免无效学习,节省时间,提升效率。

- 完整的知识体系:建立系统的知识框架,为职业发展打下坚实基础。

AI大模型从业者的核心竞争力

- 持续学习能力:Al技术日新月异,保持学习是关键。

- 跨领域思维:Al大模型需要结合业务场景,具备跨领域思考能力的从业者更受欢迎。

- 解决问题的能力:AI大模型的应用需要解决实际问题,你的编程经验将大放异彩。

以前总有人问我说:老师能不能帮我预测预测将来的风口在哪里?

现在没什么可说了,一定是Al;我们国家已经提出来:算力即国力!

未来已来,大模型在未来必然走向人类的生活中,无论你是前端,后端还是数据分析,都可以在这个领域上来,我还是那句话,在大语言AI模型时代,只要你有想法,你就有结果!只要你愿意去学习,你就能卷动的过别人!

现在,你需要的只是一份清晰的转型计划和一群志同道合的伙伴。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献336条内容

已为社区贡献336条内容

所有评论(0)