【Python大数据+AI毕设实战】拉勾网计算机岗位招聘数据分析系统、Hadoop、计算机毕业设计、包括数据爬取、数据分析、数据可视化、机器学习、实战教学

【Python大数据+AI毕设实战】拉勾网计算机岗位招聘数据分析系统、Hadoop、计算机毕业设计、包括数据爬取、数据分析、数据可视化、机器学习、实战教学

🍊作者:计算机毕设匠心工作室

🍊简介:毕业后就一直专业从事计算机软件程序开发,至今也有8年工作经验。擅长Java、Python、微信小程序、安卓、大数据、PHP、.NET|C#、Golang等。

擅长:按照需求定制化开发项目、 源码、对代码进行完整讲解、文档撰写、ppt制作。

🍊心愿:点赞 👍 收藏 ⭐评论 📝

👇🏻 精彩专栏推荐订阅 👇🏻 不然下次找不到哟~

Java实战项目

Python实战项目

微信小程序|安卓实战项目

大数据实战项目

PHP|C#.NET|Golang实战项目

🍅 ↓↓文末获取源码联系↓↓🍅

这里写目录标题

基于大数据的拉勾网计算机岗位招聘数据分析系统-功能介绍

本系统是一个以【Python大数据+AI毕设实战】拉勾网计算机岗位招聘数据分析系统为核心的综合性数据洞察平台,旨在通过前沿的大数据技术对海量招聘信息进行深度挖掘与可视化呈现。系统整体采用Python作为主要开发语言,后端依托Django框架构建稳健的Web服务,而数据处理的核心引擎则采用了业界主流的Hadoop与Spark生态。在具体实现中,系统首先利用Spark强大的分布式计算能力,对原始的拉勾网招聘数据进行高效的清洗与预处理,包括解析非结构化的薪资字段、归类繁杂的职位名称、标准化工作年限与学历要求等关键步骤。随后,通过Spark SQL与Pandas库协同执行多达15项维度的数据分析任务,涵盖了从城市岗位分布、技术方向薪资对比、工作经验与学历影响,到热门福利词云、薪资热力图等全方位的就业市场洞察。最终,所有分析结果通过Vue与Echarts构建的前端界面,以直观的图表形式动态展示,将冰冷的数据转化为对求职者极具参考价值的决策依据,完整地展现了一个从数据采集、处理、分析到可视化展示的全流程大数据项目实践。

基于大数据的拉勾网计算机岗位招聘数据分析系统-选题背景意义

选题背景

对于即将走出校门的计算机专业学生而言,如何从海量信息中精准把握就业市场的脉搏,是他们面临的首要挑战。像拉勾网这样的垂直招聘平台,虽然汇聚了大量宝贵的岗位数据,但这些数据往往以原始、非结构化的形式存在,普通用户很难直接从中提炼出有价值的宏观趋势。学生们常常陷入“哪个城市机会多?”“学什么技术工资高?”“工作几年能涨薪?”等具体问题的困惑中,而网上的信息零散且主观,缺乏系统性的数据支撑。因此,开发一个能够自动收集、处理并深度分析这些招聘数据的系统,就显得尤为必要。这个课题的提出,正是源于将复杂原始数据转化为清晰、客观洞察的实际需求,希望通过技术手段为即将踏入职场的学生们提供一个理性的、数据驱动的决策参考工具。

选题意义

这个毕业设计的意义,说白了,就是想做一个能实实在在帮到同学们的小工具。从实际应用的角度看,它把那些让人眼花缭乱的招聘信息,变成了清清楚楚的图表和排名,比如哪个技术方向最“吃香”,不同城市的薪资水平到底差多少,工作经验积累下来对薪资的提升有多明显。这样一来,大家在准备求职时心里就更有底了,不再是盲目地投简历,而是可以根据数据分析结果,有针对性地提升技能、选择目标城市和岗位。从技术实践的角度讲,这个项目也让我完整地走了一遍大数据处理的流程,从用Spark清洗数据,到用Spark SQL做分析,再到用Django和Echarts把结果展示出来,算是对课堂上学到的知识做了一次全面的综合运用。虽然它只是一个毕业设计,功能也有限,但至少提供了一个用数据说话的视角,让模糊的就业市场认知变得清晰了一些,这本身就是一件挺有价值的事情。

基于大数据的拉勾网计算机岗位招聘数据分析系统-技术选型

大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

开发语言:Python+Java(两个版本都支持)

后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

数据库:MySQL

基于大数据的拉勾网计算机岗位招聘数据分析系统-图片展示

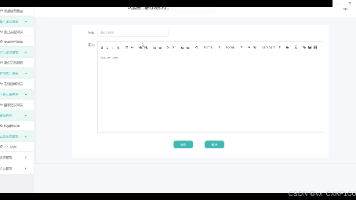

基于大数据的拉勾网计算机岗位招聘数据分析系统-代码展示

from pyspark.sql import SparkSession

from pyspark.sql import functions as F

# 初始化SparkSession,这是所有Spark功能的入口

spark = SparkSession.builder.appName("LagouDataAnalysis").getOrCreate()

# 核心功能1: 数据清洗与预处理(处理薪资、职位名称、工作经验)

def preprocess_data(raw_df):

# 使用正则表达式提取薪资范围,例如从"15k-25k"中提取15和25

raw_df = raw_df.withColumn("min_salary", F.regexp_extract(F.col("money"), "(\d+)-\d+k", 1).cast("int"))

raw_df = raw_df.withColumn("max_salary", F.regexp_extract(F.col("money"), "\d+-(\d+)k", 1).cast("int"))

# 计算平均薪资,处理可能存在的空值

raw_df = raw_df.withColumn("avg_salary", F.when((F.col("min_salary").isNotNull() & F.col("max_salary").isNotNull()), (F.col("min_salary") + F.col("max_salary")) / 2).otherwise(0))

# 标准化工作经验字段,将多种描述归一化

raw_df = raw_df.withColumn("job_exp_standardized", F.when(F.col("job_exp").rlike("在校|应届"), "应届生").when(F.col("job_exp").rlike("1-3年"), "1-3年").when(F.col("job_exp").rlike("3-5年"), "3-5年").when(F.col("job_exp").rlike("5-10年"), "5-10年").when(F.col("job_exp").rlike("10年以上"), "10年以上").otherwise("不限"))

# 从职位名称中提取技术方向关键词,进行初步分类

raw_df = raw_df.withColumn("job_category", F.when(F.col("job_name").rlike("Java|JAVA"), "Java").when(F.col("job_name").rlike("Python|python"), "Python").when(F.col("job_name").rlike("前端|web|WEB|H5"), "前端").when(F.col("job_name").rlike("大数据|BigData|Spark|Hadoop"), "大数据").when(F.col("job_name").rlike("算法|AI|机器学习"), "算法/AI").when(F.col("job_name").rlike("测试|test"), "测试").otherwise("其他"))

# 去除完全重复的记录

processed_df = raw_df.dropDuplicates()

return processed_df

# 核心功能2: 不同技术方向的岗位薪资水平分析

def analyze_salary_by_tech(processed_df):

# 筛选出有效薪资和有效技术分类的数据

valid_df = processed_df.filter((F.col("avg_salary") > 0) & (F.col("job_category") != "其他"))

# 按技术方向分组,计算每个方向的平均薪资和岗位数量

tech_salary_df = valid_df.groupBy("job_category").agg(

F.round(F.avg("avg_salary"), 2).alias("average_salary"),

F.count("job_href").alias("job_count")

)

# 按平均薪资降序排列,以便查看哪些技术方向更“值钱”

result_df = tech_salary_df.orderBy(F.desc("average_salary"))

return result_df

# 核心功能3: 工作经验与薪资关系分析

def analyze_salary_by_exp(processed_df):

# 筛选出有效薪资和有效工作经验的数据

valid_df = processed_df.filter((F.col("avg_salary") > 0) & (F.col("job_exp_standardized") != "不限"))

# 按标准化后的工作经验分组,计算每个经验段的平均薪资和岗位数量

exp_salary_df = valid_df.groupBy("job_exp_standardized").agg(

F.round(F.avg("avg_salary"), 2).alias("average_salary"),

F.count("job_href").alias("job_count")

)

# 自定义排序,让工作经验按逻辑顺序排列(应届生 -> 1-3年 -> ...)

exp_order = F.when(F.col("job_exp_standardized") == "应届生", 1).when(F.col("job_exp_standardized") == "1-3年", 2).when(F.col("job_exp_standardized") == "3-5年", 3).when(F.col("job_exp_standardized") == "5-10年", 4).when(F.col("job_exp_standardized") == "10年以上", 5)

# 应用自定义排序并返回结果

result_df = exp_salary_df.withColumn("exp_order", exp_order).orderBy(F.asc("exp_order")).drop("exp_order")

return result_df

基于大数据的拉勾网计算机岗位招聘数据分析系统-结语

👇🏻 精彩专栏推荐订阅 👇🏻 不然下次找不到哟~

Java实战项目

Python实战项目

微信小程序|安卓实战项目

大数据实战项目

PHP|C#.NET|Golang实战项目

🍅 主页获取源码联系🍅

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)