dify 通过 OpenAI-API-compatible 对接模型

Dify通过OpenAI-API兼容插件实现非原生模型(如Claude、Gemini等)的无缝调用。操作流程包括安装插件、配置模型参数(API Key、Endpoint URL)及测试验证。推荐使用API易、DMXAPI等中转服务,支持多模型切换与本地部署。常见问题涉及连接失败、输出异常等,可通过检查配置或调整参数解决。该方案简化了多模型集成,适合企业级AI应用开发。

·

在Dify中通过OpenAI-API-compatible对接模型,本质是利用Dify的插件机制兼容非OpenAI原生模型(如Claude、Gemini、DeepSeek等),通过统一接口规范实现无缝调用。以下是具体操作流程与核心要点:

一、核心原理

- 兼容模式:Dify的OpenAI-API-compatible插件模拟OpenAI的API结构(如endpoint、请求参数、响应格式),使非OpenAI模型能以相同方式被调用。

- 中转服务:需依赖第三方中转服务(如API易、DMXAPI、POLOAPI等)提供兼容层,将OpenAI格式的请求转换为目标模型可识别的格式。

二、操作步骤

1. 安装OpenAI-API-compatible插件

- 路径:登录Dify控制台 → 设置 → 模型供应商 → 搜索“OpenAI-API-compatible” → 点击安装。

- 注意:若安装后未显示,尝试刷新页面或重新安装。

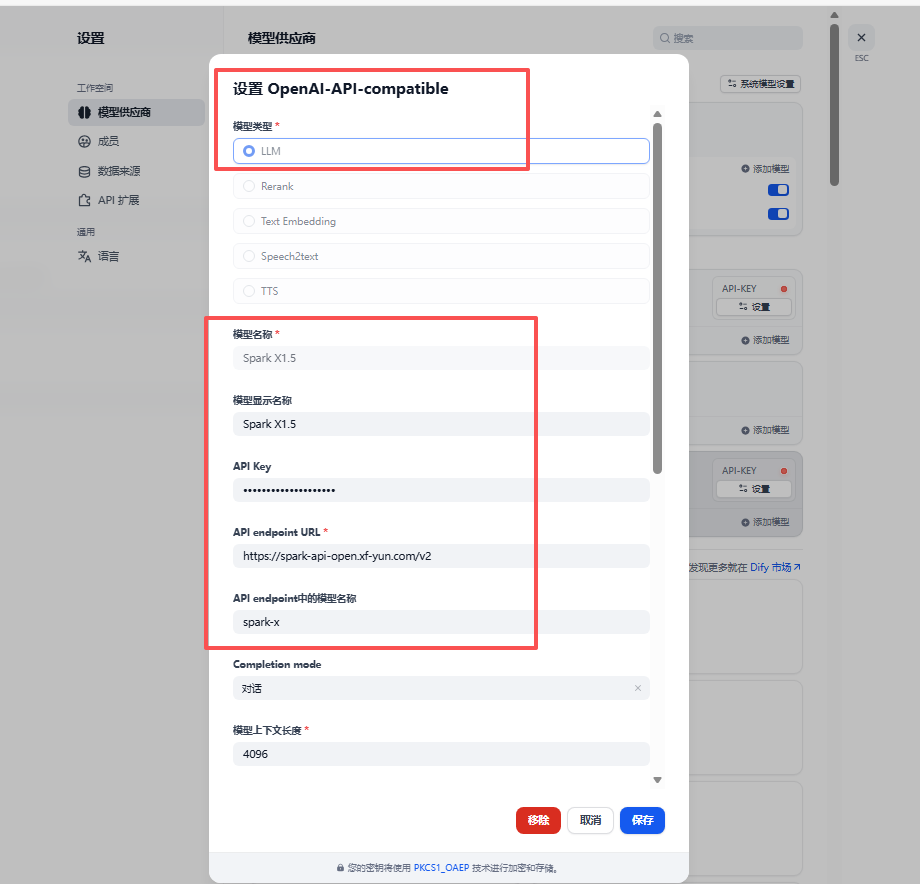

2. 配置模型参数

- 模型名称:填写目标模型的全称(如

claude-3-7-sonnet-20250219、deepseek-r1:7b),需与中转服务提供的名称一致。 - API Key:从中转服务(如API易、DMXAPI)获取,粘贴至Dify。

- API Endpoint URL:填写中转服务提供的地址(如

https://api.example.com/v1)。 - 其他参数:

- Completion Mode:选择“对话”或“补全”,根据模型能力调整。

- 上下文长度:根据模型实际能力填写(如Claude 3.7支持40960 tokens)。

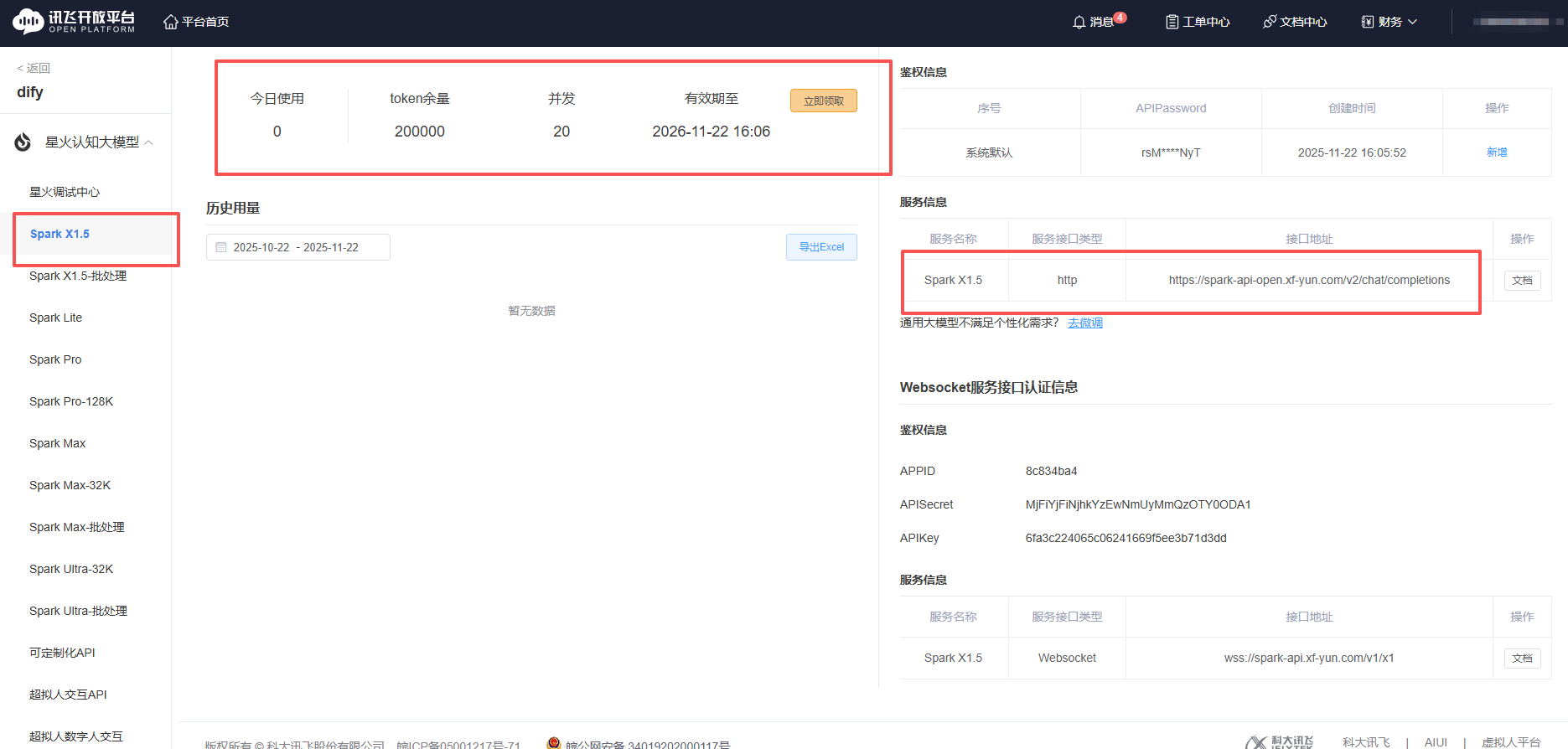

比如搞点免费的token

3. 测试与验证

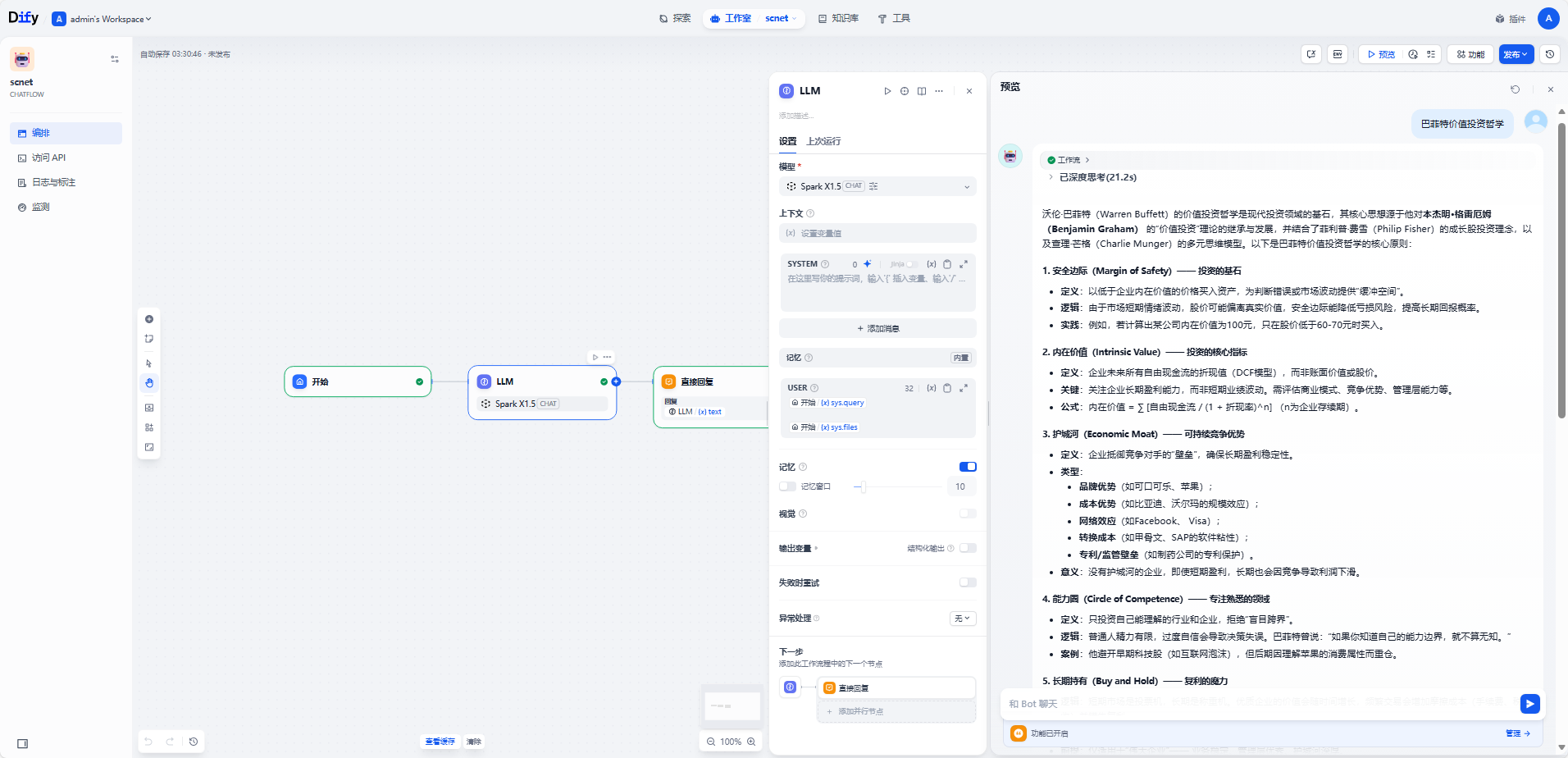

- 创建应用:在Dify工作室新建应用,选择刚配置的模型。

- 对话测试:输入提示词,观察输出是否符合预期。若失败,检查API Key、Endpoint URL是否正确,或查看中转服务日志。

三、典型场景与中转服务推荐

| 场景 | 推荐中转服务 | 优势 |

|---|---|---|

| 调用Claude模型 | API易、DMXAPI | 提供稳定兼容层,支持Claude 3.5/3.7等最新版本,无需修改代码结构。 |

| 使用Gemini模型 | POLOAPI | 支持Gemini 2.5 Pro,提供高并发额度,适合企业级应用。 |

| 部署本地开源模型(如DeepSeek) | Ollama + Dify插件 | 本地化部署,数据隐私性强,适合对安全性要求高的场景。 |

| 多模型灵活切换 | 自定义中转服务 | 通过代码实现动态路由,根据需求切换不同模型(如按成本、性能选择)。 |

四、常见问题与解决方案

- 模型不显示:

- 检查插件是否安装成功,尝试重新安装。

- 等待5-10分钟,模型列表可能延迟更新。

- 连接失败:

- 确认API Key和Endpoint URL正确,无多余空格或拼写错误。

- 检查网络是否可访问中转服务地址(如被防火墙拦截需放行)。

- 输出异常:

- 调整上下文长度或最大token数,避免超出模型限制。

- 检查提示词是否符合目标模型要求(如Claude需更详细的上下文)。

五、进阶优化

- 性能调优:通过中转服务调整响应超时时间,避免长文本生成中断。

- 成本监控:在中转服务控制台查看API调用量与费用,设置额度预警。

- 多模型备份:配置多个模型供应商,主模型失败时自动切换至备用模型。

总结

通过OpenAI-API-compatible对接模型,Dify实现了对非OpenAI生态的广泛兼容。用户只需关注中转服务的稳定性与模型能力,无需深入底层API差异,即可快速构建多模型驱动的AI应用。对于企业级用户,建议结合自定义中转服务实现更灵活的模型管理与成本控制。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)