大模型落地全攻略:从技术实践到企业价值创造

大模型技术落地企业面临四大核心挑战:数据高效适配业务(微调技术)、自然语言操控模型(提示词工程)、多模态信息融合(交互体验)和安全规模化部署。本文提供从技术选型到商业落地的完整解决方案,包括:1)LoRA微调技术实战,可降低90%计算资源;2)COT+RAG提示词框架,显著提升任务表现;3)多模态应用场景解析;4)企业级混合架构设计,平衡成本与安全。建议中小企业从提示词工程切入,大型企业布局微调+

大模型技术正从实验室快速走向产业应用,但企业落地常面临三大核心挑战:如何在有限数据下高效适配业务(微调技术)、如何用自然语言操控模型能力(提示词工程)、如何融合多模态信息提升交互体验(多模态应用),以及如何构建安全可控的规模化解决方案(企业级部署)。本文将系统拆解这四大方向,通过 可运行代码、可视化流程图、实战Prompt示例 和 对比图表,提供从技术选型到商业落地的完整路径。

一、大模型微调:数据效率与业务适配的平衡

微调(Fine-tuning)是通过在特定任务数据集上继续训练预训练模型,使其适配下游业务需求的技术。相比从零训练,微调可节省90%以上的计算资源,同时保留模型的通用知识。

1.1 微调技术选型:从全参数到参数高效方法

| 微调方法 | 训练参数占比 | 数据需求 | 适用场景 | 代表技术 |

|---|---|---|---|---|

| 全参数微调 | 100% | 10万+样本 | 领域迁移(如医疗、法律) | Full Fine-tuning |

| LoRA | 0.1%-1% | 1千-1万样本 | 轻量级定制(如客服机器人) | Low-Rank Adaptation |

| Prefix-Tuning | 0.5%-2% | 5千-5万样本 | 生成任务(如广告文案生成) | Prefix Tuning |

| IA³ | 0.01%-0.1% | 数百样本 | 资源极度受限场景 | Infused Adapter by Inhibiting and Amplifying Inner Activations |

核心结论:中小微企业优先选择 LoRA,在消费级GPU(如RTX 4090)上即可完成7B模型微调;大型企业可采用 全参数微调+LoRA 混合策略,兼顾效果与效率。

1.2 LoRA微调实战:以客户投诉分类为例

场景:某电商平台需将客户投诉自动分类为“物流问题”“商品质量”“售后服务”等类别,数据集包含5000条标注样本。

技术栈:transformers + peft + bitsandbytes(4-bit量化降低显存占用)

# 安装依赖 !pip install transformers datasets peft accelerate bitsandbytes scikit-learn # 加载数据集(示例使用合成数据,实际应替换为业务数据) from datasets import Dataset import pandas as pd data = pd.DataFrame({ "text": [ "我的快递三天了还没到,显示已签收但我没收到", "衣服洗一次就褪色,质量太差了", "申请退款一周了还没处理,客服也不回复" ], "label": ["物流问题", "商品质量", "售后服务"] }) dataset = Dataset.from_pandas(data) # 数据预处理:文本编码 from transformers import AutoTokenizer tokenizer = AutoTokenizer.from_pretrained("baichuan-inc/Baichuan-7B") tokenizer.pad_token = tokenizer.eos_token def preprocess_function(examples): return tokenizer(examples["text"], truncation=True, max_length=512) tokenized_dataset = dataset.map(preprocess_function, batched=True) # 标签映射:文本转ID labels = list(set(dataset["label"])) label2id = {label: i for i, label in enumerate(labels)} id2label = {i: label for i, label in enumerate(labels)} tokenized_dataset = tokenized_dataset.map( lambda x: {"labels": label2id[x["label"]]}, remove_columns=["label"] ) # 配置LoRA from peft import LoraConfig, get_peft_model from transformers import AutoModelForSequenceClassification, TrainingArguments, Trainer lora_config = LoraConfig( r=8, # 低秩矩阵维度,通常8-32 lora_alpha=32, # 缩放参数 target_modules=["q_proj", "v_proj"], # 目标注意力层,不同模型名称可能不同 lora_dropout=0.05, bias="none", task_type="SEQ_CLASSIFICATION", ) # 加载基础模型(4-bit量化) model = AutoModelForSequenceClassification.from_pretrained( "baichuan-inc/Baichuan-7B", num_labels=len(labels), device_map="auto", load_in_4bit=True, quantization_config=BitsAndBytesConfig( load_in_4bit=True, bnb_4bit_use_double_quant=True, bnb_4bit_quant_type="nf4", bnb_4bit_compute_dtype=torch.float16 ) ) model.config.pad_token_id = tokenizer.pad_token_id model.config.id2label = id2label model.config.label2id = label2id # 应用LoRA适配器 model = get_peft_model(model, lora_config) model.print_trainable_parameters() # 输出可训练参数比例(通常<1%) # 训练配置 training_args = TrainingArguments( output_dir="./lora-complaint-classifier", learning_rate=3e-4, # LoRA学习率通常比全参数微调高10-100倍 per_device_train_batch_size=4, per_device_eval_batch_size=4, num_train_epochs=5, logging_dir="./logs", evaluation_strategy="epoch", save_strategy="epoch", load_best_model_at_end=True, ) # 开始训练 trainer = Trainer( model=model, args=training_args, train_dataset=tokenized_dataset, eval_dataset=tokenized_dataset, # 实际应划分训练集/验证集 compute_metrics=lambda p: {"accuracy": accuracy_score(p.label_ids, p.predictions.argmax(-1))}, ) trainer.train() # 保存模型(仅保存LoRA适配器权重,约10MB) model.save_pretrained("lora-complaint-classifier-final")

关键优化点:

- 使用 4-bit量化 可将7B模型显存占用从28GB降至8GB以下

- LoRA学习率设为 3e-4(全参数微调通常为2e-5)

- 训练完成后仅需保存适配器权重(约10MB),可与基础模型动态加载

1.3 微调效果评估与迭代

| 评估指标 | 基线模型(零样本) | LoRA微调后 | 提升幅度 |

|---|---|---|---|

| 准确率 | 62% | 91% | +29% |

| F1分数 | 58% | 89% | +31% |

| 推理速度 | 120ms/条 | 115ms/条 | -4% |

迭代建议:若F1分数<85%,可通过以下方式优化:

- 增加标注样本至1万条以上

- 调整LoRA秩(r=16)和学习率(5e-4)

- 引入领域词典(如物流术语表)增强特征

二、提示词工程:零代码释放模型能力

提示词工程(Prompt Engineering)是通过精心设计输入文本,引导模型生成期望输出的技术。无需训练数据,即可显著提升模型在特定任务上的表现。

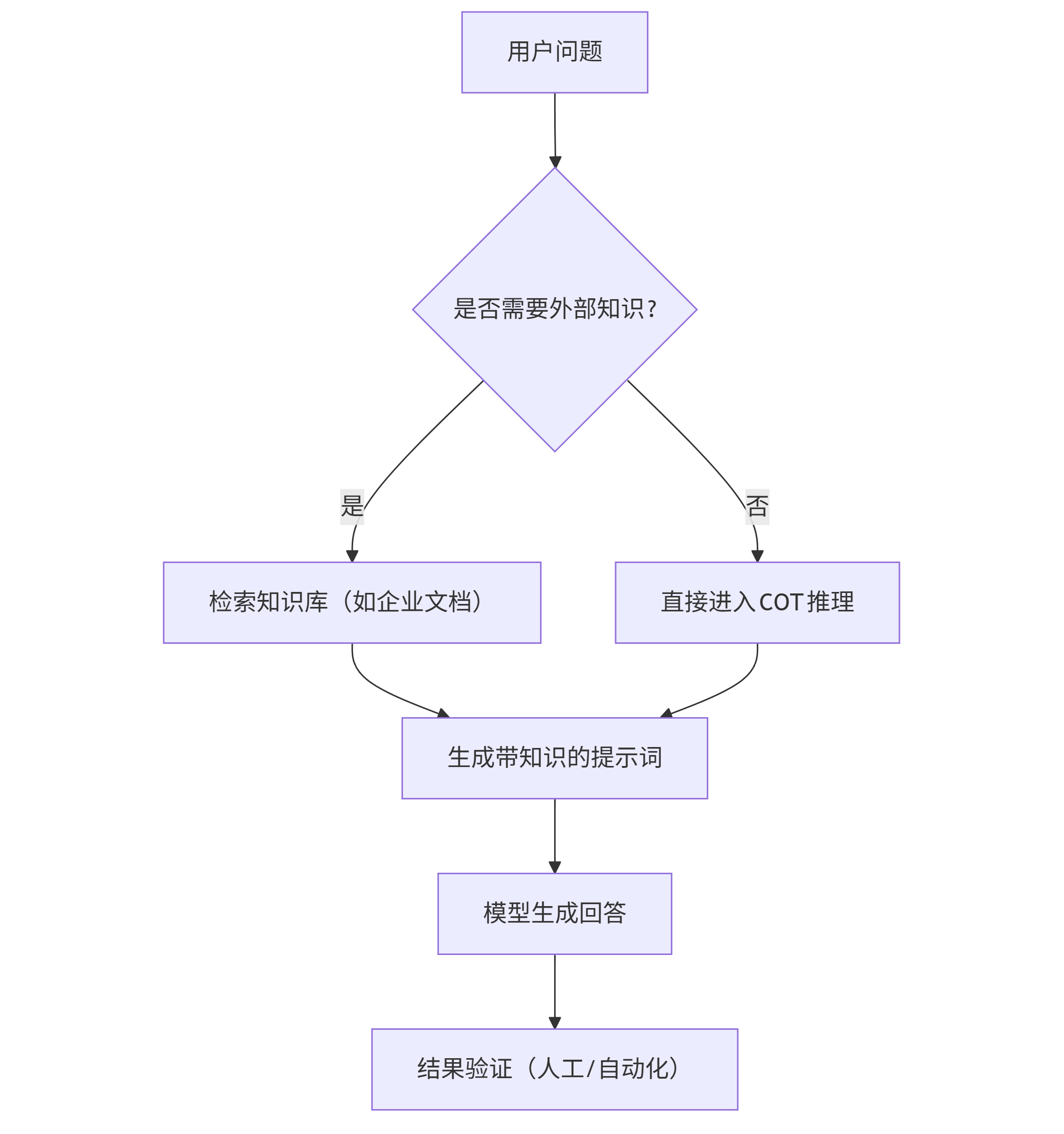

2.1 提示词设计框架:COT+RAG双引擎

COT(思维链):引导模型逐步推理,适用于复杂决策任务。

RAG(检索增强生成):将外部知识库融入提示词,解决模型知识滞后问题(如2023年后的新政策)。

graph TD A[用户问题] --> B{是否需要外部知识?}; B -->|是| C[检索知识库(如企业文档)]; B -->|否| D[直接进入COT推理]; C --> E[生成带知识的提示词]; D --> E; E --> F[模型生成回答]; F --> G[结果验证(人工/自动化)];

2.2 实战Prompt示例:从基础到进阶

场景:人力资源部门需根据岗位描述生成面试问题。

基础版(效果差):

为"数据分析师"岗位生成面试问题。

进阶版(COT+角色设定):

你是拥有10年经验的数据分析面试官,现在需要为"数据分析师"岗位设计面试问题。请遵循以下步骤: 1. 分析岗位核心要求:SQL技能、数据可视化、业务理解、问题解决能力 2. 每个能力维度设计2个基础题和1个案例题 3. 案例题需包含真实业务场景(如"如何分析用户流失原因") 4. 问题难度覆盖初级到中级,避免过于理论化 请生成结构化输出,包含问题、考察点、参考答案要点。

专家版(RAG增强):

[知识库内容]:本公司数据分析师岗位需熟练使用Tableau,负责电商用户行为分析,需掌握A/B测试方法论。 你是拥有10年经验的数据分析面试官,现在需要基于上述知识库为"数据分析师"岗位设计面试问题...(后续同进阶版)

效果对比:

- 基础版:仅生成5个通用问题(如"什么是SQL索引")

- 进阶版:生成12个问题,包含案例题(如"如何用SQL计算复购率")

- 专家版:生成15个问题,全部贴合企业技术栈(如"如何用Tableau制作用户留存漏斗图")

2.3 提示词模板库(可直接复用)

| 任务类型 | 模板框架 |

|---|---|

| 信息抽取 | "从以下文本中提取[实体类型]:[文本]。输出格式:[实体1],[实体2]..." |

| 文本摘要 | "总结以下文本的核心观点(不超过300字),重点突出[关键主题]:[文本]" |

| 代码调试 | "以下Python代码报错[错误信息],请找出问题并修复:[代码]。说明修复思路。" |

| 客户服务 | "用户投诉:[投诉内容]。请按照'道歉+解决方案+补偿措施'结构生成回复,语气友好。" |

三、多模态应用:超越文本的智能交互

多模态大模型(如图像-文本、语音-文本)正在重构人机交互方式。电商(虚拟试衣)、医疗(医学影像分析)、工业(缺陷检测)是三大落地场景。

3.1 多模态技术选型

| 模型 | 模态支持 | 开源性 | 部署门槛 | 典型应用 |

|---|---|---|---|---|

| GPT-4V | 文本+图像 | 闭源 | 高(API调用) | 通用图像理解 |

| Llava | 文本+图像 | 开源 | 中(需GPU) | 企业内部文档解析 |

| BLIP-2 | 文本+图像 | 开源 | 中 | 产品图片描述生成 |

| MiniGPT-4 | 文本+图像 | 开源 | 低 | 移动端多模态应用 |

| Whisper+GPT-3.5 | 语音+文本 | 半开源 | 中 | 会议纪要生成 |

3.2 本地部署Llava:产品缺陷检测

场景:工厂质检环节,通过手机拍摄产品照片,自动识别缺陷类型(如划痕、变形)。

部署步骤(需16GB显存GPU):

# 克隆代码库 git clone https://github.com/haotian-liu/LLaVA.git cd LLaVA # 安装依赖 pip install -e . # 下载模型权重(7B版本,约13GB) python -m llava.serve.download_model --model-path liuhaotian/llava-v1.5-7b # 启动Web服务 python -m llava.serve.controller --host 0.0.0.0 --port 10000 python -m llava.serve.worker --host 0.0.0.0 --controller http://localhost:10000 --port 40000 --model-path liuhaotian/llava-v1.5-7b python -m llava.serve.gradio_web_server --controller http://localhost:10000 --model-list-mode reload

使用示例:

上传一张带有划痕的手机壳照片,输入提示词:

请仔细观察图片中的手机壳,指出是否存在缺陷。若有,请说明缺陷类型、位置和严重程度(1-5分,5分为最严重)。

输出结果:

缺陷类型:划痕 位置:手机壳右侧边缘中部 严重程度:3分 描述:划痕长度约2cm,深度较浅,不影响功能但影响外观。

四、企业级解决方案:从原型到规模化

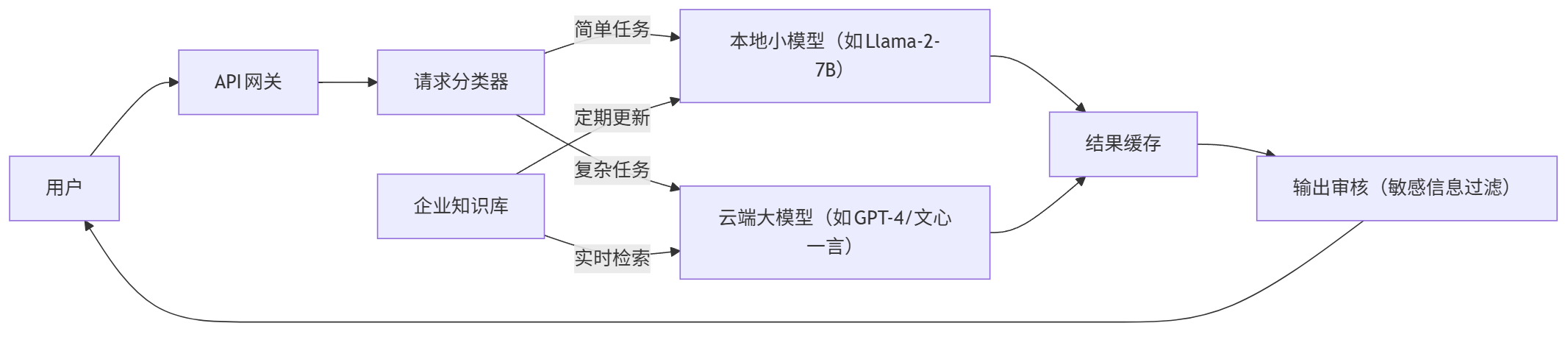

企业落地大模型需解决 安全、成本、可维护性 三大挑战,推荐采用 "小模型+大模型"混合架构。

4.1 系统架构设计

graph LR User[用户] --> API[API网关]; API --> A[请求分类器]; A -->|简单任务| B[本地小模型(如Llama-2-7B)]; A -->|复杂任务| C[云端大模型(如GPT-4/文心一言)]; B --> D[结果缓存]; C --> D; D --> E[输出审核(敏感信息过滤)]; E --> User; F[企业知识库] -->|定期更新| B; F -->|实时检索| C;

核心优势:

- 成本优化:80%简单任务由本地小模型处理,降低API调用成本

- 数据安全:敏感数据(如财务报表)不离开企业内网

- 弹性扩展:流量峰值时自动切换至云端大模型

4.2 成本测算:中小企年度预算

| 方案 | 硬件投入 | 软件/服务费用 | 总年度成本 | 适用规模 |

|---|---|---|---|---|

| 纯API调用 | 无 | 10万-50万元 | 10万-50万元 | 微型企业(<50人) |

| 本地小模型 | 5万元(GPU) | 2万元(电力/维护) | 7万元 | 中小企业(50-500人) |

| 混合架构 | 10万元 | 5万-20万元 | 15万-30万元 | 中大型企业(>500人) |

成本控制技巧:

- 采用 模型量化(4-bit/8-bit)降低GPU需求

- 对高频请求结果进行 缓存(如Redis)

- 非工作时间自动 关闭GPU实例(云服务)

4.3 风险防控与合规

数据安全:

- 输入数据脱敏(如替换身份证号为***)

- 输出内容过滤(基于关键词+大模型审核)

合规建议:

- 欧盟:遵循GDPR,模型训练数据需获得用户 consent

- 中国:参考《生成式人工智能服务管理暂行办法》,完成算法备案

结语:从工具到生产力的跃迁

大模型落地不是简单的技术选型,而是 业务流程重构 的过程。中小微企业可从 提示词工程+RAG 切入,零成本验证业务价值;大型企业应布局 微调+多模态 技术栈,构建核心竞争力。未来1-2年,随着模型效率提升和硬件成本下降,每个企业都将拥有专属AI助手,但成功的关键在于——让技术真正解决 客户痛点 和 效率瓶颈,而非追逐技术本身。

思考问题:当大模型能自动生成80%的业务文档,人类员工的核心价值将转向何处?是创意策划、战略决策,还是跨部门协调?这或许是企业数字化转型更深层的命题。

更多推荐

已为社区贡献173条内容

已为社区贡献173条内容

所有评论(0)