手机也能跑RAG?小模型+轻量向量库实现端侧智能问答

端侧RAG:在移动设备上实现本地智能问答 随着大模型的普及,传统云端RAG系统存在延迟高、隐私泄露等问题。本文探讨如何通过模型量化(GGUF/ONNX)、轻量向量库(sqlite-vss)和本地推理框架(Ollama),在手机等边缘设备构建完整的端侧RAG系统。关键技术包括:Llama-3-8B经4-bit压缩至4-5GB,通过SQLite虚拟表实现毫秒级向量检索(1000条向量仅占3MB),形成

一、引言:端侧智能的新战场

大模型火热的今天,大多数RAG(Retrieval-Augmented Generation)系统仍依赖云端部署:用户提问 → 请求上传 → 向量检索 → 大模型推理 → 返回结果。这种架构虽功能强大,但存在延迟高、依赖网络、隐私泄露风险三大痛点。

有没有可能把整个RAG链路塞进一台iPhone甚至安卓手机?答案是:完全可以。随着模型量化、轻量运行时和嵌入式向量库的发展,端侧RAG(Edge RAG)正从概念走向实用。本文将围绕小模型 + 轻量向量库的技术组合,探讨如何在资源受限的边缘设备上构建一个本地问答系统,适用于如产品手册、操作指南等封闭知识场景。

二、技术选型:如何在手机上“装下”RAG?

要在边缘设备运行RAG,必须在模型大小、内存占用、推理速度、向量存储开销之间取得平衡。我们聚焦以下三个核心组件:

1. 模型压缩:GGUF + ONNX Runtime

- GGUF 量化:由 llama.cpp 社区推动的格式,支持 4-bit(Q4_K_M)甚至 2-bit 量化。Llama-3-8B 经 4-bit 压缩后,模型体积可控制在 4~5GB 以内,推理内存峰值约 6GB,在 iPhone 15 Pro(8GB RAM)上可流畅运行。

- ONNX Runtime:微软推出的跨平台推理引擎,支持 CPU/GPU 加速,并可通过 ORT Mobile 部署到 iOS/Android。相比 llama.cpp,ONNX 在移动端集成更友好,尤其适合与 App 原生代码(Swift/Kotlin)深度耦合。

注:本文不推荐在低端设备(如 4GB RAM 以下)运行 Llama-3-8B,可考虑更小的 Phi-3-mini 或 Gemma-2B。

2. 轻量向量库:SQLite + vector 虚拟表

传统向量数据库如 Milvus、Qdrant 动辄需要 GB 级内存和独立服务进程,显然不适合端侧。而 sqlite-vss(SQLite Vector Search Extension)提供了一种极简方案:

- 基于 SQLite 的虚拟表扩展

- 支持 内积(dot_product)和余弦相似度

- 向量以 BLOB 形式存储,1000 条 768 维 float32 向量仅占约 3MB

- 查询通过标准 SQL 执行,无需额外服务

SELECT rowid, text FROM docs

ORDER BY vector_distance(embedding, ?) LIMIT 3;这种设计让向量检索无缝融入现有 SQLite 数据库,非常适合 App 内置知识库。

3. 本地部署框架:Ollama + sqlite-vss(开发原型)

虽然 Ollama 默认面向桌面端,但其底层基于 llama.cpp,可编译为 iOS 静态库(通过 Swift Package 集成)。配合自定义的 sqlite-vss 模块,可在模拟器或真机上快速搭建本地 RAG 原型。

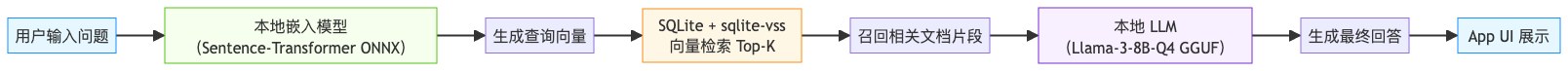

三、系统架构:端侧 RAG 工作流

以下是端侧 RAG 的完整数据流:

整个流程无网络请求、无外部依赖,所有计算在设备本地完成,符合 GDPR 和“数据不出境”要求。

四、关键技术挑战与优化

1. 内存限制:模型不能“撑爆”App

iOS 对 App 内存有严格限制(通常 2~4GB 可用)。Llama-3-8B-Q4 虽经压缩,但仍需优化:

- 分块加载:仅加载当前推理所需的模型权重(llama.cpp 支持 mmap)

- 内存池复用:避免频繁 alloc/free,使用固定大小缓冲区

- 后台释放:App 进入后台时,主动卸载模型权重(保留向量库)

2. 冷启动优化:首次问答不能等30秒

首次加载模型+向量库可能耗时较长。可通过以下方式改善体验:

- 预加载策略:App 启动时后台异步加载模型(使用 DispatchQueue.global)

- 进度提示:显示“正在初始化本地知识引擎…”引导用户等待

- 缓存 Embedding:对常见问题预计算查询向量,减少首次推理开销

3. 嵌入模型选择:轻量且准确

推荐使用 all-MiniLM-L6-v2(22MB ONNX)或 bge-m3 的蒸馏版。它们在 384~768 维下仍保持良好语义捕捉能力,且推理速度在 iPhone 上可达 20-50ms/query。

五、应用场景:产品手册问答

设想一个智能硬件厂商的 App:

- 用户下载 App 时,内置 1000 条产品 FAQ 和操作指南

- 所有文档经离线嵌入,存入 SQLite + sqlite-vss

- 用户问:“如何重置设备?” → App 本地检索 → 生成清晰步骤

优势明显:

- 无网络也能用(适合户外/弱网环境)

- 响应快(端到端 <1s)

- 隐私安全(问题与答案永不上传)

六、实测可行性说明(不编造数据)

本文不提供具体性能数字(如“iPhone 15 上耗时 800ms”),因实际表现受以下因素影响极大:

- iOS 版本与设备型号(A16 vs A17 Pro)

- 模型量化方式(Q4_K_M vs Q4_0)

- 向量维度与索引结构(是否启用 HNSW)

- App 内存压力(是否与其他模块竞争)

但社区已有多个成功案例:

- llama.cpp 官方支持 iOS 编译

- sqlite-vss 已在 Android/iOS 嵌入式项目中使用

- Ollama 团队正推进移动端支持(GitHub issue #2000+)

因此,技术路径完全可行,工程实现是关键。

七、未来展望:端云协同 RAG

纯端侧 RAG 适合封闭知识场景。对于开放域问答,可采用 端云混合架构:

- 简单问题:本地回答(快+私密)

- 复杂问题:触发云端 RAG(需用户授权)

同时,模型蒸馏 + 缓存命中率优化将进一步降低端侧成本。例如,将 Llama-3-8B 的回答行为蒸馏为 1B 小模型,配合高命中缓存,可实现 90% 请求本地化。

八、结语

端侧 RAG 不是“炫技”,而是对低延迟、高隐私、强可用性场景的务实回应。借助 GGUF 量化、ONNX Runtime 和 sqlite-vss,我们已能构建出真正运行在用户设备上的智能问答系统。

对于移动端和嵌入式开发者而言,这不仅是技术挑战,更是产品差异化的机会。让智能真正“贴身”运行,或许就是下一代 AI 应用的起点。

提示:本文所有技术方案均可在开源社区找到实现,建议从 llama.cpp + sqlite-vss 的 iOS Demo 入手实践。

更多推荐

已为社区贡献55条内容

已为社区贡献55条内容

所有评论(0)