人工智能的起源、发展、现代应用与未来发展趋势

站在2025年的时间节点回望和前瞻,我们既见证了人工智能从萌芽走向繁荣的非凡历程,也深刻认识到其未来道路上的机遇与挑战并存。人工智能的起源与发展史告诉我们,每一次技术范式的更替都凝聚着人类的智慧创新和不懈探索。从符号AI到机器学习再到深度学习,AI实现了一次又一次质的飞跃。如今,人工智能的应用早已超越实验室,深入医疗、金融、工业、交通、教育等诸多领域,为经济社会带来巨大效益。但AI技术并非中性的工

人工智能(AI)是20世纪中叶诞生的一项革命性技术,其发展历程经历了起伏与变革。从最初的逻辑推理程序到当今的深度学习模型,AI不断拓展着人类智能的边界。本文将深入回顾人工智能的历史起源与发展历程,总结AI在医疗、金融、教育、制造、交通等主要行业的现代应用案例,探讨深度学习在AI腾飞过程中扮演的关键角色及代表性模型,并重点展望人工智能未来可能的发展方向,包括通用人工智能(AGI)、类脑计算(Neuromorphic Computing)、自动机器学习(AutoML)、自监督学习、多模态学习以及大模型优化与推理加速等技术前沿。最后,本文将简要讨论AI发展带来的社会影响、伦理挑战与监管趋势。

一、人工智能的历史起源和发展历程

人工智能的理念可以追溯到计算机科学的黎明时期。早在1950年,英国数学家阿兰·图灵就在论文中提出“机器能思考吗?”的著名问题,为日后AI研究奠定了思想基础。1956年,被视为人工智能正式诞生的年份。这一年夏天,达特茅斯学院的研讨会由约翰·麦卡锡等人组织,首次提出用“人工智能”来描述让机器实现智能行为的新领域。研讨会上,艾伦·纽厄尔、赫伯特·西蒙和克利夫·肖展示了世界上第一个 AI 程序——逻辑理论家(Logic Theorist),它能够自动证明数学定理,被誉为“第一个具有人工智能的程序”。这标志着符号主义AI的开端:研究人员尝试让计算机通过操作符号和规则来模拟人类推理。当时的成果(如能解答代数文字题目的程序、让计算机学习英文等)令公众感到“惊奇”,人们对 AI 抱有极大热情。

20世纪50-60年代被视作AI的“黄金时代”。专家系统、博弈程序等初步成果不断涌现。例如,1950年代末出现的检查者(跳棋)程序能够击败业余选手,1960年代的ELIZA程序可以模拟心理治疗师对话,这些都展示了机器执行智能任务的潜力。与此同时,人工神经网络的概念也在兴起:1957年罗森布拉特发明的感知机模型尝试模拟人脑神经元的学习机制。然而,由于当时计算能力和数据的限制,这些早期AI系统只能处理非常简单的问题。1970年前后,人工智能的发展遭遇挫折。现实表现与夸大的预期之间的落差,引发了来自学界和政府的批评。1973年英国的莱斯希尔报告严厉质疑AI研究价值,美国国防高级研究计划局(DARPA)也削减了对AI的资助。由此进入第一次“AI寒冬”时期(约1974–1980年):资金和兴趣的急剧下降使许多研究计划被搁置。正如历史所示,人工智能的发展充满“热潮—幻灭”的循环:一段时期的过高期望往往导致失望和批评,进而引发经费减少,研究降温,然后几年或几十年后又迎来新一轮热潮。

20世纪80年代早期,AI领域迎来复苏。日本在1982年启动了第五代计算机计划,试图用逻辑推理机实现突破;美国和欧洲也重新投入专家系统的研究。专家系统是一类基于知识库和推理引擎的AI程序,在医学诊断等领域取得一定成功。然而这些系统的局限也逐渐暴露:构建和维护知识规则既昂贵又脆弱,推广到更复杂问题时效果不佳。1980年代末,AI再次遭遇低谷。随着专用硬件(如LISP机)市场的崩溃和专家系统热潮的退却,业界对AI的信心再度下滑,这一时期被称为第二次AI寒冬(约1987–1993年)。很多曾被寄予厚望的专家系统项目在90年代被放弃,AI研究转向低调务实的发展路径。值得注意的是,即便在“寒冬”中,学术界一些方向仍在默默进展,例如机器学习中的贝叶斯网络、决策树、支持向量机等方法在1990年代逐步成熟,为下一阶段的崛起奠定基础。

21世纪初,互联网和计算能力的提升为AI带来新契机。机器学习开始广泛应用于数据挖掘、自然语言处理等实际问题,语音识别和计算机视觉等领域在2000年前后取得显著进展。大约2012年起,人工智能进入高速发展新阶段。这一年,深度学习模型在ImageNet图像识别比赛上取得突破:由Geoffrey Hinton团队指导的AlexNet卷积神经网络大幅提高了图像分类准确率,震动了业界。这标志着深度学习带来的“深度革命”开始。随后几年,深度神经网络在语音识别、计算机视觉等任务上接连超越以往最佳算法。2016年,谷歌DeepMind的AlphaGo程序击败世界围棋冠军李世石,第一次在复杂棋类游戏上战胜顶尖人类,被视为AI发展史上的里程碑。深度学习由此奠定了人工智能领域的主导地位,人工智能的重心从早期基于规则的专家系统转向数据驱动的学习算法。伴随大数据和GPU并行计算的普及,AI系统的规模和能力呈指数级攀升。各国和企业纷纷加大投入,使得AI研究与应用进入空前活跃的时期。据斯坦福大学统计,自2016年以来全球范围关于AI的立法关注度增长了9倍,各国政府在2024年前后大幅增加了AI研发投入。可以说,经历半个多世纪风雨后,人工智能正处在新的爆发式增长“热潮”中,其影响开始渗透到日常生活和经济社会的方方面面。

为了更直观地概括人工智能的发展脉络,下面列出AI发展历程的主要阶段和特点:

可以看到,人工智能的发展并非一帆风顺,而是伴随着数次高潮和低谷循环前进的。然而,每一次“寒冬”过后,AI都能在新思路和新技术的推动下重获生机。特别是进入21世纪大数据时代后,AI的发展渐入佳境,其应用范围不断扩大。在下一节中,我们将聚焦人工智能在当今主要行业领域的应用现状,了解这场技术革命如何深刻影响各行各业。

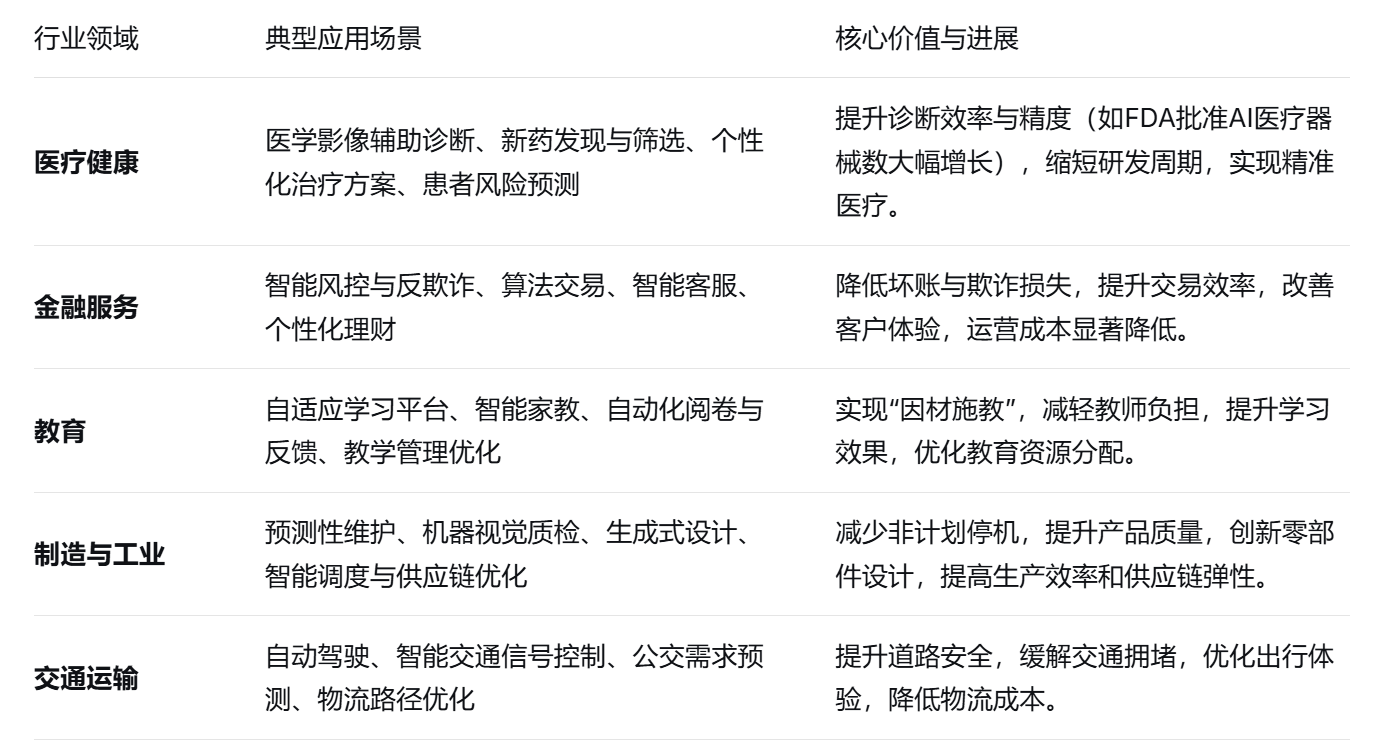

二、人工智能在主要行业领域的现代应用

伴随着算法的突破与算力的提升,人工智能技术正在各个产业领域落地开花。从医疗到交通,AI正快速从实验室走向现实世界,重塑着众多行业的业务模式和生产流程。本节将选取医疗、金融、教育、制造、交通五大领域,介绍人工智能的典型应用案例和所带来的变革。

1. 医疗健康领域: 人工智能在医疗领域的应用蓬勃发展,提升了诊疗效率和精度。从医学影像分析到新药研发,AI正深刻改变传统医疗模式。利用深度学习的医学影像诊断系统可以协助医师更快更准确地识别肿瘤、出血等异常,在放射科和病理科已经涌现多款获批产品。例如,AI通过学习海量的X光片、MRI等数据,可在几秒钟内完成初步读片和标注病灶,其准确率在某些任务上已接近甚至超过放射科医师的水平。这极大缓解了医疗资源不足情况下的诊断压力。在新药发现上,制药公司利用机器学习模型分析分子结构和基因数据,筛选潜在药物化合物,大幅缩短了研发周期。另外,医院还部署AI用于个性化治疗方案制定、患者风险预测等。例如基于患者电子病历的大数据分析,AI可以预测再入院风险或疾病并发症概率,帮助医生采取预防措施。值得注意的是,医疗AI产品正在快速获得监管认可。美国食品药品监督管理局(FDA)在2023年已批准了223种AI驱动的医疗器械,而2015年仅有6种。这表明医疗AI从实验研究走向临床实践的速度正大幅加快。当然,在赋能医疗的同时,AI应用也带来一些挑战,如算法偏见可能影响对少数族裔或特殊群体的诊断准确性、黑箱模型缺乏解释性等。因此业界也在积极研究可解释的AI(XAI)、模型验证等方法,确保医疗AI安全可靠地服务于患者。总体而言,人工智能正帮助医疗行业提高效率、减轻医务人员负担,并有望实现更加精准和个性化的医疗服务。

2. 金融服务领域: 金融行业是人工智能应用最活跃的领域之一。借助机器学习和数据挖掘技术,金融机构正以更智能高效的方式管理风险、服务客户并优化决策。在银行业,AI用于信用风险评估和反欺诈检测,通过分析海量交易数据和客户行为模式,模型可以及时识别异常交易或高风险贷款申请,从而降低坏账率和欺诈损失。例如,基于AI的反洗钱系统可自动学习交易网络的正常模式,一旦出现可疑转账路径立即报警,这比传统规则系统更灵敏可靠。在投资领域,算法交易和量化投资大量采用机器学习模型来预测市场走势和执行交易策略。高频交易系统甚至结合深度学习来从新闻和社交媒体情绪中提取信号,用于短期市场预测。在金融客服方面,智能客服机器人与大语言模型技术相结合,可以24小时在线回答客户咨询、办理业务,提升客户体验并节约人力成本。更宏观地看,人工智能已渗透金融的各个环节,包括资产配置、个性化理财顾问、保险精算、监管合规等。研究表明,目前AI在金融领域的主要应用集中于金融预测、金融风控保护以及投资分析决策等方面。其中最常见的技术是监督式学习模型,包括深度学习在内的各种方法正被广泛采用。值得一提的是,金融行业对AI的采用率非常高:根据KPMG的全球调研报告,大约71%的公司已经在财务运营中使用了AI,其中41%的公司在中高度依赖AI。AI的引入为金融业带来显著效益,例如提升运营效率、降低合规成本、发掘新的盈利机会等。当然,面对AI模型可能存在的偏见或不透明决策(例如信用评分模型可能隐含歧视),金融机构也在加强负责任的AI治理,确保模型决策公平、公正、可解释。在严格监管和风险控制要求下,金融AI的发展正朝着“可信AI”方向演进,即在追求业务价值的同时满足安全合规与伦理责任的要求。

3. 教育领域: 人工智能在教育行业展现出巨大的变革潜力。通过智能导师、个性化学习系统等应用,AI有望帮助实现“因材施教”、提高教学效率并扩展教育的可及性。自适应学习平台是典型应用之一:AI系统根据学生的学习行为和测验结果,动态调整教学内容和难度。例如,数学辅导系统可以跟踪学生对不同知识点的掌握情况,针对薄弱环节推荐额外练习,从而让每个学生按照最适合自己的节奏学习。这种个性化教学能够显著提升学习效果。智能家教(智能导师)则利用自然语言处理与知识图谱技术,与学生进行交互问答,解答疑惑并提供指导。在一些落后地区,AI导师可以部分缓解优秀师资不足的问题,为更多学生提供高质量教育资源。除了教学,AI还可以极大简化教师的行政和评估负担。例如自动阅卷与反馈系统已经可以比较准确地评判学生的主观题答案、作文等,并给出详细反馈。这不仅节省教师大量时间,也使学生能更快获得改进建议。同时,AI技术能够辅助教学管理,如通过数据分析优化课表编排、个性化地推荐课程给学生、预测哪些学生可能掉队以便及时干预等。在教育宏观决策上,教育部门可以借助AI分析区域教育数据,辅助制定教育政策和资源分配决策。联合国教科文组织(UNESCO)指出,人工智能有潜力解决当今教育面临的一些最大挑战,创新教学实践并加速实现全民优质教育(可持续发展目标4)。不过,UNESCO也强调快速发展的教育AI带来了多重风险和挑战,如数据隐私、算法偏见以及技术可能扩大教育鸿沟等。目前,国际社会正努力制定教育AI的伦理规范,确保AI应用遵循包容和公平的核心原则。总体而言,在教育领域人工智能正朝着“以学生为中心”的方向拓展,通过个性化和智能化手段,帮助更多学生以更有效的方式获取知识,同时辅助教师将精力更多投入创造性的教学活动。

4. 制造与工业领域: 制造业正在被人工智能重新定义,从设计、生产到维护的整个生命周期中,AI技术无处不在。现代制造业正迈向智能制造或工业4.0阶段,AI是核心驱动力之一。首先,在产品设计和工艺规划环节,AI能够辅助工程师进行优化。所谓生成式设计(Generative Design)利用算法在给定约束下自动产生海量设计方案,工程师从中筛选出创新且高性能的设计。一些航空航天和汽车企业已使用这类AI工具来设计更轻量且强度更高的零部件。其次,在生产过程中,AI通过机器视觉和传感数据分析实现质量控制和流程优化。部署于生产线上的计算机视觉系统可实时检测产品外观缺陷,比人工质检更快速准确。传感器数据经AI分析后,可以优化制造参数,减少能耗和废品率。预测性维护是制造业AI应用的另一个关键场景:机器设备装载的传感器将振动、温度等运行数据实时发送给AI系统,后者通过学习历史模式来预测设备何时可能故障。例如,汽车厂通过AI监测机器人手臂的电流和温度变化,在零件磨损或故障征兆出现前就安排检修,从而避免生产线意外停机。这种预防性维护降低了停工损失和维修成本,提高了设备可靠性。此外,制造企业也引入强化学习来自动调整生产调度和库存管理,实现智能调度与供应链优化。AI可以综合考虑订单需求、生产能力和物流约束,给出最优的生产排程和库存策略,以实时决策提高灵活性和效率。值得一提的是,人机协作机器人(cobot)已开始走入工厂。新一代的AI驱动协作机器人可以在没有围栏的情况下与工人并肩工作,承担繁重或重复的装配任务,而让工人专注于更高级的工作。这种协作不仅提高了产能,也改善了一线工人的工作环境。整体来看,人工智能推动制造业向着更加智能、自主和高效的方向发展,形成所谓“智能工厂”。AI系统监控着生产的各个环节,能够自主调节参数、协调资源以最大化产出并减少浪费。这些改变正在为制造企业带来显著的竞争优势——据调查,超过三分之二的制造商认为AI将成为驱动未来增长的关键技术,近77%的制造企业已经在不同程度上实施了AI方案。可以预见,随着AI技术的深化应用,制造业将实现更高水平的自动化和定制化,传统工厂将转型为高度互联且富有弹性的“智慧工厂”。

5. 交通运输领域: 人工智能在交通运输行业的应用令人瞩目,正引领我们走向更安全、高效的出行未来。最引人关注的莫过于自动驾驶技术。自动驾驶车辆依赖AI“大脑”来实时处理来自摄像头、激光雷达、雷达等多种传感器的数据,从而感知环境、规划路径并控制车辆行动。车辆上的智能算法相当于一名“人工司机”,它利用机器学习模型模拟人类的感知和决策过程,包括识别路上行人和交通标志、预测其他车辆的行为、规划驾驶路线以及及时刹车或转向避让危险。随着深度学习的发展,感知精度和决策水平不断提升,近年已经有多家公司开始在公开道路上部署自动驾驶出租车服务。例如,美国的Waymo公司的自动驾驶车队在凤凰城等地每天为大量乘客提供无人驾驶出行服务,每周完成超过15万次自动驾驶载客。中国的百度Apollo Go也已在多个城市上线运营。这标志着自动驾驶从实验验证逐步走向商业化应用。当然,目前这些车仍主要限定在特定城市区域(Geo-fencing)和良好天气条件下运行,完全无人驾驶(SAE L5级)在全球范围的大规模普及尚需时日。但AI在交通领域的作用远不止自动驾驶。智能交通管理也是一个重要方向:城市交通管理部门利用人工智能分析交通传感器和摄像头数据,能够实时优化红绿灯配时,根据路况动态调整信号以缓解拥堵。一些先进城市已经部署了AI驱动的交通控制系统,可以提前预测某一路段在未来几分钟可能发生的拥堵,并自动调整相邻路口的信号灯以疏导交通。实践证明,这类智能交通系统可将高峰期延误时间显著降低,提高通勤效率并减少车辆怠速造成的污染排放。另外,在公共交通方面,AI也发挥着作用。例如利用机器学习对历史乘客出行数据建模,可以更准确地预测公交或地铁线路的客流需求。这样公交调度部门可以优化车辆发车频率和线路配置,减少乘客等待时间。在物流运输领域,物流公司运用AI算法进行车辆路线优化,动态规划出送货卡车的最佳路径以节省油耗和时间。同时,仓储中的机器人拣选系统通过计算机视觉和强化学习,实现了自动分拣货物,提高了履约速度和准确度。可以说,从人乘车到货运,人工智能正让交通运输系统变得更聪明。更长远地看,车路协同也是AI助力交通的前沿方向:未来的智慧城市中,车辆、红绿灯、道路基础设施将通过物联网互联,AI作为大脑统筹协作,实现整体交通流的优化与自动协调。这将进一步提升交通安全、减少拥堵,并为无人驾驶汽车更好地融入道路交通创造条件。总体而言,人工智能驱动的智慧交通正在从多个层面改善我们的出行体验,朝着更安全、高效、可持续的交通体系迈进。

人工智能正成为各行业革新的引擎。无论是提升医疗诊断准确率、降低金融运营成本,还是改善工业生产效率、缓解城市交通拥堵,AI技术都展现出独特价值。当然,不同行业在应用AI时也面临各自的挑战,例如医疗领域对算法可信性的要求、金融领域的监管合规约束、教育领域对公平和隐私的关注等等。总体而言,AI在行业中的成功应用离不开对数据和行业知识的深度结合,以及对潜在风险的有效管理。随着技术的成熟和经验的积累,相信人工智能将在更多场景下大放异彩,驱动各行业迈向智能化的未来。

三、深度学习的角色与贡献

在人工智能近几十年的发展中,深度学习(Deep Learning)无疑扮演了举足轻重的角色。深度学习指利用包含多层神经网络的计算模型,从海量数据中自动学习多级抽象的特征表示。相比以往由人手工设计规则或特征的方法,深度学习可以让计算机自主提取数据特征,因而在模式识别任务上取得突破性的性能提升。自2006年前后Geoffrey Hinton等人重新唤起对多层神经网络的研究热情以来,深度学习经历了从“小荷初露”到“一骑绝尘”的发展过程。可以说,深度学习技术的演进和成熟,直接推动了2010年代那场令AI声名鹊起的技术革命。

1. 深度学习的兴起与发展: 虽然人工神经网络的思想早在上世纪中叶就已提出,但深度神经网络(包含多层隐藏层)的训练在很长时间内面临困难(如梯度消失问题)。直到2006年,Hinton等提出逐层预训练的深度信念网络(DBN),才让训练深层网络成为可能。同一时期,计算硬件——尤其是图形处理器(GPU)的并行计算能力——迅速提升,为训练大规模神经网络提供了算力支撑。2012年是深度学习发展的分水岭:Hinton指导的学生Alex Krizhevsky等设计的AlexNet模型以深度卷积神经网络(CNN)结构赢得ImageNet图像识别竞赛冠军,错误率远低于以往算法。这一壮举让全球AI界为之震惊,被广泛视为“深度学习时代”正式开启的标志。AlexNet的成功来自于8层卷积神经网络对海量图像数据的端到端学习能力,相比传统方法无需人工提取视觉特征,因而表现卓越。这一事件使深度学习迅速成为计算机视觉领域的主流方法,并很快扩展到语音识别、自然语言处理等领域。

2. 关键模型与技术路线: 在深度学习浪潮中,一系列里程碑式的模型相继出现,奠定了今天AI技术的基石。以下列出其中具有代表性的几类模型及其贡献:

-

卷积神经网络(CNN): CNN擅长处理图像等具有网格拓扑结构的数据,由1980年代的Fukushima提出概念、Yann LeCun在1990年代发展(如用于手写数字识别的LeNet-5)。CNN的核心是在网络中引入卷积层和池化层,通过局部感受野、权值共享机制来提取平移不变的特征。简单来说,卷积层能自动学习图像的边缘、纹理等低级模式,多层卷积叠加可形成对复杂图案的高级表征。CNN在计算上高效且对图像噪声和变形具有鲁棒性,因而一举解决了计算机视觉长期存在的特征提取瓶颈。AlexNet正是深度CNN的成功案例,此后VGG、GoogLeNet、ResNet等更深更复杂的CNN模型不断刷新ImageNet等基准的识别精度。CNN不仅在图像分类,还广泛用于目标检测、语义分割、医学影像分析等任务,是视觉AI领域当之无愧的工作马车。

-

循环神经网络(RNN)及长短期记忆网络(LSTM): 传统的前馈网络无法有效处理序列数据,而循环神经网络允许网络具有“记忆”功能,即通过隐藏状态循环连接来捕捉时间序列上的依赖关系。这使RNN非常适用于语音、文本等顺序数据的建模。然而,普通RNN难以学习长距离依赖,于是1997年Sepp Hochreiter和Jürgen Schmidhuber提出了长短期记忆网络(LSTM)。LSTM通过设计“门控机制”来控制信息的记忆和遗忘,成功缓解了梯度消失问题,可以将重要信息在序列中长时间保存。LSTM和稍后的GRU等变体,使得RNN真正能够应用于复杂长序列任务,如长篇文章理解、长语音信号处理等。2010年代中期,基于LSTM的序列到序列(Seq2Seq)模型在机器翻译上取得突破(如Google神经机器翻译系统),证明了RNN强大的建模能力。可以说,在Transformer问世前,LSTM主宰了序列学习领域,为语音识别、机器翻译、语言建模等任务提供了有效方案。

-

Transformer和自注意力机制: 2017年Vaswani等人发表的著名论文《Attention is All You Need》,提出了Transformer模型,彻底改变了自然语言处理(NLP)的技术路线。Transformer摒弃了传统RNN的循环结构,转而完全依赖自注意力机制来建模序列内部的依赖关系。自注意力通过计算序列中任意两个位置之间的相关性(注意力权重),实现对长距离依赖的高效建模,且可以并行计算,从而极大提高了训练效率。Transformer由编码器-解码器堆叠组成,通过多头注意力机制和前馈网络对输入序列进行编码,再根据上下文生成输出序列。凭借这种架构,Transformer在机器翻译、文本摘要等任务上性能大幅超越当时基于RNN/LSTM的方法。更重要的是,Transformer的通用性使其迅速扩展到计算机视觉、多模态处理等领域。例如,2018年的BERT模型使用Transformer编码器实现了对语言的双向表示预训练,在11项NLP任务上刷新成绩;Vision Transformer (ViT) 将Transformer应用于图像块序列,同样取得不逊于CNN的效果。可以说,Transformer引领了预训练大模型的潮流——通过在海量数据上训练通用表示,然后迁移到下游任务微调。在GPT-3等模型中,Transformer展现出惊人的生成和推理能力,成为构建当前大语言模型(LLM)的标准架构。

上述模型之外,深度学习领域还有许多重要进展,例如生成对抗网络(GAN)在生成模型领域打开新天地,图神经网络(GNN)将深度学习拓展到非欧几里得结构数据,强化学习结合深度网络在游戏和机器人控制上取得突破等等。但无论具体模型如何,数据、算力和算法被誉为驱动深度学习的“三要素”。在深度学习的发展过程中,ImageNet等大规模数据集的建立提供了“燃料”,GPU/TPU等高性能计算硬件提供了“引擎”,而新的网络结构和训练技巧则是不断改进的“路线图”。特别是迁移学习与预训练技术的兴起,使深度学习模型可以先在通用数据上学习丰富特征,再通过微调适应特定任务。这种范式极大提高了各种任务的性能和数据效率。例如,一个在海量文本上预训练过的语言模型(如BERT)只需少量标注样本微调,就能在阅读理解、问答等任务上表现优异。迁移学习极大拓宽了深度学习的适用范围。

深度学习对人工智能的贡献是全方位的:它让计算机视觉、语音识别、自然语言处理等AI核心领域取得质的飞跃,让许多过去被视为遥远的目标成为现实。例如,深度学习驱动的视觉识别使无人驾驶汽车成为可能,深度学习的语言模型催生了实用的机器翻译和智能客服。可以说,深度学习成为近年来人工智能腾飞的主要推动力,许多业界里程碑都源自深度学习技术的应用。然而,也需要看到当前深度学习的局限:这些模型往往被称为“狭义AI”,擅长特定任务但缺乏类人般的灵活推理和常识。深度学习模型需要大量数据训练且缺乏可解释性,在应对未知环境和推理复杂关系方面仍显不足。这也正是当前AI研究的热点之一,即如何超越深度学习的瓶颈,朝着更通用、更智能的方向发展。下一节中,我们将围绕这些前沿方向展开讨论。

下面通过一张表格比较深度学习领域几种代表性模型,以更清晰地了解它们的特点和演进路线:

表:深度学习三种代表性模型的对比。CNN侧重空间特征提取,RNN/LSTM擅长顺序建模,Transformer则凭借注意力机制成为通用的序列建模架构。

深度学习的成功令人工智能取得飞跃,但这并不意味着它解决了AI领域的所有难题。当前的深度学习模型参数规模巨大、训练成本高昂(如GPT-3有上千亿参数,训练费用数百万美元),同时能耗也很可观。此外,深度模型往往欠缺可解释性和因果推理能力。这些问题正促使研究者探索新的改进方向,如模型压缩、联邦学习、可解释AI等,以提高深度学习的效率、透明度和安全性。可以说,深度学习本身也在不断演进,它与其他AI方法(符号主义、进化算法等)正在出现融合趋势,例如神经符号混合模型试图结合符号推理和神经网络的优点。面向未来,实现真正类似人类智能的AI系统,可能需要超越当前深度学习范式,引入更多灵活性和推理能力。下一节我们将详细讨论人工智能未来可能的发展方向,其中很多议题实际上都是在反思**“后深度学习时代”**的技术路线。

四、人工智能未来发展的趋势展望

面对当前人工智能的巨大发展成就,我们也需要思考下一个十年乃至更长远的未来,AI将朝什么方向演进?本节将围绕几大前沿议题展开深入讨论,包括通用人工智能(AGI)、类脑计算、自动化机器学习、自监督学习、多模态学习以及大模型的优化与加速等。这些方向代表了AI未来可能的技术突破点和演进路径。需要强调的是,这些议题彼此并非独立隔绝,而是交叉影响、相辅相成。例如,实现AGI可能需要结合类脑硬件和自监督学习的思想;优化大模型的效率又是支撑AGI系统落地的必要条件。下面我们逐一进行介绍和分析。

1. 通用人工智能(AGI): 通用人工智能(Artificial General Intelligence)通常指具有类似人类一般的学习、推理和适应能力的人工智能系统,即“强人工智能”。与当前专注单一任务或领域的“弱AI”不同,AGI应能胜任任意智力任务,并在未知环境中举一反三。AGI的实现一直被视为人工智能的终极目标。根据Nature刊登的定义,AGI涉及构建能够跨领域复制人类认知能力的AI系统,被认为将带来颠覆性的社会和经济影响。一旦机器拥有了类似人类的通用智能,它可能在科学研究、技术创新等方面产生“智能爆炸”,引发超出人类理解范围的快速进步。当然,这也会带来前所未有的伦理和安全挑战,包括失控的AI决策甚至对人类生存的潜在威胁。目前,AGI依然是一个理论上的概念,没有明确的实现路径。但一些里程碑被视为朝AGI迈进的重要一步,例如AlphaGo在人类智力领域(围棋)取得突破,GPT-3展示出的语言理解和生成能力接近通用对话。有人乐观预测,在未来几十年内可能出现具有人类水平认知能力的AGI雏形。然而,多数专家认为AGI距离真正实现仍有很长的路,要克服的难题包括:常识推理(机器缺乏对物理和社会常识的理解)、自我意识(机器没有主观意识)以及自主学习(无需海量标注数据、自主从环境中学会学习)。实现AGI或许需要我们重新审视智能的定义,并融合多学科力量,如认知科学、神经科学对人脑机制的研究等。近年学界也提出一些探索方向,例如Marcus等人主张引入符号推理提高AI的可解释性和系统性,LeCun等人则强调发展自监督学习获取世界模型作为通向通用智能的关键。无论路径如何,确保AGI安全可控已成为全球关注焦点之一。许多机构(如OpenAI、DeepMind等)在研究AGI的同时,也制定了安全准则,希望在实现通用智能的过程中避免失控。各国政府和国际组织也开始讨论AGI的伦理规范和监管框架,为未来可能出现的强人工智能做好政策准备。可以预见,AGI的追寻既充满诱惑也伴随风险,一旦实现将深刻改变人类文明的发展轨迹。

2. 类脑计算(Neuromorphic Computing): 人类大脑是一个不可思议的天然智能系统,具有高效并行处理和低功耗的优点。类脑计算旨在从大脑获得灵感,研制在结构和工作机制上模拟生物神经系统的新型计算硬件与算法。传统冯·诺依曼计算机在AI任务上遇到的瓶颈之一是能耗和延迟过高。例如,大型深度神经网络的训练和推理需要消耗巨大的电能。据统计,训练一次GPT-3模型的电费可能高达几十万美元,这不仅成本高昂也不利于环保。在这种背景下,研究者开始探索突破摩尔定律极限的新范式,类脑计算就是其中最被看好的方向之一。类脑计算机的设计核心是模拟神经元和突触的功能,它常常采用“脉冲神经网络”(SNN)形式,使用离散电信号(脉冲)进行计算,类似生物神经元发放脉冲。这种架构可以做到“事件驱动”的异步计算:只有当输入发生变化时才产生脉冲进行计算,静止时则几乎不耗能。相比传统计算每时每刻都在同步运行,事件驱动计算显著降低功耗。同时,类脑芯片一般将存储单元和计算单元结合(存算一体化),仿效大脑中记忆存储和计算同时在突触进行,从而减少数据搬运导致的延迟和能耗。目前Intel、IBM等公司已经研发出多款类脑芯片原型,如Intel的Loihi芯片、IBM的TrueNorth芯片等。这些芯片集成了成百上千万个人工神经元和突触,能够用于实现简单的脉冲神经网络算法。实验表明,在执行某些任务(例如手势识别、稀疏数据分析)时,类脑芯片相比GPU/CPU可提升能效数百倍。Nature的一篇综述指出,类脑计算技术近年取得重要突破,被视为克服传统数字计算功耗与延迟瓶颈的替代方案。当然,类脑计算目前仍处于早期探索阶段,要大规模应用还有不少难题。一方面,如何编程和训练脉冲神经网络还不成熟,需要新的算法和工具链支持;另一方面,现有类脑硬件的集成度和可靠性还有待提高。不过,可以预见随着材料科学、纳米技术的发展,未来类脑芯片将拥有更多神经元、更高稳定性,并与传统AI算法更好结合。脑机接口等技术的发展也可能反过来推动类脑算法优化。总而言之,类脑计算代表了AI硬件演进的重要方向,它有望实现功耗更低、响应更快的智能系统。例如,将类脑芯片用于无人机、物联网终端等场景,可以使这些设备具备复杂感知和决策能力而耗电极少。随着对大脑认知原理的深入理解和工程技术的进步,类脑计算有潜力成为下一代AI计算架构的基石,引领计算范式从冯·诺依曼迈向全新形态。

3. 自动机器学习(AutoML): 尽管深度学习模型威力巨大,但构建和调优AI模型仍是一项高度专业化且费时费力的工作。需要AI专家决定模型架构、超参数组合,并不断试错优化。这不仅门槛高,而且对不同任务都需定制开发,严重制约了AI的普及。自动机器学习(AutoML)正是为了解决这一痛点而兴起的研究方向。AutoML的目标是自动化机器学习流程,包括自动选择模型、调节超参数,甚至自动生成神经网络结构,从而让没有深厚AI背景的从业者也能轻松训练出高性能模型。AutoML的思想可以追溯到元学习(Meta-Learning)和超参数优化等概念。例如,通过“学习如何学习”,AutoML系统可以借鉴以往类似任务上模型表现的数据,快速推断出新任务的合适模型配置。近年来,AutoML取得了长足进展。其中一个里程碑是Google于2017年提出的神经架构搜索(NAS),它使用强化学习或遗传算法自动探索神经网络架构设计,大幅减少了人工设计网络的工作。NAS技术已经成功用于设计出超过人工专家水准的网络结构(如MobileNetV3)。除了架构搜索,AutoML还涵盖自动特征工程、自动模型选择、自动超参数调优、自动管道组合等方面。例如,在Kaggle数据科学比赛中,一些参赛者使用AutoML工具(如Auto-sklearn、H2O.ai等)可以一键生成完整的数据处理和建模流水线,其效果不亚于人工精心调参的模型。AutoML被认为是让AI民主化的重要途径之一——通过降低技术壁垒,让各行各业的工程师都能运用AI解决问题。目前,工业界已经推出多种AutoML服务,如谷歌Cloud AutoML、微软AutoML、亚马逊SageMaker Autopilot等,用户只需提供数据,这些服务即可自动训练并返回优化后的模型。据综述显示,AutoML研究正从早期的模型/参数优化,拓展到自动化整个机器学习管道、增强模型可解释性以及结合人类专家反馈的混合优化等方向。当然,AutoML也面临一些挑战,比如自动探索空间巨大导致的计算成本问题、对新颖任务的泛化能力问题等等。但随着算法改进(如高效的贝叶斯优化、分布式并行搜索)和硬件提升,这些障碍正逐步被克服。可以预见,未来成熟的AutoML系统将成为数据科学家的强力助手,甚至充当“AI设计的AI”:利用AI来设计优化新的AI模型。当机器学习的繁琐劳动被自动化,人类可以将更多精力投入到更高层面的创造性工作,比如提出问题、诠释结果和决策应用上。这将极大加速AI在各领域的落地应用,让AI真正成为普适的生产力工具。

4. 自监督学习: 当前许多AI应用依赖于监督学习,需要大量人工标注的数据来训练模型。然而,获取海量高质量标注数据往往代价高昂,甚至在一些领域几乎不可能(例如让机器拥有常识)。与此形成对照,人类和动物主要依靠无监督的方式从环境中学习,只有少部分信息带有明确标签。自监督学习(Self-Supervised Learning, SSL)由此受到关注。它通过让模型在未标注数据上设计预测任务,从数据本身学习有用的表征。简单来说,自监督学习会从数据中生成伪标签或学习信号,让模型自己在海量未标注样本上训练。例如,对图像可以采用拼图恢复、旋转预测等任务;对文本可以采用上下文预测(如BERT遮蔽词预测)作为自监督目标。通过完成这些预设的“猜谜”任务,模型被迫学会理解数据内部结构,从而学到对下游任务有用的特征表示。自监督的威力在于可以利用互联网上数以百亿计的无标签数据,这被Yann LeCun形象地称为“智能的暗物质”——占据了数据宇宙的大部分,却尚未被AI充分利用。近年的研究表明,自监督学习已经取得一些突破进展。如NLP领域的GPT和BERT模型,本质上就是通过预测下一个单词或掩盖单词等自监督任务在海量文本上预训练,从而获得惊人的语言理解与生成能力。计算机视觉领域也出现了SimCLR、MoCo等自监督框架,它们通过对比学习等方法,在无标注图片上学到的视觉特征可以媲美有监督模型。自监督学习被视为通向类似人类认知能力的关键,因为它可能赋予AI一定程度的常识和世界模型。有了自监督预训练的支撑,AI在下游任务上可以大幅减少对人工标注的依赖,这对于医学、科学研究等标注极为困难的领域尤为重要。更远的设想是,当自监督学习发展成熟,AI或许能够通过持续感知环境、提出假设并验证,形成自主的知识获取循环——这将是朝通用智能迈进的重要一步。当然,目前自监督学习还不是万能的。模型从无标签数据学到的表示不一定对每个任务都足够,好比人类小孩在足够探索世界前也无法理解高级概念。因此研究者也在探索自监督结合少量监督的方案,以及设计更丰富的预训练目标来逼近人类学习机制。总之,自监督学习已经被证明是提高AI数据效率和获取背景知识的有效途径,被很多专家寄予厚望。未来,我们或许将看到AI通过观察视频、自主阅读文章等方式,自己“上学”汲取知识,逐渐具备更加广泛灵活的智能。

5. 多模态学习: 人类的智能是多感官协同的结果——我们通过视觉、听觉、触觉等多种感官综合理解世界。例如,看电影时,图像和声音共同塑造我们的感知。相比之下,传统AI系统往往专注于单一模态:图像算法只处理图像,NLP模型只处理文本。多模态学习旨在让AI能同时理解和融合多种形式的数据(如视觉、语言、语音、传感器信号等),实现更全面深刻的智能。通过结合来自不同模态的信息,AI有望具备更接近人类的认知能力。例如,在图像描述任务中,多模态模型需要将计算机视觉和自然语言处理结合,自动为图片生成描述性文本。这要求模型既看懂图像内容,又用恰当的语言表述出来。Google于2016年推出的Show-And-Tell模型是这类任务的早期成果,随后OpenAI的CLIP模型(2021年)更是通过对海量图文对进行联合训练,学到了通用的视觉-语言语义空间,可以执行跨模态的图文检索和匹配。在视觉问答(VQA)任务中,模型需要根据给定图像回答自然语言问题,也需要融合视觉和语言理解能力。多模态融合带来的另一个显著进步是最近大火的文本生成图像应用,如OpenAI的DALL·E和Stable Diffusion模型。它们使用跨模态的深度网络,将文本指令转换成相应图像,实现了“AI作画”。其背后的训练也是基于大规模图文对,模型学会了文字和视觉概念之间的对应关系。这类生成式多模态模型展现出惊人的创造力,可以根据文本描述生成从未见过的图像场景。多模态学习还推动了机器人领域的进步,让机器人能够同时处理摄像头画面、语言指令和力觉传感信息,更好地与环境和人互动。另外,在医疗中,融合患者的医学影像和临床文本记录的多模态AI有望提高诊断准确率。总体来说,多模态学习被认为是迈向更高级AI的重要一步,因为世界本身是多模态的,单一模态的信息往往不完整或有歧义,只有综合多个模态才能全面理解。多模态AI系统需要解决的挑战包括:如何表示和对齐不同模态的数据(比如将图像像素与文本词语映射到共同表示空间)、如何设计融合架构高效结合信息,以及如何处理模态不完整或不一致的情况。目前Transformer等模型为多模态融合提供了一种统一框架,其自注意力机制天然适合处理序列,不论是文字序列还是图像切分序列,都可以作为输入进行融合。这在实践中取得了不错效果。未来,多模态学习有望赋予AI更接近人类的认知:比如能够“看图说话”、通过视觉线索理解语言隐喻,甚至像人一样利用多感官线索进行常识推理。可以想见,一个强大的多模态AI或许就是实现AGI的雏形,因为它具备了通过不同信息源立体感知世界并推理的能力。

6. 大模型的优化与推理加速: 近年来,人工智能领域呈现出明显的“大模型化”趋势:模型参数规模动辄数十亿、上千亿(GPT-3等),训练数据量也是铺天盖地。超大模型的确带来了性能提升和能力跃迁,但也带来了高昂的计算和存储代价。例如,部署一个大语言模型需要占用数百GB显存,在边缘设备或普通服务器上难以运行。因此,如何优化大模型、提高其推理效率,已成为实用AI的关键问题。为此,研究人员从算法和硬件两端都提出了解决方案。在算法层面,最典型的方法包括模型压缩技术,如模型剪枝、量化、蒸馏等。剪枝通过移除模型中冗余的连接和神经元,来减少模型尺寸和计算量;量化则将模型参数从32位浮点降低到8位甚至更低位表示,以降低内存和运算需求;知识蒸馏通过训练一个小模型去模仿大模型的输出,从而获得一个在性能接近的同时体积大幅缩小的模型。这些方法在近年来的研究中取得了显著进展。例如,通过混合剪枝和量化,一些研究成功将GPT-3模型压缩90%以上,同时几乎不损失精度。另外还有稀疏化技术,通过让模型权重矩阵呈稀疏结构来利用稀疏矩阵乘法加速;低秩分解通过矩阵分解减少参数;MoE(专家混合)模型通过划分子模型专家仅激活一部分网络也达到扩展模型容量的目的。这些手段综合运用,能够将大模型的推理速度提高数倍甚至一个数量级。斯坦福AI指数报告的数据显示,从2022年11月到2024年10月,达到类似GPT-3.5水平性能的推理成本下降了超过280倍——这既归功于算法优化,也受益于硬件效率提升。同时,各大芯片厂商也在推出针对AI的大算力芯片和加速器。例如,英伟达GPU不断迭代提升AI计算吞吐量,谷歌的TPU专用于深度学习计算,还有各种ASIC加速器专门优化Transformer等模型的矩阵运算。此外,分布式计算框架的发展允许将巨型模型的计算分摊到数百上千的GPU/TPU上并行完成训练和推理。未来,量子计算等新兴技术也可能为大模型提供加速可能性。大模型优化的另一个思路是在软件层面提升内存和计算效率,如通过流水线并行、张量切片并行等范式更好地利用硬件资源,或通过算符融合、图优化等编译技术减少不必要的中间开销。总之,随着大模型在AI中的核心地位日益稳固,对其进行压缩和加速是必不可少的工作。一方面,这是为了让大模型更环保、更经济——据测算大模型的碳足迹非常可观,提升效率可以减少能源消耗。另一方面,这也是为了让大模型走出数据中心,在移动设备、物联网终端等算力有限的环境中运行。这对普及AI应用、保护数据隐私(在本地推理)都有意义。可以预见,未来几年我们将看到更多大模型高效化的创新,使得“巨兽”般的AI模型能够更敏捷地服务于各行各业,实现算力与智能的良性平衡。

以上探讨的几个方向只是人工智能未来发展的部分侧面。当然,AI的未来图景远不止技术层面,还有许多社会、人文、政策方面的问题需要同步考虑。下一节中,我们将就AI的发展对社会产生的影响、所引发的伦理挑战及各国监管的趋势做一个简要总结,以全面看待人工智能蓬勃发展所带来的机遇与风险。

五、社会影响、伦理挑战与监管趋势

人工智能技术的迅猛发展不仅带来了生产力的跃升,也对社会结构、伦理道德和治理体系提出了新的课题。首先在经济与就业方面,AI正成为新的通用目的技术,被广泛应用于生产制造、商业服务等领域。这一方面提高了劳动生产率,降低了许多行业的运营成本;但另一方面也引发了对就业替代的担忧。不少重复性高、技能要求低的岗位正面临被自动化取代的风险,例如制造业装配线工人、物流仓储人员、客服专员等。麦肯锡等机构的报告预测未来十年全球可能有数亿工作岗位受到AI影响而需要转型。然而历史经验表明,新技术同时也会创造新的就业机会和岗位类型,比如AI工程师、数据标注师、算法审核员等职业的兴起。因此关键在于社会如何做好劳动力技能的再培训和保障工作,使劳动力顺利从被替代的岗位转移到更具创造性的岗位上去。

其次在公平与偏见方面,由于AI系统是基于历史数据训练的,如果数据中包含偏见,模型可能会在决策中放大这些偏见。例如,人脸识别算法被发现对有色人种识别准确率低,这是训练数据分布不平衡导致的;招聘筛选AI曾因训练自历史录用数据而被曝出歧视女性求职者。这些案例提醒我们,AI并非中立客观的“上帝视角”,其输出可能无意中巩固现有的不公正结构。因此,必须在技术和制度层面采取措施来消除算法偏见。技术上,可通过数据平衡、算法公平约束、可解释性提高等手段减轻偏见。制度上,需要建立审查和纠偏机制,确保AI系统的决策对不同群体公正。例如,欧盟拟议的《AI法案》中要求高风险AI系统提供透明说明和避免歧视的证明。可以预见,AI伦理原则(如公平、公正、透明、可问责)将日益成为AI系统设计和评估的必要准则。

隐私与安全也是公众非常关切的问题。AI的高性能往往依赖对海量个人数据的分析,这带来了数据隐私泄露风险。如果没有适当的保护机制,AI系统可能滥用个人敏感信息用于不当目的,或在网络攻击下泄露用户数据。因此,各国都在强化数据保护法律,例如欧盟的GDPR已经对AI涉及的个人数据使用作出了严格规范。技术上,联邦学习、差分隐私等新方法正被应用,尽量在模型训练和推理过程中对用户数据进行保护。另外,随着AI深入关键基础设施(如电网、交通控制等),其安全性变得至关重要。AI系统出现失误或被恶意利用,可能造成重大事故或损失。这要求我们对AI系统建立冗余和校验机制,确保在异常状况下系统行为可控。此外,AI还可能被用于网络攻击、生成虚假信息(如Deepfake),对社会安全和舆论生态造成负面影响。如何防范AI武器化和滥用已成为全球安全的新挑战,需要国际合作制定应对策略。

面对上述种种挑战,各国政府和国际组织正积极行动以引导和规范AI的发展。在政策层面,欧美主要国家近年陆续发布了国家AI战略,将“可信AI”、“以人为本”作为核心理念。例如,欧盟于2021年提出《人工智能法案》(草案),这是全球首部试图全面规范AI的法律文件,按照AI风险等级采取不同监管措施,禁止一些不可接受的高风险AI应用(如社会信用评分、实时人脸识别)。美国也在2022年发布了《AI权利法案蓝图》,提出了确保AI系统安全有效、保护隐私、防止算法歧视等指导原则。中国等国家则强调发展与治理并重,出台了针对算法推荐、深度合成等具体应用的管理规定,要求运营者确保内容合规和结果可解释。国际层面,全球AI治理框架正在逐步形成:2023年,联合国教科文组织的《AI伦理建议书》得到100多个成员国批准,确立了AI伦理的基本原则;经济合作与发展组织(OECD)早在2019年就发布了AI治理原则,被G20等广泛认可。2023年10月,全球多国政府和科技公司代表在英国的AI安全峰会上讨论了前沿模型带来的风险和治理合作。可以说,各国政府正以前所未有的紧迫感介入AI治理:据统计,仅2024年美国联邦机构就推出了59项与AI相关的法规,是前一年的两倍。全球有75个国家的议会在2023年讨论AI议题,比2016年增加了超过20%。这一系列举措表明,在享受AI技术红利的同时,世界各国都意识到必须未雨绸缪,通过完善政策法规来防范AI可能带来的负面后果,确保这项强大技术沿着有利于人类的方向发展。

结语: 站在2025年的时间节点回望和前瞻,我们既见证了人工智能从萌芽走向繁荣的非凡历程,也深刻认识到其未来道路上的机遇与挑战并存。人工智能的起源与发展史告诉我们,每一次技术范式的更替都凝聚着人类的智慧创新和不懈探索。从符号AI到机器学习再到深度学习,AI实现了一次又一次质的飞跃。如今,人工智能的应用早已超越实验室,深入医疗、金融、工业、交通、教育等诸多领域,为经济社会带来巨大效益。但AI技术并非中性的工具,它所引发的伦理和治理问题需要我们慎重应对。在走向未来的征程中,人工智能或将迎来新的范式转变:我们期待通用人工智能的曙光,同时也在探索更加高效可信的技术路径(如类脑计算、自监督学习等)来支撑这一远景。可以肯定的是,人工智能的未来图景将由全球科研人员、产业界和政策制定者共同绘就。只有在确保安全、伦理、包容的前提下,AI才能更好地造福全人类。让我们拥抱这一变革性的技术,同时以审慎和智慧引导其前行。下一个十年,人工智能的发展必将更加精彩,也更加值得我们期待。

参考资料

-

Newell, A. & Simon, H. A. (1956). The logic theory machine: A complex information processing system. IRE Transactions on Information Theory, 2(3), 61–79. DOI: 10.1109/TIT.1956.1056797 (Early AI program Logic Theorist)

-

McCarthy, J., Minsky, M., Rochester, N., & Shannon, C. (1955). A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence. (Introduced the term “artificial intelligence”, Dartmouth Workshop 1956)

-

Nilsson, N. J. (2009). The Quest for Artificial Intelligence. Cambridge University Press. (Comprehensive history of AI, includes “AI winter” periods)

-

Radanliev, P. (2024). Artificial intelligence: reflecting on the past and looking towards the next paradigm shift. Journal of Experimental & Theoretical Artificial Intelligence. Advance online publication. DOI: 10.1080/0952813X.2024.2323042 (Surveys AI progress from logic-based systems to deep learning breakthroughs like BERT, GPT-3, etc.)

-

Stanford Institute for Human-Centered AI (HAI). (2025). AI Index Report 2025. Stanford University. (Annual report on AI progress and trends; notes AI adoption, performance, and governance indicators)

-

Nature Editorial. (2024). AI in health care. Nature (Collection). (AI revolutionizing health care from drug discovery, diagnosis, imaging to treatment)

-

Li, X., et al. (2023). Artificial intelligence applications in finance: a survey. Journal of Management Analytics, 10(4), 676–692. DOI: 10.1080/23270012.2023.2244503 (AI use-cases in finance: forecasting, risk management, decision-making)

-

KPMG International. (2024). Global AI in Finance Report. (71% of surveyed companies use AI in finance operations; AI adoption across accounting, treasury, risk, tax, etc.)

-

UNESCO. (2023). Artificial intelligence in education: Guidance for policy-makers. UNESCO, Paris. (AI’s potential and challenges in education; emphasizes inclusion & equity)

-

IBM. (2023). How is AI being used in manufacturing? IBM Think Blog. (AI enhances manufacturing efficiency, quality, and adaptability; covers predictive maintenance, quality control, cobots, etc.)

-

Center for Sustainable Systems, University of Michigan. (2023). Autonomous Vehicles Factsheet. (AI in self-driving cars uses sensors and maps to simulate human perception and decision-making)

-

PTV Group. (2025). AI in Transportation: How Artificial Intelligence Transforms Mobility. (AI enables accurate demand forecasting, vehicle distribution optimization, and intelligent traffic management in urban transport)

-

LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep Learning. Nature, 521(7553), 436–444. DOI: 10.1038/nature14539 (Introduces deep learning and its multi-layer representation learning approach)

-

Vaswani, A., et al. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems (NeurIPS). (Proposes the Transformer architecture based on self-attention, revolutionizing NLP)

-

Zhu, X., et al. (2024). A Survey on Model Compression for Large Language Models. Trans. Assoc. Comput. Linguistics, 12, 1556–1577. DOI: 10.1162/tacl_a_00704 (Covers quantization, pruning, distillation to improve efficiency of large AI models)

-

Varma, R. & Khan, S. (2023). Neuromorphic Computing: The Future of AI. Nature Electronics, 6(1), 8–10. DOI: 10.1038/s41928-022-00879-5 (Brain-inspired computing breakthroughs as alternatives to overcome power and latency limits of traditional computing)

-

Grill, B., et al. (2020). Bootstrap Your Own Latent: A New Approach to Self-Supervised Learning. Advances in Neural Information Processing Systems. (Example of self-supervised learning method leveraging unlabeled data for representation learning)

-

Hao, K. (2022). Can AI Be Truly Fair? MIT Technology Review. (Discusses AI bias issues and fairness; need for socio-technical approaches to mitigate bias in AI systems)

-

European Commission. (2021). Proposal for a Regulation laying down harmonised rules on Artificial Intelligence (AI Act). Brussels. (EU AI Act draft introducing risk-based AI regulation framework focusing on transparency, safety, and fundamental rights)

-

United Nations Educational, Scientific and Cultural Organization (UNESCO). (2021). Recommendation on the Ethics of Artificial Intelligence. Paris. (Global agreement on AI ethics principles like transparency, accountability, privacy and non-discrimination adopted by UNESCO member states)

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)