AI大模型相关专业术语笔记

大模型术语集,方便系统性了解大模型相关知识

模型术语

1.大语言模型(LLM)

- 基于深度学习的大规模神经网络模型,通常采用 Transformer架构,通过大规模数据集训练生成高质量文本(如GPT、BERT、Qwen3等)。

2.Transformer架构

- 采用 自注意力机制(Self-Attention)的神经网络架构,高效处理序列数据的长距离依赖关系,成为NLP主流架构。

3.自注意力机制(Self-Attention)

- 允许序列中每个元素关注其他元素的注意力机制,帮助捕捉长距离依赖关系。

4.多头注意力(Multi-Head Attention)

- Transformer中的机制,将注意力分解为多个“头”,学习输入的不同特征以提高表现力。

5.位置编码(Positional Encoding)

- 为Transformer提供序列位置信息的编码方式,弥补其无序列记忆能力的缺陷。

6.循环神经网络(RNN)

- 处理序列数据的神经网络,但存在梯度消失或爆炸问题,难以捕捉长期依赖。

7.长短期记忆网络(LSTM)

- 改进的RNN,通过门控机制解决梯度消失问题,增强长期依赖捕捉能力。

8.卷积神经网络(CNN)

- 用于图像处理的神经网络,通过卷积操作提取特征,也可用于文本分类等其他领域。

9.图神经网络(GNN)

- 处理图结构数据的神经网络,适用于社交网络分析、分子结构预测等。

10.混合专家模型(MoE, Mixture of Experts)

- 通过多个“专家”网络并行处理输入,门控机制选择最优结果,平衡计算效率与性能。

训练与优化技术

1.预训练(Pre-training)

- 在大规模无标注数据上训练模型,学习通用语言规律(如GPT-3的1750亿参数模型)。

2.微调(Fine-tuning)

- 在预训练模型基础上,用特定领域的小规模数据进一步优化模型性能(如金融、医疗场景的定制化模型)。

3.指令微调(Instruction Fine-Tuning)

- 针对预训练模型,通过指令或标注数据集提升模型对任务的适应性(如让模型遵循人类指令生成内容)。

4.基于人工反馈的强化学习(RLHF, Reinforcement Learning from Human Feedback)

- 构建人类反馈数据集,训练激励模型模仿人类偏好,使模型输出更符合人类意图(如ChatGPT的对齐训练)。

5.混合精度训练

- 使用 FP16/FP32 混合计算 节省显存并加速训练过程。FP16(半精度浮点数)减少内存占用和计算时间,但可能牺牲数值精度。

6.量化技术

- 降低模型精度(如 INT8、INT4、FP4)以减少模型大小和计算复杂度,例如Qwen3-32B的4-bit量化版本仅需18GB显存。

7.分布式训练

- 数据并行(将数据分片到多个GPU)和 模型并行(拆分模型参数到不同设备)技术,提升训练效率。

8.可扩展性(Scalability)

- 描述模型架构能否随着规模扩大(如参数量、数据量)保持高效运作的能力。

模型能力与特性

1.参数规模

- 大模型的参数量从十亿级(B)到万亿级(T),如GPT-3(175B)、DeepSeek R1(671B)等。

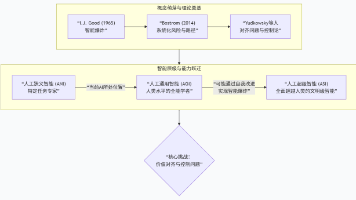

2.涌现能力(Emergence)

- 模型达到一定规模后突然出现的新能力(如零样本学习、复杂推理、上下文学习)。

3.泛化能力(Generalization)

- 模型通过迁移学习、微调等手段,将训练能力扩展到其他任务或领域。

4.上下文学习(In-context Learning)

- 模型通过输入上下文快速学习新任务,无需额外训练(如通过示例引导模型完成任务)。

5.思维链(Chain-of-Thought, CoT)

- 通过拆解问题为多个步骤,逐步推理得出答案,提升复杂任务的准确性。

6.零样本学习(Zero-shot Learning)

- 模型在未见过任务的情况下,直接通过提示(Prompt)完成任务。

应用与生态相关术语

1.AIGC(人工智能生成内容)

- 利用AI自动生成文本、图像、音频等内容的技术,依赖深度学习和NLP(如Stable Diffusion、DALL·E)。

2.生成对抗网络(GAN)

- 通过生成器和判别器的对抗训练,生成高质量图像、音频等内容。

3.扩散模型(Diffusion Model)

- 通过逐步去噪生成高质量内容,是Stable Diffusion、DALL·E 3的核心技术。

4.多模态大模型

- 融合文本、图像、视频的跨模态理解与生成能力(如CLIP、Flamingo)。

5.智能体(Agent)

- 能够感知环境并通过行动影响环境的自主实体,具备决策能力(如自动驾驶系统、游戏AI)。

6.Prompt(提示词)

- 用户输入的文本或指令,引导模型生成特定输出(如“用李白风格写诗”)。

7.Prompt Engineering(提示工程)

- 设计和优化提示词的技术,提升模型输出效果(如通过示例、指令模板激活模型能力)。

8.RAG(检索增强生成, Retrieval-Augmented Generation)

- 结合外部知识库检索与模型生成能力,增强知识密集型任务的准确性(如问答系统)。

9.向量数据库(Vector Database)

- 存储文本/图像的向量编码,支持高效检索(如Faiss、Pinecone)。

10.知识库(Knowledge Base)

- 通过嵌入(Embedding)将实体和关系映射到向量空间,支持语义推理(如问答系统、推荐引擎)。

模型层级与分类

1.L0 层级 - 通用大模型

- 经过广泛数据训练,具备跨学科通用能力(如Qwen3、GPT-4)。

2.L1 层级 - 行业大模型

- 聚焦特定行业(如金融、医疗)的垂直领域模型(如金融领域的模型优化)。

3.L2 层级 - 垂直大模型

- 针对具体业务流程或场景的精细化模型(如客服对话系统、代码生成工具)。

4.视觉大模型

- 专注于图像、视频处理的模型(如ViT、CLIP)。

5.基础科学大模型

- 应用于物理、化学等科学领域的模型(如AlphaFold)。

其他关键术语

1.维度降低(Dimensionality Reduction)

- 通过降维方法(如PCA、t-SNE)减少高维数据的计算负担和信息冗余。

2.语义关系(Semantic Relations)

- 词语间的关联模式(如同义词、反义词、逻辑推理链),对模型性能优化至关重要。

3.标记(Token)

- NLP中文本的基本单位,通常通过分词(Tokenization)分割(如英文单词、中文分词)。

4.向量编码(Embedding)

- 将文本、图像等数据映射为连续向量,捕捉语义信息(如Word2Vec、BERT的嵌入层)。

5.意图识别

从用户的文本或语音输入中,自动识别其潜在的目的或需求。常见意图识别方法有:

- 基于规则,通过人工定义关键词或者模板匹配用户输入信息,提取关键信息和对输入信息进行分类,简单易实现,解释性强,覆盖范围有限,难以处理复杂句式或歧义,维护成本高

- 基于机器学习的方法,让大模型去主动识别问题分类,比如支持向量机(SVM)、朴素贝叶斯等传统机器学习,循环神经网络(RNN)、卷积神经网络(CNN)、BERT 等预训练模型的深度学习

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)