为什么大模型画中文总乱码,底层原理是什么?

摘要: 中文AI生成图像时常出现文字乱码,如“减”字少笔画、“株”字结构错乱,甚至误解“红烧狮子头”为猛兽头颅。核心原因在于:1)训练数据中英文占比超90%,中文不足5%,模型缺乏足够学习样本;2)中文结构复杂,需精确处理偏旁部首与笔画,远超英文字母组合难度;3)模型架构将中文视为“纹理”而非独立符号,忽略细节差异。应用场景如电商海报、绘本设计等乱码频发,影响实用性。优化建议包括中英文混合提示、放

你有没有过这种崩溃时刻:让Deepseek画张“满300减50”的电商海报,结果“减”字少了两点;想做本《守株待兔》绘本,“株”字的木字旁居然粘在“朱”的头顶;甚至让AI写“红烧狮子头”,它直接给你画个猛兽头颅配餐盘——中文文字要么缺胳膊少腿,要么直接变成看不懂的乱码符号。

其实大模型不是故意调皮,就像学外语没背够单词的学生,不是不想写对,是从“底子”到“工具”都没适配好中文。今天就用大白话+生活比喻,从根上说说这事儿,0基础也能听得明明白白。

一、底层原理:为啥中文成了大模型的“软肋”?

1. 训练数据:中文是“小众课”,英文才是“主修课”

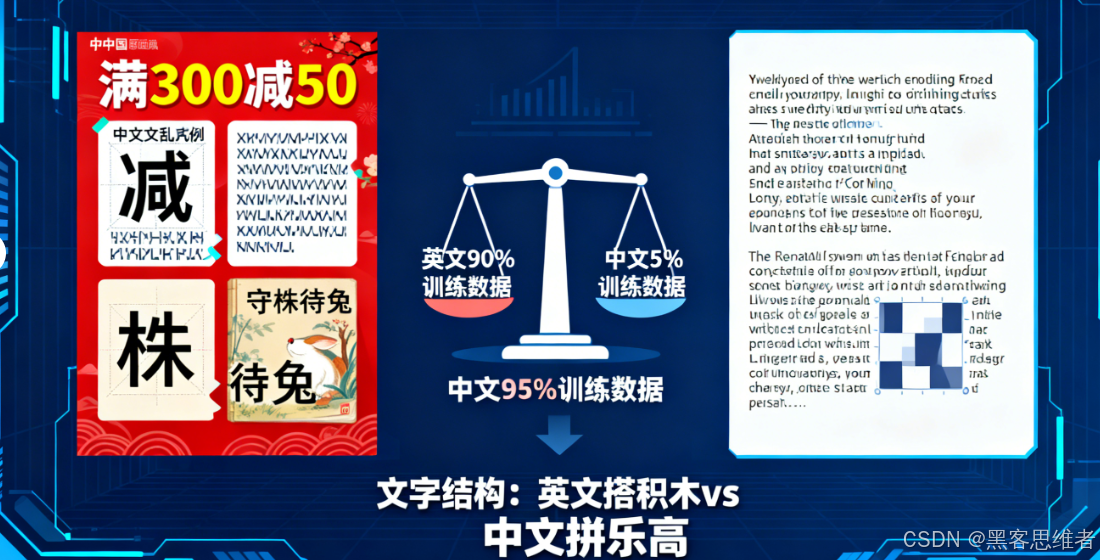

大模型学画画,全靠海量图文数据当“课本”。但目前主流模型(比如Stable Diffusion、DALL-E)的训练数据里,超过90%是英文图文对,中文相关的还不到5%。

这就像老师天天教你写ABCD,偶尔提一句“中文是方块字”,却从没让你练过笔画、偏旁。等考试让你写“车水马龙”,你只能凭着模糊印象瞎画——大模型也一样,它没见过足够多的中文正确写法,只能把“车”拆成轮子和车厢的模糊轮廓,把“马”和“龙”当成普通图案拼,最后变成“一辆载满水杯的卡车”这种离谱结果。

更坑的是,少数中文训练样本里,还混着艺术字、错别字、模糊水印的内容。大模型分不清好坏,把这些“错误答案”也记在了脑子里,生成时自然容易“复刻”乱码。

2. 文字结构:英文是“搭积木”,中文是“拼乐高城堡”

英文就26个字母,不管什么单词,都是这26个“积木”的排列组合。大模型只要记住每个字母的样子,拼起来就行,难度堪比搭小房子。

中文可就复杂了:常用字有3000多个,每个字都是独立的“乐高城堡”——“明”是“日”+“月”,“解”是“角”+“刀”+“牛”,不仅有偏旁部首,还有笔画顺序、间架结构的讲究。更要命的是,有些字笔画多到离谱,比如“龘”字有48画,相当于让大模型用像素拼出48个精准的线条,难度堪比绣十字绣。

而大模型的扩散架构,本来就擅长画连续的纹理(比如云朵、毛发),处理这种离散的精细结构就像用油画笔写毛笔字——怎么画都显得臃肿、粘连,“明”字的“日”和“月”粘成一团墨迹,“技”的提手旁变成横线,都是常有的事。

3. 模型架构:把中文当“花纹”,没当“文字”

大模型生成图像时,会把所有内容都当成“视觉纹理”处理,不会特意区分“这是风景”“这是文字”。英文单词是字母串,就算有点模糊,也能猜个大概;但中文是表意文字,差一笔就可能变成另一个字,甚至完全看不懂。

这就像把“苹果”两个字画在雾玻璃上,英文“Apple”就算有点模糊,字母轮廓还在;但中文少一横、多一点,“苹果”就可能变成“草果”“平果”,再模糊点直接成了乱码。更关键的是,大模型的注意力机制更关注整体画面,比如海报的颜色、构图,对文字这种“小细节”不上心,自然容易画错。

4. 模态冲突:连续的像素,装不下离散的中文

大模型生成图像的核心是“像素级渲染”,本质是连续的色彩点组合;而文字是离散的符号——每个字有固定的形状、固定的含义,不能随便改一笔一划。

这就像用沙子画直线:沙子是连续的,你想画一条笔直的线,稍微一动就歪了、断了。大模型用连续的像素去“凑”离散的中文字形,就像用沙子画“十”字,要么横画不直,要么竖画跑偏,最后变成扭曲的乱码。测试显示,当中文小于8号字时,大模型的乱码率高达62%,学术PPT的脚注、海报的小字,基本都是“天书”。

二、应用实例:这些场景,中文乱码最常见

1. 电商海报:促销文案成“错别字大会”

做电商的朋友应该深有体会:让AI生成“限时折扣,满300减50”的海报,“限”字的走之底变成了曲线,“减”字少了两点,“50”后面跟着莫名的符号。有商家试过直接用这种海报,顾客看不懂优惠力度,销量反而掉了一截。

反观英文海报,生成“Limited Discount: $300 off $50”,字母清晰、排版整齐,几乎不会出错。差别就在于,大模型对英文的“积木”组合烂熟于心,对中文的“城堡”结构却一知半解。

2. 绘本创作:成语故事变“猜字游戏”

有用户用腾讯混元大模型做《守株待兔》绘本,文本模型把场景写得很生动,但生成图像时,“株”字的木字旁和“朱”分了家,“兔”字的长耳朵变成了三角形,小朋友根本认不出这是啥字。

更有意思的是,生成英文绘本《The Hare and the Tortoise》时,文字清晰工整,连字体风格都能精准匹配画面。不是大模型偏心,是它学英文时“练得够多”,学中文时“练得太少”。

3. 招牌设计:店铺名称成“抽象艺术”

小餐馆老板让AI设计“家常菜馆”的招牌,结果“家”字的宝盖头变成了圆形,“常”字的竖钩弯成了波浪线,顾客路过以为是艺术展馆,根本不敢进。

而国外网友生成“Home Cooking Restaurant”的招牌,字体、大小、排版都恰到好处。这背后是大模型对英文排版规则(字母间距、行高)烂熟于心,却不知道中文需要扩大15%字间距才好看,竖排时行距要压缩到横排的60%。

三、小技巧:0基础也能减少中文乱码

虽然大模型暂时“不擅长”中文,但咱们可以稍微“搭把手”,让它少犯错:

- 中英文混合提示:比如要生成“家常菜馆”招牌,写成“家常菜馆 (Home Cooking Restaurant),宋体,清晰笔画”,用英文帮大模型“锚定”文字结构;

- 放大字号+指定字体:明确要求“文字字号24号以上,微软雅黑,无艺术变形”,减少大模型“瞎发挥”的空间;

- 避开复杂字:尽量用“一、二、十、人”这种简单字,少用“龘、齉、爨”这种笔画多的复杂字,毕竟大模型也“怕麻烦”。

四、结尾:中文乱码,藏着技术与文化的碰撞

其实大模型生成中文乱码,本质是技术范式和中文文化的“水土不服”——用适配英文的模型架构、训练数据,去处理结构更复杂、文化内涵更丰富的中文,自然容易出问题。

但这也不是无法解决的难题:字节的Seedream 4.0通过增加中文训练数据、优化双模态编码,已经让中文文字生成可用率达到78%;国内模型也在针对性优化,比如腾讯混元加强了中文语义理解,让绘本文字更精准。

就像学外语需要反复练习,大模型掌握中文也需要时间。而这个过程,不仅是技术的进步,更是不同语言文化在AI世界里的平等对话。毕竟,中文的美,藏在每一笔笔画、每一个偏旁里,值得被精准呈现。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)