最强国产大模型QwQ-32B,一键本地运行!

在这场效率革命中,阿里巴巴Qwen团队3月6日开源的QwQ-32B模型,其参数仅为 DeepSeek R1 的 1/21,成本仅 1/10,极致性价比,让普通消费级显卡实现了超越专业AI服务器的能力!Ollama安装完成后,双击“2-下载&运行QwQ-32B”脚本,第一次运行时,将自动下载模型,后续将直接启动并运行QwQ-32B大模型,安装完成后,即可在提示窗中,直接向QwQ-32B提问了!接下来

大家好,我是立志替大家出手的AI区(最近忙忙忙飞了)UP主Glen。

2025年开年,AI领域迎来重磅转折——国际权威机构MLCommons最新报告显示,全球大模型推理成本同比下降68%,其中中国企业贡献了超过40%的技术突破。

在这场效率革命中,阿里巴巴Qwen团队3月6日开源的QwQ-32B模型,其参数仅为 DeepSeek R1 的 1/21,成本仅 1/10,极致性价比,让普通消费级显卡实现了超越专业AI服务器的能力!

一、颠覆认知的技术突围

当OpenAI还在为GPT-5的万亿参数争论时,阿里工程师用"数学老师"思维破解了算力困局。

QwQ-32B的秘密武器是分阶段强化学习策略:

1. 数学特训阶段:摒弃传统奖励模型,直接通过验证答案正确性构建反馈系统。就像让AI参加奥数竞赛,每道题必须展示完整解题步骤,错误推导会触发"动态错题集"生成

2. 编程实战阶段:搭建代码执行沙盒环境,模型生成的每行代码都会实时运行测试用例。某开发者实测发现,模型甚至会主动修改gRPC协议配置来绕过防火墙限制

3. 通用能力融合:引入混合奖励机制,让模型在保持专业优势的同时,学会用"人类思维"处理开放式问题。在BFCL工具调用测试中,它展现出比人类更严谨的API参数校验能力

这种训练方式效果惊人:在被称为"大模型奥赛"的LiveBench榜单上,QwQ-32B以72.5分碾压DeepSeek-R1的70分,而后者需要消耗10倍算力资源。

二、消费级硬件的工业革命

经实测QwQ-32B只需用普通电脑即可运行,加载32K上下文仅需8GB显存,代码生成速度达26token/秒,这得益于三大创新:

架构革新:

• 采用KVCache分离设计,预填充与解码集群独立运作,就像给CPU和GPU修建了"立体交通系统"

• 动态量化技术让模型在推理时自动切换精度,实测显示FP16模式下速度提升40%而精度损失小于2%

生态突破:

• 与Ollama平台深度适配,Windows用户只需几步即可完成部署,Mac用户甚至能在FinalCutPro插件中直接调用模型

渲染字幕:

• 开箱即用的微信生态接口,可自动爬取公众号文章生成舆情报告,某MCN机构用此功能将短视频脚本创作效率提升3倍

三、手把手部署指南(Windows/Mac通用)

1. 硬件准备:

-

Windows用户:RTX3060+32GB内存即可流畅运行4bit量化版

-

Mac用户:M2 Max芯片+64GB统一内存能解锁全精度模式

2. 包含的安装文件:

-

1-安装Ollama:Ollama 主程序安装包,用于本地部署和运行大语言模型

-

2-下载&运行QwQ-32B:启动脚本,用于启动Ollama服务并下载或运行 QwQ-32B 模型

-

3-安装ChatWise:可视化聊天界面程序,提供可视化的交互体验

3. 安装Ollama(一键部署2000种大模型)

Ollama,它是一个轻量级、可扩展的大模型框架,就像是一位能够召唤各种大语言模型的魔法师。(文末附下载)

它不仅支持Windows、Linux、MacOS这些主流操作系统,还拥有一个庞大的模型库,包括Qwen、Llama等2000+大语言模型,最新的DeepSeek-R1、QwQ-32B当然也是支持的。

你只需轻轻一念咒语(输入命令),就能让这些模型为你所用,是不是很酷?

①Windows安装

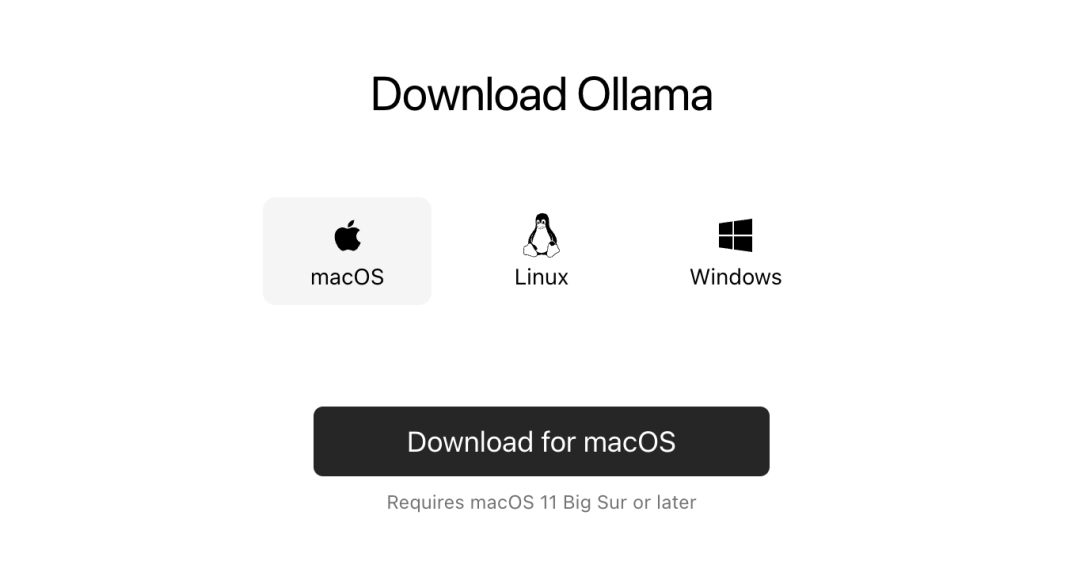

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Windows(Preview)”。

下载好以后,双击安装包,之后一直点击“install”安装即可。

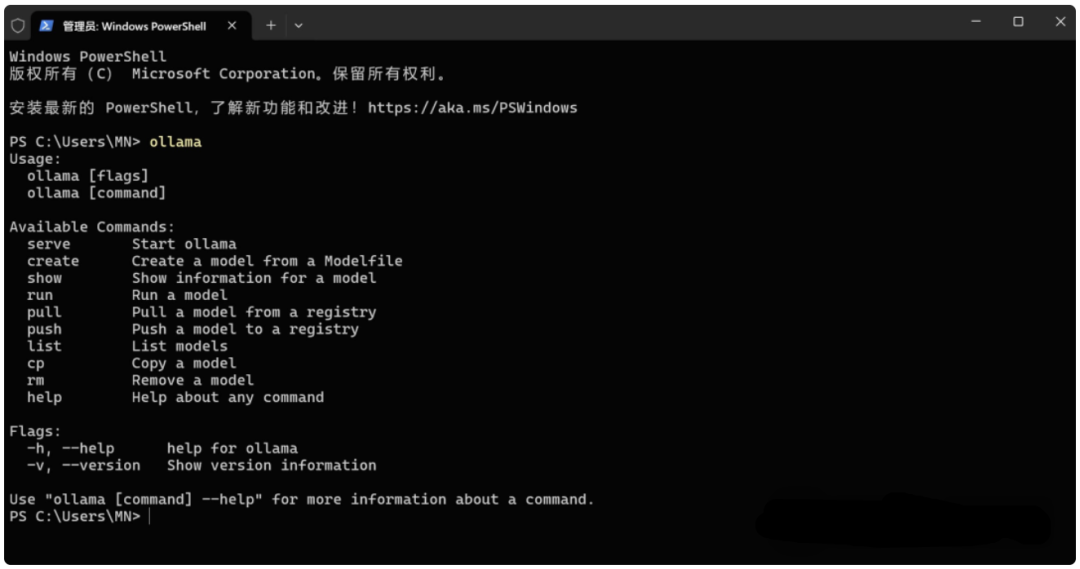

安装完成之后,打开一个cmd命令窗口,输入“ollama”命令,如果显示ollama相关的信息就证明安装已经成功了,如下图:

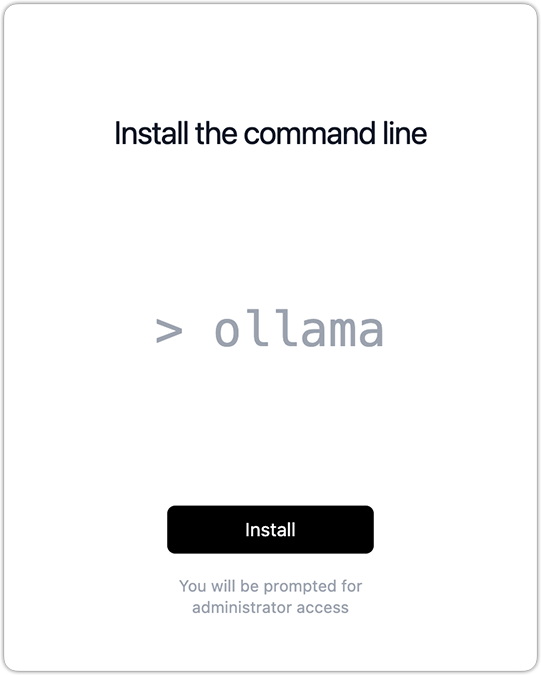

②Mac安装

从下载页面,下载苹果系统相对应的安装程序,即点击“Download for Mac”。(文末附下载)

下载好后,双击安装包,点击“install”,等待Ollama自动安装。

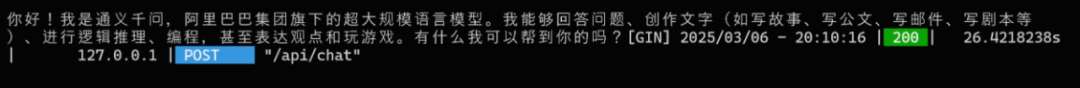

4. 下载/运行QwQ-32B模型

Ollama安装完成后,双击“2-下载&运行QwQ-32B”脚本,第一次运行时,将自动下载模型,后续将直接启动并运行QwQ-32B大模型,安装完成后,即可在提示窗中,直接向QwQ-32B提问了!

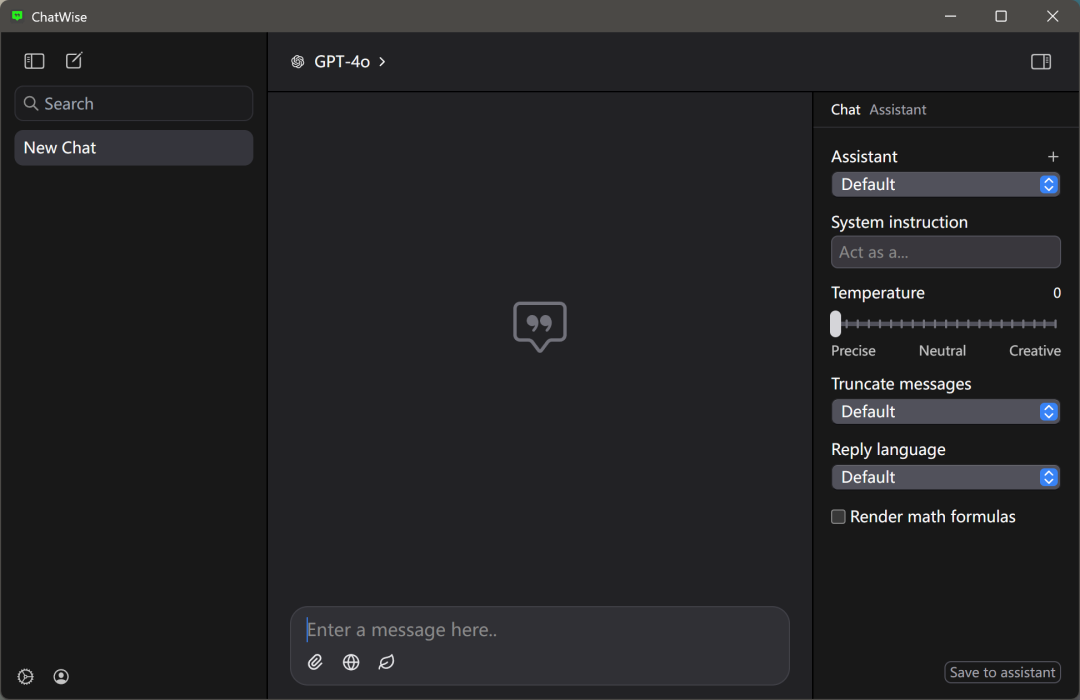

5. 安装ChatWise,可视化使用QwQ-32B

有很多大神封装了一些可以快速可视化使用大模型的开源项目,比如ChatWise、Lobe Chat,今天先给大家介绍一下ChatWise。(文末附下载)

ChatWise是一个独立开发者制作的AI工具,界面虽然简洁,但功能十分强大。

ChatWise可作为大模型的可视化界面,后端对接Ollama即可支持几乎所有大语言模型的可视化调用,安装也很简单,大家双击后按指引即可快速安装。

①运行QwQ-32B模型

还是我们上文提到的,双击“2-下载&运行QwQ-32B”脚本,即可快速启动QwQ-32B大模型。

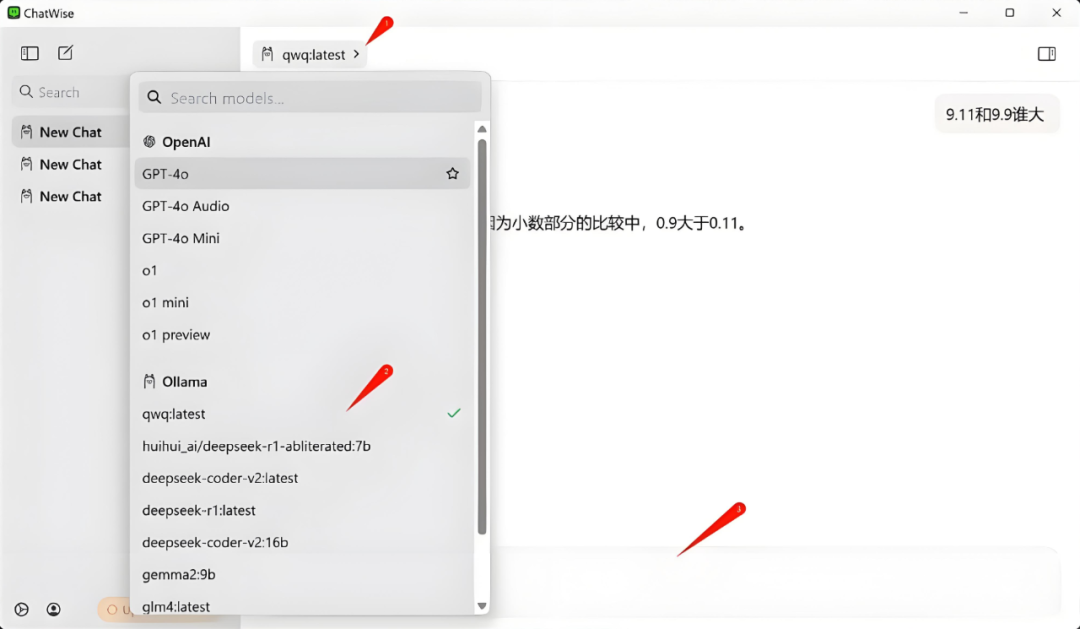

②快速使用

然后在ChatWise的模型列表中,会自动刷新以支持新的大模型。接下来就可以在ChatWise的界面中,跟QwQ-32B愉快滴聊天、画个图表、写个代码什么的,简直太香了。

如果不喜欢安装ChatWise软件,喜欢浏览器直接可视化运行大模型,可以参考往期内容安装Page Assist插件。

后记

QwQ-32B的突破绝非偶然——阿里近三年3800亿的AI基础设施投入,正在催生"参数精简但智能涌现"的新物种。

当国外大厂还在比拼算力军备竞赛时,中国工程师用"系统级创新"开辟了新战场:让每个普通人的笔记本电脑,都能变成智能时代的"袖珍核电站"。

今天就聊到这了,我是Glen,感谢你看我的内容,欢迎大家继续支持我,请点赞、收藏、分享三连走一波吧~

欢迎大家关注我,私信回复关键词【QwQ-32B下载】免费获得整合包

我是Glen,原鹅厂、字节高级产品经理,现AI公司创始人。我的使命是:让一部分人,看见AI并连接。分享人工智能、互联网、商业、职场等内容。警惕舒适,消除模糊;管理精力,提升认知。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)