面试官问:Agent 的规划模块是怎么实现的?

Agent规划模块的实现逻辑与工程取舍 当前Agent系统的规划模块主要采用"人工预设+模型填充"的混合模式,而非完全依赖LLM自主规划。主流实现方式包括: 框架控制:通过Prompt模板(如ReAct的Thought-Action循环)或程序结构(如BabyAGI的任务分派机制)固定规划流程; 分层设计:将规划拆分为任务分解、优先级排序、执行监控等子模块,LLM仅负责具体内容

面试官问:Agent 的规划模块是怎么实现的?

这篇文章完全来自大模型训练营里的 Agent 实战素材与项目拆解,遵循“能落地、可面试、可复用”的三件套思路: 原理认知 → 工程取舍 → 面试表达 → 实战案例。

回到主题,在面试中常被问到这样一个问题:

“Agent 的 Planning(规划)模块 是怎么实现的?”

这个问题看似简单,很多人回答都是一句话:“让大模型自己规划任务就行。”

但在真实工程里,这句话往往不成立。

今天我们就把这件事讲透:当前主流的 Agent 系统,规划到底是怎么做的?为什么多数时候不是模型自己想,而是人帮它“写死”的?

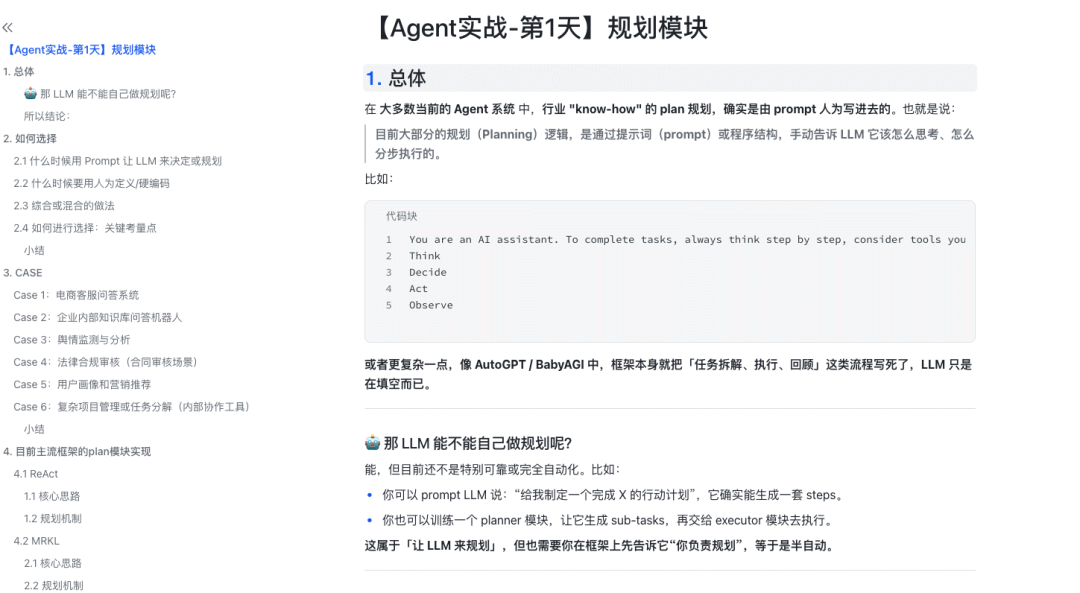

unsetunset一、当前 Agent 系统的规划,基本是“人为写进去”的unsetunset

在大多数现有的 Agent 框架中,所谓的 “Planning(规划)”,并不是 LLM 自发产生的,而是通过 Prompt 或程序结构人工嵌入进去的。

换句话说,现在的 LLM,并不会自动思考“下一步该干什么”,而是我们先告诉它该怎么想、怎么拆、怎么执行。

一个最典型的例子是这样的提示词:

You are an AI assistant.To complete tasks, always think step by step,consider tools you have, and reason before acting.Use this format:ThinkDecideActObserve

或者更复杂一点,比如 AutoGPT、BabyAGI 这类框架,会在程序中写死任务拆解、执行、回顾的循环逻辑。 LLM 只是负责在框架给的空格里,填上具体内容。

unsetunset二、那 LLM 能不能“自己规划”?unsetunset

能,但目前还不太可靠。

比如你可以 prompt 它说:

“请给我一个完成‘写一个产品需求文档’的行动计划。”

它确实能输出一套看起来挺合理的 steps,但问题是:

- 这些步骤可能不具备上下文一致性;

- 执行几轮后容易偏题;

- 无法在执行中动态修正。

于是出现了各种折中做法——让 LLM 做“半自动规划”:

- 我们告诉它:“你是 Planner,负责拆分任务”;

- 然后再由另一个 Executor 模块执行;

- 中间还要有人或代码帮它检查计划是否合理。

这就是现在绝大多数 Agent 框架的样子:规划看似自动,其实半自动。

unsetunset三、在真实项目里,规划谁来做?unsetunset

落地时最常见的问题是:哪些逻辑写在 Prompt 里交给模型做,哪些逻辑写在代码里人为固定?

这个问题没有标准答案,但可以从三类取舍逻辑出发来看。

3.1 什么时候交给 LLM 自行规划(Prompt)

适合场景:

- **问题不确定、场景多变:**比如要写营销方案、生成创意文案、制定调研计划,这些任务本身没有固定解,模型发挥空间更大。

- **希望模型具备灵活应变能力:**当需求常变、数据来源复杂时,手写规则成本太高,不如让模型按原则生成方案。

- **人力维护成本高:**如果每天都要手动改规则,不如让模型通过 Prompt 自己“思考”并给出步骤。

换句话说——适合让模型“自由发挥”的地方,就用 Prompt。

3.2 什么时候要人工或程序硬编码

适合场景:

- **流程固定,可控性要求高:**比如实名认证、法务审核、风控决策。这些环节要的是“绝对可靠”,不是灵活。

- **不需要模型推理的逻辑:**例如按钮点击、表单验证、API 调用流程,这类纯逻辑性代码交给程序更安全。

- **安全与合规要求高:**模型可能输出不合规的答案,而硬编码逻辑可以被审计、被复盘。

一句话总结:凡是出错代价大的地方,不要让模型“想”。

3.3 混合模式:最常见也最实用

绝大多数工程项目采用的是混合式规划:

- **主流程由人工或代码固定;**确保关键步骤不会跑偏。

- **关键节点交给模型规划;**比如内容生成、策略制定、风险分析等。

- **Prompt 嵌入规则和约束条件;**例如告诉模型“遇到非法输入要直接返回失败”,而不是随意发挥。

- **LLM 规划后再经人工/程序校验;**提高安全性与可解释性。

这其实就是“灵活与可控的平衡点”。

unsetunset四、真实案例解析unsetunset

为了更直观地理解,我们来看几个典型场景。

Case 1:电商客服问答系统

- 硬编码部分:

- 身份验证、订单查询、退款流程;

- 售后政策逻辑; 这些步骤要固定、可审计、不可被模型更改。

- Prompt 部分:

- 用户自然语言问答;

- 问题总结与推荐; 模型通过 Prompt 来生成更自然的对话和解释。

总结: 客服业务逻辑硬编码,用户交互语言用 Prompt。

Case 2:企业知识库问答

- 硬编码部分:

- 权限管理;

- 检索与查询语句;

- Prompt 部分:

- 对文档内容的总结、解释;

- 多文档整合与推理。

总结: 权限与结构写死,内容生成交模型。

Case 3:舆情监测系统

- 硬编码部分:

- 数据采集与标签定义;

- Prompt 部分:

- 文本打标签;

- 每日报告总结。

总结: 结构化任务交程序,语义化分析交模型。

Case 4:合同审核 Agent

- 硬编码部分:

- 法律条款库;

- 风险等级定义;

- Prompt 部分:

- 条款分析;

- 合规建议生成。

总结: 风险规则写死,文本分析用模型。

Case 5:项目任务规划 Agent

- 硬编码部分:

- 项目管理权限;

- 任务追踪逻辑;

- Prompt 部分:

- 需求拆解;

- 沟通建议。

总结: 项目结构程序控制,内容生成模型负责。

unsetunset五、主流框架的规划机制unsetunset

接下来看看目前主流 Agent 框架里,Planning 是怎么实现的。

5.1 ReAct

论文:《ReAct: Synergizing Reasoning and Acting in Language Models》

**核心思路:**让模型一边推理,一边行动。 输出格式固定为:

Thought → Action → Observation → Thought → ...

规划机制:

- Prompt 中写明固定循环;

- LLM 在 “Thought” 阶段思考下一步;

- 外部程序解析 “Action” 并调用工具。

**总结:**即时规划(on-the-fly),靠 Prompt + 控制循环实现。

5.2 MRKL

论文:《Modular Reasoning, Knowledge and Language》

**核心思路:**LLM 充当“控制中枢”,通过推理决定要调用哪个工具。 典型流程:

思考 → 选择工具 → 执行 → 获取结果 → 再思考

规划机制:

- Prompt 中提供可用工具列表;

- LLM 推理选择;

- 外部代码负责执行工具调用。

**总结:**规划 = 工具选择;Prompt 决定路线,程序保证执行。

5.3 BabyAGI

**核心思路:**自动化任务管理循环。

包含三个 Agent:

- 创建任务;

- 任务排序;

- 执行任务。

规划机制:

- Task Creation Agent 负责子任务规划;

- Task Prioritization Agent 负责排序;

- 执行 Agent 实际执行。

**总结:**规划逻辑在外部 Python 框架里,模型只是填任务文本。

5.4 AutoGPT

**核心思路:**更强的自我驱动循环系统。 包含:

- Memory;

- Planner;

- Command Executor。

规划机制:

- LLM 生成下一个行动描述;

- 程序解析命令、执行;

- 写回记忆,再继续下一轮。

**总结:**看似自动,其实每一步都由外部循环驱动。

5.5 对比小结

| 框架 | 规划核心 | LLM作用 | 控制逻辑 |

|---|---|---|---|

| ReAct | 即时思考 + 行动 | 小步规划 | Prompt 模板 |

| MRKL | 工具路由 | 工具选择 | Prompt + 程序 |

| BabyAGI | 子任务生成 | 子任务规划 | 外部循环 |

| AutoGPT | 自我迭代 | 下一步命令生成 | 主循环驱动 |

这些系统的共同点是:规划逻辑主要靠 Prompt 和外部程序控制,而不是 LLM 自己全盘思考。

unsetunset六、面试官在听什么?unsetunset

面试官通常不是想听名词堆砌,而是要判断你是否理解“规划的本质是控制结构”。

可以这样答:

目前主流 Agent 框架中的规划(Planning),主要是通过 Prompt 模板 + 程序循环实现的。 LLM 负责局部的推理和决策,但总体流程由人工定义。 例如 ReAct 框架通过“Thought–Action–Observation”循环实现即时规划,BabyAGI 则通过任务创建与优先级模块做宏观调度。

unsetunset七、总结unsetunset

- **现状:**当前 LLM 的规划能力有限,主要依赖人为定义的结构与提示。

- **原因:**因为语言模型只是生成模型,不具备稳定的状态记忆与执行控制,需要外部框架帮它“分步走”。

- **趋势:**新研究开始尝试让模型自我改写 Prompt、自主规划任务,但仍依赖元框架管理。

- **核心启发:**真正稳定的 Agent,往往是“人工控制主干 + 模型填充细节”的混合结构。

这篇文章完全来自训练营里的 Agent 实战素材与项目拆解,遵循“能落地、可面试、可复用”的三件套思路:原理认知 → 工程取舍 → 面试表达 → 实战案例。

unsetunset最后说一句unsetunset

这段时间,我陆续写了二十几篇关于 RAG(检索增强生成)的面试答题文章。

很多同学说,看完之后不仅知道“怎么答”,还知道“为什么这么答”,甚至能把思路直接用到自己的项目里。

其实,这些文章并不是凭空写出来的,也不是简单整理网络资料,而是来自我在大模型训练营里的真实项目沉淀。

训练营里有多个从零到落地的实战项目。

1、企业培训问答 Agent(含多轮理解与记忆模块)

2、金融研报 RAG 系统(混合检索、重排序、多模态解析)

3、行业深研助手 DeepResearch(实时检索 + 知识沉淀链路)

4、深学 AI 学习助手(上下文结构化与生成链路可解释)

这些实战项目不是“照着文档做一遍”那种,而是会带着同学一步步拆逻辑、跑代码、调权重、对指标,最终能说清楚“为什么这么设计、哪里容易踩坑、怎么迭代优化”。

这些内容最终沉淀成训练营内部的体系化笔记、方法论文档、Badcase 修复记录和面试表达模板,而我近期写的那一系列文章,就是从这些文档中衍生出来的。

所以你会看到:

不是只讲概念,而是讲落地。

不是只讲方案,而是讲取舍。

不是只讲原理,而是告诉你面试官到底在听什么。

如果你正在准备大模型方向的求职,或希望真正把 RAG 从“知道”变成“能做、能讲、能复盘”,那大模型训练营可能会非常适合你。

真正能拉开差距的,从来不是知识点,而是体系与思考方式。

在过去的几个月中,我们已经有超过 80 个 同学(战绩真实可查)反馈拿到了心仪的 offer ,包含腾讯、阿里、字节、华为、快手、智谱、月之暗面、minimax、小红书等各家大厂以及传统开发 / 0 基础转行的同学在短时间内拿到了各类大中小厂的 offer。

最近这几年,经济形式下行,IT行业面临经济周期波动与AI产业结构调整的双重压力,很多人都迫于无奈,要么被裁,要么被降薪,苦不堪言。但我想说的是一个行业下行那必然会有上行行业,目前AI大模型的趋势就很不错,大家应该也经常听说大模型,也知道这是趋势,但苦于没有入门的契机,现在他来了,我在本平台找到了一个非常适合新手学习大模型的资源。大家想学习和了解大模型的,可以**点击这里前往查看**

更多推荐

已为社区贡献65条内容

已为社区贡献65条内容

所有评论(0)