多Agent协作中的分布式因果推理方法【边缘信息融合与全局一致性】

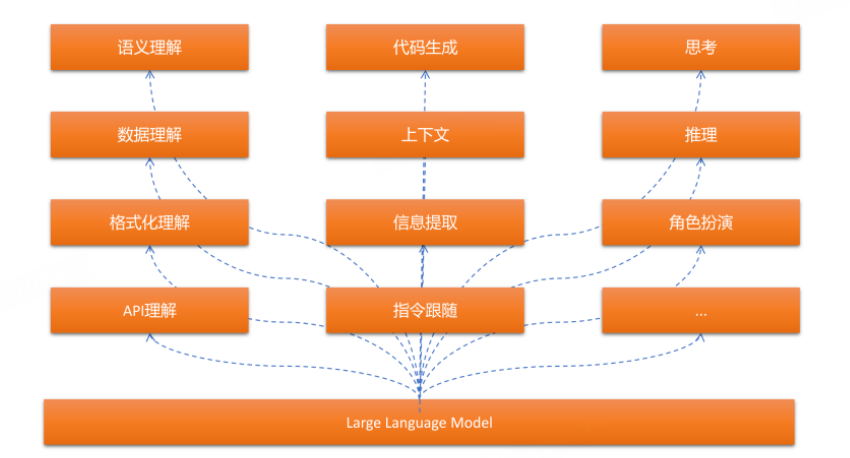

在人工智能和机器学习领域,因果推理为决策制定提供了比传统相关性分析更为深入的洞察。尤其是在多Agent系统中,因果推理有助于智能体理解事件的因果关系,而不仅仅是表面上的相关性,从而做出更为合理和有效的决策。本文将探讨基于因果推理的Agent决策框架,从相关性到因果性建模的过渡,以及如何通过编程实现这一框架。

多Agent协作中的分布式因果推理方法【边缘信息融合与全局一致性】

在人工智能和机器学习领域,因果推理为决策制定提供了比传统相关性分析更为深入的洞察。尤其是在多Agent系统中,因果推理有助于智能体理解事件的因果关系,而不仅仅是表面上的相关性,从而做出更为合理和有效的决策。本文将探讨基于因果推理的Agent决策框架,从相关性到因果性建模的过渡,以及如何通过编程实现这一框架。

一、因果推理与相关性分析的区别

1.1 相关性 vs 因果性

-

相关性是指两个或多个变量之间的统计关系,通常表明它们一起变化,但不一定意味着一个变量引起了另一个变量的变化。例如,冰激凌销售与溺水事件有相关性,但这并不意味着冰激凌的销售直接导致溺水。

-

因果性则更进一步,涉及到变量之间的因果关系。因果推理关注的是某一事件如何直接影响另一个事件。通过因果推理,我们能够理解在特定环境下的行动或事件如何改变其他事件的发生。

1.2 相关性到因果性的建模

在机器学习中,很多时候我们使用相关性来构建模型,这对于短期预测和表面层次的模式识别有很大的作用。然而,深层次的决策问题通常需要因果推理,以便更好地理解行动和结果之间的因果链条。在多Agent决策系统中,理解因果关系能够帮助智能体做出更加符合目标的决策。

二、因果推理的关键技术

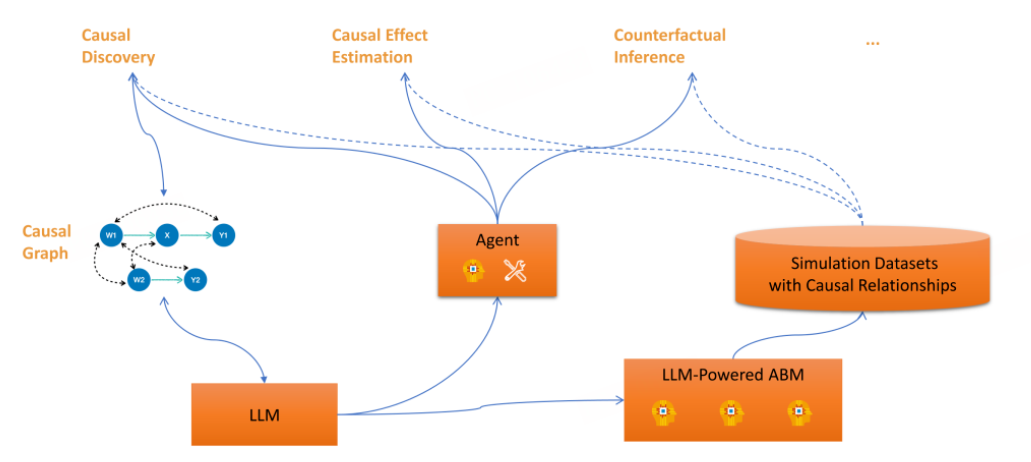

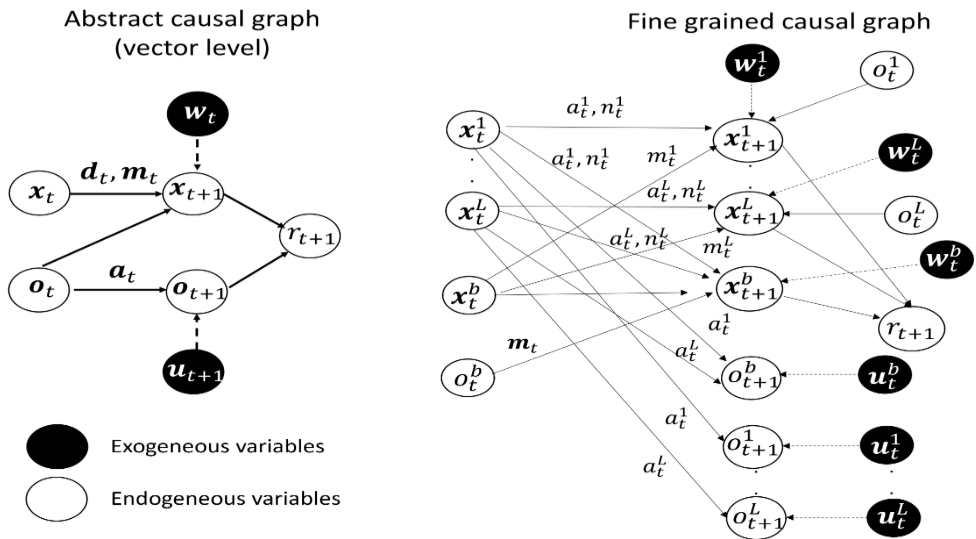

2.1 因果图与贝叶斯网络

因果图(Causal Graphs)是一种用于表示变量之间因果关系的图结构,其中每个节点代表一个变量,边代表变量之间的因果关系。贝叶斯网络是一种广泛应用的因果推理模型,它将因果图和概率论结合,帮助推断在给定条件下事件的发生概率。

2.2 潜在结果框架

潜在结果框架(Potential Outcomes Framework),也叫做Rubin因果模型,广泛应用于因果推理中。在这种框架下,每个决策都有一个潜在的结果(或状态),因果效应的计算基于对不同决策结果的比较。

三、基于因果推理的Agent决策框架

3.1 Agent决策的背景

在多Agent系统中,智能体通常需要基于环境的状态、其他智能体的行为及其相互之间的影响来做出决策。通过引入因果推理,智能体不仅能够理解自己和环境的当前状态,还能预测某些行动可能导致的长期效果。

3.2 因果推理框架设计

为了将因果推理融入到Agent决策中,我们设计了以下框架:

-

建模因果关系:通过构建因果图来表示Agent和环境之间的关系。每个节点代表一个决策变量或环境变量,边表示这些变量之间的因果关系。

-

数据收集与更新:收集环境数据并根据实际行动反馈更新因果图,使用贝叶斯推理更新变量之间的概率关系。

-

决策规则设计:基于因果推理结果,制定决策规则。通过模拟不同决策对系统状态的影响,选择最佳行动。

3.3 因果推理在Agent决策中的应用

假设有一个自动驾驶Agent,我们希望其能够根据路况、天气、交通信号等信息做出决策。在这种场景中,传统的相关性分析(例如,天气与交通拥堵的相关性)不足以确保安全的决策,因为智能体需要理解天气的变化如何直接影响交通流量,以及如何根据这些信息做出更合适的驾驶决策。

四、代码实战:基于贝叶斯网络的因果推理

在实际应用中,贝叶斯网络可以帮助我们实现因果推理。以下是一个简单的代码示例,展示如何使用Python中的pgmpy库构建和推断一个贝叶斯网络。

4.1 安装依赖

首先,我们需要安装pgmpy库:

pip install pgmpy

4.2 构建因果网络

from pgmpy.models import BayesianNetwork

from pgmpy.factors.discrete import DiscreteFactor

from pgmpy.factors.discrete import TabularCPD

# 创建贝叶斯网络

model = BayesianNetwork([('Weather', 'Traffic'), ('Traffic', 'Accident')])

# 定义条件概率分布(CPD)

cpd_weather = TabularCPD(variable='Weather', variable_card=2, values=[[0.7], [0.3]])

cpd_traffic = TabularCPD(variable='Traffic', variable_card=2, values=[[0.8, 0.4], [0.2, 0.6]], evidence=['Weather'], evidence_card=[2])

cpd_accident = TabularCPD(variable='Accident', variable_card=2, values=[[0.9, 0.2], [0.1, 0.8]], evidence=['Traffic'], evidence_card=[2])

# 将CPD添加到模型中

model.add_cpds(cpd_weather, cpd_traffic, cpd_accident)

# 检查模型是否有效

assert model.check_model()

4.3 推理与决策

我们可以通过推理来计算给定某些证据下其他变量的概率。例如,推断在某种天气条件下,发生交通事故的概率。

from pgmpy.inference import VariableElimination

# 创建推理器

inference = VariableElimination(model)

# 计算给定天气条件下,发生事故的概率

prob_accident_given_weather = inference.query(variables=['Accident'], evidence={'Weather': 1})

print(prob_accident_given_weather)

4.4 结果分析

通过上述推理,Agent可以得到交通事故的发生概率,并基于这个信息决定是否采取规避措施。这个过程展示了因果推理在决策中的重要作用。

五、因果推理在多Agent系统中的扩展应用

在多Agent系统中,每个智能体(Agent)都有自己的感知、决策和行动能力。通过因果推理,智能体不仅能够对环境中的局部因素做出响应,还能预测与其他智能体互动时可能产生的因果效应。传统的基于规则的决策系统往往忽视了这些复杂的因果关系,而通过因果推理,可以显著提升系统的决策能力和适应性。

5.1 因果推理在多Agent协作中的角色

在多Agent系统中,协作是常见的任务,智能体之间的互动和信息共享可以带来更好的集体决策。然而,若没有因果推理,智能体只能基于局部信息做出决策,可能会导致低效或冲突的结果。例如,在无人驾驶的车队中,车辆需要根据其他车辆的动作做出反应,这不仅仅是看当前的车速,还要了解前方车辆可能采取的行动及其后果。

因果推理能够帮助智能体理解并预测这些互动中的潜在后果,从而调整自己的行为。例如,如果一个Agent知道A和B之间存在某种因果关系(如,Agent A超速可能导致碰撞),它可以做出相应的调整,避免与Agent B发生冲突。

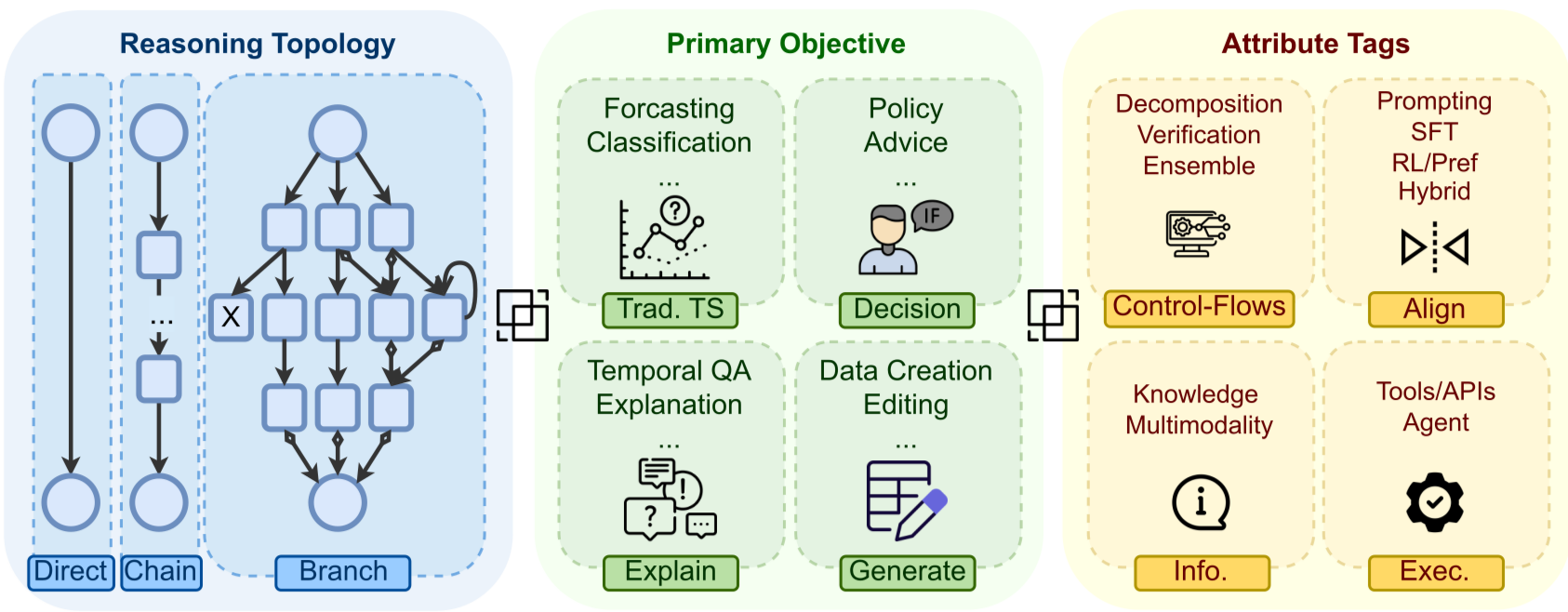

5.2 因果推理与强化学习的结合

因果推理与强化学习的结合是当前多Agent系统中较为前沿的研究方向。强化学习(RL)通过奖励与惩罚引导智能体学习最优策略,但这种方法通常依赖于大量的实验数据来获得有效的策略,而因果推理则可以为强化学习提供更深层次的洞察,帮助智能体理解不同动作的潜在因果效应,从而减少探索的成本和风险。

例如,假设一个智能体在进行资源分配的决策时,基于历史数据,它可以通过因果推理模型预测某个行动可能带来的长期效应,如资源过度分配可能导致系统崩溃。通过因果推理与强化学习结合,智能体可以提前了解这些因果链条,在试验中做出更合理的选择。

5.3 因果推理在分布式环境中的挑战

尽管因果推理能在多Agent系统中带来更好的决策能力,但它在分布式系统中的应用面临着一些挑战。由于每个Agent仅能感知局部环境,获取全局的因果信息往往需要共享大量数据,而这在实际应用中可能导致隐私问题、计算复杂度和通信开销等问题。

为了解决这些问题,研究者提出了多种方法,如基于分布式因果推理的框架,允许各个Agent在不共享全部数据的前提下,通过局部推理进行协作决策。这种方法能够有效降低计算成本,同时确保智能体之间的隐私保护。

六、因果推理与决策模型的结合

6.1 决策树与因果推理

决策树是一种常用的机器学习方法,用于从历史数据中提取决策规则。然而,决策树通常侧重于相关性,并未考虑变量之间的因果关系。为了解决这一问题,研究者提出了因果决策树(Causal Decision Tree, CDT),该模型在构建树的过程中引入了因果推理的思想,能够更好地描述变量间的因果关系。

例如,在一个基于因果决策树的自动化决策系统中,智能体在构建决策树时,不仅仅关注数据的相关性,还需要通过因果推理分析每一个决策分支所对应的因果效应。这样,决策树能够在特定条件下做出更为合适的决策。

6.2 因果推理与博弈论结合的应用

博弈论是研究决策者在互动过程中如何优化决策的数学模型。在多Agent系统中,博弈论可以帮助智能体分析其行为对其他智能体行为的影响,从而达到最优决策。通过将因果推理与博弈论结合,智能体能够不仅仅通过反复博弈来优化策略,还能预测不同策略的长期影响和因果后果,从而做出更为精确的决策。

例如,在一个多智能体的市场环境中,参与者的定价策略不仅依赖于当前市场价格,还会受到其他参与者策略变化的因果影响。通过结合因果推理,智能体能够理解自己的价格调整会如何影响其他参与者的行为,从而在博弈中占得先机。

6.3 因果推理的优化与调优

随着多Agent系统中因果推理需求的不断提升,优化因果推理模型成为了一项重要的研究任务。在实际应用中,因果推理模型往往需要根据具体的应用场景进行定制和调优。常见的优化方法包括:

- 因果推理模型选择与验证:在众多因果推理方法中,选择最适合当前任务的模型至关重要。可以通过交叉验证等方法,评估不同因果推理模型在特定任务上的性能。

- 因果推理与大数据的结合:大数据时代下,因果推理的实现依赖于海量的历史数据。通过大数据技术,可以更有效地提取因果关系,提升因果推理的准确性和效率。

- 多尺度因果推理:在复杂的多Agent系统中,不同智能体可能操作在不同的时间尺度上。通过多尺度因果推理,可以从更长时间的视角来理解Agent间的相互作用及其因果链条。

6.4 因果推理与个性化决策

在个性化决策中,每个Agent的行为模式和决策策略可能不同,这要求因果推理能够根据不同智能体的特点进行个性化调整。个性化决策不仅仅是对行为的调整,还包括对预测模型的定制。通过因果推理,智能体可以更好地理解自己在特定情境下的行动后果,从而选择最合适的决策路径。

例如,在个性化推荐系统中,因果推理可以帮助系统理解用户行为背后的因果关系,而不仅仅是基于历史数据的相关性分析。通过因果推理,系统能够预测不同推荐内容对用户行为的长远影响,从而提供更具个性化的推荐结果。

七、未来展望

尽管因果推理在Agent决策中已经取得了一些显著进展,但随着技术的不断发展,仍然有许多挑战和机遇需要探索。未来,随着因果推理算法的优化、分布式因果推理框架的完善以及大规模多Agent系统的应用,因果推理将在更加复杂的应用场景中发挥重要作用。

- 跨领域因果推理:随着智能体在多个领域的应用,跨领域的因果推理将成为一个重要的研究方向。例如,智能体可能在多个不同的任务中进行学习和决策,这要求它们能够跨任务地推断因果关系。

- 因果推理与深度学习结合:深度学习能够自动学习数据中的复杂模式,但通常忽略了因果关系。通过将因果推理与深度学习结合,可以实现更为精确和灵活的决策模型。

- 因果推理的自动化与可解释性:随着因果推理在决策系统中的应用日益增多,如何提高因果推理的自动化水平和模型的可解释性,将是未来研究的关键。

通过因果推理,智能体能够从更深层次理解世界,并根据因果关系做出更有效的决策。随着研究的不断深入,我们有理由相信,基于因果推理的决策框架将在未来的人工智能领域扮演越来越重要的角色。

更多推荐

已为社区贡献46条内容

已为社区贡献46条内容

所有评论(0)