YOLOv8【特征融合Neck篇·第17节】一文整明白,YOLOF单级特征融合!

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》,该专栏持续复现网络上各种热门内容(全网YOLO改进最全最新的专栏,质量分97分+,全网顶流),改进内容支持(分类、检测、分割、追踪、关键点、OBB检测)。且专栏会随订阅人数上升而涨价(毕竟不断更新),当前性价比极高,有一定的参考&学习价值,部分内容会基于现有的国内外顶尖人工智能AIGC等AI大模型技术总结改进而来,嘎嘎硬核。 ✨ 特惠福利

🏆 本文收录于 《YOLOv8实战:从入门到深度优化》,该专栏持续复现网络上各种热门内容(全网YOLO改进最全最新的专栏,质量分97分+,全网顶流),改进内容支持(分类、检测、分割、追踪、关键点、OBB检测)。且专栏会随订阅人数上升而涨价(毕竟不断更新),当前性价比极高,有一定的参考&学习价值,部分内容会基于现有的国内外顶尖人工智能AIGC等AI大模型技术总结改进而来,嘎嘎硬核。

✨ 特惠福利:目前活动一折秒杀价!一次订阅,永久免费,所有后续更新内容均免费阅读!

全文目录:

💖 一、温故知新:上期内容回顾 (CSP-PAN跨阶段路径聚合)

Hello,亲爱的技术探索者们!欢迎再次回到我们的专栏!在今天我们即将踏上一段化繁为简的奇妙旅程之前,让我们先来回顾一下上一站《YOLOv8【特征融合Neck篇·第16节】CSP-PAN跨阶段路径聚合,一文搞明白!》的风景——CSP-PAN (Cross Stage Partial Path Aggregation Network)。这是一个在现代高性能目标检测器(尤其是YOLO系列)中占据核心地位的强大Neck架构,它的设计思想是如此的精妙和高效!

1.1 CSPNet的核心智慧:优化信息流

CSPNet (Cross Stage Partial Network) 的核心思想,源于一个深刻的观察:在深度神经网络中,大量的计算被消耗在处理那些包含重复梯度信息的特征图上。为了解决这个问题,CSPNet提出了一种全新的信息流组织方式:

- 分流 (Split):将进入一个阶段(Stage)的特征图,在通道维度上分成两部分。

- 一路“主干”,一路“捷径”:让一小部分特征(例如一半)进入一个复杂的处理模块(如ResBlock或DenseBlock),我们称之为“主干路”。而让另一大部分特征走一条“捷径”,几乎不进行任何处理。

- 汇合 (Transition):将“主干路”处理后的结果与“捷径”上的特征进行拼接(Concatenate),然后通过一个过渡层(如1x1卷积)进行信息融合。

这种设计的最大好处是,在不牺牲过多性能的前提下,大幅减少了计算量。同时,那条“捷径”为梯度反向传播提供了一条高速公路,极大地优化了梯度流,使得网络训练更稳定,收敛更快。

1.2 PANet的双向奔赴:特征的深度融合

PANet (Path Aggregation Network) 则是对经典FPN的重大升级。我们知道,FPN通过一条“自顶向下”的路径,将高层的强语义信息传递到底层,增强了小目标的检测能力。但PANet的作者认为,这还不够!底层的强定位信息(如边缘、纹理)同样需要被有效地传递到高层。

因此,PANet在FPN的基础上,增加了一条“自底向上”的路径。这条路径将FPN融合后的底层特征,通过下采样的方式,一步步地向上传递,与更高层的特征进行再次融合。这一“来”一“回”的双向信息流动,极大地增强了整个特征金字塔的表达能力。

1.3 CSP-PAN的强强联合:效率与性能的典范

当CSPNet的智慧遇上PANet的结构,CSP-PAN便应运而生。它的做法非常直观:将PANet中的主要计算模块(例如FPN和PAN路径中的卷积块),用CSP的思想进行封装。

具体来说,在PANet的每个融合节点,输入的特征不再是全部送入卷积块,而是先进行CSP式的分流,一部分走卷积处理,另一部分走捷径,最后再汇合。这使得PANet在保持其强大双向特征融合能力的同时,也拥有了CSPNet的优点:

- 计算量显著降低

- 梯度流更加顺畅

- 特征重用效率更高

CSP-PAN可以说是现代目标检测Neck设计的集大成者,是平衡速度与精度的典范之作。

1.4 留下的思考:Neck一定要这么复杂吗?

CSP-PAN如此强大,它通过优化算子和信息流,将一个复杂的多尺度融合Neck变得高效。但这也引发了一个更深层次的、更具颠覆性的问题:

我们真的需要一个如此复杂的、涉及多层上采样、下采样、拼接、融合的Neck吗?

我们构建复杂Neck的初衷是为了解决目标的多尺度问题。但,“多尺度融合”是解决该问题的唯一途径吗?有没有可能,我们从一开始就走上了一条“弯路”?

这个问题,正是我们今天的主角——YOLOF将要用它的设计来回答的。准备好迎接一场思想上的风暴了吗?

🌟 二、今日主角:YOLOF (You Only Look One-level Feature)

欢迎来到本期的核心部分!今天,我们将要认识的YOLOF,是一个充满颠覆精神的作品。它的名字已经霸气地宣告了它的核心思想:“你只需要看一层特征就够了!”。这在当时以FPN为绝对主流的检测器领域,无疑是一声惊雷。

2.1 FPN的“功”与“过”:我们真的需要它吗?

自2017年FPN(特征金字塔网络)被提出以来,它迅速成为了目标检测领域的“标配”。无论是二阶段的Faster R-CNN,还是一阶段的RetinaNet、YOLO系列,几乎都采用了FPN或其变种(PANet, BiFPN, NAS-FPN等)作为Neck。

FPN的“功”是显而易见的:

- 多尺度特征融合:它通过结合高层的语义信息和底层的空间信息,生成了一系列高质量的特征金字塔,让检测器能更好地处理不同尺寸的目标。

- 分而治之 (Divide and Conquer):它将不同尺寸范围的锚框(Anchor)或预测任务,分配到不同分辨率的特征图上。例如,P3层负责小物,P5层负责大物。

但随着时间推移,FPN的“过”,或者说它的代价,也逐渐显现:

- 结构复杂性:FPN引入了大量的上采样、下采样和横向连接操作,使得Neck部分的网络结构变得复杂。

- 计算与内存开销:这些复杂的操作,尤其是在高分辨率特征图上的计算,带来了显著的计算量(FLOPs)和内存访问成本(Memory Access Cost),使得Neck往往成为整个检测器的性能瓶颈。

- 设计多样性:FPN的成功也某种程度上“固化”了研究者的思维,后续大量的Neck研究都围绕着“如何更好地设计跨尺度连接”展开,而很少有人去质疑FPN本身的必要性。

2.2 YOLOF的深刻洞察:问题的根源是“优化”而非“融合”

YOLOF的作者们进行了一系列精密的消融实验,得出了一个惊人的结论:FPN之所以有效,其主要贡献并非来自于“多尺度特征的融合”,而是来自于它“分而治之”的检测策略!

这是什么意思呢?让我们来深入理解一下。

在一阶段检测器中(如RetinaNet),一个检测头需要同时处理覆盖了整张图的、各种尺寸的正样本(目标)和负样本(背景)。

- 对于大目标,检测头需要一个大的感受野来捕捉其整体结构。

- 对于小目标,检测头需要一个小的感受野来关注其局部细节。

如果只用单一特征层(比如ResNet的C5层,感受野很大)去同时优化这两类目标,检测头会陷入“两难”:它很难学习到一组参数,既能很好地识别大目标,又能很好地识别小目标。这就好比让一个只擅长看远景的望远镜,去同时看清远处的山和近处的蚂蚁,任务本身就充满了矛盾。

FPN通过将不同尺寸的锚框分配到不同层(P3, P4, P5),巧妙地绕过了这个优化难题。

- 在P3层,感受野较小,锚框也小,检测头可以专注于优化小目标。

- 在P5层,感受野较大,锚框也大,检测头可以专注于优化大目标。

因此,YOLOF认为,FPN本质上是一个优化问题的解决方案,而不是一个纯粹的特征融合问题。多尺度特征融合,只是这个解决方案带来的一个“副产品”。

2.3 YOLOF的破局之道:单特征层上的“C位出道”

既然问题的本质是优化,那么我们能不能不绕路,直接解决它呢?

YOLOF的回答是:能!

它的核心思想是:

- 放弃FPN:彻底抛弃复杂的多尺度Neck结构。我们只从骨干网络中取一层特征图(例如C5)来进行后续处理。

- 扩大感受野范围:在这一层特征图上,设计一个特殊的模块,使其每一个像素点都能够拥有多种不同大小的感受野。

- 统一处理:让检测头在这张经过处理的、包含了多尺度上下文信息的单层特征图上,进行所有目标的检测。

这样一来,当检测头在某个像素点上工作时,它能同时“看”到这个点周围的大范围上下文和小范围细节。无论是大目标还是小目标,都能找到与之匹配的感受野信息。那个棘手的优化难题,便被直接化像素点上工作时,它能同时“看”到这个点周围的大范围上下文和小范围细节。无论是大目标还是小目标,都能找到与之匹配的感受野信息。那个棘手的优化难题,便被直接化解了!

这种设计,用最简单的结构,直击问题的核心,堪称一次优雅的“降维打击”。

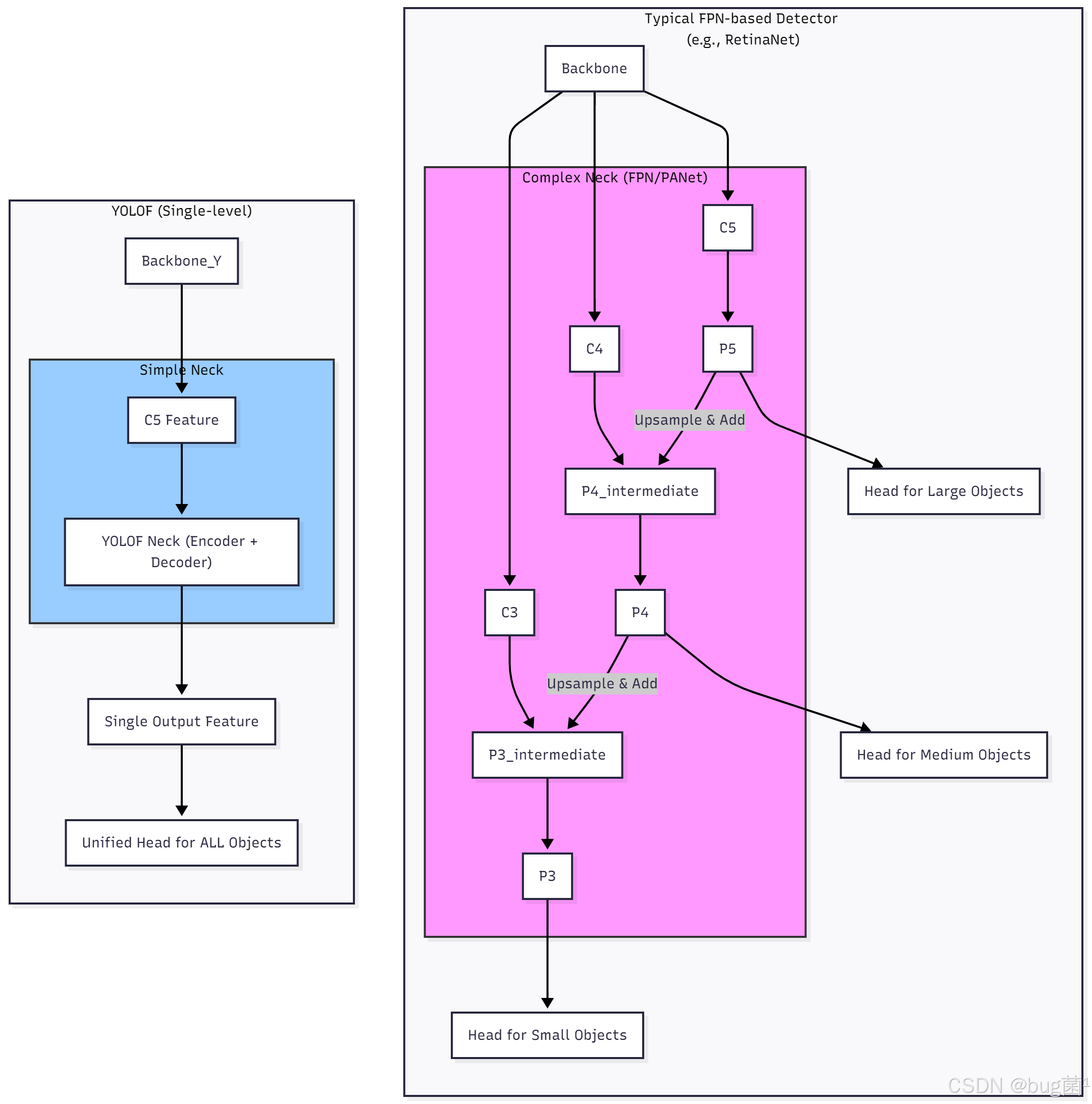

从图中可以清晰地看到,YOLOF的结构被极大地简化了。这种简洁性不仅带来了理论上的优雅,更直接转化为了惊人的推理速度。

🚀 三、YOLOF架构深度解析:简洁背后的力量

理解了YOLOF的革命性思想后,让我们深入其内部,探究这个简洁的Neck是如何施展魔法,以单层特征之力抗衡整个特征金字塔的。

3.1 极简的宏观架构:三步走的艺术

YOLOF的整体架构,清晰地体现了“少即是多”的哲学。它由三部分组成:Backbone, Encoder, 和 Decoder。

- Backbone (骨干网络):与所有检测器一样,负责提取图像的基础特征。YOLOF通常使用标准的ResNet或ResNeXt作为骨干。一个关键点是,它只从骨干网络中取出一个最高层的特征图,通常是下采样32倍的

C5层。 - Encoder (编码器):这是YOLOF的灵魂所在。它的任务是接收单层的

C5特征,并为其注入 度的上下文信息,从而解决我们之前讨论的优化难题。 - Decoder (解码器):它的作用相对简单,主要是对Encoder输出的特征进行精炼和调整,使其更适合送入后续的检测头。

整个Neck部分就是由Encoder和Decoder构成的,信息流清晰、直接,没有任何旁路分支。

3.2 核心组件(1): 单级特征图 (Single-level Feature)

为什么选择C5?

- 语义信息强:

C5位于骨干网络的顶端,经过了最多次的卷积和下采样,因此它包含了最丰富的、最高级的语义信息。这对于识别物体的类别至关重要。 - 感受:

C5的理论感受野是整个骨干网络中最大的,这为检测大目标提供了良好的基础。

但只用C5的挑战也同样巨大:

- 空间分辨率低:下采样32倍后,图像细节大量丢失,对于小目标的定位和识别是毁灭性的。

- 感受野单一:虽然

C5的感受野很大,但它仍然是相对固定的。如何让它同时具备多种感受野,是YOLOF必须解决的核心问题。

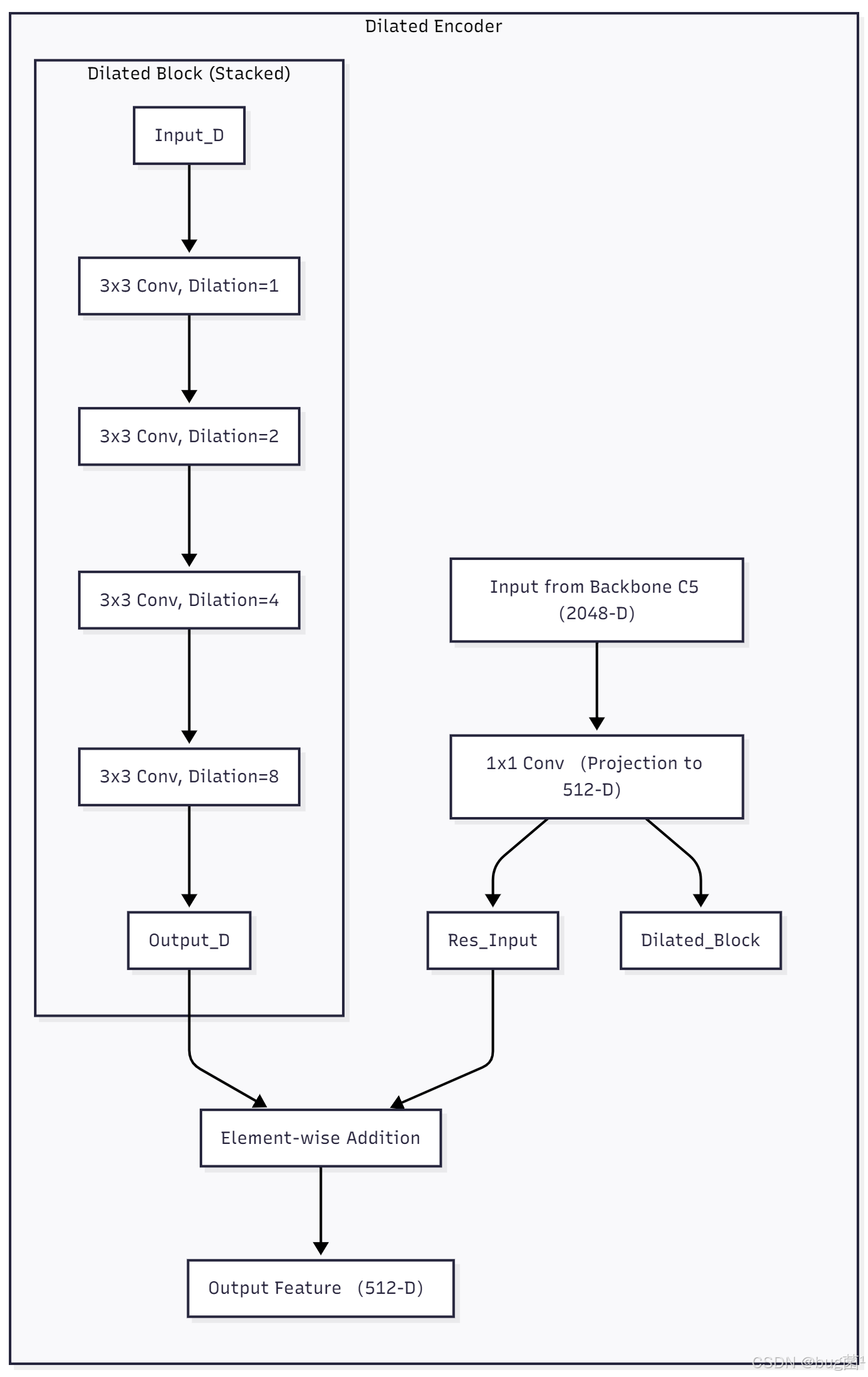

3.3 核心组件(2): 空洞编码器 (Dilated Encoder)

为了解决C5的挑战,YOLOF设计了空洞编码器 (Dilatedncoder)。这个模块的设计思想,受到了语义分割领域中ASPP(Atrous Spatial Pyramid Pooling)的启发。

空洞编码器的目标是:改变特征图分辨率的前提下,高效地扩大感受野,并捕获多尺度的上下文信息。

其结构非常精炼:

- 投影层 (Projection):首先,一个

1x1的卷积层将来自BackboneC5的特征(例如2048通道)投影到一个较低的维度(例如512通道),用于减少计算量。 - 堆叠的空洞卷积 (acked Dilated Convolutions):这是核心部分。它由一系列(通常是4个)具有不同空洞率 (dilation rate) 的3卷积串联而成。

- 什么是空洞卷积?** 空洞卷积(Atrous Convolution / Dilated Convolution)是一种特殊的卷积操作。它在标准的卷积核中插入“空洞”,从而在不增加参数量和计算量的情况下,扩大卷积核的覆盖范围(即感受野)。

- 不同的空洞率**:YOLOF中的这几个卷积层,会采用递增的空洞率,例如

rate=(等同于标准3x3卷积),rate=2,rate=4,rate=8。这意味着,数据流过这个堆叠模块时,它的感受野会逐渐、指数级地扩大。

- 残差连接 (Residual Connection):最后,将经过空洞卷积堆叠处理后的特征,与第一步投影层输出的特征进行逐元素相加。这个残差连接非常重要,它允许网络融合原始的、未经修改的局部特征和经过多尺度上下文增强后的全局特征。

通过这个精巧的设计,从Final_Output中任意取出一个像素点,它都蕴含了从小的、局部的(来自残差连接)到非常大的、全局的(来自最大空洞率卷积)多种感受野的信息。问题解决了!

3.4 核心组件(3): 统一匹配的检测头 (Uniform Matching)

在获得了这张强大的、富含多尺度信息的单层特征图后,YOLOF的检测头设计就非常直接了。它采用了与RetinaNet类似的标准检测头,包含分类和回归两个分支。

最关键的区别在于锚框匹配 (Anchor Matching) 策略:

- FPN:将不同尺寸的锚框(例如,小的分配给P3,大的分配给P5)匹配到不同的特征图上。

- YOLOF:将所有尺寸 的锚框(从小的到大的),都匹配到 同一张 由Neck输出的特征图上。

这种“统一匹配”的策略所以能够成功,完全得益于空洞编码器所提供的丰富的多尺度感受野。现在,检测头有能力在同一个地方,同时处理好大、中、小不同目标的预测任务了。

3.5 YOLOF如何弥补精度:当“感受野”遇见“正负样本”

我们再回到最初的优化问题上,更深入地理解YOLOF是如何弥补精度的。

-

对于大目标:一个大目标会对应多个正样本锚框。这些锚框覆盖的区域,在经过空洞编码器处理后,能够有效地利用大空洞率的卷积分支,获取到捕捉目标全貌所需的巨大感受野。

-

对于小目标:一个小目标只对应少数几个正样本锚框。这些锚框所在的区域,同样在空洞编码器中进行了处理。虽然大空洞率的分支可能会引入过多的背景噪声,但由于编码器中也包含了小空洞率(

rate=1, 2)的分支,并且有直连的残差连接,检测头依然可以从中提取到精确的、小范围的局部特征来识别和定位小目标。 -

Fal Loss:同时,YOLOF沿用了Focal Loss来处理极端不平衡的正负样本问题,这对于单阶段检测器的精度至关重要。

综上所述,YOLOF通过一个空洞编码器,在单层特征图上模拟出了一个“ 感受野金”,从而替代了FPN的“特征金字塔”,用更低的成本解决了同样的核心问题。

💻 四、YOLOF代码实战:用PyTorch构建极速Neck

理论的深度让我们着迷,而代码的实现则让理论变得触手可及。现在,就让我们用PyTorch来亲手打造YOLOF这个简洁而强大的Neck吧!

4.1 核心中的核心:DilatedEncoder模块实现

我们首先来实现YOLOF的灵魂——空洞编码器。

import torch

import torch.nn as nn

import torch.nn.functional as F

from typing import List

class DilatedEncoder(nn.Module):

"""

YOLOF的空洞编码器模块。

它由一个1x1卷积,一个包含4个具有不同空洞率的3x3卷积的堆叠块,

以及一个残差连接构成。

"""

def __init__(self, in_channels: int, encoder_channels: int):

"""

初始化空洞编码器。

参数:

in_channels (int): 输入特征图的通道数 (来自骨干网络C5,例如2048)

encoder_channels (int): 编码器内部的工作通道数 (例如512)

"""

super().__init__()

# 1. 1x1的投影卷积,用于降低通道数和特征转换

self.project_conv = nn.Sequential(

nn.Conv2d(in_channels, encoder_channels, kernel_size=1, bias=False),

nn.BatchNorm2d(encoder_channels),

nn.ReLU(inplace=True)

)

# 2. 堆叠的空洞卷积块

# dilation_rates: 空洞率列表

# 论文中使用了 [1, 2, 4, 8] 的 rates,但这里为了演示,使用 [2, 4, 6, 8]

# 注意:padding = dilation_rate 才能保持 H, W 不变

dilation_rates = [2, 4, 6, 8]

self.dilated_convs = nn.Sequential(*[

nn.Sequential(

nn.Conv2d(encoder_channels, encoder_channels, kernel_size=3, padding=rate, dilation=rate, bias=False),

nn.BatchNorm2d(encoder_channels),

nn.ReLU(inplace=True)

) for rate in dilation_rates

])

def forward(self, x: torch.Tensor) -> torch.Tensor:

"""

前向传播。

参数:

x (torch.Tensor): 来自骨干网络的C5特征图。

返回:

torch.Tensor: 经过多尺度上下文增强后的特征图。

"""

# 1. 首先通过投影层

projected_feat = self.project_conv(x)

# 2. 特征流过空洞卷积堆叠块

dilated_feat = self.dilated_convs(projected_feat)

# 3. 添加残差连接

output = projected_feat + dilated_feat

return output

代码解析:

-

__init__:

**project_conv: 一个标准的1x1 Conv-BN-ReLU块,负责将高维的输入特征(如ResNet50 C5的2048维)降维到编码器的工作维度(如512维),这是减少后续计算量的关键一步。dilated_convs: 这是实现的核心。我们使用一个列表推导式和nn.Sequential(*...)语法,非常优雅地构建了4个串联的空洞卷积块。- 关键点:对于一个

kernel_size=3的空洞卷积,为了使输入和输出的H, W保持不变,padding必须等于dilation_rate。这是因为空洞卷积的等效核大小为k_eff = k + (k-1)*(rate-1),这里是 `3 + 2*(rate-1)其感受野覆盖的范围变大了,因此需要更大的padding。

-

forward:- 代码清晰地展示了数据流:

x先进投影层得到projected_feat。 - 然后

projected_feat进入dilated_convs得到dilated_feat。 - 最后,

projected_feat和dilated_feat通过简单的+号实现残差连接。整个过程非常直观。

- 代码清晰地展示了数据流:

4.2 组装YOLOF整体Neck

有了核心的Encoder,我们现在来组装包含Encoder和Decoder的完整YOLOF Neck。

class YOLOFNeck(nn.Module):

"""

完整的YOLOF Neck实现,包含Encoder和Decoder。

"""

def __init__(self, in_channels: int, neck_channels: int, num_decoder_layers: int = 2):

"""

初始化YOLOF Neck。

参数:

in_channels (int): 输入特征图的通道数 (来自骨干网络C5)

neck_channels (int): Neck输出特征图的通道数,也是Encoder的工作通道数

num_decoder_layers (int): Decoder中包含的卷积层数量

"""

super().__init__()

# 1. 实例化空洞编码器

self.encoder = DilatedEncoder(in_channels=in_channels, encoder_channels=neck_channels)

# 2. 构建解码器

# 解码器由一系列标准的3x3卷积构成,用于精炼特征

decoder_layers = []

for _ in range(num_decoder_layers):

decoder_layers.append(

nn.Sequential(

nn.Conv2d(neck_channels, neck_channels, kernel_size=3, padding=1, bias=False),

nn.BatchNorm2d(neck_channels),

nn.ReLU(inplace=True)

)

)

self.decoder = nn.Sequential(*decoder_layers)

def forward(self, features: List[torch.Tensor]) -> List[torch.Tensor]:

"""

前向传播。

参数:

features (List[torch.Tensor]): 来自骨干网络的特征列表。YOLOF只使用最后一层。

返回:

List[torch.Tensor]: 只包含一个元素的列表,即最终输出的单层特征图。

"""

# YOLOF只使用最高层的特征,通常是列表中的最后一个

x = features[-1]

# 1. 通过编码器

x = self.encoder(x)

# 2. 通过解码器

x = self.decoder(x)

# YOLOF的输出仍然是一个列表,以保持与其他Neck(如FPN)的接口兼容性

return [x]

代码解析:

-

init:

- 我们直接实例化了之前定义的

DilatedEncoder。 decoder的实现非常简单,就是堆叠了numdecoder_layers个标准的3x3 Conv-BN-ReLU块,它的作用是进一步融合和优化特征。

- 我们直接实例化了之前定义的

-

forward:

x = features[-1]: 这一行代码鲜明地体现了YOLOF的核心思想——只取输入特征列表中的最后一个(即C5)。- 数据依次流过

encoder和decoder。 return [x]: 最后返回一个只包含一个张量的列表。这样做是为了与那些输出多层特征(如P3, P4, P5)的FPN-based Neck保持API接口的一致性,方便在不同的检测框架中即插即用地替换。

4.3 完整使用示例与解析

现在,让我们模拟一下在实际模型中如何使用这个YOLOFNeck。

if __name__ == '__main__':

# --- 1. 定义模型配置 ---

# 假设Backbone是ResNet-50

backbone_c5_channels = 2048 # ResNet-50 C5层的输出通道数

neck_output_channels = 512 # Neck期望的输出通道数

# --- 2. 实例化YOLOF Neck ---

yolof_neck = YOLOFNeck(

in_channels=backbone_c5_channels,

neck_channels=neck_output_channels,

num_decoder_layers=2

)

yolof_neck.eval() # 设置为评估模式

print("--- YOLOF Neck 实例化成功!---")

print(yolof_neck)

# --- 3. 模拟输入 ---

print("\n--- 模拟输入 ---")

batch_size = 2

# 假设输入图像尺寸为 640x640,C5特征图为 20x20 (下采样32倍)

dummy_c5_feature = torch.randn(batch_size, backbone_c5_channels, 20, 20)

# 模拟一个完整的Backbone输出列表,但YOLOF只会用到最后一个

dummy_backbone_outputs = [

torch.randn(batch_size, 512, 80, 80), # C3 (未使用)

torch.randn(batch_size, 1024, 40, 40), # C4 (未使用)

dummy_c5_feature # C5 (使用)

]

print(f"输入C5特征图尺寸: {dummy_c5_feature.shape}")

# --- 4. 前向传播测试 ---

with torch.no_grad():

output_features = yolof_neck(dummy_backbone_outputs)

# --- 5. 验证输出 ---

print("\n--- 验证输出 ---")

assert isinstance(output_features, list) and len(output_features) == 1, "输出应为单元素列表"

final_output = output_features[0]

print(f"YOLOF Neck 输出特征图尺寸: {final_output.shape}")

# 验证输出的通道数和尺寸是否正确

expected_shape = (batch_size, neck_output_channels, 20, 20)

assert final_output.shape == expected_shape, f"输出尺寸错误!期望 {expected_shape}, 得到 {final_output.shape}"

print("\n✅ 所有测试通过!YOLOF Neck 正常工作,结构简洁,运行高效!")

代码与结果解析:

- 我们成功实例化了

YOLOFNeck,并传入了模拟的ResNet-50 C5层的通道数。 - 我们创建了一个包含C3, C4, C5的列表

dummy_backbone_outputs来模拟一个真实骨干网络的输出,但你可以清晰地看到,只有C5被YOLOF所关注。 - 前向传播后,我们得到的

output_features是一个只包含一个张量的列表。 - 最终输出的张量,其通道数被成功地转换为了我们期望的

neck_tput_channels(512),并且其空间分辨率20x20与输入的C5完全保持一致。这证明我们的Neck在整个过程中没有进行任何下采样或上采样,完美体现了YOLOF的设计。

⚖️ 五、性能与效率:YOLOF的“降维打击”

我们已经从理论和代码层面完全掌握了YOLOF。现在,让我们从一个更高的视角,来审视它带来的革命性影响,以及它的优势与权衡。

5.1 速度的极致:为什么YOLOF这么快?

YOLOF的推理速度远超同等精度下的FPN-based检测器(如RetinaNet),其速度优势是压倒性的。原因就在于其极简的结构:

- 无跨尺度操作:这是最核心的原因。FPN及其变种包含了大量的

Upsample(上采样)、Downsample(下采样)和Concat(拼接)操作。这些操作,尤其是Upsample和Concat,会带来巨大的内存访问开销 (Memory Access Cost)。在GPU上,频繁地读取和写入不同尺寸的特征图,会打断计算流水线,成为性能瓶颈。YOLOF完全没有这些操作,数据流从头到尾都在单一尺度的特征图上进行,对硬件极其友好。 - 计算量(FLOPs)更低:相比于需要在P3, P4, P5, P6, P7多个层级上都进行计算的FPN,YOLOF只在一个层级上进行计算,其总的浮点运算量天然就更少。

- 更少的检测头:FPN-based检测器通常有多个检测头,分别对应不同的特征层。而YOLOF只有一个统一的检测头,进一步减少了计算开销。

YOLOF的速度优势,是对FPN复杂性的一次彻底的“降维打击”。它证明了,通过巧妙的结构设计,我们可以在不牺牲太多精度的前提下,获得数量级的速度提升。

5.2 精度的权衡:YOLOF的适用场景与局限

天下没有免费的午餐。YOLOF的极简设计,在带来速度的同时,也必然会在精度上有所取舍。

适用场景:

-

速度优先的应用:对于需要高吞吐量、低延迟的实时检测任务(如视频流分析、云端推理服务),YOLOF是绝佳的选择。

-

数据集规模适中:在像COCO这样物体尺度分布相对均衡的数据集上,YOLOF可以取得非常有竞争力的结果。

-

作为强大的基线:由于其简洁性,YOLOF非常适合作为一个快速、可靠的基线模型(Baseline),用于验证和比较其他更复杂的模块的有效性。

潜在局限:

- 小目标检测性能:尽管空洞编码器尽力弥补,但完全依赖于低分辨率的

C5特征,使得YOLOF在检测极小目标上的能力,天然地弱于那些能够利用高分辨率底层特征(如P3)的FPN-based检测器。这是它最主要的精度短板。 - 对极端尺度变化的鲁棒性:如果一个数据集中的物体尺度变化范围极大(例如,同时存在像素级的小物体和占据半个屏幕的大物体),YOLOF的单层特征可能难以完全覆盖如此宽的尺度范围,性能可能会下降。

5.3 YOLOF的深远影响:对Neck设计的重新思考

YOLOF的意义,远不止于一个模型本身。它更像是一篇宣言,促使整个社区重新思考Neck在目标检测中的真正作用。

- 挑战FPN的“霸权”:YOLOF用无可辩驳的实验结果证明了,FPN并非不可或缺。这激发了后续一系列关于“无FPN”检测器的研究。

- 关注优化问题:它将研究者的视线,从“如何设计更复杂的特征融合路径”,拉回到了“如何更好地解决检测中的核心优化问题”上,这是一个更本质的思考方向。

- 简洁就是力量:YOLOF是“奥卡姆剃刀”原则在深度学习设计中的一次完美体现——“如无必要,勿增实体”。它告诉我们,最优雅的解决方案,往往也是最简单的那个。

🎓 六、总结与展望

在今天的探索中,我们深入学习了YOLOF这个充满智慧和勇气的杰作。它以一种近乎“叛逆”的姿态,挑战了当时目标检测领域的“金科玉律”,为我们展示了简洁的力量。让我们一同回顾这次思想洗礼的收获:

- 我们从回顾CSP-PAN开始,理解了现代高效Neck的设计范式,并由此引出了对Neck复杂性的终极拷问。

- 我们深入YOLOF的动机,揭示了其核心洞察:FPN的主要作用是解决优化问题,而非多尺度融合。

- 我们 深度剖析了YOLOF的,特别是其灵魂组件——空洞编码器 (Dilated Encoder),理解了它是如何在单层特征图上创造出“感受野金字塔”的。

- 在代码实战中,我们用PyTorch亲手实现了完整的YOLOF Neck,并验证了其简洁、高效的数据流,将理论知识转化为了实践能力。

- 最后,我们 客观地权衡了YOLOF的得,看到了它在速度上的极致优势和在精度上的合理取舍,并理解了它对整个领域的深远影响。

YOLOF教会我们,在面对一个复杂问题时,除了在现有框架上做加法,更要敢于跳出框架,去质疑和思考问题的本质。有时候,最强大的武器,不是更复杂的装备,而是更深刻的洞察。为你今天的深度思考和学习点赞!👍

🔔 七、蓄势待发:下期内容预告 (DetectoRS递归特征融合)

今天,我们领略了YOLOF“大道至简”的哲学,它通过简化Neck,达到了速度的极致。

然而,在科研的道路上,探索永无止境。与YOLOF的“减法”哲学相对,另一派思想则在“加法”的道路上探索到了极致。他们思考的是:我们能否设计一种机制,让Backbone和Neck不再是独立的两个阶段,而是能够相互迭代、相互增强,从而将特征的质量推向一个前所未有的高度?

这,就是我们下一期的主角——DetectoRS (Detecting objects with Recursive Feature Pyramid and Switchle Atrous Convolution) 的核心思想!

在下一期第18节中,我们将一起探索:

- 宏观层面的递归:什么是递归特征金字塔 (Recursive Feature Pyramid, RFP)?它如何将FPN的输出“反馈”给Backbone,形成一个迭代式的特征精炼闭环?

- 动态的Backbone:什么是 可切换空洞卷积 (Switchable Atrous Convolution, SAC?它如何让Backbone自身具备动态调整感受野的能力,从而更好地与RFP配合?

- 性能的巅峰:我们将看到,这种极致的“加法”和“迭代”设计,是如何在COCO等榜单上刷新记录,达到当时SOTA性能的。

- 复杂性与收益:深入探讨DetectoRS在带来巨大精度提升的同时,所付出的巨大计算代价。

如果说YOLOF是追求效率的“轻骑兵”,那么DetectoRS就是追求性能的“重装甲军团”。下一期,让我们一同见证这场关于“极致简洁”与“极致复杂”的思想碰撞!不见不散!👋😊

希望本文所提供的YOLOv8内容能够帮助到你,特别是在模型精度提升和推理速度优化方面。

PS:如果你在按照本文提供的方法进行YOLOv8优化后,依然遇到问题,请不要急躁或抱怨!YOLOv8作为一个高度复杂的目标检测框架,其优化过程涉及硬件、数据集、训练参数等多方面因素。如果你在应用过程中遇到新的Bug或未解决的问题,欢迎将其粘贴到评论区,我们可以一起分析、探讨解决方案。如果你有新的优化思路,也欢迎分享给大家,互相学习,共同进步!

🧧🧧 文末福利,等你来拿!🧧🧧

文中讨论的技术问题大部分来源于我在YOLOv8项目开发中的亲身经历,也有部分来自网络及读者提供的案例。如果文中内容涉及版权问题,请及时告知,我会立即修改或删除。同时,部分解答思路和步骤来自全网社区及人工智能问答平台,若未能帮助到你,还请谅解!YOLOv8模型的优化过程复杂多变,遇到不同的环境、数据集或任务时,解决方案也各不相同。如果你有更优的解决方案,欢迎在评论区分享,撰写教程与方案,帮助更多开发者提升YOLOv8应用的精度与效率!

OK,以上就是我这期关于YOLOv8优化的解决方案,如果你还想深入了解更多YOLOv8相关的优化策略与技巧,欢迎查看我专门收集YOLOv8及其他目标检测技术的专栏《YOLOv8实战:从入门到深度优化》。希望我的分享能帮你解决在YOLOv8应用中的难题,提升你的技术水平。下期再见!

码字不易,如果这篇文章对你有所帮助,帮忙给我来个一键三连(关注、点赞、收藏),你的支持是我持续创作的最大动力。

同时也推荐大家关注我的公众号:「猿圈奇妙屋」,第一时间获取更多YOLOv8优化内容及技术资源,包括目标检测相关的最新优化方案、BAT大厂面试题、技术书籍、工具等,期待与你一起学习,共同进步!

🫵 Who am I?

我是计算机视觉、图像识别等领域的讲师 & 技术专家博客作者,笔名bug菌,CSDN | 掘金 | InfoQ | 51CTO | 华为云 | 阿里云 | 腾讯云 等社区博客专家,C站博客之星Top30,华为云多年度十佳博主,掘金多年度人气作者Top40,掘金等各大社区平台签约作者,51CTO年度博主Top12,掘金/InfoQ/51CTO等社区优质创作者;全网粉丝合计 30w+;更多精彩福利点击这里;硬核微信公众号「猿圈奇妙屋」,欢迎你的加入!免费白嫖最新BAT互联网公司面试真题、4000G PDF电子书籍、简历模板等海量资料,你想要的我都有,关键是你不来拿。

-End-

更多推荐

已为社区贡献56条内容

已为社区贡献56条内容

所有评论(0)