LLM - Model Context Protocol(MCP)底层解析与实战指南

近年来,大语言模型(LLM)给各行各业带来变革。但原生LLM受限于静态知识库和有限外部能力,实用性面临天花板。如何让LLM“动手做事”,实现**实时数据获取与工具协作**,一直是AI工程领域的关键课题。

文章目录

引言

近年来,大语言模型(LLM)给各行各业带来变革。但原生LLM受限于静态知识库和有限外部能力,实用性面临天花板。如何让LLM“动手做事”,实现实时数据获取与工具协作,一直是AI工程领域的关键课题。

随着Function Calling、外部插件机制发展,一种更简洁、标准化的解决方案迅速崭露头角——Model Context Protocol(MCP)。它以协议层形式,让模型如“具身智能体”般自如扩展外部能力,在AI应用工程领域获得大量关注。

本文将系统梳理MCP出现的背景、底层机制、典型用例与开发实践,全方位助力技术人掌握MCP生态最新动态与落地核心能力。

MCP基础原理

什么是MCP?

MCP,全称Model Context Protocol,是一套面向AI模型(尤指LLM)设计的能力扩展开放协议。它标准化了大模型如何发现、调用、使用外部工具(如API、数据库、文件系统等)或资源,从而突破模型静态封闭的知识能力边界。

核心目标:

- 以最小抽象统一工具发现、描述与调用接口

- 解耦模型能力与具体API逻辑

- 支持本地/远程部署,安全灵活

基本角色

- MCP Client

通常嵌入AI产品(如Claude Desktop App),负责与服务端握手、加载工具、转发用户请求及结果。 - MCP Server

标准化注册一批“功能工具包”(Tool),并对外暴露REST或本地协议接口,实际执行任务逻辑。 - Tool/Resource/Prompt

- Tool:具备明确输入输出定义、可供模型调用的功能单元(如get_forecast)

- Resource:可由客户端读取的文件型数据或API响应

- Prompt:预设指令模板,提升任务自动化与复用性

MCP在AI工具生态里的定位

对比OpenAI Plugin/Function Calling等同类机制,MCP优势在于协议解耦与通用扩展——无论集成于桌面端、聊天应用还是IDE,都能按需“装配”新功能如积木化升级AI助手。

MCP工作机制深度剖析

实战案例:实时天气查询实录

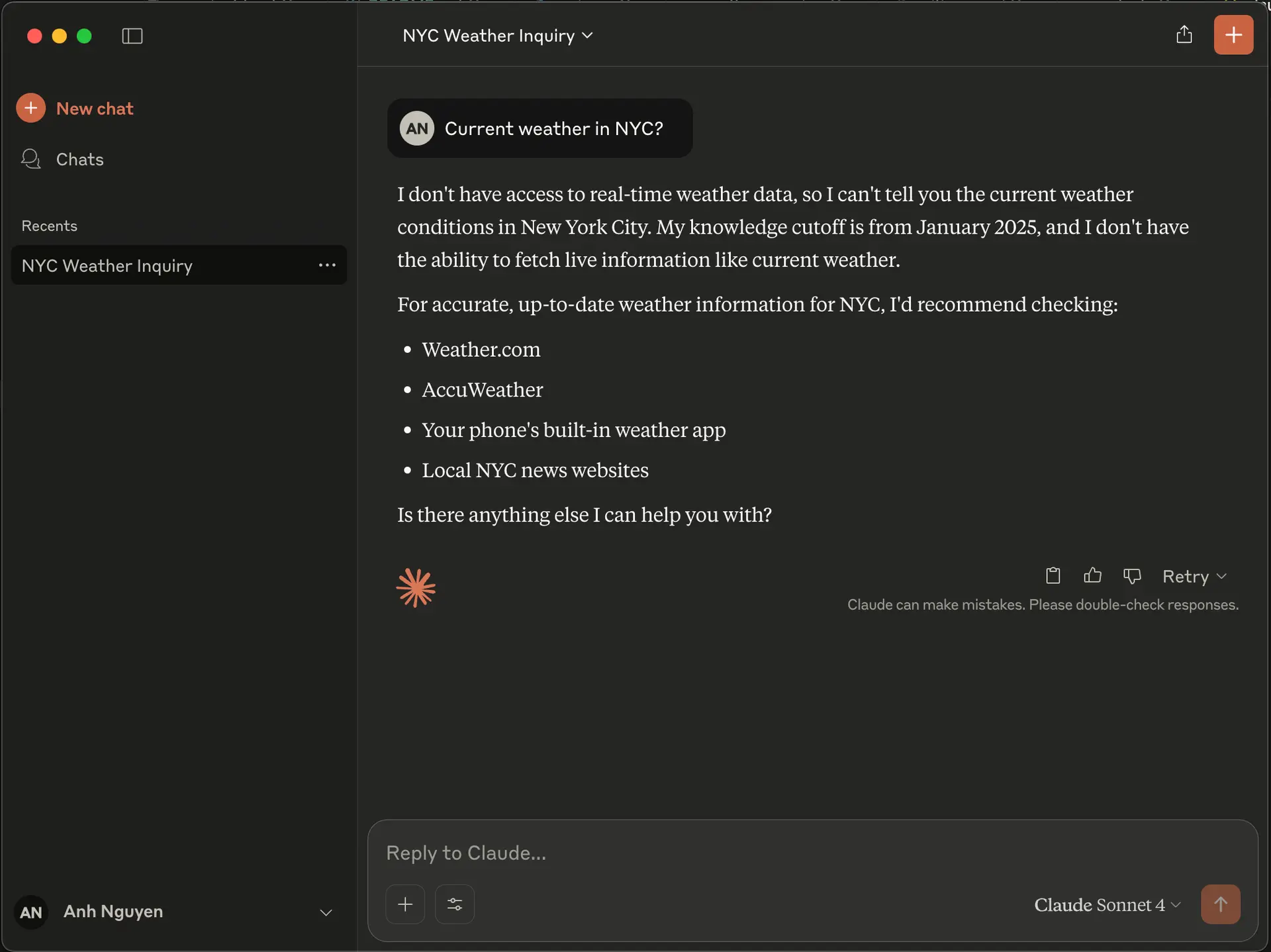

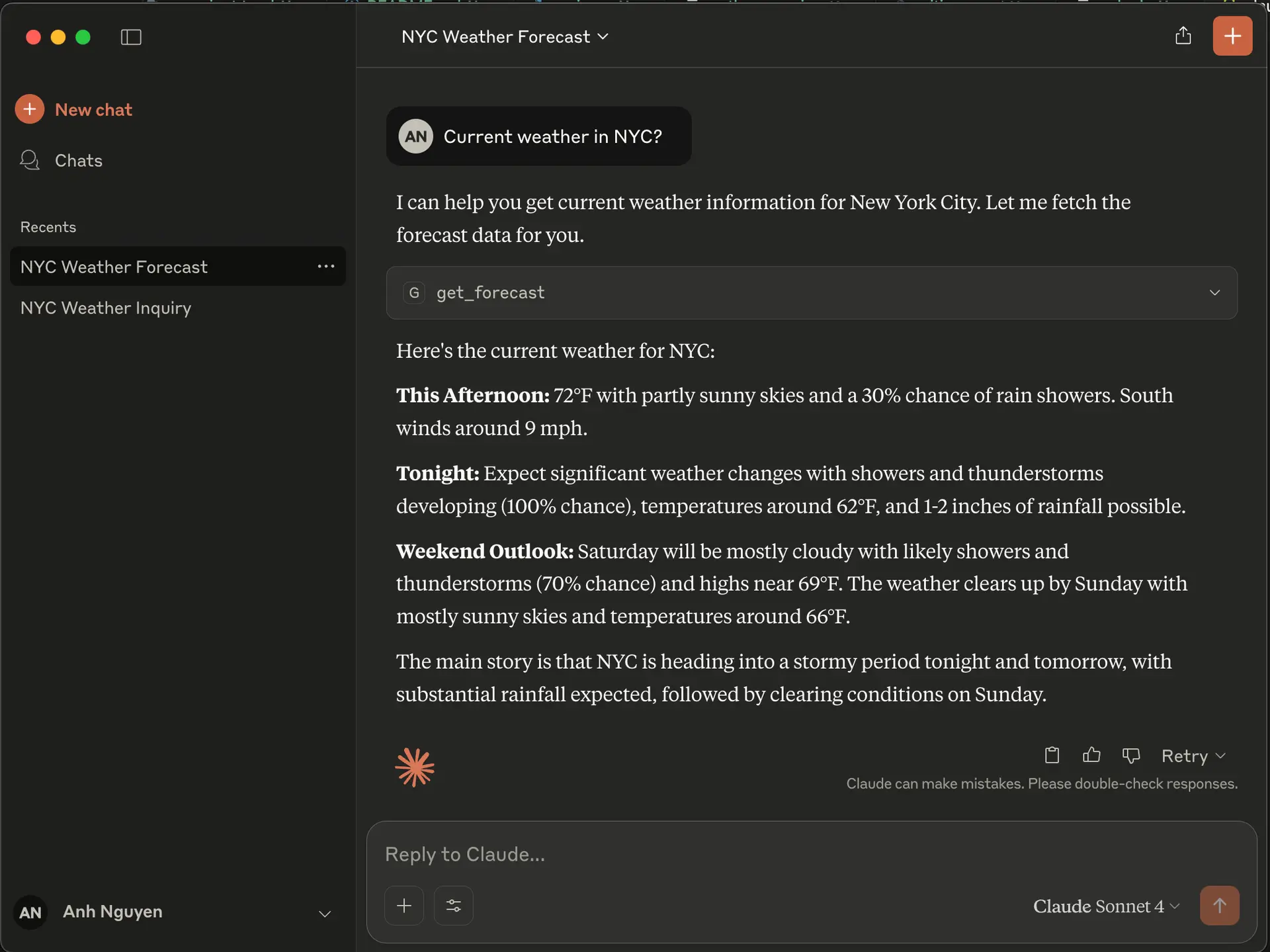

有了 MCP,它现在可以通过以下工具来回答这个问题:

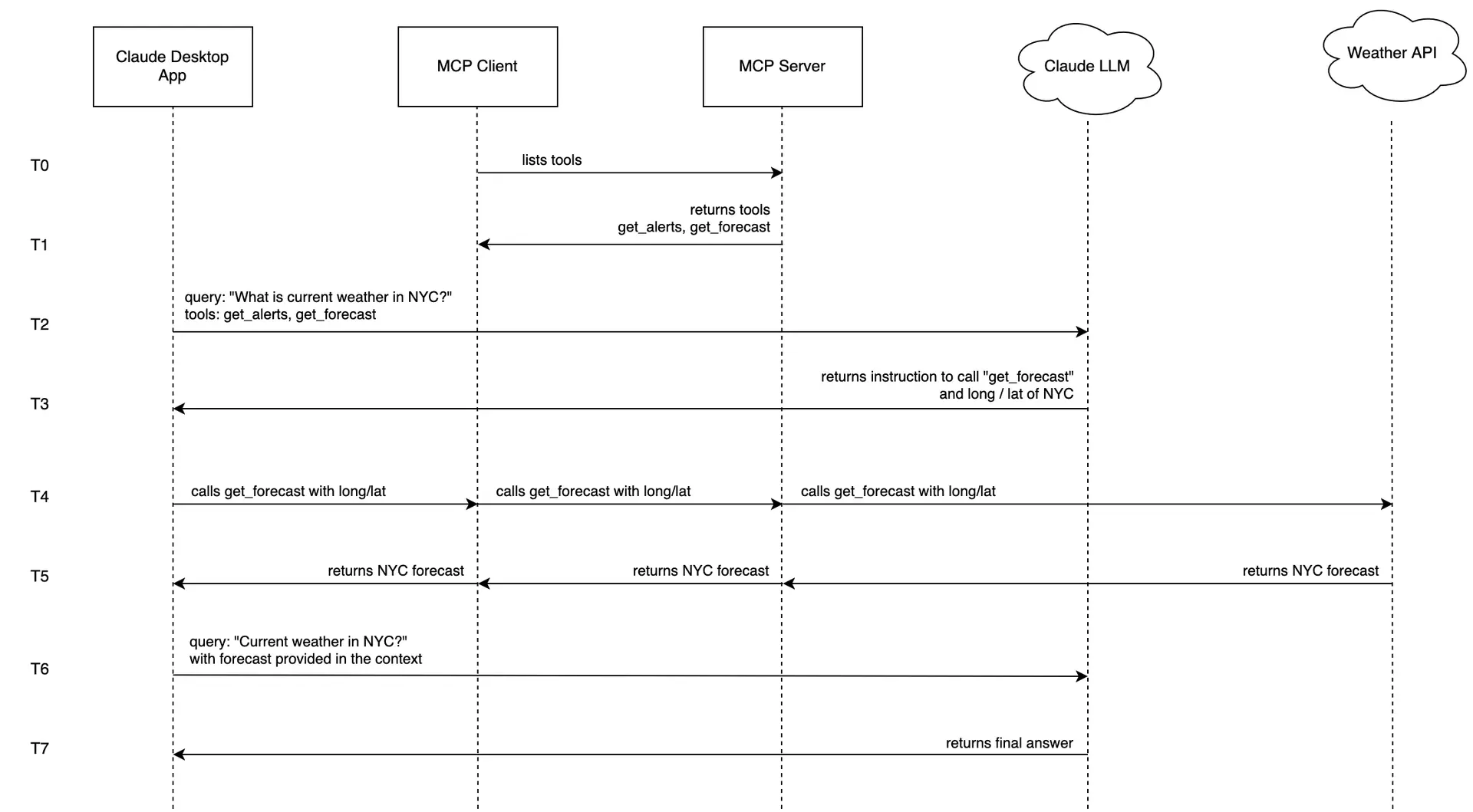

以Claude Desktop为例,演示一个完整的实时天气查询流程:

流程

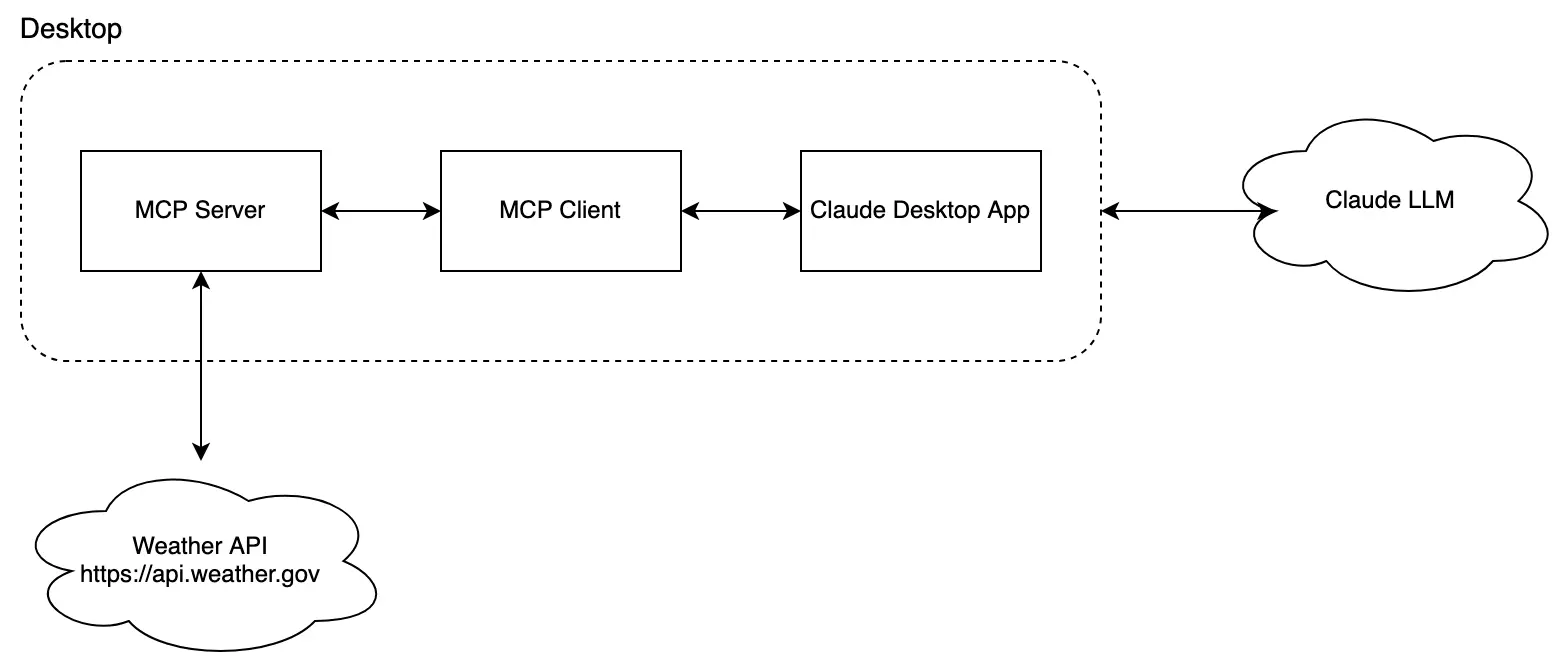

- MCP Client建立会话,拉取MCP Server工具列表(如get_forecast、get_alerts)

[ { "name": "get_alerts", "description": "Get weather alerts for a US state.", "input_schema": { "properties": {"state": {"title": "State", "type": "string"}}, "required": ["state"] } }, { "name": "get_forecast", "description": "Get weather forecast for a location", "input_schema": { "properties": { "latitude": {"title": "Latitude", "type": "number"}, "longitude": {"title": "Longitude", "type": "number"} }, "required": ["latitude", "longitude"] } } ] - 用户提问:Current weather in NYC?

- MCP Client封装用户输入与工具元信息,发送至Claude LLM

- Claude LLM判断最优调用方案,自动选择合适Tool(如get_forecast),并自动生成参数(如曼哈顿坐标)

- MCP Client调用对应MCP Server接口,Server转发至底层Weather API,获取实时气象数据

- 数据信息逐级返还,最终由LLM生成自然语言答复展示给用户

控制流与数据流简图

MCP与大模型协作优势与创新

| 机制 | 工具发现 | 调用灵活性 | 扩展生态 | 部署形态 | 典型场景 |

|---|---|---|---|---|---|

| OpenAI Plugin | 插件注册 | 依赖云API | 官方精选为主 | 远程SaaS | Web检索、结构化数据获取 |

| Function Calling | Tool参数注入 | 灵活 | 基于API文档 | 本地/云端 | 内部业务API对接 |

| MCP | 运行时灵活挂载 | 完全标准协议 | 社区百花齐放 | 本地/桌面/远程均可 | 任意第三方扩展、桌面工具、私有数据 |

创新点总结:

- 服务发现/调用协议解耦,开发者只需实现标准接口即可

- 支持IDE/桌面端原生集成,为离线/私有场景提供天然适配

- 统一描述各类能力单元,极大便于功能复用与组合创新

安全性与合规挑战

MCP使AI“动手做事”门槛极大降低,其本身也带来新的攻击面——如权限提升、资源滥用、数据外泄。

开发与部署建议:

- 严格限制可用Tool的权限与参数范围

- 细粒度日志审计与异常监控

- 务必过滤敏感输入输出内容,防止Prompt Injection等AI专属新型攻击

- 对Tool调用结果做二次校验,特别是涉及用户资金/隐私等高风险操作

- 遵守Local/Global法律法规,确保数据安全与合规

未来展望与应用趋势

- 生态高速扩展: MCP服务端适配Github、Jira、Slack、Cloudflare等主流开发与协作平台,支持多模态(文本/音频/图片)工具赋能

- AI业务形态重塑: AI助手将不再只是“只会说话”,而是深度集成到生产力工作流的“超级插件中枢”

- 隐私增强与自托管浪潮: 本地部署、桌面工具自定义等成为主流,兼顾创新与合规

- 智能体与多Agent协作趋势: MCP标准助力智能体生态发展,与RAG、多Agent框架共同推动AI工程化落地

结论

MCP作为大模型能力扩展的新范式,以协议标准化+生态开放双轮驱动,成为全行业关注热点。对开发者而言,MCP不仅能让你的LLM“触手可及”任何外部功能,更帮助打造高度个性化、安全可信的AI应用。

未来,用MCP打造只属于你的AI超级助手,将会是每一位AI开发者的必修课。现在,正是上车时机!

更多推荐

已为社区贡献38条内容

已为社区贡献38条内容

所有评论(0)