【边缘端的深度思考】Jetson AGX Xavier 部署 ERNIE-4.5-21B-A3B-Thinking 全流程深度实战

本文详细介绍了在NVIDIA Jetson AGX Xavier边缘计算设备上部署百度ERNIE-4.5-21B大语言模型的完整流程。首先通过WSL2环境完成JetPack 5.1.x系统的刷机配置,包括USB透传、恢复模式进入等关键步骤。然后优化开发环境,包括切换性能模式、配置软件源、修复CUDA路径等。文章还提供了系统资源监控和Python隔离环境的搭建方法,为在边缘设备上高效运行MoE架构的

边缘端的深度思考:Jetson AGX Xavier 部署 ERNIE-4.5-21B-A3B-Thinking 全流程深度实战

前言

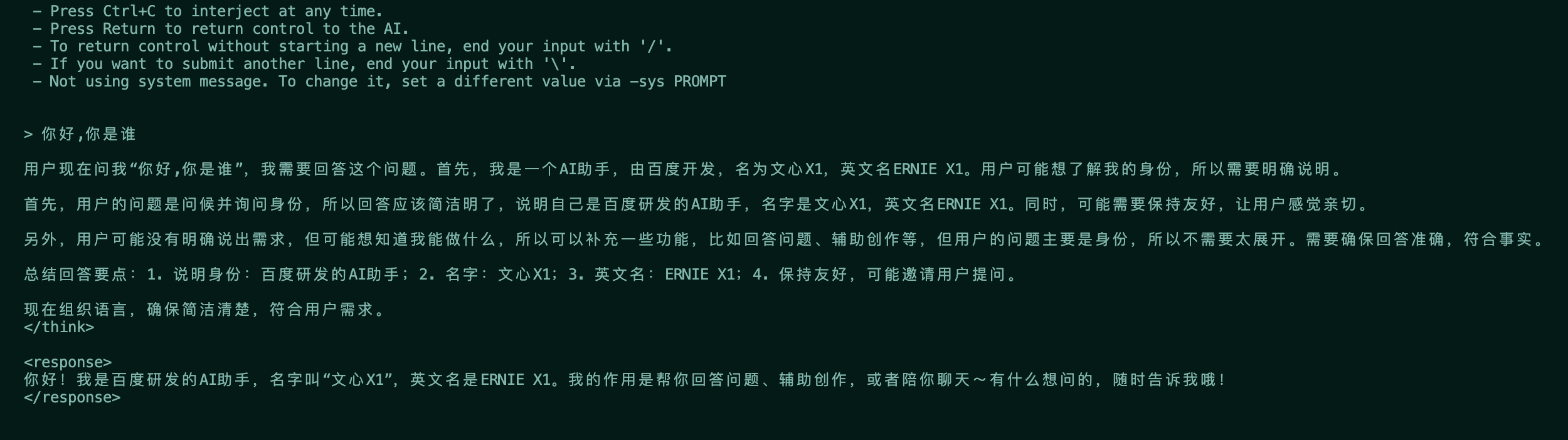

在边缘计算领域,NVIDIA Jetson AGX Xavier 凭借其 32GB 统一内存和 Volta 架构 GPU,依然是运行大语言模型(LLM)的强力平台。近期,百度推出的 ERNIE-4.5-21B-A3B-Thinking 模型,引入了类似 OpenAI o1 的“深度思考”模式,配合 MoE(混合专家)架构,在保持 21B 参数规模的同时,将推理时的激活参数控制在 3B 左右。

本文将提供一份详尽的工程指南,指导如何在 Jetson AGX Xavier 上通过 Windows WSL2 环境完成 JetPack 5.1.x 的纯净刷机,构建高效的开发环境,并使用 llama.cpp 框架部署这一具备深度推理能力的模型。

第一部分:系统重塑 —— 基于 WSL2 的 JetPack 5.x 刷机

Jetson AGX Xavier 最高仅支持 JetPack 5.x (L4T 35.x) 系列,无法升级至 JetPack 6。为了确保 CUDA 版本的兼容性(通常为 CUDA 11.4),强烈建议彻底重刷系统。

1.1 宿主机环境准备

刷机操作将在 Windows 10/11 PC 上通过 WSL2 子系统完成,这种方式比传统虚拟机更高效。

- WSL2 安装:确保已安装 Ubuntu 20.04 发行版(JetPack 5 的 SDK Manager 对 20.04 支持最佳)。

- USBIPD 工具:用于将 Windows 的 USB 端口透传给 WSL。请访问 usbipd-win GitHub 下载并安装最新的

.msi包。 - SDK Manager:前往 NVIDIA 官网下载适用于 Linux 的

.deb安装包,并在 WSL 中安装:sudo apt update sudo apt install -y libgconf-2-4 libatk1.0-0 libatk-bridge2.0-0 libgdk-pixbuf2.0-0 libgtk-3-0 libgbm-dev libnss3-dev libxss-dev sudo apt install ./sdkmanager_*.deb # 替换为实际文件名

1.2 进入强制恢复模式 (Force Recovery Mode)

这是识别设备的物理基础,操作顺序必须精确。

- 断电检查:确保 Jetson AGX Xavier 已连接电源适配器,但处于关机状态。

- 物理连接:使用高质量 USB-C 数据线,连接 Jetson 正面的 USB Type-C 接口(电源指示灯旁边的接口)至电脑 USB 端口。

- 按键序列:

- 第一步:按住中间的 【Recovery (恢复) 键】 不松手。

- 第二步:按一下最右侧的 【Power (电源) 键】 开机。

- 第三步:等待约 2~3 秒。

- 第四步:先松开 【Recovery 键】。

- 第五步:最后松开 【Power 键】。

- 验证状态:打开 Windows 设备管理器,展开“通用串行总线设备”或“其他设备”,若出现名为 APX 或 NVIDIA USB Boot-recovery driver 的设备,即表示成功。

1.3 USB 透传与烧录配置

在 Windows PowerShell (管理员权限) 中建立连接通道:

usbipd list

# 输出示例:

# BUSID VID:PID DEVICE STATE

# 1-2 0955:7019 APX Not attached

# 执行挂载(务必替换 1-2 为实际 BUSID)

# 关键参数:--auto-attach 用于处理刷机过程中设备重启导致的连接断开问题

usbipd attach --wsl Ubuntu-20.04 --busid 1-2 --auto-attach

在 WSL 终端中启动刷机工具:

sdkmanager

SDK Manager 关键配置项:

- Target Hardware: 选择

Jetson AGX Xavier modules。 - JetPack Version: 必须选择 5.1.2 或 5.1.3 (L4T 35.x.x)。

- DeepStream: 推荐勾选,方便后续视频流处理。

- 进入 Step 3 后的配置:

- Storage Device: 务必选择 eMMC (32GB)。

- 警告:若误选 NVMe,会导致刷机引导失败,因为 Xavier 默认引导介质为板载 eMMC。

- OEM Configuration: 选择 Runtime (手动运行时配置)。

- Storage Device: 务必选择 eMMC (32GB)。

点击 Flash 开始烧录。OS 阶段完成后,Jetson 会重启并进入 Ubuntu 初始化界面。此时需连接显示器、键盘鼠标完成账号设置,并插入网线获取 IP 地址。随后在 SDK Manager 中输入 IP、用户名、密码,继续安装 SDK Components (CUDA, cuDNN, TensorRT)。

第二部分:构建高效开发环境

原生 JetPack 系统环境较为基础,需进行一系列优化以适应大模型部署。

2.1 解锁最大性能模式 (NVPModel)

Xavier 默认运行在受限功耗模式下。需切换至 MAXN (无限制) 模式并锁频。

# 切换到 MAXN 模式 (ID: 0)

sudo nvpmodel -m 0

# 立即最大化 CPU/GPU 时钟频率

sudo jetson_clocks

2.2 替换 APT 软件源 (清华源-ARM64)

# 备份原源

sudo cp /etc/apt/sources.list /etc/apt/sources.list.bak

# 写入新源

sudo bash -c 'cat > /etc/apt/sources.list <<EOF

deb http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal main restricted universe multiverse

deb-src http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal main restricted universe multiverse

deb http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-updates main restricted universe multiverse

deb-src http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-updates main restricted universe multiverse

deb http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-backports main restricted universe multiverse

deb-src http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-backports main restricted universe multiverse

deb http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-security main restricted universe multiverse

deb-src http://mirrors.tuna.tsinghua.edu.cn/ubuntu-ports/ focal-security main restricted universe multiverse

EOF'

sudo apt update && sudo apt upgrade -y

2.3 修复 CUDA 环境变量

JetPack 5.x 的 CUDA 安装路径位于 /usr/local/cuda,但默认不在 PATH 中,会导致编译时找不到 nvcc。

# 写入环境变量

echo 'export PATH=/usr/local/cuda/bin:$PATH' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc

source ~/.bashrc

# 验证

nvcc --version # 应显示 CUDA 11.4

2.4 部署 Jtop 监控与 Miniconda

安装 jetson-stats (jtop) 以便实时监控系统资源,安装 Miniconda 以隔离 Python 环境。

# 安装 Jtop

sudo apt install python3-pip -y

python3 -m pip install --upgrade pip

pip3 config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

sudo pip3 install jetson-stats

sudo systemctl restart jtop.service

# 安装 Miniconda

wget https://mirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/Miniconda3-latest-Linux-aarch64.sh

bash Miniconda3-latest-Linux-aarch64.sh

source ~/.bashrc

# 配置 Conda 清华源

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge

conda config --set show_channel_urls yes

第三部分:编译 llama.cpp 推理引擎

llama.cpp 是目前边缘端推理的首选框架,支持 GGUF 格式及 CUDA 混合推理。

3.1 获取源码

需使用支持 gpt-oss 及最新架构的 Master 分支(2025年8月后版本):

git clone https://github.com/ggml-org/llama.cpp.git

cd llama.cpp

3.2 编译构建 (开启 CUDA 加速)

AGX Xavier 搭载 Volta 架构 GPU,编译时必须开启 GGML_CUDA=ON。编译时间较长,请耐心等待。

# 安装编译依赖

sudo apt update

sudo apt install -y build-essential cmake git

# 配置 CMake

cmake -B build -DGGML_CUDA=ON

# 并行编译

cmake --build build --parallel

3.3 常见故障排查 (Troubleshooting)

如果在 CMake 配置阶段出现如下 CUDA Compiler 未找到 的错误:

CMake Error at .../CMakeDetermineCompilerId.cmake:726 (message):

Compiling the CUDA compiler identification source file "CMakeCUDACompilerId.cu" failed.

Compiler: CMAKE_CUDA_COMPILER-NOTFOUND

...

No such file or directory

原因:CMake 无法定位 nvcc 编译器,通常是因为环境变量未生效或指向错误的 CUDA 版本。

修复方案:显式指定 CUDA 路径(根据实际安装版本,JetPack 5 默认为 cuda-11.4)。

# 临时导出环境变量进行修复

export PATH=/usr/local/cuda-11.4/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-11.4/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}

# 清理并重新配置

rm -rf build

cmake -B build -DGGML_CUDA=ON

cmake --build build --parallel

3.4 安装 Python 依赖

编译完成后,安装必要的 Python 库以支持脚本调用:

pip install -e .

第四部分:ERNIE-4.5-21B-A3B-Thinking 深度解析

4.1 模型特性

ERNIE-4.5-21B-A3B-Thinking 是百度发布的轻量级旗舰模型,其核心特性包括:

- MoE 架构:总参数 21B,但在推理时仅激活 3B 参数(每次从 64 个专家中激活 6 个)。这使得它在 Xavier 这种边缘设备上也能保持较高的 Token 生成速度。

- Thinking 能力:引入了类似思维链(CoT)的深度思考模式,在回答复杂问题前会先生成

<thinking>过程,显著提升了逻辑推理、代码生成和数学解题能力。 - 128K 上下文:支持超长文本输入。

4.2 GGUF 量化版本选型指南

针对 AGX Xavier 的 32GB 统一内存,需在精度与上下文长度之间做权衡。以下是推荐版本:

| 量化版本 | 文件大小 | 显存占用 (估算) | 适用场景 | 推荐指数 |

|---|---|---|---|---|

| Q8_0 | 23.2 GB | ~26 GB | 最高精度。适合逻辑要求严苛的任务。但在 32GB 设备上,留给 KV Cache 的空间极少,不适合长对话。 | ⭐⭐⭐ |

| Q6_K | 18.0 GB | ~20 GB | 黄金平衡。精度损失极低,且能留出 10GB+ 内存用于长上下文,稳定性最佳。 | ⭐⭐⭐⭐⭐ |

| Q4_K_M | 13.3 GB | ~15 GB | 高速推理。适合对首字延迟(TTFT)敏感的应用。 | ⭐⭐⭐⭐ |

第五部分:部署实战与指令详解

假设模型文件已下载并存放于:/home/lzj-jetson/my_ssd/models/unsloth/ERNIE-4.5-21B-A3B-Thinking-GGUF/。

5.1 场景一:CLI 命令行交互 (使用 Q6_K 版本)

CLI 模式适合快速测试模型性能和简单的问答交互。这里选用 Q6_K 版本以确保流畅度。

./build/bin/llama-cli \

-m /home/lzj-jetson/my_ssd/models/unsloth/ERNIE-4.5-21B-A3B-Thinking-GGUF/ERNIE-4.5-21B-A3B-Thinking-Q6_K.gguf \

-ngl 4 \

-c 8192 \

-cnv \

--color

参数详解:

-m: 模型路径。-ngl 4: GPU 层数卸载。- 深度解析:Jetson 是统一内存架构,CPU 和 GPU 共享物理内存。虽然

-ngl 999可以将计算全部交给 GPU,但在 MoE 架构下,有时保留部分层在 CPU 上处理或仅卸载部分层(如4层)可能有助于平衡调度,特别是在显存极度紧张时。不过在通常情况下,建议尝试调高此值以获得更快速度。

- 深度解析:Jetson 是统一内存架构,CPU 和 GPU 共享物理内存。虽然

-c 8192: 上下文窗口大小。Q6_K 版本留有足够内存,可设置较大的上下文。-cnv: 开启连续对话模式。

5.2 场景二:API Server 服务化部署 (使用 Q8_0 版本)

Server 模式用于对外提供 OpenAI 兼容的 API 接口。若追求极致的单次回答质量,可选用 Q8_0 版本。

./build/bin/llama-server \

-m /home/lzj-jetson/my_ssd/models/unsloth/ERNIE-4.5-21B-A3B-Thinking-GGUF/ERNIE-4.5-21B-A3B-Thinking-Q8_0.gguf \

-ngl 4 \

--port 8080 \

--host 0.0.0.0 \

-c 4096

注意事项:

- 上下文限制:由于 Q8_0 占用约 23.2GB 显存,系统开销约 2-3GB,剩余空间有限。务必将

-c(上下文长度) 限制在 4096 左右,否则极易发生 OOM (Out of Memory) 错误导致进程被杀。 - Host 设置:

--host 0.0.0.0允许局域网内其他设备通过 IP 访问。

5.3 验证 API 服务

服务启动后,可使用 curl 进行测试:

curl http://localhost:8080/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "ernie-thinking",

"messages": [

{"role": "user", "content": "如何用 Python 实现快速排序?"}

]

}'

通过以上步骤,您已成功将 Jetson AGX Xavier 打造成了一个具备“深度思考”能力的边缘 AI 工作站。ERNIE-4.5 的 MoE 架构与 Xavier 的硬件特性相结合,为边缘端的复杂逻辑处理提供了全新的可能性。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)