未来Transformer 架构探索:状态空间模型

摘要 状态空间模型(SSM)作为一种新型架构,正在挑战Transformer在AI领域的地位。如Mamba和VisionMamba等模型已证明其在NLP和CV任务中的高效性。SSM采用线性计算复杂度机制,通过状态转移和输出方程处理序列数据,特别适合长文本处理。其关键创新在于利用零阶保持技术将离散信号连续化,并引入专家混合技术优化计算效率。相比Transformer,SSM在保持性能的同时显著降低了

未来Transformer 架构探索:状态空间模型

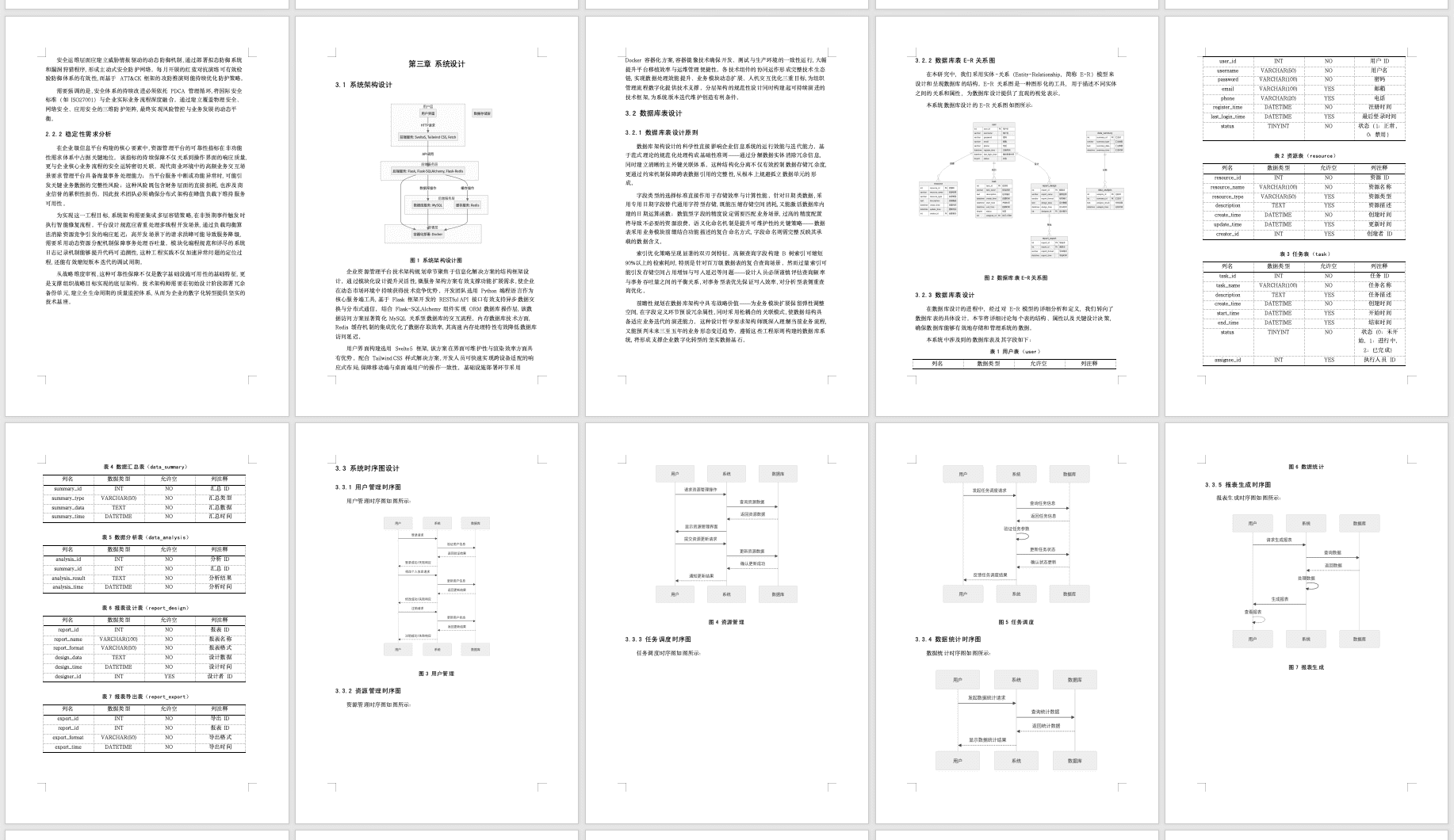

状态空间模型(SSM)是一种新的模型结构,正在成为替代 Transformer 的热门研究方向。像 Mamba 和 Vision Mamba 这样的模型就是典型的状态空间模型,它们在自然语言处理和计算机视觉等任务中取得了很好的效果。

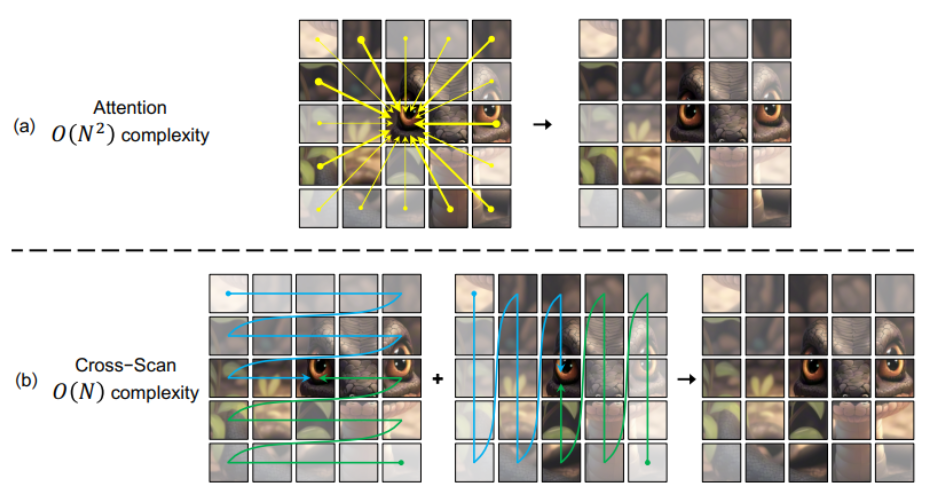

与 Transformer 基于注意力机制不同,状态空间模型在计算和存储方面的复杂度是与输入序列的长度呈线性关系的。也就是说,随着输入序列变长,状态空间模型的效率比 Transformer 更高。这使得状态空间模型在处理长文本时尤其有优势,是当前研究中一个非常值得关注的高效架构。

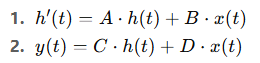

简单来说,状态空间模型的核心思想是:它将一个动态系统的行为分解为两部分:第一部分是描述系统状态随时间变化的方程,第二部分是将系统的状态与输出联系起来的方程。通过这两个方程,模型能够利用当前的状态信息预测未来的状态或输出。

这两个方程可以用下面的数学形式表示:

其中:

- h(t)是系统的状态,表示当前的内部信息。

- x(t) 是输入序列,表示外部输入的信息。

- A 是状态转移矩阵,控制状态如何随时间变化。

- B 是控制矩阵,描述输入对状态的影响。

- C是输出矩阵,描述状态对输出的影响。

- D 是直接影响矩阵,表示输入直接对输出的影响。

这四个矩阵(A, B, C, D)是可学习的参数,模型通过训练来调整这些参数,以更好地预测未来的状态或输出。

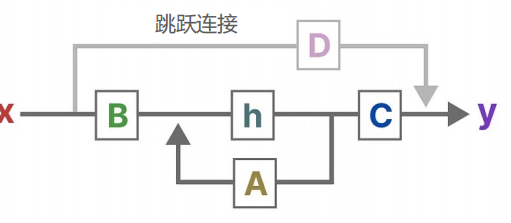

状态空间模型(SSM)的基本工作流程大致如下所示。首先,输入信号 x 会与矩阵 B相乘,得到一个向量,这个向量用来表示输入信号对系统状态的影响。接着,系统状态 h是一个隐藏的向量,包含了系统的核心“知识”,它通过与矩阵 A相乘,描述了不同状态之间的相互关系,体现了系统的动态变化。

在生成最终输出之前,我们需要先根据当前状态和输入信号来更新状态。然后,矩阵 C会将当前的状态映射到输出空间,矩阵 D提供输入信号到输出的直接影响,这通常叫做“跳跃连接”(Skip Connection)。最终,系统会基于这些计算得出输出。

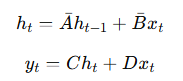

为了使状态空间模型能够处理离散输入信号(比如文本序列),可以采用一种叫做“零阶保持”(Zero-Order Hold, ZOH)的技术。这意味着,每次接收到一个离散信号时,模型会保持这个信号的值,直到下一个新的信号到达。这种方法能够把离散信号转化为连续信号,使得模型能更高效地处理输入。

在这个过程中,还有一个可调的参数叫做“步长”(Δ),它决定了每次信号保持的时间,代表了输入信号的分辨率。通过这种方式,状态空间模型能够在离散输入的基础上生成连续的状态表示。

如果忽略输入信号对输出的直接影响(即忽略矩阵 D),状态空间模型的离散化形式可以表示为:

其中,Aˉ=e^ΔA ,Bˉ 通过跨层连接实现了高效的信息传播,这样做可以保留更精细的隐藏状态信息,提升模型的整体性能,特别是在处理需要复杂表示的任务时效果尤为显著。

此外,一些改进的状态空间模型,如 BlackMamba 和 MoE-Mamba,引入了专家混合(MoE)技术,使模型能够动态地根据任务需求选择激活不同的专家模块。这样不仅优化了计算资源的使用,还在保持高性能的同时显著降低了计算成本。这些改进进一步提升了状态空间模型在处理复杂任务时的能力。

总的来说,状态空间模型(SSM)是一种通过捕捉系统动态行为来进行预测的模型架构。与传统的 Transformer 模型依赖注意力机制不同,SSM 在计算和存储方面具有更高的效率,尤其在处理长文本序列时。SSM 的核心思想是通过两个方程描述系统的状态变化和输出之间的关系:

- 系统的状态通过矩阵 AAA 和输入 xxx 的影响(矩阵 BBB)进行更新。

- 然后,状态 hhh 被映射到输出 yyy 通过矩阵 CCC,并且可以通过矩阵 DDD 添加输入到输出的直接影响。

为了应对离散输入(如文本序列),SSM 采用零阶保持(ZOH)技术,将离散信号转换为连续信号,并通过步长 Δ\DeltaΔ 来调整信号保持的时间,从而优化计算过程。

另外,SSM 也结合了专家混合(MoE)技术,像 BlackMamba 和 MoE-Mamba 就引入了这一技术,使得模型可以灵活选择不同的专家模块进行计算,既提高了性能,又优化了资源使用效率。

总体来说,SSM 在效率和性能上都有显著的提升,特别是在处理长序列或复杂任务时,提供了比 Transformer 更为高效的解决方案。

最近这几年,经济形式下行,IT行业面临经济周期波动与AI产业结构调整的双重压力,很多人都迫于无奈,要么被裁,要么被降薪,苦不堪言。但我想说的是一个行业下行那必然会有上行行业,目前AI大模型的趋势就很不错,大家应该也经常听说大模型,也知道这是趋势,但苦于没有入门的契机,现在他来了,我在本平台找到了一个非常适合新手学习大模型的资源。大家想学习和了解大模型的,可以**点击这里前往查看**

更多推荐

已为社区贡献71条内容

已为社区贡献71条内容

所有评论(0)