给 AI 装上“外挂大脑”:一篇看懂什么是「上下文工程」

如果说「提示词工程」是教你**“怎么说话”(How to ask),那么「上下文工程」就是教你“说话前准备什么资料”**(What to know)。上下文工程,就是通过设计、优化、筛选和重组喂给 AI 的信息环境,让 AI 在有限的注意力内,能够最精准、最高效地解决特定任务的技术。你要让 AI 帮你写一份法律合同。就像你对律师说:“请用专业的语气,参考民法典,帮我写一份合同。”(你在打磨指令)。

给 AI 装上“外挂大脑”:一篇看懂什么是「上下文工程」

你有没有遇到过这种情况:

你兴致勃勃地和 ChatGPT 或 Claude 聊你的工作项目,聊了大概几十个回合,它突然“失忆”了,开始胡说八道,或者完全忘记了你十分钟前刚提到过的一个关键数据?又或者,你把一本 500 页的技术手册丢给它,问它第 300 页的一个细节,它却自信满满地给出了错误的答案?

这并不是因为 AI 变笨了,而是因为我们喂给它的“上下文(Context)”出了问题。

在 AI 圈子里,过去两年大家都在卷**「提示词工程(Prompt Engineering)」(即如何更巧妙地向 AI 提问)。但现在,随着大模型能力的进化,一个新的、更硬核的概念正在崛起,它被称为「上下文工程(Context Engineering)」**。

如果不理解它,你就无法真正发挥 AI 的潜力;理解了它,你就相当于给 AI 装上了一个过目不忘的“外挂大脑”。

这篇文章约 3000 字,将带你从零开始,彻底搞懂这个决定 AI 未来表现的核心技术。

第一部分:AI 的“短时记忆”危机

要理解“上下文工程”,首先得理解 AI 是怎么“思考”的。

1. AI 其实是“金鱼记忆”

很多人以为 AI 像人类一样,有一个连续的记忆。其实不然。对于大语言模型来说,每一次你点击“发送”,它都是一次全新的生命。

它不记得你是谁,不记得上一句聊了什么。之所以它现在能跟你连续对话,是因为系统在后台做了一个动作:把你之前所有的聊天记录(即“上下文”),打包成一大段文字,连同你最新的问题,一次性重新塞给 AI。

AI 每次都在阅读完整的“聊天历史剧本”,然后续写下一句台词。

2. 昂贵的“窗口费”

既然是把历史记录打包发过去,那把这辈子的书都打包进去不行吗?

不行。这就涉及到一个核心概念:上下文窗口(Context Window)。

你可以把 AI 想象成一个正在考试的学生,而“上下文窗口”就是他的课桌。

- 早期的 AI(如 GPT-3): 课桌非常小,只能放两张 A4 纸(约 4k tokens)。一旦资料超过这个量,旧的纸就会被挤掉,AI 就“失忆”了。

- 现在的 AI(如 GPT-4, Claude 3, Gemini 1.5): 课桌变得巨大无比,甚至可以放下一整个图书馆(100万 - 200万 tokens)。

但是,课桌变大带来了两个新问题:

- 贵: 每次都要把图书馆的书搬来搬去,算力成本极高。

- 注意力涣散: 就像人类一样,资料太多,找关键信息反而变慢了,甚至会产生幻觉,漏掉重要细节(这在技术上被称为“大海捞针”问题)。

这时候,**「上下文工程」**就登场了。

第二部分:什么是上下文工程?

如果说「提示词工程」是教你**“怎么说话”(How to ask),那么「上下文工程」就是教你“说话前准备什么资料”**(What to know)。

定义:

上下文工程,就是通过设计、优化、筛选和重组喂给 AI 的信息环境,让 AI 在有限的注意力内,能够最精准、最高效地解决特定任务的技术。

打个比方:

你要让 AI 帮你写一份法律合同。

- 提示词工程: 就像你对律师说:“请用专业的语气,参考民法典,帮我写一份合同。”(你在打磨指令)。

- 上下文工程: 就像你在见律师之前,整理好了双方的背景调查、过往的类似案例、相关的法律条文,并且把重点用红笔圈出来,整整齐齐地放在律师面前。(你在构建环境)。

在大模型时代,“给什么资料”往往比“怎么问”更重要。

第三部分:上下文工程的三大核心魔法

那么,工程师们具体是如何做“上下文工程”的呢?虽然技术细节很复杂,但原理其实就是三步走:清洗、结构化、增强。

魔法一:信息清洗(给课桌大扫除)

这是最基础的一步。虽然现在的模型能读 100 万字,但如果你塞进去 90% 都是废话,AI 的表现一定会下降。

“垃圾进,垃圾出(Garbage In, Garbage Out)” 是永恒的真理。

- 去噪: 比如你要 AI 分析网页内容,上下文工程会自动把网页里的广告、导航栏、版权声明这些“噪音”切掉,只保留正文。

- 压缩: 对于冗长的对话历史,技术上会进行“摘要”。比如你们聊了 50 句废话,系统会将其压缩成一句:“用户之前询问了关于 Python 的安装问题,并解决了报错。” 这样既保留了记忆,又节省了空间。

小白启示: 当你发给 AI 一长串文档时,试着自己先删减掉无关的段落,你会发现 AI 变聪明了。

魔法二:结构化数据(说 AI 听得懂的方言)

人类喜欢看散文,但 AI 更喜欢看“结构”。

如果你给 AI 一堆乱七八糟的会议记录,它可能会晕。但如果你通过上下文工程,把这些信息转换成 JSON(一种程序员常用的数据格式)或者 Markdown 表格,AI 的理解能力会直线飙升。

案例对比:

- 差的上下文: “张三说我们要快点做,李四反对,说预算不够,王五觉得可以折中……”(AI 需要费力去猜谁支持谁)。

- 好的上下文(结构化后):

| 发言人 | 立场 | 核心观点 | | :--- | :--- | :--- | | 张三 | 支持 | 强调速度 | | 李四 | 反对 | 强调预算限制 | | 王五 | 中立 | 建议折中方案 |

小白启示: 在投喂长资料时,尽量用 1. 2. 3. 列表、小标题、粗体字来整理内容。你整理得越清晰,AI 的“注意力机制”就越容易锁定重点。

魔法三:RAG(检索增强生成)——真正的外挂

这是上下文工程中最核武器级别的技术:RAG (Retrieval-Augmented Generation)。

即使是 200 万窗口,也装不下整个企业的数据库。如果我要 AI 回答关于公司 10 年前的一个小项目的细节,怎么办?

RAG 的原理就像是**“开卷考试”**。

- 不强记: 我们不要求 AI 记住公司所有的文档。

- 建索引: 我们把公司文档切碎,存进一个叫**“向量数据库(Vector Database)”**的地方。你可以把它理解为一个超级智能的图书馆索引系统。

- 检索(Retrieval): 当你问:“那个项目当时谁负责?”系统不会直接把问题丢给 AI。系统会先去“向量数据库”里搜,找到最相关的 3 段文档。

- 增强(Augmented): 系统把这 3 段文档 + 你的问题,打包成一个新的上下文,喂给 AI。

- 生成(Generation): AI 看着这 3 段文档,回答了你的问题。

上下文工程的核心挑战就在这里: 如何精准地找到那“3段文档”?找错了(比如找成了同名的另一个项目),AI 就会一本正经地胡说八道。因此,优化检索策略,是上下文工程的重中之重。

第四部分:为什么“长窗口”不能取代“上下文工程”?

你可能会问:“Google 的 Gemini 1.5 都能一次读懂几百万字了,未来甚至无限长,还需要搞这些复杂的工程吗?直接把所有资料丢进去不就行了?”

答案是:依然需要,而且更需要。

这里有两个反直觉的现象:

1. “大海捞针”效应 (Lost in the Middle)

科学家发现,当上下文特别长(比如几百页书)时,AI 往往能记住开头,也能记住结尾,但特别容易忽略中间的信息。

就像你突击复习考试,开头很认真,结尾快背完了也很兴奋,但中间那部分最容易走神。

优秀的上下文工程,会利用一种叫**“重排序(Reranking)”**的技术。不管资料多长,它会先把最可能包含答案的那段话,通过算法找出来,强行移动到上下文的“开头”或“结尾”黄金位置,确保 AI 一定能看到。

2. “注意力稀释”

给的信息越多,噪音就越多。

如果你问:“苹果怎么吃?”

- 背景资料 A:水果百科全书(含苹果)。

- 背景资料 B:包含乔布斯传记、苹果公司财报、牛顿的故事、水果百科全书。

如果你把资料 B 全部塞进去,AI 很有可能因为看到太多“苹果公司”的信息,而开始跟你聊 iPhone,而不是聊怎么削皮。

上下文工程的精髓,不仅在于“给信息”,更在于“克制地给信息”。 只提供最精准的上下文,才能得到最精准的回答。

第五部分:实战场景——这东西能怎么用?

为了让你更有体感,我们来看看上下文工程在现实中是怎么把 AI 变成神器的。

场景一:拥有“无限记忆”的私人管家

- 以前: 你告诉 AI 你对花生过敏。过了一个月,你问它推荐菜谱,它给你推荐了宫保鸡丁(含花生)。

- 有了上下文工程: 系统会把你“花生过敏”这条信息,写入到一个长期的**“用户画像存储库”**里。哪怕过了一年,只要你问关于吃的东西,系统就会自动把“用户花生过敏”这条上下文,悄悄插入到你的提示词里。AI 就会说:“推荐您吃鱼香肉丝(已为您避开花生)。”

场景二:全知全能的编程助手

- 以前: 你把一段代码发给 AI 找 Bug。AI 说代码没问题。但其实 Bug 是因为这段代码调用的另一个文件里的函数变了。AI 看不到那个文件。

- 有了上下文工程: 像 Cursor 或 GitHub Copilot 这样的工具,会自动扫描你整个项目文件夹。当你写代码时,它会自动把你当前光标引用的其他文件代码,作为上下文喂给模型。它“看”到了全局,自然能解出 Bug。

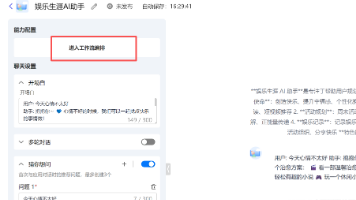

场景三:角色扮演与小说创作

- 以前: 聊久了,AI 扮演的“林黛玉”说话越来越像个现代人,OOC(角色崩坏)严重。

- 有了上下文工程: 我们可以构建一个**“世界观维持系统”**。每次对话前,强制在上下文最前端插入一段:“你现在是林黛玉,你需要用红楼梦的语言风格,你的性格是多愁善感……” 并且,如果涉及到之前的剧情,系统会自动检索之前的剧情摘要塞进去。这样,林黛玉就永远不会变成 AI 客服。

第六部分:未来的趋势——上下文即模型

最后,我们展望一下未来。

目前的 AI 开发模式是:模型 + 上下文 = 应用。

模型是通用的(像一个刚毕业的高材生),而上下文是专用的(像公司的内部资料)。

上下文工程的终极形态,可能是“缓存(Caching)”。

最近,Anthropic(Claude 的开发商)和 Google 都推出了**“Prompt Caching(提示词缓存)”**技术。

这意味着,你可以把一整本 500 页的《操作手册》或者几万行的代码库,一次性传给 AI,然后**“冻结”**在它的短期记忆里。

下一次你再提问,不需要重新上传这 500 页书(既省钱又快),AI 直接基于这个冻结的记忆回答。

这让“上下文”变得像“模型权重”一样重要。未来,你可能不需要训练一个专属模型,你只需要精心设计一套超级完美的“上下文包”,加载进去,通用的 AI 瞬间就变成了你的行业专家。

总结:给你的建议

读完这篇文章,作为普通用户或开发者,你可以带走以下几个行动点:

- 不要迷信“一次发完”: 如果你的任务很复杂,资料很长,不要一股脑丢给 AI。试着分段,或者先让 AI 总结前面的内容。

- 像整理衣柜一样整理信息: 发给 AI 的东西,越有条理(用 Markdown,用表格,用分类),AI 越聪明。

- 不仅要学 Prompt,更要学 Context: 当你觉得 AI 回答不好时,先别急着改提问方式,检查一下:“我是不是漏给了它什么关键背景?” 或者 “我是不是给了它太多干扰信息?”

上下文工程,本质上就是一种“沟通的艺术”。

在这个人机共生的时代,谁能构建出最清晰、最精准的信息环境,谁就能驾驭最强大的智能。

下一步行动建议:

下次当你需要 AI 处理一个长文档或复杂任务时,试着先写一个“背景卡片”(包含:你是谁、任务背景、核心限制、参考数据),把这个卡片作为第一条消息发给 AI,看看效果是否比直接提问好得多。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)