RAG从入门到精通(一)——什么是RAG?

1. 什么是RAG

RAG(Retrieval-Augmented Generation)是 “检索辅助生成” 的特定技术框架,核心满足 3 个条件:

- 核心目标:提升大模型生成内容的准确性、时效性、可追溯性。

- 核心流程:先从外部知识库(文档、数据库等)检索与用户需求相关的信息,再将 “检索结果 + 用户需求” 一起输入大模型。

- 核心关系:检索是手段,生成是目的,检索为生成提供外部知识支撑(

解决大模型知识过期、幻觉问题)。

RAG(Retrieval-Augmented Generation,检索增强生成)是一种结合「检索」与「生成」的AI技术,核心是让大模型在生成答案前,先从外部知识库中检索相关信息,再基于检索结果和自身知识生成回复。

1.1 核心原理

- 检索阶段:用户提问后,系统先从预设的外部知识库(如文档、数据库、网页等)中,快速筛选出与问题高度相关的片段。

- 增强生成阶段:将检索到的相关信息作为「参考资料」,与用户问题一起输入大模型,让模型结合参考资料和自身训练知识,生成准确、有依据的答案。

1.2 核心价值

- 解决大模型「知识过期」问题:无需重新训练模型,只需更新外部知识库,就能让模型掌握最新信息(如2025年的新政策、行业动态)。

- 提升答案「准确性」和「可追溯性」:答案基于明确的参考资料生成,减少模型幻觉(虚构信息),且可标注答案来源。

- 降低「训练成本」:相比微调大模型,更新知识库的成本更低、效率更高,适合中小团队或高频更新知识的场景(如企业内部文档、产品手册)。

1.3 典型应用场景

- 企业知识库问答:员工查询内部制度、技术文档、产品说明(如“公司报销流程是什么?”)。

- 智能客服:基于最新的产品信息、售后政策,解答用户咨询(如“某型号产品的保修期限是多久?”)。

- 专业领域问答:结合行业文献、法规条文,生成专业回复(如法律条文解读、医疗常识查询)。

- 个人知识管理:整合个人笔记、学习资料,快速检索并生成总结(如“这个知识点的核心内容是什么?”)。

1.4 关键组成部分

- 外部知识库:存储待检索的原始信息(支持文档、表格、PDF、网页等多种格式)。

- 检索引擎:负责快速匹配用户问题与知识库内容(常用技术如向量检索、关键词检索)。

- 大模型:基于检索结果生成自然语言回复(如GPT、LLaMA、文心一言等)。

- 数据处理模块:将原始知识库内容转化为适合检索的格式(如拆分文档片段、生成向量嵌入)。

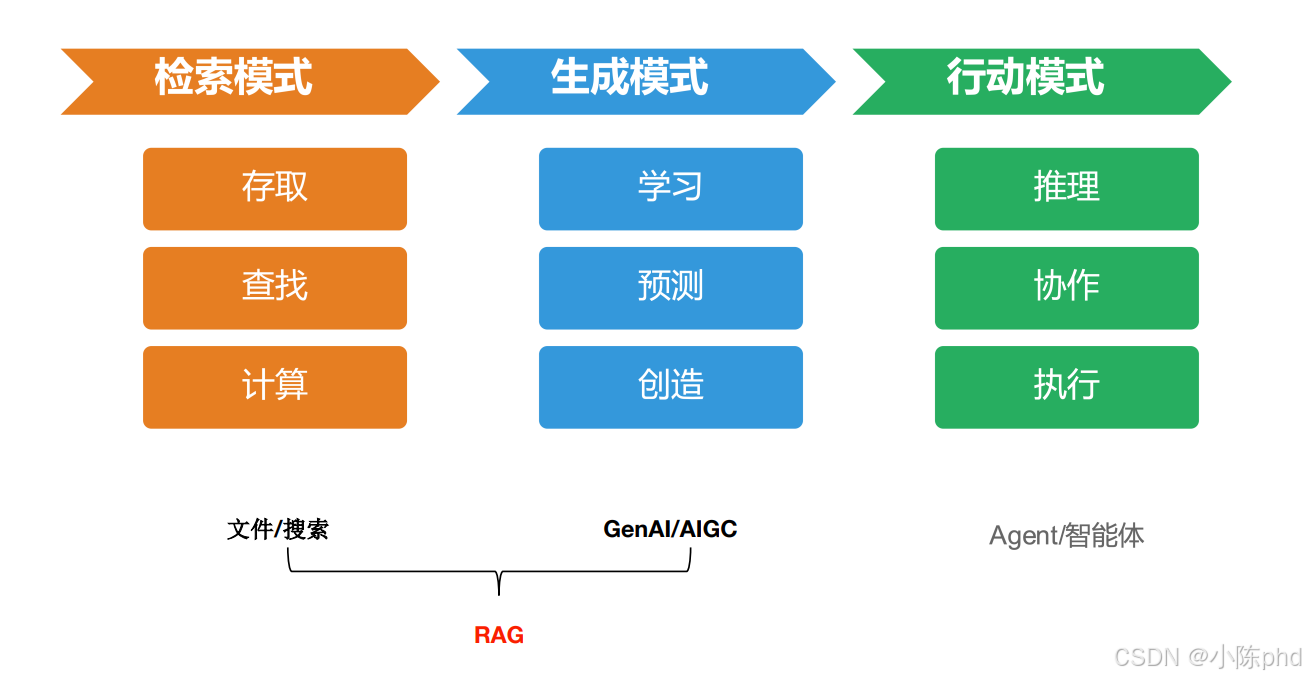

这张图对AI技术能力分层与关联的可视化解释,核心是清晰区分三类技术模式,并点明RAG的组成逻辑:

-

检索模式(橙色模块)

对应“文件/搜索”领域,聚焦信息的存取、查找和计算,典型场景包括:- 存取:管理文件、数据库的存储与读取(如云盘文件管理、数据库CRUD操作);

- 查找:通过关键词、向量等方式检索信息(如搜索引擎、企业知识库查询);

- 计算:基于检索结果做统计、分析(如从数据库拉取数据后做报表计算)。

-

生成模式(蓝色模块)

对应“GenAI/AIGC(生成式AI/人工智能生成内容)”领域,聚焦学习、预测和创造,典型场景包括:- 学习:基于数据训练模型(如训练大模型理解语言规则);

- 预测:基于已有模式生成内容(如AI写邮件、预测用户行为);

- 创造:生成全新的、有创意的内容(如AI绘画、写小说)。

-

行动模式(绿色模块)

对应“Agent/智能体”领域,聚焦推理、协作和执行,典型场景包括:- 推理:基于信息做逻辑判断(如AI分析财务数据后给出决策建议);

- 协作:多智能体分工完成任务(如多个AI工具协同处理复杂项目);

- 执行:直接操作外部系统(如AI自动发送邮件、控制物联网设备)。

-

RAG的定位(底部关联)

图中用“文件/搜索 + GenAI/AIGC”的组合标注了RAG(检索增强生成),意思是:

RAG是检索模式和生成模式的结合——先通过“检索模式”从外部知识库(文件、搜索结果等)获取信息,再通过“生成模式”的大模型,结合这些信息生成精准、有依据的内容(如基于企业文档生成问答、基于行业报告生成分析)。

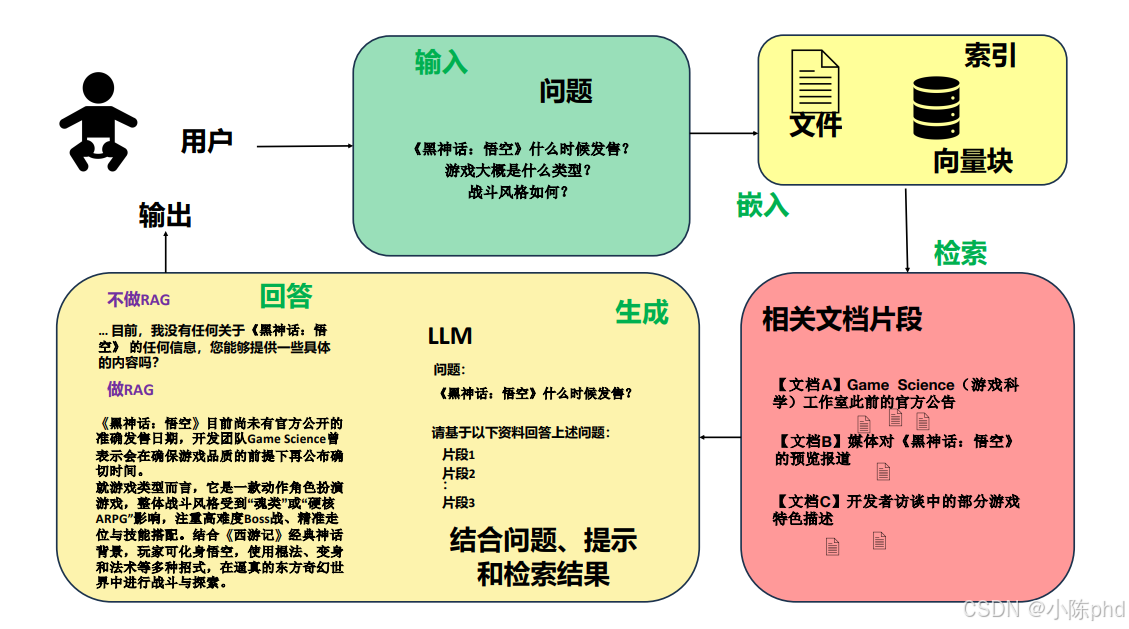

这张图以《黑神话:悟空》为例,直观呈现了RAG的完整流程:

- 用户先提出关于游戏发售时间、类型、战斗风格的问题;

- 系统随即从存储着官方公告、媒体报道等文档向量块的知识库中,检索出相关文档片段;

- 之后大模型结合这些检索结果与问题生成回答。

对比“不做RAG”时大模型因缺乏信息而无法回答的情况,RAG通过“检索外部知识+大模型生成”的组合,解决了大模型知识过期、易产生幻觉的问题,让AI的回答从模糊空白变得精准且有依据,本质是为大模型加装了“外置知识库”,复刻了人类“查资料再创作”的逻辑。

换个视角看:

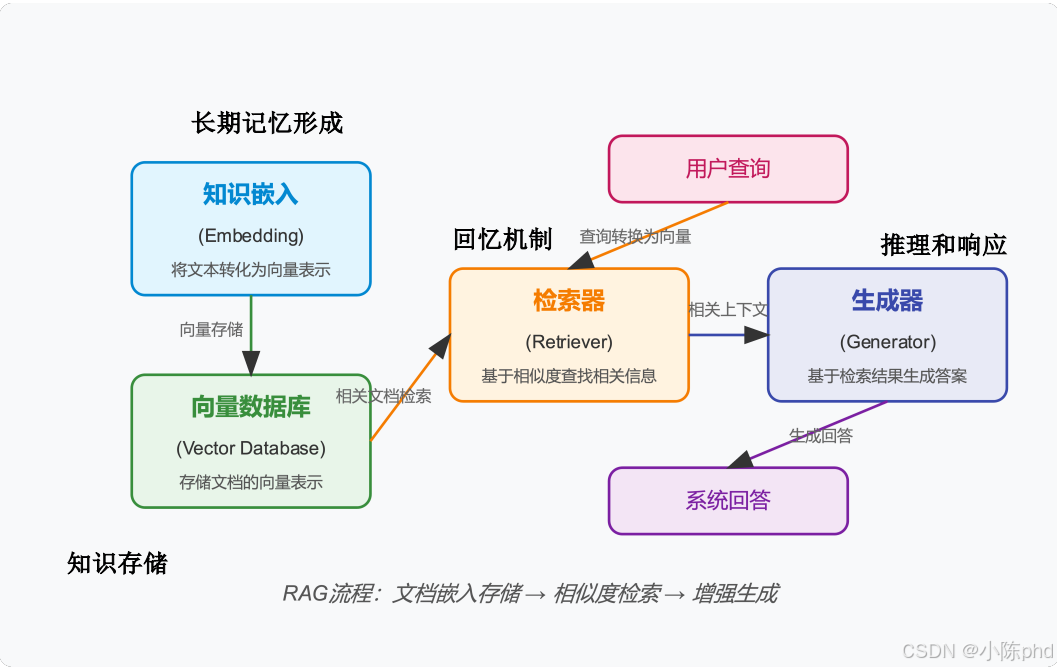

这张图从知识存储、回忆机制、推理响应三个维度,拆解了 RAG 的技术实现流程:

- 知识存储(长期记忆形成):通过 “知识嵌入” 环节将文本转化为向量表示,再把这些向量存储到 “向量数据库” 中,完成外部知识的长期留存,类似人类把信息存入长期记忆。

- 回忆机制(检索环节):当有用户查询时,先把查询转化为向量,然后由 “检索器” 基于相似度从向量数据库中查找相关文档片段,这一步就像人类根据问题从记忆里调取相关信息。

- 推理和响应(生成环节):“生成器” 会结合检索到的相关上下文,生成最终的系统回答,相当于人类基于调取的记忆进行思考并输出结论。

整个 RAG 流程可总结为“文档嵌入存储→相似度检索→增强生成”,通过这样的技术链路,让大模型能高效利用外部知识,输出准确且有依据的回答。

RAG流程:

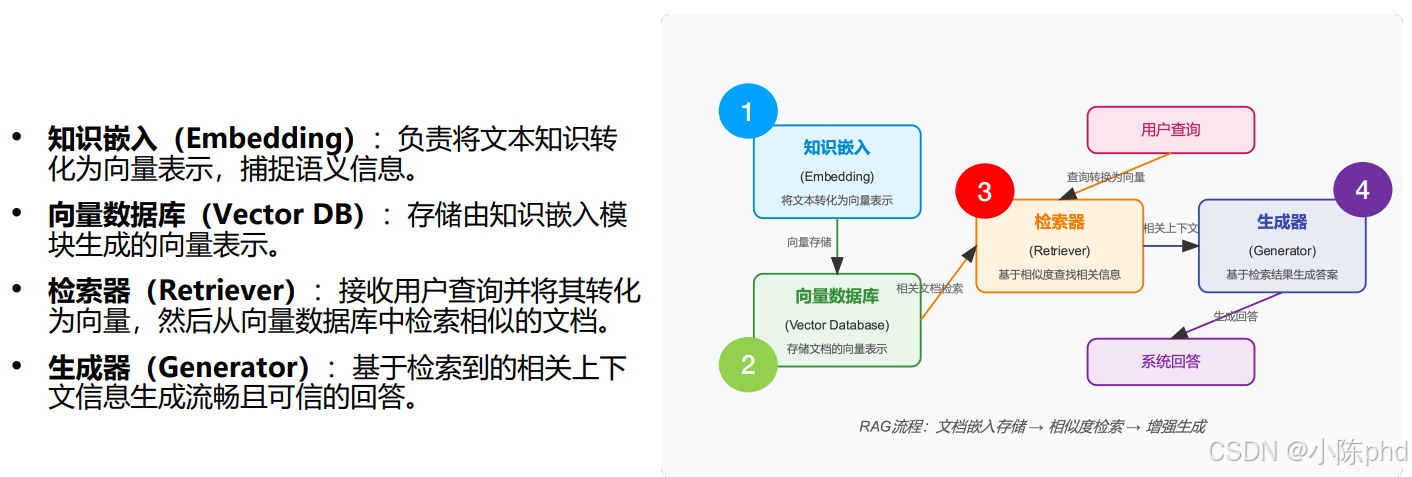

这张图和文字结合,从模块分工和流程步骤两方面,:

先看左侧的模块说明:

- 知识嵌入(Embedding):把文本知识变成向量,捕捉语义信息,比如“《黑神话:悟空》发售时间”会被转化成计算机能理解的向量形式。

- 向量数据库(Vector DB):专门存这些向量,相当于一个“语义级”的知识库,比如把所有游戏相关的文档向量都存在这里。

- 检索器(Retriever):用户问“游戏类型是什么”时,它先把这个问题转成向量,再去向量数据库里找最相似的文档片段,比如从媒体报道、开发者访谈的向量中匹配相关内容。

- 生成器(Generator):拿到检索到的文档片段后,就像人类结合资料写回答一样,生成流畅又准确的系统回答,比如说明游戏是动作角色扮演类型。

再看右侧的流程步骤(标了1-4):

- 先通过知识嵌入把文档转成向量,存到向量数据库(知识存储阶段);

- 用户发起查询后,检索器把查询转成向量,从向量数据库里找相似文档(回忆机制);

- 生成器结合这些文档生成回答(推理响应);

- 最终输出系统回答。

整个流程就是“文档嵌入存储→相似度检索→增强生成”,每个模块各司其职,让RAG能高效地把外部知识和大模型生成能力结合起来,解决大模型知识过期、回答没依据的问题。

2. RAG核心步骤

2.1 索引

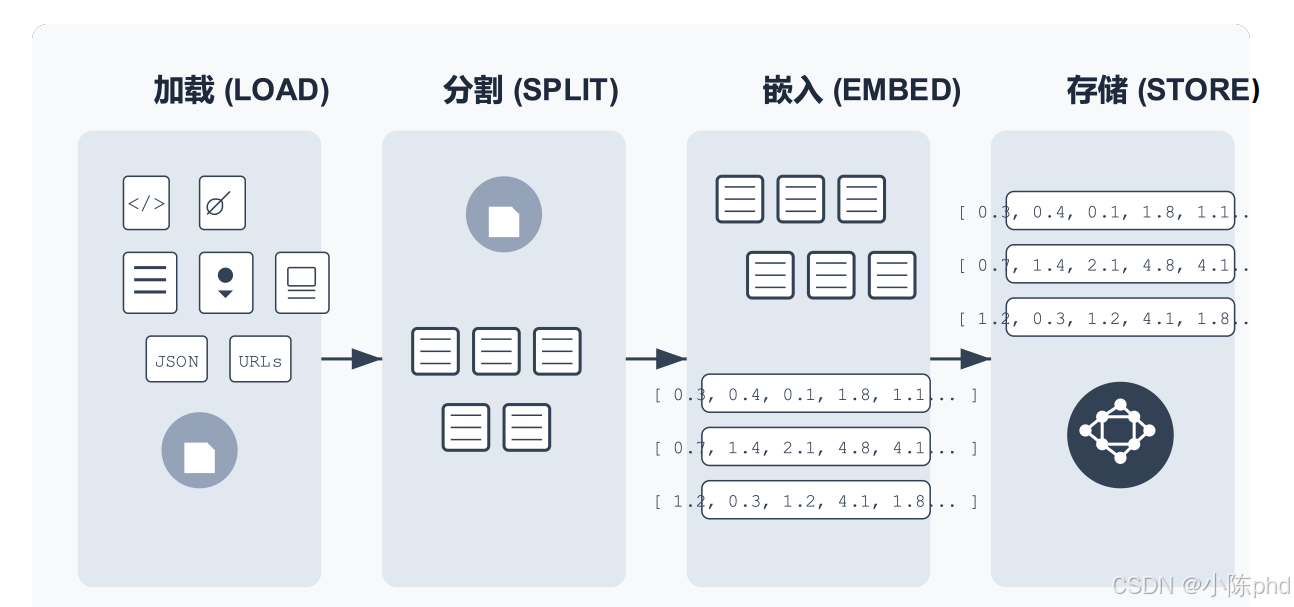

这张图展示RAG中索引构建的完整流程,也就是把外部知识转化为可检索的“向量索引”的过程,分为四个核心环节:

-

加载(LOAD):导入各类知识源

先把要检索的知识导入系统,支持的类型很丰富,比如代码(<//>)、文档(文件图标)、文本(列表图标)、JSON数据、网页URL等,相当于把分散的知识“收集”起来。 -

分割(SPLIT):把知识拆成小段

因为大段文本不利于精准检索,所以要把导入的知识分割成一个个小片段(比如按段落、按语义单元拆分),就像把一本书拆成章节和小节,方便后续处理。 -

嵌入(EMBED):把文本变成向量

这一步是“索引”的核心技术环节——用嵌入模型(Embedding Model)把每个文本片段转化为向量(一组数字)。这些向量能捕捉文本的语义信息,比如“游戏发售时间”和“上线日期”虽然文字不同,但语义相似,它们的向量也会很接近。 -

存储(STORE):把向量存到数据库

最后把这些向量存储到向量数据库中(图中带节点的图标),形成“向量索引”。当用户提问时,系统会把问题也转成向量,然后在这个数据库里快速找到语义最相似的向量对应的文本片段,实现精准检索。

简单来说,RAG的“索引”就是通过“加载→分割→嵌入→存储”这一系列操作,把人类能理解的文本知识,转化为计算机能快速检索的“向量知识库”,为后续的“检索增强生成”打好基础。

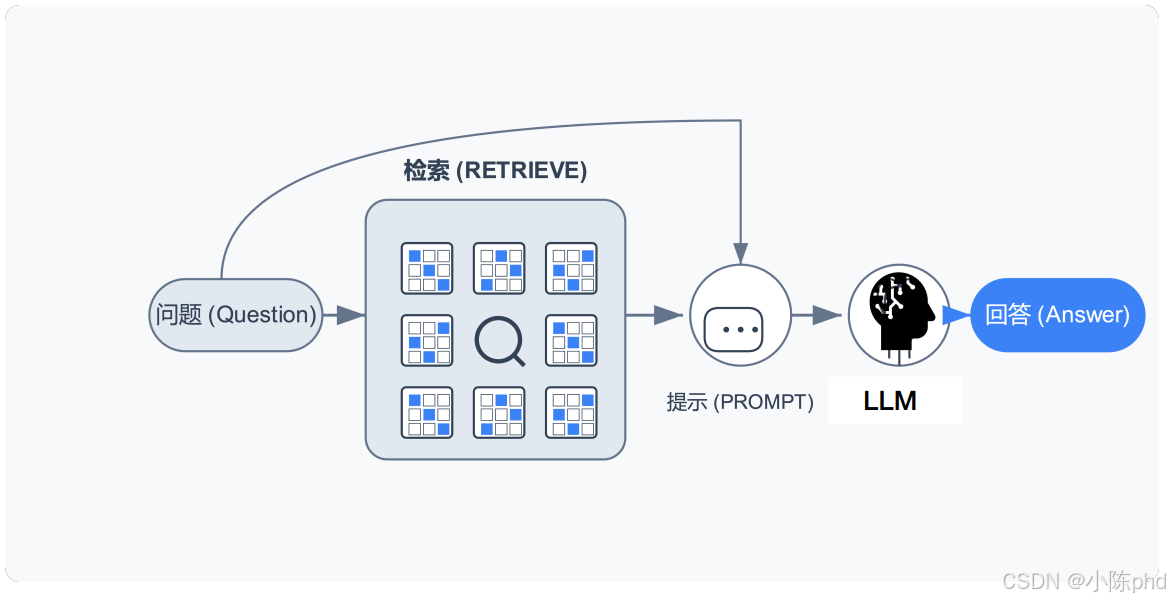

2.2 检索和生成

用户提出问题后,先进入检索(RETRIEVE)环节——从存储的知识片段(图中网格块)里,基于语义相似度找到与问题相关的内容。接着,这些检索结果会和问题一起组成提示(PROMPT),输入给大模型(LLM)。最后,大模型基于提示生成回答(Answer)。这张图揭示 RAG“检索外部知识增强生成”的本质:通过检索环节为大模型补充精准的外部信息,让生成的回答更准确、有依据,解决了大模型知识过期或幻觉的问题。

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)