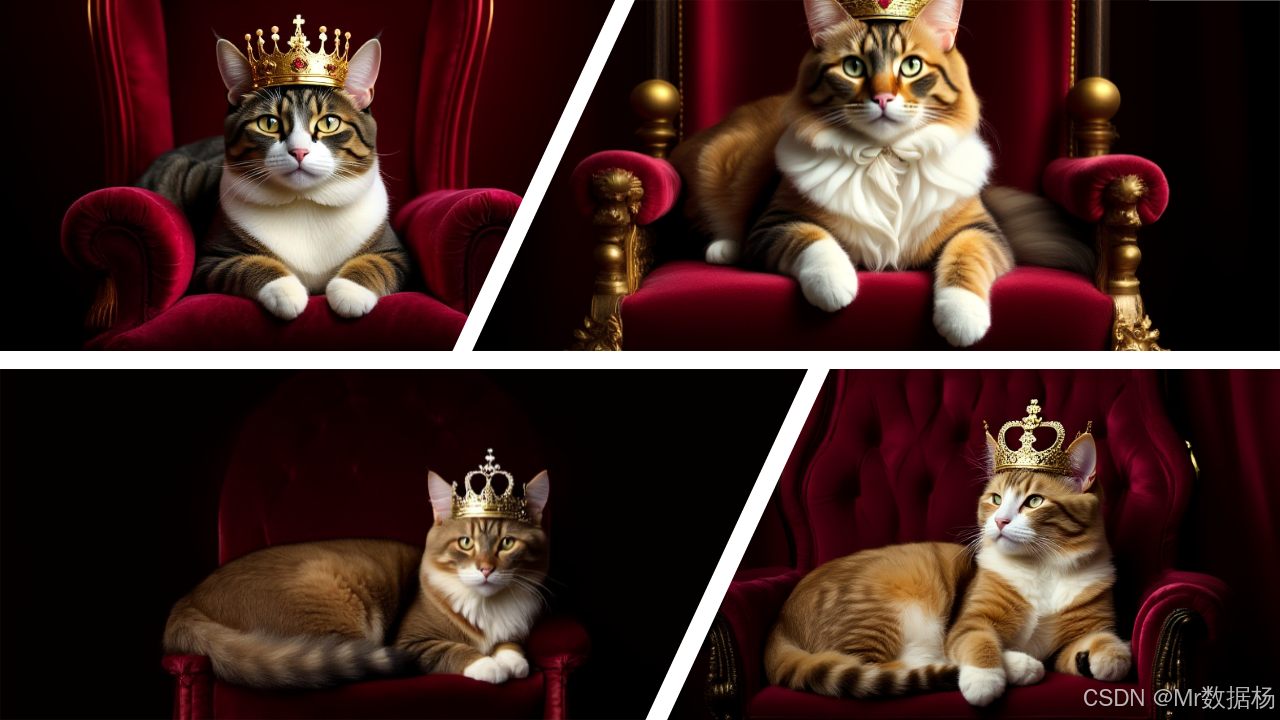

【ComfyUI】OmniGen2 文生图依托统一7B多模态架构生成高质量图像

本文介绍了一个基于Omnigen2模型的ComfyUI工作流,展示了从文本到图像的完整生成过程。工作流通过预训练模型、噪声采样和提示词引导,实现高质量图像生成。核心包含UNet扩散模型、CLIP文本编码器和VAE解码器的协作,支持艺术创作、角色设计等应用场景。文章详细解析了工作流节点组成、执行流程和实际应用价值,并提供了相关开发资源链接。该方案突出文本理解的精准性和图像风格的可控性,为AI绘画提供

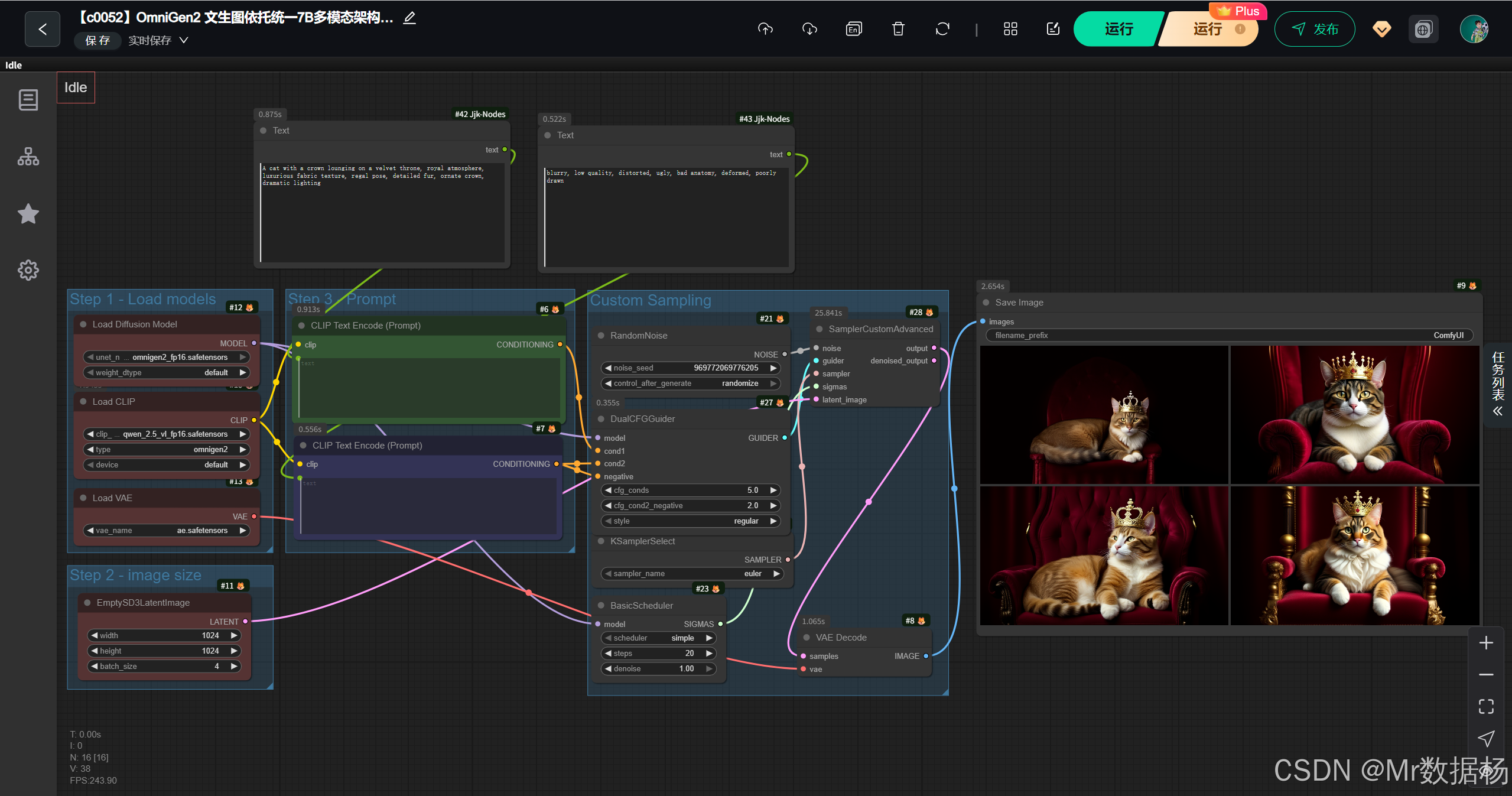

今天展示的案例是一个基于 Omnigen2 的 ComfyUI 工作流。整个流程通过加载预训练模型、输入正负提示词、结合噪声与采样策略,生成高清图像,并最终保存输出。

该工作流核心突出的是对文本提示的精准理解与图像风格的可控性,读者能够直观感受到从文本到图像的转化过程,以及不同节点之间的协作如何保证画面质量。

文章目录

工作流介绍

这个工作流采用了 UNet 主模型、CLIP 文本编码器以及 VAE 解码器 的协作方式,将提示词经过编码转化为条件输入,再结合噪声与调度器完成扩散采样,生成符合描述的高质量图像。核心模型不仅提供了稳定的扩散生成能力,也保证了语义理解的准确性。

核心模型

在模型部分,Omnigen2 作为主要扩散模型,配合 qwen_2.5_vl_fp16 文本编码器和 ae VAE 解码器,实现了文本语义解析、潜空间计算与最终图像解码的完整链路。表格展示了核心模型的组成与作用。

| 模型名称 | 说明 |

|---|---|

| omnigen2_fp16.safetensors | 核心扩散模型,负责潜空间的逐步采样与图像生成 |

| qwen_2.5_vl_fp16.safetensors | 文本编码器,将提示词与负面提示转化为条件向量 |

| ae.safetensors | VAE 模型,用于潜空间图像的解码与高质量画面还原 |

Node节点

节点部分涵盖了噪声生成、采样器选择、CFG 引导器、调度器以及保存图像等关键环节。RandomNoise 与 KSamplerSelect 提供初始随机输入,DualCFGGuider 结合正负提示增强引导效果,SamplerCustomAdvanced 执行采样生成,最终由 VAEDecode 将潜变量解码为图像并通过 SaveImage 节点保存。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载扩散模型 Omnigen2,作为核心图像生成模块 |

| CLIPLoader | 加载文本编码器,处理正负提示词 |

| CLIPTextEncode | 将输入提示与负面提示转化为条件信息 |

| RandomNoise | 生成随机噪声,作为扩散起始点 |

| KSamplerSelect | 选择采样算法(如 Euler) |

| DualCFGGuider | 应用条件引导与负面约束,提升生成效果 |

| BasicScheduler | 提供扩散过程中的调度与步数控制 |

| SamplerCustomAdvanced | 执行采样推理,生成潜变量图像 |

| VAEDecode | 将潜变量解码为真实图像 |

| SaveImage | 输出最终生成的图像文件 |

工作流程

整个工作流以“加载模型—生成潜变量—扩散采样—解码输出”为主线展开。UNet 与 CLIP 模块共同提供了模型和语义支撑,RandomNoise 与 KSamplerSelect 决定了扩散的随机起点与采样方式,DualCFGGuider 在正负提示的双重约束下调节引导强度,BasicScheduler 控制扩散的迭代步数,最终由 SamplerCustomAdvanced 将所有条件组合完成潜变量生成,再通过 VAE 解码成真实图像并保存。这一流程保证了文本到图像的可控性和画面质量。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载 | 加载核心扩散模型、VAE 与文本编码器,为后续生成提供基础 | UNETLoader, VAELoader, CLIPLoader |

| 2 | 提示词处理 | 将正面描述与负面约束转化为语义条件向量 | CLIPTextEncode |

| 3 | 随机噪声生成 | 初始化潜空间的随机输入,为扩散过程提供起点 | RandomNoise |

| 4 | 采样与调度 | 选择采样算法并设定扩散步数,形成稳定的迭代路径 | KSamplerSelect, BasicScheduler |

| 5 | 条件引导 | 应用 CFG 策略,结合正负提示对采样过程进行约束 | DualCFGGuider |

| 6 | 潜变量生成 | 执行高级采样器推理,输出潜变量图像结果 | SamplerCustomAdvanced |

| 7 | 图像解码与保存 | 将潜变量解码为高清图像并保存到本地 | VAEDecode, SaveImage |

大模型应用

CLIPTextEncode 文本语义嵌入生成

在 OmniGen2 文生图工作流中,CLIPTextEncode 节点负责将用户提供的正向 Prompt 转化为 CLIP 嵌入,用于指导生成模型在统一 7B 多模态架构下生成高质量图像。Prompt 的精细化描述直接影响图像的角色、场景、动作、光影和细节表现,是实现高精度图像生成的核心节点。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode (Positive Prompt) | A cat with a crown lounging on a velvet throne, royal atmosphere, luxurious fabric texture, regal pose, detailed fur, ornate crown, dramatic lighting | 将正向 Prompt 转化为 CLIP 嵌入,用于控制 OmniGen2 模型的图像生成语义,实现角色、场景、细节和光影的高精度呈现。 |

CLIPTextEncode (Negative Prompt) 负向语义控制

该节点生成负向嵌入,用于抑制生成图像中不希望出现的元素或风格,保证生成图像干净、自然、细节准确。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode (Negative Prompt) | blurry, low quality, distorted, ugly, bad anatomy, deformed, poorly drawn | 将负向 Prompt 转化为 CLIP 嵌入,用于抑制不希望出现的视觉元素或低质量细节,提升图像生成精度与一致性。 |

使用方法

OmniGen2 工作流结合多模态 CLIP 嵌入、潜在空间采样和 VAE 解码,实现高精度图像生成。用户提供正向 Prompt,CLIPTextEncode 转化为条件嵌入,负向 Prompt 生成负向嵌入用于抑制不需要的元素。UNETLoader 加载核心扩散模型,KSamplerSelect 和 SamplerCustomAdvanced 控制潜变量采样,BasicScheduler 提供时间步 SIGMAS,EmptySD3LatentImage 生成潜在起始图像,VAELoader 与 VAEDecode 将潜在图像解码为最终图像,SaveImage 输出。用户可通过修改 Prompt 或 CFG 值控制图像内容和风格,实现统一 7B 多模态架构下的高质量图像生成。

| 注意点 | 说明 |

|---|---|

| Prompt 描述精细 | 确保角色、场景、动作和光影符合预期 |

| 使用负向 Prompt | 避免生成低质量或不符合语义的元素 |

| 潜变量尺寸与输出匹配 | 保证 VAEDecode 解码后图像比例正确 |

| 采样器与步数合理 | 调整 KSamplerSelect 和 SamplerCustomAdvanced 参数平衡速度与质量 |

| 模型量化与精度 | OmniGen2 FP16 模型节省显存,同时保持高细节质量 |

应用场景

该工作流适用于需要高质量定制图像生成的场景,例如艺术创作、角色设计、广告视觉素材制作等。通过正负提示的组合,可以有效控制画面风格与细节,避免低质量或畸形的输出。在实际使用中,艺术设计师能够快速探索不同风格的构图,游戏或影视制作人员可以生成概念原画,普通用户也能在创作中体验可控的 AI 绘画过程。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 艺术创作 | 生成符合描述的原创作品 | 插画师、设计师 | 高分辨率艺术插画 | 风格可控、画面细节丰富 |

| 角色设计 | 构建人物或场景的原型图像 | 游戏美术、影视团队 | 人物造型与场景概念图 | 提供创意灵感与参考 |

| 广告与宣传 | 制作符合需求的宣传图或海报元素 | 广告公司、品牌方 | 宣传海报、广告素材 | 高效产出定制化视觉内容 |

| 娱乐体验 | 体验 AI 绘画与生成乐趣 | 普通用户 | 趣味化的创意图像 | 满足个性化审美与分享需求 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)