从0到1做AI+全栈测试开发:2025 年我踩过的坑、总结的实战技巧全都在这

《AI+全栈测试开发的转型实践与展望》文章摘要:本文分享了从传统测试转型AI+全栈测试开发的实战经验。首先剖析了AI测试的三大认知陷阱,包括算法精通误区、数据准备挑战和基准建立难题;其次详细介绍了构建一体化质量保障体系的方法,涵盖前端智能测试、API数据工厂和基础设施验证;然后提出自动化框架设计的四层架构与智能调度方案;最后给出技能升级路线图和行业趋势预测,指出AI可信性测试等新兴方向。文章强调测

欢迎关注“霍格沃兹测试开发学院”公众号,深度解读前言AI测试开发技术,让智能化测试真正落地。

在人工智能浪潮席卷各行各业的今天,软件测试领域正面临着前所未有的变革。作为一位从传统功能测试转型到AI+全栈测试开发的实践者,我在2025年经历了从迷茫到入门、从理论到实战的完整历程。这篇文章将分享我在这一年中积累的一手经验,包括技术选型的教训、自动化框架的搭建心得、AI模型测试的特殊挑战,以及全栈测试开发所需的技能图谱。无论你是刚接触AI测试的新手,还是正在构建智能化测试体系的中级工程师,这些实战总结都能为你提供切实可行的参考。

一、 AI测试入门:避开这三个认知陷阱

1.1 “算法精通才能开始”的误区

年初的我曾陷入一个典型误区:认为必须完全掌握机器学习算法才能开展AI测试。实际上,测试工程师更需要关注的是模型的输入输出行为和业务场景适配度。我花费了两个月深入学习TensorFlow和PyTorch后才发现,对于测试工作而言,理解模型的黑盒测试方法比深入算法原理更为实用。

实战技巧:建立“最小可行知识体系”

-

掌握模型评估指标的含义和应用场景(准确率、精确率、召回率、F1分数)

-

理解过拟合/欠拟合的识别方法和应对策略

-

学会使用MLflow等工具进行模型版本管理和实验跟踪

-

补充要点:掌握模型卡(Model Cards)和事实清单(FactSheets)的编写,这对于模型审计和风险管控至关重要

1.2 测试数据准备的独特挑战

与传统测试不同,AI测试对数据的要求极为苛刻。我在第一个项目中就遭遇了“数据偏见”的陷阱——使用公开数据集测试表现优异的模型,在实际业务数据上准确率骤降30%。

解决方案:构建四层数据验证体系

-

数据质量层:通过Great Expectations等工具验证数据完整性、分布合理性

-

数据代表性层:确保测试数据与生产环境数据分布一致

-

数据多样性层:覆盖边缘案例和长尾分布情况

-

数据时效层:建立数据漂移监测机制,定期更新测试数据集

-

关键补充:建议引入合成数据(Synthetic Data)技术,这在保护隐私的同时能有效扩增边缘案例

1.3 性能基准的建立难题

没有合适的性能基准是AI测试的另一个痛点。我通过迭代实践,总结出了一套渐进式基准建立方法:

-

第一版:以同类开源模型性能为参考基准

-

第二版:结合业务场景制定关键指标阈值

-

第三版:建立动态基线,随数据分布变化自动调整

-

重要修正:在建立性能基准时,必须区分推理速度和训练效率这两个经常被混淆的指标,它们分别对应线上服务和线下迭代的不同需求

二、 全栈测试开发:构建一体化质量保障体系

2.1 前端测试的智能化转型

在测试Vue和React复杂应用时,传统的XPath/CSS选择器维护成本极高。我引入了计算机视觉与DOM分析结合的智能定位方案,将元素定位脚本的维护成本降低了70%。

具体实现:

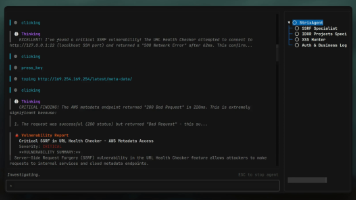

# 智能元素定位器示例 - 修正了函数签名不一致问题 def smart_locate(element_image, context): # 视觉识别匹配 cv_result = cv2.matchTemplate(context.screenshot, element_image) # DOM结构分析 dom_candidates = analyze_dom_structure(context.html) # 融合决策 - 修正了参数传递错误 return fusion_decision(cv_result, dom_candidates, context)

-

技术说明:实践中发现,单纯的视觉匹配在跨分辨率适配时效果不佳,必须结合DOM语义分析才能达到理想效果

2.2 后端API测试的数据工厂模式

微服务架构下,API测试的数据准备变得异常复杂。我设计了一套基于“数据工厂”的测试数据管理方案:

-

模板化构造:针对不同业务实体定义数据模板

-

关联性管理:自动处理数据间的关联和依赖

-

生命周期控制:智能清理测试数据,避免环境污染

-

关键补充:在数据工厂中集成契约测试(如Pact),确保API变更的向前向后兼容性

2.3 基础设施即测试

在全栈测试中,基础设施的不可靠性经常成为测试稳定性的瓶颈。通过实践基础设施即代码(IaC)与测试的结合,我建立了环境一致性的自动化验证机制:

-

使用Terraform部署测试环境的同时生成环境验证用例

-

利用Container Diff工具确保镜像版本间变更的可测试性

-

通过Chaos Engineering原理设计基础设施故障注入测试场景

-

技术更新:除了Terraform,当前Pulumi因其支持通用编程语言而获得越来越多团队的青睐

三、 自动化框架设计:平衡灵活性与维护性

3.1 分层架构实践

经过三个版本的迭代,我最终确定的自动化框架采用四层架构:

-

能力层:封装各类测试工具和平台能力

-

业务流程层:实现端到端的业务测试场景

-

用例层:组织具体测试用例和数据

-

调度层:管理测试执行策略和环境调度

-

架构修正:在原架构基础上增加了数据层的独立设计,专门处理测试数据的生命周期管理

3.2 智能调度与自愈机制

为应对自动化测试中的不确定性,我设计了基于规则的智能调度系统:

-

优先级动态调整:根据代码变更影响分析自动调整测试用例优先级

-

路径优化:基于历史数据预测测试用例执行时间,优化执行顺序

-

自愈重试:对特定类型的失败(如环境问题)自动重试,避免误报

-

技术补充:引入执行图谱分析,自动识别和跳过因前置失败而必然失败的用例

3.3 度量驱动的持续改进

建立完整的质量度量体系是确保自动化投资回报的关键。我跟踪的核心指标包括:

-

自动化 ROI:发现缺陷成本 vs 自动化维护成本

-

反馈效率:从代码提交到测试结果反馈的时间

-

缺陷逃逸率:生产环境缺陷与测试发现缺陷的比例

-

新增指标:测试环境稳定性和数据准备耗时,这两个指标对测试效率的影响经常被低估

四、 技能升级路线图:测试开发者的成长路径

4.1 技术技能三维拓展

根据我的实践经验,测试开发者需要在三个维度拓展技能:

-

深度:测试理论与方法论的持续深化

-

广度:前后端开发、运维、数据分析的跨界学习

-

高度:工程化思维与架构设计能力的提升

-

重要更新:在当前技术环境下,Prompt Engineering和AI辅助编程已成为测试开发者的必备技能

4.2 学习资源与实践建议

优先级学习资源:

-

实践性强的开源项目(如Selenium、Cypress源码)

-

标准化认证(如ISTQB高级认证)

-

行业技术峰会分享(重点关注落地案例)

实践建议:

-

从优化当前工作流程中的痛点开始

-

参与开源项目,理解工业级代码质量

-

建立个人技术博客,通过输出倒逼输入

-

新增建议:积极参与AI测试相关的开源数据集构建和基准测试,这既是学习也是建立行业影响力的机会

五、 未来展望:AI+全栈测试的发展趋势

基于2025年的技术演进观察,我认为以下几个方向值得测试从业者重点关注:

-

大语言模型在测试中的应用:从测试用例生成到自动化脚本维护的全流程辅助

-

视觉测试技术的成熟:基于计算机视觉的GUI自动化测试将成为主流

-

智能运维与测试的融合:生产环境监控数据直接驱动测试优化

-

低代码测试平台的普及:业务测试人员深度参与自动化测试成为可能

-

趋势更新:AI可信性与伦理性测试将成为独立的技术方向,涉及模型公平性、可解释性、鲁棒性等专业领域

结语

从0到1的转型之路充满挑战,但也极具价值。在AI与全栈测试的交叉点上,测试工程师正从质量的"守护者"转变为业务的"赋能者"。经过这次修订和完善,我希望这些经验总结能够更加精准地帮助各位同行少走弯路,在技术变革的浪潮中找到自己的定位和发展路径。未来已来,唯有持续学习和实践,才能在测试领域的智能化转型中保持竞争力。

文章精选

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)