【强烈推荐】AI Agent革命:从Co-Pilot到Auto-Pilot的技术跃迁,大模型开发者必读指南

保证100%免费。

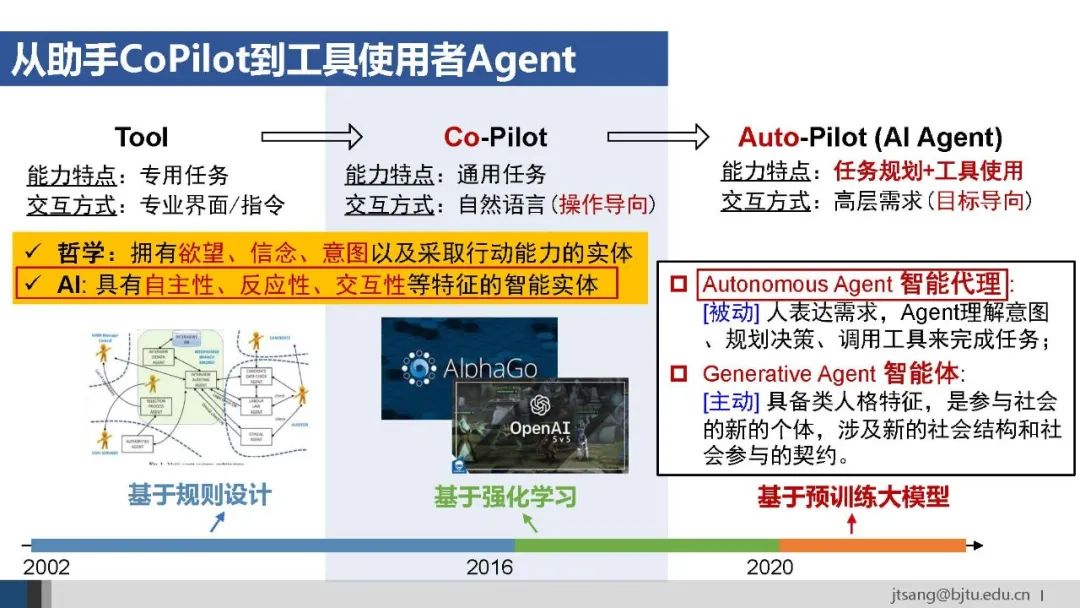

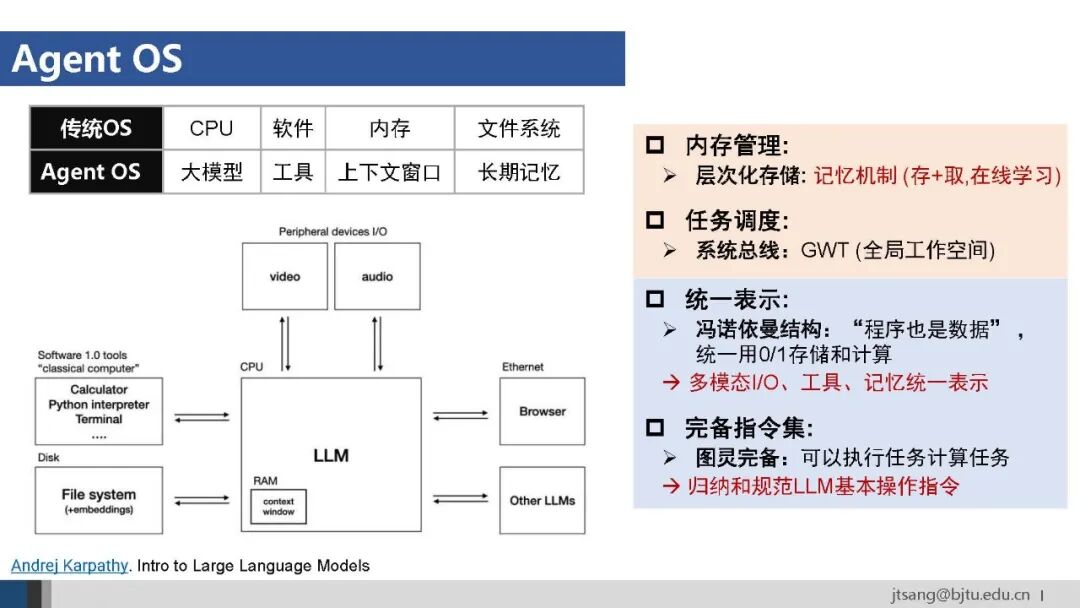

本文回顾了AI从专家系统到Agentic AI的发展历程,重点分析了AI Agent的核心能力(任务规划、工具使用)和技术实现路径。AI Agent正从人机协作的副驾驶发展为自主完成复杂任务的主驾驶,代表新的抽象层,实现"what I want"的目标导向服务。未来Agent OS将成为运行基础,通过action agent和information agent的深度融合,突破物理限制,实现智能持续提升。

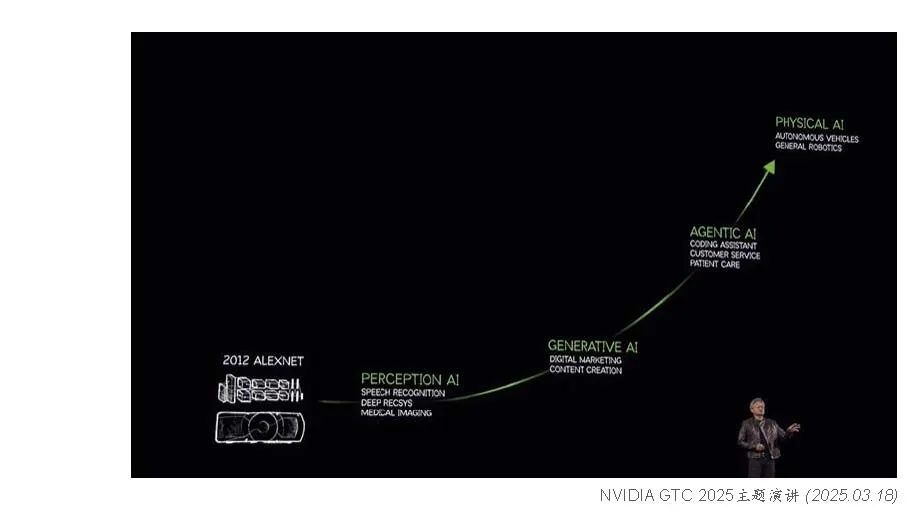

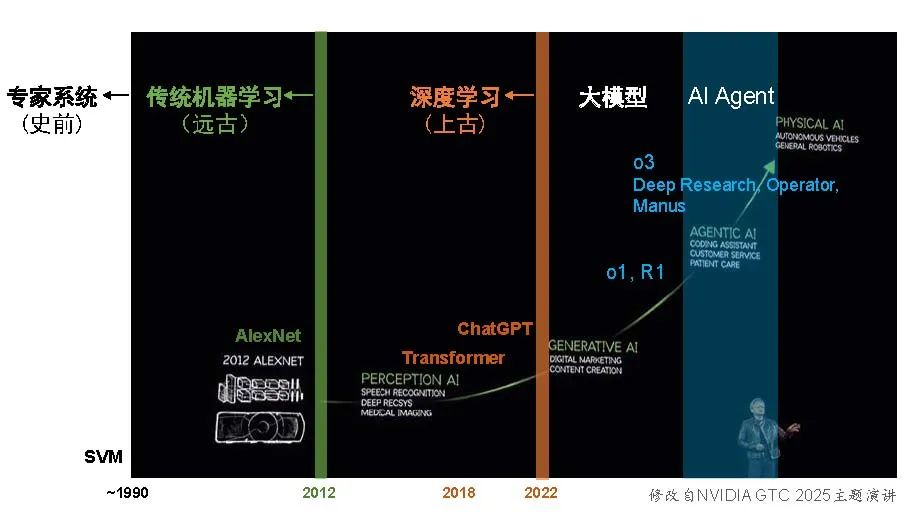

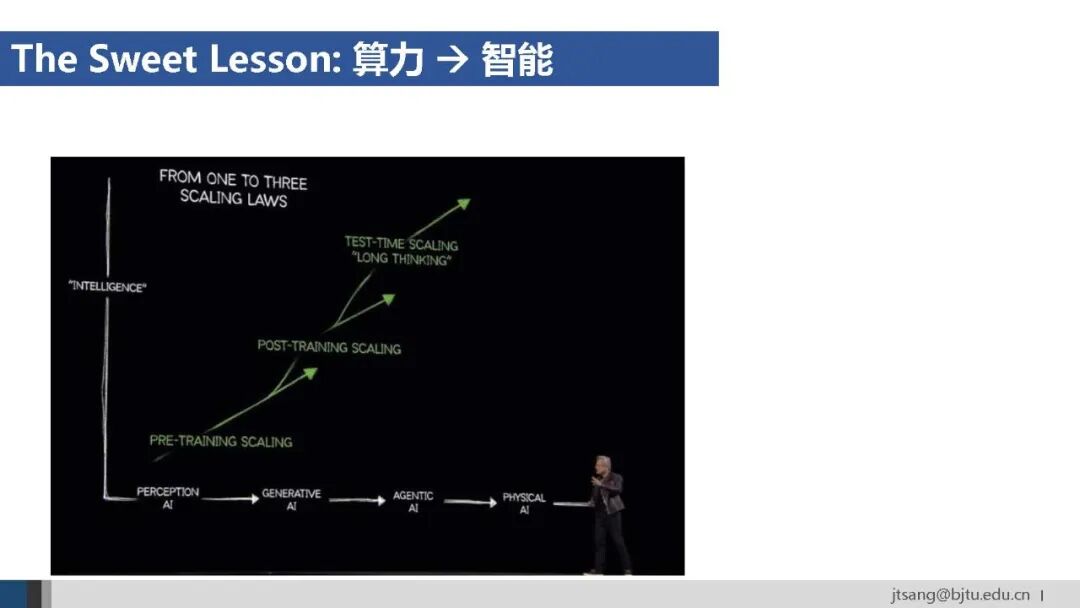

黄仁勋在英伟达GTC2025的主题演讲中回顾了AI过去十几年的发展。从2012年AlexNet开始的深度学习,到近几年大模型推动的生成式AI,再到当下正经历的Agentic AI,直到未来的Physical AI。

深度学习的十年里,AI进展超过了此前传统机器学习三十年的积累。而ChatGPT上线后的短短两年半,AI更是突飞猛进,取得的成果已经远超深度学习的十年。

“人间一天,AI一年”。从今天回望,深度学习像是上古时期的,传统机器学习则是更遥远的远古技术,而SVM之前的专家系统,算是文明尚未开化的史前AI了。

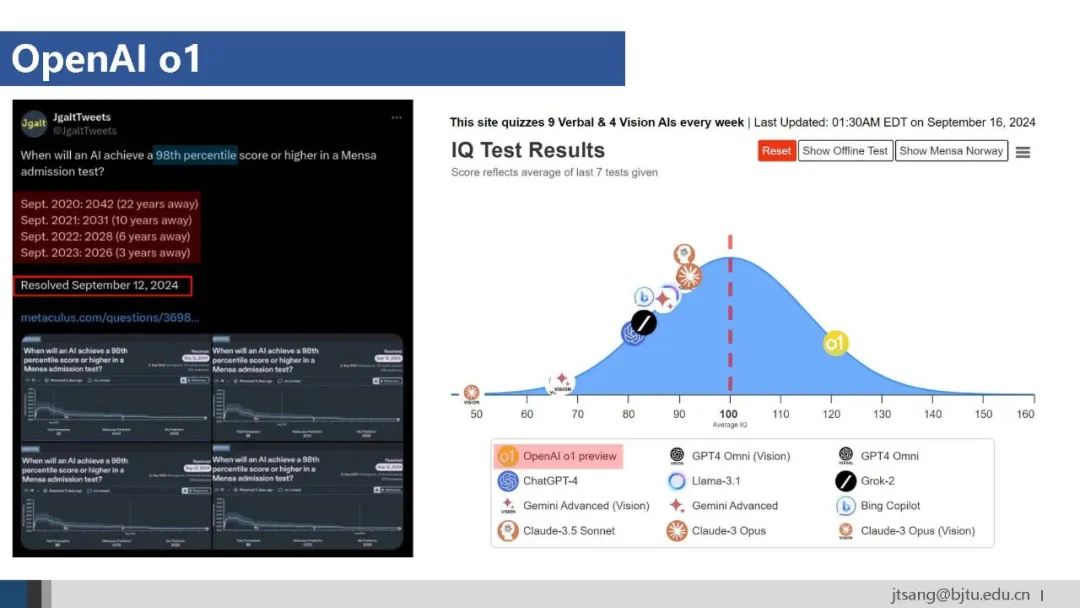

当前所处的Agentic AI有两波标志性事件:第一波是去年9月开始的以OpenAI的o1和DeepSeek的R1为代表的推理模型逐渐成熟,第二波是今年初的o3模型上线和Deep Research、Operator、Manus等Agent应用的出现。

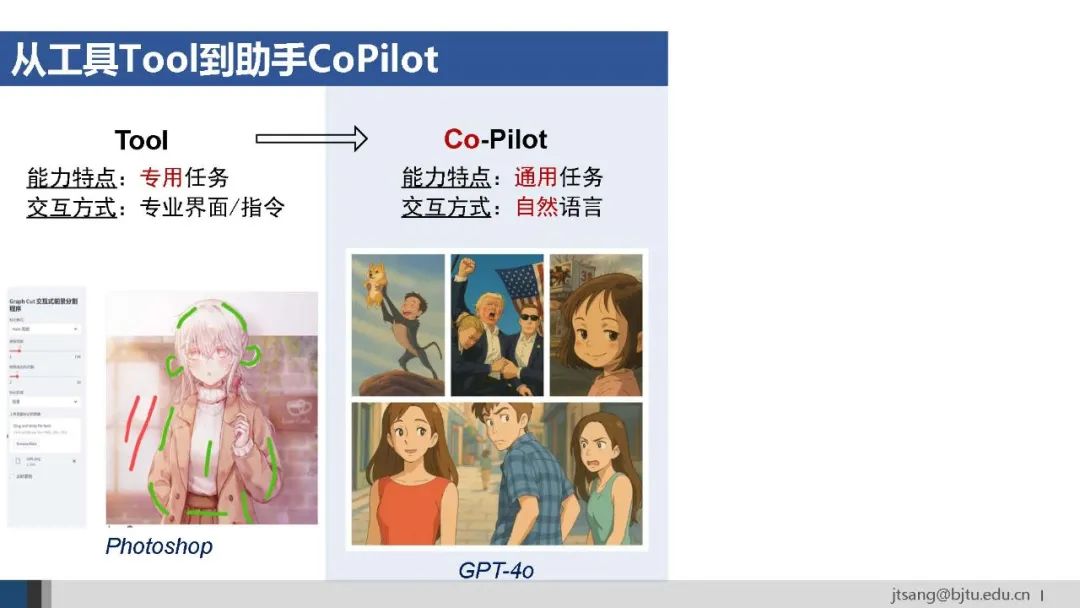

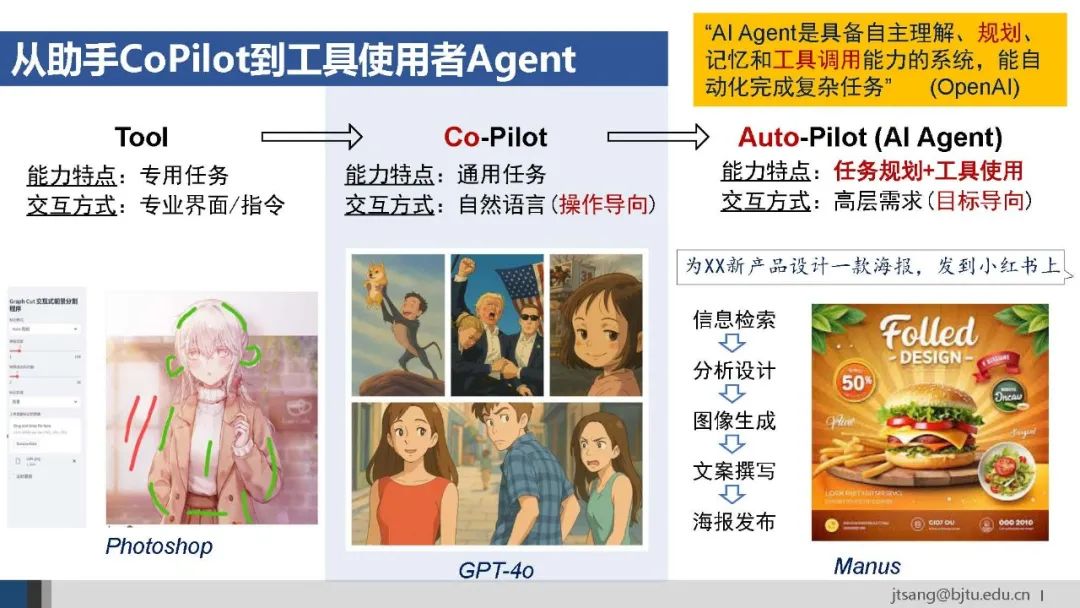

在大模型之前,以专家系统、传统机器学习和传统深度学习为代表的AI,依赖专业界面和指令,解决专用任务。比如用Photoshop进行交互式抠图。这一阶段的AI和人类历史上每次技术革命一样,提供的是被人类使用的工具。

大模型带来的通用任务解决能力和自然语言交互界面,使AI成为人机协作的副驾驶Co-Pilot。比如GPT-4o支持基于自然语言指令生成图片、抠图、风格迁移等。不过,此时仍需人类给出明确、具体的指令:人指挥一步,AI执行一步。

除了内容理解和生成的感知能力,大模型逐步具备了任务规划和工具使用的认知决策和行动能力。AI可以直接理解和实现目标导向的高层需求。

比如提出“为某新产品设计海报并发布到小红书”,Manus会自主进行任务规划—将复杂任务拆解为多个子任务,并在必要时使用外部工具/其他agent来执行其中某个子任务。

此时,AI成为了主驾驶Auto-Pilot–即AI Agent。根据OpenAI的定义:AI Agent是具备自主理解、规划、记忆和工具调用能力的系统,能自动化完成复杂任务。

以上是从AI发展的角度看如何从Tool演变为AI Agent。从Agent这个术语本身出发,哲学和AI有不同的定义。以技术实现为目的,我们更关注AI定义中的自主性、反应性和交互式,暂不讨论尚未形成共识的哲学范畴的意识等问题。

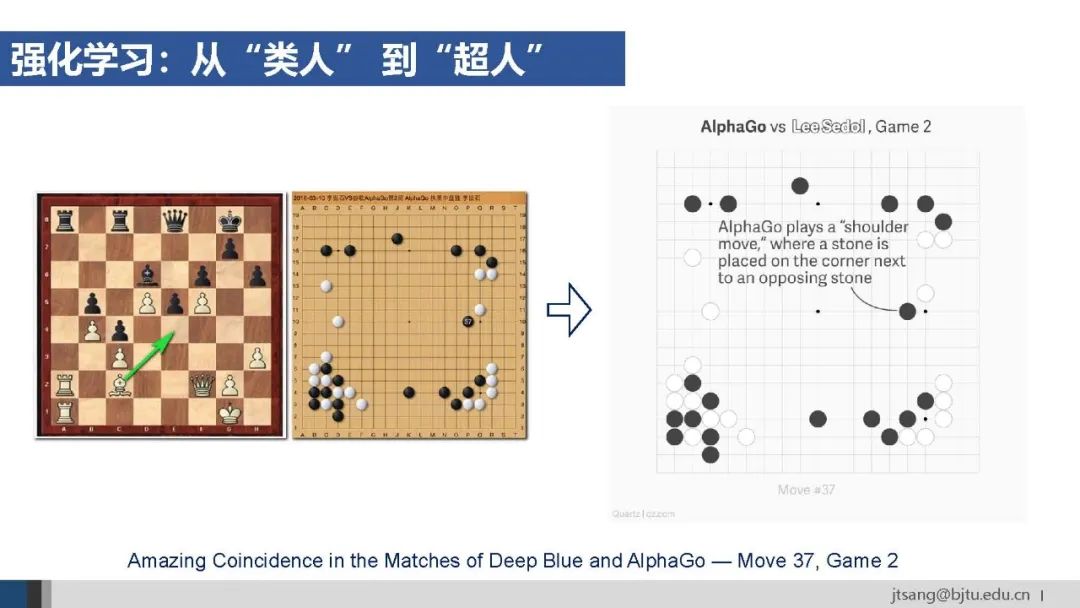

实际上,Agent一直是AI发展中的核心概念。从技术路径看,先后经历了基于规则和基于强化学习两个阶段。AlphaGo和OpenAI早期的游戏Agent即基于强化学习训练,在单一任务、封闭环境中达到了超过人类的水平。

今天的AI Agent建立在大模型的基础上,通过预训练获得了世界知识先验,并以语言作为处理不同任务的接口,使得AI Agent超越了仅依赖强化学习的局限,具备一定的泛化能力和通用性。

根据行为发起主体,AI Agent又可以分为被动响应人类需求的autonomous agent,和具备类人格特征和主动行为模式的generative agent。

以下从任务规划和工具使用两种核心能力、以及应用这三个方面,介绍前一种AI Agent – autonomous agent的进展。

**1.**任务规划

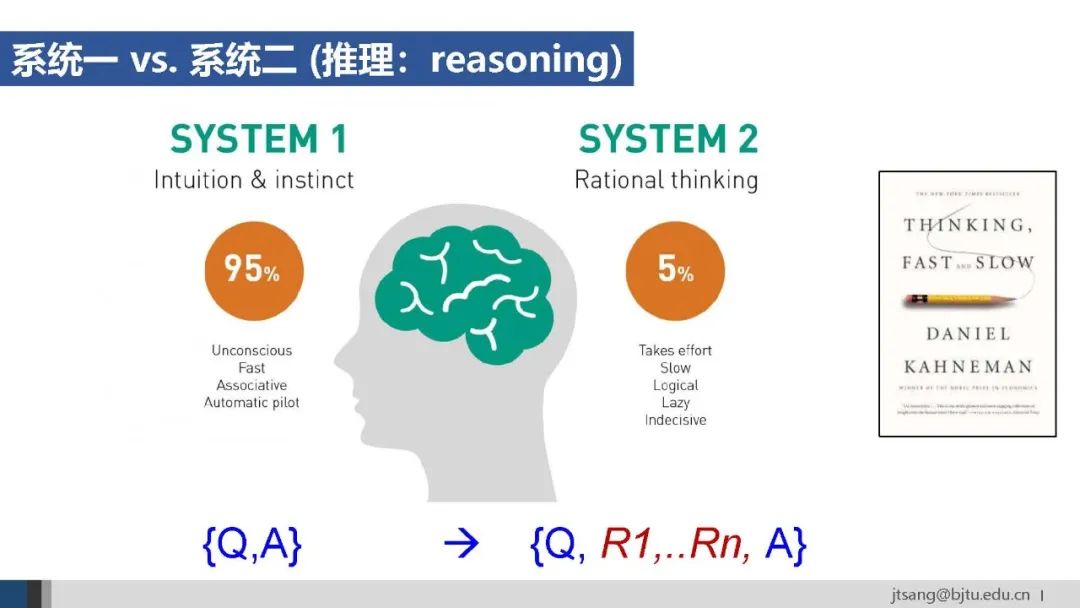

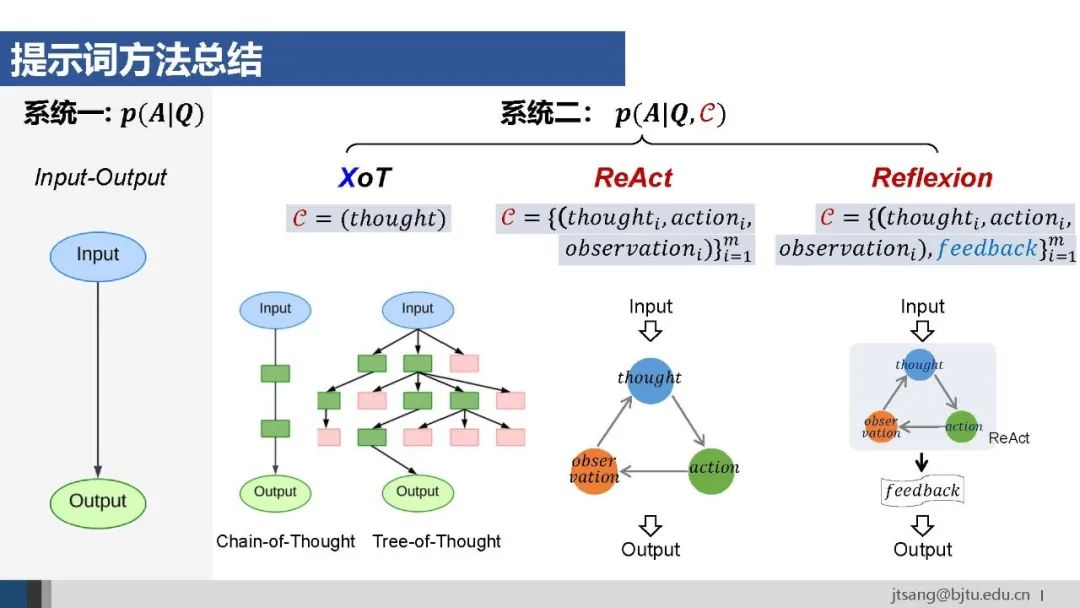

任务规划与人类的系统二能力紧密相关。按照心理学理论,系统一代表直觉,从Q直接到A,属于“快思考”;系统二从Q到A之间增加了多步的逻辑推理,属于“慢思考”。

(区分推理和推断:推理reasoning是指模型通过多步骤、结构化的中间过程来得出结论;而推断inference泛指模型生成输出结果的过程,可能基于推理、也可能不基于推理)。

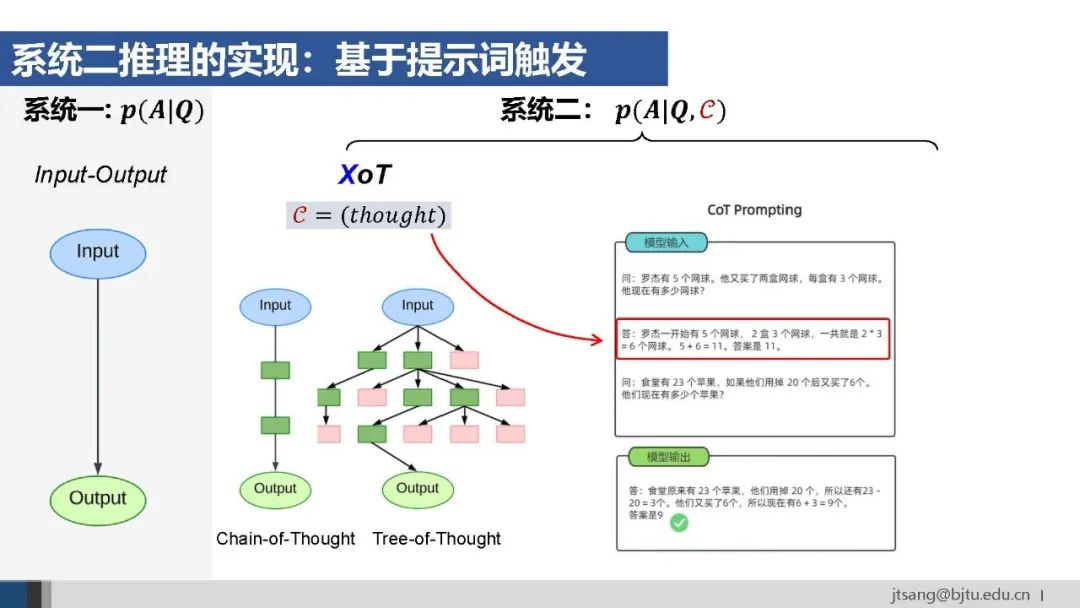

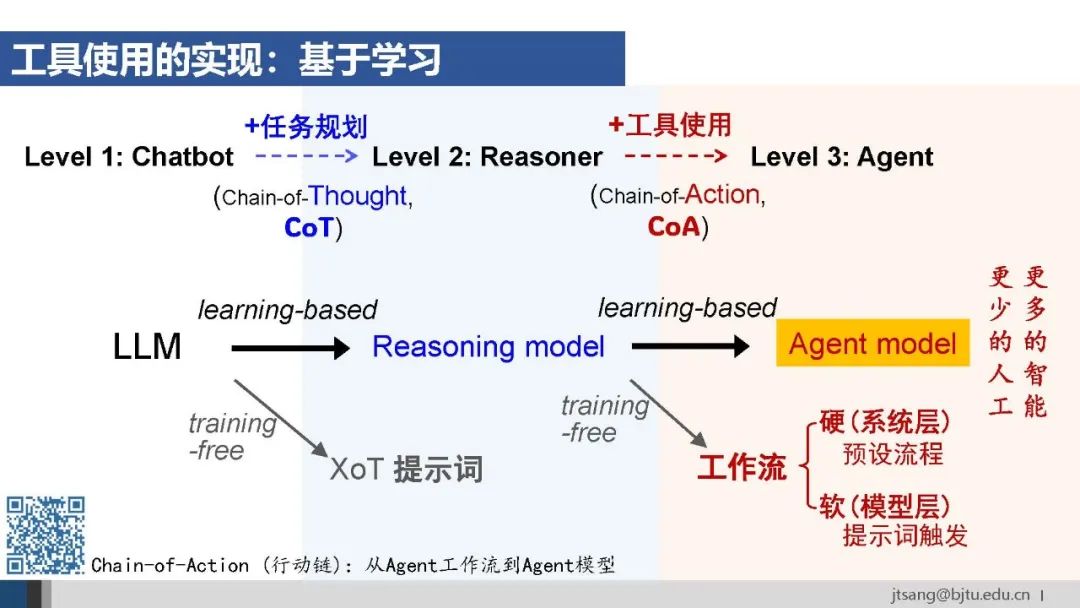

要让大模型实现系统二的推理能力,第一种方法是提示词。

比如思维链CoT、思维树ToT等方法,提供少量包含推理过程的样本示例,激发模型In-Context Learning上下文学习,在线调整其推断行为。

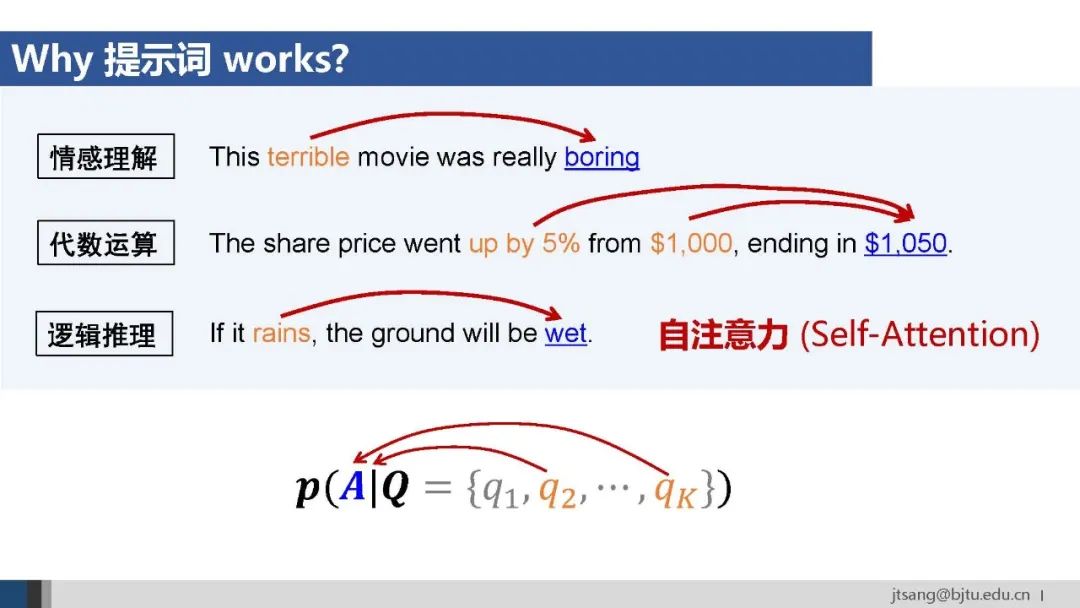

大模型从预训练的多任务学习中学到了捕捉上下文关联的自注意力,提示词相当于在推断阶段增加了一个“条件层”,让模型在进行推断时参考示例中的推理结构,影响其生成结果。

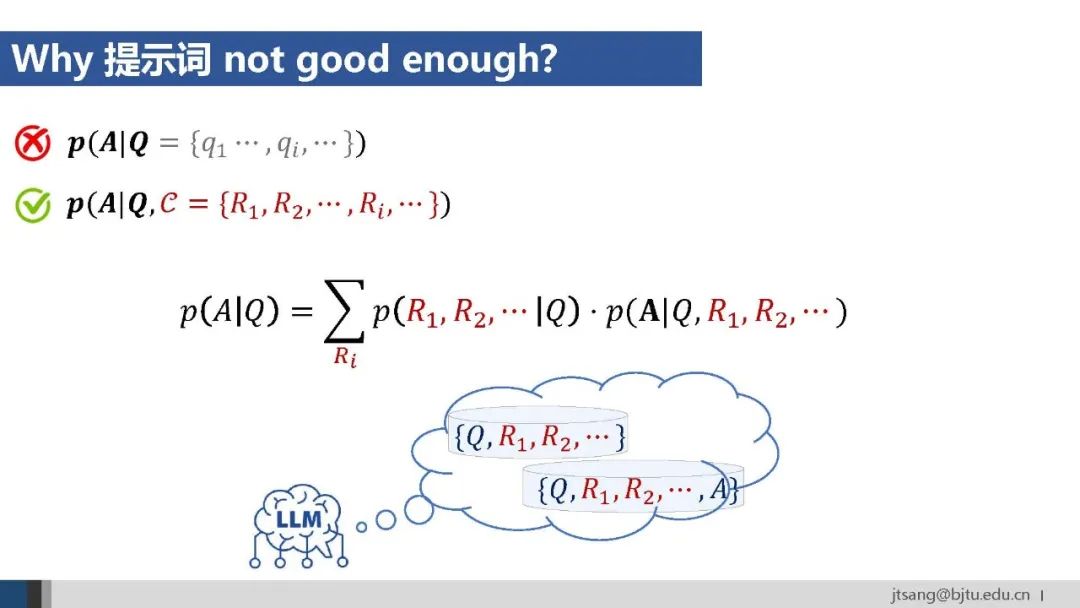

然而,互联网语料主要是 (Q, A) 的形式,这意味着自注意力中学到的上下文关联是在问题和答案之间的。而推理需要捕捉推理过程和答案之间的关联。在推理过程上将p(A|Q)展开后,可以看得很清楚。

因此,最直接的方式还是构造含有推理过程的数据,通过学习将推理能力内化进到模型里。

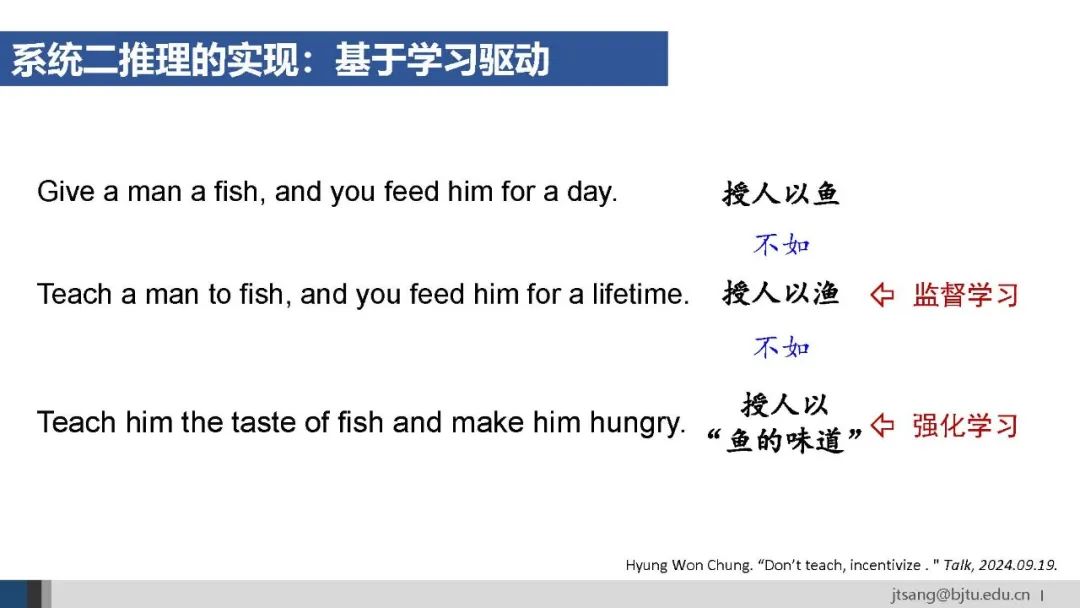

主要有监督学习和强化学习两种学习路线。监督学习类似师傅手把手教徒弟,像是大学之前的通识教育,提供标准解法和完整步骤。

强化学习则更像研究生教育,导师出了题目,学生自己探索,导师定期给反馈。从这个类比也可以理解强化学习中结果奖励和过程奖励的关系。

以上是从老师的角度,监督学习是“教”,强化学习是“育”。

从学生的角度,监督学习是“学”,强化学习是“习”。别人标注的推理路径不一定适合你,在试错中探索适合自己的路径才是王道。

o1首次展示了基于学习的推理模型的潜力。

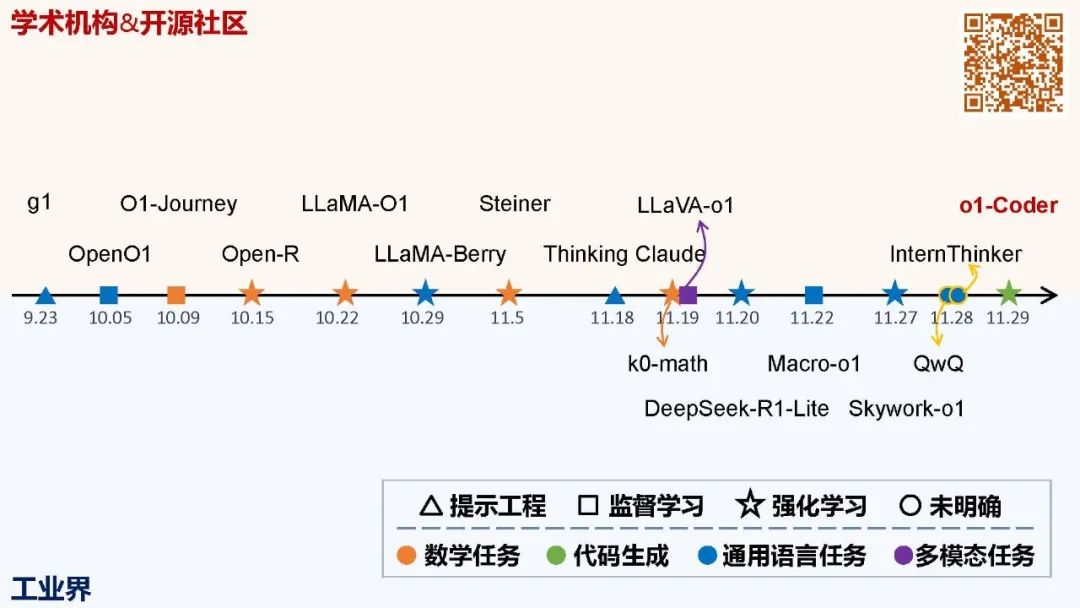

之后学术界和开源社区出现了大量复现工作。和预训练需要大规模集群不同,推理模型的学习聚焦后训练阶段,算力资源的门槛相对较低。

而且,预训练算法在GPT-3.5之前基本都开源了,加上ChatGPT发布后一年多的时间,大家摸索地七七八八了。但后训练、特别是用强化学习训练大语言模型,有大量待探索的工作。学术界觉得自己又行了。

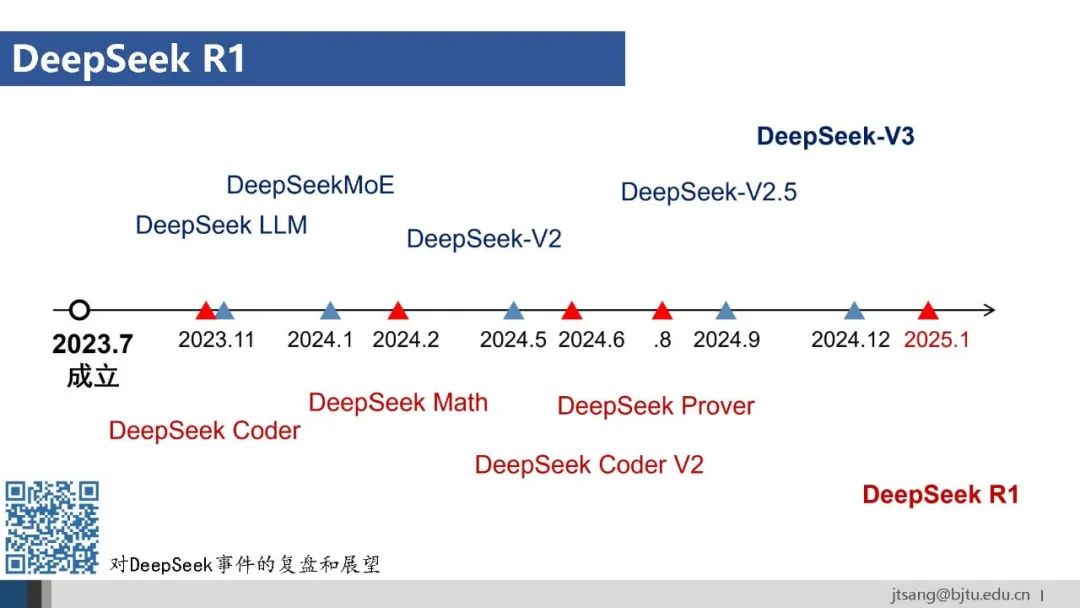

再之后就是DeepSeek R1将推理模型的训练秘籍公开,而且大幅压缩了模型训练和推断成本。

o1验证了推理模型的可行性,R1极致优化效率,降低技术应用门槛。从新技术的早期 demo 出现,到成本降低后的规模化应用,是典型的技术演进路径。

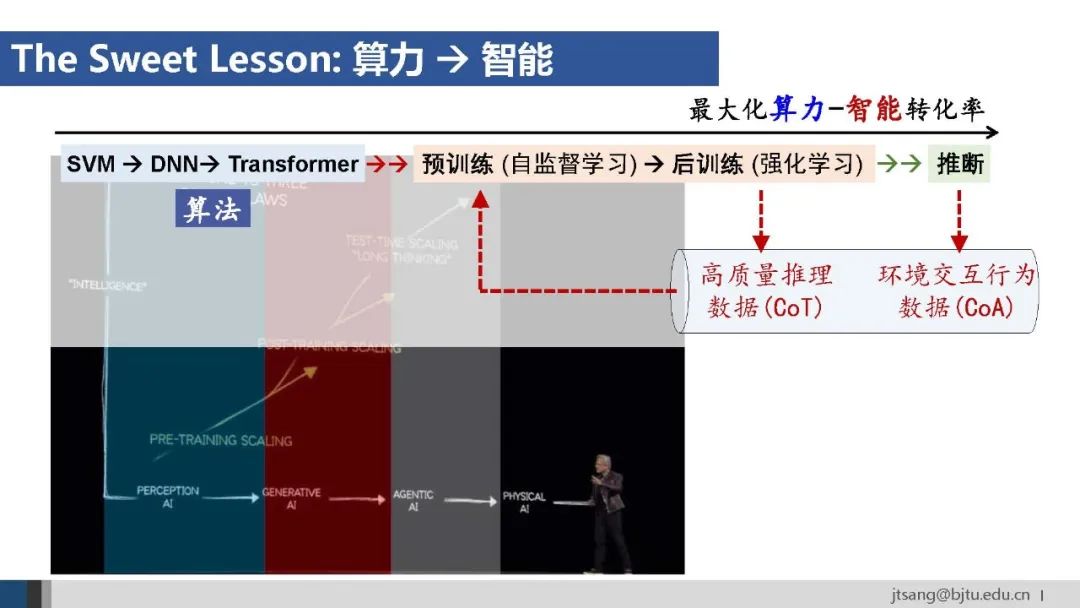

强化学习在推理模型训练中的作用有两点启发:(1)计算换数据,(2)合成新数据。通过强化学习采样出新的高质量数据,为突破人类数据局限、进一步提升模型能力提供了可能。

2. 工具使用

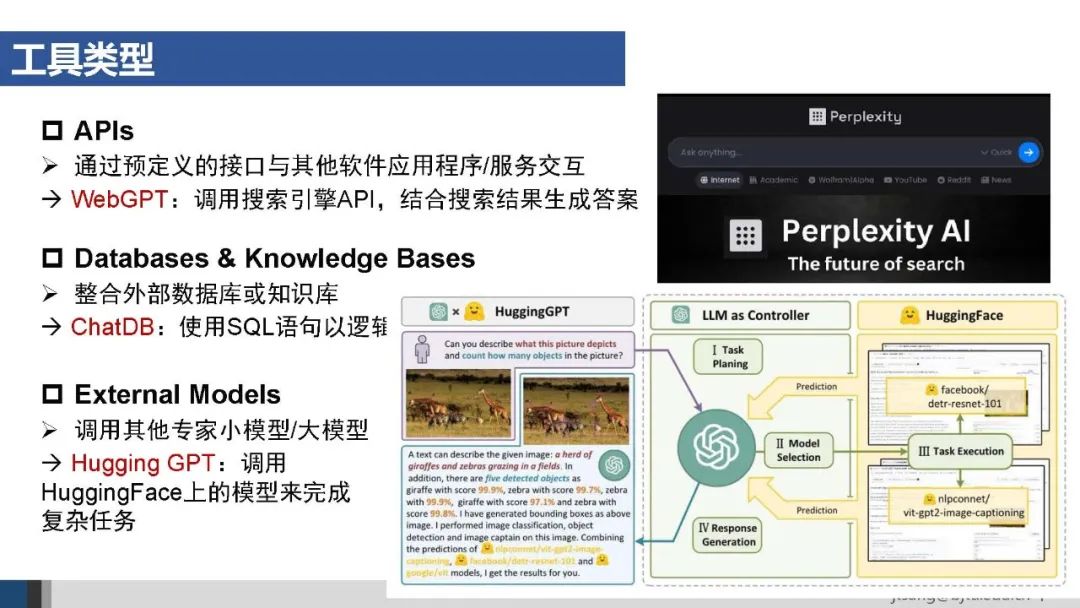

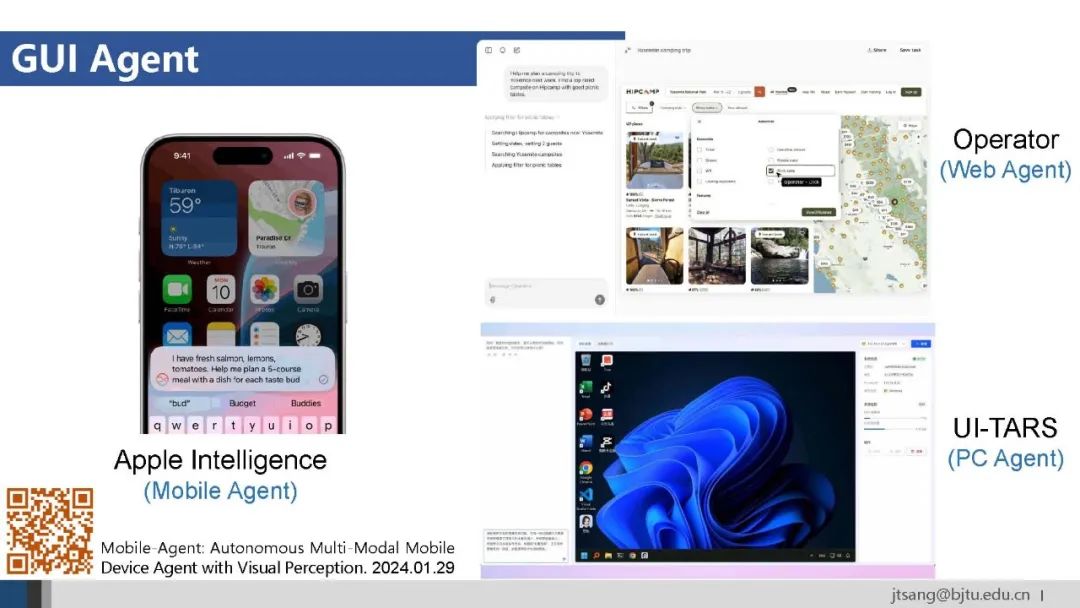

AI Agent可调用的工具主要有API接口、数据库和知识库、外部模型等。对于无法API化的外部系统,可以将图形界面交互也封装成工具供Agent调用。

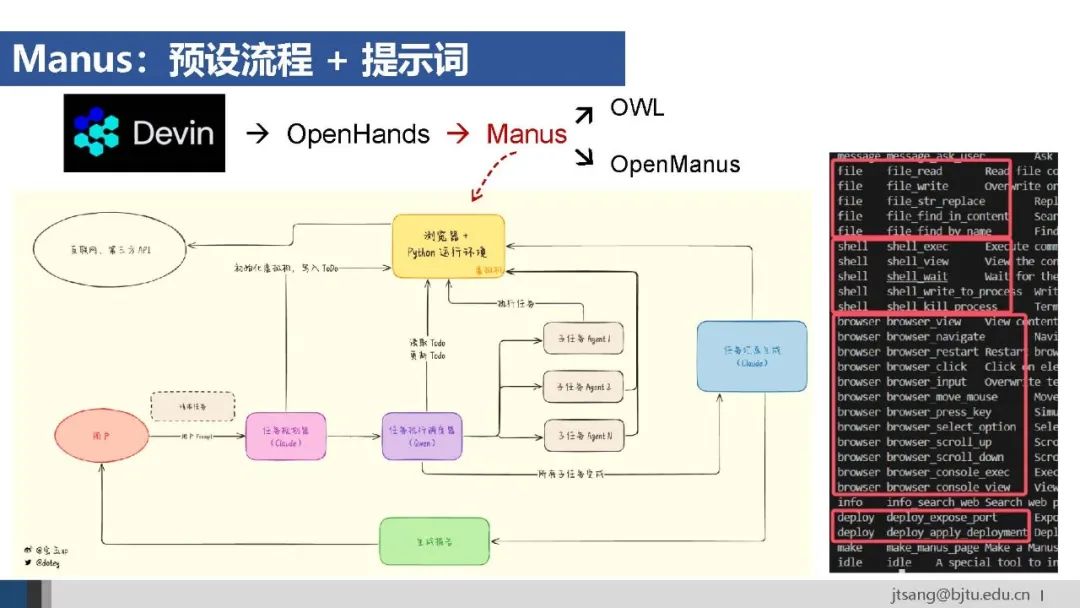

使用工具的第一种方式是**系统层的预设流程,**即通过硬编码方式定义Agent的行为逻辑。

优点是确定性强、可靠,但缺乏灵活性、难以应对开放性和动态变化的环境。字节的Coze是典型的通过设计工作流搭建Agent的平台。

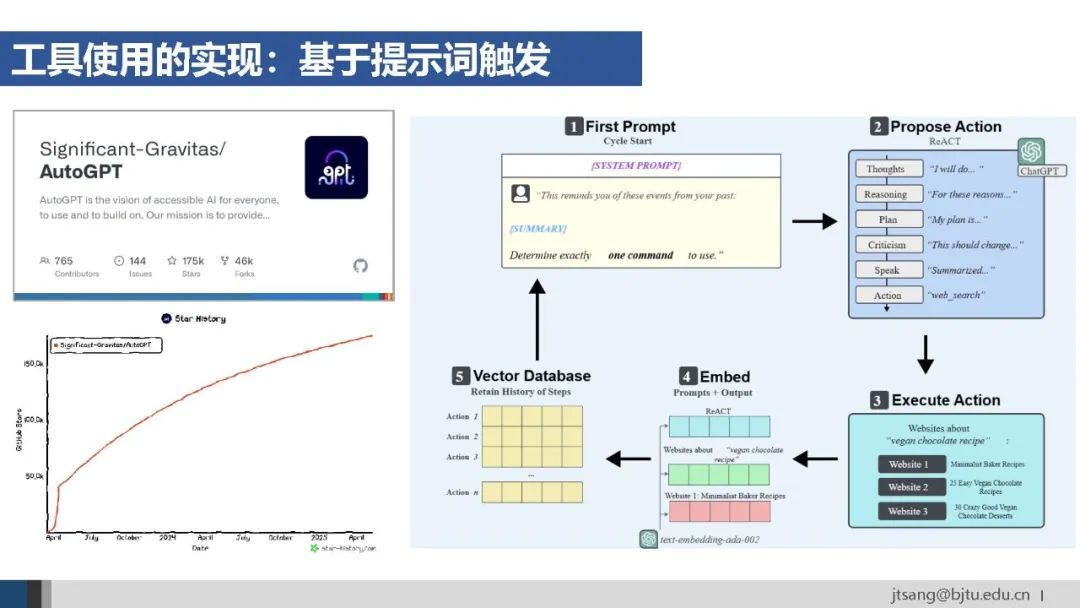

另一种实现方式是**模型层的提示词触发,**引导模型选择合适的工具。这种方式更加灵活,适用于基于局部上下文的任务决策。AutoGPT是早期代表性的基于提示词的Agent框架。

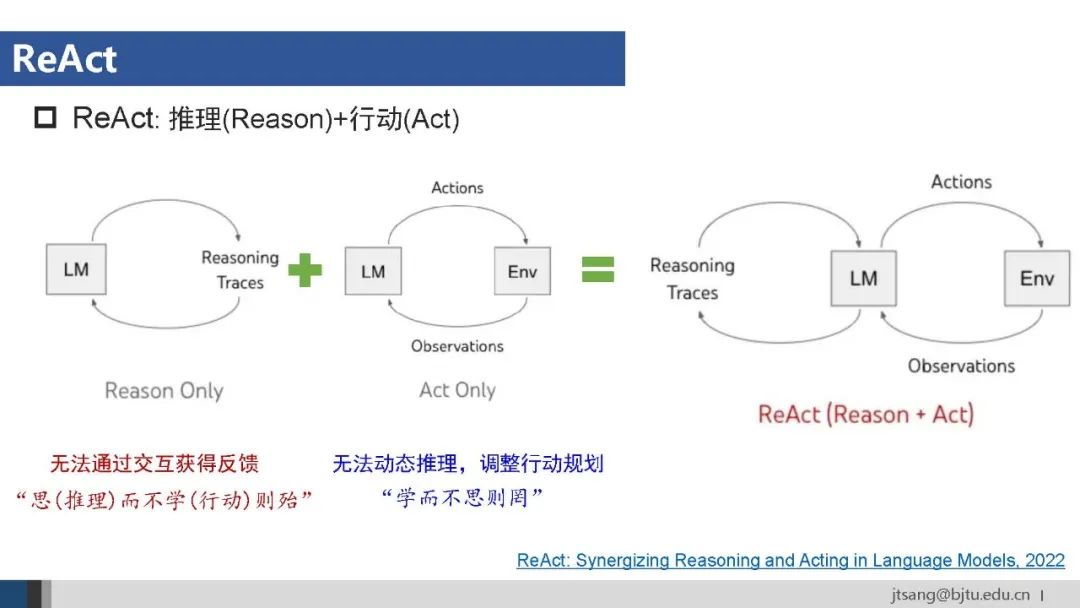

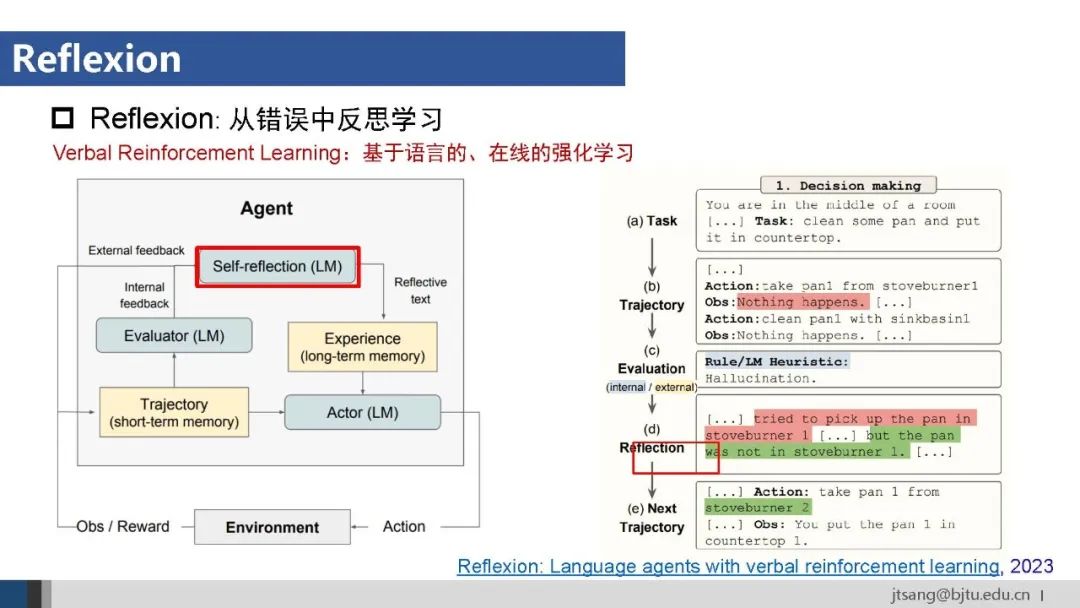

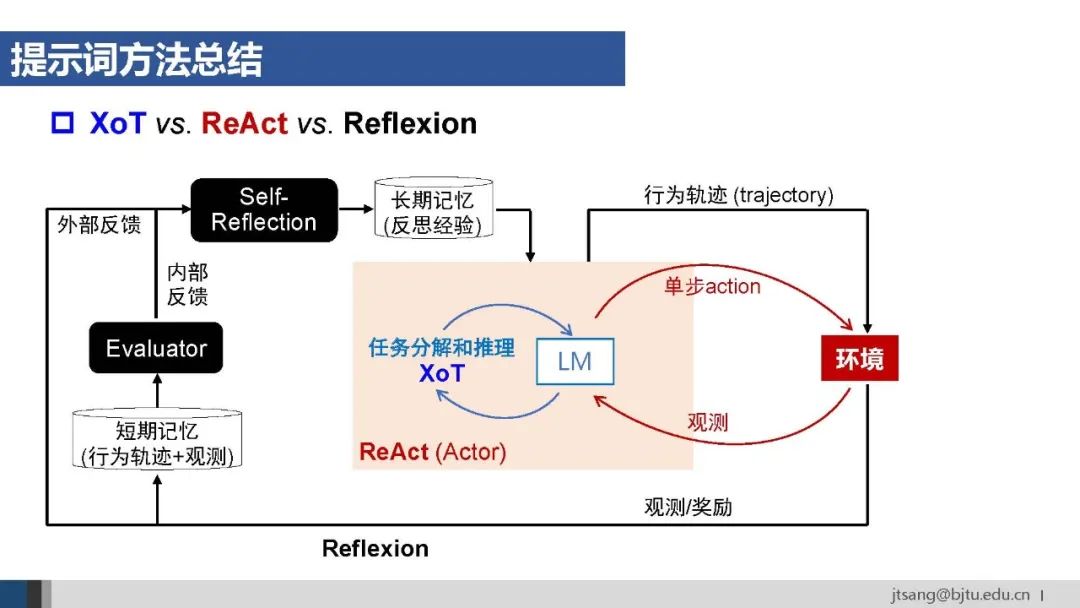

Agent框架使用的提示词方法包括ReAct、Reflexion等。任务规划使用的XoT关注模型内部行为,ReAct通过使用工具与外部环境交互,Reflexion则进一步结合整个行为轨迹,支持Agent从错误中学习并改进行动策略。

Manus结合使用了预设流程和提示词的方法:预设的任务解决流程是问题分析-任务规划-调用子任务Agent-结果总结等,在每个子任务Agent内部则设计了针对性的提示词。

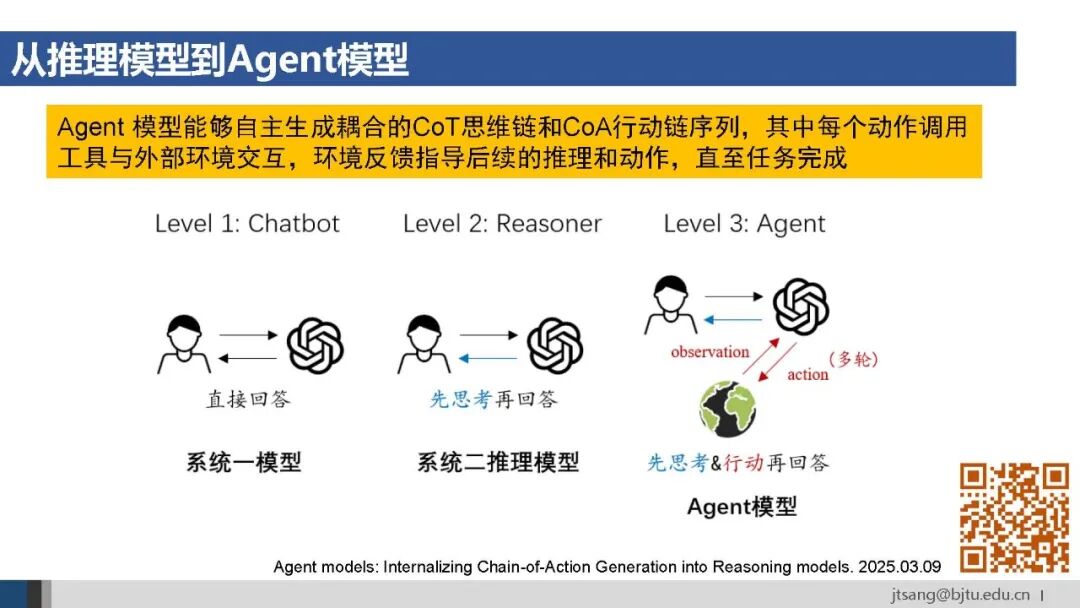

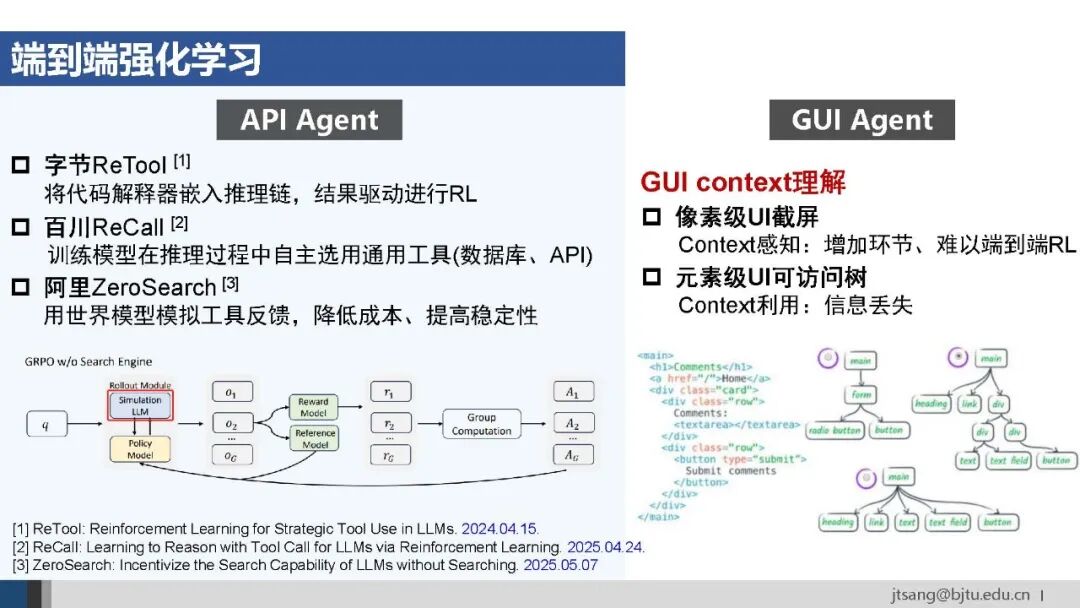

与推理能力类似,工具使用(在推理链中使用工具,Chain-of-Action,CoA)也可以通过学习的方式内化到模型中。

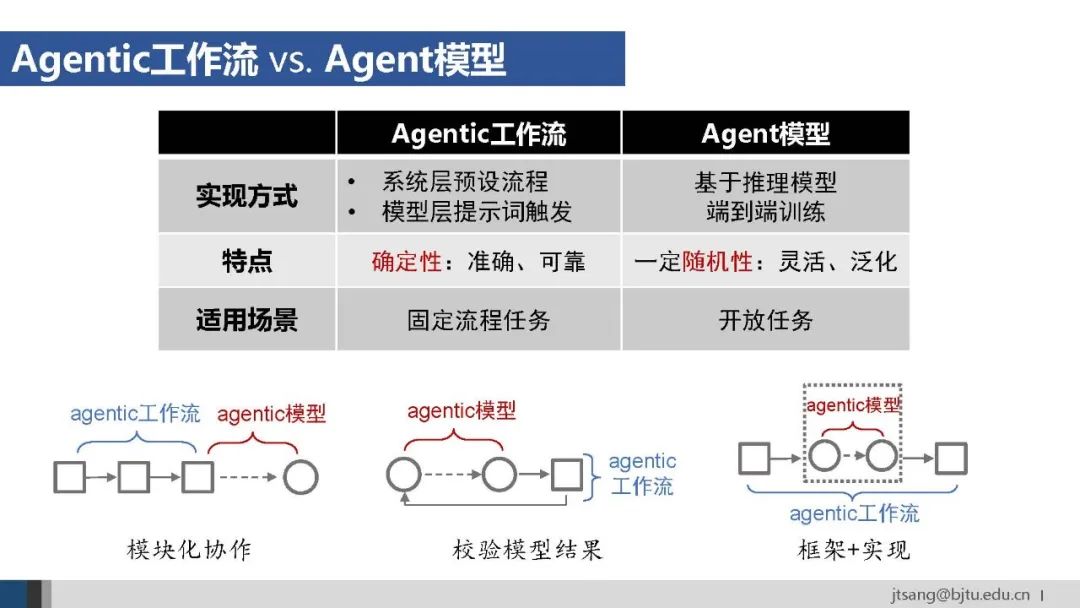

将预设流程和提示词触发两种方式统称为工作流。根据“更少的人工,更多的智能”的原则,基于学习得到的Agent模型应该具有更高的上限。

基于端到端学习的Agent模型o3于4月16日正式上线。Greg Brockman在介绍时明确说o3学习“在思维链中使用工具”。

3月初的论文给agent模型下了一个定义。

与LLM和推理模型的人-模型二元结构不同,agent模型要求能够同时进行思考与行动,形成了由人、模型和环境构成的三元结构:使用工具与环境进行交互以获得反馈,经过多轮的思考、行动和观察后,最终生成回复。

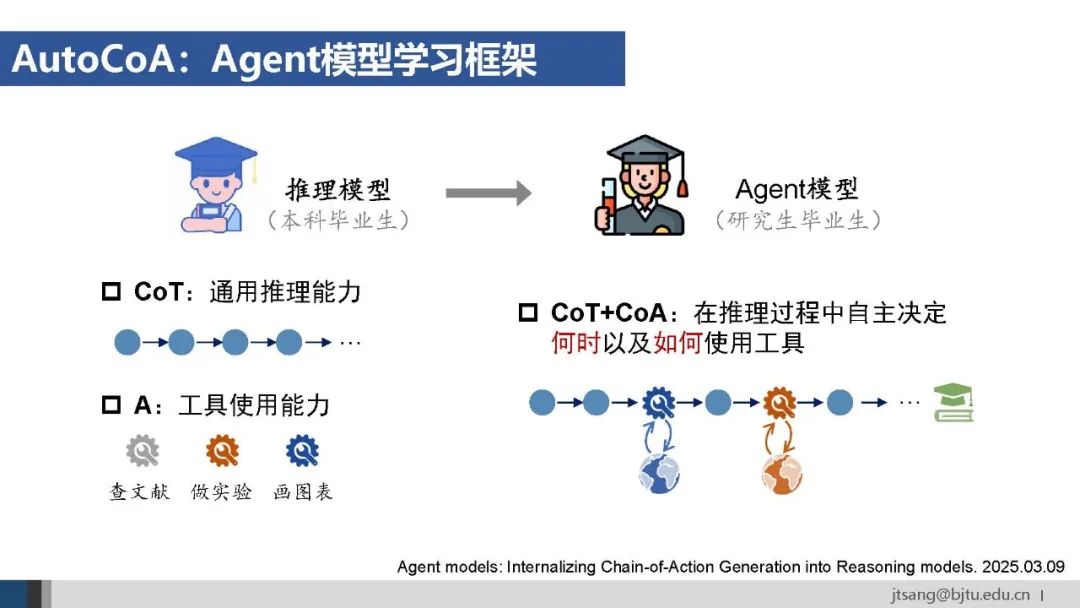

推理模型已经具备了通用推理能力和单点的工具使用能力。Agent模型训练旨在面向任务目标,端到端训练模型在推理过程中的链式工具使用能力。

如同研究生通过完成学位论文,才能掌握如何整合查阅文献、做实验、绘制图表这些单个技能完成一个复杂的任务。

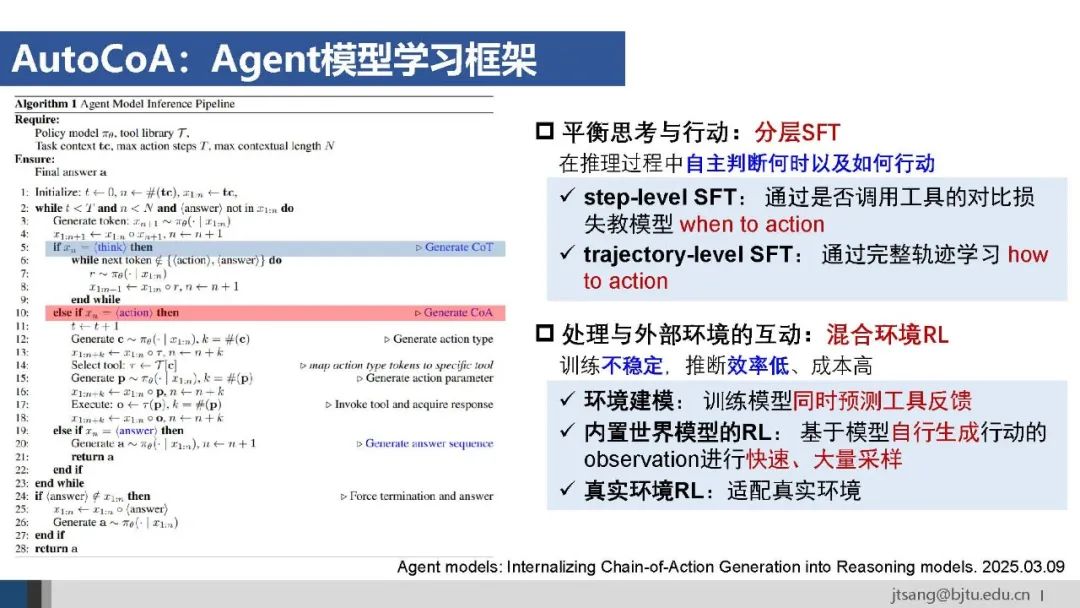

Agent模型学习框架需要平衡思考与行动,并处理外部环境交互带来的训练不稳定和效率低成本高的问题。

AutoCoA设计了分层SFT,将模型行动的when和how两个能力拆解;并提出了混合环境RL,训练策略模型自己模拟环境反馈。

端到端训练的Agent模型,由于面向任务目标进行了策略优化,其选择的工具和工具使用参数是面向全局任务目标生成的。

相比之下,提示词触发的agentic工作流方法,模型虽然也有一定的自主灵活性,但行动是单步进行的,只能根据局部上下文做出选择。

Agent模型探索能力上限,Agentic工作流保证任务执行下限,二者在很长时间内将结合使用。

三种可能的结合方式:(1)模块化协作,确定性流程使用工作流,灵活性需求使用Agent模型;(2)校验模型结果,通过工作流对Agent模型的输出进行校验,减少模型的随机性和幻觉不确定性等问题;(3)框架+实现,工作流搭建顶层确定框架,模型实现底层灵活和智能。

随着自主性进一步提高,工具也将由agent通过在线编程按需创建。一些全栈开发的agent,比如Devin、亚马逊的Kiro都在实现类似的功能。

3. AI Agent应用

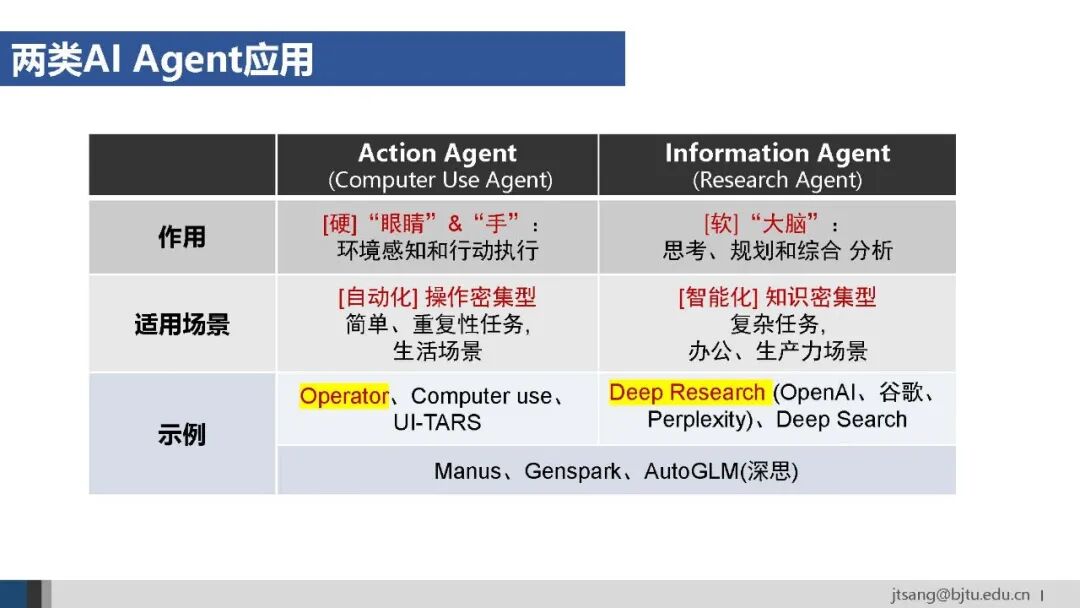

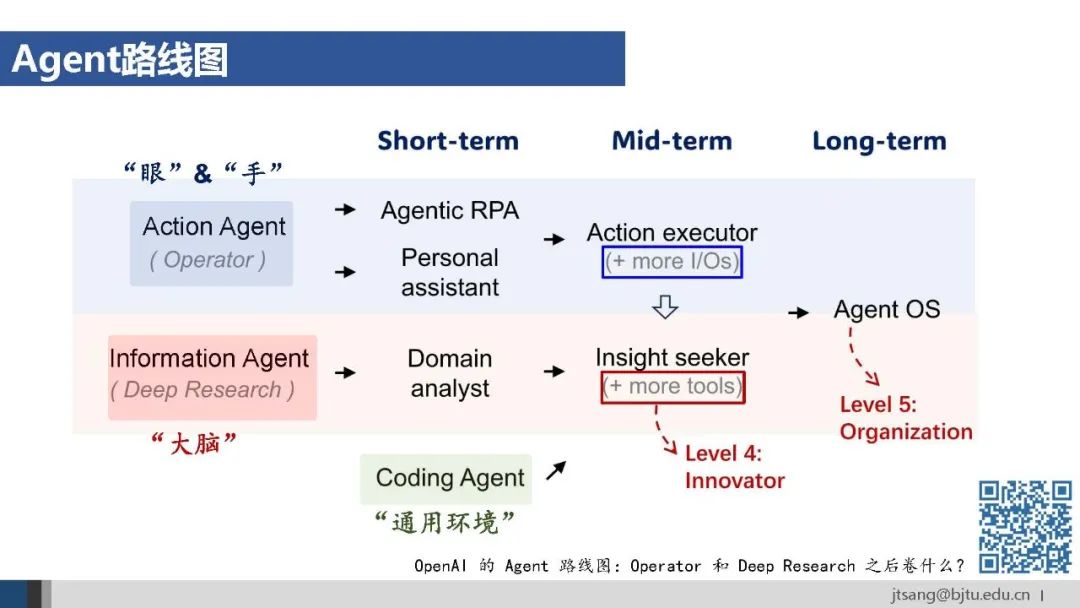

Operator和Deep Research代表了目前AI Agent的两个主要应用方向:操作action agent和信息information agent。

前者扮演“眼和手”的角色,擅长环境交互与自动化操作,适用于重复性强的操作密集型任务。后者扮演“大脑”的角色,擅长知识整合与复杂分析,适用于知识密集型任务。

实现方式上包括GUI Agent、API Agent和多Agent三种。

其中多Agent,比如荣耀的OS Agent “YoYo”调用中移动的App Agent“灵犀”,目前看是使用大型App、兼顾通用性和效率的可选方案。

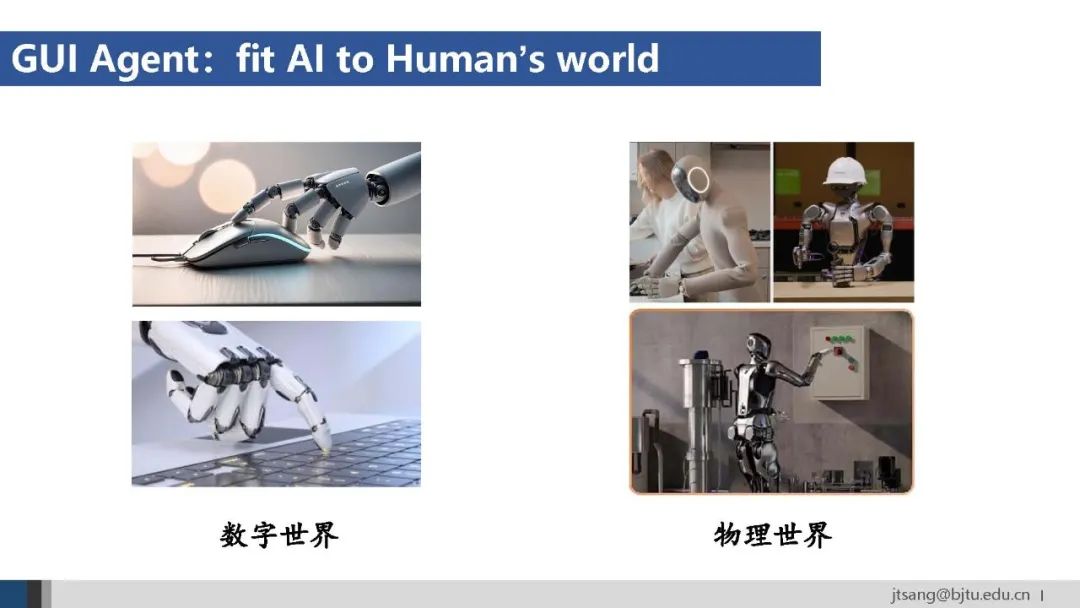

GUI Agent和API Agent代表了看待未来AI发展的两种思维。GUI Agent代表的是让AI适应人类的数字世界,人形机器人即是让AI适应人类的物理世界。

相比物理世界改造的困难,数字世界的改造要相对容易些。API Agent则希望为AI创建一个原生的世界,包括为AI专门设计的工具、交流语言等。

AutoCoA的框架主要面向的是API Agent。从4月中旬开始,几个大厂密集发布的工作,也证明端到端RL在API Agent上是跑得通的。

但在GUI Agent上,强如字节的UI-TARS,RL也只能在单步行动上训练。

问题可能出在是对GUI context的理解上:截屏的方法增加了感知环节,使得端到端训练难以进行;可访问树的方法由于信息丢失,会影响上下文信息的利用。

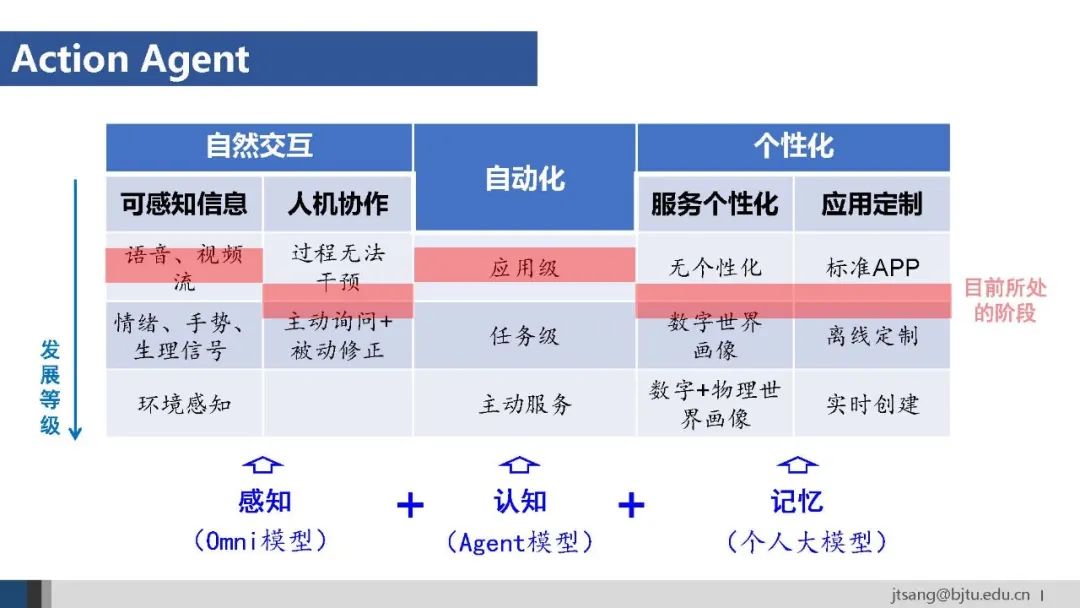

Action agent目前主要在各类终端上。Agent入口的层级从高到低有应用级、系统级和硬件级。

微信将元宝直接放到联系人中,再次体现了腾讯作为连接器的定位:通过微信连接人和信息-公众号,连接人和服务-小程序,甚至连接任何交易-微信支付。

终端agent应该具备自然交互、自动化、个性化三个特点。分别对应了感知、认知和记忆三方面主要能力。

Information agent从基于单次搜索的信息查询,发展到基于多次搜索的知识服务。

OpenAI的deep research进一步实现了面向任务完成的多次搜索优化,代表了未来AI Agent应用的重要方向。

人的信息处理能力,从查询、总结到综合分析,目前information agent已基本具备。更高级的创造能力,除了模型智能的提升,还需要更多的API接口、以及融合action agent与物理世界打通提供更多元的外部信息才可能实现。

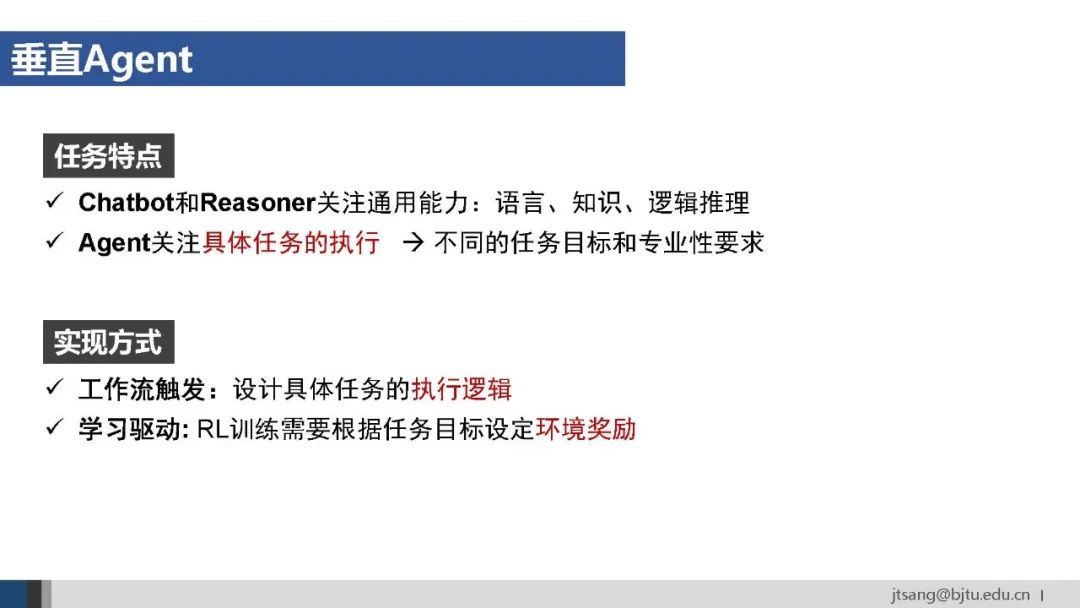

关于AI Agent应该通用还是垂直的讨论。

从任务特点看,agent与chatbot和reasoner不同,关注的是具体任务的执行,这也是“AI下半场”的另一种解释:从刷通用能力的benchmark到解决具体任务。

从实现方式看,工作流的方法需要面向任务设计具体的执行逻辑;基于RL学习的方法,则需要根据任务目标,设定准确的环境奖励。

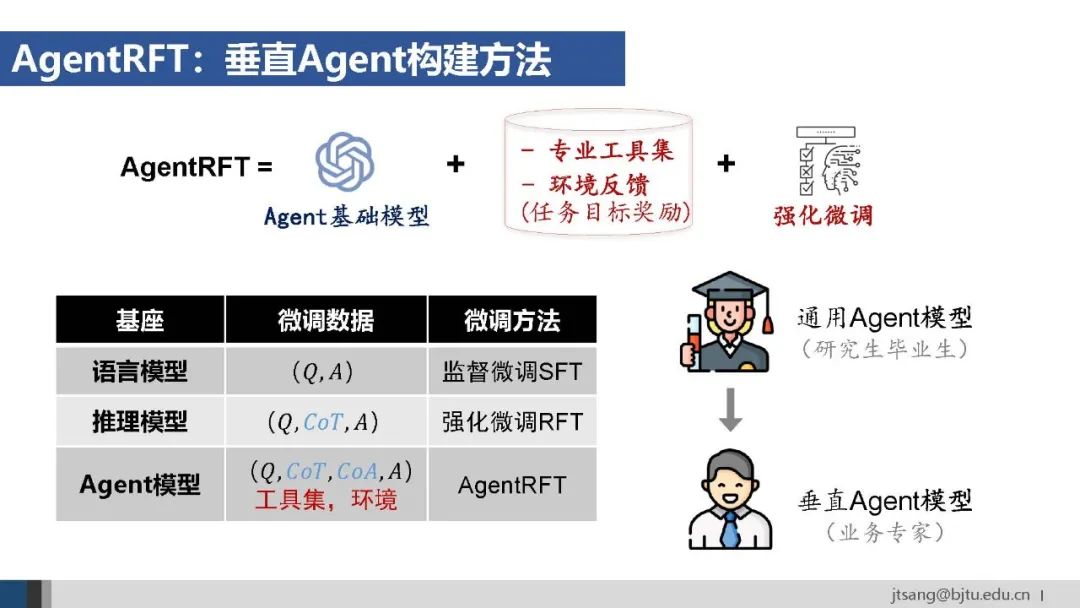

对o3等agent基础模型微调获得垂直agent的通用公式是:准备完成任务所需的专业工具集、受控环境内可验证的任务目标,然后进行强化微调。

随着o3、Qwen3等Agent基础模型成熟,就好像高素质的研究生毕业生供应增加。企业需要接下来结合具体任务继续培养,在特定工作上训练成为业务专家。

端到端训练垂直Agent,已经在广告(ICON)、网络安全(XBOW)、软件开发(Traversal)等领域有了成功案例。

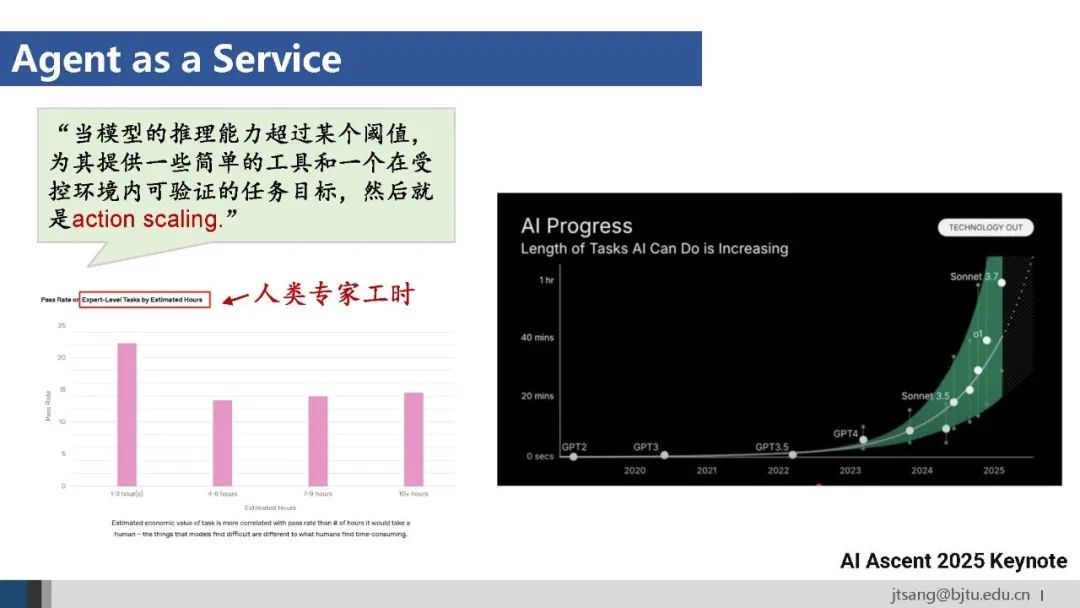

OpenAI开始用可替代的人类专家工时评估模型的能力,这表明agent逐步作为一种服务成为生产力。

Agent的生产力由模型智能、工具多样性和数据专业性三个因素决定。应用层不仅要承接最新模型成果,还需要从工具和数据两个方面向下优化模型。

与chatbot失效的数据飞轮不同,在agent阶段,普通用户的行动流数据对于提升模型能力还是有用的,所以AI Agent产品目前仍然存在数据飞轮。OpenAI收购Windsurf,很大程度上是看重其丰富的开发者agentic行为数据。

对比传统软件通过需求分析确定高频、标准、静态的需求,基于Agent的服务可以满足长尾、个性化、动态的需求。基于Agent的新一代软件的界面可能被高度简化为一个对话框,传统复杂的操作过程被隐藏,成为面向目标的服务交付。

如乔布斯40年前的预言,从how to do、what to do,到what I want,用户只需描述“我想要什么”,Agent自动完成“怎么做”。AI Agent代表了新的抽象层,已经无限接近人类思维。

正如网页和App是互联网信息的应用载体,agent是智能服务的载体。Agent的设计,因此应该更充分地发挥AI整合底层数据资源和工具生态的效率和能力。

这需要action agent和information agent的深度融合。马斯克曾说:电脑和手机是人的数字延伸,其带来的无限信息访问能力已经可以让我们成为超人了。

让AI像人一样操纵电脑,从而接管一切人类在屏幕前完成的工作,是OpenAI成立时就定下的目标。

随着action agent接入更多I/O,information agent可使用更多工具,AI Agent正在突破人类肉身的物理限制,可以以无限带宽连接世界。这不仅是完成人类的任务,更是让agent自主、持续地从人类世界学习和进化的方式。

Agent OS将成为AI Agent的运行基础。

任务规划、工具使用和记忆是AI Agent的三个基础能力。关于记忆,“大海捞针”评估的主要是单点信息检索的能力,agent解决复杂任务需要的是上下文理解和全局推理能力。

最近一年已经看到了任务规划和工具使用能力的发展,期待记忆机制的突破。

回到黄仁勋的主题演讲。

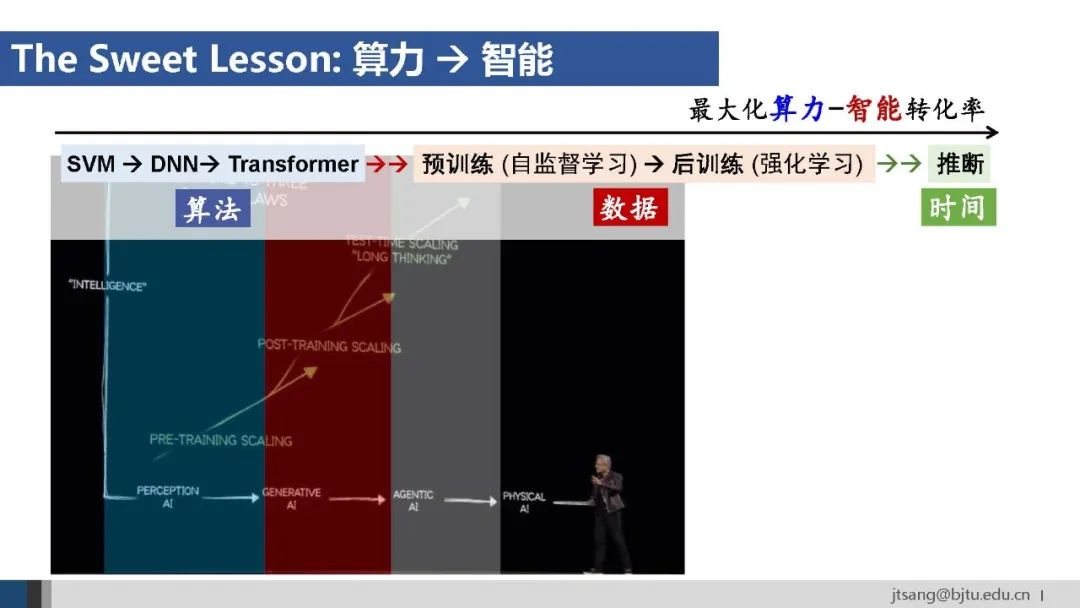

预训练、后训练、推断三阶段的scaling law,支撑着目前生成式AI和Agentic AI的发展。

这背后是从算力到智能的sweet lesson。

随着算力每年增长4-5倍,近十年的算力已经提升了百万倍。当算力资源成为主要的推动因素,AI发展的一条暗线是:如何将越来越多的算力以最高的效率转化为智能的提升。

这一过程分成了三个阶段。早期从SVM到DNN再到Transformer,是从算法侧消化算力,能在大量数据上训练大规模参数的模型,可以说到Transformer已基本收敛了。

接下来解决的是如何提供源源不断的数据。这包括了预训练基于自监督学习可以吃掉整个互联网的数据,以及后训练结合强化学习将算力转化为高质量的合成数据。

AI Agent是这一线索的延续:在推断阶段,用更多时间消耗更多算力,进一步提升智能水平。

进一步,从预训练到后训练再到推断的三个scaling law,不是简单的单向关系。

后训练中采样获得的高质量推理数据,推断阶段通过工具与外部环境交互获得的行为数据,可以反哺预训练,形成正向循环,实现智能的持续提升。

如何从零学会大模型?小白&程序员都能跟上的入门到进阶指南

当AI开始重构各行各业,你或许听过“岗位会被取代”的焦虑,但更关键的真相是:技术迭代中,“效率差”才是竞争力的核心——新岗位的生产效率远高于被替代岗位,整个社会的机会其实在增加。

但对个人而言,只有一句话算数:

“先掌握大模型的人,永远比后掌握的人,多一次职业跃迁的机会。”

回顾计算机、互联网、移动互联网的浪潮,每一次技术革命的初期,率先拥抱新技术的人,都提前拿到了“职场快车道”的门票。我在一线科技企业深耕12年,见过太多这样的案例:3年前主动学大模型的同事,如今要么成为团队技术负责人,要么薪资翻了2-3倍。

深知大模型学习中,“没人带、没方向、缺资源”是最大的拦路虎,我们联合行业专家整理出这套 《AI大模型突围资料包》,不管你是零基础小白,还是想转型的程序员,都能靠它少走90%的弯路:

- ✅ 小白友好的「从零到一学习路径图」(避开晦涩理论,先学能用的技能)

- ✅ 程序员必备的「大模型调优实战手册」(附医疗/金融大厂真实项目案例)

- ✅ 百度/阿里专家闭门录播课(拆解一线企业如何落地大模型)

- ✅ 2025最新大模型行业报告(看清各行业机会,避免盲目跟风)

- ✅ 大厂大模型面试真题(含答案解析,针对性准备offer)

- ✅ 2025大模型岗位需求图谱(明确不同岗位需要掌握的技能点)

所有资料已整理成包,想领《AI大模型入门+进阶学习资源包》的朋友,直接扫下方二维码获取~

① 全套AI大模型应用开发视频教程:从“听懂”到“会用”

不用啃复杂公式,直接学能落地的技术——不管你是想做AI应用,还是调优模型,这套视频都能覆盖:

- 小白入门:提示工程(让AI精准输出你要的结果)、RAG检索增强(解决AI“失忆”问题)

- 程序员进阶:LangChain框架实战(快速搭建AI应用)、Agent智能体开发(让AI自主完成复杂任务)

- 工程落地:模型微调与部署(把模型用到实际业务中)、DeepSeek模型实战(热门开源模型实操)

每个技术点都配“案例+代码演示”,跟着做就能上手!

课程精彩瞬间

② 大模型系统化学习路线:避免“学了就忘、越学越乱”

很多人学大模型走弯路,不是因为不努力,而是方向错了——比如小白一上来就啃深度学习理论,程序员跳过基础直接学微调,最后都卡在“用不起来”。

我们整理的这份「学习路线图」,按“基础→进阶→实战”分3个阶段,每个阶段都明确:

- 该学什么(比如基础阶段先学“AI基础概念+工具使用”)

- 不用学什么(比如小白初期不用深入研究Transformer底层数学原理)

- 学多久、用什么资料(精准匹配学习时间,避免拖延)

跟着路线走,零基础3个月能入门,有基础1个月能上手做项目!

③ 大模型学习书籍&文档:打好理论基础,走得更稳

想长期在大模型领域发展,理论基础不能少——但不用盲目买一堆书,我们精选了「小白能看懂、程序员能查漏」的核心资料:

- 入门书籍:《大模型实战指南》《AI提示工程入门》(用通俗语言讲清核心概念)

- 进阶文档:大模型调优技术白皮书、LangChain官方中文教程(附重点标注,节省阅读时间)

- 权威资料:斯坦福CS224N大模型课程笔记(整理成中文,避免语言障碍)

所有资料都是电子版,手机、电脑随时看,还能直接搜索重点!

④ AI大模型最新行业报告:看清机会,再动手

学技术的核心是“用对地方”——2025年哪些行业需要大模型人才?哪些应用场景最有前景?这份报告帮你理清:

- 行业趋势:医疗(AI辅助诊断)、金融(智能风控)、教育(个性化学习)等10大行业的大模型落地案例

- 岗位需求:大模型开发工程师、AI产品经理、提示工程师的职责差异与技能要求

- 风险提示:哪些领域目前落地难度大,避免浪费时间

不管你是想转行,还是想在现有岗位加技能,这份报告都能帮你精准定位!

⑤ 大模型大厂面试真题:针对性准备,拿offer更稳

学会技术后,如何把技能“变现”成offer?这份真题帮你避开面试坑:

- 基础题:“大模型的上下文窗口是什么?”“RAG的核心原理是什么?”(附标准答案框架)

- 实操题:“如何优化大模型的推理速度?”“用LangChain搭建一个多轮对话系统的步骤?”(含代码示例)

- 场景题:“如果大模型输出错误信息,该怎么解决?”(教你从技术+业务角度回答)

覆盖百度、阿里、腾讯、字节等大厂的最新面试题,帮你提前准备,面试时不慌!

以上资料如何领取?

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

为什么现在必须学大模型?不是焦虑,是事实

最近英特尔、微软等企业宣布裁员,但大模型相关岗位却在疯狂扩招:

- 大厂招聘:百度、阿里的大模型开发岗,3-5年经验薪资能到50K×20薪,比传统开发岗高40%;

- 中小公司:甚至很多传统企业(比如制造业、医疗公司)都在招“会用大模型的人”,要求不高但薪资可观;

- 门槛变化:不出1年,“有大模型项目经验”会成为很多技术岗、产品岗的简历门槛,现在学就是抢占先机。

风口不会等任何人——与其担心“被淘汰”,不如主动学技术,把“焦虑”变成“竞争力”!

最后:全套资料再领一次,别错过这次机会

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献242条内容

已为社区贡献242条内容

所有评论(0)