OmniVLA论文学习

纯ai翻译,有误请谅解。

纯ai翻译,有误请谅解。

项目链接:https://readerek.github.io/Objtac.github.io.

1.引言

触觉感知是人类灵巧操作能力的基础,使我们能够以惊人的精确性和适应性完成从穿针到处理易碎物品等复杂任务。尽管视觉能够提供整体的空间信息,但触觉感知具有互补优势:可直接测量接触动态(如压力分布、纹理),在视觉遮挡情况下依然可靠,并提供可用于实时控制的高频反馈(Dahiya et al., 2009)。这些生物学证据凸显了视觉—触觉融合在涉及物理交互的复杂操作任务中的关键作用。

在机器人领域,视觉与触觉感知的融合已成为提升操作能力的一个有前景的方向(Cui and Trinkle, 2021)。早期研究(Calandra et al., 2018;Li et al., 2018;Qi et al., 2023;Huang et al., 2024)主要关注小规模模型,通过结合视觉和触觉特征来解决特定任务,例如滑动检测或抓取稳定性预测。尽管这些方法证明了多模态感知的价值,但其适用范围有限,通常面向高度专用的应用,且难以在多样化的场景中实现泛化。

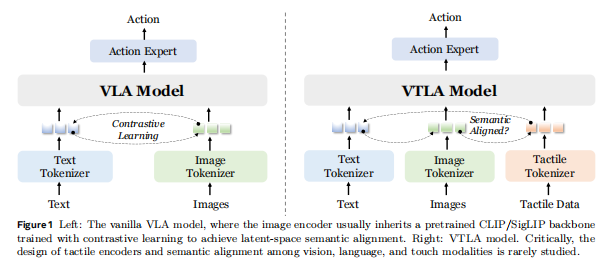

近年来,视觉-语言-动作(Vision-Language-Action, VLA)模型的发展(Brohan et al., 2023a; Kim et al., 2024a; Black et al., 2024; Team et al., 2025)极大推动了机器人操作能力的提升。这类模型利用大规模预训练视觉语言模型(VLMs)(Liu et al., 2023; Li et al., 2024; Zhang et al., 2025a; Bai et al., 2025)来理解自然语言指令和视觉观测,展现出很强的泛化潜力与智能性。然而,这些模型主要依赖视觉和语言,忽略了触觉所提供的丰富语义和物理反馈。现有尝试(Zhang et al., 2025b; Huang et al., 2025; Yu et al., 2025)在将触觉融入VLA框架时,大多将触觉数据视作低层信号,未能在语义层面将其与视觉与语言信息对齐。

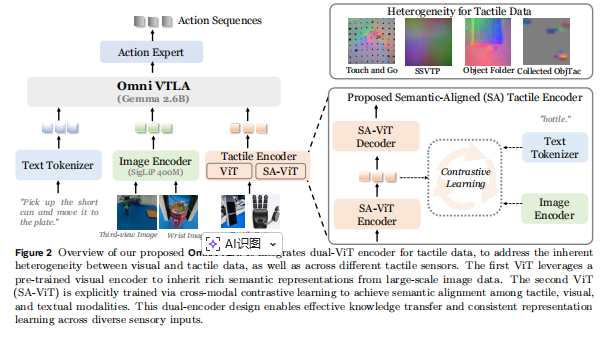

为弥补这一缺口,我们提出 OmniVTLA(Vision-Tactile-Language-Action Model),一种将视觉、触觉与语言统一到共享语义空间中的新型架构,如图1所示。VTLA 利用对比学习将高分辨率触觉信号与视觉和语言概念进行对齐,使机器人能够在“看到什么”和“被要求做什么”的语境下“理解自己触摸到了什么”。具体来说,我们提出了一条用于触觉数据的双编码器路径,以应对模态异质性,其中包括一个预训练视觉 Transformer(ViT)以及一个语义对齐的触觉 ViT(SA-ViT)。其次,我们构建了 ObjTac 数据集,涵盖 10 类共 56 个物体的文本、视觉与基于力的触觉数据,总计 135K 三模态样本。第三,我们利用跨传感器数据训练了一个语义对齐的触觉编码器,以学习统一的触觉表示,并作为 OmniVTLA 的更优初始化。

大量实验表明,VTLA 在性能上显著优于 VLA 基线方法。在搬取与放置任务中,VTLA 在夹爪执行中将成功率提高了 21.9%(达到 96.9%),在灵巧手执行中提高了 6.2%(达到 100%)。此外,VTLA 生成的轨迹更加平滑,符合直觉上的运动原则:“在环境开阔时快速移动,接触物体前才放慢速度。”

我们的贡献总结如下:

-

我们提出了 OmniVTLA,一个用于端到端高接触操作任务的全新框架,将视觉、触觉与语言统一建模。OmniVTLA 使用双编码器路径来克服不同触觉传感器之间的异质性问题。

-

我们构建了 ObjTac 数据集,一个全面的触觉数据集,包含 10 个类别、56 个物体的 135K 三模态样本。在此基础上,我们为 OmniVTLA 训练了一个语义对齐的触觉编码器。

-

真实世界实验表明,OmniVTLA 的性能显著优于典型的 VLA 模型,成功率最高提升 21.9%。此外,它还能减少任务完成时间,并使生成的轨迹更加平滑。

2.相关工作

触觉感知在感知任务中的应用

早期的触觉感知研究主要聚焦于处理低层物理信号(如力、振动、形变),以解决特定的感知任务,例如抓取稳定性预测(Calandra et al., 2018; Cui et al., 2020)和滑动检测(Li et al., 2018)。近期的工作逐渐转向学习更具泛化性的触觉表示,使其能够在任务、传感器和模态之间迁移。这些工作通过构建数据集(Fu et al., 2024; Cheng et al., 2025)、建立共享嵌入空间(Yang et al., 2024)、开发可迁移架构(Zhao et al., 2024)以及提出统一建模框架(Feng et al., 2025),展示了跨模态对齐和可泛化表示在触觉感知中的重要性。尽管这些方法提升了触觉感知能力,但它们仍然与动作策略的生成脱节,从而限制了其在机器人实时控制中的应用。此外,现有大多数研究使用基于视觉的触觉数据(如 GelSight(Yuan et al., 2017; Johnson and Adelson, 2009)),而对在机器人策略学习中同样常用的基于力的触觉数据关注较少。

视觉-触觉融合在操作任务中的研究

近年来,视觉-触觉策略学习在高接触操作中取得了显著进展。强化学习框架已被有效应用于将视觉与触觉输入结合用于装配任务(Lee et al., 2020; Hansen et al., 2022)以及灵巧手的手内操控(Hu et al., 2025)。更近期的趋势则倾向采用模仿学习范式(Yu et al., 2023; Lin et al., 2024; Huang et al., 2024; Xue et al., 2025; Liu et al., 2025),研究用于精细操作的视觉-触觉表示和系统架构。尽管这些方法在特定任务中获得了令人印象深刻的表现,但与视觉-语言-动作模型相比,它们在语义推理和泛化能力方面仍然存在局限。这一领域的不足正是我们的工作希望通过视觉-触觉语义融合来弥补的。

视觉-语言-动作模型

视觉-语言-动作(VLA)模型近年来成为构建通用机器人策略的重要范式。Brohan et al. (2023b) 率先提出将机器人动作表示为语言 token,从而实现来自网络规模预训练知识的迁移。Kim et al. (2024b) 通过 LoRA 微调提出了高效迁移的开源替代方案。随后的一系列研究(Team et al., 2024; Black et al., 2024; Liu et al., 2024; Bjorck et al., 2025)进一步扩展了该能力,引入基于 flow 或 diffusion 的动作生成方法(Chi et al., 2023)。在可扩展性(Wen et al., 2025; Team et al., 2025; Shukor et al., 2025)、推理机制(Zhao et al., 2025; Lin et al., 2025)以及三维扩展(Zhen et al., 2024; Qu et al., 2025)等方面的努力进一步增强了其适用性。

尽管 VLA 模型在开放世界泛化方面表现卓越,但其仅依赖视觉与语言,使其在需要高精度物理交互的高接触任务中表现受限。新兴的触觉增强方法尝试缓解这些限制,包括基于语言的传感器融合(Jones et al., 2025)、触觉参与的 VLA 学习(Hao et al., 2025; Zhang et al., 2025b)以及低维度力觉增强控制(Huang et al., 2025; Yu et al., 2025)。然而,这些方法尚未充分探索触觉编码器的设计。

我们的 OmniVTLA 框架在这一范式上实现了重要突破,通过统一的跨模态表示学习,为触觉建立了双编码器路径,从根本上推进了触觉在 VLA 系统中的融合方式。

3.方法

3.1 问题表述(Problem Formulation)

形式上,动作模型的目标是对分布进行建模,其中

表示对应的动作序列(H为动作块的长度),而

表示当前时刻的观测。

对于典型的 VLA 模型,观测通常包括若干 RGB 图像、语言提示以及机器人自身状态(proprioceptive state)。此时模型可形式化表示为:

其中表示第

个图像(例如第三视角图像或机械臂腕部相机图像),

是语言 token 序列。通常,图像

会使用对比式图像编码器

(如 CLIP、SigLIP)编码,该编码器一般基于 Vision Transformer(ViT)(Dosovitskiy et al., 2020),并投射至与文本 token 共享的潜在嵌入空间。

(MVLA(⋅)表示整个 VLA 模型)

相比之下,我们的 VTLA 模型目标是将触觉数据也纳入输入,如图 2 所示。其模型形式为:

其中 表示第

个触觉数据源,例如安装在双指夹爪指尖的触觉传感器,或灵巧手多个手指与手掌的触觉传感器。

表示触觉编码器。

直观来看,可以将触觉数据重新映射为张量,并借用类似 ViT 的结构按“图像方式”进行编码,但触觉数据的特性与视觉数据显著不同。因此,本研究的目标是探索不同的触觉编码器及其训练策略,以确定 VTLA 的最佳架构。

3.2 具有双编码器路径的整体架构

如图 2 所示,所提出的 OmniVTLA 架构构建于 π0(Black et al., 2024)的基础之上。它由三个核心组件组成:tokenizer(分词器)、**backbone(骨干网络)**以及 action head(动作头)。

分词器负责处理三类输入:

-

使用 PaliGemma tokenizer(词表大小:257,152)对语言指令

进行处理;

-

使用 SigLIP 模型(Zhai et al., 2023)编码图像观测

;

-

对触觉观测

进行编码,将所有模态映射到潜在 token 空间。

具体而言,对于图像(包括第三视角和腕部视角),我们将原始图像调整为 224 × 224 的分辨率,每张图像生成 256 个 token。对于触觉数据,我们将值域归一化到 int8,并将多个触觉传感器的输出拼接成单张图像,再通过 ViT 类似的编码器处理为 224 × 224 的输入,生成 256 个 token。

之后,Gemma-2B 的 backbone 处理拼接后的多模态 token,生成动作 token,再由 action head 通过 flow matching 损失(与 π0 一致)解码为最终动作。

动作表示依执行器类型而异:

-

对于双指夹爪,用 10 个 token 表示(3 个相对位置、6 个相对角度、1 个夹爪状态);

-

对于四指机械手,用 25 个 token 表示(3 个相对位置、6 个相对角度、16 个绝对关节角)。

触觉编码器设计中的关键挑战

现有工作未充分重视触觉编码器的设计,主要由于触觉数据存在两类异质性:

-

触觉与视觉数据之间的差异

-

不同触觉传感器之间的差异(图 2 左上角给出了示例)

此外,不同触觉数据集(如 TAG (Yang et al., 2022)、SSVTP (Kerr et al., 2023)、ObjectFolder (Gao et al., 2021))之间的数据形式差异很大,使得统一的触觉编码器设计更加困难。

因此,我们探索了四种不同的触觉编码器,其详细实验结果在 Sec. 4.2 中给出:

-

VTLA-FS:从零开始训练触觉编码器,仅依赖有限的遥操作触觉数据。

-

VTLA-Pre:用大规模视觉数据预训练模型初始化触觉编码器,并在少量遥操作数据上微调。

-

VTLA-SA:先基于跨模态对比学习进行语义对齐训练(见 Sec. 3.3),再在少量数据上微调。

-

OmniVTLA:使用双编码器路径,其中一条为 VTLA-Pre,另一条为 VTLA-SA。

触觉传感器异质性的原因

触觉传感器因原理不同而产生明显差异:

-

视觉型触觉传感器(如 GelSight (Yuan et al., 2017; Johnson & Adelson, 2009))

→ 捕获高分辨率的表面形貌,但时间分辨率较低(最多约 30Hz) -

基于力的触觉传感器(如 Paxini Gen2 (Paxini, 2025))

→ 空间分辨率较低,但时间分辨率高(适合捕捉快速接触事件)

因此,力类触觉传感器能够有效补充视觉模态的信息。

为了处理不同触觉传感器之间的异质性,我们提出了双 ViT 编码器(dual-encoder path),通过拼接其输出 token,使模型能够实现跨传感器理解。这构成了 OmniVTLA 中触觉编码器的重要组成部分。

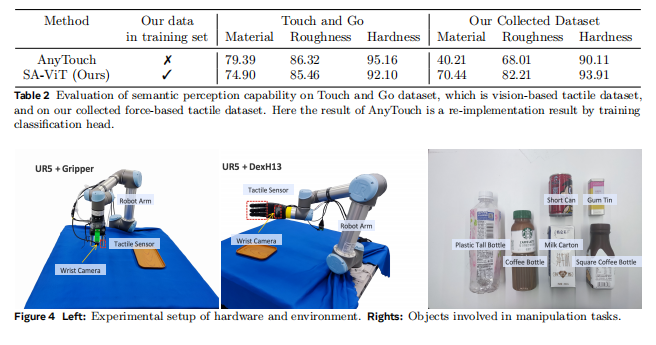

3.3 语义对齐触觉编码器(Semantic-Aligned Tactile Encoder)

尽管已有工作(Feng et al., 2025)探索了视觉-触觉传感器的统一表示,但其方法难以推广到基于力的触觉感知。如表 2 所示,预训练的 AnyTouch 编码器在基于力的数据集上仅取得 40.21% 的材质分类准确率,显示出严重的跨传感器迁移限制。

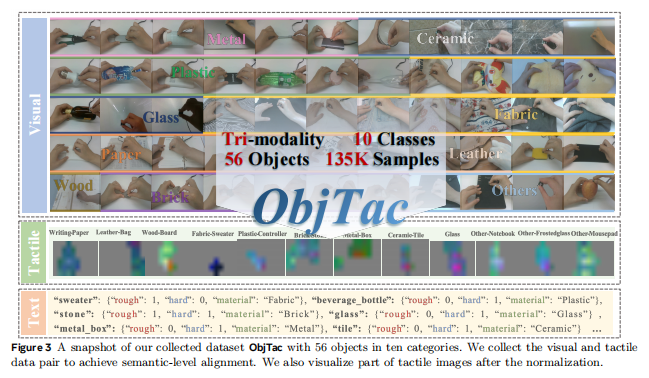

为解决这一问题,我们构建了自有数据集 ObjTac,其中包含对齐的文本、视频和力觉触觉数据。我们为 56 个不同物体收集了触觉-视觉配对数据,如图 3 所示。最终数据集包含 10 种物体类型(塑料、玻璃、木材、砖块、金属、织物、皮革、陶瓷、纸张及其他),并按表面粗糙度(粗糙 vs 光滑)和材料硬度(刚性 vs 柔软)进行分类。我们收集的数据集将于近期公开发布。

数据采集与处理流程

-

交互实验:

每个物体进行 2–5 次交互试验,每次 10–60 秒(采样率 60 Hz),共获得 270,000 条力觉数据记录。

同时采集第一视角视频,分辨率 720P,帧率 30 FPS,共得到 252 条视频序列,平均时长 18 秒。

最终收集 135K 样本,每个样本包含配对的触觉与视觉数据。 -

语言注释:

对每个物体添加对象级别的注释,包括:物体名称、材料类型、粗糙度类别、硬度类别、视频级元数据以及文本描述。 -

时间同步:

使用时间戳对视觉和触觉模态进行同步对齐。

语义对齐编码器训练

为了训练更优的语义对齐触觉编码器,我们将 ObjTac 数据集与现有数据集合并,并采用 AnyTouch 的二阶段训练流程(Feng et al., 2025),实现多模态和跨传感器对齐。

由于我们的数据集包含三模态数据对,对于新增数据,我们直接使用总对齐损失:

其中:

-

表示单批次内从视觉到语言的损失(参考 CLIP (Radford et al., 2021))

-

,

,

为超参数

-

另外,还将 跨传感器匹配损失(binary cross-entropy) 纳入总损失

效果与意义

通过加入 ObjTac 数据集,这个语义对齐触觉编码器能够更好地适应实际使用的触觉传感器,并在视觉与语言语境中对触觉信号(如材质、粗糙度、硬度)进行语义对齐。

如表 2 所示,SA-ViT 在基于力的触觉数据集上实现了显著更高的分类准确率,同时在视觉触觉数据集(Touch and Go)上保持了接近基线的性能。

后续实验等暂略

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)