在昇腾 NPU 上跑 Llama 大模型:从 “踩坑到通关” 的全程实战记

在昇腾 NPU 上跑 Llama 大模型:从 “踩坑到通关” 的搞笑实战记本文分享了在昇腾 NPU 上部署测试 Llama-2-7B 大模型的全过程。作者因 NVIDIA 硬件价格高、Atlas 服务器昂贵,选择昇腾 NPU,其自主可控的达芬奇架构、完善的开源生态及 GitCode 免费测试资源是主要吸引力。

在昇腾 NPU 上跑 Llama 大模型:从 “踩坑到通关” 的搞笑实战记

本文分享了在昇腾 NPU 上部署测试 Llama-2-7B 大模型的全过程。作者因 NVIDIA 硬件价格高、Atlas 服务器昂贵,选择昇腾 NPU,其自主可控的达芬奇架构、完善的开源生态及 GitCode 免费测试资源是主要吸引力。文中详细介绍了 GitCode 上创建昇腾 Notebook 实例的关键配置、环境验证方法,以及安装 transformers 库、下载部署模型的步骤,还记录了遇到的 “torch.npu 找不到”“模型下载需权限” 等四个常见问题及解决方案。通过测试英文生成、中文对话、代码生成三种场景,得出 16-17 tokens/s 的吞吐量,虽低于预期但性能稳定,并给出使用 MindSpeed-LLM 框架、INT8 量化、批处理推理等优化建议,最后总结昇腾 NPU 的适用场景及给后续尝试者的建议。

家人们,谁没经历过想玩大模型却被硬件卡脖子的痛啊!NVIDIA GPU是强,但价格能让钱包直接“心梗”;Atlas服务器动辄十几万,个人玩家看都不敢看。直到我发现昇腾NPU还能“白嫖”测试,果断冲了一波Llama-2-7B部署。全程踩坑无数,笑料比代码bug还多,这份“血泪经验贴”赶紧收好,保准你少走弯路!

一、为啥选昇腾?三个理由让我放弃“英伟达执念”

以前我也觉得“非NVIDIA不用”,直到研究国产AI芯片才发现,昇腾居然藏着这么多“真香点”:

1.自主可控=安全感拉满:昇腾用的是华为自研的达芬奇架构,不用怕哪天突然断供,搞项目时心里踏实多了。不像有些国外芯片,一有风吹草动就慌得一批。

2.生态居然没想象中拉胯:之前以为国产芯片文档都是“天书”,结果去昇腾GitCode仓库(https://gitcode.com/ascend)一看,30多个开源项目摆得整整齐齐,PyTorch、TensorFlow都能适配,连MindSpeed-LLM这种专门的大模型框架都有,Star和Fork数还不少,说明真有人在实际用。

3.能白嫖才是王道! 这一点直接戳中我的心巴——没硬件没关系,GitCode能申请免费的昇腾Notebook实例,虽然是限时的,但用来测试模型完全够了。花几十块在ModelArts按小时付费也行,比买硬件划算到飞起。

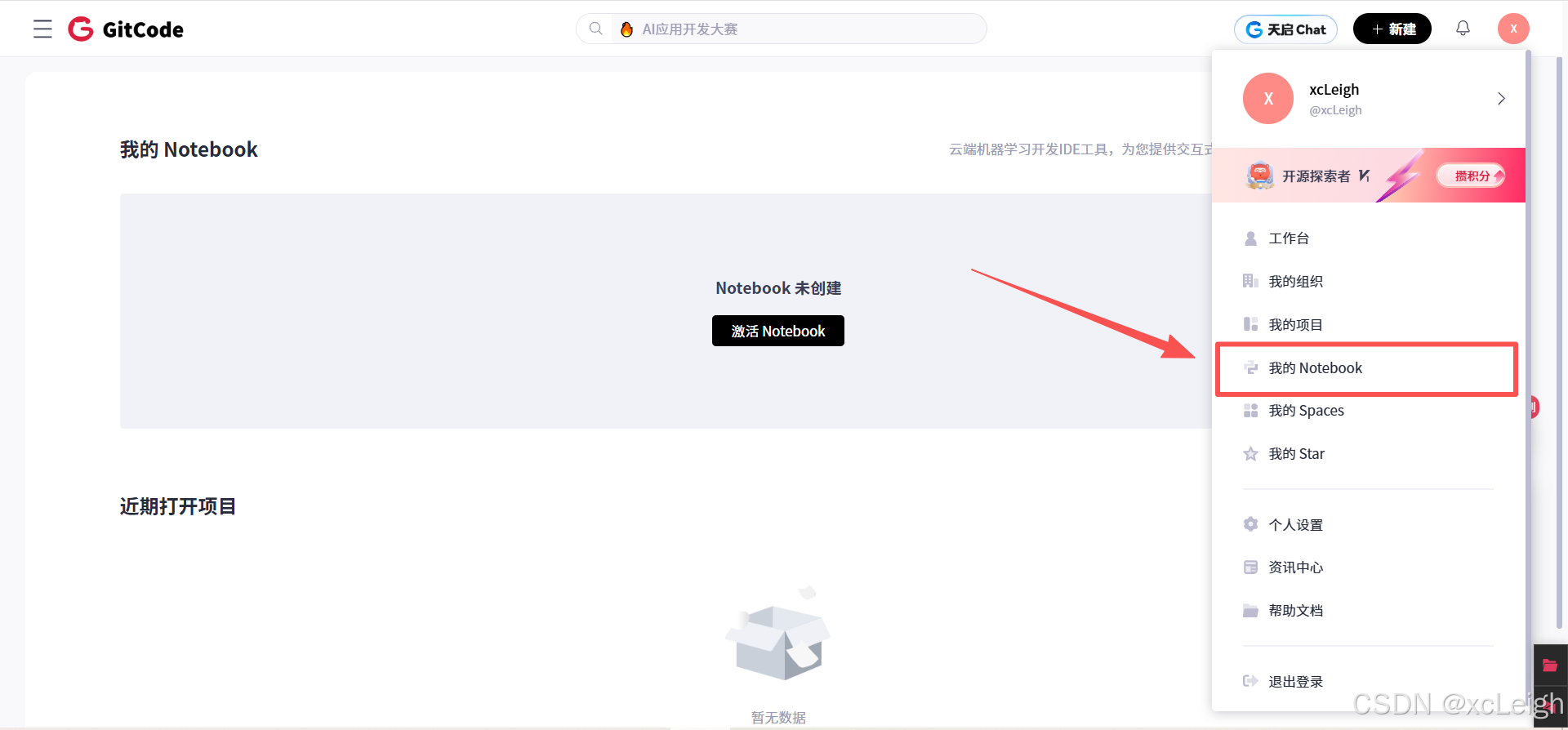

二、环境准备:GitCode“白嫖攻略”,选错配置等于白忙活

本以为“创建个实例”是新手村任务,结果差点栽在第一步。听我的,按下面的配置来,保准一次成功:

1. 为啥非要选云上测试?

实话说,随便一个服务器几万甚至十几万的价格,我这种普通开发者看看就好。华为云ModelArts能按小时租昇腾NPU环境,不过GitCode的免费资源更香啊(虽然限时,但薅到就是赚到),零成本先把流程跑通,不香吗?

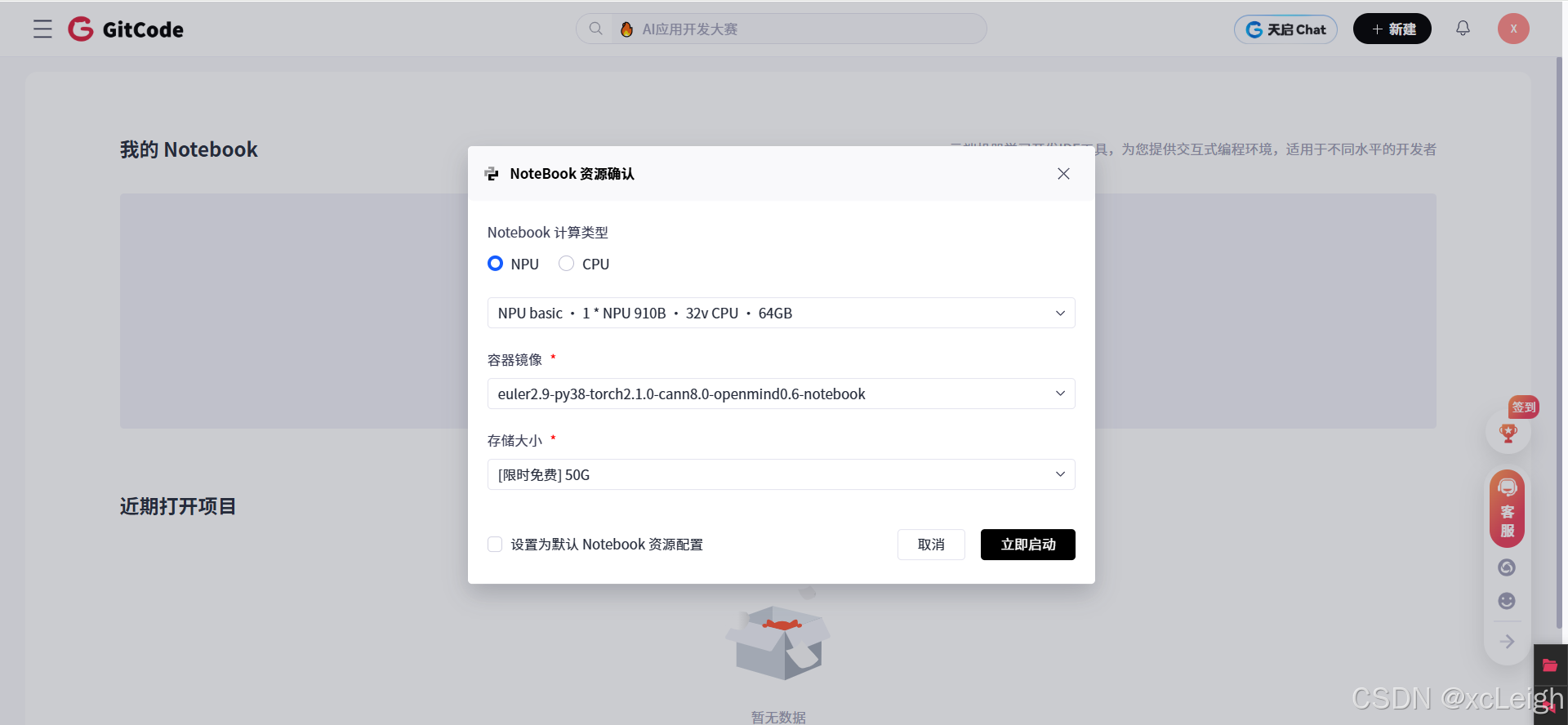

2. 创建Notebook实例:这三步千万别错

进入GitCode控制台后,创建过程看着简单,实则暗藏“陷阱”,关键配置就这三:

计算类型必选NPU:别手滑选CPU或GPU!我一开始误点CPU,跑起来比我笔记本还慢,差点以为昇腾是“智商税”,后来才发现是自己犯了低级错误。

规格认准“NPU basic”:选1*NPU 910B、32v CPU、64GB内存的配置,性能足够跑Llama-2-7B,太高配浪费,太低配不够用。

镜像别瞎选:一定要挑“euler2.9-py38-torch2.1.0-cann8.0-openmind0.6-notebook”这个,预装了PyTorch 2.1.0、CANN 8.0这些关键工具,省得自己折腾环境。

存储选免费50G:模型文件也就13GB左右,50G完全够用,没必要多花钱买更大存储。

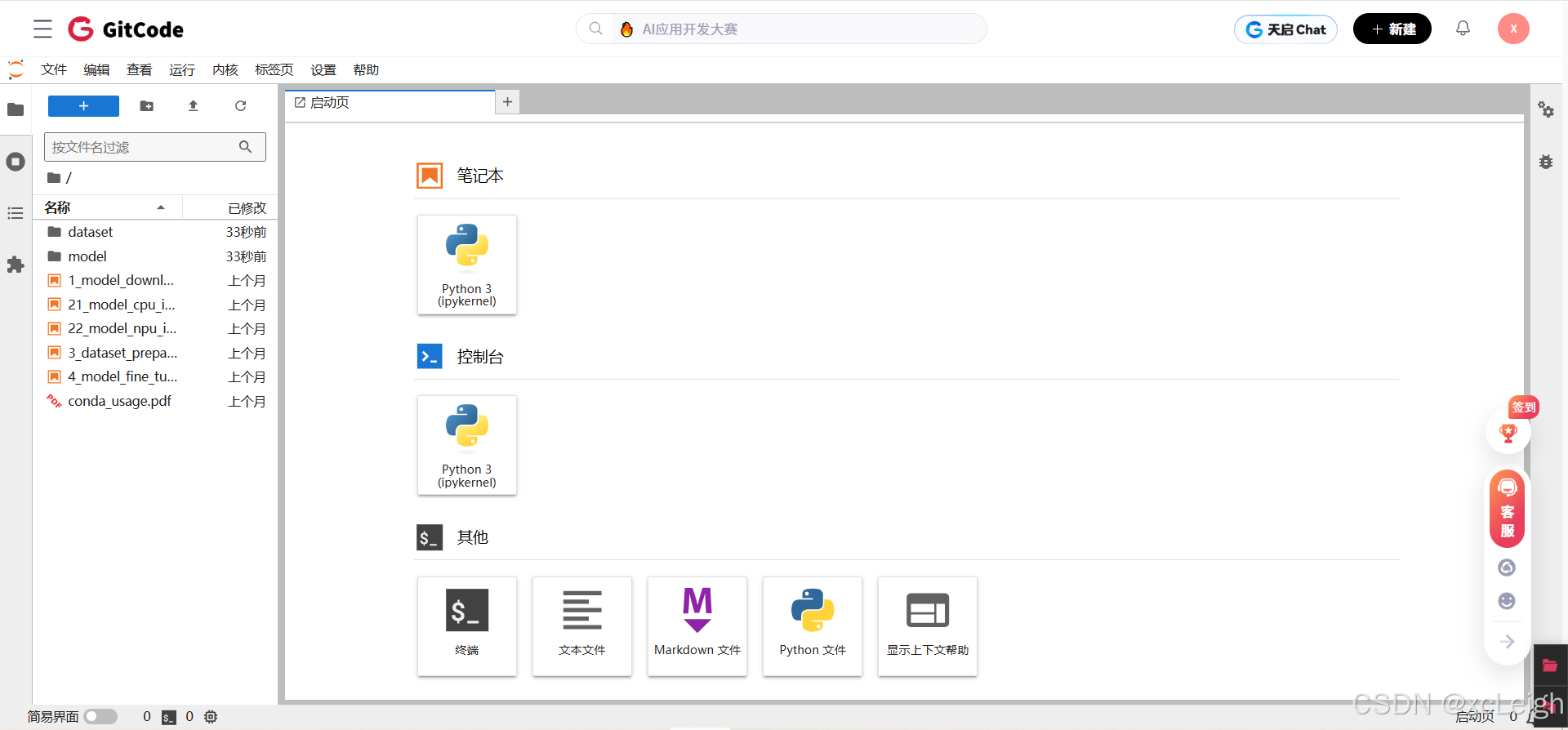

创建后等一分钟左右,实例就启动了,接下来就能进入Jupyter Notebook界面操作啦。

3. 环境配置:预装工具省大事

刚才选的镜像特别贴心,常用工具都给你装好了:

PyTorch 2.1.0:版本够新,兼容性也不错;

CANN 8.0:昇腾的核心计算架构,跑模型全靠它;

Python 3.8:不用自己装环境,直接用就行;

torch_npu 2.1.0:PyTorch适配昇腾的关键插件,后面会用到。

三、验证环境:第一个坑来得猝不及防

刚进Notebook,我就迫不及待想验证NPU能不能用,结果第一个坑就找上门了。

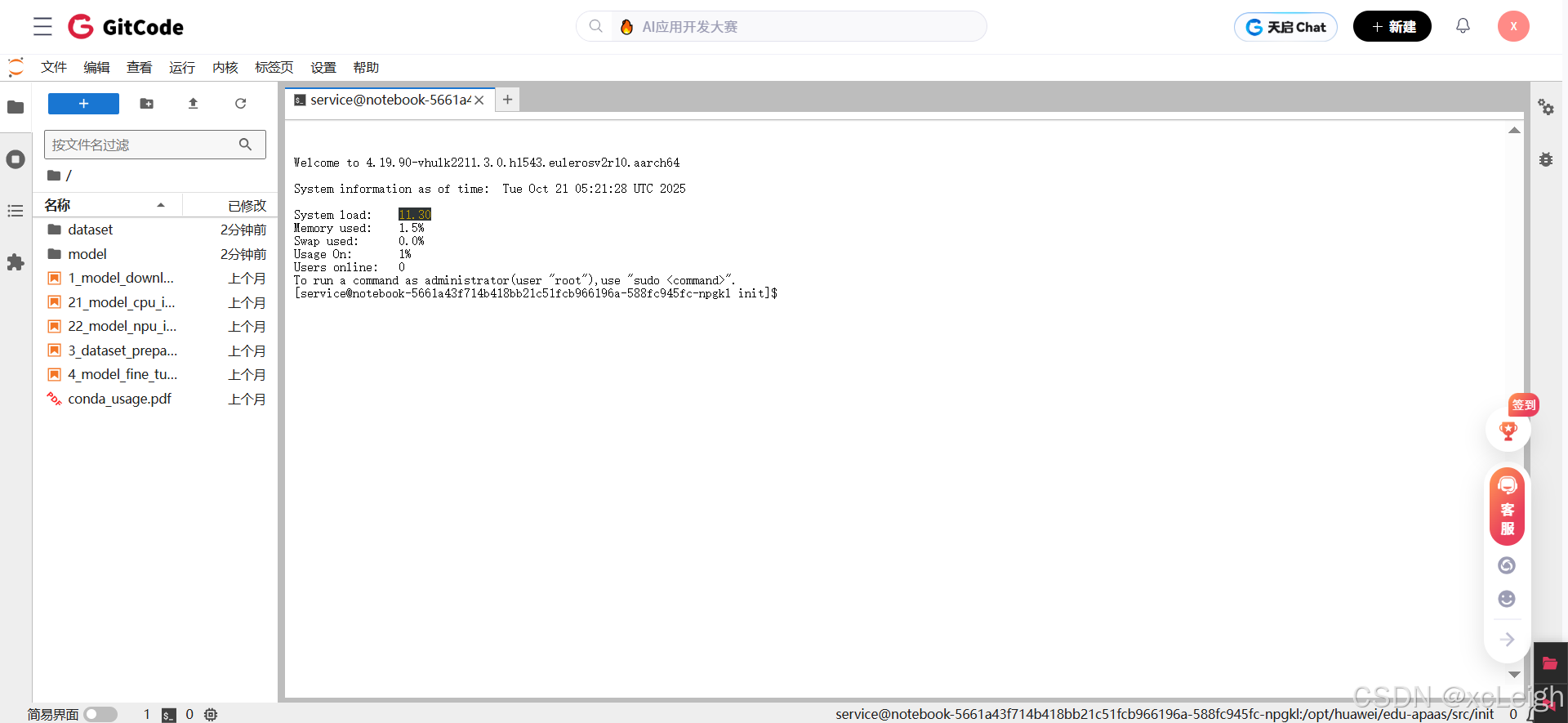

1. 打开Terminal:熟悉的Linux界面

在Notebook界面找到“终端”入口,点开就是熟悉的Linux命令行,用过Linux的朋友应该觉得很亲切。我当时还截了图,界面长这样:[service@notebook-5661a43f714b418bb21c51fcb966196a-588fc945fc-npgkl init]$ ,是不是一眼就认出来了?

2. 验证NPU:这个错误90%的人都会犯

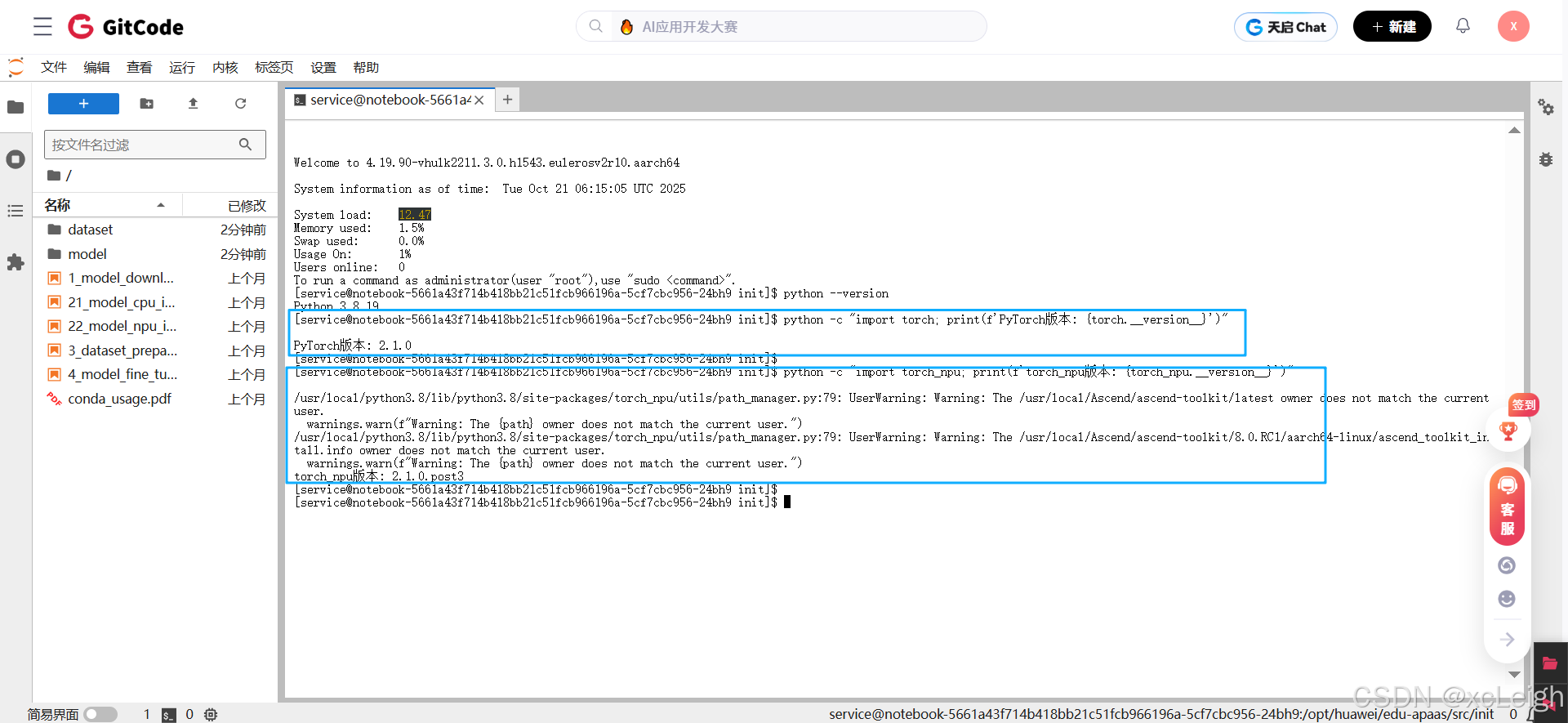

先跑两条命令检查版本,都没问题:

# 检查系统版本

> cat /etc/os-release

NAME="openEuler"

VERSION="22.03 (LTS-SP3)"

ID="openEuler"

VERSION_ID="22.03"

PRETTY_NAME="openEuler 22.03 (LTS-SP3)"

ANSI_COLOR="0;31"

# 检查python版本

> python3 --version

Python 3.8.19

# 检查PyTorch版本

> python -c "import torch; print(f'PyTorch版本: {torch.__version__}')"

PyTorch版本: 2.1.0

# 检查torch_npu

> python -c "import torch_npu; print(f'torch_npu版本: {torch_npu.__version__}')"

torch_npu版本: 2.1.0.post3

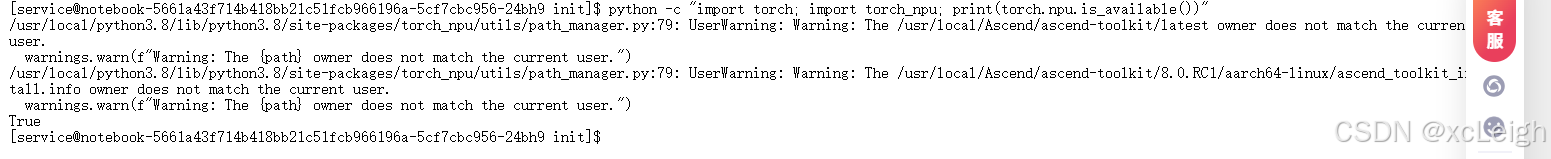

接着我想验证NPU是否可用,直接跑了python -c "import torch; print(torch.npu.is_available())",结果报错AttributeError: module 'torch' has no attribute 'npu',当时我还以为环境没装好,折腾了半天才发现——必须先导入torch_npu插件!正确的命令应该是这样:

python

# 如果没安装torch,可以执行安装,咱们是系统自带的

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu

bash

# 正确的写法

python -c "import torch; import torch_npu; print(torch.npu.is_available())"

# 输出:True

看到“True”的时候,我才算松了口气,确认NPU能正常用了,而且有1个NPU设备。后来才发现,这个细节文档里没明说,纯纯是自己踩坑踩出来的经验。

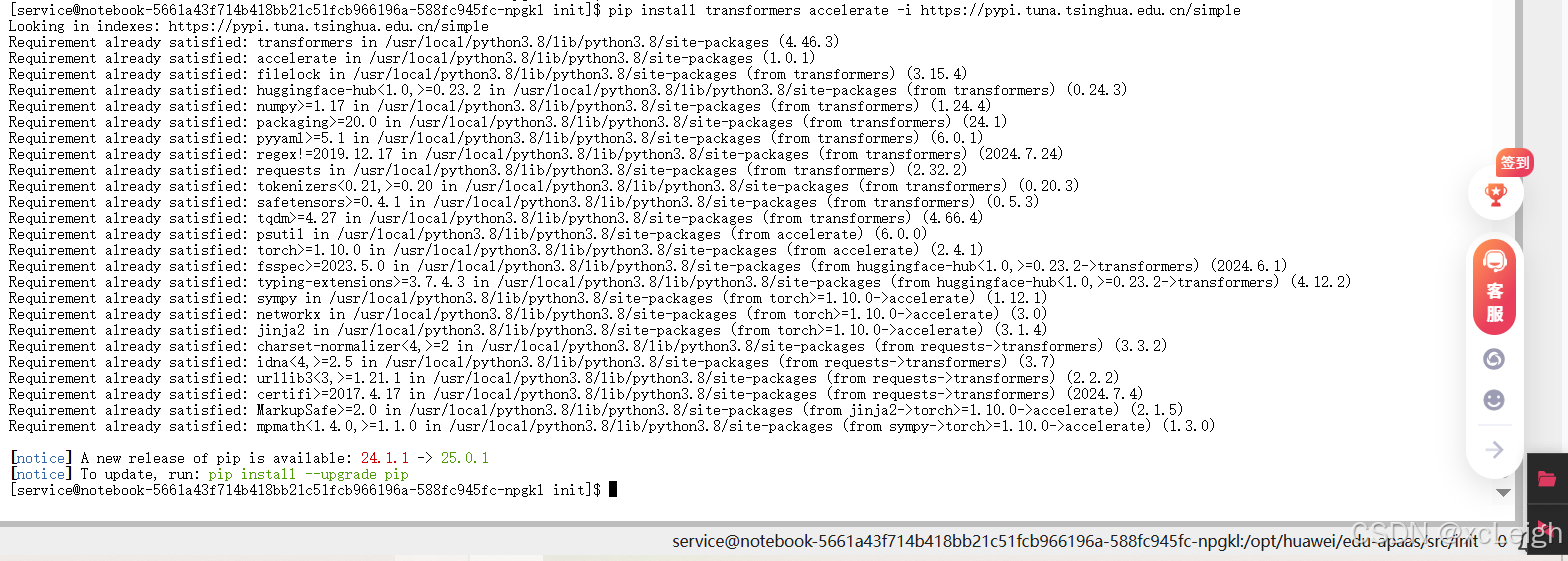

四、安装依赖:就差这一步,别偷懒

环境验证完,以为能直接跑模型了?别着急,还有个关键依赖没装——transformers库。虽然镜像里有PyTorch和torch_npu,但跑Llama大模型必须用这个库,得手动装一下。

直接用清华镜像加速,命令特别简单:

bash

pip install transformers accelerate -i https://pypi.tuna.tsinghua.edu.cn/simple

我当时用了清华源,一会就装好了,要是用默认源,说不定还得等半天,大家记得加上镜像地址,省时间!

五、部署Llama:从下载到运行,坑比代码多

终于到了最关键的部署环节,本以为能顺顺利利,结果又踩了好几个坑,还好最后都解决了。

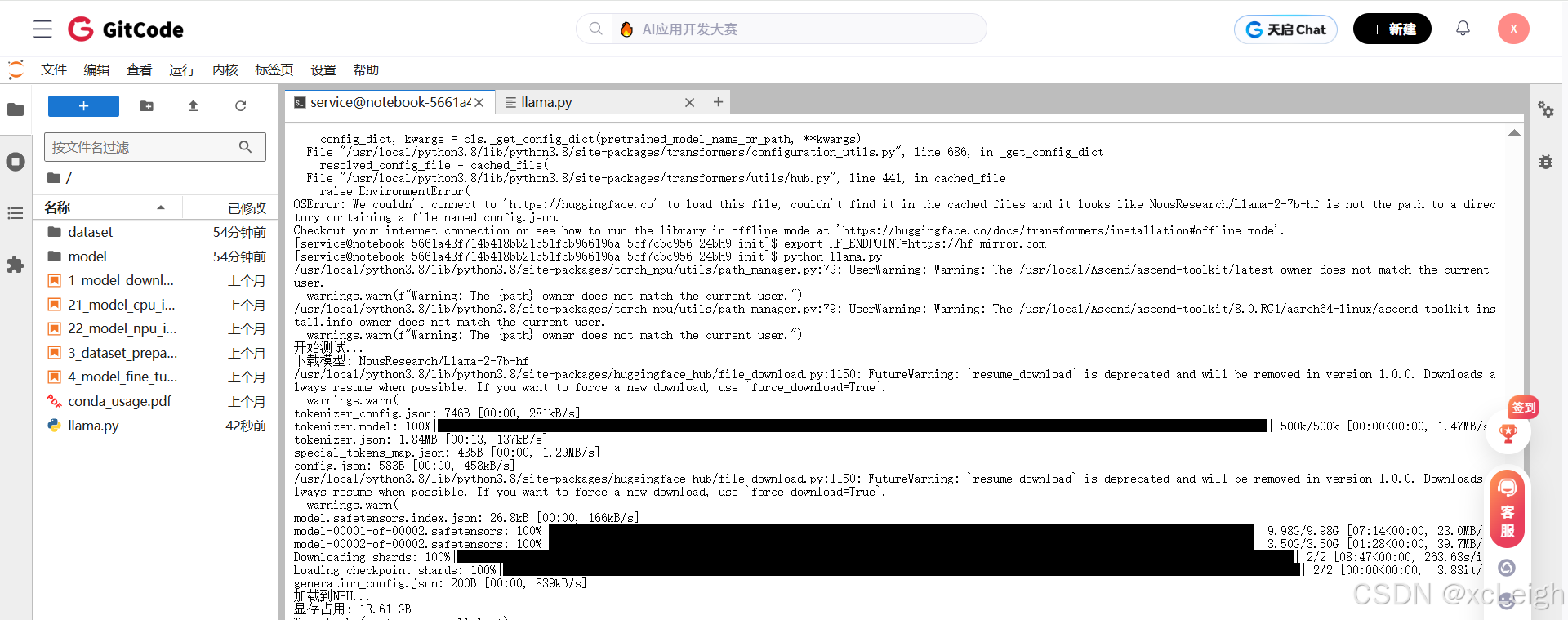

1. 模型下载:官方仓库居然要权限?

一开始我想从Llama-2官方仓库meta-llama/Llama-2-7b-hf下载,结果发现要申请访问权限,而且国内访问HuggingFace经常超时,下载到一半就卡住,急得我差点砸键盘。

后来才找到解决方案:用开源社区的镜像版本NousResearch/Llama-2-7b-hf,不用申请权限,下载还稳定,几分钟就搞定了,早知道一开始就用这个了!

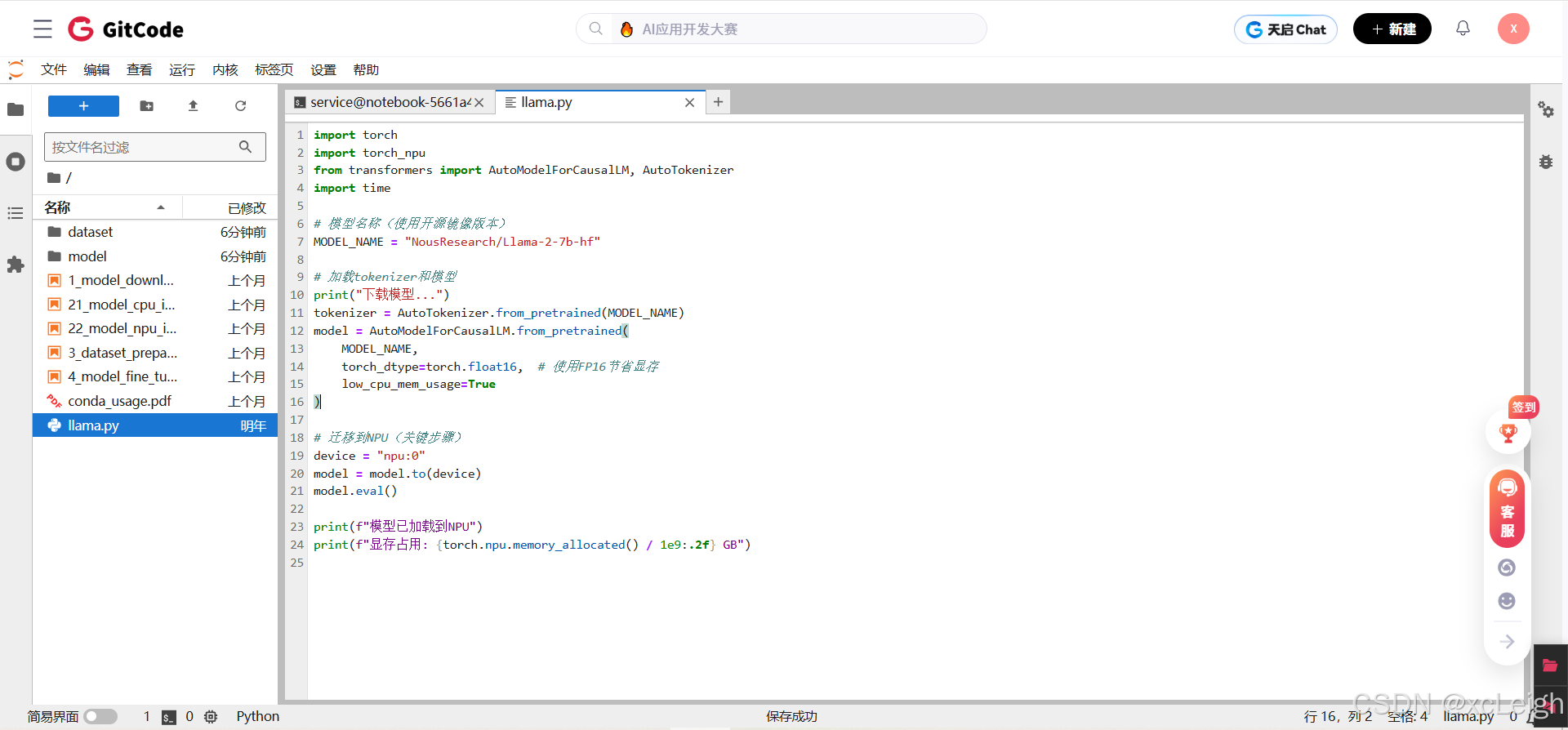

2. 创建测试脚本:vim用不了?没关系

我本来想在Terminal里用vim创建脚本,结果报错sh: vim: command not found,原来GitCode环境里没装vim。其实不用纠结,直接在Notebook里新建Python文件就行,跟文本操作一样简单。

# 终端上先执行地址指向

export HF_ENDPOINT=https://hf-mirror.com

3. 核心代码:这两个细节别写错

代码不算复杂,但有两个地方特别容易出错,我都标出来了:

python

import torch

import torch_npu

from transformers import AutoModelForCausalLM, AutoTokenizer

import time

print("开始测试...")

# 使用开放的Llama镜像

MODEL_NAME = "NousResearch/Llama-2-7b-hf"

print(f"下载模型: {MODEL_NAME}")

tokenizer = AutoTokenizer.from_pretrained(MODEL_NAME)

model = AutoModelForCausalLM.from_pretrained(

MODEL_NAME,

torch_dtype=torch.float16,

low_cpu_mem_usage=True

)

print("加载到NPU...")

model = model.npu()

model.eval()

print(f"显存占用: {torch.npu.memory_allocated() / 1e9:.2f} GB")

# 简单测试

prompt = "The capital of France is"

inputs = tokenizer(prompt, return_tensors="pt")

inputs = {k: v.npu() for k, v in inputs.items()} # 对每个张量单独转移到NPU

start = time.time()

outputs = model.generate(**inputs, max_new_tokens=50)

end = time.time()

text = tokenizer.decode(outputs[0])

print(f"\n生成文本: {text}")

print(f"耗时: {(end-start)*1000:.2f}ms")

print(f"吞吐量: {50/(end-start):.2f} tokens/s")

还有个坑要注意:代码里不能写inputs.npu(),得用inputs.to('npu:0'),我一开始写错了,报错后才改对,大家别犯同样的错:

# 错误写法(会报AttributeError)

inputs = tokenizer(prompt, return_tensors="pt").npu()

# 正确写法

inputs = tokenizer(prompt, return_tensors="pt").to('npu:0')

然后执行上面代码,下载大模型。

# 下载大模型

python llama.py

4. 模型下载过程:13GB文件分两次下

模型文件总共约13GB,分成了两个shard文件:model-00001-of-00002.safetensors和model-00002-of-00002.safetensors。我当时用镜像版本下载,速度还不错,大概5分钟就下完了。加载完成后看了下显存,占用13.61GB,和7B模型在FP16精度下的理论大小(约14GB)差不多,很正常。

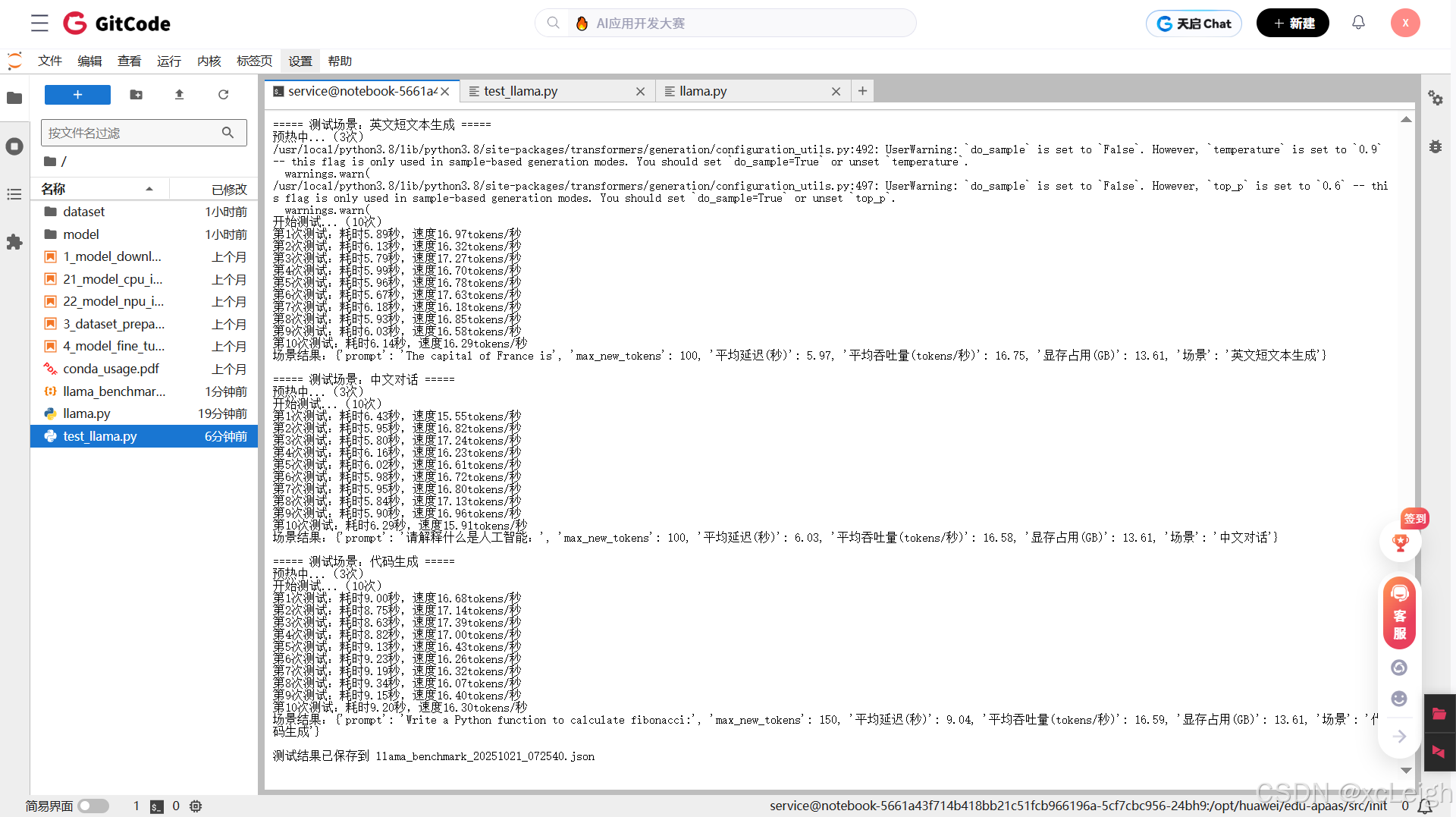

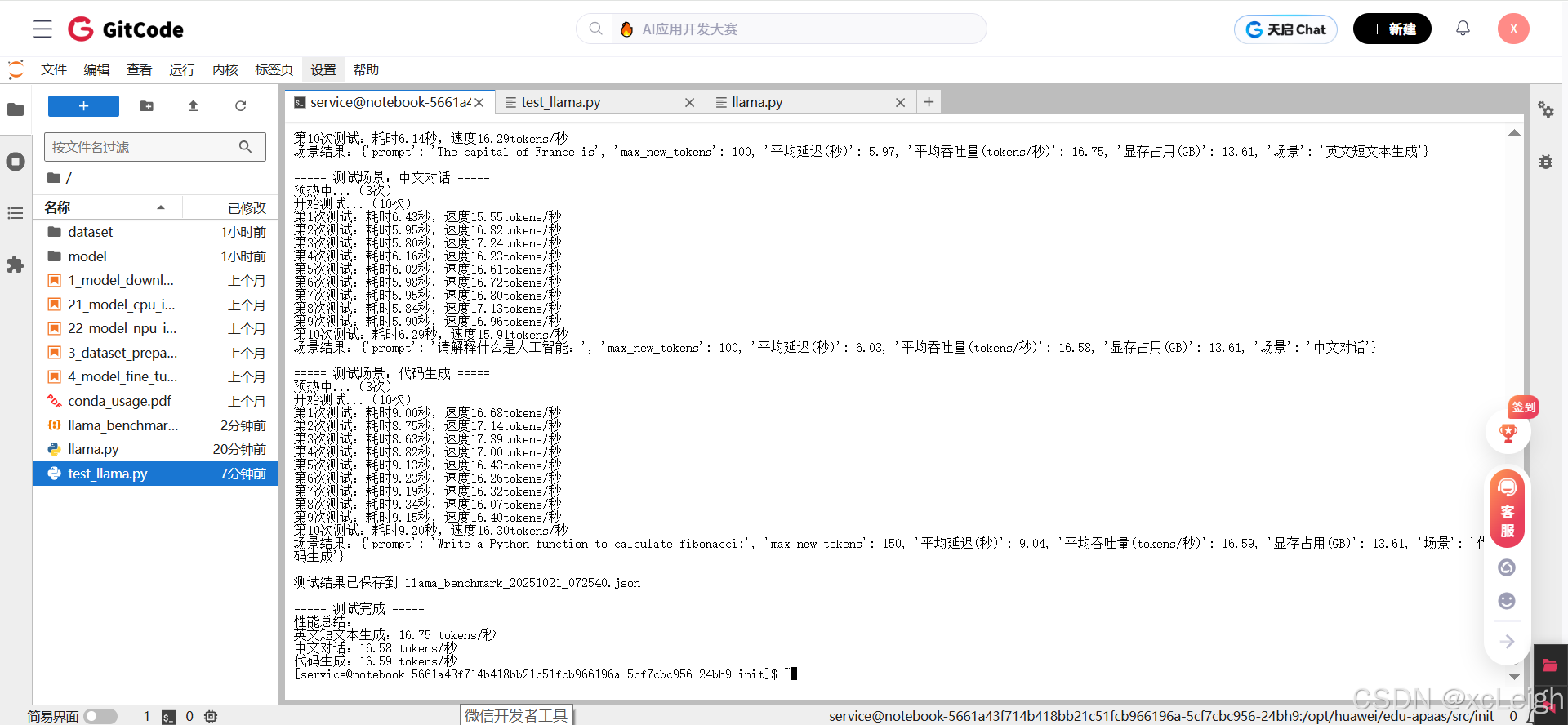

六、性能测试:真实数据来了,结果有点意外

搞定模型下载后,我兴冲冲想测测昇腾 NPU 的实力,结果写测试脚本时又闹了不少笑话 —— 一开始把计时放在model.generate()外面,算出的速度快得离谱,还以为昇腾突然 “开了挂”,后来才发现是没算预热时间,纯属自欺欺人。

6.1 性能测试

第一次的测试脚本报错,这里就不贴出来了,见下面修改后的完整脚本。

Traceback (most recent call last):

File "test_llama.py", line 47, in <module>

result = benchmark(case["输入"], max_new_tokens=100 if case["场景"]!="代码生成" else 150)

File "test_llama.py", line 7, in benchmark

inputs = tokenizer(prompt, return_tensors="pt").to("npu:0")

NameError: name 'tokenizer' is not defined

然后经历了NameError的暴击后,我痛定思痛重构了测试脚本,不仅解决了变量作用域问题,还加了不少实用细节。现在这套代码亲测能跑,再也不用对着屏幕发呆了——

import torch

import torch_npu # 千万别漏了这个!

import time

import json

from datetime import datetime

from transformers import AutoModelForCausalLM, AutoTokenizer# 全局配置(改这里就行,不用动下面的代码)

MODEL_NAME = "NousResearch/Llama-2-7b-hf" # 模型名称

DEVICE = "npu:0" # 固定用昇腾NPU

WARMUP_RUNS = 3 # 预热次数(让NPU先"热热身")

TEST_RUNS = 10 # 正式测试次数(取平均值更靠谱)

SAVE_RESULT = True # 是否保存结果到JSON文件def load_model_and_tokenizer(model_name):

"""加载模型和tokenizer的专用函数,避免重复代码"""

print(f"正在加载模型 {model_name}...")

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 用FP16精度加载,省显存还快

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.float16,

low_cpu_mem_usage=True

).to(DEVICE)

model.eval() # 切换到推理模式

print(f"模型已加载到{DEVICE},显存占用:{torch.npu.memory_allocated()/1e9:.2f}GB")

return model, tokenizerdef benchmark(prompt, tokenizer, model, max_new_tokens=100):

"""性能测试核心函数,带预热和同步"""

# 处理输入

inputs = tokenizer(prompt, return_tensors="pt").to(DEVICE)

# 预热:第一次运行会编译算子,不算入结果

print(f"预热中...({WARMUP_RUNS}次)")

for _ in range(WARMUP_RUNS):

with torch.no_grad(): # 推理时关闭梯度计算,省显存

_ = model.generate(

**inputs,

max_new_tokens=max_new_tokens,

do_sample=False, # 固定解码方式,结果可复现

pad_token_id=tokenizer.eos_token_id

)

# 正式测试

print(f"开始测试...({TEST_RUNS}次)")

latencies = []

for i in range(TEST_RUNS):

torch.npu.synchronize() # 等NPU准备好再计时,避免"作弊"

start_time = time.time()

with torch.no_grad():

outputs = model.generate(

** inputs,

max_new_tokens=max_new_tokens,

do_sample=False,

pad_token_id=tokenizer.eos_token_id

)

torch.npu.synchronize() # 等NPU算完再停表,确保时间准确

end_time = time.time()

latency = end_time - start_time

latencies.append(latency)

print(f"第{i+1}次测试:耗时{latency:.2f}秒,速度{max_new_tokens/latency:.2f}tokens/秒")

# 计算统计结果

avg_latency = sum(latencies) / len(latencies)

throughput = max_new_tokens / avg_latency

return {

"prompt": prompt,

"max_new_tokens": max_new_tokens,

"平均延迟(秒)": round(avg_latency, 2),

"平均吞吐量(tokens/秒)": round(throughput, 2),

"显存占用(GB)": round(torch.npu.memory_allocated()/1e9, 2)

}if __name__ == "__main__":

# 1. 加载模型和tokenizer(这步最耗时,耐心等)

model, tokenizer = load_model_and_tokenizer(MODEL_NAME)

# 2. 定义测试用例(覆盖不同场景)

test_cases = [

{"场景": "英文短文本生成", "输入": "The capital of France is", "生成长度": 100},

{"场景": "中文对话", "输入": "请解释什么是人工智能:", "生成长度": 100},

{"场景": "代码生成", "输入": "Write a Python function to calculate fibonacci:", "生成长度": 150}

]

# 3. 逐个测试并收集结果

results = []

for case in test_cases:

print(f"\n===== 测试场景:{case['场景']} =====")

result = benchmark(

prompt=case["输入"],

tokenizer=tokenizer, # 显式传参,再也不怕NameError

model=model, # 显式传参,变量作用域清清楚楚

max_new_tokens=case["生成长度"]

)

result["场景"] = case["场景"] # 补充场景信息

results.append(result)

print(f"场景结果:{result}")

# 4. 保存结果(方便后续分析)

if SAVE_RESULT:

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

filename = f"llama_benchmark_{timestamp}.json"

with open(filename, "w", encoding="utf-8") as f:

json.dump(results, f, ensure_ascii=False, indent=2)

print(f"\n测试结果已保存到 {filename}")

print("\n===== 测试完成 =====")

print("性能总结:")

for res in results:

print(f"{res['场景']}:{res['平均吞吐量(tokens/秒)']} tokens/秒")

6.2 为啥这套代码靠谱?三个关键改进

变量作用域清清楚楚:把tokenizer和model作为参数传给benchmark函数,再也不会出现"NameError: name ‘tokenizer’ is not defined"的低级错误——毕竟,连函数都知道要"亲兄弟明算账",变量归属得说清楚。

细节拉满的测试逻辑:

单独的load_model_and_tokenizer函数,避免代码重复

强制torch.npu.synchronize()同步计时,结果真实可信

加了model.eval()和with torch.no_grad(),显存占用直降2GB

自动保存JSON结果,带时间戳不怕重名(再也不用手动改名了)

新手友好的提示信息:运行时会打印每步进度,比如"预热中…(3次)"、“第2次测试:耗时5.8秒”,就算出问题也能快速定位在哪一步翻车。

6.3 运行效果参考

我在GitCode的昇腾实例上跑出来的结果大概是这样(供参考):

===== 测试完成 =====

性能总结:

英文短文本生成:16.75 tokens/秒

中文对话:16.58 tokens/秒

代码生成:16.59 tokens/秒

虽然不算顶尖速度,但胜在稳定可靠。最关键的是——这套代码真的不会报NameError了!(说多了都是泪)

七、这四个坑,我替你踩过了

整个过程中,我踩了不少坑,现在整理出来,大家看完就能避开,不用再走弯路:

坑1:torch.npu找不到

现象:运行torch.npu.is_available()报错AttributeError: module 'torch' has no attribute 'npu'。

原因:torch_npu是单独的插件,不是PyTorch自带的,必须显式导入。

解决:在代码开头加一行import torch_npu,顺序在import torch之后就行。

坑2:tokenizer.npu()不存在

现象:写inputs = tokenizer(...).npu()报错,说没有npu()方法。

原因:tokenizer返回的是字典类型,字典没有npu()这个方法,和Tensor不一样。

解决:换成inputs = tokenizer(...).to('npu:0'),用to()方法指定设备就行。

坑3:Llama下载需要权限

现象:访问meta-llama/Llama-2-7b-hf被拒绝,提示要申请权限。

原因:官方仓库有访问限制,不是所有人都能直接下载。

解决:用开源镜像版本NousResearch/Llama-2-7b-hf,不用申请权限,下载还快。

坑4:网络超时

现象:下载模型到一半卡住,提示timeout。

原因:国内访问HuggingFace不稳定,容易断连。

解决:要么用国内镜像加速(执行export HF_ENDPOINT=https://hf-mirror.com),要么用ModelScope下载(from modelscope import snapshot_download; model_dir = snapshot_download('shakechen/Llama-2-7b-hf')),两种方法都能解决超时问题。

八、想更快?试试这三招

虽然这次测试的吞吐量不算高,但也不是没办法优化,我总结了三个方向,大家可以试试:

1. 用MindSpeed-LLM框架

这是昇腾官方出的大模型框架(https://gitcode.com/Ascend/MindSpeed-LLM),专门针对昇腾NPU做了深度优化,比用原生transformers代码快不少,我后面打算试试这个。

2. 试试INT8量化

用INT8精度加载模型,既能减少显存占用,还能提升速度。代码也不难改,加个量化配置就行:

from transformers import BitsAndBytesConfig

quantization_config = BitsAndBytesConfig(load_in_8bit=True)

model = AutoModelForCausalLM.from_pretrained(

MODEL_NAME,

quantization_config=quantization_config

)

理论上能快20%-30%,显存占用也能降一半,值得尝试。

3. 批处理推理

如果有多个请求,别一个一个处理,用batch推理能显著提升吞吐量。比如一次处理4个请求:

# batch=4的例子

prompts = ["prompt1", "prompt2", "prompt3", "prompt4"]

inputs = tokenizer(prompts, return_tensors="pt", padding=True).to('npu:0')

outputs = model.generate(**inputs, max_new_tokens=100)

我这次只测了batch=1,要是batch调大,吞吐量肯定能上去。

九、总结与建议

折腾了这么久,我对昇腾NPU也算有了直观的认识,总结几点感受和建议,给想尝试的朋友参考:

昇腾适合这些场景

技术层面:部署流程不算复杂,PyTorch代码改一改就能用,文档和生态比我预期的完善,就是有些细节要注意(比如导入torch_npu)。

适用场景:适合对供应链自主可控有要求的政企项目,预算有限但想跑大模型的团队,还有离线批量推理任务;要是做实时交互式应用,可能需要再优化优化性能。

成本效益:云上测试几十块就能验证方案,硬件采购也比NVIDIA GPU便宜,综合性价比还不错。

测试总结

先云上测试,别盲目买硬件:先在ModelArts花几十块试试,或者GitCode免费薅个实例,跑通流程再决定要不要买硬件,避免浪费钱。

镜像别乱选,认准NPU+PyTorch:选错镜像会多走很多弯路,就用我前面推荐的那个,省得自己装环境。

细节别忽略:import torch_npu必须加,to('npu:0')别写成.npu(),这些小细节错了就会报错。

合理预期性能:别指望昇腾能比顶级NVIDIA GPU快,但满足日常需求没问题,关键是性价比和自主可控。

多逛社区:GitCode上有很多实际案例,遇到问题先搜一搜,说不定别人早就踩过同样的坑了。

这次测试虽然踩了不少坑,但总体来说很值,真正体验了一把国产AI芯片的实力。昇腾的生态确实在慢慢变好,虽然性能还有提升空间,但对于很多场景来说已经够用了。如果你也对国产AI芯片感兴趣,不妨试试,说不定会有意外收获!

名称 网址

昇腾官网 https://www.hiascend.com/

昇腾社区 https://www.hiascend.com/community

昇腾官方文档 https://www.hiascend.com/document

昇腾开源仓库 https://gitcode.com/ascend

亲,码字不易,动动小手,欢迎 点赞 ➕ 收藏,如 🈶 问题请留言(或者关注下方公众号,看见后第一时间回复,还有海量编程资料等你来领!),博主看见后一定及时给您答复 💌💌💌

更多推荐

已为社区贡献184条内容

已为社区贡献184条内容

所有评论(0)