linux-高级IO(下)

本文摘要: 本文详细介绍了Linux系统中的epoll多路转接机制。主要内容包括:1)epoll的三个核心函数:epoll_create创建epoll实例、epoll_wait等待事件发生、epoll_ctl管理监控描述符;2)epoll工作原理,通过回调机制和就绪队列实现高效I/O复用;3)epoll服务器实现示例,包括监听套接字、接收连接和处理事件;4)epoll的两种工作模式:水平触发(LT

目录

多路转接之epoll

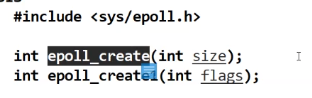

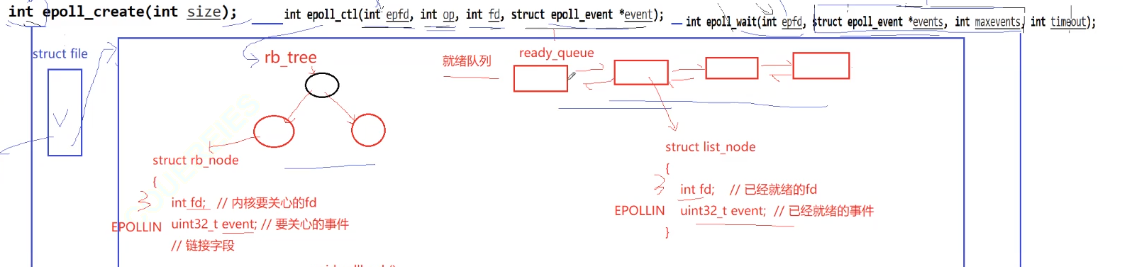

epoll_create

:创建epoll模型

size已经废弃,值只要填写的大于0就行,返回值也是一个文件描述符。

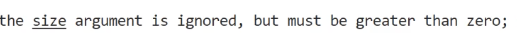

epoll_wait

epoll_wait 是 Linux 中 epoll 机制的核心函数之一,用于等待 epoll 实例监控的文件描述符上发生的事件,是实现 I/O 多路复用的关键步骤。

基本语法

参数说明

- epfd : epoll 实例的文件描述符(由 epoll_create 或 epoll_create1 创建)。

- events :指向 struct epoll_event 数组的指针,用于存储发生的事件信息。

参数类型epoll_event:

它的第1个参数会以位图的形式传递标记位。

- maxevents :指定 events 数组的最大容量,必须大于 0。

- timeout :超时时间(毫秒),有三种取值:

- 0 :立即返回,无论是否有事件发生。

- 正数:等待指定毫秒数,若超时前有事件发生则立即返回。

- -1 :无限期等待,直到有事件发生才返回。

返回值

- 成功:返回发生事件的文件描述符数量(大于 0)。

- 超时:返回 0 (当 timeout 为正数或 0 时)。

- 失败:返回 -1 ,并设置 errno 指示错误(如 EBADF 表示 epfd 无效)。

作用

epoll_wait 会阻塞等待 epoll 实例中监控的文件描述符发生事件(如可读、可写等),当事件发生或超时后,将事件信息存入 events 数组并返回,从而高效处理多个 I/O 操作,避免传统 select/poll 的性能瓶颈。

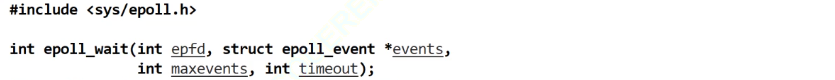

新增,修改,删除一个文件描述符事件。

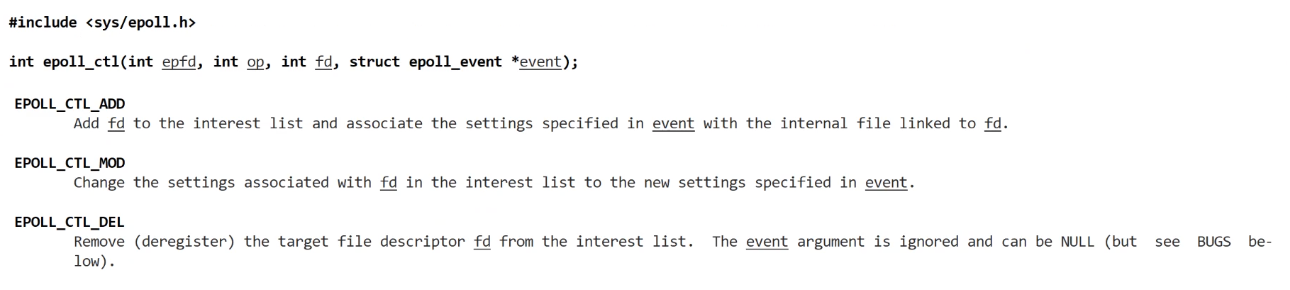

epoll_ctl

epoll_ctl 是 Linux 系统中 epoll 机制的核心函数之一,用于控制 epoll 实例中的事件,比如添加、修改或删除需要监听的文件描述符及其关联事件。

基本语法

参数说明

- epfd : epoll 实例的文件描述符,由 epoll_create 或 epoll_create1 创建。

- op :操作类型,有三种可选值:

- fd :需要操作的文件描述符(如套接字、管道等)。

- event :文件描述符上的哪一个事件。

struct epoll_event 结构体

- events :常用事件类型包括:

- EPOLLIN :表示文件描述符可读(如收到数据)。

- EPOLLOUT :表示文件描述符可写(如缓冲区有空间)。

- EPOLLERR :表示文件描述符发生错误。

- EPOLLHUP :表示文件描述符被挂断(如连接关闭)。

- EPOLLET :边缘触发模式(默认是水平触发)。

返回值

- 成功时返回 0 。

- 失败时返回 -1 ,并设置 errno 指示错误原因(如 EBADF 表示 epfd 或 fd 无效, EEXIST 表示添加已存在的 fd 等)。

作用

epoll_ctl 是 epoll 机制中管理监听对象的关键函数,通过它可以动态维护需要监控的文件描述符列表,配合 epoll_wait 实现高效的 I/O 多路复用。

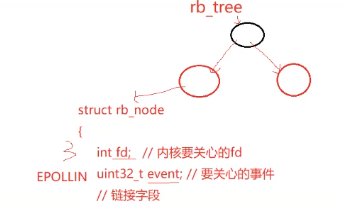

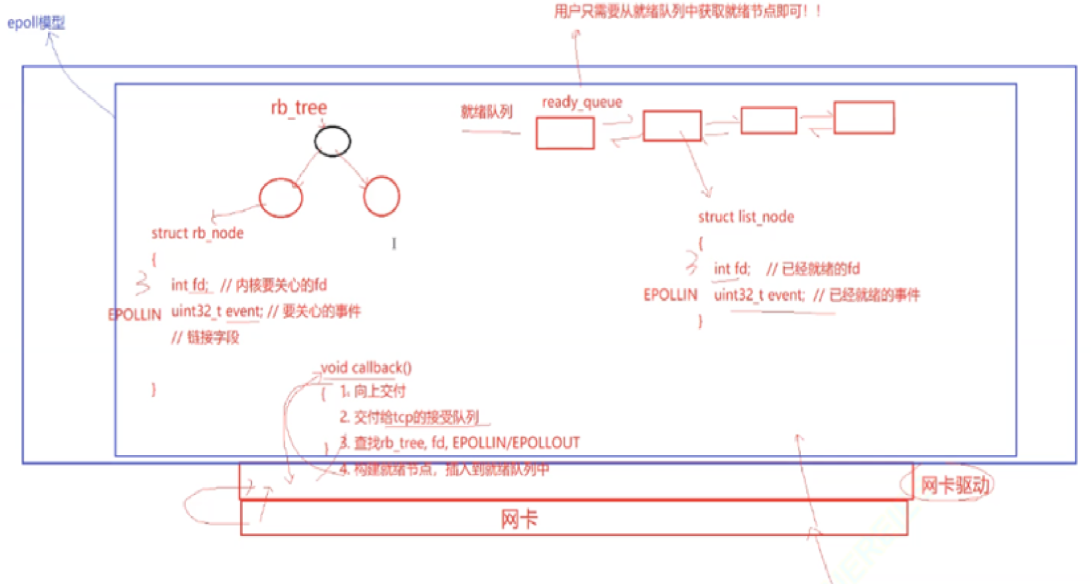

epoll原理

polk and select都借用了类似辅助数组一样的存储形式,他们都是由用户维护,而epoll确实由操作系统维护的。

当网卡数据准备就绪的时候,网卡会向上层发送硬件中断信号给操作系统。上层接收到硬件中断信号以后,会进行比对来检测这个硬件中断信号的含义。进而发现网卡上数据已经完备

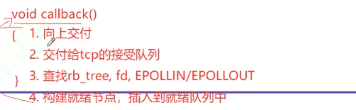

当网卡驱动层得知网卡内有数据就绪,它会自动调用一个回调函数calback

回调函数会将该数据向上层传递,因为不同层级间数据的传输并不是通过拷贝而来,而是通过指针的指向来获取,因此它需要把数据传输给tcp的接收队列。进而将数据传输给用户层的接收缓冲区,同时,他还需要在红黑树中查找对应的文件描述符,有没有被需要关注的任务任务选项,假设回调函数回调的时候传输的就是一个文件描述符为3,写事件,而红黑树中,

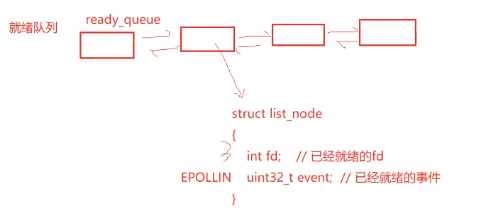

3号文件描述符写事件被关注,那么他就需要把内部文件构造成一个新的节点,插入到就绪队列

之后用户就只需要从就绪队列中获取就绪节点即可。上述过程共同组成了epoll模型

该模型的返回值是一个文件描述符,而我们之前所讲文件描述符由struct file进行管理。

而我们刚刚所讲的三个调用接口与epoll模型的关系如下:

代码

包装epoll

#pragma once

class nocopy

{

public:

nocopy(){}

nocopy(const nocopy &) = delete;

const nocopy&operator=(const nocopy &) = delete;

};#pragma once

#include "nocopy.hpp"

#include "Log.hpp"

#include <cerrno>

#include <cstring>

#include <sys/epoll.h>

class Epoller : public nocopy

{

static const int size = 128;

public:

Epoller()

{

_epfd = epoll_create(size);

if (_epfd == -1)

{

lg(Error, "epoll_create error: %s", strerror(errno));

}

else

{

lg(Info, "epoll_create success: %d", _epfd);

}

}

int EpollerWait(struct epoll_event revents[], int num)

{

int n = epoll_wait(_epfd, revents, num, /*_timeout 0*/ -1);

return n;

}

int EpllerUpdate(int oper, int sock, uint32_t event)

{

int n = 0;

if (oper == EPOLL_CTL_DEL)

{

n = epoll_ctl(_epfd, oper, sock, nullptr);

if (n != 0)

{

lg(Error, "epoll_ctl delete error!");

}

}

else

{

// EPOLL_CTL_MOD || EPOLL_CTL_ADD

struct epoll_event ev;

ev.events = event;

ev.data.fd = sock; // 目前,方便我们后期得知,是哪一个fd就绪了!

n = epoll_ctl(_epfd, oper, sock, &ev);

if (n != 0)

{

lg(Error, "epoll_ctl error!");

}

}

return n;

}

~Epoller()

{

if (_epfd >= 0)

close(_epfd);

}

private:

int _epfd;

int _timeout{3000};

};

epollserver的构建

#pragma once

#include <iostream>

#include <memory>

#include <sys/epoll.h>

#include "Socket.hpp"

#include "Epoller.hpp"

#include "Log.hpp"

#include "nocopy.hpp"

uint32_t EVENT_IN = (EPOLLIN);

uint32_t EVENT_OUT = (EPOLLOUT);

class EpollServer : public nocopy

{

static const int num = 64;

public:

EpollServer(uint16_t port)

: _port(port),

_listsocket_ptr(new Sock()),

_epoller_ptr(new Epoller())

{

}

void Init()

{

_listsocket_ptr->Socket();

_listsocket_ptr->Bind(_port);

_listsocket_ptr->Listen();

lg(Info, "create listen socket success: %d\n", _listsocket_ptr->Fd());

}

void Accepter()

{

// 获取了一个新连接

std::string clientip;

uint16_t clientport;

int sock = _listsocket_ptr->Accept(&clientip, &clientport);

if (sock > 0)

{

// 我们能直接读取吗?不能

_epoller_ptr->EpllerUpdate(EPOLL_CTL_ADD, sock, EVENT_IN);

lg(Info, "get a new link, client info@ %s:%d", clientip.c_str(), clientport);

}

}

// for test

void Recver(int fd)

{

// demo

char buffer[1024];

ssize_t n = read(fd, buffer, sizeof(buffer) - 1); // bug?

if (n > 0)

{

buffer[n] = 0;

std::cout << "get a messge: " << buffer << std::endl;

// wrirte

std::string echo_str = "server echo $ ";

echo_str += buffer;

write(fd, echo_str.c_str(), echo_str.size());

}

else if (n == 0)

{

lg(Info, "client quit, me too, close fd is : %d", fd);

//细节3

_epoller_ptr->EpllerUpdate(EPOLL_CTL_DEL, fd, 0);

close(fd);

}

else

{

lg(Warning, "recv error: fd is : %d", fd);

_epoller_ptr->EpllerUpdate(EPOLL_CTL_DEL, fd, 0);

close(fd);

}

}

void Dispatcher(struct epoll_event revs[], int num)

{

for (int i = 0; i < num; i++)

{

uint32_t events = revs[i].events;

int fd = revs[i].data.fd;

if (events & EVENT_IN)

{

if (fd == _listsocket_ptr->Fd())

{

Accepter();

}

else

{

// 其他fd上面的普通读取事件就绪

Recver(fd);

}

}

else if (events & EVENT_OUT)

{

}

else

{

}

}

}

void Start()

{

// 将listensock添加到epoll中 -> listensock和他关心的事件,添加到内核epoll模型中rb_tree.

_epoller_ptr->EpllerUpdate(EPOLL_CTL_ADD, _listsocket_ptr->Fd(), EVENT_IN);

struct epoll_event revs[num];

for (;;)

{

int n = _epoller_ptr->EpollerWait(revs, num);

if (n > 0)

{

// 有事件就绪

lg(Debug, "event happened, fd is : %d", revs[0].data.fd);

Dispatcher(revs, n);

}

else if (n == 0)

{

lg(Info, "time out ...");

}

else

{

lg(Error, "epll wait error");

}

}

}

~EpollServer()

{

_listsocket_ptr->Close();

}

private:

std::shared_ptr<Sock> _listsocket_ptr;

std::shared_ptr<Epoller> _epoller_ptr;

uint16_t _port;

};epoll的两种模式

LT:水平触发,它是epoll的默认模式,在事件到来时如果上层不处理,它会高电平的一直向上层传输信号.

ET:边缘触发,该模式是数据或链接从无到有,从有到多变化的时候才会通知我们一次,相对而言,该模式的通知效率更高,其io效率也更高。

ET模式是倒逼程序员,每一次通知,他都必须把本轮的数据全部取走,读取数据的方式是循环读取,直到这个读取出错为止,但是因为fd的读取方式默认是阻塞的,我们不能通过阻塞的方式进行读取,但我们并不知道内部是否已经有数据 ,因此不然的话我们进程就会阻塞的卡住了,因此。我们要以非阻塞轮询的方式进行数据读取。

正因为ET模式是一次性将数据读取完,tcp便可以向对方通过一个更大的窗口,从而从概率上让对方一次给我发送更多的数据。因为通知频率更少,因而单位时间内通知效率更高,同时数据传输量的增大,为io效率的更高也奠定了基础,因此相对而言,它是更优的,但是因为水平触发也可以一次性的对数据进行读取完毕。因此在不同场景下,二者谁效率更高效依托于不同的设计方式。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)