Coze扣子教程(一)

Coze Studio 是一款集成式 AI Agent 开发利器,汇聚各类前沿大模型和工具,支持多样化的开发模式与框架,从开发到部署全流程覆盖,为你缔造极致便捷的 AI Agent 创作环境。目前已有上万家企业及数百万开发者依托 Coze Studio 开展工作。Coze Studio 提供了 AI Agent 开发所需的核心技术组件,包括 Prompt、RAG、Plugin 和 Workflow

什么是 Coze Studio

Coze Studio 是一款集成式 AI Agent 开发利器,汇聚各类前沿大模型和工具,支持多样化的开发模式与框架,从开发到部署全流程覆盖,为你缔造极致便捷的 AI Agent 创作环境。目前已有上万家企业及数百万开发者依托 Coze Studio 开展工作。

Coze Studio 提供了 AI Agent 开发所需的核心技术组件,包括 Prompt、RAG、Plugin 和 Workflow,让开发者能够专注于 AI 核心价值的创新实现。

具备开箱即用特性,以最低成本打造专业级 AI Agent:Coze Studio 为开发者配备了完善的应用模板和编排框架,基于这些资源,你可以迅速构建各类 AI Agent,让创意迅速落地为现实应用。

Coze Studio 源自服务过上万家企业及数百万开发者的「扣子开发平台」,我们将其核心引擎全面开放。这一可视化开发工具使 AI Agent 的创建、调试与部署过程变得异常简单。

借助 Coze Studio 提供的直观可视化设计与编排工具,开发者通过零代码或低代码方式,能够快速打造并调试智能体、应用及工作流,实现强大的 AI 应用开发及更多定制化业务逻辑,是构建低代码 AI 产品的理想之选。Coze Studio 致力于降低 AI Agent 开发与应用的门槛,鼓励社区共建和分享交流,助力你在 AI 领域进行更深层次的探索与实践。

技术架构方面,Coze Studio 后端采用 Golang 语言开发,前端则基于 React + TypeScript,整体架构遵循微服务设计并依据领域驱动设计(DDD)原则构建。为开发者提供一个高性能、高可扩展性且便于二次开发的底层框架,助力应对复杂多变的业务需求。

Coze Studio 能做什么

借助扣子提供的可视化设计与编排工具,你可以通过零代码或低代码的方式,快速搭建出基于大模型的各类 AI 项目,满足个性化需求、实现商业价值。

- 搭建智能体:智能体是基于对话的 AI 项目,它通过对话方式接收用户的输入,由大模型自动调用插件或工作流等方式执行用户指定的业务流程,并生成最终的回复。智能客服、虚拟伴侣、个人助理、英语外教都是智能体的典型应用场景。

- 搭建 AI 应用:应用是指利用大模型技术开发的应用程序。扣子中搭建的 AI 应用具备完整业务逻辑和可视化用户界面,是一个独立的 AI 项目。通过扣子开发的 AI 应用有明确的输入和输出,可以根据既定的业务逻辑和流程完成一系列简单或复杂的任务,例如 AI 搜索、翻译工具、饮食记录等。

- 搭建工作流:扣子的工作流功能可以用来处理逻辑复杂,且有较高稳定性要求的任务流。扣子提供了大量灵活可组合的节点包括大语言模型 LLM、自定义代码、判断逻辑等,无论你是否有编程基础,都可以通过拖拉拽的方式快速搭建一个工作流。例如创建一个撰写行业研究报告的工作流,让智能体写一份 20 页的报告。

快速开始

参考快速开始,了解如何获取并部署 Coze Studio 开源版,快速构建项目、体验 Coze Studio 开源版。

功能清单

| 功能模块 | 功能点 |

|---|---|

| 模型服务 | 管理模型列表,可接入OpenAI、火山方舟 等在线模型服务 |

| 搭建智能体 | * 编排、发布、管理智能体 * 支持配置工作流、知识库等资源 |

| 搭建应用 | * 创建、发布应用 * 通过工作流搭建业务逻辑 |

| 搭建工作流 | 创建、修改、发布、删除工作流 |

| 开发资源 | 支持创建并管理以下资源: * 插件 * 知识库 * 数据库 * 提示词 |

| API 与 SDK | 创建会话、发起对话等 OpenAPI |

| 通过 Chat SDK 将智能体或应用集成到自己的应用 |

环境要求

在参考本文安装 Coze Studio 之前,确保您的软硬件环境满足以下要求:

| 项目 | 说明 |

|---|---|

| CPU | 2 Core |

| RAM | 4 GiB |

| Docker | 提前安装 Docker、Docker Compose,并启动 Docker 服务,详细操作请参考 Docker 文档: * macOS:推荐使用 Docker Desktop 安装,参考 Docker Desktop For Mac 安装指南。 * Linux:参考 Docker 安装指南 和 Docker Compose 安装指南。 * Windows:推荐使用 Docker Desktop 安装,参考 Docker Desktop For Windows 安装指南。 |

安装 Coze Studio

为简化部署流程,火山引擎提供了一键部署解决方案。

步骤一:获取源码

在本地项目中执行以下命令,获取 Coze Studio 最新版本的源码。

# 克隆代码 git clone https://github.com/coze-dev/coze-studio.git

步骤二:部署并启动服务

首次部署并启动 Coze Studio 需要拉取镜像、构建本地镜像,可能耗时较久,请耐心等待。如果看到提示 "Container coze-server Started",表示 Coze Studio 服务已成功启动。

cd coze-studio # start service # for macOS or Linux make web # for windows cp .env.example .env docker compose -f ./docker/docker-compose.yml up

步骤三:注册账号

访问 http://localhost:8888/sign 输入用户名、密码点击注册按钮。

步骤三:配置模型

配置模型,http://localhost:8888/admin/#model-management 新增模型。

步骤五:登录访问

访问 Coze Studio http://localhost:8888/

后续操作

成功部署 Coze Studio 后,如需使用插件、知识库等功能,你还需要:

- 配置插件:部分官方插件需要通过第三方服务的密钥鉴权,例如飞书云文档系列组件。若未配置密钥,插件将显示为”未授权“。

- 配置基础组件:核心组件如下

- 知识库:如需使用知识库功能,则必须配置 Embedding 组件;对于图片知识库,还需要额外设置 OCR 组件以识别图片中的文字。

- 图片上传:当需要使用大模型多模态输入时,上传组件需要配置公网域名或者 IP 地址,否则在调试台和模型对话时,模型无法读取已上传的图片。

- 配置模型:按需增加模型服务,使你的智能体、工作流或应用能使用更多模型。

公网安全风险

如果要将 Coze Studio 部署到公网环境下,建议关注以下安全风险:

模型配置注意事项

在填写模型配置文件之前,请确保你已经了解了以下注意事项:

为 Coze Studio 配置模型

Coze Studio 是基于大语言模型的 AI 应用开发平台,首次部署并启动 Coze Studio 开源版之前,你需要先在 Coze Studio 项目里配置模型服务,否则创建智能体或者工作流时,无法正常选择模型。

可以通过配置管理后台 http://localhost:8888/admin/#model-management 来添加火山删除模型。

第三方模型服务

| 平台 | protocol | base_url | 特别说明 |

|---|---|---|---|

| 火山方舟 | ark | 国内火山引擎:https://ark.cn-beijing.volces.com/api/v3/ 海外 BytePlus:https://ark.ap-southeast.bytepluses.com/api/v3/ |

无 |

| 阿里百炼 | openai 或 qwen |

https://dashscope.aliyuncs.com/compatible-mode/v1 | qwen3 系列在非流式调用时不支持 thinking,如果使用需要设置 conn_config 中 enable_thinking: false,coze studio后续版本会适配此能力。 |

| 硅基流动 | openai | https://api.siliconflow.cn/v1 | 无 |

| 其他第三方 api 中转 | openai | api 文档中提供的地址 注意路径通常带 /v1 后缀,不带 /chat/completions 后缀 |

如果平台仅中转或代理模型服务,非 openai 模型请按照【官方模型服务】部分文档配置 protocol |

开源框架

| 框架 | protocol | base_url | 特别说明 |

|---|---|---|---|

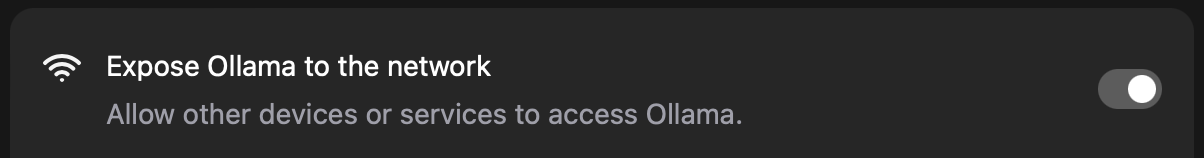

| ollama | ollama | http://${ip}:11434 | 1. 镜像网络模式是 bridge,coze-server 镜像内 localhost 不是主机的 localhost。需要修改为 ollama 部署机器的 ip,或 http://host.docker.internal:114342. 检查 api_key:未设置 api_key 时,此参数置空。 3. 确认部署 Ollama 主机的防火墙是否已开放 11434 端口。 4. 确认 ollama 网络已开启对外暴露。

|

| vllm | openai | http://${ip}:8000/v1(port 启动时指定) | 无 |

| xinference | openai | http://${ip}:9997/v1 (port 启动时指定) | 无 |

| sglang | openai | http://${ip}:35140/v1(port 启动时指定) | 无 |

| LMStudio | openai | http://${ip}:${port}/v1 | 无 |

官方模型服务

| 模型 | protocol | base_url | 特别说明 |

|---|---|---|---|

| Doubao | ark | https://ark.cn-beijing.volces.com/api/v3/ | 无 |

| OpenAI | openai | https://api.openai.com/v1 | 检查 by_azure 字段配置,如果模型是微软 azure 提供的模型服务,此参数应设置为 true。 |

| Deepseek | deepseek | https://api.deepseek.com/ | 无 |

| Qwen | qwen | https://dashscope.aliyuncs.com/compatible-mode/v1 | qwen3 系列在非流式调用时不支持 thinking,如果使用需要设置 conn_config 中 enable_thinking: false,coze studio后续版本会适配此能力。 |

| Gemini | gemini | https://generativelanguage.googleapis.com/ | 无 |

| Claude | claude | https://api.anthropic.com/v1/ | 无 |

Pages 25

Clone this wiki locally

- 建议关闭注册功能,或开启邮箱白名单,否则任意用户均可通过链接使用。

- 建议为工作流代码节点开启默认沙箱环境,以增强安全性。详细配置说明可参考代码节点沙箱环境。

- 建议根据业务需求(例如内网访问)为部署环境配置网络,规避 SSRF 风险。

- Coze Studio 服务端默认只监听 localhost,部署到公网环境下时建议仅在必要时监听

0.0.0.0,或者增加额外的安全措施,以免服务直接暴露在公网。 -

Coze Studio 是基于大语言模型的 AI 应用开发平台,首次部署运行 Coze Studio 开源版之前,你需要先克隆到本地的项目中,配置所需要的模型。项目正常运行过程中,也可以随时按需添加新的模型服务、删除不需要的模型服务。

模型列表

Coze Studio 支持的模型服务如下:

- 火山方舟 | Byteplus ModelArk

- OpenAI

- DeepSeek

- Claude

- Ollama

- Qwen

- Gemini

- 在删除模型之前,请确保此模型已无线上流量。

- 智能体或工作流根据模型 ID 来调用模型。对于已上线的模型,请勿修改模型 ID,否则可能导致模型调用失败。

- 什么是 Coze Studio | What is Coze Studio

- 快速开始 | Quick Start

- 项目配置 | Project Configuration

- API 参考 | API Reference

- Chat SDK | Chat SDK

- 开发规范 | Development Standards

- 开发指南 | Developer Guide

- 常见问题 | FAQ

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)