【ComfyUI】动漫转真人 摄影风格自动光影映射

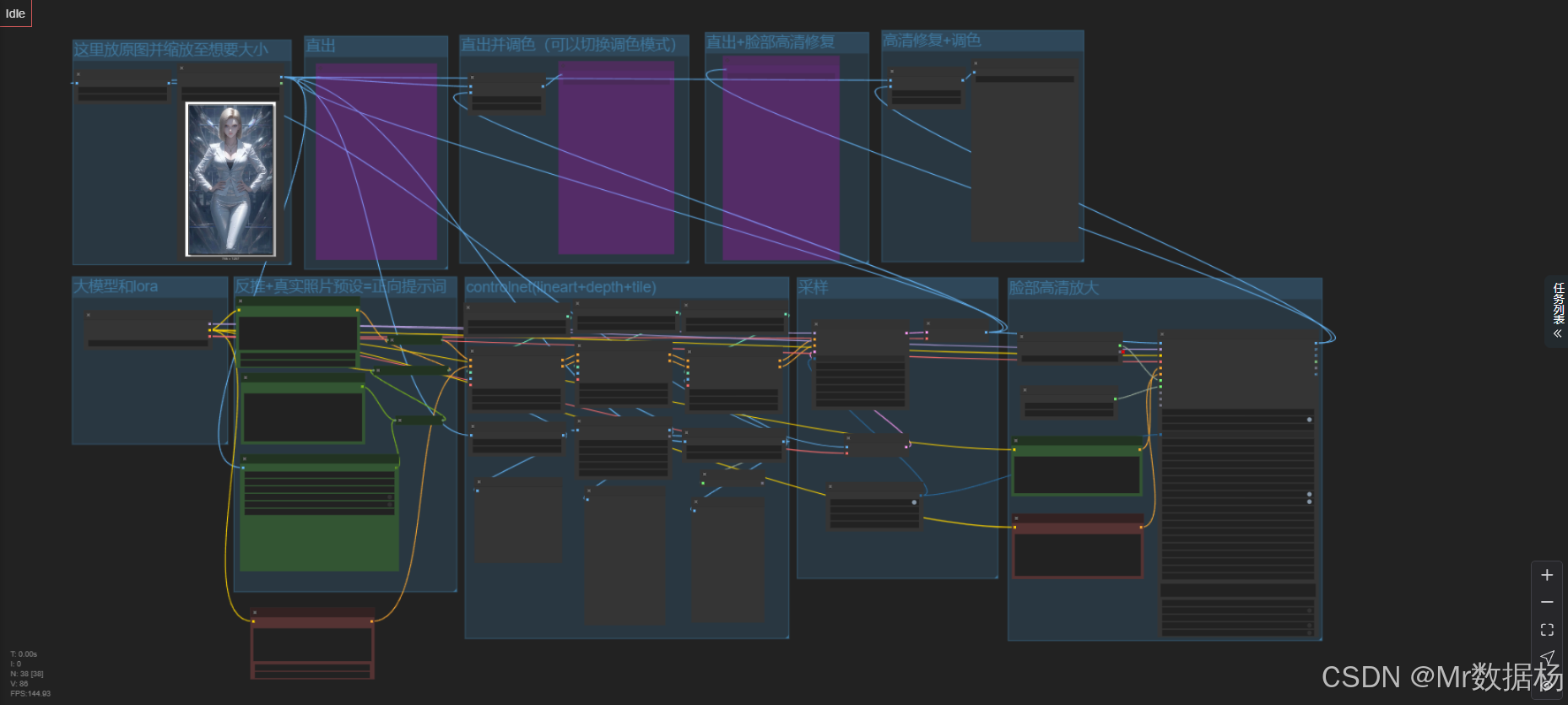

本工作流演示了一个动漫转真人风格的ComfyUI流程,通过融合OpenPose、Tile、Depth等多种ControlNet控制信号与AWPortrait XL_1.1文生图模型,实现二维动漫图像到逼真摄影风格人像的转换。流程包含图像加载、预处理、多路ControlNet控制融合、文生图生成、风格迁移和后处理等模块化环节,最终输出兼具语义准确性和艺术美感的写实人像,适用于虚拟角色人设建立等应用场

今天给大家演示一个 动漫转真人 + 摄影风格光影映射 ComfyUI 工作流。这个流程能自动将二维风格的动漫图像转化为具备真实光影、细节纹理和摄影风格的逼真人像。通过融合多种 ControlNet 类型(如 OpenPose、Tile、Depth)、风格配准处理器与文生图大模型,最终生成具有真实感且具有艺术气质的人像作品,适合二次元到真人风格转换、虚拟角色人设建立等场景应用。

文章目录

工作流介绍

本工作流围绕“动漫转真人”的自动化图像增强与风格迁移任务,利用多模型融合策略,结合 ControlNet 的多维控制与多轮图像处理,分阶段构建出层次丰富、光影自然、细节完整的逼真肖像图。工作流中不仅涵盖了基础图像加载、放大、预处理步骤,也引入了例如 depth、tile、openpose 等多种 ControlNet 控制信号,通过分支节点并联构建稳定控制结构,确保最终图像兼具语义精度与美学细节。此外,通过 imageColorMatch 节点完成风格迁移,使输入图像在色调与光照上与目标照片高度一致。

核心模型

该工作流核心依赖的模型为 AWPortrait XL_1.1.safetensors,这是一款专注于人像写实风格的文生图模型,支持高质量面部还原、光影模拟以及摄影构图细节建模。在搭配 ControlNet 和多种 conditioning 输入后,能够在复杂控制下依然保持高一致性输出。

| 模型名称 | 说明 |

|---|---|

| AWPortrait XL_1.1.safetensors | 高写实风格肖像生成模型,适用于人物摄影级图像重建 |

Node节点

本工作流由多个功能分明的 Node 节点组成。ControlNet 多模态 Loader 实现了对 OpenPose、Depth、Tile 的输入控制;TextEncoder、CLIP 等完成了正负 prompt 编码;imageColorMatch 实现风格迁移;KSampler 与 VAE 负责文生图主过程;后处理环节结合 SaveImage、PreviewImage 进行展示与保存;整个流程模块化清晰,具备良好的复用性与可调性。

| 节点名称 | 说明 |

|---|---|

| LoadImage | 读取用户上传动漫图 |

| CheckpointLoaderSimple | 加载核心文生图模型 |

| CLIPTextEncodeA1111 / CLIPTextEncode | 编码文本 Prompt 与提示词 |

| ACN_ControlNet++LoaderSingle | 加载 ControlNet 模型(Tile、Depth、OpenPose) |

| DepthAnythingPreprocessor / TilePreprocessor / OpenposePreprocessor | 提取图像深度、分块细节与姿态信息 |

| ControlNetApplyAdvanced | 多次使用,用于深度融合 control 输入与条件生成信息 |

| KSampler | 控制采样步骤与图像生成逻辑 |

| VAEEncode / VAEDecode | 编解码图像 Latent 空间 |

| easy imageColorMatch | 图像风格匹配处理 |

| SaveImage / PreviewImage | 输出图像保存与预览展示 |

| UltralyticsDetectorProvider / SAMLoader | 用于脸部检测与自动掩码辅助 |

工作流程

整个工作流按照“加载 → 预处理 → 控制融合 → 风格转换 → 文生图生成 → 后处理”的顺序逐步推进。前期通过 ControlNet 三模输入(OpenPose、Depth、Tile)实现对姿态、光影、纹理的精准控制,中期将条件信息与 prompt 编码合并,结合 KSampler 执行核心图像生成,后期通过 imageColorMatch 节点迁移目标图像的摄影风格,最终输出高保真度的真人风格图像。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 图像加载 | 加载用户提供的动漫图片,并进行尺寸统一和放大处理 | LoadImage, ImageScaleToTotalPixels |

| 2 | 模型加载 | 加载文生图模型及其配套的 CLIP 和 VAE 模型 | CheckpointLoaderSimple |

| 3 | 提示词编码 | 正向与负向 prompt 文本编码,生成条件控制向量 | CLIPTextEncodeA1111, Text Concatenate |

| 4 | ControlNet控制 | 使用 OpenPose、Tile、Depth 三路 ControlNet 实现姿态、分块、深度约束 | ACN_ControlNet++LoaderSingle, OpenposePreprocessor, TilePreprocessor, DepthAnythingPreprocessor |

| 5 | 控制融合 | 多个 ControlNet 输入融合到主生成流程中,控制图像生成的内容和构图 | ControlNetApplyAdvanced(多次使用) |

| 6 | 图像采样生成 | 在融合 ControlNet 条件和 prompt 后进行 latent 图像生成 | KSampler, VAEEncode, VAEDecode |

| 7 | 风格迁移 | 将生成图像与参考图风格进行匹配,完成摄影光影一致性 | easy imageColorMatch |

| 8 | 自动检测增强 | 利用人脸检测、掩膜提取与局部细节增强 | UltralyticsDetectorProvider, SAMLoader |

| 9 | 图像保存与展示 | 将最终图像保存到本地,并支持预览 | SaveImage, PreviewImage |

大模型应用

CLIPTextEncodeA1111 文本风格与语义约束核心

这个节点负责把用户输入的 Prompt 转成可供主模型理解的语义向量。它只做一件事,就是将文字中的风格、主体、光影倾向、构图偏好等信息,编码成模型的条件输入。Prompt 会直接影响最终的摄影风格、肤质细节、光比强弱与整体真实度,因此写 Prompt 的过程就是定义画面特征的过程。正向 Prompt 强化目标风格,反向 Prompt 则降低噪点、错误结构与不想出现的视觉元素。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncodeA1111 | Positive Prompt: masterpiece, ultradetailed, best quality, extremely detailed, realistic photo, realistic, Negative Prompt: text, watermark, nsfw, nude, 2d anime style, 3d style, (worst quality), (low quality), (normal quality), lowres, bad anatomy, ((bad hands, broken hands)), (many fingers), ((grayscale)) watermark, moles, |

将 Prompt 文本编码为模型的语义向量,用于控制画面风格、细节等级与整体品质,是画面风格走向的核心来源。 |

CLIPTextEncode 面部特征精细引导

这个节点单独处理人脸特定的 Prompt,它不负责生成画面,只负责把“面部风格倾向”转成语义条件,例如肤质、年龄段、种族特征与审美方向。Prompt 越清晰,人物脸部越稳定。它只处理输入文字,对于画面之外的流程不做任何判断。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode | Positive Prompt: best quality, realistic young asian lady face, pale skin, beautiful lady face, Negative Prompt: text, watermark, nsfw, nude, 2d anime style, 3d style, (worst quality), (low quality), (normal quality), lowres, bad anatomy, ((bad hands, broken hands)), (many fingers), ((grayscale)) watermark, moles, |

专注于面部特写语义编码,使模型在渲染脸部时保持风格一致、细节自然。 |

CLIPTextEncodeA1111(第二组) 全局去瑕疵与质量压制

这一组节点作为额外的负向语义来源,确保在高强度风格映射中依然维持画面干净度。它的职责是编码各种需要抑制的问题,如噪点、结构错误、风格化痕迹等,使成片更贴近真实摄影。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncodeA1111 | Negative Prompt: text, watermark, nsfw, nude, 2d anime style, 3d style, (worst quality), (low quality), (normal quality), lowres, bad anatomy, ((bad hands, broken hands)), (many fingers), ((grayscale)) watermark, moles, |

承担额外的负向语义校正,使最终照片更真实干净,降低典型 AI 错误结构的生成概率。 |

使用方法

整个工作流从用户上传的动漫图开始,通过检测结构、深度、边缘信息,再载入摄影风格模型,把图像从动漫风格映射为写实摄影风格。用户更换输入图后,系统会自动执行深度提取、Openpose 结构识别、Tile 细节增强、光影适配、颜色映射,再结合 Prompt 语义重新渲染。

角色图用于提供主体信息,结构图(Openpose 与 depth)用于保持姿态一致性,Prompt 提供风格与真实度导向,系统会自动把所有信息融合成最终成片,整个过程无需用户手调节点参数。

| 注意点 | 说明 |

|---|---|

| Prompt 要清楚表达摄影风格 | 模型依赖语义向量做风格判定,模糊的描述会削弱写实效果 |

| 反向 Prompt 需保持完整 | 可减少噪点、破损结构和 AI 痕迹 |

| 输入动漫图越干净越好 | 背景噪音过多会影响深度和结构分析 |

| 不要在 Prompt 加过多冲突词 | 例如“anime”和“realistic”混用会降低一致性 |

| 更换图像后无需改动流程 | 工作流会自动重新推理并映射风格 |

| 光线强烈的图像可能需调整 | 强光区域会让深度、边缘更难识别,影响最终真实度 |

应用场景

本工作流面向“二次元到写实风格转换”应用场景,特别适用于动漫角色转真人形象建模、虚拟主播生成、角色写实同人图创作等内容制作场合。通过多种控制策略与图像增强技术组合,不仅能保留角色原貌,还能增强其在摄影构图、光影表现和皮肤细节方面的真实感。该流程适合内容创作者、游戏美术、数字人设设计等专业用户批量高效地生成写实风格人物图像。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 动漫转真人形象 | 将二维角色转换为真实风格人像 | 二次元创作者、虚拟主播设计师 | 动漫人物写实图像 | 光影逼真、脸部精细、风格匹配一致 |

| 同人图风格统一 | 对已有动漫图进行风格映射,输出写实版本 | 插画师、影像后期人员 | 写实风格版本的动漫图 | 色调统一、构图合理 |

| 角色设计提案 | 快速生成高质量角色设计初稿 | 游戏策划、美术设计团队 | 真人版角色概念图 | 多模控制构图精确、效率高 |

| 虚拟人设生成 | 为虚拟偶像/主播建立真人外形草图 | 虚拟人开发公司 | 写实风格头像与半身像 | 可直接投入数字人制作流程 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)