认识大模型

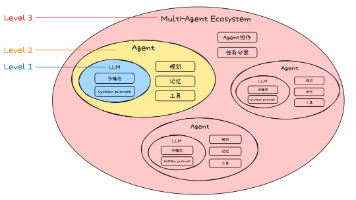

• 通过海量数据的训练,这个⽹络会⾃⼰调整每个“神经元”的重要性(即参数的值),最终形成⼀个⾮常复杂的“判断流⽔线”。⽐如,⼀个识别猫的神经⽹络,某些参数可能专⻔负责识别猫的眼睛,另⼀些参数专⻔负责识别猫的轮廓。• 交互⽅式⾰命: 我们不⽤点按钮、写代码,直接像对⼈说话⼀样给它指令(Prompt) 它就能听懂并执⾏,⽐如你直接说“写⼀⾸关于春天的诗”,它就能给你写出来。• ⽤“超级团队⼯作流程”(

认识模型

模型是⼀个从数据中学习规律的“数学函数”或“程序”。旨在处理和⽣成信息的算法,通常模仿⼈类的认知功能。通过从⼤型数据集中学习模式和洞察,这些模型可以进⾏预测、⽣成⽂本、图像或其他输出,从⽽增强各个⾏业的各种应⽤。

可以简单理解为模型是⼀个"超级加⼯⼚",这个⼯⼚是经过特殊训练的,训练师给它看了海量的例⼦(数据),并告诉它该怎么做。通过看这些例⼦,它⾃⼰摸索出了⼀套规则,学会了完成某个"特定任务"。模型就是⼀套学到的"规则"或者"模式",它能根据你给的东西,产⽣你想要的东西。

模型的关键特点在于:

- 特定任务:⼀个模型通常只擅⻓⼀件事。⽐如:

◦ ⼀个模型专⻔识别图⽚⾥是不是猫。

◦ ⼀个模型专⻔预测明天会不会下⾬。

◦ ⼀个模型专⻔判断⼀条评论是好评还是差评。

-

需要“标注数据”:训练这种模型需要⼤量“标准答案”。(⽐如:成千上万张已经标注好“是猫”或“不是猫”的图⽚)。

-

参数较少:参数是模型从数据中学到的“知识要点”或“内部规则”(⽐如:上述⽰例中的规则仅是"中间数")。参数较少说明模型的复杂度和能⼒相对有限。

认识⼤语⾔模型

什么是⼤语⾔模型?

⼤语⾔模型(Large Language Model,LLM)是指基于⼤规模神经⽹络(参数规模通常达数⼗亿⾄万亿级别,例如GPT-3包含1750亿参数),通过⾃监督或半监督⽅式,对海量⽂本进⾏训练的语⾔模型。

名词解释:

- 神经⽹络:⼀个极其⾼效的“团队⼯作流程”或“条件反射链”。

例如教⼀个⼩朋友识别猫:

• 不会只给⼀条规则(⽐如“有胡⼦就是猫”),因为兔⼦也有胡⼦。

• 我们会让他看很多猫的图⽚,他⼤脑⾥的视觉神经会协同⼯作:◦ 有的神经元负责识别“尖⽿朵”,

◦ 有的负责识别“胡须”,

◦ 有的负责识别“⽑茸茸的尾巴”。

• 这些神经元⼀层层地传递和组合信息,最后⼤脑综合判断:“这是猫!”

神经⽹络就是模仿⼈脑的这种⼯作⽅式。

• 它由⼤量虚拟的“神经元”(也就是参数)和连接组成。

• 每个神经元都像⼀个⼩处理单元,负责处理⼀点点信息。⽆数个神经元分成很多层,前⼀层的输出作为后⼀层的输⼊。

• 通过海量数据的训练,这个⽹络会⾃⼰调整每个“神经元”的重要性(即参数的值),最终形成⼀个⾮常复杂的“判断流⽔线”。⽐如,⼀个识别猫的神经⽹络,某些参数可能专⻔负责识别猫的眼睛,另⼀些参数专⻔负责识别猫的轮廓。

简单说:神经⽹络就是⼀个通过数据训练出来的、由⼤量参数组成的复杂决策系统。

- ⾃监督学习:“完形填空”超级⼤师。

例如我们想学会⼀⻔外语,但没有⽼师给出题和批改。怎么办?

• 我们可以拿⼀本该语⾔的⼩说,⾃⼰玩“完形填空”:随机盖住⼀个词,然后根据上下⽂猜测这个词是什么。

• ⼀开始猜得乱七⼋糟。

• 但不断地重复这个过程,看了成千上万本书后,对这个语⾔的语法、词汇搭配、上下⽂逻辑了如指掌。现在不仅能轻松猜对被盖住的词,甚⾄能⾃⼰写出流畅的⽂章。

⾃监督学习就是这个过程。

• 模型⾯对海量的、没有标签的原始⽂本(⽐如互联⽹上的所有⽂章、⽹⻚)。

• 它⾃⼰给⾃⼰创造任务:把⼀句话中间的某个词遮住,然后尝试根据前后的词来预测这个被遮住的词。

• 通过亿万次这样的练习,模型就深刻地学会了语⾔的规律。它不需要⼈类⼿动去给每句话标注“这是主语”、“这是谓语”。

简单说:⾃监督就是让模型从数据本⾝找规律,⾃⼰给⾃⼰当⽼师。

半监督学习:“师⽗领进⻔,修⾏在个⼈”。

例如你想学做菜:

• 师傅先教你⼏道招牌菜(⽐如⿇婆⾖腐、宫保鸡丁)⸺这相当于给了你⼀些 “有标注的数据”(菜谱和成品)。

• 然后,师傅让你去尝遍天下各种美⻝,⾃⼰研究其中的⻔道⸺这相当于接触海量的 “⽆标注数据” (各种未知的⻝材和味道)。

• 你结合师傅教的基本功和⾃⼰尝遍天下美⻝的经验,最终不仅能完美复刻招牌菜,还能创新出新的菜式。这就是“半监督”。

先⽤少量带标签的数据让模型“⼊⻔”,掌握⼀些基本规则,然后再让它去海量的⽆标签数据中⾃我学习和提升。这对于⼤语⾔模型来说也是⼀种常⽤的训练⽅式。

简单说:半监督就是“少量指导+⼤量⾃学”的结合模式。

语⾔模型:⼀个“超级⾃动补全”或“语⾔预测器”。

例如你在⽤⼿机打字,输⼊“今天天⽓真”,输⼊法会⾃动提⽰“好”、“不错”、“冷”等。这个输⼊法之所以能提⽰,就是因为它内部有⼀个⼩型的“语⾔模型”,它根据你输⼊的前⽂,计算下⼀个词最可能是什么。

语⾔模型的核⼼任务就是预测下⼀个词。⼀个强⼤的语⾔模型,能够根据⼀段话,预测出最合理、最

通顺的下⼀个词是什么,这样⼀个个词接下去,就能⽣成⼀整段话、⼀篇⽂章。

简单说:语⾔模型就是⼀个计算“接下来最可能说什么”的模型。

现在,我们再回头看那段描述,就⼀⽬了然了。翻译成⼤⽩话就是:

⼤语⾔模型是⼀个:

• ⽤“超级团队⼯作流程”(⼤规模神经⽹络)搭建的,拥有数百亿甚⾄上万亿个“脑细胞”(参数)的 “超级⾃动补全系统”(语⾔模型)。

• 它学习的⽅式,主要是通过⾃⼰玩“海量完形填空”(⾃监督学习),或者 “少量名师指导+海量⾃学” (半监督学习)……

• 从互联⽹上所有的⽂本数据中学会了语⾔的规律。

因此,它具有以下⼏个核⼼特点:

• 规模巨⼤: 它的“脑细胞”(参数)特别多(通常达到数⼗亿甚⾄万亿级别),所以思考问题更复杂、更全⾯,就像⼀⽀百万⼤军和⼀个⼩分队的区别。

• 通⽤性强: 它不是为单⼀任务训练的。因为它通过“完形填空”学会的是整个语⾔世界的底层规律(语法、逻辑、知识关联),⽽不是只背会了“猫的图⽚”。所以它能举⼀反三,把底层能⼒灵活应⽤到聊天、翻译、写代码等各种任务上。这种“涌现”能⼒,就像孩⼦通过⼤量阅读后,突然能写出意想不到的优美句⼦⼀样。

• 训练⽅式不同: 主要使⽤⾃监督学习,从海量⽆标注的原始⽂本中学习。它不依赖⼈⼯⼀张张地给图⽚标“这是猫”,⽽是直接从原始⽂本中⾃学,效率极⾼,规模可以做得⾮常⼤。

• 交互⽅式⾰命: 我们不⽤点按钮、写代码,直接像对⼈说话⼀样给它指令(Prompt) 它就能听懂并执⾏,⽐如你直接说“写⼀⾸关于春天的诗”,它就能给你写出来。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)