AI爬虫时代:传统抓取技术面临淘汰

摘要:2025年网页抓取行业呈现三大趋势:数据购买成本降低、AI技术释放新可能、开源与专有工具混合使用。AI驱动的数据采集方式正逐步替代传统规则编写,能更好应对动态页面和反爬机制。本文提供了一个Python+Selenium+AI辅助的实验方案,通过自然语言描述自动识别页面元素选择器,展示了AI如何提升数据采集效率和适应性。这种"传统爬虫+AI辅助"的混合思路,代表了行业向更智

背景介绍

根据 Zyte 在其《2025 Web Scraping Industry Report》中的分析,“买数据变便宜且更容易”“AI/大模型释放了数据采集项目的新可能性”“开源+专有工具混合成为主流”三大趋势凸显。(zyte.com)

此外,另一篇来自 X‑Byte Enterprise Crawling 的技术博客指出:2025 年网页抓取正朝向“更智能、更快速、AI 加持”的方向演进,传统靠写规则+模拟浏览器的方式已难以应对反爬机制和结构变更挑战。(X-Byte Enterprise Crawling)

换句话说:

-

网页结构频繁变更、反爬机制更复杂、JS 渲染/动态加载页面比以往更多。

-

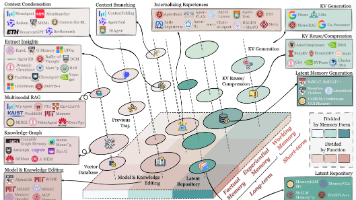

同时,AI 驱动的工具(如自动解析页面结构、识别数据字段、基于自然语言描述抓取需求)越来越被使用。

-

对于数据采集团队来说,这意味着 “只写固定 Selector 的爬虫”正逐步进入瓶颈期,需要新的思路。

用途与意义分析

对于从事数据采集、爬虫、知识图谱、商业智能的技术人员或团队而言,这一趋势非常值得重视:

-

效率提升:AI 辅助抓取能减少人工编写规则、减少错误、加快上线。

-

结构变化容忍度提高:当页面布局变化、标签变化、AJAX 加载更多时,AI-驱动工具能更快适应。

-

低代码/无代码取数能力增强:对于非程序人员也开启数据抓取可能,有助于快速原型验证。

-

合规与运营思考加重:随着工具门槛下降,数据采集规模扩大,企业需要更关注数据来源合法性、反爬机制遵循、运营成本。

-

战略选择“买/自建”更为关键:报告中指出,企业在“自建采集平台”与“购买数据或者使用第三方采集服务”间的选择正在重估。(zyte.com)

总之,这对你作为数据采集技术博主而言,是一个非常好的话题切入:你既可以分享新工具/新思路,也可以探讨“传统爬虫方式在新环境下如何升级”。

二、实验复现代码:用 Python + Selenium + AI 提示辅助抓取

下面是一个简化示例:假设我们要从一个动态加载商品页抓取「商品名称」和「价格」。我们将使用 Selenium 模拟浏览器,然后借助一个简单的 NLP 模型提示(这里用 openai 模拟)来辅助识别页面中所需字段。注意:此脚本仅做学习与实验用途,务必遵守目标站点 robots 协议及法律法规。

import time

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

import openai # 需安装 openai 包,并填入你的 api_key

# 配置

openai.api_key = "YOUR_API_KEY_HERE"

TARGET_URL = "https://example-ecommerce.com/product/12345"

def fetch_page_html(url):

opts = Options()

opts.add_argument("--headless")

opts.add_argument("--disable-gpu")

driver = webdriver.Chrome(options=opts)

driver.get(url)

time.sleep(5) # 等待 JS 加载

html = driver.page_source

driver.quit()

return html

def ask_ai_for_selectors(html):

"""

使用 OpenAI GPT 模型提示:请从以下 HTML 中识别“商品名称”和“价格”对应的 CSS selector

"""

prompt = f"""给定下面的网页 HTML 内容:

{html[:2000]} <!-- 为避免超长截断,仅示意 -->

请你分析并输出:1) 商品名称对应的 CSS selector;2) 商品价格对应的 CSS selector。只输出 selector,不解释。"""

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{"role":"user","content":prompt}],

temperature=0

)

selectors = resp.choices[0].message.content.strip().splitlines()

return selectors

def extract_with_selectors(html, selectors):

soup = BeautifulSoup(html, "lxml")

name = soup.select_one(selectors[0]).get_text().strip() if soup.select_one(selectors[0]) else None

price = soup.select_one(selectors[1]).get_text().strip() if soup.select_one(selectors[1]) else None

return name, price

if __name__ == "__main__":

html = fetch_page_html(TARGET_URL)

selectors = ask_ai_for_selectors(html)

print("AI 生成的 selectors:", selectors)

name, price = extract_with_selectors(html, selectors)

print(f"抽取结果 → 名称:{name};价格:{price}")

使用说明 &扩展建议

-

首发先用 Selenium 或 Playwright 抓动态页面 HTML。

-

然后让 LLM (如 GPT-4o)辅助“从 HTML 中识别数据字段”。这种方式是 “传统 Selector 编写”+“AI 辅助识别” 的混合思路。

-

你可以改进为:对同一站点多页面循环、自动汇总若干 selectors,进一步用 RL/优化方式挑出最佳 selector。

-

再扩展:加入代理/IP 池、防反爬(如识别 JS challenge/滑块验证码)、异常检测机制。

-

最终形成一个 “低代码采集模块”--让运营人员通过自然语言描述“我要抓取 XXX 网站的产品名称 + 价格 +库存”,系统自动生成抓取脚本。

这个实验展示了 “AI辅助抓取” 的可能路径,与你前述趋势高度契合。

三、小结

-

本周聚焦:网页采集正由“手写规则”时代迈向“AI辅助+结构适应”时代。作为技术人员,需要调整思维:不只是“如何抓”,更是“如何适应变化+如何用更智能的方式抓”。

-

我提供了一个 Python+Selenium+LLM 的实验脚本,供你理解并改造。

-

如果你希望获得一个成熟、稳定、可测试的“数据采集解决方案”,欢迎访问我的主页查看联系方式。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)