AI 的环保账,训练一个模型要用多少电?

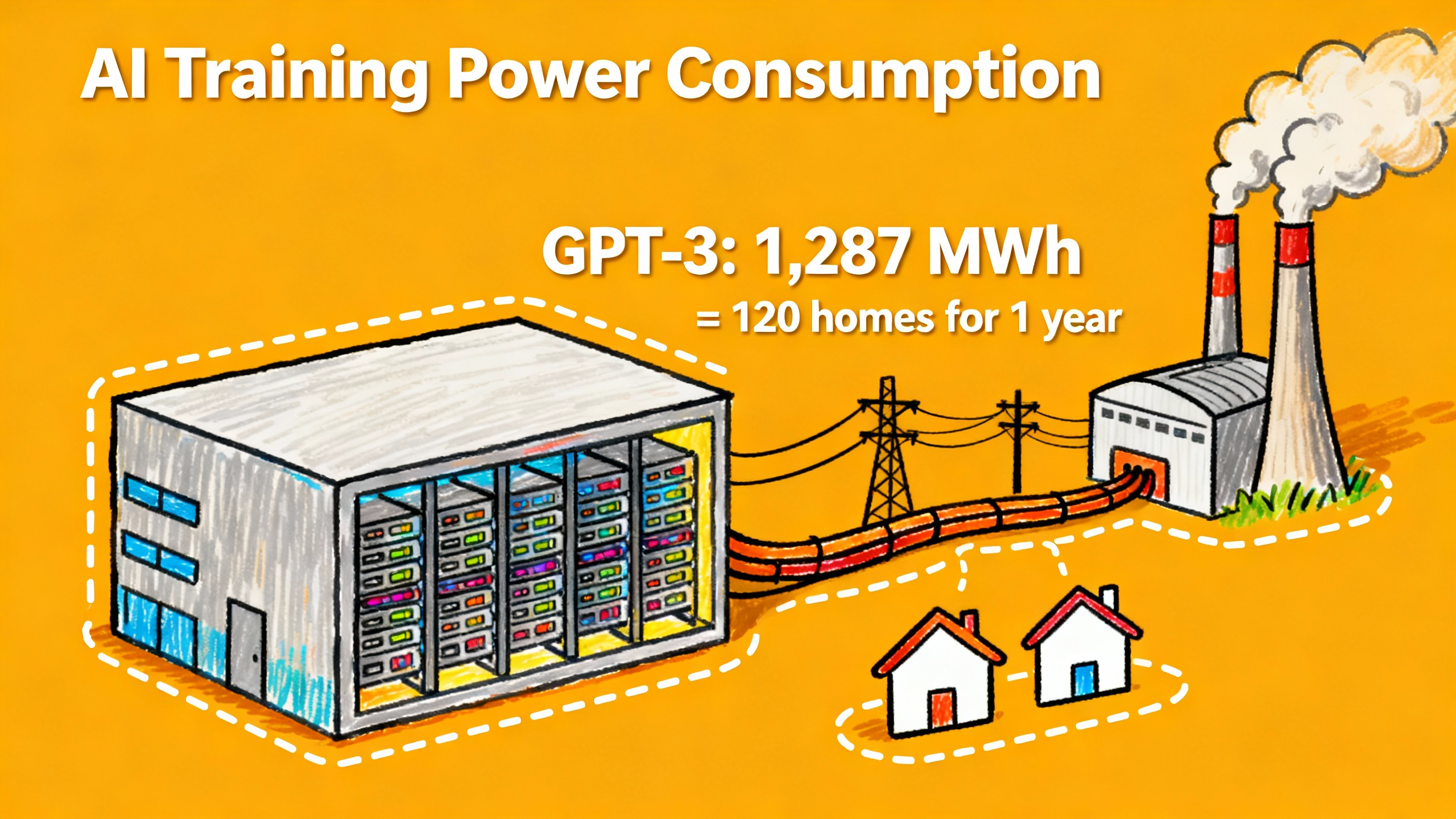

前段时间看到一个数字,把我吓了一跳:训练 GPT-3 这个模型,总共消耗了 1,287 兆瓦时的电。这是什么概念?大概相当于 120 个美国家庭一年的用电量。我当时就想,这也太夸张了吧。但仔细想想,这几年 AI 发展得这么快,ChatGPT、Midjourney 这些工具我们每天都在用,背后得有多少服务器在运转?这笔环保账到底该怎么算,我觉得值得好好聊聊。

前段时间看到一个数字,把我吓了一跳:训练 GPT-3 这个模型,总共消耗了 1,287 兆瓦时的电。这是什么概念?大概相当于 120 个美国家庭一年的用电量。

我当时就想,这也太夸张了吧。但仔细想想,这几年 AI 发展得这么快,ChatGPT、Midjourney 这些工具我们每天都在用,背后得有多少服务器在运转?这笔环保账到底该怎么算,我觉得值得好好聊聊。

数据中心里发生了什么

如果你以为 AI 模型就是跑在某台电脑上,那可就想简单了。

训练一个大型 AI 模型,需要的是专门的数据中心。这些数据中心里塞满了服务器,每台服务器上装着专门用来跑 AI 的芯片——比如英伟达的 H100 GPU。这些芯片的功耗有多大?单个 H100 的额定功率是 700 瓦,但如果算上整个服务器和数据中心的配套设施,每块 GPU 实际消耗的功率能达到 1,500 瓦左右。

更要命的是,AI 训练对算力的需求特别集中。根据国际能源署(IEA)的数据,一个 AI 训练集群消耗的能量,是普通计算工作负载的 7 到 8 倍。这就好比你家里开着一台普通电脑,突然换成了 8 台同时满负荷运转,电表转速能让你怀疑人生。

而且这些服务器不能过热,数据中心得配备大量的冷却系统。在一个现代化的数据中心里,服务器本身大概占 60% 的耗电量,剩下的很大一部分就是冷却设备在用。那些效率低一点的老数据中心,冷却系统甚至能占到总耗电量的 30% 以上。

从训练到使用,能耗账单还在继续

训练只是个开始。

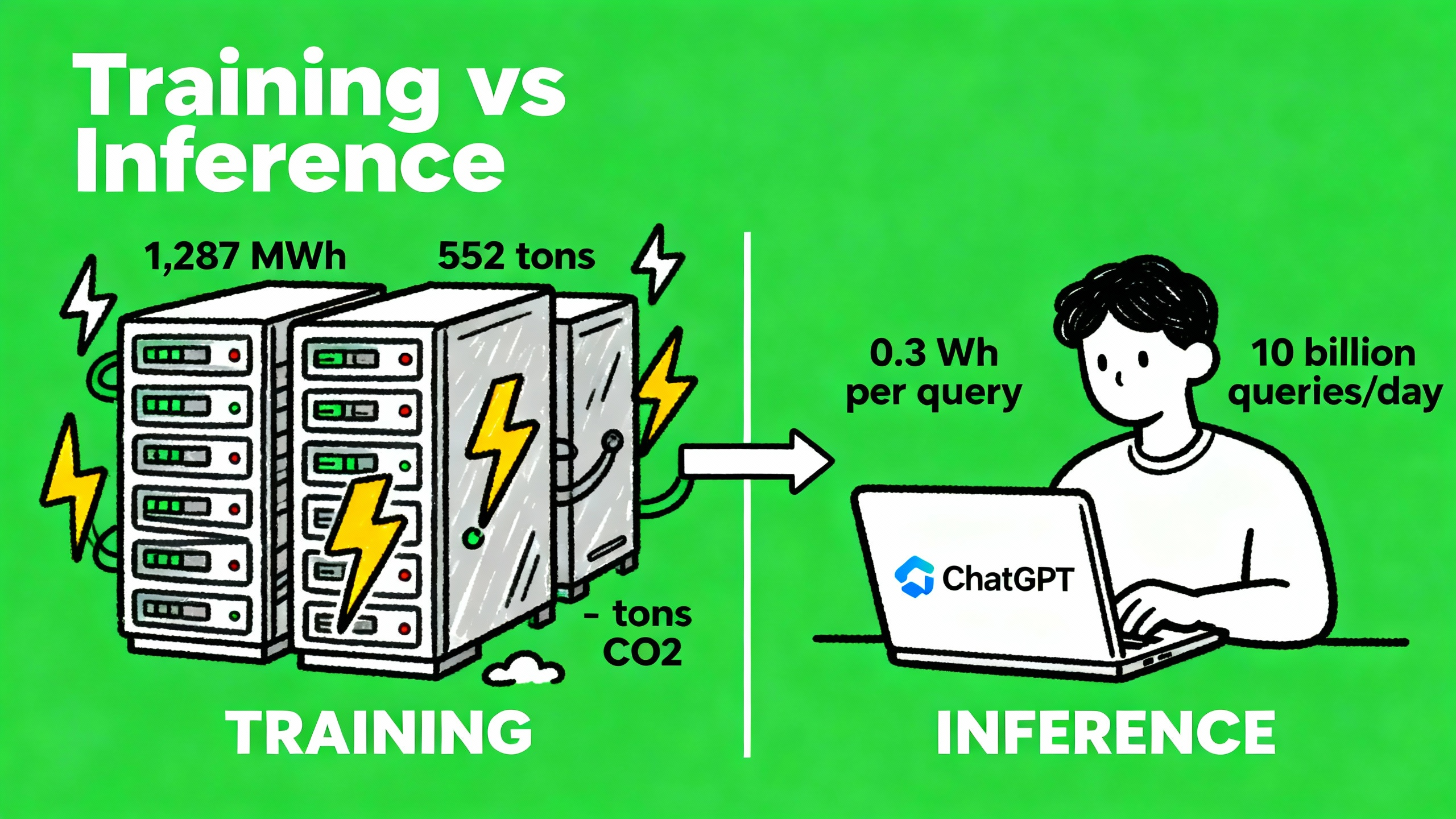

GPT-3 的训练过程消耗了 1,287 兆瓦时的电,同时排放了大约 552 吨二氧化碳。这听起来已经很多了,但如果你以为模型训练完就不耗电了,那就错了。

每次你打开 ChatGPT 问个问题,背后都有服务器在运转。Epoch AI 的研究人员算过一笔账:一次典型的 GPT-4o 查询,大概消耗 0.3 瓦时的电。这个数字单看不算大,大概就是一个 LED 灯泡亮几分钟的耗电量。但问题是,ChatGPT 现在有 3 亿用户,每天要处理 10 亿条消息。这么一算,光是 ChatGPT 的推理(也就是回答用户问题)这一项,就需要大约 12.5 兆瓦的持续功率。

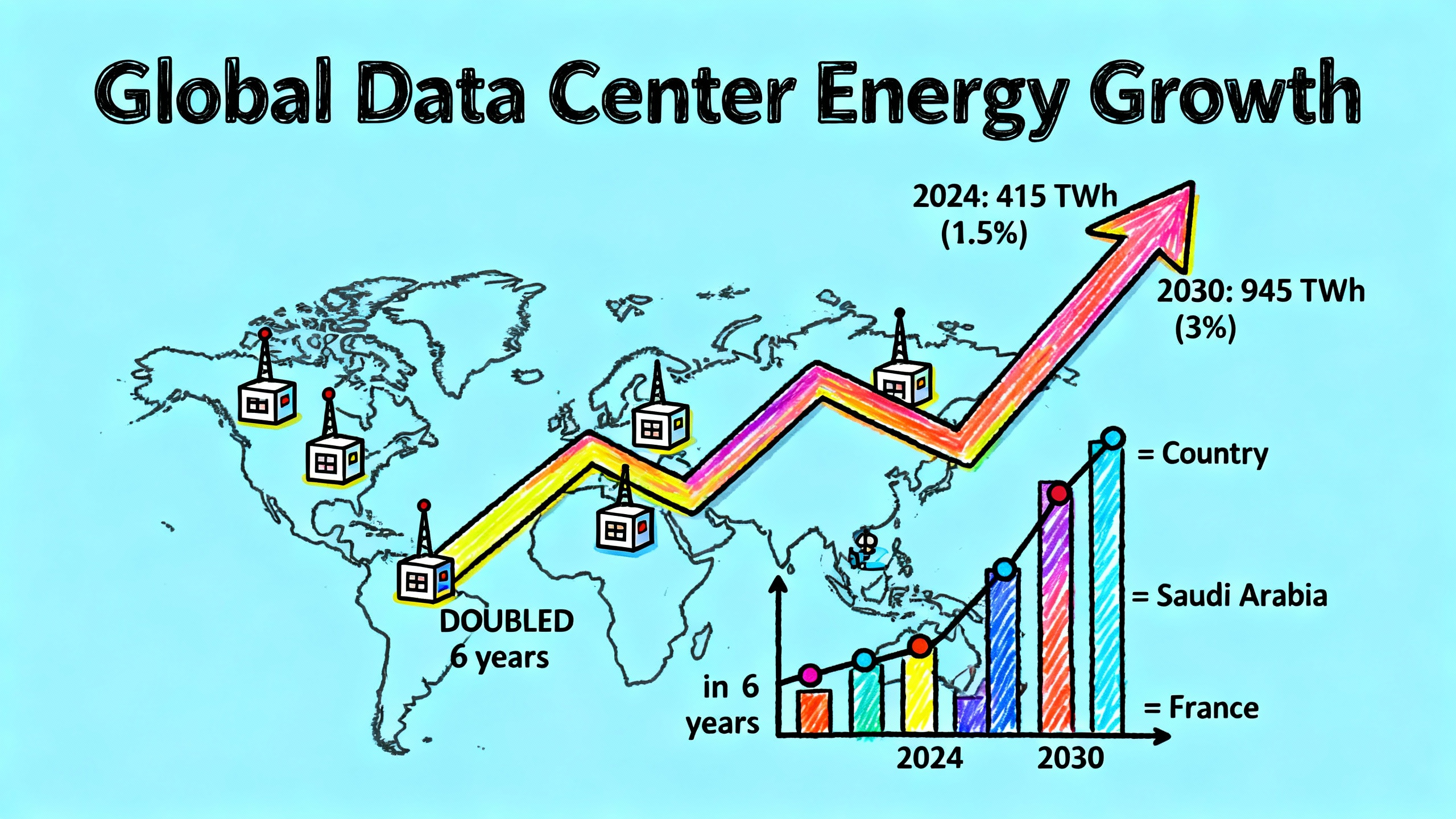

这个数字还在快速增长。2024 年,全球数据中心的总耗电量大约是 415 太瓦时(TWh),占全球总发电量的 1.5%。IEA 预测,到 2030 年,这个数字会翻倍,达到 945 太瓦时,占比接近 3%。这里面很大一部分增长,就是 AI 推动的。

更让人头疼的是,AI 训练的能耗波动特别大。训练过程中,算力需求会忽高忽低,电网得想办法应对这些波动。通常的做法是用柴油发电机来调峰,这又带来了额外的碳排放。

不只是电,还有水

说到这里,我发现大家往往只关注电,但其实还有一个容易被忽略的问题:水。

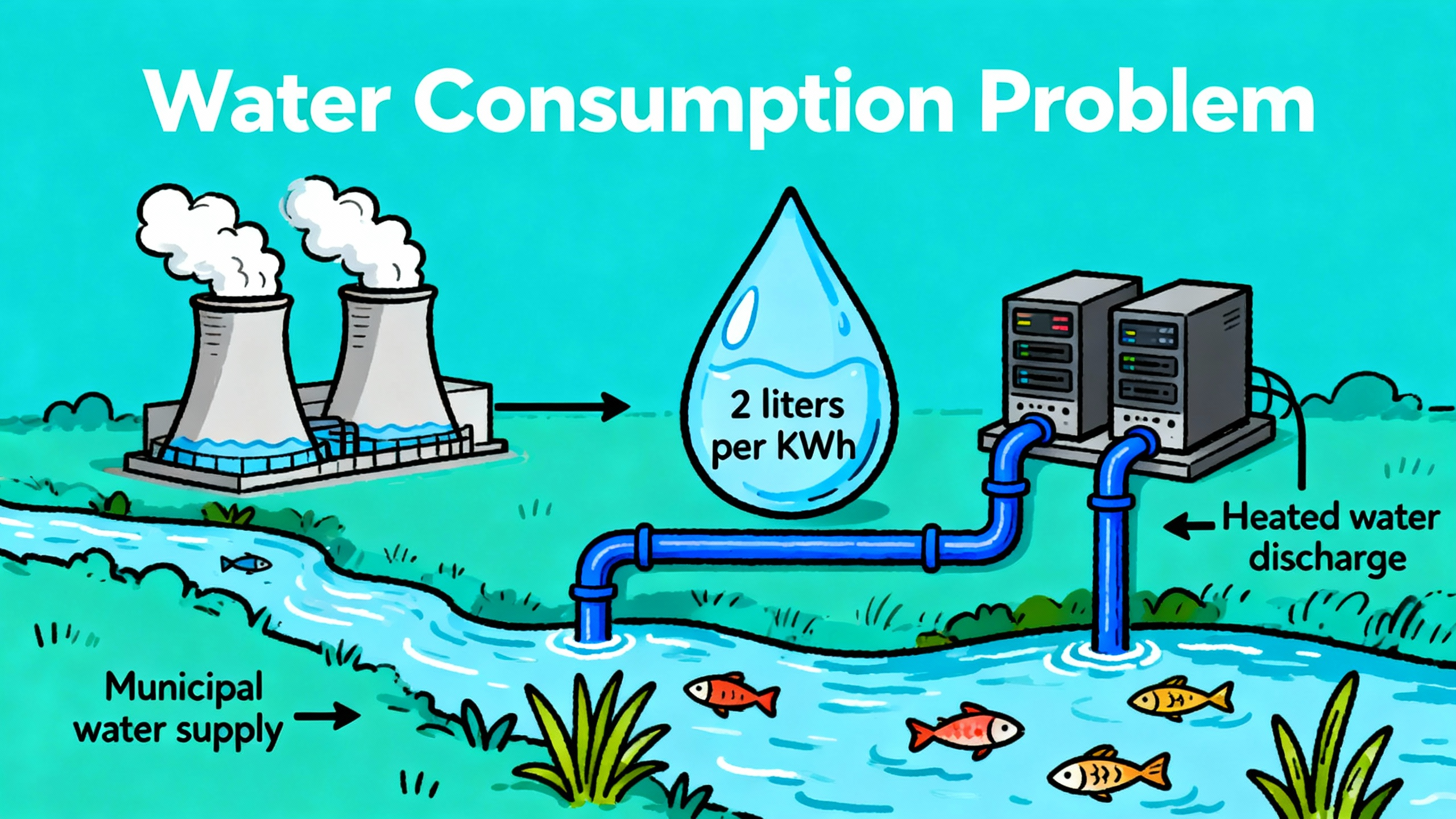

数据中心的冷却系统需要大量的水。有研究估算,数据中心每消耗 1 千瓦时的电,就需要 2 升水来冷却设备。这些水从哪里来?通常是当地的市政供水系统。

这就意味着,一个大型数据中心的运转,会给当地的水资源带来不小的压力。而且这些水用完之后,温度会升高,如果直接排放到河流或湖泊里,可能会影响当地的生态系统。

MIT 的研究人员在一篇论文里提到,AI 的环境影响不只是插上电源那一刻产生的,还包括整个系统层面的连锁反应。数据中心建在哪里,用什么样的能源,怎么处理废热和废水,这些都是环保账单的一部分。

这笔账怎么算才合理

看到这里你可能会想,那不同的模型是不是耗电量差别很大?

确实是这样。2022 年,有研究团队专门测算了 BLOOM 这个 1,760 亿参数的模型。他们发现,训练 BLOOM 大概消耗了 433 兆瓦时的电(这已经比 GPT-3 少很多了),产生了大约 25 吨的碳排放。但这里有个细节:BLOOM 的训练是在法国进行的,法国的电力主要来自核能,碳排放强度比大多数国家低 5 到 10 倍。如果换个地方训练,碳排放可能会高出好几倍。

这就引出了一个很重要的问题:能不能让 AI 训练更高效一点?

答案是肯定的,而且业界已经在做了。比如:

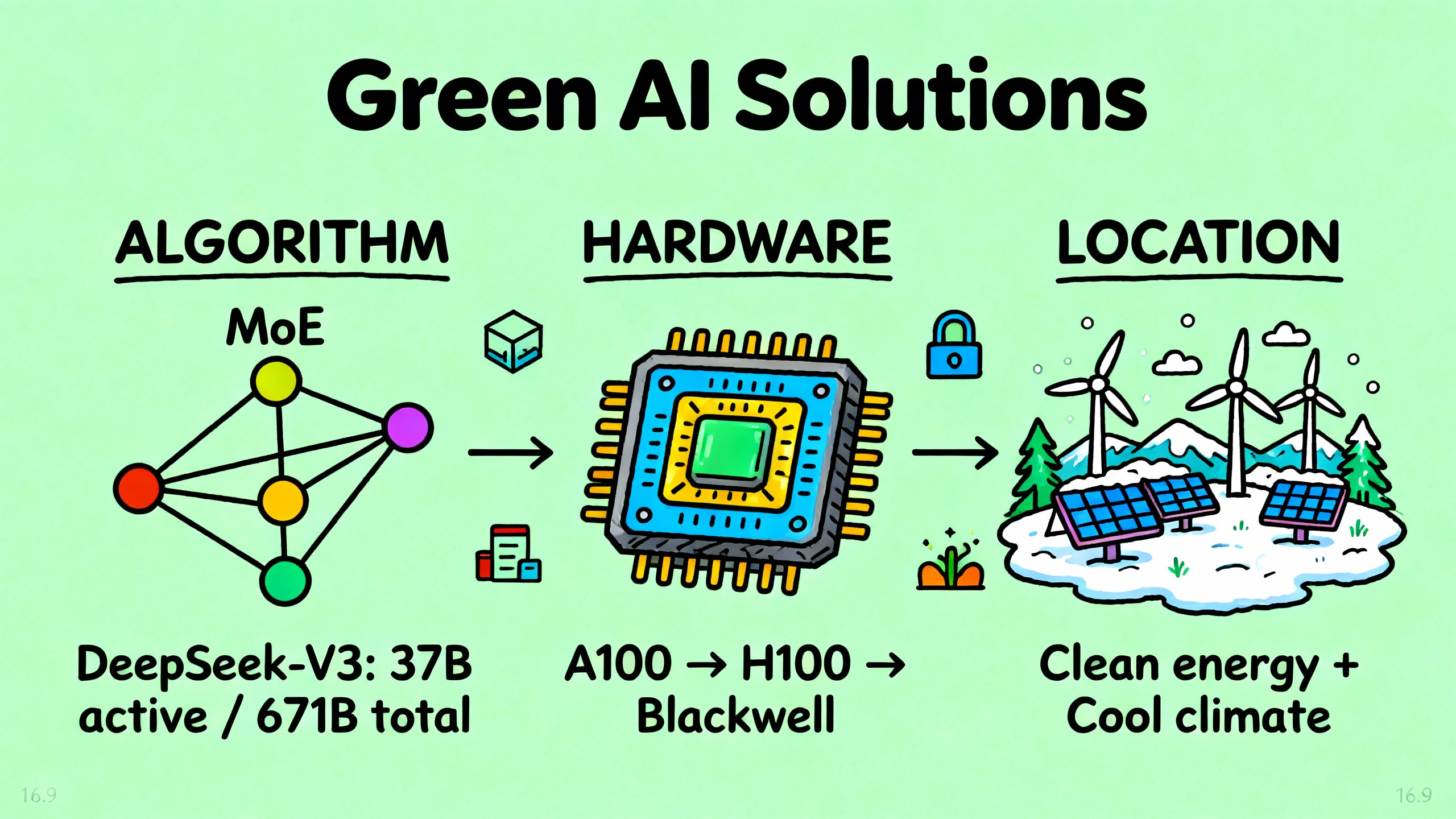

算法层面,研究人员在想办法让模型变得更"聪明"。DeepSeek-V3 这个模型,虽然总共有 6,710 亿个参数,但实际运行的时候只激活其中的 370 亿个,这种"混合专家"(MoE)架构能大幅降低能耗。OpenAI 的 GPT-4o mini 也是类似的思路,性能不错但耗电少得多。

硬件层面,芯片厂商在不断提升能效。从英伟达的 A100 到 H100,再到最新的 Blackwell 系列,每一代芯片的能效都在提升。数据中心的设计也在优化,那些超大规模的数据中心,能效比(PUE)已经能做到 1.15 左右,意思是每用 1 度电跑计算,只需要额外用 0.15 度电来维持数据中心运转。

选址策略,有些公司开始把数据中心建在电力更清洁、气候更凉爽的地方。北欧就很受欢迎,那边有大量的水电和风电,而且天气冷,冷却成本低。

但说实话,这些努力能不能跟上 AI 发展的速度,现在还不好说。模型越来越大,应用越来越多,效率提升能不能抵消规模扩张带来的能耗增长,这是个问号。

我们该如何看待这件事

写到这里,我自己也在想,这个问题到底该怎么看。

从个人使用的角度来说,每次用 ChatGPT 问个问题,0.3 瓦时的耗电量确实不算多。一个美国家庭平均每天用电 28,000 瓦时,就算你是重度用户,一天问 100 个问题,也就 30 瓦时,占比微乎其微。

把视角拉到整个行业,情况就不一样了。2024 年,AI 数据中心的耗电量已经相当于沙特阿拉伯一个国家的用电量。到 2030 年,这个数字可能会超过法国。而且这还只是保守估计,如果 AI 应用的增长速度超出预期,能耗增长可能会更快。

最大的问题在于,这些数字太不透明了。OpenAI 没有公开 GPT-4 的训练能耗,谷歌、Meta 这些公司也是。我们只能通过一些研究机构的估算来了解大概情况。但如果连基本的数据都没有,怎么去讨论责任,怎么去推动改进?

Epoch AI 的研究人员在报告里提到,公众对 AI 能耗的印象其实有很多误解,有些人觉得用一次 ChatGPT 就像开一次车那么耗能,这是夸大了。但反过来说,如果 AI 公司能更透明地公布数据,这些误解也就不会存在了。

另一个让我有点担心的是,AI 的发展速度实在太快了。数据中心从规划到建成,通常需要两三年,但 AI 模型几个月就能迭代一次。能源系统跟不上这个节奏,很多地方的电网已经开始感受到压力了。美国有些地区,电力公司甚至开始限制新建数据中心,因为电力供应跟不上了。

但话说回来,我也不觉得应该因为环保问题就停止 AI 的发展。AI 确实在很多领域带来了价值,从医疗诊断到科学研究,从提高工作效率到辅助创作。关键是怎么在发展和环保之间找到平衡。

MIT 的研究团队提出了一个观点,我觉得挺有道理:我们需要更全面地评估 AI 的环境成本和社会价值。不是说 AI 一定不该用,而是要想清楚,哪些应用真的值得投入这么多资源,哪些可能只是锦上添花甚至是浪费。

比如说,用 AI 来加速新材料研发、优化能源系统、预测气候变化,这些应用本身可能就能带来更大的环保收益。但如果只是为了生成一张无聊的图片,或者回答一个简单到 Google 搜索就能解决的问题,那就值得商榷了。

最后我想说的是,这个问题不只是 AI 公司的责任,也不只是用户的责任,而是整个社会需要一起面对的。AI 公司应该更透明地披露能耗数据,投资更高效的技术和更清洁的能源。政策制定者需要建立合理的监管框架,鼓励负责任的发展。而作为用户,我们也可以更有意识地使用这些工具,不必要的时候就少用一点。

AI 的环保账,现在才刚刚开始算。这笔账会怎么发展,很大程度上取决于我们现在做出的选择。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)