《提示工程架构师必知:Agentic AI在公共安全领域的创新应用》

本文将从提示工程架构师的视角,拆解Agentic AI(智能体AI)在公共安全领域的创新应用。我们会结合实际场景(如智能视频监控、应急响应、舆情联动),讲解如何用提示工程设计“能自主决策、会调用工具、可动态优化”的Agentic系统,解决传统AI的“能力边界”问题。我们选择**“智能视频监控中的异常事件检测与处置”**作为核心场景。实时检测:从视频流中识别异常(如斗殴、火灾、人员聚集);自主决策:

《Agentic AI赋能公共安全:提示工程架构师必知的创新应用与实现路径》

一、引言:公共安全的“智能升级”痛点与Agentic AI的破局之道

1. 痛点引入:当传统AI遇到公共安全的“复杂战场”

凌晨2点的商场监控画面中,一个黑影突然闪过货架——是小偷?还是工作人员晚归?传统视频监控系统只能触发“移动物体检测”的报警,却无法判断“是否需要立即出警”;

某社区突发火灾,监控系统拍到了烟雾,但无法自动调用周边摄像头确认火势蔓延情况,也不知道该通知哪个消防中队最快到达;

舆情系统监测到“某地铁站有人持刀”的消息,却无法联动视频监控核实事件真实性,导致警方误判响应等级……

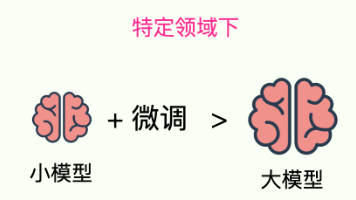

这些场景,是公共安全领域的“日常痛点”:数据多(视频、音频、文本舆情)、场景杂(盗窃、火灾、斗殴、恐怖袭击)、要求高(实时性、准确性、可解释性)。传统AI系统(如单一的目标检测模型、规则引擎)要么“只会做一件事”,要么“不会灵活决策”,难以应对复杂的公共安全挑战。

2. 文章内容概述:用Agentic AI构建“会思考的公共安全助手”

本文将从提示工程架构师的视角,拆解Agentic AI(智能体AI)在公共安全领域的创新应用。我们会结合实际场景(如智能视频监控、应急响应、舆情联动),讲解如何用提示工程设计“能自主决策、会调用工具、可动态优化”的Agentic系统,解决传统AI的“能力边界”问题。

3. 读者收益:从“懂理论”到“能落地”

读完本文,你将掌握:

- Agentic AI在公共安全的核心价值:为什么它比传统AI更适合处理复杂场景?

- 提示工程设计技巧:如何用思维链、少样本提示让智能体“会思考”?

- 实战步骤:从“定义智能体角色”到“集成工具”,手把手实现一个“智能视频监控异常处置智能体”;

- 避坑指南:公共安全领域应用Agentic AI的关键注意事项(如安全性、可解释性)。

二、准备工作:你需要知道的“前置知识”

1. 技术栈与知识储备

- Agentic AI基础:了解智能体(Agent)的核心概念(自主决策、目标分解、工具调用),熟悉LangChain、LlamaIndex等Agent框架;

- 提示工程经验:掌握思维链(Chain of Thought)、少样本提示(Few-Shot Prompting)、自我反思(Self-Reflection)等技巧;

- 公共安全领域常识:了解公共安全的常见场景(视频监控、应急响应、舆情分析)、行业规范(如“人类监督”要求);

- 工具集成能力:会调用API(如公安内部的警力分布接口、视频监控数据库)、使用计算机视觉模型(如YOLOv8、OpenCV)。

2. 环境与工具准备

- 大语言模型:推荐使用GPT-4、Claude 3(支持工具调用与长文本处理);

- Agent框架:LangChain(成熟的工具链与Agent实现)、LlamaIndex(适合多模态数据处理);

- 数据处理工具:OpenCV(视频流处理)、YOLOv8(目标检测)、Pandas(数据清洗);

- 开发环境:Python 3.10+、VS Code、Postman(接口调试)。

三、核心实战:构建“智能视频监控异常处置智能体”

场景定义:解决什么问题?

我们选择**“智能视频监控中的异常事件检测与处置”**作为核心场景。目标是让智能体实现:

- 实时检测:从视频流中识别异常(如斗殴、火灾、人员聚集);

- 自主决策:判断事件严重程度,调用工具(如警力分布API、周边摄像头)获取更多信息;

- 动态处置:生成可执行的处置建议(如“通知消防中队”“调动附近警力”),并接受人类反馈优化。

步骤一:定义智能体的“目标与角色”

Agentic AI的核心是**“角色定位”**——你需要明确:“这个智能体是谁?它要做什么?它有哪些权限?”

1. 角色定义

- 名称:公共安全视频监控智能体(PS-VSA, Public Safety Video Surveillance Agent);

- 定位:辅助公安值班人员的“智能决策助手”;

- 目标:实时分析视频流,检测异常事件,生成精准的处置建议;

- 权限:可调用视频监控系统、警力分布API、舆情数据库,但所有处置建议需经人类确认后执行(符合公共安全的“人类监督”要求)。

2. 为什么要明确角色?

公共安全领域的AI应用,“边界感”比“能力强”更重要。如果智能体没有明确的角色定位,可能会出现“越权决策”(如未经确认直接通知消防中队),或“决策模糊”(如无法判断“是否需要出警”)。提示工程架构师的任务,就是用角色提示把智能体“框在安全范围内”。

步骤二:用提示工程设计“智能体的思考逻辑”

提示工程是Agentic AI的“大脑设计图”。对于公共安全场景,我们需要让智能体**“像人类民警一样思考”**——从“发现异常”到“解决问题”,逐步分解任务,并给出可解释的决策过程。

1. 设计思路:思维链(CoT)+ 少样本(Few-Shot)

- 思维链:让智能体把复杂任务分解为“可执行的步骤”(如“检测异常→确认类型→调用工具→生成建议”);

- 少样本:用“真实案例”教会智能体“如何处理具体场景”(如“火灾”“斗殴”的不同处置方式)。

2. 具体提示模板(以“视频监控异常处置”为例)

# 角色定位

你是“公共安全视频监控智能体(PS-VSA)”,负责辅助公安值班人员处理视频监控中的异常事件。你的核心规则是:

1. 所有决策必须“可解释”(需说明“为什么这么做”);

2. 所有处置建议必须“经人类确认”(不能直接执行操作);

3. 优先使用“权威工具数据”(如警力分布API、消防中队位置数据库)。

# 任务分解(思维链)

当收到视频监控异常报警时,你需要按以下步骤思考:

步骤1:**验证异常真实性**(调用“视频帧复核工具”,确认是否为误报,如光线变化、动物移动);

步骤2:**分类异常类型**(根据视频内容判断:火灾、斗殴、人员聚集、盗窃等);

步骤3:**评估严重程度**(使用“异常等级评估工具”,如“火灾”分为“小型(烟雾)、中型(明火)、大型(蔓延)”);

步骤4:**调用辅助工具**(如“警力分布API”获取最近的派出所位置,“消防中队数据库”获取最快到达的消防队伍);

步骤5:**生成处置建议**(包括:事件描述、严重等级、所需资源、行动步骤)。

# 少样本示例(火灾场景)

输入:视频监控拍到“某商场3楼女装区有烟雾,且有人员惊慌逃窜”。

思考过程:

1. 调用“视频帧复核工具”,确认烟雾为“真实火灾”(非误报);

2. 分类异常类型为“火灾”;

3. 调用“异常等级评估工具”,判断为“中型(有烟雾+人员逃窜,未发现明火)”;

4. 调用“消防中队数据库”,获取“距离商场最近的消防中队是‘XX消防中队’,车程5分钟”;

5. 生成处置建议:

- 事件描述:某商场3楼女装区发生火灾(中型),有烟雾,人员惊慌逃窜;

- 严重等级:中型(需立即出警);

- 所需资源:XX消防中队1辆水罐消防车、3名消防员;

- 行动步骤:1. 通知XX消防中队出警;2. 联动商场物业关闭电梯、开启消防通道;3. 提醒值班人员关注火势蔓延情况。

# 输出要求

请用“结构化格式”输出,方便值班人员快速查看:

【事件描述】:[具体场景,如“某商场3楼女装区有烟雾”]

【异常类型】:[火灾/斗殴/人员聚集等]

【严重等级】:[小型/中型/大型]

【工具调用记录】:[调用的工具名称及结果,如“视频帧复核工具:确认非误报”]

【处置建议】:[具体行动步骤,需包含“所需资源”“注意事项”]

【思考过程】:[用自然语言说明“为什么这么做”]

3. 为什么要这样设计?

- 思维链:解决了“智能体不会分解任务”的问题。比如传统AI可能直接输出“火灾”报警,但智能体需要知道“为什么判断为火灾”“需要调用什么工具”;

- 少样本:解决了“智能体不会处理具体场景”的问题。比如“火灾”和“斗殴”的处置方式完全不同,少样本能让智能体快速学会“差异化决策”;

- 规则约束:解决了“智能体越权”的问题。比如“所有建议需经人类确认”的规则,用提示写进智能体的“潜意识”里,避免出现“擅自行动”的风险。

步骤三:集成工具与数据,让智能体“会用工具”

Agentic AI的优势在于**“能调用工具扩展能力”**。对于公共安全场景,我们需要集成以下几类工具:

1. 工具分类与实现

| 工具名称 | 功能描述 | 实现方式 |

|---|---|---|

| 视频帧复核工具 | 验证异常是否为误报(如光线变化、动物) | OpenCV+YOLOv8(检测目标) |

| 异常等级评估工具 | 评估异常严重程度(如火灾分为小型/中型) | 规则引擎(基于专家知识) |

| 警力分布API | 获取最近派出所的位置与可用警力 | 公安内部接口(RESTful) |

| 消防中队数据库 | 获取最快到达的消防中队位置 | 关系型数据库(MySQL) |

2. 工具调用的提示设计

为了让智能体“正确使用工具”,我们需要在提示中明确**“什么时候调用工具”“如何调用工具”**。例如:

# 工具调用规则

- 当需要“验证异常真实性”时,必须调用“视频帧复核工具”;

- 当需要“获取警力/消防资源位置”时,必须调用对应的API/数据库;

- 工具调用的格式要求:<|FunctionCallBegin|>[{"name":"工具名称","parameters":{"参数1":"值1","参数2":"值2"}}]<|FunctionCallEnd|>;

- 工具返回结果后,必须“解释结果用途”(如“根据警力分布API返回的‘XX派出所距离事件地点1公里’,建议调用该派出所警力”)。

3. 代码示例:用LangChain集成工具

以下是用LangChain实现“工具调用”的核心代码(以“视频帧复核工具”和“警力分布API”为例):

from langchain.agents import Tool, initialize_agent

from langchain.chat_models import ChatOpenAI

from langchain.prompts import PromptTemplate

import requests

import cv2

from ultralytics import YOLO

# 1. 定义“视频帧复核工具”(用YOLOv8检测异常)

def video_frame_review(frame_path: str) -> str:

# 加载YOLOv8模型(预训练的异常事件检测模型)

model = YOLO("yolov8n-anomaly.pt")

# 读取视频帧

frame = cv2.imread(frame_path)

# 检测异常(返回异常类型:火灾、斗殴、人员聚集等)

results = model(frame)

# 解析结果(取置信度最高的异常类型)

if results[0].boxes:

anomaly_type = results[0].boxes[0].cls[0].item()

anomaly_map = {0: "火灾", 1: "斗殴", 2: "人员聚集", 3: "盗窃"}

return f"异常类型:{anomaly_map[anomaly_type]},置信度:{results[0].boxes[0].conf[0].item():.2f}"

else:

return "未检测到异常(误报)"

# 2. 定义“警力分布API”(调用公安内部接口)

def police_force_api(area: str) -> str:

url = "https://police-api.example.com/force-distribution"

params = {"area": area}

response = requests.get(url, params=params)

if response.status_code == 200:

data = response.json()

return f"最近派出所:{data['nearest_station']},距离:{data['distance']}公里,可用警力:{data['available_officers']}人"

else:

return "警力分布API调用失败"

# 3. 注册工具到LangChain

tools = [

Tool(

name="VideoFrameReviewTool",

func=video_frame_review,

description="用于复核视频帧中的异常事件,输入视频帧路径,返回异常类型与置信度"

),

Tool(

name="PoliceForceAPI",

func=police_force_api,

description="用于获取指定区域的警力分布情况,输入区域名称(如“XX路XX商场”),返回最近派出所信息"

)

]

# 4. 初始化大语言模型与Agent

llm = ChatOpenAI(model_name="gpt-4", temperature=0) # 温度设为0,保证决策稳定

agent = initialize_agent(

tools,

llm,

agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION, # 适合聊天场景的工具调用Agent

verbose=True, # 输出思考过程(方便调试)

handle_parsing_errors=True # 处理工具调用格式错误

)

# 5. 测试工具调用(以“商场火灾”为例)

input_prompt = """

视频监控报警:“某商场3楼女装区有烟雾,且有人员惊慌逃窜”。请按照以下步骤处理:

1. 调用“视频帧复核工具”,确认异常类型;

2. 调用“警力分布API”,获取商场周边的警力信息;

3. 生成处置建议(需包含异常类型、警力信息、行动步骤)。

"""

# 运行Agent

response = agent.run(input_prompt)

print("智能体输出:\n", response)

4. 代码说明

- 工具定义:

video_frame_review函数用YOLOv8检测视频帧中的异常,police_force_api函数调用公安内部API获取警力分布; - Agent初始化:使用

CHAT_ZERO_SHOT_REACT_DESCRIPTION类型的Agent,支持“聊天式”工具调用(适合与值班人员交互); - 测试输入:模拟“商场火灾”的报警场景,Agent会自动调用两个工具,并生成处置建议。

步骤四:动态决策与反馈优化

公共安全场景的“动态性”很强——比如“火灾”可能从“小型烟雾”蔓延到“大型明火”,“斗殴”可能从“两人冲突”升级为“群体事件”。Agentic AI的优势在于**“能根据新信息调整决策”**。

1. 动态决策的实现:用“多轮工具调用”

例如,当智能体检测到“商场有烟雾”时,会先调用“视频帧复核工具”确认异常类型(如“火灾”),然后调用“消防中队数据库”获取最近的消防队伍位置。如果此时“烟雾浓度升高”(新的视频帧信息),智能体会自动触发第二轮工具调用:调用“火灾蔓延预测工具”(用机器学习模型预测火势),并更新处置建议(如“增加消防队伍数量”)。

2. 反馈优化:用“人类反馈”改进提示

公共安全领域的AI应用,“人类信任”比“ accuracy”更重要。如果值班人员修改了智能体的处置建议(如“智能体建议调用3名民警,值班人员认为需要5名”),我们需要把这些反馈“喂给”智能体,优化它的决策逻辑。

(1)收集反馈的方式

- 主动询问:在智能体生成建议后,添加“是否需要调整?”的提示(如“值班人员,你认为这个建议是否合适?如需修改,请说明原因。”);

- 被动记录:通过系统日志记录值班人员对建议的修改(如“2024-05-01 02:30,值班人员将‘3名民警’修改为‘5名民警’,原因:‘斗殴事件升级为群体冲突’”)。

(2)用反馈优化提示:示例

假设值班人员修改了“斗殴事件”的处置建议(将“3名民警”改为“5名民警”),我们可以在提示模板中添加**“反馈案例”**:

# 反馈优化案例(斗殴事件)

原智能体建议:调用3名民警前往现场;

值班人员修改:调用5名民警(原因:“斗殴事件升级为群体冲突,需要更多警力控制场面”);

优化后的思考步骤:

当检测到“斗殴事件”且“参与人数超过5人”时,调用“警力分布API”获取“可用警力≥5名”的派出所,并建议调用该派出所的全部可用警力。

(3)代码示例:用“反馈循环”更新提示

from langchain.memory import ConversationBufferMemory

# 初始化记忆模块(用于存储人类反馈)

memory = ConversationBufferMemory(memory_key="chat_history", return_messages=True)

# 优化后的提示模板(加入反馈案例)

updated_prompt = """

# 角色定位

你是“公共安全视频监控智能体(PS-VSA)”,负责辅助公安值班人员处理视频监控中的异常事件。你的核心规则是:

1. 所有决策必须“可解释”(需说明“为什么这么做”);

2. 所有处置建议必须“经人类确认”(不能直接执行操作);

3. 优先使用“权威工具数据”(如警力分布API、消防中队位置数据库)。

# 任务分解(思维链)

当收到视频监控异常报警时,你需要按以下步骤思考:

步骤1:**验证异常真实性**(调用“视频帧复核工具”,确认是否为误报);

步骤2:**分类异常类型**(根据视频内容判断:火灾、斗殴、人员聚集、盗窃等);

步骤3:**评估严重程度**(使用“异常等级评估工具”);

步骤4:**调用辅助工具**(如“警力分布API”“消防中队数据库”);

步骤5:**生成处置建议**(需包含异常类型、警力信息、行动步骤)。

# 反馈优化案例(斗殴事件)

原智能体建议:调用3名民警前往现场;

值班人员修改:调用5名民警(原因:“斗殴事件升级为群体冲突,需要更多警力控制场面”);

优化后的规则:当“斗殴事件”的“参与人数超过5人”时,建议调用“可用警力≥5名”的派出所。

# 输入要求

请根据以下输入,生成处置建议:

{chat_history} # 记忆模块中的历史对话(包括人类反馈)

当前输入:{input}

"""

# 重新初始化Agent(加入记忆模块)

agent = initialize_agent(

tools,

llm,

agent=AgentType.CHAT_ZERO_SHOT_REACT_DESCRIPTION,

verbose=True,

memory=memory,

prompt=PromptTemplate(template=updated_prompt, input_variables=["chat_history", "input"])

)

# 测试反馈优化(模拟值班人员修改建议)

# 第一轮输入:模拟“斗殴事件”报警

input_1 = "视频监控拍到“某商场门口有5人斗殴,有肢体冲突”。"

response_1 = agent.run(input_1)

print("第一轮输出:\n", response_1)

# 模拟值班人员反馈:“需要增加到5名民警,因为参与人数较多”

input_2 = "值班人员反馈:‘建议调用5名民警,参与人数超过5人’。"

response_2 = agent.run(input_2)

print("第二轮输出(反馈后):\n", response_2)

# 第三轮输入:模拟“更大规模的斗殴事件”

input_3 = "视频监控拍到“某广场有10人斗殴,有人持械”。"

response_3 = agent.run(input_3)

print("第三轮输出(优化后):\n", response_3)

3. 效果预期

- 第一轮输出:智能体可能会建议“调用3名民警”(根据初始规则);

- 第二轮反馈:值班人员修改建议后,Agent会将“参与人数超过5人需调用5名民警”的规则存入记忆;

- 第三轮输出:当遇到“10人斗殴”的场景时,Agent会自动调用“警力分布API”获取“可用警力≥5名”的派出所,并建议调用5名民警(符合反馈后的规则)。

步骤五:可解释性设计——让值班人员“信任智能体”

公共安全领域的AI应用,“可解释性”是生死线。如果值班人员无法理解智能体的“思考过程”,就不会信任它的建议。提示工程架构师的任务,是用**“思考过程可视化”**让智能体“把决策逻辑说清楚”。

1. 可解释性的实现方式

- 强制输出“思考过程”:在提示模板中要求智能体“每一步都要说明原因”(如“为什么调用这个工具?”“为什么建议这个行动?”);

- 使用“结构化输出”:用列表、表格等形式展示决策步骤(如“步骤1:验证异常→步骤2:分类类型→步骤3:调用工具→步骤4:生成建议”);

- 关联“权威数据”:在建议中注明“数据来源”(如“根据警力分布API返回的‘XX派出所有5名可用民警’,建议调用该派出所”)。

2. 示例:可解释的处置建议

智能体输出:

【事件描述】:某广场有10人斗殴,有人持械,现场有围观群众。

【异常类型】:斗殴事件(群体冲突)

【严重等级】:大型(持械、参与人数多)

【工具调用记录】:

1. 视频帧复核工具:确认异常类型为“斗殴事件”(置信度95%);

2. 警力分布API:获取广场周边的“XX派出所”(距离1.2公里,可用警力5名);

3. 异常等级评估工具:评估为“大型”(持械+参与人数超过10人)。

【处置建议】:

- 调用“XX派出所”的5名民警前往现场(数据来源:警力分布API);

- 通知辖区交警部门封闭广场周边道路(避免车辆进入);

- 联系120急救中心(预防人员受伤)。

【思考过程】:

1. 视频帧复核工具确认“斗殴事件”为真实异常(非误报);

2. 参与人数超过10人且有持械,根据“反馈优化案例”,需要调用“可用警力≥5名”的派出所;

3. XX派出所距离最近且有5名可用民警,符合要求;

4. 封闭道路和联系120是“大型斗殴事件”的标准处置流程(根据专家规则)。

四、进阶探讨:Agentic AI在公共安全的“未来方向”

1. 多模态联动:从“单一数据”到“综合判断”

公共安全事件的“线索”往往分散在多模态数据中:

- 视频:拍到“商场烟雾”;

- 音频:拍到“人群尖叫”;

- 文本:舆情系统监测到“某商场着火”的微博。

Agentic AI的下一步,是**“整合多模态数据”**——用提示工程让智能体“同时分析视频、音频、文本数据”,更准确地判断事件真实性(如“视频中的烟雾+音频中的尖叫+文本中的舆情”,可确认“火灾”的真实性)。

2. 群体智能:从“单智能体”到“多智能体协同”

复杂的公共安全事件(如“大型演唱会的 crowd 控制”),需要多个智能体协同工作:

- 视频监控智能体(负责检测异常);

- 舆情分析智能体(负责监测社交媒体中的负面消息);

- 应急响应智能体(负责协调消防、医疗、警力)。

提示工程架构师的任务,是用**“群体提示”**设计智能体之间的“沟通规则”(如“视频监控智能体发现异常后,需通知舆情分析智能体核实消息”)。

3. 轻量化与边缘部署:从“云端”到“边缘”

公共安全的“实时性”要求很高(如“火灾”需要在3分钟内通知消防中队)。传统的“云端Agentic AI”(依赖大语言模型)可能会有“延迟”问题。未来的方向是**“边缘Agentic AI”**——用轻量化的大语言模型(如Llama 2 7B)和工具链,将智能体部署在摄像头、边缘服务器上,实现“本地实时决策”。

4. 安全性与可靠性:从“能做事”到“不出事”

公共安全领域的AI应用,“不出错”比“能做事”更重要。提示工程架构师需要关注:

- 对抗攻击防御:防止黑客篡改视频帧(如用DeepFake生成“虚假火灾”),用“多源数据验证”(如视频+音频+舆情)抵御攻击;

- 人类监督机制:用“强制确认”规则(如“智能体的建议必须经值班人员点击‘确认’按钮才能执行”),避免“越权决策”;

- 故障恢复:当工具调用失败(如警力分布API宕机),智能体需自动切换到“备用方案”(如调用“周边派出所的电话”)。

五、总结:Agentic AI是公共安全的“智能伙伴”

1. 核心要点回顾

- Agentic AI的价值:解决传统AI“不会灵活决策”的问题,能处理公共安全领域的“复杂场景”;

- 提示工程的作用:用思维链、少样本、反馈优化,让智能体“像人类一样思考”;

- 实现步骤:定义角色→设计提示→集成工具→动态决策→反馈优化;

- 关键原则:“可解释性”“人类监督”“边界感”是公共安全AI应用的“生命线”。

2. 成果展示:我们实现了什么?

通过本文的步骤,我们构建了一个**“能思考、会调用工具、可动态优化”**的公共安全视频监控智能体。它能:

- 实时检测视频中的异常事件(如火灾、斗殴);

- 自主调用工具获取警力、消防资源信息;

- 生成可解释的处置建议(符合公共安全的“人类监督”要求);

- 根据值班人员的反馈,不断优化决策逻辑。

3. 鼓励与展望

公共安全领域的Agentic AI应用,“落地比创新更重要”。作为提示工程架构师,你不需要追求“最先进的模型”,而是要关注“最适合的场景”——比如“智能视频监控”“舆情联动应急”“社区安全巡检”。

不妨从**“小场景”**开始尝试:比如为你的社区设计一个“流浪狗聚集检测智能体”(用视频监控检测流浪狗,调用社区物业的“狗只管理工具”,生成“捕捉建议”)。当你完成这个小项目,你会更深刻地理解:Agentic AI不是“取代人类”,而是“成为人类的智能伙伴”。

六、行动号召:一起构建“更安全的世界”

如果你是提示工程架构师,或公共安全领域的从业者:

- 分享你的经验:在评论区留言,说说你遇到的“公共安全AI应用痛点”,我们一起讨论解决方案;

- 尝试小项目:用本文的步骤,构建一个“智能体小应用”(如“社区火灾报警智能体”),并分享你的成果;

- 提出问题:如果你对Agentic AI的实现细节有疑问(如“如何集成消防中队数据库”“如何设计反馈循环”),欢迎在评论区提问,我会一一解答。

公共安全是“每个人的事”,而Agentic AI是“我们的工具”。让我们一起用技术,让世界更安全!

作者:[你的名字]

公众号:[你的技术公众号]

备注:本文代码示例已上传至GitHub(链接),欢迎Star和Fork!

更多推荐

已为社区贡献126条内容

已为社区贡献126条内容

所有评论(0)