【AIGC篇】深度探究剖析AIGC技术背后那些所谓的算法设计及应用

AIGC 技术涵盖了多种人工智能算法和技术,其核心目标是让机器模拟人类的创造力和创作能力。它主要基于深度学习技术,尤其是神经网络架构,通过对大量数据的学习和训练,使机器能够生成具有一定逻辑性、连贯性和创造性的内容。

别急,花总是会开的!

目录

一、引言

随着人工智能技术的飞速发展,AIGC(AI Generated Content,人工智能生成内容)技术已经成为当今科技领域最热门的话题之一。AIGC 技术能够自动生成文本、图像、音频、视频等多种形式的内容,为内容创作、艺术设计、广告营销、影视制作、软件开发等众多领域带来了前所未有的变革。从自动撰写新闻报道、创作诗歌和小说,到生成逼真的虚拟人物图像和沉浸式的虚拟场景,AIGC 展现出了巨大的潜力和应用前景。在这篇文章中,我们将深入探讨 AIGC 技术背后的核心算法,分析其工作原理,并通过 C++ 代码示例来展示一些关键算法的实现细节,旨在帮助读者更好地理解这一革命性技术的内在机制。

二、AIGC 技术概述

AIGC 技术涵盖了多种人工智能算法和技术,其核心目标是让机器模拟人类的创造力和创作能力。它主要基于深度学习技术,尤其是神经网络架构,通过对大量数据的学习和训练,使机器能够生成具有一定逻辑性、连贯性和创造性的内容。AIGC 技术的兴起得益于以下几个关键因素:

2.1数据的爆炸式增长:

互联网的普及和数字设备的广泛使用,使得海量的数据被存储和共享,为 AIGC 的训练提供了丰富的素材,涵盖了各种领域和风格的内容,为算法学习提供了充足的样本。

2.2计算能力的提升:

GPU(图形处理器)和 TPU(张量处理器)等专用硬件的发展,极大地加速了深度学习算法的训练和推理过程,使得训练大规模神经网络成为可能。

2.3深度学习算法的进步:

各种新型的神经网络架构和优化算法的涌现,如生成对抗网络(GANs)、变分自编码器(VAEs)和 Transformer 架构,为 AIGC 的实现提供了强大的理论和技术支持。

三、核心算法解析:

3.1生成对抗网络(GANs):

生成对抗网络(GANs)是 AIGC 领域中最具代表性的算法之一,由生成器(Generator)和判别器(Discriminator)组成。生成器的任务是生成看似真实的数据,而判别器的任务是区分生成的数据和真实数据。通过两者之间的对抗训练,生成器不断提高生成数据的质量,直到判别器难以区分生成数据和真实数据。

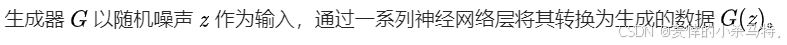

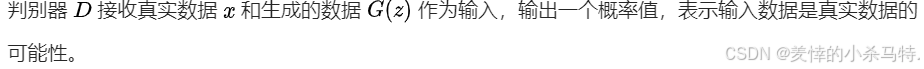

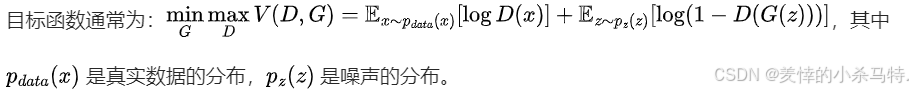

基本原理:

①

②

③

下面展示一个简单的 GANs 生成器和判别器的 C++ 代码示例,使用了 C++ 的深度学习库如 TensorFlow C++ API 或 DLib:

#include <iostream>

#include <tensorflow/core/framework/tensor.h>

#include <tensorflow/core/platform/env.h>

#include <tensorflow/core/public/session.h>

// 定义生成器

tensorflow::Tensor Generator(const tensorflow::Tensor& noise) {

// 这里使用简单的全连接层作为示例,实际中会使用更复杂的网络结构

tensorflow::TensorShape input_shape = noise.shape();

int input_size = input_shape.dim_size(0);

tensorflow::TensorShape output_shape({input_size, 784});

tensorflow::Tensor weights(tensorflow::DT_FLOAT, tensorflow::TensorShape({input_size, 784}));

tensorflow::Tensor biases(tensorflow::DT_FLOAT, tensorflow::TensorShape({784}));

// 初始化权重和偏置,这里使用随机初始化

auto weights_flat = weights.flat<float>();

auto biases_flat = biases.flat<float>();

for (int i = 0; i < weights_flat.size(); ++i) {

weights_flat(i) = static_cast<float>(rand()) / RAND_MAX;

}

for (int i = 0; i < biases_flat.size(); ++i) {

biases_flat(i) = static_cast<float>(rand()) / RAND_MAX;

}

tensorflow::Tensor output(tensorflow::DT_FLOAT, output_shape);

auto input_flat = noise.flat<float>();

auto output_flat = output.flat<float>();

for (int i = 0; i < output_flat.size(); ++i) {

float sum = 0.0f;

for (int j = 0; j < input_size; ++j) {

sum += input_flat(j) * weights_flat(i * input_size + j);

}

output_flat(i) = sum + biases_flat(i);

}

return output;

}

// 定义判别器

tensorflow::Tensor Discriminator(const tensorflow::Tensor& input) {

// 同样使用简单的全连接层

tensorflow::TensorShape input_shape = input.shape();

int input_size = input_shape.dim_size(0);

tensorflow::TensorShape output_shape({input_size, 1});

tensorflow::Tensor weights(tensorflow::DT_FLOAT, tensorflow::TensorShape({input_size, 1}));

tensorflow::Tensor biases(tensorflow::DT_FLOAT, tensorflow::TensorShape({1}));

// 初始化权重和偏置

auto weights_flat = weights.flat<float>();

auto biases_flat = biases.flat<float>();

for (int i = 0; i < weights_flat.size(); ++i) {

weights_flat(i) = static_cast<float>(rand()) / RAND_MAX;

}

for (int i = 0; i < biases_flat.size(); ++i) {

biases_flat(i) = static_cast<float>(rand()) / RAND_MAX;

}

tensorflow::Tensor output(tensorflow::DT_FLOAT, output_shape);

auto input_flat = input.flat<float>();

auto output_flat = output.flat<float>();

for (int i = 0; i < output_flat.size(); ++i) {

float sum = 0.0f;

for (int j = 0; i < input_size; ++j) {

sum += input_flat(j) * weights_flat(i * input_size + j);

}

output_flat(i) = sum + biases_flat(i);

}

return output;

}

int main() {

tensorflow::Session* session;

tensorflow::Status status = tensorflow::NewSession(tensorflow::SessionOptions(), &session);

if (!status.ok()) {

std::cerr << status.ToString() << std::endl;

return 1;

}

// 初始化噪声张量

tensorflow::Tensor noise(tensorflow::DT_FLOAT, tensorflow::TensorShape({100}));

auto noise_flat = noise.flat<float>();

for (int i = 0; i < noise_flat.size(); ++i) {

noise_flat(i) = static_cast<float>(rand()) / RAND_MAX;

}

// 生成数据

tensorflow::Tensor generated_data = Generator(noise);

// 判别数据

tensorflow::Tensor discriminator_output = Discriminator(generated_data);

std::cout << "Discriminator output: " << discriminator_output.flat<float>()(0) << std::endl;

session->Close();

return 0;

}下面对它进行一下解释:

①这段代码使用了 TensorFlow C++ API 来实现一个简单的 GANs 架构。

②Generator函数接收一个噪声张量作为输入,通过全连接层将其转换为生成的数据。

③Discriminator函数接收输入数据(可以是真实数据或生成数据),并通过另一个全连接层输出一个判别结果。④在

main函数中,我们创建了一个会话,生成噪声,调用生成器生成数据,然后调用判别器进行判别。

3.2变分自编码器(VAEs):

变分自编码器(VAEs)是另一种强大的生成模型,它将输入数据编码为潜在空间中的低维表示,然后从潜在空间解码为生成的数据。它假设数据是由潜在变量生成的,并通过优化重构误差和潜在变量的分布与先验分布之间的差异来学习生成模型。

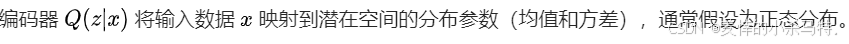

基本原理:

①

②

②

③

③

④

下面展示一个简单的 VAE 的 C++ 代码示例(使用伪代码形式,因为完整实现较为复杂):

#include <iostream>

#include <vector>

#include <cmath>

class VAE {

private:

std::vector<double> encoder(const std::vector<double>& x) {

// 这里是编码器的实现,使用简单的线性变换作为示例

std::vector<double> mean(2);

std::vector<double> log_var(2);

for (int i = 0; i < 2; ++i) {

mean[i] = 0.0;

log_var[i] = 0.0;

for (int j = 0; j < x.size(); ++j) {

mean[i] += x[j] * 0.1;

log_var[i] += x[j] * 0.2;

}

}

return {mean[0], log_var[0], mean[1], log_var[1]};

}

std::vector<double> decoder(const std::vector<double>& z) {

// 这里是解码器的实现,使用简单的线性变换作为示例

std::vector<double> reconstructed(x.size());

for (int i = 0; i < x.size(); ++i) {

reconstructed[i] = z[0] * 0.3 + z[1] * 0.4;

}

return reconstructed;

}

double sample(const std::vector<double>& mean, const std::vector<double>& log_var) {

std::vector<double> std_dev(2);

for (int i = 0; i < 2; ++i) {

std_dev[i] = std::exp(0.5 * log_var[i]);

}

std::vector<double> epsilon(2);

for (int i = 0; i < 2; ++i) {

epsilon[i] = (static_cast<double>(rand()) / RAND_MAX - 0.5) * 2.0;

}

std::vector<double> z(2);

for (int i = 0; i < 2; ++i) {

z[i] = mean[i] + std_dev[i] * epsilon[i];

}

return z;

}

double kl_divergence(const std::vector<double>& mean, const std::vector<double>& log_var) {

double kl = 0.0;

for (int i = 0; i < 2; ++i) {

kl += -0.5 * (1 + log_var[i] - mean[i] * mean[i] - std::exp(log_var[i]));

}

return kl;

}

double reconstruction_loss(const std::vector<double>& x, const std::vector<double>& reconstructed) {

double loss = 0.0;

for (int i = 0; i < x.size(); ++i) {

loss += (x[i] - reconstructed[i]) * (x[i] - reconstructed[i]);

}

return loss;

}

public:

double train(const std::vector<double>& x) {

std::vector<double> params = encoder(x);

std::vector<double> z = sample({params[0], params[1]}, {params[2], params[3]});

std::vector<double> reconstructed = decoder(z);

double kl = kl_divergence({params[0], params[1]}, {params[2], params[3]});

double rec_loss = reconstruction_loss(x, reconstructed);

return rec_loss + kl;

}

};

int main() {

VAE vae;

std::vector<double> input = {1.0, 2.0, 3.0};

double loss = vae.train(input);

std::cout << "Loss: " << loss << std::endl;

return 0;

}下面对它进行一下解释:

①encoder函数将输入数据映射到潜在空间的均值和对数方差。

②cecoder函数将潜在变量解码为重构的数据。

③sample函数从潜在空间的分布中采样。

④kl_divergence计算 KL 散度,确保潜在空间符合先验分布。

⑤reconstruction_loss计算重构损失。

⑥train函数完成整个训练过程,计算总损失。

3.3Transformer 架构:

Transformer 架构在自然语言处理领域的 AIGC 应用中取得了巨大的成功,如 OpenAI 的 GPT 系列和 Google 的 BERT。它基于自注意力机制(Self-Attention),能够处理长序列数据,而无需像传统的循环神经网络(RNN)那样依赖序列的顺序处理,从而具有更好的并行性和训练效率。

基本原理:

①

②

③

下面展示一个简单的自注意力机制的 C++ 代码示例:

#include <iostream>

#include <vector>

#include <cmath>

std::vector<std::vector<double>> dot_product(const std::vector<std::vector<double>>& Q, const std::vector<std::vector<double>>& K) {

int n = Q.size();

int m = K.size();

int d = Q[0].size();

std::vector<std::vector<double>> scores(n, std::vector<double>(m));

for (int i = 0; i < n; ++i) {

for (int j = 0; j < m; ++j) {

double score = 0.0;

for (int k = 0; k < d; ++k) {

score += Q[i][k] * K[j][k];

}

scores[i][j] = score;

}

}

return scores;

}

std::vector<std::vector<double>> softmax(const std::vector<std::vector<double>>& scores) {

int n = scores.size();

int m = scores[0].size();

std::vector<std::vector<double>> probs(n, std::vector<double>(m));

for (int i = 0; i < n; ++i) {

double max_score = scores[i][0];

for (int j = 1; j < m; ++j) {

if (scores[i][j] > max_score) max_score = scores[i][j];

}

double sum_exp = 0.0;

for (int j = 0; j < m; ++j) {

probs[i][j] = exp(scores[i][j] - max_score);

sum_exp += probs[i][j];

}

for (int j = 0; j < m; ++j) {

probs[i][j] /= sum_exp;

}

}

return probs;

}

std::vector<std::vector<double>> attention(const std::vector<std::vector<double>>& Q, const std::vector<std::vector<double>>& K, const std::vector<std::vector<double>>& V) {

std::vector<std::vector<double>> scores = dot_product(Q, K);

std::vector<std::vector<double>> attn_probs = softmax(scores);

int n = attn_probs.size();

int d = V[0].size();

std::vector<std::vector<double>> output(n, std::vector<double>(d));

for (int i = 0; i < n; ++i) {

for (int j = 0; j < d; ++j) {

for (int k = 0; k < V.size(); ++k) {

output[i][j] += attn_probs[i][k] * V[k][j];

}

}

}

return output;

}

int main() {

std::vector<std::vector<double>> Q = {{1.0, 2.0}, {3.0, 4.0}};

std::vector<std::vector<double>> K = {{5.0, 6.0}, {7.0, 8.0}};

std::vector<std::vector<double>> V = {{9.0, 10.0}, {11.0, 12.0}};

std::vector<std::vector<double>> attn_output = attention(Q, K, V);

for (const auto& row : attn_output) {

for (double val : row) {

std::cout << val << " ";

}

std::cout << std::endl;

}

return 0;

}代码解释:

①dot_product函数计算 Query 矩阵 Q和 Key 矩阵 K 的点积,得到得分矩阵。

②softmax函数将得分矩阵归一化,得到注意力概率矩阵。

③attention函数将注意力概率矩阵与 Value 矩阵 V相乘,得到最终的输出。

四、算法训练与优化:

AIGC 算法的训练是一个复杂且计算密集的过程,涉及到以下几个关键方面:

4.1损失函数的选择:

根据不同的任务和算法选择合适的损失函数至关重要。对于图像生成,常用的损失函数有均方误差(MSE)、感知损失(Perceptual Loss)等;对于文本生成,交叉熵损失(Cross-Entropy Loss)是常见的选择。

4.2优化算法:

常用的优化算法包括随机梯度下降(SGD)及其变种,如 Adagrad、Adadelta、Adam 等。这些算法通过调整模型的参数,使损失函数最小化。以下是一个使用 Adam 优化器的 C++ 伪代码示例:

代码展示:

class AdamOptimizer {

private:

double lr;

double beta1;

double beta2;

double epsilon;

std::vector<double> m;

std::vector<double> v;

int t;

public:

AdamOptimizer(double learning_rate = 0.001, double b1 = 0.9, double b2 = 0.999, double eps = 1e-8) : lr(learning_rate), beta1(b1), beta2(b2), epsilon(eps), t(0) {}

void update(std::vector<double>& params, const std::vector<double>& grads) {

if (m.empty()) {

m.resize(grads.size(), 0.0);

v.resize(grads.size(), 0.0);

}

t++;

for (size_t i = 0; i < grads.size(); ++i) {

m[i] = beta1 * m[i] + (1 - beta1) * grads[i];

v[i] = beta2 * v[i] + (1 - beta2) * grads[i] * grads[i];

double m_hat = m[i] / (1 - std::pow(beta1, t));

double v_hat = v[i] / (1 - std::pow(beta2, t));

params[i] -= lr * m_hat / (std::sqrt(v_hat) + epsilon);

}

}

};

int main() {

std::vector<double> params = {1.0, 2.0, 3.0};

std::vector<double> grads = {-0.1, 0.2, -0.3};

AdamOptimizer adam;

adam.update(params, grads);

for (double param : params) {

std::cout << param << " ";

}

std::cout << std::endl;

return 0;

}代码解释:

①AdamOptimizer类实现了 Adam 优化算法,根据梯度更新参数。

②update方法根据当前梯度和历史梯度信息更新参数,其中 m 是梯度的一阶矩估计, v是梯度的二阶矩估计,t 是更新的次数。

五、AIGC 的应用领域与挑战:

5.1内容创作:

-

内容创作领域:

- 文本创作:

- AIGC 在文本创作方面展现出了强大的能力,能够生成各种类型的文本,包括新闻报道、博客文章、产品描述、广告文案等。例如,一些新闻机构开始使用 AIGC 技术来撰写一些常规性的体育赛事报道或财经新闻,根据比赛结果或市场数据自动生成相应的报道内容,大大提高了新闻产出的效率。对于网络小说创作,AIGC 可以帮助作者生成故事大纲、角色设定,甚至可以根据作者设定的情节和风格续写章节,辅助作家完成长篇小说的创作。

- 在学术研究领域,AIGC 可以辅助学者撰写论文的部分内容,如对大量数据进行初步的分析和总结,为研究人员提供新的思路和观点,节省文献综述的时间和精力。例如,在医学研究中,通过对大量医学文献的学习,AIGC 可以为研究者总结不同疾病的症状、治疗方法及研究进展,还可以协助撰写研究背景部分的内容。

- 图像创作:

- AIGC 能够生成逼真的图像,从简单的图标、插画到复杂的数字绘画、3D 建模和场景渲染。设计师可以利用 AIGC 工具生成各种风格的图像,如动漫风格、写实风格、油画风格等,满足不同客户的需求。例如,在游戏开发中,AIGC 可以根据游戏设计师的描述快速生成游戏角色、道具和场景,大大缩短开发周期。像 DALL・E 2、Midjourney 等工具,用户只需输入一段描述性的文字,就能生成高质量的图像,为艺术家和设计师提供了丰富的灵感来源和素材库。

- 在广告设计领域,AIGC 可以根据产品特点和目标受众的特征生成吸引人的广告海报和宣传图片,甚至可以根据不同的营销活动生成系列广告图像,提高广告投放的效果。

- 音频创作:

- 可以生成各种类型的音频内容,如音乐、音效、语音旁白等。对于音乐创作,AIGC 可以根据用户设定的音乐风格(如古典、摇滚、爵士等)、情绪(如欢快、悲伤、激昂等)和节奏,创作出原创的音乐曲目。一些视频制作团队使用 AIGC 生成背景音乐,为视频内容增添氛围感。

- 在有声书制作中,AIGC 可以将文字内容转换为自然流畅的语音,为用户提供个性化的听书体验。像 Google 的 WaveNet 等技术,可以生成高度逼真的语音,在不同语言和语音风格方面表现出色,甚至可以模拟不同的口音和情感表达。

- 视频创作:

- 生成短视频、动画和电影预告片等。一些短视频平台利用 AIGC 技术根据热门话题和用户喜好自动生成短视频内容,增加平台的内容多样性。在动画制作中,AIGC 可以辅助生成角色的动作、表情和场景的动态效果,降低动画制作成本。

- 对于电影行业,AIGC 可以为电影制作虚拟角色和特效,使电影的视觉效果更加震撼。例如,在科幻电影中,通过 AIGC 可以生成外星生物、未来城市等虚拟场景,为观众带来更加身临其境的体验。

- 文本创作:

-

教育领域:

- 教学内容生成:

- 教师可以使用 AIGC 生成教学课件、练习题、考试题目等。根据不同的学科和教学大纲,AIGC 可以创建丰富多样的学习资源,如数学公式推导、物理实验模拟、历史事件的故事化讲解等,帮助教师更有效地准备课程。对于在线教育平台,AIGC 可以根据学生的学习进度和掌握程度,生成个性化的学习路径和测试题,实现因材施教。

- AIGC 还可以为语言学习提供帮助,如生成语言对话练习的场景和内容,让学生在不同语境下练习口语和听力。例如,对于学习英语的学生,AIGC 可以模拟各种日常、商务、旅游等场景的对话,让学生与虚拟角色进行对话练习。

- 智能辅导:

- 作为智能辅导系统,为学生提供学习帮助和解答问题。它可以对学生的作业和论文进行批改和反馈,指出错误和改进的方向。同时,根据学生的问题,以自然语言的方式为学生讲解复杂的概念和解题思路,帮助学生更好地理解和掌握知识。

- 教学内容生成:

-

商业领域:

- 产品设计和研发:

- 在工业设计方面,AIGC 可以根据产品的功能和市场定位,提出多种设计方案,帮助设计师进行头脑风暴和概念设计。例如,汽车制造商可以使用 AIGC 设计汽车的外观和内饰,根据不同的性能指标和用户需求生成多种车型的设计草图。

- 在软件开发中,AIGC 可以辅助编写代码,根据开发人员的需求生成代码框架和部分函数代码,提高开发效率。像 GitHub Copilot 利用 AIGC 技术,为程序员提供代码补全和代码生成功能,减少开发人员的编码工作量,同时也可以帮助初学者学习编程。

- 市场营销和客户服务:

- 可以生成个性化的营销方案和用户推荐。根据用户的购买历史和浏览行为,为用户推荐合适的产品和服务,并生成针对性的营销文案,提高用户转化率。在客户服务方面,AIGC 可以通过聊天机器人为用户提供即时的帮助和解答,处理用户的常见问题,节省人力成本,提高服务效率和用户满意度。

- 产品设计和研发:

-

娱乐和游戏领域:

- 游戏开发:

- 除了前面提到的图像和场景生成,AIGC 还可以为游戏设计剧情和任务系统。根据游戏的世界观和玩家的进度,为玩家提供动态的任务和剧情,使游戏体验更加丰富和持久。例如,角色扮演游戏可以利用 AIGC 不断生成新的任务和故事情节,避免玩家出现游戏内容的重复感。

- 对于游戏中的 NPC(非玩家角色),AIGC 可以让其具有更加智能的对话和行为,使 NPC 能够根据玩家的不同选择和行动做出更真实的反应,增强游戏的沉浸感和互动性。

- 影视和动漫:

- 可以为影视和动漫的剧本创作、角色塑造和情节发展提供创意。AIGC 可以根据用户的创意构思生成完整的剧本,包括场景描述、角色对话和故事发展,为影视制作团队提供新的创作思路。同时,在后期制作中,AIGC 可以辅助进行色彩校正、画面修复和特效合成等工作,提升作品的视觉质量。

- 游戏开发:

5.2面临的挑战:

-

数据问题:

- 数据质量和偏差:

- AIGC 严重依赖大量的数据进行训练,数据的质量直接影响生成内容的质量。如果训练数据存在错误、噪声或偏差,那么生成的内容也会受到影响。例如,如果用于训练的图像数据集中大部分是某种特定风格或特定角度的图像,那么生成的图像可能会偏向于这种风格或角度,缺乏多样性。在文本生成中,如果训练数据主要来自于某种特定的文体或主题,那么生成的文本也会受到局限。

- 数据的标注问题也会影响 AIGC 的性能。对于一些需要监督学习的任务,不准确或不完整的标注会使模型学习到错误的信息。例如,在训练图像分类的 AIGC 模型时,错误的图像标签会导致模型对图像的分类出现偏差。

- 数据隐私和版权:

- AIGC 训练过程中使用的数据可能涉及用户的隐私信息,如果处理不当,可能会导致隐私泄露。例如,一些文本生成模型可能会记住并重现训练数据中的个人信息或敏感信息。

- 关于版权问题,当 AIGC 生成的内容与现有作品相似时,难以界定其是否侵犯了版权。比如,AIGC 生成的图像或文本可能会不自觉地复制现有作品的某些元素,引发版权纠纷。

- 数据质量和偏差:

-

模型性能和可解释性:

- 性能瓶颈:

- 训练大规模的 AIGC 模型需要大量的计算资源和时间,对于一些小型企业或个人开发者来说,可能难以承受。例如,训练一个复杂的 GAN 或 Transformer 架构的模型可能需要高性能的 GPU 集群和数周甚至数月的时间,限制了 AIGC 的广泛应用。

- 模型的推理速度也可能成为问题,尤其是在实时应用场景中,如实时视频生成或实时对话系统中,如果生成速度过慢,会影响用户体验。

- 可解释性差:

- 深度学习模型的可解释性本身就是一个挑战,对于 AIGC 模型更是如此。由于其复杂的神经网络结构,很难解释为什么模型会生成某种特定的内容。这对于需要高可靠性和可信赖性的应用场景,如医疗诊断、法律等领域是一个严重的问题,因为用户难以理解模型是如何做出决策和生成内容的。

- 性能瓶颈:

-

伦理和社会影响:

- 内容真实性和可靠性:

- AIGC 生成的内容可能会误导用户,尤其是在新闻和信息传播领域。假新闻和虚假信息可能会通过 AIGC 大量传播,因为它可以生成看似真实的内容。例如,一些不法分子可能会利用 AIGC 生成虚假的新闻报道或社交媒体帖子,混淆公众视听。

- 在科学研究中,如果 AIGC 生成的数据或结论被误用,会影响科学研究的可信度和可靠性。

- 社会公平和就业结构调整:

- AIGC 的广泛应用可能会导致一些职业受到冲击,如内容创作者、翻译人员、文案撰写者等,可能会面临工作被取代的风险,引发社会就业结构的调整。然而,同时也会催生出新的职业,如 AIGC 训练师、模型评估师等,但需要一定的时间和社会资源来实现职业的转型和再培训。

- 从社会公平的角度来看,如果 AIGC 技术主要被大公司或发达地区掌握,可能会加剧数字鸿沟,使不同地区和人群在获取和使用 AIGC 技术带来的好处方面存在差异。

- 内容真实性和可靠性:

-

技术局限:

- 内容的创新性和深度:

- 尽管 AIGC 可以生成看似新颖的内容,但往往缺乏真正的创新性和深度。在一些高创造性的领域,如高级艺术创作和复杂的学术研究,AIGC 生成的内容可能只是对已有知识和风格的简单组合,难以突破人类的创造力极限。例如,AIGC 生成的诗歌可能在形式上符合诗歌的格律,但缺乏真正的情感和思想内涵。

- 对于长文本和复杂故事的创作,AIGC 可能会出现逻辑不连贯、情节矛盾等问题,难以创作出具有深刻主题和复杂人物关系的作品。

- 对复杂任务的处理能力:

- 在一些需要多领域知识和复杂推理的任务中,AIGC 表现不佳。例如,在处理需要跨学科知识和复杂逻辑推理的决策问题时,AIGC 难以综合各种信息做出合理的决策,其智能程度仍然无法与人类相比。

- 内容的创新性和深度:

尽管 AIGC 技术面临着诸多挑战,但随着技术的不断进步和社会的共同努力,这些问题有望逐步得到解决或缓解。在未来,AIGC 将继续在各个领域发挥重要作用,为人类社会带来更多的便利和创新,同时也需要我们不断思考如何引导其健康、可持续的发展,以避免其可能带来的负面影响。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)