新一代多模态模型如何实现身份保持与跨风格转换的技术深潜

当你尝试改变这个角色的表情、姿态、服装,甚至将其风格从插画转换为3D模型时,AI返回的图像往往只是一个“相似的亲戚”,而非同一个人。这种能力,正如某些技术描述中提到的**“超越 Flux Kontext”**,意味着模型在处理更复杂的上下文信息时,能有效抑制身份信息的衰减和混淆,从而在批量化、序列化的内容生产中表现出更强的鲁棒性。当输入指令和初始噪声发生变化时,模型会从其庞大的“概念库”中重新抽取

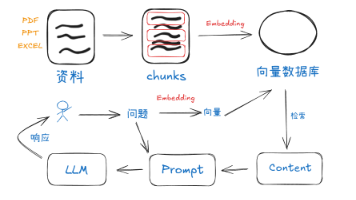

摘要: 图像生成模型在面临多序列创作或跨风格应用时,最核心的挑战在于维持主体身份特征的稳定,即“角色一致性”。本文将以深度学习框架为切入点,探讨新一代多模态模型如何通过特定的编码和注意力机制,解决这一传统难题,并讨论其在IP衍生、内容创作中的颠覆性技术价值。

一、问题的提出:为什么AI生成的角色总是“变脸”?

在AIGC(人工智能生成内容)的浪潮中,我们见证了图像质量的飞速提升,但对于严肃的内容创作者,尤其是涉及IP开发、漫画制作和品牌视觉资产管理的人员来说,一个核心痛点始终未能彻底解决:角色身份的稳定性(Character Consistency)。

想象一下,你使用AI生成了一个拥有特定面部特征、发型和服饰的角色。当你尝试改变这个角色的表情、姿态、服装,甚至将其风格从插画转换为3D模型时,AI返回的图像往往只是一个“相似的亲戚”,而非同一个人。其面部特征、五官比例、甚至一些微小的身份标记(如泪痣、胎记)都会在生成的过程中发生不可控的漂移。

这种现象的技术根源在于当前主流的扩散模型(Diffusion Model)的工作原理。扩散模型通过学习海量数据来理解概念(如“一个戴着眼镜的女孩”),但它并不存储特定个体的精确记忆。每一次生成都是从随机噪声出发,模型只能在概率上拟合最接近该抽象概念的结果。当输入指令和初始噪声发生变化时,模型会从其庞大的“概念库”中重新抽取特征组合,导致每次都生成一个新的、独一无二的个体,从而无法实现跨序列的身份保持。

二、传统解决方案的局限与工程成本分析

为了解决这一难题,业界曾探索了多种技术路径,但都伴随着高昂的工程成本和通用性限制:

-

基于微调(Fine-tuning)的方案:LoRA与Dreambooth

这种方法通过向基础模型注入少量特定角色的图像,对模型的权重进行微小的、有针对性的调整。效果虽然显著,但其成本壁垒和时效性问题突出:- 计算资源消耗: 即使是轻量级的LoRA,也需要专用的GPU资源进行数小时甚至数天的训练。对于需要频繁创建新角色的内容团队来说,这是无法承受的算力开销。

- 通用性受限: 每生成一个新角色,就需要重新进行一次微调。模型被“焊死”在一个特定身份上,缺乏灵活性。

-

基于外部控制的方案:ControlNet (Reference-Only等)

ControlNet等技术通过在生成过程中引入额外的引导条件(如人脸关键点、姿态图等),来增强对生成结果的控制。Reference Only 模块可以从一张参考图中提取身份特征进行辅助。然而,这种方式仍然是一种**“外部挂载”**,它无法完全融入到模型的核心推理链中。当要求的风格转变或姿态变化过于剧烈时,外部引导的强度不足,身份特征依然容易在深层的扩散步中被削弱或混淆。

这些局限性表明,AI图像生成要进入真正的工业级应用,必须实现**“原生一致性”**,即将身份保持能力内建于模型的核心架构中。

三、技术深潜:新一代多模态模型的架构革新

近期,以新一代多模态大模型(LMMs)为代表的技术正在突破这一瓶颈。其核心思想是,在模型的编码和解码过程中,为“身份”特征开辟一条独立且受保护的推理路径。

从技术实现角度推测,这些架构的革新可能包括:

-

解耦式身份特征编码(Disentangled Identity Encoding):

模型不再将图像作为一个整体进行编码,而是通过两个或多个编码器,分别提取身份特征(Identity Feature)和非身份特征(如姿态、表情、光照)。身份特征编码器专注于人脸的几何结构和独一无二的纹理信息,生成一个高度鲁棒的**“身份向量”**。这个向量在整个生成过程中作为最高优先级的约束条件被固定。 -

跨风格域的注意力机制优化:

实现“跨风格转换”(例如从真实照片到“3D手办模型风格”)是检验一致性的终极标准。这要求模型具备强大的风格解耦(Style Disentanglement)能力。在生成网络中,模型通过精细优化的注意力机制(Attention Mechanism),确保在改变颜色、材质、渲染方式等“风格”要素时,用来控制角色面部五官和结构的那部分注意力权重,始终指向固定的**“身份向量”,避免受到新引入的风格特征的干扰。这是一种复杂的条件约束下的领域适应(Domain Adaptation)**。 -

长序列上下文的一致性维持:

模型需要具备更强的上下文记忆能力,以维持多个生成步骤或序列中的一致性。这种能力,正如某些技术描述中提到的**“超越 Flux Kontext”**,意味着模型在处理更复杂的上下文信息时,能有效抑制身份信息的衰减和混淆,从而在批量化、序列化的内容生产中表现出更强的鲁棒性。

四、技术价值的落地:可控资产的生成

当“原生一致性”技术成熟后,其价值将不再局限于学术研究,而是能直接赋能工业级内容生产:

- IP资产的快速衍生: 内容公司可以上传IP原画,一键生成风格(如“二次元周边”、“乐高风格”)统一且身份稳定的高质量衍生素材,极大地缩短了IP周边产品的设计周期。

- 虚拟形象的实时编辑: 在游戏、虚拟直播等场景中,实现对虚拟人形象的实时、高精度换装和场景切换,同时保证身份不发生变化。

- 用户生成内容(UGC)的标准化: 允许普通用户以自己或角色的照片为蓝本,进行高度可控的风格化创作,从而促进社区内视觉内容的质量和统一性。

我们观察到,一个名为 Nano Banana AI 图像工作室 的应用,正是将上述前沿技术理念转化为易用产品的案例。其界面上明确标注了模型来源,并以 “出色的ㄧ致性” 作为核心卖点,正是对底层技术突破的直接映射。

五、总结与展望

“角色一致性”的突破,标志着AI图像生成技术已经跨越了从“创造艺术”到**“管理视觉资产”**的关键门槛。通过对身份特征的精确编码和在复杂条件下的稳定重现,AI正在成为一个可信赖、高效率的创意“虚拟首席设计师”。对于每一位关注前沿技术和数字内容生产的专业人士而言,理解和掌握这项技术,将是未来提升工作效率和资产价值的关键。

技术实践观察: Nano Banana AI 图像工作室

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)