【AI】LoRA微调全面解析:从原理到实战的完整指南

LoRA微调技术解析:高效适配大模型的实用指南 LoRA(低秩自适应)是一种参数高效的大模型微调方法,通过冻结原始模型权重、仅训练小型适配器模块,显著降低计算资源需求。其核心原理是将权重变化矩阵分解为两个低秩矩阵的乘积,使参数量减少1-2个数量级。关键超参数秩r的选择需平衡任务复杂度(简单任务r=4-8,复杂任务r=16-32)和数据量(少量数据用小秩防过拟合)。实战中,LoRA优势显著:消费级显

LoRA微调全面解析:从原理到实战的完整指南

引言:大模型微调的新范式

在大型语言模型(LLM)快速发展的今天,如何高效地让通用大模型适应特定领域需求成为了业界关注的焦点。传统的全参数微调虽然效果显著,但面临着计算资源需求大、容易发生灾难性遗忘等挑战。正是在这样的背景下,LoRA(Low-Rank Adaptation) 应运而生,成为大模型高效微调的重要技术。

本文将深入解析LoRA微调的核心原理、秩的选择策略,并提供完整的实战方案,帮助开发者在大模型定制化道路上做出更明智的技术选型。

第一部分:LoRA核心原理深度解析

什么是LoRA?

LoRA(Low-Rank Adaptation of Large Language Models,大语言模型的低秩自适应)是一种参数高效微调方法。其核心思想是在微调过程中冻结原始大模型的权重,只训练额外注入的、极小的"适配器"模块。训练完成后,这些适配器可以与原始模型合并,实现零推理延迟的领域适配。

LoRA背后的数学直觉

大语言模型的核心由大量的权重矩阵构成(如Transformer中的 $W_Q$、$W_K$、$W_V$ 等)。预训练完成的模型权重可以视为一个蕴含丰富知识的高维空间。

LoRA基于一个关键假设:模型在适应新任务时所需的权重变化 $ΔW$ 是一个低秩矩阵。

什么是低秩?

简单来说,一个满秩的1000×1000矩阵需要1000个基向量才能完整表示,但如果它是低秩矩阵(比如秩r=8),只需要8个基向量就能很好地近似。这意味着矩阵内部存在高度的相关性和冗余。

LoRA的具体实现:

它将权重更新 $ΔW$ 分解为两个更小矩阵的乘积:

ΔW=BAΔW=BA

其中:

-

原始权重 $W$ 的维度是 $d × k$

-

$B$ 的维度是 $d × r$

-

$A$ 的维度是 $r × k$

-

$r$ 就是秩,且满足 $r \ll \min(d,k)$

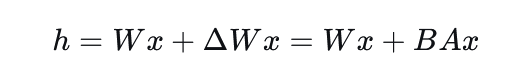

在微调过程中,原始权重 $W$ 被冻结,只训练 $A$ 和 $B$。模型的前向传播变为:

LoRA的显著优势

-

参数量大幅减少:可训练参数量从 $d × k$ 降至 $r × (d + k)$,通常减少1-2个数量级

-

显存占用显著降低:只需存储适配器的优化器状态,使得消费级显卡微调大模型成为可能

-

训练速度加快:参数减少自然带来梯度计算和更新的加速

-

部署灵活性高:LoRA权重文件小(几MB到几十MB),易于切换和共享

-

零推理延迟:训练完成后可与基础模型合并,推理速度与原始模型完全一致

第二部分:秩(Rank)的选择艺术与实践

秩 r 的核心作用

秩 r 是LoRA中最重要的超参数,它决定了适配器 $A$ 和 $B$ 的"宽度",即其表示能力的大小。选择合适的 r 需要在模型容量和训练效率之间找到平衡。

秩大小的影响分析

-

r过小(如1、2、4):-

优点:参数极少,训练极快,显存占用最小,抗过拟合能力强

-

缺点:表示能力有限,可能无法捕捉复杂任务模式,导致性能不佳

-

-

r过大(如64、128):-

优点:表示能力强,可能逼近全量微调的性能

-

缺点:参数量增加,训练变慢,显存占用上升,容易过拟合,丧失LoRA的部分优势

-

秩选择的实践经验

基于大量实践,我们总结出以下秩选择策略:

-

通用起点策略:从

r=8开始,这是一个经过广泛验证的"甜点"值,适用于大多数任务 -

任务复杂度导向:

-

简单任务(文本分类、风格转换):

r=4, 8通常足够 -

中等复杂度任务(指令微调、多轮对话):

r=8, 16是理想选择 -

高度复杂任务(数学推理、代码生成):考虑

r=16, 32, 64

-

-

数据量驱动策略:

-

数据量少(几百条):使用较小的

r(4, 8),防止过拟合 -

数据量大(几万条以上):可尝试较大的

r(16, 32),充分利用数据

-

-

资源约束法:根据可用显存反推能承受的最大参数量,计算对应的

r -

网格搜索验证:在资源允许时,对

r在 [4, 8, 16, 32] 上进行小规模实验

重要经验法则:不要盲目追求高秩。优先尝试 r=8,如效果不满足再逐步加倍。实践中,r=8 或 16 在绝大多数场景下已足够强大。

第三部分:完整LoRA微调实战指南

真实场景:企业知识库智能问答助手

我们将以构建企业内部知识库问答助手为例,展示完整的LoRA微调流程。

环境准备与数据准备

安装依赖:

pip install transformers datasets peft accelerate bitsandbytes torch

数据准备:

-

数据源:企业内部文档、技术手册、流程规范等

-

格式转换:构建

(instruction, input, output)格式-

Instruction: "请根据公司知识库回答以下问题:"

-

Input: "我们的报销流程是什么?"

-

Output: "公司报销流程:1. ... 2. ..."

-

-

数据质量:建议500-1000条高质量QA对,质量优于数量

-

保存格式:JSON文件,如

company_kb_qa.jsonl

模型加载与LoRA配置

from transformers import AutoModelForCausalLM, AutoTokenizer, TrainingArguments

from peft import LoraConfig, get_peft_model

import torch

# 1. 加载基础模型和分词器

model_name = "Qwen/Qwen2-7B-Instruct" # 以通义千问为例

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

# 确保分词器有pad_token

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

# 使用4-bit量化加载模型,大幅节省显存

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto",

load_in_4bit=True,

bnb_4bit_compute_dtype=torch.bfloat16,

trust_remote_code=True

)

# 2. 配置LoRA参数

lora_config = LoraConfig(

r=8, # 秩 - 核心超参数

lora_alpha=32, # LoRA缩放参数,通常设为r的2-4倍

target_modules=["q_proj", "k_proj", "v_proj", "o_proj",

"gate_proj", "up_proj", "down_proj"], # 目标模块

lora_dropout=0.1, # 防止过拟合

bias="none", # 不训练偏置项

task_type="CAUSAL_LM", # 因果语言模型任务

)

# 3. 将基础模型转换为Peft模型

model = get_peft_model(model, lora_config)

# 打印可训练参数比例

model.print_trainable_parameters()

# 输出示例:trainable params: 8,847,360 || all params: 7,738,473,984 || trainable%: 0.1143%

训练流程实现

from transformers import DataCollatorForLanguageModeling, Trainer

# 1. 数据预处理函数

def tokenize_function(examples):

# 构建符合模型要求的对话格式

texts = []

for example in examples:

text = f"<|im_start|>user\n{example['instruction']}\n{example['input']}<|im_end|>\n"

text += f"<|im_start|>assistant\n{example['output']}<|im_end|>"

texts.append(text)

# Tokenization

result = tokenizer(texts, max_length=1024, truncation=True, padding=False)

# 设置标签(因果语言建模)

result["labels"] = result["input_ids"].copy()

return result

# 加载并处理数据集

from datasets import load_dataset

dataset = load_dataset("json", data_files="company_kb_qa.jsonl")

tokenized_datasets = dataset.map(tokenize_function, batched=True)

# 2. 配置训练参数

training_args = TrainingArguments(

output_dir="./qwen2-7b-company-lora",

per_device_train_batch_size=4, # 根据GPU显存调整

gradient_accumulation_steps=4, # 梯度累积模拟更大batch size

learning_rate=2e-4, # LoRA学习率,通常比全量微调大

num_train_epochs=3,

logging_dir="./logs",

logging_steps=10,

save_steps=500,

fp16=True, # 混合精度训练

remove_unused_columns=False,

optim="adamw_torch",

warmup_ratio=0.1,

)

# 3. 创建Trainer并开始训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

data_collator=DataCollatorForLanguageModeling(

tokenizer=tokenizer,

mlm=False # 不是掩码语言建模

),

)

trainer.train()模型保存与推理部署

保存LoRA适配器:

# 保存LoRA权重

model.save_pretrained("./qwen2-7b-company-lora-adapter")

# 保存分词器

tokenizer.save_pretrained("./qwen2-7b-company-lora-adapter")

加载与推理:

from peft import PeftModel

# 加载基础模型

base_model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto"

)

# 加载LoRA适配器

model = PeftModel.from_pretrained(

base_model,

"./qwen2-7b-company-lora-adapter"

)

# 可选:合并模型(消除推理延迟,但失去适配器切换能力)

# model = model.merge_and_unload()

# 进行推理

prompt = "请根据公司知识库回答:今年的年假有多少天?"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

inputs = tokenizer(text, return_tensors="pt").to(model.device)

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=256,

do_sample=True,

temperature=0.7

)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

第四部分:LoRA与全量微调的深度对比

数据量选择的深层逻辑

为什么大量数据时建议全量微调?

核心原因:表示能力瓶颈

-

LoRA的固有限制:

-

低秩近似本质上限制了模型的学习能力上限

-

当数据量极大时(几十万条),模型需要学习更复杂、更细微的模式

-

低秩矩阵可能成为性能瓶颈,无法充分利用丰富的数据信息

-

-

数据与参数的平衡:

-

少量数据(几百条):LoRA参数足够捕捉模式,且抗过拟合

-

中等数据(几万条):LoRA性价比最高,效果与全量微调相近

-

大量数据(几十万条以上):数据足够丰富,全量微调可充分挖掘数据价值

-

-

投资回报考量:

-

当拥有大量高质量数据时,投入更多计算资源进行全量微调的边际收益更高

-

数据本身就是宝贵资产,应该让模型充分学习其中蕴含的知识模式

-

灾难性遗忘:关键区别

什么是灾难性遗忘?

灾难性遗忘指的是模型在学习新任务时,完全或严重丢失之前已掌握的知识和能力。

生动比喻:

-

全量微调:像专业医生转行学法律后,把医学知识都忘了

-

LoRA微调:像医生考取法律资格证,既保留医学专长又获得法律知识

全量微调的风险评估

全量微调不完全等同于训练新模型,但灾难性遗忘风险显著更高:

# 概念性展示全量微调风险

def full_finetune_risk_demo():

预训练模型能力 = "精通:数学推理、编程实现、文学创作、历史知识..."

全量微调后模型 = "专注于:医疗诊断专业知识"

# 测试通用能力

测试问题 = "请解释牛顿第二定律并给出Python模拟代码"

模型回答 = "作为医疗AI,我主要专注于疾病诊断和治疗方案..." # 灾难性遗忘发生!

return "模型过度专业化,丧失原有通用能力"LoRA的保护机制

LoRA通过权重冻结技术天然避免灾难性遗忘:

技术原理:

-

基础权重 $W$ 完全冻结,保持不变

-

只训练额外的低秩适配器 $BA$

-

原始知识"固化"在 $W$ 中,新知识存储在 $BA$ 中

# LoRA的知识保护机制

def lora_knowledge_preservation():

原始知识库 = 冻结的_W矩阵 # 包含预训练获得的所有通用知识

领域新知识 = 可训练的_BA矩阵 # 学习特定领域知识

# 前向传播:结合通用知识与领域知识

输出 = (原始知识库 + 领域新知识) × 输入

# 关键优势:即使新知识训练不理想,原始知识仍然完好无损

return "通用能力与专业能力的完美共存"第五部分:微调策略决策框架

综合决策流程图

数据量评估

↓

少于1万条 → 强烈推荐LoRA (r=8~16)

↓

1万~10万条 → LoRA优先 (r=16~32),效果不佳再考虑全量

↓

10万条以上 → 评估任务复杂度

├── 简单任务 → 仍可用LoRA (r=32~64)

└── 复杂任务 → 考虑全量微调或QLoRA

典型场景分析

场景1:企业内部知识库(LoRA优势场景)

场景特征 = {

"数据量": "几百到几千条QA对",

"核心需求": "在保留通用能力基础上添加专业知识",

"硬件条件": "单卡GPU或有限计算资源",

"推荐方案": "LoRA (r=8~16)",

"决策理由": "数据量适中,需保护通用能力,资源受限"

}

场景2:专业领域模型(需权衡场景)

场景特征 = {

"数据量": "1-5万条专业数据",

"核心需求": "构建领域专业模型",

"硬件条件": "多卡GPU服务器",

"推荐方案": "先尝试LoRA (r=16~32),验证集评估",

"决策理由": "平衡效果与成本,避免过度投资"

}

场景3:大规模领域适应(全量微调候选)

场景特征 = {

"数据量": "10万条以上高质量数据",

"核心需求": "打造顶尖领域专家模型",

"硬件条件": "充足计算资源",

"推荐方案": "考虑全量微调或QLoRA",

"决策理由": "数据足够丰富,值得充分学习"

}

渐进式微调最佳实践

推荐的三步策略:

-

第一步:总是从LoRA开始

# 最小可行方案验证 lora_config = LoraConfig(r=8, lora_alpha=32, ...) # 快速训练1-2个epoch,验证基础效果

第二步:按需增强能力

if 验证集效果不满足需求:

# 方案A:增加秩

lora_config = LoraConfig(r=16, ...)

# 方案B:扩展目标模块

lora_config = LoraConfig(target_modules=更多模块...)

第三步:谨慎考虑全量

# 严格的全量微调准入条件

if (数据量 > 100000 and

验证集表明LoRA遇到瓶颈 and

计算资源充足 and

任务要求极致性能):

考虑全量微调()

else:

继续优化LoRA配置() # 绝大多数场景的推荐选择

技术对比总结

| 特性维度 | LoRA微调 | 全量微调 | 说明 |

|---|---|---|---|

| 参数量 | 极少(0.1%-1%) | 全部(100%) | LoRA参数效率极高 |

| 显存需求 | 很低 | 很高 | LoRA适合资源受限环境 |

| 训练速度 | 快 | 慢 | LoRA收敛更快 |

| 灾难性遗忘 | 风险极低 | 风险较高 | LoRA的核心优势 |

| 多任务支持 | 优秀 | 差 | LoRA适配器灵活切换 |

| 大数据适应性 | 可能遇到瓶颈 | 能充分学习 | 全量微调的数据优势 |

| 部署便利性 | 可合并,无开销 | 单一模型 | 两者推理效率相同 |

| 硬件门槛 | 消费级显卡 | 专业级设备 | LoRA降低使用门槛 |

结论与展望

LoRA技术无疑是大模型 democratization(民主化)的重要推动力。它让更多的团队和个人能够在有限资源下获得高质量的领域专用模型,极大地促进了大模型技术的普及和应用创新。

核心价值总结:

-

技术普惠:使得大模型定制化不再是大厂的专利

-

风险控制:有效避免灾难性遗忘,保护模型通用能力

-

效率提升:大幅降低微调成本,加速模型迭代周期

-

灵活架构:支持多任务、多领域的快速切换和组合

未来展望:

随着LoRA相关技术的不断发展(如AdaLoRA、LoRA+等),我们期待看到更多创新的参数高效微调方法出现,进一步推动大模型技术在各个行业的深度应用。

在实践中,我们建议始终采用"从LoRA开始,按需升级"的渐进式策略,这已在绝大多数场景下被证明是最佳的技术选型路径。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)