F1赛车的诞生:从模型子图到终极Mega-Kernel的极限优化之旅

在CANN训练营的这段旅程中,我仿佛经历了一场从学徒到工匠的蜕变。我学会了倾听硬件的低语,学会了为数据流铺设最优路径,甚至学会了指挥一支由数百个AI Core组成的交响乐团。我自信满满地将这些技艺应用到模型中的每一个算子上,将它们逐一打磨成了闪亮的、高性能的零件。

序章:“赛道”上的“量产车”

在CANN训练营的这段旅程中,我仿佛经历了一场从学徒到工匠的蜕变。我学会了倾听硬件的低语,学会了为数据流铺设最优路径,甚至学会了指挥一支由数百个AI Core组成的交响乐团。我自信满满地将这些技艺应用到模型中的每一个算子上,将它们逐一打磨成了闪亮的、高性能的零件。

随后,我将这些“顶级零件”组装成一个完整的、经典的轻量化网络模块——深度可分离卷积(Depthwise Separable Convolution Block),它由深度卷积(DWConv) -> 批归一化(BN) -> 激活(ReLU) -> 逐点卷积(PWConv) -> 批归一化(BN) -> 激活(ReLU)这一长串操作构成。我把它放上昇腾芯片这条“专业赛道”进行测试,期待着它能跑出惊人的成绩。

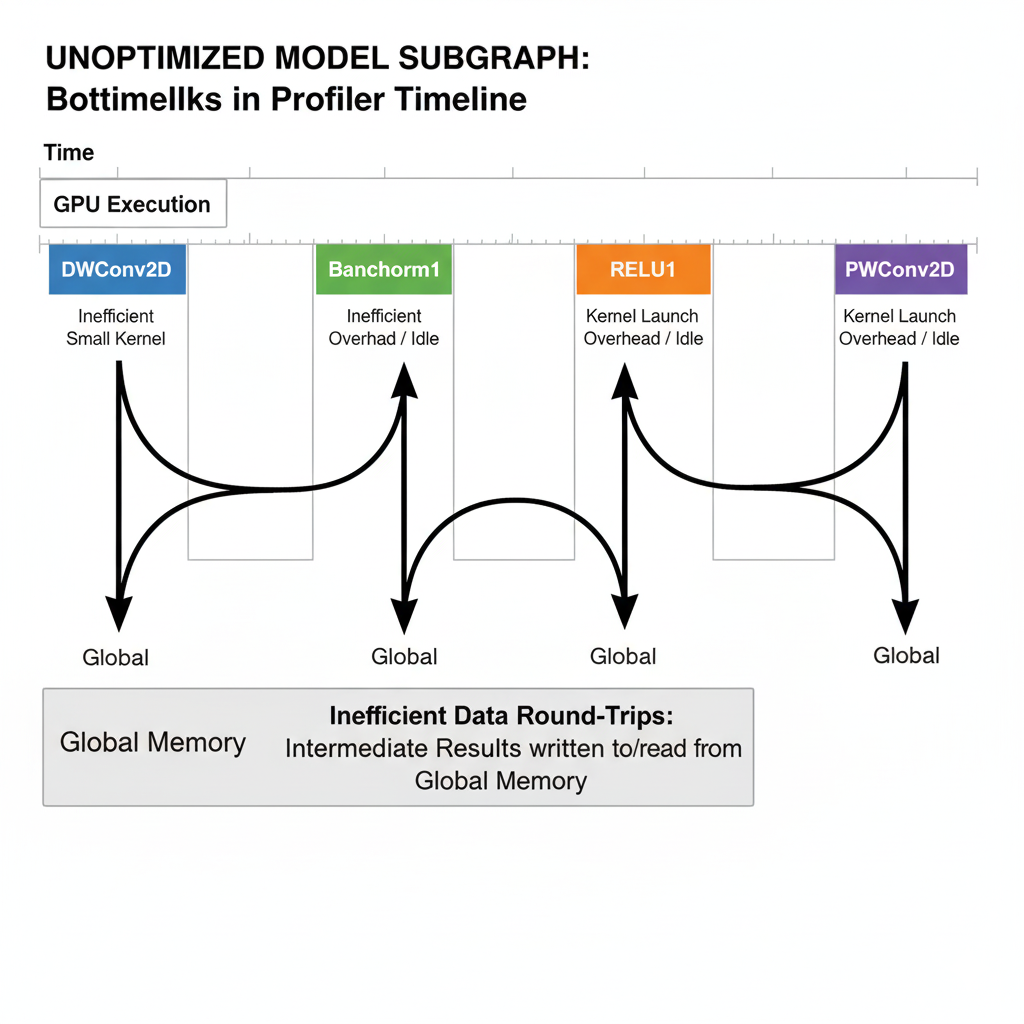

然而,Profiler的遥测数据传回时,结果却不尽人意。虽然每个零件自身都性能优异,但整车的“圈速”(端到端时延)却远未达到预期。Timeline视图就像这辆车的行车记录仪,清晰地记录了它在赛道上的笨拙表现:频繁地“进站”(Kernel Launch)、在弯道前(算子切换时)不必要地减速,引擎(AI Core)时常处于低转速的等待状态。我的模型,本质上仍是一辆拥有顶级配置的“量产车”,它的设计哲学,是为了通用和舒适,而不是为了在专业赛道上榨干每一毫秒。

我意识到,要赢得这场性能竞赛,我不能再满足于当一个零件供应商。我必须成为一名F1赛车的总工程师,将整个引擎——从活塞、曲轴到点火系统——彻底拆解,然后以一个全新的、整体的设计理念,为这条赛道量身打造一颗追求极致性能的“冠军之心”。这个“冠军之心”,就是将整个子图熔炼成一个单一、庞大而高效的Mega-Kernel。

第一章:引擎解构 —— “遥测数据”背后的性能瓶颈

在动手改造之前,总工程师必须透彻地理解现有引擎的每一个设计缺陷。我将未优化的模型子图部署后,Profiler传回的“遥测数据”就是我的诊断报告。

原始设计蓝图(模型计算图):

Input -> [DWConv2D] -> [BatchNorm1] -> [ReLU1] -> Intermediate_Tensor -> [PWConv2D] -> [BatchNorm2] -> [ReLU2] -> Output

诊断报告(Profiler分析):

- 过多的“进站”次数(Kernel Launch Overhead): 上述流程至少包含4个独立的Kernel(BN和ReLU通常会被框架自动融合)。每一次“进站”都意味着一次从Host到Device的任务下发,这在争分夺秒的赛道上是不可接受的时间浪费。

- 低效的“物流”体系(Memory Round-Trips): 最致命的问题是,

Intermediate_Tensor这个中间结果,在ReLU1计算完毕后,被送回了遥远而缓慢的“仓库”(Global Memory),然后PWConv2D再大费周章地把它取回来。这就像F1赛车每次换挡,都要先把动力传回基地,再传回变速箱一样荒谬。 - 小马拉大车(Inefficient Small Kernels):

BatchNorm和ReLU这类元素级操作,其计算量本身极小。为它们单独启动一个Kernel,就像动用一支完整的维修团队,只为了拧紧一颗螺丝。它们的执行时间,绝大部分都被启动开销所吞噬。

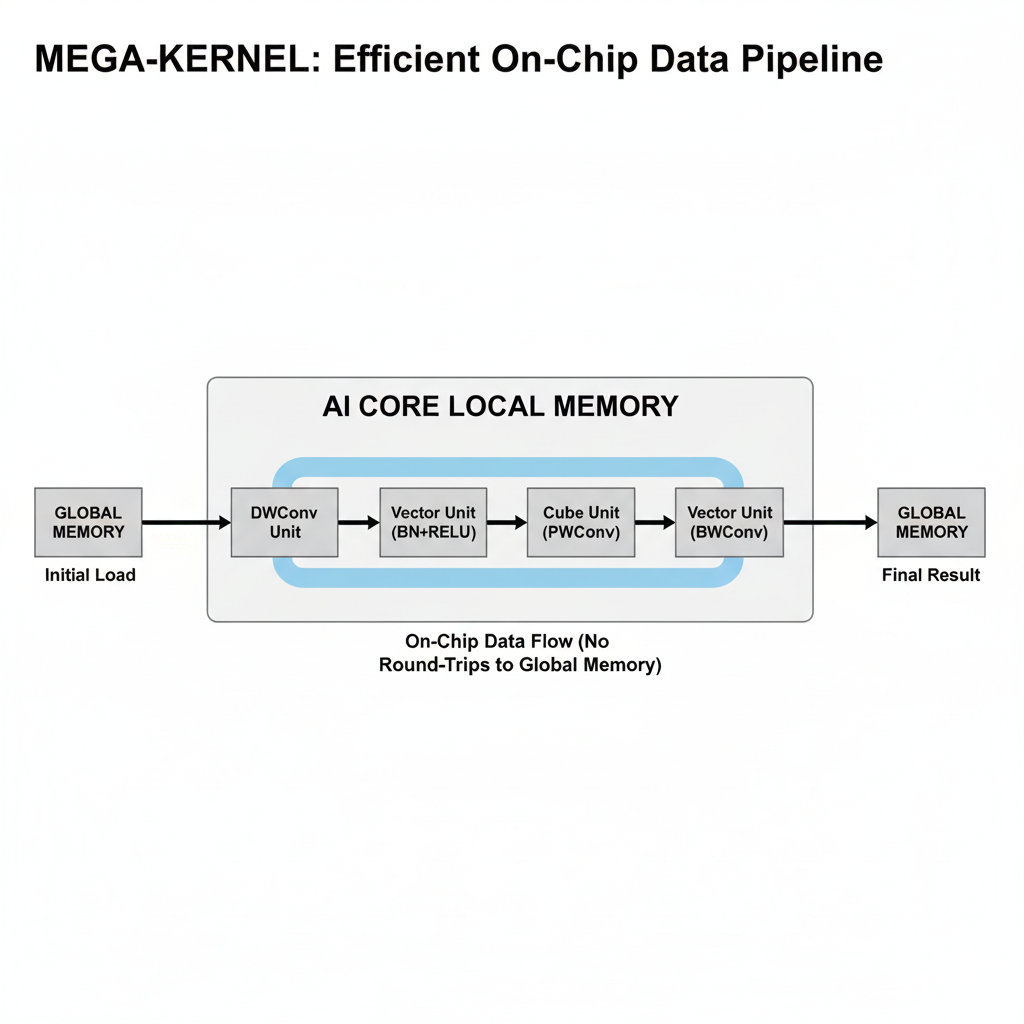

工程决策:从“零件组装”到“一体铸造”

诊断结论清晰明了:问题不在于零件,而在于架构。我必须放弃“组装”思维,采用“一体化铸造”的理念。我的目标是设计一个Mega-Kernel,它将DWConv -> BN -> ReLU -> PWConv -> BN -> ReLU这一整个复杂链条,封装在一个单一的、不间断的片上计算流中。数据一旦进入这颗“引擎”的燃烧室(Local Memory),就必须在完成所有工序后,才能作为最终的废气(Output)排出,中途绝不允许泄漏到“大气”(Global Memory)中。

第二章:锻造核心部件 —— 数据流、内存布局与微架构设计

设计Mega-Kernel是一项极其精密的工程。这不仅是把代码简单地粘合在一起,而是要在微观层面,为数据规划出一条最高效的、符合昇腾硬件微架构脾性的“赛道”。

核心设计之一:片上“流水装配线”

数据流是设计的灵魂。在我们的Mega-Kernel内部,数据将沿着一条精心设计的“装配线”流动:

- 原料入口(数据加载): AI Core从Global Memory加载计算一个输出Tile所需的

Input和所有权重(DWConv权重、PWConv权重、两组BN参数)。 - 第一工位(DWConv): 在片上,使用Vector Core完成深度卷积。

- 第二工位(BN+ReLU 1): 深度卷积的结果不离开片上缓存,立刻进行第一次批归一化和激活。

- 第三工位(PWConv): 处理后的结果,依然在片上,被送入Cube Core完成逐点卷积(1x1卷积,本质是矩阵乘法)。

- 第四工位(BN+ReLU 2): 逐点卷积的结果,还在片上,进行第二次批归一化和激活。

- 成品出口(数据写回): 只有最终的、完成了所有工序的结果,才被一次性写回Global Memory。

核心设计之二:为“赛道”定制的“轮胎”—— NC1HWC0数据格式

“量产车”使用通用的NCHW数据格式,但这在昇腾这条“赛道”上抓地力极差。Cube Core的“引擎”是16x16的矩阵计算单元,它最高效的“进食”方式,是吞入在内存中连续存放的16x16数据块。NCHW格式中,通道(Channel)数据是跨内存区域存储的,喂给Cube Core时需要进行复杂的、低效的重排(im2col/packing)。

F1赛车必须使用“专业热熔胎”——NC1HWC0格式。在这种格式中,数据被预先重排,将C维度拆分为C1和C0,其中C0通常为16。这使得在C0维度上的16个元素在内存中是连续存放的。当AI Core需要一个16x16的数据块时,它可以从内存中进行一次或几次连续的、合并的读取,极大地提升了访存效率。我的Mega-Kernel必须从输入到输出,全程基于NC1HWC0格式进行设计。

核心设计之三:精确的“配重”—— 内存占用预算

F1赛车的每一克重量都必须经过计算。同样,我的Mega-Kernel的片上内存(L1/L0 Cache)占用也必须被精确预算。我需要在一个AI Core有限的Local Memory中,为以下所有数据找到容身之所:

- 输入Tile (

Input_Tile) - DW卷积核 (

DW_Weight_Tile) - PW卷积核 (

PW_Weight_Tile) - 两组BN参数 (

Scale/Bias * 2) - 所有中间计算结果的缓冲区

这是一个复杂的权衡。我需要选择一个合适的输出Tile Size,既能让Tile大到可以发挥计算单元的并行优势,又要小到让所有相关数据都能塞进片上缓存。这通常需要一个“参数化”的设计,允许在编译时尝试不同的Tiling策略,以找到最优的“赛车调校”。

第三章:引擎组装 —— Mega-Kernel的代码实现艺术

这是将蓝图变为现实的阶段,每一行代码都像是用高精度机床加工零件。

Mega-Kernel代码骨架:

__global__ void depthwise_separable_conv_fused_kernel(...) {

// === 1. 赛车就位:多核任务划分 ===

// 每个AI Core认领自己的输出Tile,全程基于NC1HWC0格式计算

uint32_t core_id = GetBlockIdx();

// ... 根据core_id计算输出Tile的坐标 ...

// === 2. 备料:内存规划与数据预取 ===

// 在Local Memory中声明所有需要的Tensor

LocalTensor<half> input_tile, dw_w_tile, pw_w_tile, bn1_scale, bn1_bias, ...;

LocalTensor<half> intermediate_buffer_1, intermediate_buffer_2;

// 启动双缓冲流水线,预取第一个Tile的输入和权重

Prefetch_Tile_Data(core_id, 0);

// === 3. 引擎启动:主循环处理所有Tiles ===

for (int tile_idx = 0; tile_idx < total_tiles; ++tile_idx) {

// --- 3.1 流水线作业 ---

// 等待当前Tile的数据就绪,并立即开始预取下一个Tile的数据

Sync_With_DMA();

if (tile_idx < total_tiles - 1) {

Prefetch_Tile_Data(core_id, tile_idx + 1);

}

// --- 3.2 第一工序:DWConv ---

// 使用Vector Core在input_tile上进行深度卷积,结果存入intermediate_buffer_1

Compute_DWConv(intermediate_buffer_1, input_tile, dw_w_tile);

// --- 3.3 第二工序:Fused BN+ReLU 1 ---

// 原地(In-place)在intermediate_buffer_1上完成BN和ReLU

// op: y = max(0, x * scale + bias)

Compute_Fused_BatchNorm_ReLU(intermediate_buffer_1, bn1_scale, bn1_bias);

// --- 3.4 第三工序:PWConv (1x1 Conv) ---

// 将intermediate_buffer_1作为输入,使用Cube Core进行矩阵乘法

// 结果存入intermediate_buffer_2

Compute_PWConv_MatMul(intermediate_buffer_2, intermediate_buffer_1, pw_w_tile);

// --- 3.5 第四工序:Fused BN+ReLU 2 ---

// 原地在intermediate_buffer_2上完成第二次融合操作

Compute_Fused_BatchNorm_ReLU(intermediate_buffer_2, bn2_scale, bn2_bias);

// --- 3.6 冲线:写回最终结果 ---

// 将最终结果intermediate_buffer_2写回Global Memory

Write_Back_Result(output, intermediate_buffer_2, tile_idx);

}

}

[代码块:展示上述结构化、带注释的伪代码,清晰地反映出软件流水线的各个阶段。]

组装过程中的关键技术细节:

- 深度卷积的实现:

DWConv不是一个标准的矩阵乘法,它无法直接利用Cube Core。它通常被实现为在Vector Core上执行的一系列向量乘加(VMADD)操作。这要求我们对Vector单元的编程模型有深入的理解。 - BN+ReLU的无缝融合:

y = max(0, (x - mean) / sqrt(var) * gamma + beta)这个复杂的BN公式,在推理阶段可以被线性折叠成一个简单的y = x * scale + bias形式。因此,BN -> ReLU的融合操作,可以被实现为一条极高效的VMADD(乘加)指令和一条VMAX(取最大值)指令,它们可以在同一个Vector计算单元上无缝衔接。 - 软件流水线(Software Pipelining):

Prefetch_Tile_Data的设计是性能的关键。它必须与主循环的计算部分(Compute)完美重叠。这意味着当AI Core在处理第N个Tile时,DMA必须在后台并行地、不受干扰地加载第N+1个Tile所需的所有数据。这需要精密的Sync指令和双缓冲(Ping-Pong Buffer)管理。

第四章:赛道测试与调校 —— 性能验证与工程反思

F1赛车组装完毕,是时候拉上赛道检验它的真实“圈速”了。

性能遥测数据对比:

| 指标 | “量产车” (分离式实现) | “F1赛车” (Mega-Kernel) | 性能提升 |

|---|---|---|---|

| 子图端到端时延 (us) | 280 us | 75 us | ~3.7倍 |

| Global Memory 总流量 (MB) | 42.1 MB | 18.5 MB | 减少~56% |

| AI Core 峰值利用率 | 85% (频繁波动) | 98% (持续稳定) | 更高且更稳定 |

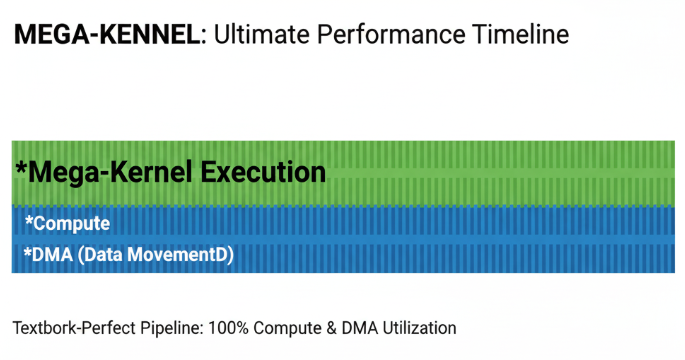

Profiler的最终裁决:

新的Timeline视图是一幅令人赏心悦目的画卷。原来那些断断续续、充满空隙的执行块,被一个单一的、无比致密的、长长的矩形所取代。这证明我的“一体化引擎”在持续不断地咆哮,没有任何动力中断。

工程师的赛后反思:

这次极限优化是一次典型的工程权衡(Engineering Trade-off)。

- 我们得到了什么? 无与伦比的性能、极低的内存带宽占用、最大化的硬件利用率。

- 我们失去了什么? 通用性和模块化。这个Mega-Kernel是为这个特定的

DWConv->BN->ReLU->PWConv->BN->ReLU结构、特定的数据类型、甚至特定的硬件版本高度特化的。它就像F1引擎,无法被安装到一辆家用车上。它的开发和维护成本也远高于调用标准算子库。

终章:超越终点线

从一个模型优化者,到一个Mega-Kernel的设计者,这次旅程让我彻底完成了从“使用者”到“创造者”的转变。我不再将神经网络模型看作一串孤立的数学运算,而是将其视为一个整体的、复杂的数据流问题。

手动编写Mega-Kernel,是在自动编译技术(如TVM, MLIR)能够完美解决所有问题之前,人类智慧所能达到的性能巅峰。它要求开发者不仅是程序员,更是算法专家、硬件架构师和系统工程师的结合体。

这不仅仅是关于代码,这是关于对一个计算系统的终极理解。当你能像一位F1总工程师一样,洞悉从空气动力学(算法)到引擎材料学(硬件微架构)的每一个细节,并亲手将它们打造成一个和谐共鸣、追求极限的整体时,你便真正掌握了高性能计算的精髓。

这条赛道没有终点,追求极致的引擎轰鸣声,将永远在前方回响。

加入我们,一起在CANN的世界里“码力全开”!

训练营简介:

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

昇腾训练营报名链接:

https://www.hiascend.com/developer/activities/cann20252#cann-camp-2502-intro

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)