ai模型概念

生成模型的演进,本质上是对如何表征和优化复杂数据分布这一统计学问题的不断探索。VAE通过变分推断和ELBO提供了一个稳固的贝叶斯框架,但存在近似误差。GAN绕过了显式的密度估计,通过博弈论直接学习从简单分布到数据分布的变换,但训练不稳定。流模型通过精确的变量变换实现了似然的精确计算,但要求变换可逆且雅可比行列式易算,结构设计复杂。扩散模型通过一个固定的马尔可夫链过程将数据逐步扰动为噪声,再学习逆过

一、 核心基础概念

这些是理解生成模型所必需的概率论与统计学基石。

-

概率分布

-

概念:描述随机变量取不同值的可能性。生成模型的终极目标就是学习到一个模型分布 pmodel(x)pmodel(x),使其尽可能地接近真实数据的分布 pdata(x)pdata(x)。

-

类型:

-

离散分布:变量取值是离散的(如图像的像素值在0-255之间)。

-

连续分布:变量取值是连续的(如自然图像的RGB值归一化到[0,1])。

-

-

常见分布:均匀分布、高斯分布(正态分布)、伯努利分布、范畴分布等。

-

-

似然函数

-

概念:在给定模型参数 θθ 时,观测到当前数据 XX 的概率。它被视为参数 θθ 的函数。

-

公式:L(θ∣X)=p(X∣θ)L(θ∣X)=p(X∣θ)。

-

重要性:最大似然估计 是训练大多数生成模型(尤其是显式密度模型)的基本原则。我们的目标是找到一组参数 θθ,使得模型将观测到的真实数据的“可能性”最大化。

-

-

条件概率与贝叶斯定理

-

条件概率:p(Y∣X)p(Y∣X) 表示在事件 XX 发生的条件下,事件 YY 发生的概率。

-

贝叶斯定理:p(Y∣X)=p(X∣Y)p(Y)p(X)p(Y∣X)=p(X)p(X∣Y)p(Y)。

-

应用:在生成模型中,尤其是在变分自编码器(VAE)中,我们经常需要处理后验概率 p(z∣x)p(z∣x)(给定数据 xx,其潜在编码 zz 的分布),贝叶斯定理是推导其近似方法的核心。

-

-

期望与方差

-

期望:随机变量概率加权下的“平均值”。在优化目标(如ELBO)中经常需要计算期望。

-

方差:衡量随机变量与其期望的偏离程度。在评估生成质量和多样性时,方差是一个隐含的考量因素。

-

-

熵与信息论概念

-

信息熵:衡量一个概率分布的不确定性或混乱程度。熵越大,不确定性越高。

-

交叉熵:衡量用一个估计的分布 pp 去近似真实分布 qq 时所付出的平均编码长度。常用于训练生成模型(如GAN的判别器)的损失函数。

-

KL散度:衡量两个概率分布之间的差异(非对称)。它是生成模型中最重要的概念之一。

-

JS散度:KL散度的一种对称变体,在原始GAN中被使用。

-

二、 关键进阶概念

这些概念是构建和理解现代生成模型(如VAE, GAN, Flow-based Model)的核心。

-

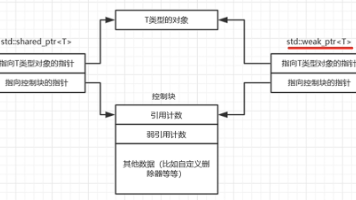

潜变量模型

-

概念:假设观测到的数据 xx 是由一个未观测到的、低维的潜变量 zz 所生成的。数据分布可以表示为:

p(x)=∫p(x∣z)p(z)dzp(x)=∫p(x∣z)p(z)dz -

意义:它将高维复杂的数据分布(如图像)的生成过程,分解为一个简单的潜变量分布 p(z)p(z)(如标准高斯分布)和一个复杂的生成过程 p(x∣z)p(x∣z)。VAE和生成流模型都是潜变量模型。

-

-

变分推断

-

问题:在潜变量模型中,计算后验概率 p(z∣x)=p(x∣z)p(z)p(x)p(z∣x)=p(x)p(x∣z)p(z) 通常是难以处理的,因为边缘似然 p(x)p(x) 的计算涉及复杂的积分。

-

解决方案:用一个由参数 ϕϕ 控制的简单分布 qϕ(z∣x)qϕ(z∣x) 来近似这个难以处理的后验分布 p(z∣x)p(z∣x)。

-

核心工具:通过最大化证据下界(ELBO) 来优化 qϕ(z∣x)qϕ(z∣x),使其接近真实后验。

-

-

证据下界

-

推导:通过对数似然 logp(x)logp(x) 的变分下界。

logp(x)≥Eqϕ(z∣x)[logpθ(x∣z)]−DKL(qϕ(z∣x)∥p(z))logp(x)≥Eqϕ(z∣x)[logpθ(x∣z)]−DKL(qϕ(z∣x)∥p(z)) -

解读:

-

第一项(重构项):期望在近似后验 qϕ(z∣x)qϕ(z∣x) 下,解码器 pθ(x∣z)pθ(x∣z) 能够很好地重构数据 xx。它鼓励生成质量。

-

第二项(正则化项):KL散度,迫使近似后验 qϕ(z∣x)qϕ(z∣x) 接近先验分布 p(z)p(z)。它鼓励潜空间的规整性,防止过拟合。

-

-

重要性:VAE的优化目标就是最大化ELBO。

-

-

蒙特卡洛方法

-

概念:通过从概率分布中随机采样来近似计算复杂积分或期望值的一类方法。

-

应用:在VAE中,为了计算ELBO关于 ϕϕ 的梯度,需要从 qϕ(z∣x)qϕ(z∣x) 中采样,这引入了随机性。重参数化技巧 就是为了解决这个采样的不可导问题而提出的。

-

-

测度变换与变量变换定理

-

概念:当有一个随机变量 zz(服从简单分布)通过一个复杂、可逆的变换 ff 得到新变量 x=f(z)x=f(z) 时,变量变换定理描述了 xx 的分布如何由 zz 的分布和变换 ff 的雅可比矩阵决定。

-

公式:px(x)=pz(f−1(x))∣det∂f−1∂x∣px(x)=pz(f−1(x))det∂x∂f−1

-

重要性:这是归一化流模型 的核心。通过堆叠一系列可逆变换,可以将一个简单分布“流”成一个复杂的数据分布,并且可以精确地计算新样本的似然。

-

-

博弈论

-

概念:研究多个决策者之间策略互动的数学模型。

-

应用:生成对抗网络(GAN) 的框架被形式化为一个极小极大博弈。

-

生成器 GG:试图生成假数据来“欺骗”判别器。

-

判别器 DD:试图区分真实数据和生成数据。

-

-

目标函数:minGmaxDV(D,G)=Ex∼pdata[logD(x)]+Ez∼p(z)[log(1−D(G(z)))]minGmaxDV(D,G)=Ex∼pdata[logD(x)]+Ez∼p(z)[log(1−D(G(z)))]

-

三、 概念与模型的对应关系

| 生成模型类型 | 核心依赖的统计学概念 |

|---|---|

| 变分自编码器(VAE) | 潜变量模型、变分推断、证据下界(ELBO)、KL散度、蒙特卡洛采样、重参数化技巧 |

| 生成对抗网络(GAN) | 博弈论(极小极大博弈)、JS散度 / f-散度 / Wasserstein距离、非参数统计 |

| 归一化流模型 | 变量变换定理、雅可比行列式、可逆函数、测度变换 |

| 自回归模型(如PixelCNN) | 概率链式法则、条件概率、极大似然估计 |

| 扩散模型 | 马尔可夫链、高斯分布、重参数化技巧、变分下界(与VAE类似) |

总结

生成模型的演进,本质上是对如何表征和优化复杂数据分布这一统计学问题的不断探索。

-

VAE 通过变分推断和ELBO提供了一个稳固的贝叶斯框架,但存在近似误差。

-

GAN 绕过了显式的密度估计,通过博弈论直接学习从简单分布到数据分布的变换,但训练不稳定。

-

流模型 通过精确的变量变换实现了似然的精确计算,但要求变换可逆且雅可比行列式易算,结构设计复杂。

-

扩散模型 通过一个固定的马尔可夫链过程将数据逐步扰动为噪声,再学习逆过程以生成数据,目前在许多领域取得了顶尖效果。

理解这些背后的统计学概念,不仅能帮助我们更好地理解现有模型的原理和优缺点,也为开发和理解下一代生成模型奠定了坚实的基础。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)