AI大模型入门 七 核心概念深度解析:参数量、Token、上下文窗口、上下文长度与温度

本文解析了大模型中的五个核心概念:1)参数量决定模型复杂度与计算成本;2)Token是文本处理的基本单元;3)上下文窗口影响模型理解范围;4)上下文长度限制模型处理能力;5)温度参数控制生成内容的创造性与准确性。这些要素共同影响大模型的性能表现,理解它们有助于优化模型设计与应用,在计算成本与生成质量间取得平衡。掌握这些概念对高效运用AI技术具有重要指导意义。

随着大模型在AI领域的广泛应用,理解它们的核心概念至关重要。参数量、Token、上下文窗口、上下文长度和温度这五个术语,不仅是模型设计中的基本要素,还在模型的应用效果、训练成本和生成质量等方面起着决定性作用。接下来,让我们深入解析这五个核心概念,并用图示帮助您更直观地理解它们的实际应用。

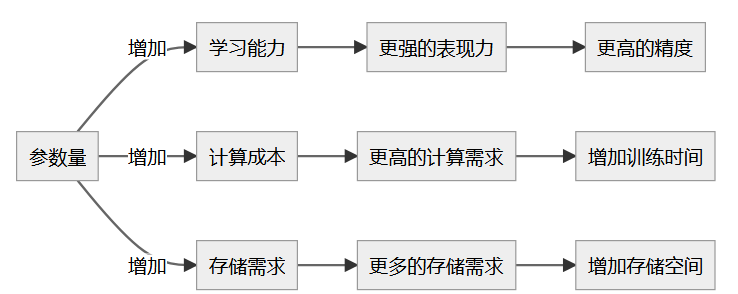

1. 参数量:模型能力与计算成本的平衡

参数量是大模型的一个关键指标,决定了模型的复杂度、表现力和计算需求。简单来说,参数量就像是模型的大脑,它包含了模型在训练过程中学习到的所有信息。

作用与影响

-

学习能力:更多的参数意味着模型可以捕捉更复杂的数据模式。例如,GPT-4拥有1.8万亿个参数,因此能在文本生成上展现更强的表达能力。

-

计算成本:随着参数量的增加,模型的计算需求也会增加,意味着需要更多的计算资源和训练时间。

-

存储需求:大模型需要更高的存储空间,因此硬件配置也需要更加高效。

-

泛化能力:大模型虽然能在训练数据上取得更好的效果,但也有过拟合的风险,因此如何平衡参数量至关重要。

参数量与模型表现力的关系

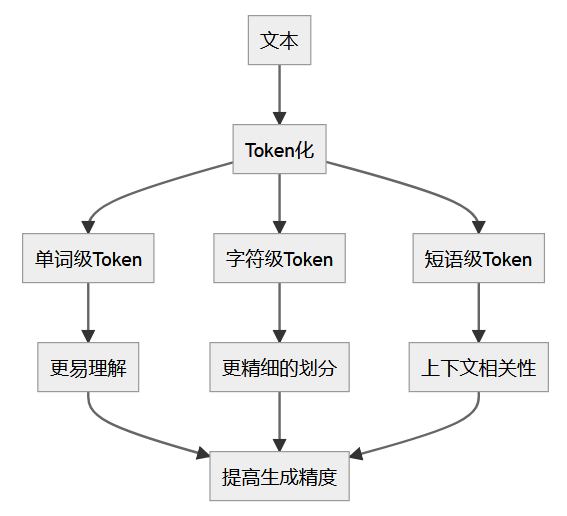

2. Token:模型理解文本的基本单元

在大模型中,Token代表模型理解和处理文本的最小单位。每个Token都可以是一个单词、字符或符号,甚至是一个短语。

作用与影响

-

Token化过程:文本被分解为多个Token,这些Token会被模型用来生成预测或输出。例如,“你好,我是公众号云网记,请多多关照!”这句话会被拆解成20个Token,标点符号也算作一个独立的Token。

-

Token化影响理解能力:Token划分的精细度会直接影响模型的理解能力。特别是在中文处理时,多音字和词组的划分需要更细致的策略。

Token划分对文本理解的影响

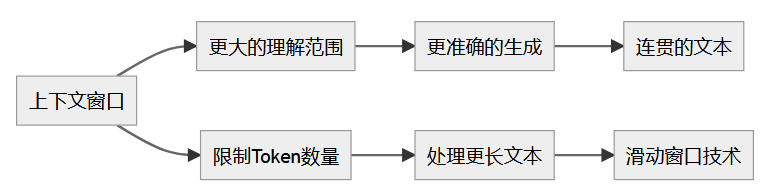

3. 上下文窗口:决定模型理解范围

上下文窗口是指在生成文本时,模型能一次性“看到”的最大文本长度。这个窗口决定了模型在生成每个Token时,参考多少前文信息。

作用与影响

-

窗口大小影响生成质量:较大的上下文窗口可以让模型更好地捕捉上下文信息,从而生成更加连贯和准确的文本。

-

限制与挑战:随着输入序列的增大,模型的计算复杂度也会增加,因此需要在效率和效果之间找到平衡点。

上下文窗口对文本生成的影响

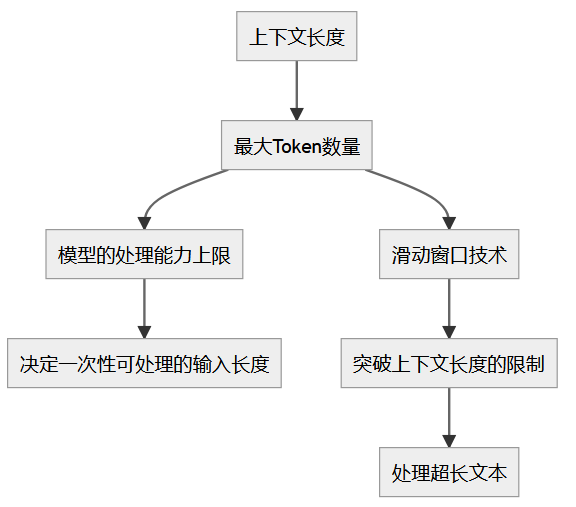

4. 上下文长度:模型的处理极限

上下文长度是指模型一次性能够处理的最大Token数量,决定了模型能够处理多长的输入。

作用与影响

-

处理能力的上限:上下文长度限制了模型每次处理的输入信息量。例如,ChatGPT-3.5的上下文长度为4096个Token,这意味着它无法一次性处理超过此长度的文本。

-

突破上下文长度的技术:为了处理超长文本,技术如滑动窗口被应用于模型中,通过分段处理来突破这一限制。

上下文长度与处理能力的关系

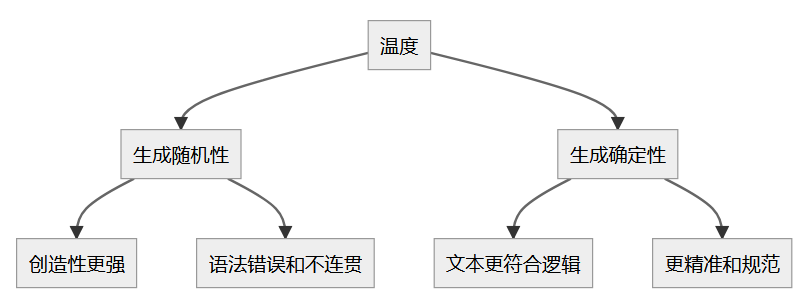

5. 温度:控制输出的创造性与逻辑性

温度是一个调节模型生成文本时随机性与确定性的参数。通过调整温度,我们可以控制模型生成内容的创造性与准确性之间的平衡。

作用与影响

-

低温度(0.2): 输出内容更为规范、符合逻辑,适用于需要高精度的任务。

-

高温度(0.8): 输出内容更具创造性,但可能包含不规范或不连贯的元素,适用于需要创新的任务,如写作或创意生成。

温度调节生成文本的影响

推荐阅读

* https://blog.csdn.net/chengzi_beibei/article/details/150393633?spm=1001.2014.3001.5501

* https://blog.csdn.net/chengzi_beibei/article/details/150393354?spm=1001.2014.3001.5501

* https://blog.csdn.net/chengzi_beibei/article/details/150393354?spm=1001.2014.3001.5501

学社精选

- 测试开发之路 大厂面试总结 - 霍格沃兹测试开发学社 - 爱测-测试人社区

- 【面试】分享一个面试题总结,来置个顶 - 霍格沃兹测试学院校内交流 - 爱测-测试人社区

- 测试人生 | 从外包菜鸟到测试开发,薪资一年翻三倍,连自己都不敢信!(附面试真题与答案) - 测试开发 - 爱测-测试人社区

- 人工智能与自动化测试结合实战-探索人工智能在测试领域中的应用

- 爱测智能化测试平台

- 自动化测试平台

- 精准测试平台

- AI测试开发企业技术咨询服务

技术成长路线

系统化进阶路径与学习方案

- 人工智能测试开发路径

- 名企定向就业路径

- 测试开发进阶路线

- 测试开发高阶路线

- 性能测试进阶路径

- 测试管理专项提升路径

- 私教一对一技术指导

- 全日制 / 周末学习计划

- 公众号:霍格沃兹测试学院

- 视频号:霍格沃兹软件测试

- ChatGPT体验地址:霍格沃兹测试开发学社

- 霍格沃兹测试开发学社

企业级解决方案

测试体系建设与项目落地

- 全流程质量保障方案

- 按需定制化测试团队

- 自动化测试框架构建

- AI驱动的测试平台实施

- 车载测试专项方案

- 测吧(北京)科技有限公司

技术平台与工具

自研工具与开放资源

- 爱测智能化测试平台 - 测吧(北京)科技有限公司

- ceshiren.com 技术社区

- 开源工具 AppCrawler

- AI测试助手霍格沃兹测试开发学社

- 开源工具Hogwarts-Browser-Use

人工智能测试开发学习专区

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)