CANN 全流程开发实战:从环境搭建到推理部署

CANN 开发是昇腾 AI 生态落地的核心环节,从环境搭建到推理部署的全流程实践,需充分利用 CANN 的工具链与 API 优势。建议开发者从 “小模型、单设备” 场景入手,逐步扩展到 “大模型、多设备” 的工程化部署,持续挖掘昇腾硬件的算力潜力。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

CANN(Compute Architecture for Neural Networks)作为昇腾 AI 生态的核心计算架构,支撑着从算子开发到模型部署的全流程 AI 开发任务。本文聚焦 CANN 开发的工程化落地,从环境搭建、多框架模型迁移到推理应用开发,完整呈现 CANN 开发的端到端实践路径。

一、CANN 开发生态全景图

CANN 生态涵盖工具链、开发框架、部署平台三大核心模块,各模块的功能与协同关系如下:

| 模块类型 | 核心组件 | 功能定位 |

|---|---|---|

| 工具链 | msOpGen、Model Converter、Profiling Toolkit | 算子工程生成、模型格式转换、性能分析 |

| 开发框架 | Ascend C、AscendCL、TF/PT 插件 | 算子开发、推理编程、框架生态适配 |

| 部署平台 | Atlas 系列硬件、MindX SDK | 边缘 / 云端推理硬件、行业解决方案套件 |

二、CANN 开发环境一站式搭建

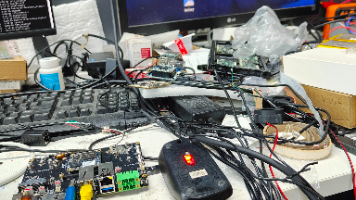

(一)硬件与系统适配

CANN 开发需基于昇腾硬件(如 Atlas 200I DK A2、Atlas 800)或CPU 模拟环境,系统推荐 Ubuntu 20.04。以下是环境依赖检查与安装步骤:

1. 依赖检查

# 检查系统版本

cat /etc/os-release

# 检查内核版本

uname -r

# 安装必要依赖

sudo apt-get install gcc g++ make cmake git libprotobuf-dev protobuf-compiler

2. CANN 包安装(以 7.0.0 版本为例)

# 下载CANN包(从昇腾官网获取)

tar -zxvf Ascend-cann-toolkit_7.0.0_linux-x86_64.run

# 执行安装

./Ascend-cann-toolkit_7.0.0_linux-x86_64.run --install

# 配置环境变量

source /usr/local/Ascend/ascend-toolkit/set_env.sh

(二)多框架开发环境集成

CANN 支持 TensorFlow、PyTorch 等主流框架的插件化集成,以 PyTorch 为例,安装适配插件步骤如下:

# 安装PyTorch(版本需与CANN兼容,如1.11.0)

pip install torch==1.11.0 torchvision==0.12.0

# 安装Ascend PyTorch插件

pip install torch_npu==1.11.0 -f https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/ascend/ascend-toolkit/latest/torch_npu/index.html

验证安装是否成功:

import torch

import torch_npu

# 查看NPU设备

print(torch.npu.device_count())

# 执行简单计算

x = torch.randn(2, 3).npu()

y = torch.randn(2, 3).npu()

print(torch.add(x, y))

三、模型迁移:从 PyTorch 到 CANN 的全流程实践

将 PyTorch 模型迁移到 CANN 平台,需经历模型转换、算子适配、性能优化三个阶段,以下以 ResNet-50 为例展开实战。

(一)模型转换(使用 Model Converter)

Model Converter 支持将 PyTorch 模型转换为 CANN 支持的om格式(离线模型),步骤如下:

- 导出 PyTorch 模型为

onnx格式:

import torch

import torchvision.models as models

# 加载预训练模型

model = models.resnet50(pretrained=True)

model.eval()

# 导出ONNX

dummy_input = torch.randn(1, 3, 224, 224)

torch.onnx.export(

model, dummy_input, "resnet50.onnx",

opset_version=11, input_names=["input"], output_names=["output"]

)

- 转换为

om格式:

# 使用atc工具转换

atc --model=resnet50.onnx --framework=5 --output=resnet50_om --soc_version=Ascend310P3

(二)算子兼容性处理

若模型中存在 CANN 不支持的自定义算子,需通过Ascend C 开发自定义算子并注册到框架中。以自定义GELU算子为例,关键步骤如下:

- 实现 Ascend C 算子(参考前文算子开发流程);

- 注册算子到 PyTorch 插件:

from torch_npu.utils import register_op

@register_op("custom_gelu")

def custom_gelu(input):

# 调用Ascend C自定义算子

return torch.ops.custom_ops.gelu(input)

(三)模型性能优化

通过 CANN 的Profiling Toolkit分析性能瓶颈,针对aic_mte2_ratio(内存带宽)和aic_core_utili(计算单元利用率)优化:

| 优化措施 | 实施方式 | 预期收益 |

|---|---|---|

| 算子融合 | 使用atc --fusion-switch=1开启算子融合,合并连续小算子 |

耗时减少 20%-30% |

| 精度优化 | 开启 BFLOAT16 精度(atc --precision_mode=allow_mix_precision) |

性能提升 1.5 倍,精度损失 < 1% |

| batch 调大 | 调整推理 batch_size(如从 1 调整为 8) | 吞吐量提升 5-8 倍 |

四、推理部署:基于 AscendCL 的应用开发

AscendCL(Ascend Computing Language)是 CANN 的推理编程接口,支持 C/C++/Python 开发推理应用。以下以 Python 为例,开发 ResNet-50 推理应用。

(一)AscendCL 推理流程

推理流程分为模型加载、数据预处理、推理执行、结果后处理四步,代码框架如下:

from ascendctl import *

# 1. 初始化AscendCL

acl.init()

device_id = 0

context, ret = acl.rt.create_context(device_id)

# 2. 加载OM模型

model_path = "resnet50_om.om"

model_id, ret = acl.mdl.load_from_file(model_path)

# 3. 准备输入数据(预处理为模型要求的格式)

import cv2

img = cv2.imread("test.jpg")

img = cv2.resize(img, (224, 224))

img = img.transpose(2, 0, 1).astype("float32") / 255.0

# 转换为ACL内存格式

input_ptr, ret = acl.util.ptr_from_data(img)

# 4. 执行推理

output_ptr, ret = acl.mdl.execute(model_id, [input_ptr], [img.shape])

# 5. 后处理结果

output_data = acl.util.data_from_ptr(output_ptr, (1, 1000), acl.DataType.FLOAT32)

pred_label = output_data.argmax()

print(f"预测类别:{pred_label}")

# 6. 资源释放

acl.mdl.unload(model_id)

acl.rt.destroy_context(context)

acl.finalize()

(二)多设备并行推理

对于多 Atlas 设备场景,可通过多线程 + 设备绑定实现并行推理:

import threading

def infer_on_device(device_id, model_path, img_path):

acl.init()

context, _ = acl.rt.create_context(device_id)

# 加载模型、执行推理...

acl.rt.destroy_context(context)

acl.finalize()

# 启动多线程,每个线程绑定一个设备

threads = []

for i in range(2): # 假设2个设备

t = threading.Thread(target=infer_on_device, args=(i, "resnet50_om.om", "test.jpg"))

threads.append(t)

t.start()

for t in threads:

t.join()

五、CANN 开发常见问题与解决方案

(一)环境类问题:CANN 包安装失败

现象:执行./Ascend-cann-toolkit.run时提示依赖缺失。解决方案:

- 检查系统依赖是否完整,执行:

sudo apt-get install $(cat dependency_list.txt) - 若仍失败,尝试离线安装依赖包,再重新执行安装脚本。

(二)模型转换问题:ONNX 转 OM 失败

现象:atc转换时提示 “不支持的算子 XXX”。解决方案:

- 确认算子是否在 CANN 支持列表中(参考官网《算子支持列表》);

- 若为自定义算子,需先通过 Ascend C 开发并注册,再重新导出 ONNX 模型。

(三)推理性能问题:吞吐量不达标

现象:推理吞吐量远低于硬件标称值。解决方案:

- 用

Profiling Toolkit分析task_latency和aic_core_utili; - 针对性优化(如开启算子融合、调大 batch_size、优化数据预处理)。

结语

CANN 开发是昇腾 AI 生态落地的核心环节,从环境搭建到推理部署的全流程实践,需充分利用 CANN 的工具链与 API 优势。建议开发者从 “小模型、单设备” 场景入手,逐步扩展到 “大模型、多设备” 的工程化部署,持续挖掘昇腾硬件的算力潜力。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)