当AI犯错:RDA的确权、溯源与“算法责任”的法律边界

【摘要】算法决策失误引发的责任归属是前沿法律难题。文章探讨以区块链和零知识证明构建数字证据链,结合新型仲裁与保险机制,为AI时代的责任划分提供系统性解决方案。

【摘要】算法决策失误引发的责任归属是前沿法律难题。文章探讨以区块链和零知识证明构建数字证据链,结合新型仲裁与保险机制,为AI时代的责任划分提供系统性解决方案。

引言

设想一个场景。一辆处于L4级自动驾驶状态的汽车,在城市快速路上因未能准确识别一个被部分遮挡的交通指示牌,导致了一起追尾事故。事故调查发现,AI的感知模型在训练阶段,使用了一批包含该类罕见场景的交通“真实数据资产”(Real Data Asset, RDA)。然而,这批RDA中,部分数据的标注存在细微偏差。

此刻,责任的指针开始在多个主体间摇摆。是驾驶位上未能及时接管的车主?是集成了该AI系统的汽车制造商?是开发了感知算法的科技公司?还是提供了那批“瑕疵”数据的RDA所有者?

这个场景并非科幻,它精准地投射出当前“算法责任”领域的法律真空与技术挑战。传统的产品责任法,建立在物理世界“缺陷-因果-损害”的线性逻辑之上,面对由数据驱动、多方参与、决策过程不透明的AI系统,显得捉襟见肘。RDA的出现,更是将这条从数据源头到最终决策的“责任链”拉长、打散,使其变得前所未有的复杂。

本文的目的,不是简单地评判谁应担责,而是试图从技术架构师的视角,剖析这一困境的根源,并提出一个由技术、法律及商业模式共同构成的协同治理框架。我们将深入探讨如何利用区块链、可验证计算等前沿技术,构建一条不可篡改、可追溯、可验证的数字证据链,并在此基础上,展望“算法仲裁庭”与新型保险机制如何为这条脆弱的责任链提供制度性保障。

一、❖ “算法责任”的困境:一条断裂的证据链

AI系统的决策过程,本质上是一个漫长的数据传递与转换过程。当最终结果出现偏差时,回溯这条链路并定位根本原因,是确定责任的前提。但在现实中,这条证据链往往是断裂的。

1.1 传统法律框架的失效

传统侵权责任法或产品责任法,通常需要满足三个核心要件:产品存在缺陷、损害事实发生、缺陷与损害之间存在因果关系。这套逻辑在处理AI责任时,遇到了根本性的障碍。

-

“缺陷”难以定义。AI模型的“缺陷”是什么?是算法设计本身有漏洞,还是训练数据有偏见?一个在99.99%的情况下都表现优异的模型,在0.01%的极端场景下犯错,这算不算“缺陷”?这种概率性的、非确定性的“缺陷”,与传统工业品中明确的物理或设计缺陷,存在本质区别。

-

因果关系难以证明。AI的决策是一个“黑箱”。即使我们知道输入的数据和输出的结果,中间复杂的、非线性的计算过程也常常无法被人类完全理解。要清晰地证明是某一批RDA中的某个标注错误,通过复杂的模型训练,最终导致了特定场景下的决策失误,这种跨越多个主体、横跨数月甚至数年的因果链举证,在技术和法律上都近乎不可能。

-

责任主体难以锁定。一个自动驾驶AI系统,其背后是庞大的产业协作网络。

参与主体

扮演角色

潜在责任点

数据提供方

提供原始或标注后的RDA

数据不真实、标注错误、存在偏见、侵犯隐私

模型开发者

设计、训练并优化AI算法模型

算法设计缺陷、模型泛化能力不足、过拟合

系统集成商

将AI模型集成到具体产品中(如汽车)

集成过程中的软硬件兼容性问题、安全冗余不足

产品制造商

生产并销售最终产品

整车硬件故障、未尽到充分的告知和培训义务

终端用户/所有者

使用和操作产品

未按规定操作、未及时接管、数据上传授权

这张表格清晰地展示了责任主体的多元化。当事故发生时,这些主体往往会相互推诿,形成一个难以解开的责任僵局。

1.2 RDA的引入:责任链的指数级复杂化

RDA作为驱动AI模型迭代的核心“燃料”,其资产化和市场化流转,进一步加剧了责任认定的复杂性。一个高性能的AI模型,其训练数据可能来自成百上千个不同的提供方。

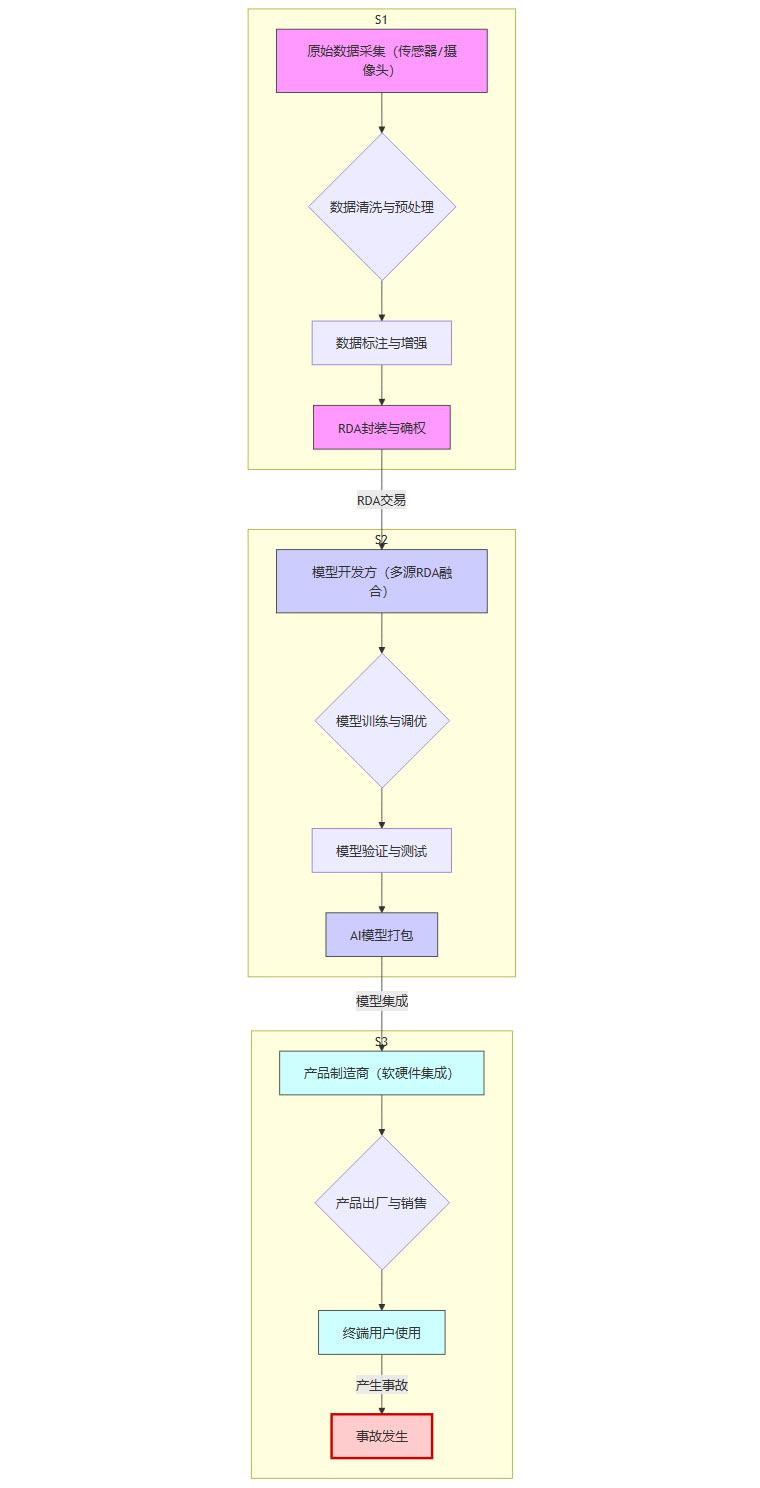

我们可以用一个流程图来描绘这条被RDA拉长的责任链。

从上图可见,从最初的原始数据采集(A)到最终的事故发生(L),中间经历了至少10个关键环节,涉及至少三个不同类型的责任域。任何一个环节的微小瑕疵,都可能被后续环节放大,最终酿成事故。例如,数据标注环节(C)的一个系统性偏差,可能在模型训练(F)中被学习并固化,最终在终端用户使用(K)时暴露出来。

1.3 举证的“不可能三角”

在司法实践中,试图厘清AI责任的尝试,往往会陷入一个由技术、法律和商业共同构成的“不可能三角”。

-

技术黑箱(Technical Opacity):深度学习模型的内部决策逻辑极其复杂,难以用人类语言进行解释。我们无法像审查传统代码一样,通过逻辑审计来定位错误。

-

主体分散(Subject Dispersion):如前所述,责任链条上的参与者众多,且可能跨越国界,各自的法律义务和数据标准不一,导致证据收集和责任分配的协调成本极高。

-

商业机密(Commercial Confidentiality):AI模型和训练数据集是开发者的核心商业机密。在诉讼中,要求企业完全公开其模型权重、训练数据和算法细节,既不现实,也可能损害其市场竞争力。

这三个角相互掣肘,使得任何一方都难以提供完整、有效的证据来支持自己的主张或反驳对方的指控。这正是我们需要技术手段来打破僵局的根本原因。

二、❖ 技术破局:构建可信的数字证据基础设施

法律的滞后性是客观存在的。与其等待一部完美的“AI责任法”出台,不如从技术架构入手,设计一套能够让责任“可追溯”、“可验证”的基础设施。这套设施的核心,是区块链与可验证计算的结合。

2.1 全链路数据溯源:从“数据血缘”到“数据履历”

要追责,首先要知道“谁,在何时,用什么数据,做了什么事”。**“数据血缘”(Data Provenance)**就是解决这个问题的关键。它记录了数据从诞生到消亡的全生命周期轨迹。而区块链技术,则为这份“血缘”记录提供了一个不可篡改、可信的载体。

2.1.1 区块链的角色:不可篡改的分布式账本

区块链在这里的作用并非发行加密货币,而是作为一个高可信度的“数字公证人”。

-

哈希锁定:链上的每一条记录,无论是RDA的元数据、数据处理操作,还是模型训练的日志,都会被计算成一个唯一的哈希值(如同数字指纹)。后一个区块会包含前一个区块的哈希值,形成一个环环相扣的链条。任何对历史记录的微小改动,都会导致后续所有区块的哈希值发生变化,从而被系统立即发现。

-

时间戳:每个区块都带有一个可信的时间戳,精确记录了事件发生的时间顺序,为确定因果关系提供了时序证据。

-

分布式共识:账本由多个节点共同维护,单个参与方无法单方面篡改数据。这保证了记录的公正性和抗审查性。

通过区块链,我们可以为每一份RDA、每一个AI模型,都创建一份不可篡改、全流程可追溯的“数据履历”。

2.1.2 “数据血缘”的实现机制

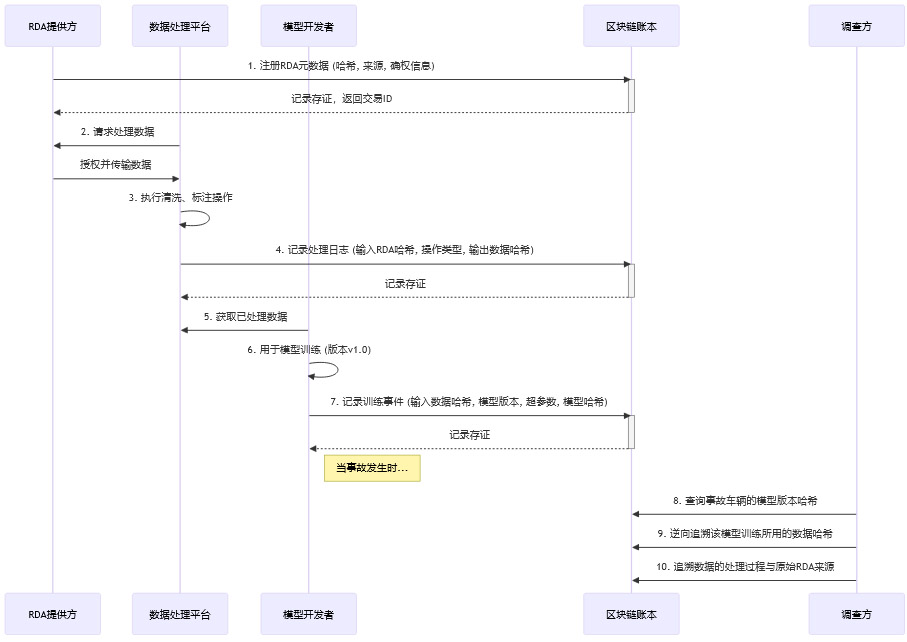

一个典型的基于区块链的数据血缘追溯系统,其工作流程如下:

这个流程清晰地展示了如何从一个最终的模型,层层回溯到其所依赖的每一份原始数据,以及中间经历的每一次处理。事故调查不再是“口说无凭”,而是有链上铁证可查。

2.1.3 实践案例:EDR数据与模型元数据上链

在自动驾驶场景中,我们可以将车辆的“事件数据记录器”(EDR,俗称汽车黑匣子)数据与AI决策过程进行绑定存证。

-

行驶中:车辆的AI系统在做出每一次关键决策(如紧急制动、变道)时,可以实时将关键的输入数据(如传感器融合后的场景数据哈希)、使用的模型版本号、决策输出结果等核心元数据打包,通过轻量级节点发送到区块链进行存证。

-

事故后:调查人员可以提取EDR中记录的物理数据(车速、方向盘转角等),并与链上记录的AI决策元数据进行交叉比对。如果两者在时间戳上能够对应,且数据哈希一致,就形成了一条完整的证据闭环,可以精确还原事故发生前几秒钟,AI系统“看到”了什么,“想”了什么,以及“做”了什么。

这极大地降低了事故认定的争议空间,让技术分析回归到客观数据本身。

2.2 可验证计算:打开“AI黑箱”的一扇窗

数据溯源解决了“用了什么数据”的问题,但还有一个更深层次的难题:“AI的计算过程本身是否可信?”模型是否被篡改?是否存在未被发现的后门?或者,模型是否产生了所谓的“幻觉”(Hallucination),给出了一个逻辑上不成立的随机结果?

可验证计算(Verifiable Computation),特别是**零知识证明(Zero-Knowledge Proof, ZKP)**技术,为回答这些问题提供了强有力的工具。

2.2.1 零知识证明(ZKP)的核心价值

ZKP允许一方(证明者,Prover)向另一方(验证者,Verifier)证明一个论断是正确的,而无需透露除了“该论断是正确的”之外的任何额外信息。

在AI责任场景中,它的核心价值在于:

在不泄露模型权重、训练数据等商业机密的前提下,向监管或司法机构证明AI的某次决策,确实是由某个经过备案的、未经篡改的模型,基于特定的输入数据,通过合规的计算过程得出的。

这相当于为AI的每一次决策都附上了一份由密码学保证的“计算过程公证书”。

2.2.2 ZKP在AI决策中的应用流程

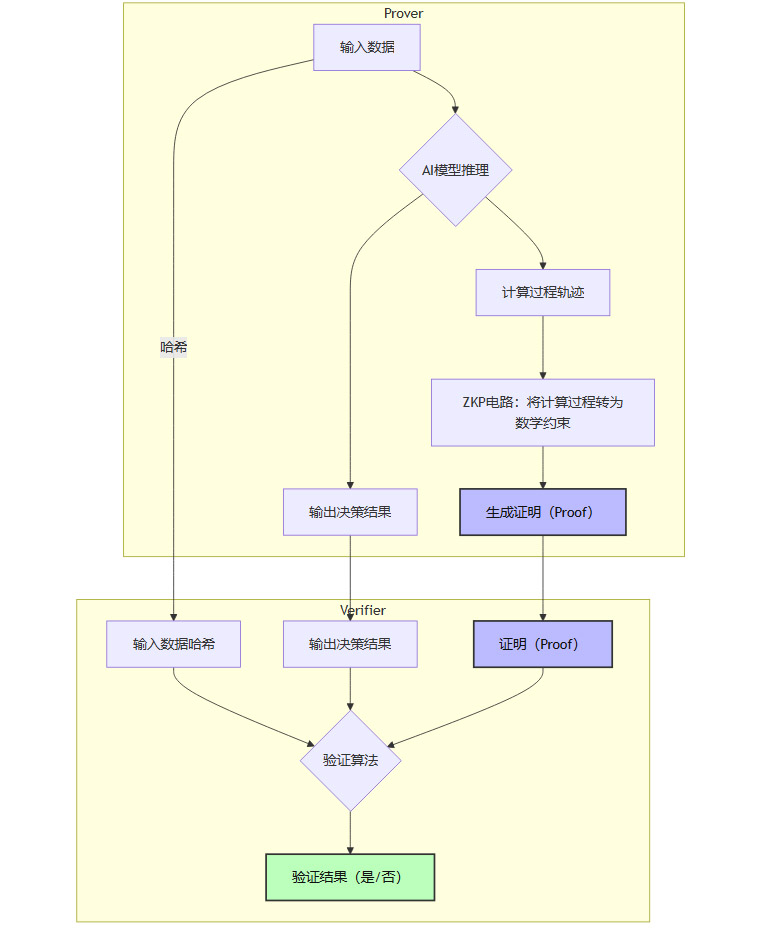

将ZKP应用于AI推理(Inference)过程,通常涉及以下步骤:

-

电路转换:首先,需要将AI模型的计算逻辑(至少是关键部分)转换成一个ZKP电路。这是一个复杂的工程,需要将神经网络的乘法、加法等运算,翻译成ZKP系统能够理解的代数约束。

-

证明生成:当AI模型进行一次推理时,除了生成决策结果,还会将计算的中间步骤作为“证据”(witness)输入到ZKP电路中,生成一个非常简短的证明(Proof)。

-

证明验证:验证方(如仲裁庭的技术专家)无需重新运行整个复杂的AI模型。他们只需要拿到公开的输入数据哈希、决策结果和那个简短的证明,通过一个非常快速的验证算法,就能在毫秒级别内确认这次计算过程的完整性和正确性。

通过这种方式,“AI黑箱”在保持其机密性的同时,其行为的确定性与合规性变得可以被外部验证。这就有效解决了前文提到的“技术黑箱”与“商业机密”之间的矛盾。

2.2.3 ZKP与区块链的协同

ZKP与区块链是天作之合。

-

区块链记录了“存在性”证据:某份数据在某个时间点存在,某个模型被用于决策。

-

ZKP提供了“过程性”证据:这次决策的计算过程是完整且正确的。

当事故发生后,调查方可以从区块链上获取与事故相关的决策记录(包含输入哈希、输出结果和ZKP证明),然后独立进行验证。两者结合,构建了一个从数据源头到计算过程,再到最终结果的全链路、端到端的信任闭环。

(当前字数:4835)

好的,我将继续输出剩余内容。

三、❖ 制度创新:法律与保险的协同演进

技术提供了厘清事实的工具,但最终的责任判定、损失弥补和风险分散,仍然需要法律和商业模式的创新来完成。一个纯粹由技术构建的“理想国”是不存在的,技术必须嵌入到有效的社会制度中才能发挥最大价值。

3.1 争议解决的新范式:“算法仲裁庭”

传统的司法诉讼流程漫长、成本高昂,且法官往往缺乏审理复杂AI案件所需的技术背景。因此,建立一个更专业、更高效的争议解决机制势在必行。

3.1.1 设立背景与必要性

-

专业性要求高:AI责任纠纷的核心,往往是对数据、算法和模型的深度技术剖析。这需要一个由计算机科学家、数据专家、伦理学家和法律专家组成的跨学科团队来进行裁决。

-

效率要求高:技术和商业的迭代速度很快,冗长的诉讼会严重拖累创新。一个能够快速响应、快速裁决的机制,对行业发展至关重要。

-

证据形式新颖:如前文所述,区块链存证、ZKP证明等新型数字证据,需要仲裁机构具备相应的采信标准和技术验证能力。

“算法仲裁庭”正是在这样的需求下应运而生的概念。它是一个专门处理算法和数据相关纠纷的专业机构。

3.1.2 DAO治理模式的探索

更有趣的探索是,这类仲裁庭本身可以采用**去中心化自治组织(DAO)**的形式来运作。

-

专家治理:DAO的成员可以是全球范围内经过认证的技术和法律专家。案件可以根据其技术领域,智能匹配给相应的专家小组进行审理。

-

规则透明:仲裁的规则、专家的投票权重、裁决的逻辑等,都可以通过智能合约的形式编码在区块链上,公开透明,不可篡改。

-

执行自动化:裁决结果可以直接触发智能合约,执行赔偿金的划转等操作,减少了人为干预和执行成本。

一个基于DAO的算法仲裁庭,其工作流程可能如下:

-

案件上链:纠纷双方将案件材料、链上证据ID等提交至DAO平台。

-

专家选举:DAO根据案件标签,随机或通过质押投票的方式,从专家库中选出仲裁员。

-

证据验证与审理:仲裁员独立验证双方提交的链上证据(如ZKP证明),并根据预设的仲裁规则进行在线辩论和投票。

-

裁决生成与执行:智能合约根据投票结果自动生成裁决,并执行相应的资产处置。

这种模式将技术治理与法律裁决深度融合,可能是最适应数字时代争议解决的新范式。

3.1.3 技术证据的采信

无论仲裁庭以何种形式存在,其核心都在于对新型技术证据的采信。这方面,现实世界的司法系统已经迈出了第一步。例如,中国的北京、杭州等地的互联网法院,早已在实践中承认区块链存证的法律效力。这为“算法仲裁庭”采信更复杂的技术证据(如ZKP)铺平了道路,标志着法律正在从“信任人”向“信任机器、信任代码”的范式转变。

3.2 风险分担的商业闭环:数据资产与AI责任保险

即使责任能够被清晰界定,高昂的赔偿也可能让创新型的小公司或个人开发者破产。保险,作为社会风险管理的基础工具,必须在AI时代扮演更重要的角色。

3.2.1 保险产品的分层设计

针对AI责任链条上的不同主体,需要设计精细化的、分层的保险产品。

|

保险类型 |

投保对象 |

核心承保风险 |

理赔关键依据 |

|---|---|---|---|

|

数据资产质量保险 |

RDA提供方、数据标注公司 |

因数据不准确、存在偏见或标注错误,导致AI模型决策失误而引发的第三方索赔。 |

区块链上的“数据血缘”记录,证明事故模型确实使用了该批次数据。 |

|

AI模型责任保险 |

AI算法开发者、模型提供商 |

因模型设计缺陷、泛化能力不足或“算法歧视”等问题,造成的直接或间接损失。 |

模型的版本控制记录、训练日志、以及证明模型输出与预期行为偏差的测试报告。 |

|

自动驾驶系统综合险 |

汽车制造商、系统集成商 |

覆盖从硬件故障到软件缺陷,再到人机交互失误的全场景风险。这是对前两者保险的补充和整合。 |

车辆EDR数据、链上AI决策元数据、ZKP计算过程证明。 |

|

用户操作与接管责任险 |

终端用户/车主 |

在需要人类接管的场景下,因用户未能及时、正确地接管控制权而导致的事故责任。 |

车辆内部的驾驶员监控系统(DMS)数据,以及系统发出接管请求的时间戳记录。 |

这种分层设计,将一个巨大的、模糊的风险,拆解成了多个小的、清晰的风险单元,使得每个参与方都能为其可控范围内的风险购买保险,实现了精准的风险转移。

3.2.2 技术驱动的保险创新

前文讨论的技术基础设施,同样能深刻地改变保险行业的运作模式。

-

动态保费定价:保险公司可以基于链上可信的AI运行数据(如自动驾驶里程、平均接管次数、运行环境复杂度等),对保费进行动态、实时的调整。表现更安全的系统和驾驶员,可以享受更低的保费。

-

秒级理赔认证:事故发生后,智能合约可以自动从区块链和车辆EDR中拉取可信数据,验证是否满足理赔条件。一旦满足,赔付款可以自动划转,将理赔周期从数周缩短到数分钟。

-

承保前置审查:保险公司可以要求投保的AI系统必须接入指定的技术溯源和验证平台,确保其开发和运行过程符合承保标准。这从源头上降低了风险。

通过这种方式,保险不再是事故发生后的被动补偿,而是深度嵌入到风险产生全过程的主动管理工具。

四、❖ 治理框架:构建多方协同的权责体系

技术和制度的最终落地,需要转化为清晰的、可执行的治理规则。这需要责任链上的所有参与方共同努力,通过合同约定和行业标准,构建一个协同的权责体系。

4.1 RDA提供方的合规义务

-

来源合规:确保数据的采集和使用获得了充分的授权,符合隐私保护法规(如GDPR、个人信息保护法)。

-

版本管理:对数据集的每一个版本、每一次清洗和标注操作,都进行清晰的版本控制,并记录上链。

-

质量声明:在提供数据时,附带一份详细的“数据说明书”,清晰描述数据的分布、潜在偏见、标注标准和适用场景。

-

撤回与召回机制:一旦发现数据存在严重瑕疵,应有机制能够及时通知所有下游使用者,并触发模型的更新或召回。

4.2 AI开发与集成方的技术责任

-

可验证训练:在模型训练的每个阶段,都应记录关键日志并上链,确保训练过程的可复现和可审计。

-

数据留痕:清晰记录每个模型版本所使用的所有RDA来源及其版本号,建立模型与数据之间牢固的“血缘关系”。

-

风险披露:在交付模型或产品时,必须明确告知其能力的边界、运行设计域(ODD)以及在极端场景下可能出现的失效模式。

-

保险配置:强制或鼓励开发者和集成方为其产品购买相应的AI责任保险。

4.3 终端用户与运营商的权责边界

-

理解运行域(ODD):用户必须被充分告知并理解,自动驾驶等AI系统只能在特定的条件(如天气、路况、地理围栏)下安全运行。

-

履行接管义务:对于非完全自动驾驶系统(L2-L4),用户有明确的责任和义务,在系统发出请求或明显超出能力范围时,立即接管车辆控制。

-

数据授权与取证:用户在使用产品前,应通过合同明确授权,在发生事故时,允许制造商或调查机构访问必要的车辆数据用于责任认定。

结论

“AI犯错”带来的责任困境,并非一个单一的技术问题或法律问题,而是一个复杂的系统性挑战。试图用一把钥匙打开所有的锁,注定会失败。

破局之道在于构建一个**“技术-法律-保险”三位一体的协同治理模式**。

-

以技术为基石:通过区块链和零知识证明等技术,打造一个可信的数字证据基础设施。这让“追责”从一个充满争议的社会学问题,回归为一个有据可查的技术问题。

-

以法律为准绳:在技术证据的基础上,建立专业的、高效的争议解决机制,如“算法仲裁庭”。这确保了责任能够被公正、快速地判定。

-

以保险为保障:通过分层的、与技术深度绑定的保险产品,为责任链上的所有参与方提供风险分散和损失补偿的工具。这让创新者敢于探索,让使用者敢于信任。

这条道路不会一帆风顺,它需要跨领域的协作、持续的技术投入和渐进的制度演化。但这是我们在享受AI技术带来巨大便利的同时,维系社会公正、平衡创新与责任的唯一可行路径。我们正在塑造的,不仅是下一代的技术架构,更是未来数字社会的信任基石。

📢💻 【省心锐评】

AI责任的本质是信任的重构。抛弃单一归责的旧思维,拥抱“技术可证+法律专审+保险兜底”的组合拳,才是通往人机和谐共存未来的务实路线图。

更多推荐

已为社区贡献280条内容

已为社区贡献280条内容

所有评论(0)