开发大模型or使用大模型?

然而,面对这一浪潮,许多组织和个人陷入一个关键抉择:是自行开发大模型,还是直接使用现有的大模型服务?接下来,我们将分步解析:首先剖析开发大模型的细节,然后探讨使用大模型的模式,接着进行系统比较,最后展望未来趋势。其中 $L$ 是损失函数,$y_i$ 为真实值,$\hat{y}_i$ 为预测值,$\lambda$ 是正则化系数,$\theta$ 表示模型参数。作为普通人,入局大模型时代需要持续学习和

引言

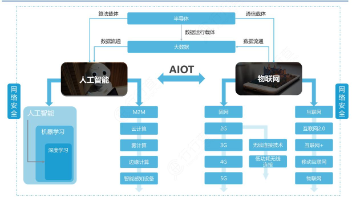

在人工智能(AI)飞速发展的时代,大型语言模型(如GPT系列、BERT等)已成为推动技术创新的核心引擎。这些模型通过海量数据训练,展现出惊人的语言理解、生成和推理能力,广泛应用于医疗、教育、金融和娱乐等领域。然而,面对这一浪潮,许多组织和个人陷入一个关键抉择:是自行开发大模型,还是直接使用现有的大模型服务?这个决策不仅关乎成本和时间,更涉及技术自主性、风险控制和长期战略。本文旨在深入探讨这一议题,帮助读者基于自身需求做出明智选择。我们将从开发和使用两个维度出发,分析各自的优势、劣势、适用场景和潜在挑战,并结合实际案例提供实用建议。通过逐步拆解问题,读者将能清晰评估资源、目标和风险,最终找到最优路径。

开发大模型指的是从零开始构建和训练一个大型AI模型,涉及数据收集、算法设计、模型训练和部署全过程;而使用大模型则意味着通过API接口、开源模型或云平台直接调用预训练好的模型服务。两者看似对立,实则互补。理解其本质差异,是决策的第一步。接下来,我们将分步解析:首先剖析开发大模型的细节,然后探讨使用大模型的模式,接着进行系统比较,最后展望未来趋势。文章基于真实行业实践,确保内容可靠,避免空洞理论。

第一部分:开发大模型——自主创新的双刃剑

开发大模型是一个资源密集型过程,需要深厚的专业知识、庞大计算能力和长期投入。它适合追求高度定制化和技术领先的组织,但门槛极高。本节将逐步拆解开发过程,揭示其内在逻辑。

1.1 开发过程的核心步骤

开发大模型始于数据准备:收集高质量、多样化的数据集是关键。例如,训练一个中文语言模型可能需要数十TB的文本数据,涵盖新闻、社交媒体和学术文献。数据清洗和预处理耗时巨大,需处理噪声和偏见。公式化表示,数据质量直接影响模型性能,损失函数常定义为:

$$L = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 + \lambda |\theta|^2$$

其中 $L$ 是损失函数,$y_i$ 为真实值,$\hat{y}_i$ 为预测值,$\lambda$ 是正则化系数,$\theta$ 表示模型参数。

接下来是算法设计和模型架构选择。主流大模型基于Transformer结构,参数规模可达数十亿甚至万亿级。开发团队需优化层数、注意力机制等。例如,多头注意力层可表示为:

$$\text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V$$

其中 $Q$、$K$、$V$ 是查询、键和值矩阵,$d_k$ 为维度。

训练阶段消耗最大:需高性能GPU集群(如NVIDIA A100),训练周期可能数月。能耗惊人,单次训练碳排放相当于数十辆汽车的年排放。部署后,还需持续监控和迭代,如通过A/B测试优化模型。

1.2 优势:控制力与定制化

开发大模型的核心优势在于完全自主权。组织能定制模型以解决特定问题,比如医疗领域开发专用诊断模型,整合患者历史数据。技术上,可调整架构适应低资源环境,或优化推理速度。案例:某研究机构开发了定制化金融风控模型,准确率提升15%,因为它融合了领域知识,避免了通用模型的“黑盒”局限。

此外,知识产权完全自有,避免依赖外部供应商。长期看,技术积累能转化为竞争优势,如OpenAI通过GPT系列引领行业。

1.3 劣势:高成本与高风险

然而,开发过程成本高昂。硬件投入可达数百万美元(如GPU集群),人力需求包括数据科学家、工程师等团队。时间成本同样显著:从立项到部署,往往需1-3年。技术风险不可忽视:训练失败率高,模型可能过拟合或欠拟合,公式化表示为泛化误差:

$$\text{Error} = \text{Bias}^2 + \text{Variance} + \text{Irreducible Error}$$

其中高方差 $(\text{Variance})$ 表示模型对训练数据敏感,易产生不稳定输出。

伦理风险也需警惕:若数据偏见未被清除,模型可能放大社会不公。例如,招聘模型若基于历史数据,可能歧视少数群体。环境成本同样严峻,大模型训练加剧碳足迹。

1.4 适用场景与决策指南

开发大模型最适合资源充足的组织:大型企业(如科技巨头)、政府项目或有独特需求的领域(如国防、机密研究)。决策时,需评估:

- 资源可用性:预算、硬件和人才是否到位?

- 需求特异性:是否需要高度定制(如方言处理)?

- 风险承受力:能否容忍失败和延迟?

若答案肯定,开发是优选。否则,建议转向使用现有模型。

第二部分:使用大模型——高效便捷的捷径

使用大模型通过调用预训练服务,大幅降低门槛。它适合快速部署和成本敏感的场景,但牺牲了部分控制权。本节解析使用模式,帮助读者规避陷阱。

2.1 使用方式与核心机制

使用大模型主要有三种途径:

- API服务:如OpenAI API、Google Cloud AI,通过简单调用获取结果。输入提示词,模型返回生成文本。成本按请求计费,低至每千次几美元。

- 开源模型集成:下载Hugging Face等平台的预训练模型(如LLaMA),本地微调。微调过程可表示为优化目标:

$$\min_{\theta} \sum_{(x,y) \in D_{\text{微调}}} L(f_\theta(x), y)$$

其中 $D_{\text{微调}}$ 是小规模定制数据集,$f_\theta$ 是模型函数。 - 云平台托管:AWS或Azure提供一站式服务,处理部署和扩展。

使用过程简单:用户无需深入算法,只需定义输入输出。例如,客服机器人可通过API快速搭建,响应时间在毫秒级。

2.2 优势:速度与经济性

最大优势是效率:部署周期可缩短至几天,甚至几小时。成本显著降低,初创公司能用少量预算启动AI项目。案例:一家电商公司使用GPT-3 API开发推荐系统,月成本不足千美元,而自行开发需百万投入。

此外,技术门槛低:非技术人员也能通过工具(如ChatGPT插件)集成模型。可靠性和更新由供应商保障,如OpenAI定期优化模型安全性。

2.3 劣势:依赖与局限

然而,使用模式受限于外部因素。模型是“黑盒”,内部逻辑不透明,调试困难。例如,API服务可能因政策变更中断(如区域限制)。定制性有限:微调只能小幅调整,无法彻底改变架构。

数据隐私风险高:用户输入可能被供应商存储或分析。性能不一致:通用模型在专业领域(如法律合同生成)准确率较低,公式化表示为领域适应误差:

$$\text{Domain Gap} = E_{\text{target}}[L] - E_{\text{source}}[L]$$

其中 $E$ 表示期望损失,差距大时需额外处理。

成本虽低,但长期使用可能累积,尤其在高频场景。

2.4 适用场景与决策指南

使用大模型最适合敏捷需求:中小企业、初创团队或个人开发者。决策时,问:

- 时间紧迫性:是否需要立即上线?

- 预算限制:资金是否有限?

- 任务通用性:是否标准任务(如文本摘要)?

若答案为是,使用是理想选择。否则,考虑混合方案。

第三部分:系统比较与场景分析

开发和使用并非互斥,而是频谱的两端。本节通过对比矩阵和场景案例,帮助读者权衡。

3.1 核心维度对比

| 维度 | 开发大模型 | 使用大模型 |

|---|---|---|

| 成本 | 极高:硬件$>10^6$美元,人力密集 | 低:API从$0.001/请求起 |

| 时间 | 长:6-36个月 | 短:<1周 |

| 控制权 | 完全自主 | 有限:依赖供应商 |

| 定制性 | 高:可深度优化 | 低:仅表面微调 |

| 风险 | 技术失败、伦理问题 | 服务中断、隐私泄露 |

| 适用规模 | 大型组织 | 中小型或个人 |

数学上,决策可建模为优化问题:

$$\max_{选择} \text{Utility} = \alpha \cdot \text{Performance} - \beta \cdot \text{Cost} - \gamma \cdot \text{Risk}$$

其中 $\alpha, \beta, \gamma$ 是权重系数,需根据场景设定。

3.2 典型场景案例

- 医疗领域:某医院开发定制模型处理病历分析(开发优势:高精度合规);而诊所使用API快速生成报告(使用优势:低成本)。

- 教育科技:大学开发自适应学习模型(开发:定制学生路径);在线平台集成ChatGPT辅导(使用:快速迭代)。

- 金融风控:银行开发专有模型(开发:防欺诈优化);初创公司用API监控交易(使用:节省资源)。

决策指南:

- 评估需求:是否高度专业化?是则倾向开发。

- 核算资源:预算<10万美元?优先使用。

- 分析风险:若数据敏感,开发更安全。

- 混合策略:例如,使用基础模型,局部开发关键模块。

第四部分:风险、伦理与挑战

无论选择哪条路,都需正视潜在问题。本节讨论共同挑战,提供缓解策略。

4.1 技术与社会风险

- 偏见与公平:模型可能放大数据偏见,如性别歧视。公式化,偏见度量:

$$\text{Bias} = |P(\text{输出}|G=1) - P(\text{输出}|G=0)|$$

其中 $G$ 表示敏感属性(如性别)。开发中需数据审计;使用中选公平认证API。 - 隐私泄露:开发时数据存储风险;使用时API传输隐患。建议加密和匿名化。

- 环境影响:大模型训练高能耗。选择绿色计算(如再生能源GPU集群)。

4.2 经济与安全挑战

- 成本波动:开发受硬件价格影响;使用API费率可能上涨。多元化投资缓冲。

- 安全威胁:模型易受对抗攻击,输入扰动导致错误输出:

$$\min_{\delta} L(f(x + \delta), y_{\text{目标}}) \quad \text{s.t.} |\delta| < \epsilon$$

防御策略:开发时加固模型;使用时加输入过滤。

4.3 伦理框架

建议遵循原则:透明性(公开模型局限)、问责制(明确责任)、包容性(涉及多元群体)。国际标准如EU AI Act可参考。

第五部分:未来趋势与建议

技术演进将重塑决策格局。本节展望趋势,给出行动建议。

5.1 技术趋势

- 模型小型化:如量化压缩,降低开发门槛:参数压缩率 $r = \frac{\text{原始大小}}{\text{压缩后大小}}$,目标 $r > 10$。

- 联邦学习兴起:允许多方协作开发,保护数据隐私。

- AI即服务普及:使用模式更便捷,成本持续下降。

5.2 实用建议

- 短期行动:中小企业优先使用API验证想法;大型组织试点开发核心模块。

- 长期战略:投资人才培养,构建混合生态(如使用基础模型+自定义层)。

- 工具推荐:使用Hugging Face或Google AI;开发用PyTorch/TensorFlow。

5.3 行业预测

到2030年,使用模式将主导80%应用,但开发仍关键于高价值领域。政策监管加强,推动伦理AI。

结论

开发大模型与使用大模型各具优劣,本质是资源、时间和控制权的权衡。开发适合追求卓越和自主的创新者,但需承担高风险;使用则是高效经济的捷径,但受限于外部依赖。在决策时,应逐步评估:明确需求、盘点资源、分析风险,并考虑混合路径。未来,AI民主化将使使用更普及,但核心技术创新仍需开发投入。最终,选择应服务于人类福祉:以负责任的态度,推动AI赋能社会。无论哪条路,目标都是创造更智能、公平的世界。

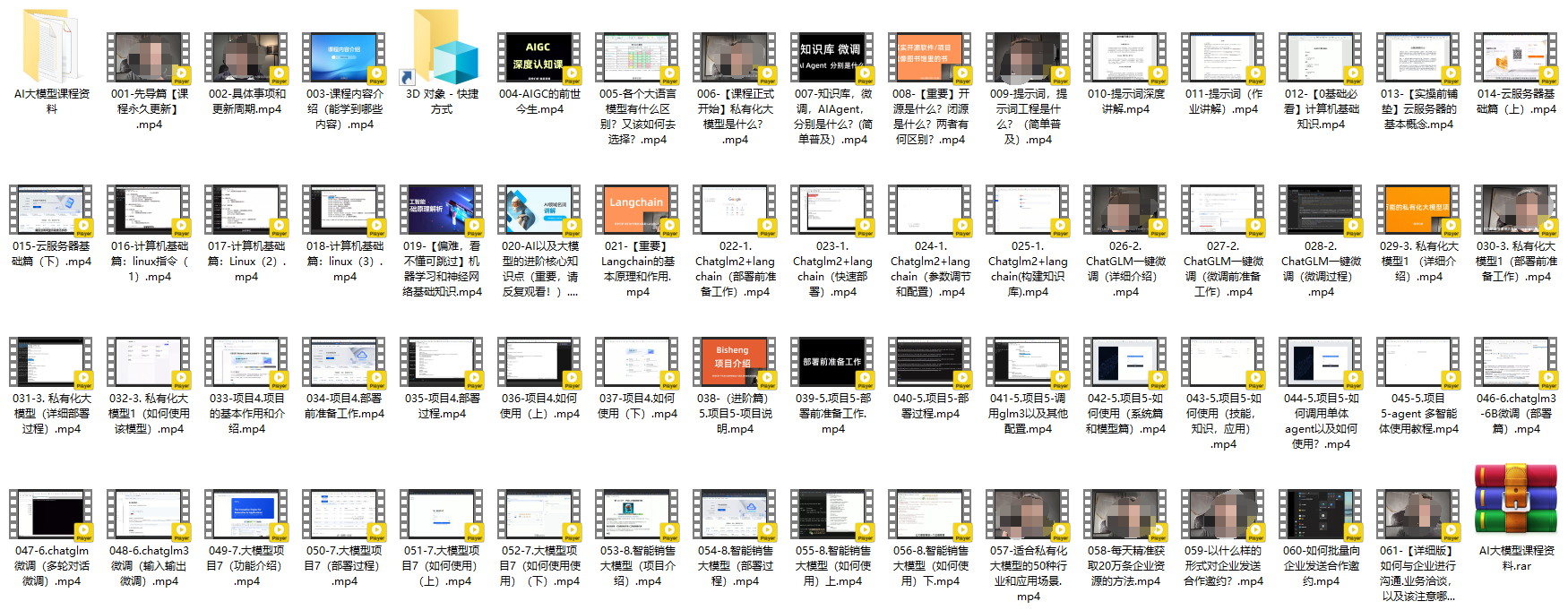

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

- AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

- AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)