ASCERTAIN数据集 情绪 生理信号数据集 下载方式

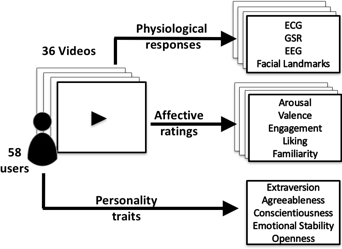

ASCERTAIN是一个用于情感识别的多模态数据库,包含58名受试者观看36个情感诱发影片时的生理反应和面部活动数据。记录内容包括3导联心电图(ECG)、皮电反应(GSR)、单通道干式脑电(EEG)以及面部标志点轨迹(EMO)。实验后受试者需填写大五人格问卷和情感维度评分(唤醒度、愉悦度等)。该数据集采用商用传感器采集,更接近实际应用场景,适用于情感识别、人格-情感关系研究、多模态融合等方向。数据

数据集官网:https://ascertain-dataset.github.io/

数据集下载:https://gitee.com/CodeStoreHub/Emotion-Recognition-Dataset

一、数据集简介

-

ASCERTAIN 是一个多模态数据库,旨在用商业传感器(off-the-shelf sensors)记录人在观看情感诱发影片片段时的生理反应和面部活动,同时获得其人格特质(大五人格)与自我报告的情感状态。

-

数据集由 58 位受试者(37 男、21 女,平均年龄约30岁)参与。

-

每位受试者观看 36 个电影片段(每片段平均约 80 秒,标准差约20秒)作为情感诱发刺激。

-

同步记录的模态包括:

-

生理信号:3通道心电图(ECG)、皮电反应(GSR)、单通道干式脑电(EEG)。

-

面部活动:面部标志点轨迹(EMO)或“Facial landmark trajectories (EMO)”表征面部表情变化。

-

-

在观看影片后,受试者会对每个片段进行自我报告:包括唤醒度 (arousal)、愉悦度 (valence)、参与度 (engagement)、喜好 (liking)、熟悉度 (familiarity)。同时,每位受试者填写了大五人格问卷:外向性 (Extraversion)、宜人性 (Agreeableness)、尽责性 (Conscientiousness)、情绪稳定性/神经质 (Emotional Stability/Neuroticism)、开放性 (Openness)。

二、采集细节与流程

-

受试者:58 人,男女各37/21,平均年龄约30。

-

刺激材料:36 个电影片段,选自此前研究,旨在诱发多样情绪反应。每段平均约80 秒。

-

同步录制:在实验过程中,同时采集 EEG、ECG、GSR、生理质量标注(数据质量)、面部活动。

-

标注与问卷:

-

每个影片片段后,受试者打分 arousal、valence、engagement、liking、familiarity。

-

每位受试者预先填写大五人格指标 + 50 个描述性形容词,用以计算其人格特质得分。

-

-

数据质量评价:对每个模态(ECG, EEG, GSR, EMO 面部活动)都有录制质量的标注。

-

实验环境:使用商业传感器(非医学级高端设备),例如干式 EEG 传感器 (Neuroskype 或类似);意味着数据更贴近实际应用场景而非严格实验室条件。

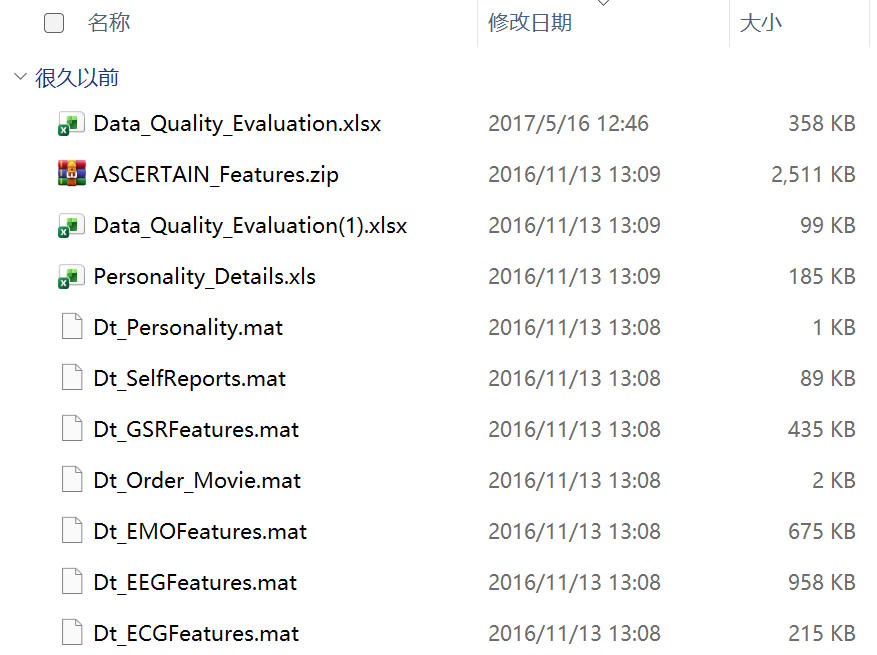

三、数据内容与结构

-

主体维度包括:受试者 × 影片片段 × 多模态信号 × 自评标注。

-

生理信号:

-

ECG:3-通道。

-

GSR:皮电响应。

-

EEG:单通道(或少通道)干式脑电。

-

-

面部活动:面部关键点轨迹 (landmark trajectories) 表示面部表情/活动。

-

问卷/人格:大五人格 + 50 形容词评估 + 每片段的 arousal/valence 等评分。

-

数据质量标注:每模态、每录制片段都有质量评价,以便后续筛选/剔除低质量信号。

四、应用方向与研究价值

-

情感识别 (Affect recognition):通过生理信号/面部活动预测 arousal/valence/engagement 等情感维度。

-

人格与情感关系研究:数据集为人格特质 (Big-5) 与情感反应、生理反应之间的关系分析提供基础。论文中指出:“emotion–personality relationship is better captured by non-linear rather than linear statistics.”

-

多模态融合研究:提供 EEG+ECG+GSR+面部活动数据,为多模态机器学习/深度学习提供实验平台。

-

隐式情感/人格识别:即无需语言文字、自我报告之外,通过生理+面部数据识别个体的情绪和人格。

-

商业/应用传感器可行性:因为使用商业传感器,研究结果更贴近实际可部署的系统。

五、适用范围与局限性

优点

-

多模态同步录制,能支持丰富的融合研究。

-

涉及人格维度 + 情感维度,拓展了情感计算研究的范畴。

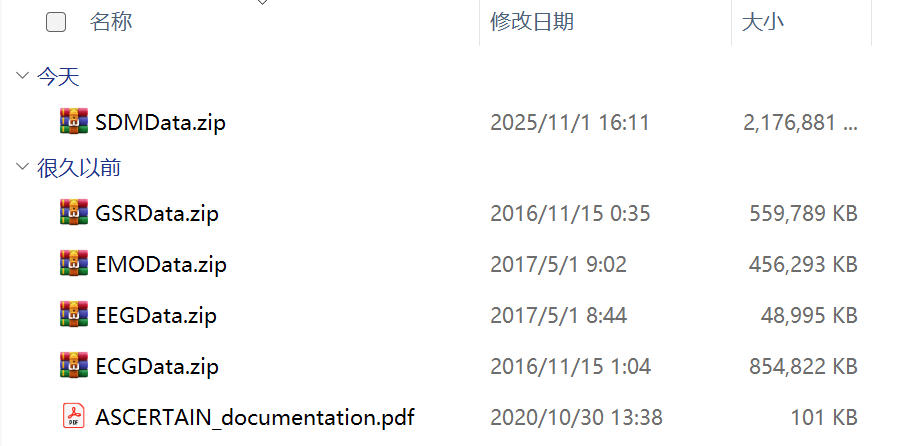

数据集下载:https://gitee.com/CodeStoreHub/Emotion-Recognition-Dataset

数据预览:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)