人工智能大模型入门分享(一)——利用ollama搭建本地大模型服务(DeepSeek-R1)

Ollama支持Windows、macOS和Linux系统。访问Ollama官网下载对应版本的安装包,按照提示完成安装。安装完成后,可通过命令行输入验证是否成功。

大模型技术日益普及,本地化部署成为许多开发者和研究者的需求。Ollama作为一款轻量级工具,支持在本地运行开源大语言模型,提供便捷的交互体验。以下介绍如何利用Ollama搭建本地大模型服务。

安装Ollama

Ollama支持Windows、macOS和Linux系统。访问Ollama官网下载对应版本的安装包,按照提示完成安装。安装完成后,可通过命令行输入ollama --version验证是否成功。

对于Linux用户,可通过curl一键安装:

curl -fsSL https://ollama.ai/install.sh | sh

下载模型

Ollama支持多种开源模型,包括Llama 2、Mistral等。运行以下命令下载DeepSeek-R1模型(以实际支持的模型名为准):

ollama pull deepseek-r1

模型下载进度会显示在终端中,完成后可通过ollama list查看已安装模型。

启动模型服务

使用run命令启动模型交互界面:

ollama run deepseek-r1

启动后会进入对话模式,直接输入问题即可获得模型回复。退出交互模式输入/bye。

高级配置

自定义模型参数

通过修改Modelfile调整参数(如温度、重复惩罚等),示例:

FROM deepseek-r1

PARAMETER temperature 0.7

PARAMETER num_ctx 2048

保存后使用ollama create <自定义名称> -f Modelfile创建定制化模型。

API调用

Ollama默认提供本地API接口(11434端口),可通过HTTP请求调用:

curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1",

"prompt": "解释神经网络原理"

}'

GPU加速

若系统配有NVIDIA GPU,安装CUDA驱动后,Ollama会自动启用GPU加速。可通过nvidia-smi命令确认显存占用情况。

常见问题解决

- 下载中断:使用

ollama pull --insecure跳过SSL验证重试。 - 显存不足:在Modelfile中添加

PARAMETER num_gpu_layers 20减少GPU层数。 - 端口冲突:通过环境变量

OLLAMA_HOST修改监听地址。

应用场景示例

本地知识库问答

结合LangChain等框架,可将模型与本地文档库连接,构建私有知识问答系统。

代码辅助

通过VS Code插件(如Continue)连接Ollama,实现实时代码补全与解释。

自动化脚本

编写Shell脚本调用API,实现批量文本处理或日志分析。

注意:实际部署时需确保硬件资源(尤其是显存)满足模型要求。DeepSeek-R1等模型通常需要16GB以上显存以获得流畅体验。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

- AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

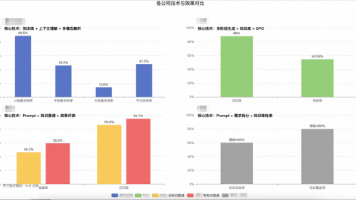

- AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)