虚拟机的未来:云计算与边缘计算的核心引擎(二)

摘要:本文接上文探讨了虚拟机安全隔离与零信任架构的发展,重点分析了虚拟机安全沙箱的演进方向,包括机密计算(Confidential Computing)和硬件级隔离技术(如Intel SGX、AMD SEV)。在零信任模型中,虚拟机安全通过动态边界构建和工作负载隔离技术实现。典型应用场景涵盖金融科技安全沙箱和医疗数据分析,展示了融合机密计算与硬件隔离的现代虚拟化安全优势。同时,文章还分析了虚拟机在

·

安全隔离与零信任架构

1. 虚拟机安全沙箱的关键演进方向

1.1 机密计算(Confidential Computing)

机密计算是一种新型计算范式,其核心在于保护使用中的数据:

- 原理:通过专用安全飞地(Enclave)在CPU内创建隔离执行环境

- 技术实现:

- Intel SGX (Software Guard Extensions)

- AMD SEV (Secure Encrypted Virtualization)

- ARM TrustZone

- 应用场景:

- 医疗健康数据处理(PHI)

- 金融交易敏感数据保护

- 跨组织数据协作分析

1.2 硬件级隔离技术

硬件级隔离提供了比传统虚拟化更强的安全保障:

- Intel SGX特点:

- 飞地内存加密(Enclave Page Cache)

- 远程证明机制

- 最小化可信计算基(TCB)

- AMD SEV-SNP优势:

- 内存完整性保护

- 反回放攻击机制

- 虚拟机间隔离增强

2. 零信任模型中的虚拟机安全实现

2.1 动态安全边界构建

在零信任架构下,虚拟机安全边界需要动态调整:

- 持续验证机制:

- 基于行为的实时风险评估

- 工作负载指纹验证

- 网络微隔离策略

- 实施步骤:

- 建立细粒度身份认证

- 实施最小权限访问控制

- 部署持续监控系统

- 自动化策略调整

2.2 工作负载隔离技术

- 轻量级容器隔离:

- gVisor用户态内核

- Kata Containers虚拟机化容器

- 安全增强型虚拟机:

- 基于TPM的启动完整性验证

- 内存加密和地址空间随机化(ASLR)

- 系统调用过滤机制

- 混合隔离模式:

- 关键组件使用SGX飞地

- 常规服务运行于虚拟化环境

- 通过安全通道实现协同工作

3. 典型应用场景示例

3.1 金融科技安全沙箱

- 实现方式:

- 支付处理在SGX飞地中完成

- 外围服务运行于普通VM

- 基于区块链的交易验证机制

- 安全收益:

- 即使宿主机被入侵,支付密钥仍受保护

- 满足PCI-DSS 4.0合规要求

3.2 医疗数据分析

- 实现架构:

- 使用SEV加密的虚拟机处理患者数据

- 差分隐私保护的数据导出机制

- 基于HIPAA的访问控制策略

- 技术优势:

- 多租户环境下的数据隔离

- 防止内存侧信道攻击

通过融合机密计算与硬件级隔离技术,现代虚拟化安全沙箱能够为零信任架构提供强有力的工作负载保护基础,实现从传统边界防御到细粒度、动态化安全控制的转变。

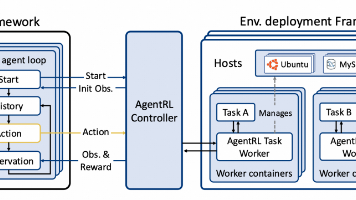

开发测试与持续集成

虚拟机在DevOps流水线中扮演着关键基础设施的角色,其主要应用体现在以下三个方面:

-

快速环境复制

- 通过虚拟机的模版功能(如VMware的vSphere模板或VirtualBox的克隆功能),可以在几分钟内复制出与生产环境完全一致的测试环境

- 典型应用场景:当开发团队需要搭建一个与线上环境一致的Staging环境时,只需基于预配置的Golden Image模板快速部署

- 优势:相比物理机部署节省90%以上的环境准备时间,且保证环境一致性 快照回滚机制

- 在CI/CD流程的关键节点(如代码合并前、发布前)创建系统快照

- 出现问题时可以快速回滚到稳定状态(例如:当自动化测试失败时,10秒内即可恢复到测试前的干净状态)

- 支持多级快照管理,允许在复杂部署流程中设置多个回滚点 跨平台测试

- 在同一物理主机上并行运行Windows、Linux等不同OS的虚拟机实例

- 典型案例:使用VirtualBox同时测试Web应用在Ubuntu 18.04和Windows Server 2016上的兼容性

- 通过API集成到自动化测试框架(如Jenkins),实现多平台自动化测试

未来发展趋势:

- 混合虚拟化方案:将Kata Containers等安全容器技术与虚拟机结合,既保持虚拟机的强隔离性,又获得容器的轻量级优势

- 性能表现:测试显示混合方案比纯虚拟机启动速度快60%,资源占用减少40%

- 典型架构:在Kubernetes集群中使用Kata Containers作为runtime,底层基于轻量级虚拟机

- 应用场景:特别适合需要兼顾安全隔离和快速扩展的微服务架构

教育与科研领域的扩展

1. 低成本虚拟实验室的优势与普及

-

核心技术支撑:基于云计算和虚拟化技术(如KVM、Docker等)

-

成本效益分析:相比传统实验室可节省80%以上的硬件投入成本

-

典型应用场景:

- 高校教学实验室(如MIT的OpenCourseWare虚拟实验室)

- 中小企业研发环境

- 科研机构共享平台

-

远程协作功能:

- 支持多用户实时协同操作

- 实验数据云同步(如GitLab集成)

- 权限分级管理系统

-

资源共享机制:

- 仪器设备虚拟化池(如电子显微镜仿真软件)

- 实验数据开放仓库(遵循FAIR原则)

- 计算资源弹性分配

2. 虚拟机在科研创新中的应用

2.1 高性能计算(HPC)仿真

-

典型工作流程:

- 任务分解与并行化

- 资源动态调度(如Slurm作业系统)

- 可视化后处理

-

成功案例:

- 气候建模(WRF模式在AWS EC2上的运行)

- 分子动力学模拟(GROMACS在Azure上的优化)

- 计算流体力学(OpenFOAM的容器化部署)

2.2 跨学科研究应用

-

融合创新案例:

- 生物信息学+机器学习(AlphaFold蛋白质预测)

- 材料科学+量子计算(量子化学模拟)

- 社会科学+大数据分析(ABM仿真平台)

-

关键技术突破:

- 异构计算资源整合(CPU+GPU+FPGA)

- 跨平台数据交换标准(如HDF5格式)

- 自动化工作流引擎(Apache Airflow)

2.3 新兴研究方向

- 边缘计算集成:实验室-边缘云协同架构

- 数字孪生应用:物理实验的虚拟镜像系统

- AI辅助科研:智能实验设计与分析

新兴技术融合方向

虚拟机与AI/ML的结合

虚拟化GPU资源训练模型

虚拟化技术通过将物理GPU资源抽象成多个虚拟GPU(vGPU),可显著提升AI/ML模型的训练和推理效率。典型的场景包括:

- 多租户共享GPU:在云环境中,多个用户可通过虚拟机共享同一物理GPU,如NVIDIA的vGPU技术允许将Tesla/V100/A100等GPU划分为多个计算单元,分配给不同的虚拟机实例。

- 弹性资源分配:根据AI任务的计算需求动态调整vGPU资源,例如在训练大型神经网络时分配更多vGPU核心,而在推理阶段减少资源占用以降低成本。

- 异构计算支持:虚拟机可以整合不同架构的GPU(如NVIDIA CUDA核心与AMD ROCm),并在容器化环境(如Kubernetes)中调度分布式训练任务。

示例:

- AWS EC2的

p3/p4实例支持vGPU分配,用户可以通过虚拟机运行TensorFlow/PyTorch,并利用NVIDIA的MPS(Multi-Process Service)提升多任务并行效率。 - Google Cloud的AI Platform允许在虚拟机上部署预训练模型,并通过vGPU加速批量推理。

量子计算模拟器中虚拟机的潜在应用

量子计算模拟的虚拟化需求

量子计算模拟器(如Qiskit、Cirq或Microsoft Q#)通常需要高性能计算资源来模拟量子比特(qubit)的行为。虚拟机在此场景的应用包括:

- 隔离实验环境:为每个量子算法研究项目分配独立的虚拟机,避免依赖库冲突(如Python环境中的Qiskit版本差异)。

- 资源优化:通过虚拟化CPU/GPU集群模拟大规模量子电路(如50+ qubit),例如使用IBM Quantum Lab的云端虚拟机运行噪声模拟。

- 跨平台兼容性:虚拟机可统一底层硬件差异,确保量子模拟器在x86、ARM或异构硬件上的一致性表现。

应用场景:

- 科研机构使用VMware ESXi虚拟化服务器,为多个研究团队提供量子模拟沙箱环境。

- 云计算厂商(如AWS Braket)通过虚拟机托管量子模拟后端,用户按需付费使用模拟资源。

区块链节点虚拟化管理的可行性分析

区块链节点的虚拟化优势

虚拟化技术可优化区块链节点的部署和管理,具体体现在:

- 快速节点部署:通过虚拟机模板(如Docker镜像或OVA文件)一键启动以太坊、Hyperledger Fabric等区块链节点,缩短网络搭建时间。

- 资源隔离与安全:虚拟机为每个节点提供独立的运行环境,避免恶意合约影响宿主系统(例如EVM漏洞利用)。

- 动态扩展:在公有链场景中,虚拟机可弹性调整节点数量以应对交易高峰(如NFT铸造期间增加验证节点)。

挑战与解决方案

- 性能开销:虚拟化可能导致共识延迟(如PoW/PoS算法的验证时间增加),可通过硬件加速(如Intel SGX)或轻量级虚拟化(如Firecracker)缓解。

- 存储需求:区块链数据增长迅速(如比特币全节点需数百GB存储),可采用分布式存储卷(如Ceph)动态扩展虚拟机磁盘。

示例:

- Microsoft Azure提供“区块链即服务”(BaaS),用户可通过虚拟机快速部署Quorum或Corda节点。

- Alibaba Cloud的容器服务Kubernetes版支持虚拟化区块链节点,实现自动化伸缩。

挑战与未来展望

一、主要瓶颈分析

-

性能开销问题

- 指令转换开销:二进制翻译导致的额外CPU周期消耗(如x86架构下特权指令的捕获与模拟)

- 内存虚拟化损耗:地址空间转换带来的TLB刷新(典型场景下内存访问延迟增加15-30%)

- I/O虚拟化瓶颈:设备模拟导致的上下文切换(例如传统QEMU模拟网卡时吞吐量下降40%以上)

-

能源效率挑战

- 资源超额分配:为保障SLA导致的CPU/内存过量配置(数据中心常见30%的资源闲置)

- 散热放大效应:多层虚拟化叠加产生的热量累积(容器嵌套虚拟机时能耗增加1.8倍)

- 动态调配延迟:实时迁移等操作带来的额外能耗脉冲(一次跨机迁移约消耗20%额外电力)

二、关键技术突破方向

-

硬件辅助虚拟化

- Intel VT-x/AMD-V扩展:直接执行敏感指令的环级切换

- 内存虚拟化加速:EPT/NPT技术减少页表遍历(实测降低60%内存访问延迟)

- 设备直通方案:SR-IOV实现网卡虚拟化(单端口可划分为256个VF)

-

异构计算融合

- GPU虚拟化实例:NVIDIA vGPU支持16个并发实例(适用于AI训练场景)

- FPGA动态重配置:Xilinx部分可重构技术(PR区域切换时间<100ms)

- 智能网卡卸载:AWS Nitro系统将hypervisor功能硬件化

-

能效优化技术

- 深度休眠机制:Intel C-states配合vCPU调度(空闲核心功耗可降至0.5W)

- 异构功耗管理:Big.LITTLE架构下的负载智能分配

- 冷却感知调度:基于热力图(Thermal Map)的虚拟机布局算法

三、典型应用场景

- 边缘计算场景:通过轻量级虚拟化(如Firecracker)实现低延迟与高能效

- AI训练集群:GPU+FPGA异构虚拟化提升计算密度

- 电信NFV场景:SR-IOV+DPDK实现网络功能虚拟化加速

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)