一图读懂 Dify 架构:AI 原生应用开发的底层逻辑全拆解

·

摘要

AI 原生应用平台将大语言模型、检索增强生成、插件生态与可视化编排融合为一体,成为企业智能化的基石。本文以 Dify 架构为例,从设计原则、核心模块、执行引擎、落地场景到工程实践与演进方向,做全面且可操作的拆解。文中包含直观流程图、对比表格与实施建议,帮助产品经理、架构师与开发者在实践中快速落地 AI 原生应用。

关键字

AI原生应用;Dify架构;任务编排;RAG;插件系统

平台为什么要重构架构

AI 原生应用并不是把模型塞进旧有系统那么简单。要真正发挥 LLM 的价值,平台需要解决三大基本问题:

- 上下文管理:长对话、流程化任务与外部知识共同构成复杂上下文,需要一致的状态管理与检索机制。

- 工具与外部系统集成:业务逻辑常需要调用数据库、搜索、API、第三方服务,平台需把这些工具变成可安全调用的“插件”。

- 可编排性与可观测性:业务往往是多步骤、多分支的工作流,平台需提供可视化编排与执行可观测能力,便于研发与产品协同。

Dify 的设计目标就是在上述三点上给出一套工程化、可扩展且业务友好的解决方案。

Dify 的架构全景图

下面用一张流程化的架构图展示 Dify 的核心模块与数据流,让整体结构一目了然。

设计原则与工程考量

设计原则

- 模块化解耦:模型、检索、插件与编排模块互相独立,通过统一接口通信。

- 弱耦合强契约:所有外部调用通过明确的 Schema 与能力契约暴露,便于自动化校验与依赖管理。

- 有状态与无状态共存:支持请求级无状态推理与会话/流程级有状态存储。

- 可观测与可恢复:每次任务具备完整的事件与状态链路,支持节点重试与回滚。

- 多模型多来源:并行接入公有云模型、自研模型及私有化模型,动态路由与熔断策略支持。

工程考量

- 可扩展性:按需扩展模型池、节点执行器和插件运行环境。

- 安全性:插件隔离、参数白名单、租户数据隔离与审计链路。

- 成本控制:推理层支持缓存/对齐策略,检索层采用分层冷热数据策略。

- 开发体验:可视化编排与模拟调试,降低业务团队上手门槛。

核心模块逐一拆解

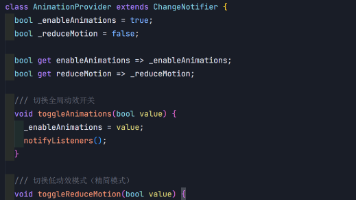

模型适配器

- 作用:抽象不同模型厂商的 API,提供统一的 completion、embedding、rank 等能力接口。

- 要点:支持模型版本管理、负载均衡、调用超时与并发限制。

- 工程实践:使用策略模式实现多模型路由;在适配器层实现 prompt 模板管理与安全过滤。

检索增强生成 RAG

- 作用:通过向量检索将外部知识注入模型上下文,提升回答准确性与可解释性。

- 要点:向量索引构建策略、召回融合策略、上下文截断与摘要策略。

- 工程实践:分层索引:近期会话与长期知识分别存储;检索结果加入来源元信息便于溯源。

插件系统

- 作用:将外部能力(数据库查询、订单处理、搜索、浏览器抓取等)封装为可调用工具。

- 要点:插件需要明确输入输出 Schema;支持 function call 的自动映射与权限校验。

- 工程实践:插件托管在独立沙箱,插件调用走网关并记录审计日志;提供插件商店与版本管理。

工作流编排引擎 GraphEngine

- 作用:把业务流程抽象为 DAG 节点,按拓扑执行,支持条件分支、循环、并行与重试。

- 要点:事件驱动执行、节点状态持久化、节点重入与异常处理、模拟调试器。

- 工程实践:引擎提供可视化编辑器、节点模板库与运行时监控面板;支持脚本节点与自定义节点扩展。

状态管理与持久化

- 策略:短期会话使用内存或 Redis,长期任务与审计日志使用 Postgres 或专用持久层。

- 要点:状态序列化标准化;对敏感数据加密存储;租户隔离实现方式可选共享表字段或独立 schema。

- 工程实践:实现基于事件溯源的状态回放能力,便于调试历史执行流程。

执行引擎工作流详解

下面以一个典型场景“客户问题自动处理并记录工单”为例,展示执行流程与节点交互。

关键能力点

- 意图解析节点:快速判断是否需要插件或知识检索,减少不必要的模型调用。

- 分支与并行:在检查多个信息源时并行发起查询,合并结果后再调用 LLM 进行整合。

- 回写能力:插件执行结果可写回外部系统,形成闭环自动化。

- 审计链路:每次插件调用与模型生成均有审计记录,便于合规与追责。

常见使用场景与实践建议

场景一 智能客服与销售助理

- 实现要点:上下文会话记忆、FAQ RAG 强化、订单/用户信息插件调用、会话转人工机制。

- 操作建议:设置问题分类阈值,低置信度转人工;对敏感操作增加二次认证。

场景二 企业知识库与内部问答

- 实现要点:构建定期同步的向量库;结合摘要器将长文档压缩为候选上下文。

- 操作建议:索引时保留来源元信息;针对行业术语做专门 embedding 微调。

场景三 自动化办公与审批流程

- 实现要点:将审批节点抽象为工作流节点,调用审批插件完成状态变更与通知。

- 操作建议:在关键节点加入回退与人工介入选项;为每条审批链路保留完整审计。

场景四 数据分析与报告自动化

- 实现要点:插件集成 SQL 查询与图表生成,LLM 负责自然语言解读与洞察提炼。

- 操作建议:为数据插件配置查询权限与速率限制;结果通过模板化 prompt 保证一致性。

对比视角与可选设计权衡

| 维度 | 方案 A 标准做法 | Dify 风格取舍 | 设计建议 |

|---|---|---|---|

| 模型接入 | 单一厂商绑定 | 多模型统一适配 | 推荐多模型路由与成本感知策略 |

| 状态管理 | 全部写入 DB | 冷热分层(Redis + Postgres) | 会话短期缓存,长任务持久化 |

| 插件执行 | 直接调用 | 沙箱 + 审计 + Schema | 必须的安全隔离与权限校验 |

| 编排方式 | 代码化脚本 | 可视化 DAG + 自定义节点 | 对业务团队友好,保留代码扩展入口 |

| 可观测性 | 基本日志 | 事件链路 + 指标 + 回放 | 强烈建议从设计期开始埋点 |

实施路线图与落地步骤

- 评估业务场景

- 列出需自动化的流程和必需外部系统接口。

- 搭建基础设施

- 部署模型适配层、向量数据库、插件运行沙箱与状态持久化层。

- 设计能力契约

- 为插件与模型接口定义输入输出 Schema 与错误编码。

- 构建核心节点库

- LLM 节点、检索节点、HTTP 节点、插件节点、判断节点等。

- 可视化工作流开发

- 让产品人员能通过拖拽构建并模拟流程。

- 分阶段上线

- 先在非关键路径做 A/B 测试,收集指标后逐步扩容。

- 运维与成本监控

- 推理成本、存储成本与插件调用费用需可视化。

- 安全与合规

- 数据脱敏、访问控制、审计与日志保留策略落地。

常见问题与实践陷阱

- 陷阱一 模型输出不可控

- 建议:加入后处理校验、事实核验节点与低置信度回退策略。

- 陷阱二 上下文爆炸导致成本飙升

- 建议:采用摘要器、检索精细化及上下文窗口管理策略。

- 陷阱三 插件滥用带来安全风险

- 建议:插件仅暴露最小可用能力,调用前做权限与参数白名单校验。

- 陷阱四 编排复杂难维护

- 建议:模块化节点库与良好文档;对复杂流程做分层拆解与单元化测试。

趋势与演进方向

- 意图驱动的自动构建

- 平台将进一步支持通过自然语言描述直接生成工作流与节点组合。

- 自适应执行策略

- 基于运行时指标动态切换模型、缓存与并发参数以节省成本并提升性能。

- 多模态原生支持

- 图像、语音、表格与文本能力在平台层面统一编排与检索。

- 开放插件生态

- 插件市场与第三方能力交换协议将变成平台竞争力核心。

- 可解释性与合规

- 自动生成可审计的决策链与证据汇总,降低法律与合规风险。

项目案例速览 模板化实现示例

| 场景 | 核心节点 | 关键实现要点 |

|---|---|---|

| 智能客服 | 意图识别;知识检索;客服回复;CRM 回写 | 会话记忆 + RAG;插件隔离;转人工阈值 |

| 报表自动化 | 数据查询;图表生成;自然语言摘要 | SQL 插件;可视化模板;结果缓存 |

| 审批流程 | 表单解析;规则判断;审批通知 | 表单 schema 校验;回退机制;审计日志 |

| 市场洞察 | 数据采集;主题分类;趋势生成 | 爬虫插件;向量聚类;结果时间序列化 |

结语

打造一套工程可落地的 AI 原生应用平台,不是把模型接入就完事,而是要把模型、检索、工具与编排作为一个生态来建设。以 Dify 架构为蓝本的设计,强调模块化、可观测与可扩展,为企业把 AI 能力产品化提供了实践路径。落地的关键在于从能力契约、审计与安全这几条红线出发,逐步把复杂业务拆成可组合的节点,交由产品与业务以低门槛方式编排与验证。

附录 引用与参考链接

- Tasking AI GitHub 项目 https://github.com/TaskingAI/TaskingAI.git

- Dify 项目与架构资源 https://github.com/langgenius/dify.git

- 相关技术解析文章 https://mp.weixin.qq.com/s/LufWftgPGaF3lCtjDVZx5A

更多推荐

已为社区贡献193条内容

已为社区贡献193条内容

所有评论(0)