基于深度学习的AI量子计算优化算法设计

随着量子计算技术的快速发展,其在解决复杂问题上展现出了巨大的潜力。然而,量子计算的硬件资源有限,且面临着噪声和误差等问题,需要高效的优化算法来提高其性能。深度学习作为一种强大的机器学习技术,具有强大的非线性建模能力和数据处理能力。本文章的目的是探讨如何将深度学习与量子计算相结合,设计出基于深度学习的AI量子计算优化算法,以提高量子计算的效率和准确性。本文的范围涵盖了从核心概念的介绍、算法原理的讲解

基于深度学习的AI量子计算优化算法设计

关键词:深度学习、AI、量子计算、优化算法、算法设计

摘要:本文聚焦于基于深度学习的AI量子计算优化算法设计。首先介绍了相关背景,包括目的、预期读者等内容。详细阐述了深度学习、量子计算等核心概念及其联系,给出了清晰的文本示意图和Mermaid流程图。深入讲解了核心算法原理,用Python代码进行详细说明,并给出了数学模型和公式。通过项目实战展示了代码实现过程和详细解读。探讨了该算法在不同领域的实际应用场景,推荐了学习资源、开发工具框架以及相关论文著作。最后总结了未来发展趋势与挑战,并提供了常见问题解答和扩展阅读参考资料,旨在为相关领域的研究者和开发者提供全面而深入的技术指导。

1. 背景介绍

1.1 目的和范围

随着量子计算技术的快速发展,其在解决复杂问题上展现出了巨大的潜力。然而,量子计算的硬件资源有限,且面临着噪声和误差等问题,需要高效的优化算法来提高其性能。深度学习作为一种强大的机器学习技术,具有强大的非线性建模能力和数据处理能力。本文章的目的是探讨如何将深度学习与量子计算相结合,设计出基于深度学习的AI量子计算优化算法,以提高量子计算的效率和准确性。

本文的范围涵盖了从核心概念的介绍、算法原理的讲解、数学模型的构建、项目实战的演示到实际应用场景的分析等多个方面。通过对这些内容的详细阐述,帮助读者全面了解基于深度学习的AI量子计算优化算法的设计和实现过程。

1.2 预期读者

本文的预期读者包括对量子计算、深度学习和优化算法感兴趣的科研人员、工程师和学生。对于从事量子计算研究的人员,本文可以提供新的思路和方法来优化量子算法;对于深度学习领域的研究者,本文展示了深度学习在新兴领域的应用;对于学生而言,本文可以作为学习量子计算和深度学习结合的参考资料。

1.3 文档结构概述

本文的文档结构如下:

- 核心概念与联系:介绍深度学习、量子计算等核心概念及其之间的联系,并给出文本示意图和Mermaid流程图。

- 核心算法原理 & 具体操作步骤:详细讲解基于深度学习的AI量子计算优化算法的原理,并使用Python代码进行说明。

- 数学模型和公式 & 详细讲解 & 举例说明:构建算法的数学模型,给出相关公式,并进行详细讲解和举例。

- 项目实战:通过实际案例展示算法的实现过程,包括开发环境搭建、源代码实现和代码解读。

- 实际应用场景:探讨算法在不同领域的实际应用场景。

- 工具和资源推荐:推荐学习资源、开发工具框架和相关论文著作。

- 总结:总结未来发展趋势与挑战。

- 附录:提供常见问题与解答。

- 扩展阅读 & 参考资料:列出扩展阅读的内容和参考资料。

1.4 术语表

1.4.1 核心术语定义

- 深度学习(Deep Learning):一种基于人工神经网络的机器学习技术,通过构建多层神经网络来学习数据的深层次特征和模式。

- 量子计算(Quantum Computing):利用量子力学原理进行计算的新型计算模式,具有强大的并行计算能力。

- 优化算法(Optimization Algorithm):用于寻找最优解的算法,在量子计算中用于优化量子电路和量子态。

- 量子态(Quantum State):量子系统的状态,用波函数来描述。

- 量子门(Quantum Gate):量子计算中的基本操作单元,类似于经典计算中的逻辑门。

1.4.2 相关概念解释

- 神经网络(Neural Network):由大量神经元组成的网络结构,用于模拟人脑的信息处理过程。

- 量子比特(Qubit):量子计算中的基本信息单元,类似于经典计算中的比特。

- 量子纠缠(Quantum Entanglement):量子系统中粒子之间的一种特殊关联状态,具有非局域性和超距作用。

1.4.3 缩略词列表

- DNN(Deep Neural Network):深度神经网络

- QNN(Quantum Neural Network):量子神经网络

- QAOA(Quantum Approximate Optimization Algorithm):量子近似优化算法

2. 核心概念与联系

核心概念原理

深度学习

深度学习是一种基于人工神经网络的机器学习技术。其核心思想是通过构建多层神经网络,让网络自动学习数据的特征和模式。常见的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)和长短时记忆网络(LSTM)等。

以一个简单的全连接神经网络为例,网络由输入层、隐藏层和输出层组成。输入层接收输入数据,隐藏层对输入数据进行非线性变换,输出层输出最终的结果。网络通过反向传播算法来调整神经元之间的连接权重,以最小化预测结果与真实结果之间的误差。

量子计算

量子计算利用量子力学原理进行计算。量子比特(qubit)是量子计算中的基本信息单元,与经典比特不同,量子比特可以处于0和1的叠加态。量子计算的优势在于其强大的并行计算能力,通过量子门对量子比特进行操作,可以同时处理多个计算任务。

例如,一个n个量子比特的量子系统可以同时处于2n2^n2n个状态的叠加态,这使得量子计算在处理某些复杂问题时具有指数级的加速优势。

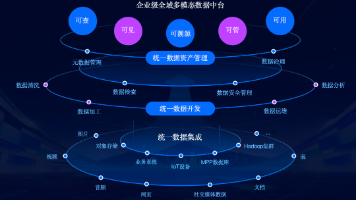

架构的文本示意图

深度学习与量子计算的结合可以通过以下架构实现:

输入数据首先经过深度学习模型进行特征提取和处理,得到的特征信息被用于指导量子计算的优化过程。量子计算模块根据这些特征信息对量子态和量子电路进行优化,得到优化后的量子计算结果。最后,将量子计算结果反馈给深度学习模型,进行进一步的训练和调整。

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

核心算法原理

基于深度学习的AI量子计算优化算法的核心思想是利用深度学习模型来学习量子计算中的优化策略。具体来说,深度学习模型以量子计算的输入数据和当前状态作为输入,输出量子门的操作序列和参数,以实现对量子态和量子电路的优化。

具体操作步骤

- 数据准备:收集量子计算的输入数据,包括量子态的初始信息和目标函数等。

- 深度学习模型构建:选择合适的深度学习模型,如深度神经网络(DNN)或卷积神经网络(CNN),并进行模型的训练。

- 量子计算模拟:使用量子计算模拟器对量子态和量子电路进行模拟,得到当前的量子计算结果。

- 优化策略生成:将量子计算的输入数据和当前状态输入到深度学习模型中,得到量子门的操作序列和参数。

- 量子电路更新:根据深度学习模型输出的操作序列和参数,更新量子电路。

- 重复步骤3 - 5:不断重复上述步骤,直到满足终止条件,如达到最大迭代次数或目标函数收敛。

Python源代码详细阐述

import numpy as np

import tensorflow as tf

# 定义深度学习模型

class QuantumOptimizationModel(tf.keras.Model):

def __init__(self):

super(QuantumOptimizationModel, self).__init__()

self.dense1 = tf.keras.layers.Dense(64, activation='relu')

self.dense2 = tf.keras.layers.Dense(32, activation='relu')

self.output_layer = tf.keras.layers.Dense(10, activation='linear')

def call(self, inputs):

x = self.dense1(inputs)

x = self.dense2(x)

return self.output_layer(x)

# 初始化模型

model = QuantumOptimizationModel()

# 定义损失函数和优化器

loss_fn = tf.keras.losses.MeanSquaredError()

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

# 模拟量子计算输入数据

num_samples = 100

input_data = np.random.randn(num_samples, 20)

target_output = np.random.randn(num_samples, 10)

# 训练模型

epochs = 10

for epoch in range(epochs):

with tf.GradientTape() as tape:

predictions = model(input_data)

loss = loss_fn(target_output, predictions)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

print(f'Epoch {epoch + 1}, Loss: {loss.numpy()}')

在上述代码中,我们首先定义了一个简单的深度神经网络模型QuantumOptimizationModel,用于学习量子计算的优化策略。然后,我们定义了损失函数和优化器,并模拟了量子计算的输入数据和目标输出。最后,我们使用梯度下降法对模型进行训练,不断调整模型的参数,以最小化预测结果与目标输出之间的误差。

4. 数学模型和公式 & 详细讲解 & 举例说明

数学模型

设量子系统的初始状态为∣ψ0⟩\vert\psi_0\rangle∣ψ0⟩,目标状态为∣ψtarget⟩\vert\psi_{target}\rangle∣ψtarget⟩。我们的目标是找到一组量子门操作序列U=U1U2⋯UnU = U_1U_2\cdots U_nU=U1U2⋯Un,使得经过这些操作后,量子系统的状态∣ψ⟩=U∣ψ0⟩\vert\psi\rangle = U\vert\psi_0\rangle∣ψ⟩=U∣ψ0⟩尽可能接近目标状态∣ψtarget⟩\vert\psi_{target}\rangle∣ψtarget⟩。

为了衡量两个量子态之间的接近程度,我们可以使用保真度(Fidelity)的概念,保真度定义为:

F(∣ψ⟩,∣ψtarget⟩)=∣⟨ψ∣ψtarget⟩∣2F(\vert\psi\rangle, \vert\psi_{target}\rangle) = \vert\langle\psi\vert\psi_{target}\rangle\vert^2F(∣ψ⟩,∣ψtarget⟩)=∣⟨ψ∣ψtarget⟩∣2

我们的优化目标是最大化保真度FFF,即:

maxUF(∣ψ⟩,∣ψtarget⟩)=maxU∣⟨ψ0∣U†∣ψtarget⟩∣2\max_{U} F(\vert\psi\rangle, \vert\psi_{target}\rangle) = \max_{U} \vert\langle\psi_0\vert U^{\dagger}\vert\psi_{target}\rangle\vert^2UmaxF(∣ψ⟩,∣ψtarget⟩)=Umax∣⟨ψ0∣U†∣ψtarget⟩∣2

详细讲解

在基于深度学习的AI量子计算优化算法中,深度学习模型的作用是学习如何选择最优的量子门操作序列UUU。深度学习模型以量子系统的初始状态∣ψ0⟩\vert\psi_0\rangle∣ψ0⟩和目标状态∣ψtarget⟩\vert\psi_{target}\rangle∣ψtarget⟩作为输入,输出量子门的操作参数。

具体来说,深度学习模型的输入可以表示为一个向量x=[∣ψ0⟩,∣ψtarget⟩]\mathbf{x} = [\vert\psi_0\rangle, \vert\psi_{target}\rangle]x=[∣ψ0⟩,∣ψtarget⟩],输出可以表示为一个向量y=[θ1,θ2,⋯ ,θm]\mathbf{y} = [\theta_1, \theta_2, \cdots, \theta_m]y=[θ1,θ2,⋯,θm],其中θi\theta_iθi表示第iii个量子门的操作参数。

量子门操作可以表示为幺正矩阵Ui(θi)U_i(\theta_i)Ui(θi),经过一系列量子门操作后,量子系统的状态可以表示为:

∣ψ⟩=Um(θm)Um−1(θm−1)⋯U1(θ1)∣ψ0⟩\vert\psi\rangle = U_m(\theta_m)U_{m - 1}(\theta_{m - 1})\cdots U_1(\theta_1)\vert\psi_0\rangle∣ψ⟩=Um(θm)Um−1(θm−1)⋯U1(θ1)∣ψ0⟩

然后,我们可以计算当前状态∣ψ⟩\vert\psi\rangle∣ψ⟩与目标状态∣ψtarget⟩\vert\psi_{target}\rangle∣ψtarget⟩之间的保真度FFF,并将其作为损失函数来训练深度学习模型。

举例说明

假设我们有一个两量子比特的量子系统,初始状态为∣ψ0⟩=∣00⟩\vert\psi_0\rangle = \vert00\rangle∣ψ0⟩=∣00⟩,目标状态为∣ψtarget⟩=12(∣00⟩+∣11⟩)\vert\psi_{target}\rangle = \frac{1}{\sqrt{2}}(\vert00\rangle + \vert11\rangle)∣ψtarget⟩=21(∣00⟩+∣11⟩)。

我们可以使用单量子比特旋转门Rx(θ)R_x(\theta)Rx(θ)和两量子比特受控非门(CNOT)来构建量子电路。深度学习模型的任务是学习如何选择合适的旋转角度θ\thetaθ,使得经过量子门操作后,量子系统的状态尽可能接近目标状态。

首先,我们可以将初始状态和目标状态表示为向量形式:

∣ψ0⟩=[1000],∣ψtarget⟩=12[1001]\vert\psi_0\rangle = \begin{bmatrix}1\\0\\0\\0\end{bmatrix}, \vert\psi_{target}\rangle = \frac{1}{\sqrt{2}}\begin{bmatrix}1\\0\\0\\1\end{bmatrix}∣ψ0⟩= 1000 ,∣ψtarget⟩=21 1001

然后,我们可以定义单量子比特旋转门Rx(θ)R_x(\theta)Rx(θ)和两量子比特受控非门(CNOT)的矩阵表示:

Rx(θ)=[cos(θ2)−isin(θ2)−isin(θ2)cos(θ2)],CNOT=[1000010000010010]R_x(\theta) = \begin{bmatrix}\cos(\frac{\theta}{2}) & -i\sin(\frac{\theta}{2})\\-i\sin(\frac{\theta}{2}) & \cos(\frac{\theta}{2})\end{bmatrix}, CNOT = \begin{bmatrix}1 & 0 & 0 & 0\\0 & 1 & 0 & 0\\0 & 0 & 0 & 1\\0 & 0 & 1 & 0\end{bmatrix}Rx(θ)=[cos(2θ)−isin(2θ)−isin(2θ)cos(2θ)],CNOT= 1000010000010010

假设我们选择的量子门操作序列为U=CNOT⊗Rx(θ)U = CNOT \otimes R_x(\theta)U=CNOT⊗Rx(θ),则经过量子门操作后,量子系统的状态为:

∣ψ⟩=(CNOT⊗Rx(θ))∣ψ0⟩\vert\psi\rangle = (CNOT \otimes R_x(\theta))\vert\psi_0\rangle∣ψ⟩=(CNOT⊗Rx(θ))∣ψ0⟩

我们可以计算当前状态∣ψ⟩\vert\psi\rangle∣ψ⟩与目标状态∣ψtarget⟩\vert\psi_{target}\rangle∣ψtarget⟩之间的保真度FFF,并使用深度学习模型来调整旋转角度θ\thetaθ,以最大化保真度FFF。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

为了实现基于深度学习的AI量子计算优化算法,我们需要搭建相应的开发环境。以下是具体的搭建步骤:

安装Python

首先,我们需要安装Python。建议使用Python 3.7及以上版本。可以从Python官方网站(https://www.python.org/downloads/)下载并安装Python。

安装深度学习框架

我们选择使用TensorFlow作为深度学习框架。可以使用以下命令安装TensorFlow:

pip install tensorflow

安装量子计算模拟器

为了模拟量子计算,我们可以使用Qiskit作为量子计算模拟器。可以使用以下命令安装Qiskit:

pip install qiskit

5.2 源代码详细实现和代码解读

以下是一个基于深度学习和Qiskit的量子计算优化算法的完整代码示例:

import numpy as np

import tensorflow as tf

from qiskit import QuantumCircuit, Aer, execute

# 定义深度学习模型

class QuantumOptimizationModel(tf.keras.Model):

def __init__(self):

super(QuantumOptimizationModel, self).__init__()

self.dense1 = tf.keras.layers.Dense(64, activation='relu')

self.dense2 = tf.keras.layers.Dense(32, activation='relu')

self.output_layer = tf.keras.layers.Dense(1, activation='tanh')

def call(self, inputs):

x = self.dense1(inputs)

x = self.dense2(x)

return self.output_layer(x)

# 初始化模型

model = QuantumOptimizationModel()

# 定义损失函数和优化器

loss_fn = tf.keras.losses.MeanSquaredError()

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

# 模拟量子计算

def quantum_computation(theta):

# 创建量子电路

circuit = QuantumCircuit(1, 1)

# 应用旋转门

circuit.rx(theta, 0)

# 测量量子比特

circuit.measure(0, 0)

# 使用模拟器运行电路

backend = Aer.get_backend('qasm_simulator')

job = execute(circuit, backend, shots=1000)

result = job.result()

counts = result.get_counts(circuit)

# 计算测量结果的期望值

if '0' in counts:

prob_0 = counts['0'] / 1000

else:

prob_0 = 0

if '1' in counts:

prob_1 = counts['1'] / 1000

else:

prob_1 = 0

expectation = prob_0 - prob_1

return expectation

# 训练模型

epochs = 10

for epoch in range(epochs):

with tf.GradientTape() as tape:

# 生成随机输入

input_data = np.random.randn(1, 10)

# 模型预测

theta_pred = model(input_data)

# 进行量子计算

expectation = quantum_computation(theta_pred.numpy()[0][0])

# 计算损失

target_expectation = 0.5

loss = loss_fn([target_expectation], [expectation])

# 计算梯度

gradients = tape.gradient(loss, model.trainable_variables)

# 更新模型参数

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

print(f'Epoch {epoch + 1}, Loss: {loss.numpy()}')

代码解读与分析

深度学习模型定义

在代码中,我们定义了一个简单的深度神经网络模型QuantumOptimizationModel,包含两个隐藏层和一个输出层。输入数据经过两个隐藏层的非线性变换后,输出一个值作为量子门的旋转角度θ\thetaθ。

量子计算模拟

quantum_computation函数用于模拟量子计算。该函数接受一个旋转角度θ\thetaθ作为输入,创建一个单量子比特的量子电路,应用旋转门Rx(θ)R_x(\theta)Rx(θ),并进行测量。最后,计算测量结果的期望值。

训练过程

在训练过程中,我们使用随机输入数据来训练深度学习模型。模型预测出旋转角度θ\thetaθ,然后将其输入到量子计算模拟函数中,得到量子计算的期望值。我们将期望值与目标期望值进行比较,计算损失函数,并使用梯度下降法更新模型的参数。

通过不断重复上述过程,模型可以学习到如何选择合适的旋转角度θ\thetaθ,以使得量子计算的期望值接近目标期望值。

6. 实际应用场景

量子化学模拟

在量子化学中,需要计算分子的电子结构和化学反应过程。传统的计算方法在处理复杂分子时面临着计算量巨大的问题。基于深度学习的AI量子计算优化算法可以用于优化量子化学模拟中的量子电路,提高计算效率和准确性。通过学习分子的结构和性质,深度学习模型可以自动选择最优的量子门操作序列,从而更精确地模拟分子的电子结构和化学反应。

组合优化问题

组合优化问题是一类在实际应用中广泛存在的问题,如旅行商问题(TSP)、背包问题等。这些问题的求解通常需要在大量的可能解中寻找最优解,计算复杂度非常高。量子计算在解决组合优化问题上具有潜在的优势,基于深度学习的AI量子计算优化算法可以用于优化量子近似优化算法(QAOA),提高其在组合优化问题上的求解性能。深度学习模型可以学习问题的特征和结构,为QAOA提供更有效的初始参数和优化策略。

机器学习模型训练

在机器学习中,模型的训练通常需要大量的计算资源和时间。量子计算可以加速机器学习模型的训练过程,基于深度学习的AI量子计算优化算法可以用于优化量子机器学习算法,如量子支持向量机(QSVM)和量子神经网络(QNN)。深度学习模型可以学习数据的特征和分布,为量子机器学习算法提供更合适的量子态和量子门操作,从而提高模型的训练效率和性能。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville所著,是深度学习领域的经典教材,涵盖了深度学习的基本概念、算法和应用。

- 《量子计算与量子信息》(Quantum Computation and Quantum Information):由Michael A. Nielsen和Isaac L. Chuang所著,是量子计算领域的权威教材,详细介绍了量子计算的基本原理、算法和实验技术。

- 《量子机器学习》(Quantum Machine Learning):由Vedran Dunjko和Hans J. Briegel所著,介绍了量子计算与机器学习的结合,包括量子机器学习算法和应用。

7.1.2 在线课程

- Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授授课,系统地介绍了深度学习的基本概念、算法和应用。

- edX上的“量子计算基础”(Quantum Computing Fundamentals):由IBM提供,介绍了量子计算的基本原理、算法和实验技术。

- Udemy上的“量子机器学习实战”(Quantum Machine Learning in Practice):介绍了量子机器学习的基本概念、算法和应用,并通过实际案例进行演示。

7.1.3 技术博客和网站

- arXiv(https://arxiv.org/):是一个开放获取的预印本平台,包含了大量的量子计算、深度学习和相关领域的研究论文。

- Medium上的“量子计算”(Quantum Computing)和“深度学习”(Deep Learning)主题:有许多专业人士分享的关于量子计算和深度学习的技术文章和研究成果。

- Qiskit官方网站(https://qiskit.org/):提供了Qiskit量子计算框架的文档、教程和示例代码。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专业的Python集成开发环境(IDE),具有强大的代码编辑、调试和项目管理功能。

- Jupyter Notebook:是一个交互式的开发环境,适合进行数据分析、模型训练和实验验证。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言和插件扩展,可用于开发深度学习和量子计算项目。

7.2.2 调试和性能分析工具

- TensorBoard:是TensorFlow提供的可视化工具,可用于监控模型的训练过程、可视化模型结构和分析性能指标。

- Qiskit Aer:是Qiskit提供的量子计算模拟器,可用于模拟量子电路的运行和分析性能。

- Profiler:是Python内置的性能分析工具,可用于分析代码的运行时间和内存使用情况。

7.2.3 相关框架和库

- TensorFlow:是一个开源的深度学习框架,提供了丰富的工具和库,可用于构建和训练各种深度学习模型。

- PyTorch:是另一个流行的深度学习框架,具有动态图机制和简洁的API,适合进行研究和开发。

- Qiskit:是IBM开发的开源量子计算框架,提供了量子电路构建、模拟和实验的工具和库。

7.3 相关论文著作推荐

7.3.1 经典论文

- “A Fast Quantum Mechanical Algorithm for Database Search”(Lov Grover,1996):提出了Grover算法,是量子计算中著名的搜索算法,具有二次加速的优势。

- “Quantum Computing with Neural Networks”(G. M. Palma,et al.,1996):探讨了量子计算与神经网络的结合,为量子神经网络的研究奠定了基础。

- “Deep Learning”(Yoshua Bengio,et al.,2015):是深度学习领域的综述性论文,介绍了深度学习的发展历程、基本概念和应用。

7.3.2 最新研究成果

- “Quantum Machine Learning: What Quantum Computing Means to Data Mining”(Peter Wittek,2014):介绍了量子计算在数据挖掘和机器学习中的应用,探讨了量子机器学习的发展趋势和挑战。

- “Quantum Approximate Optimization Algorithm”(Edward Farhi,et al.,2014):提出了量子近似优化算法(QAOA),用于解决组合优化问题。

- “Deep Learning for Quantum Physics”(Guillaume Verdon,et al.,2017):探讨了深度学习在量子物理中的应用,包括量子态重构、量子控制和量子算法优化等方面。

7.3.3 应用案例分析

- “Quantum Machine Learning for Drug Discovery”(Matteo Tescari,et al.,2020):介绍了量子机器学习在药物发现中的应用,通过量子计算加速药物分子的筛选和设计。

- “Quantum Computing for Financial Optimization”(S. Woerner,et al.,2018):探讨了量子计算在金融优化中的应用,如投资组合优化和风险评估等。

- “Deep Learning in Quantum Chemistry”(Justin S. Smith,et al.,2017):介绍了深度学习在量子化学中的应用,通过深度学习模型预测分子的性质和反应活性。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 算法创新:未来,基于深度学习的AI量子计算优化算法将不断创新。研究人员将探索更多的深度学习模型和量子算法的结合方式,开发出更高效、更准确的优化算法。例如,结合强化学习和量子计算,实现自适应的量子电路优化。

- 硬件融合:随着量子计算硬件的不断发展,深度学习与量子计算的融合将更加紧密。未来的量子计算机可能会集成深度学习加速器,实现硬件级的协同计算,进一步提高计算效率。

- 跨领域应用:基于深度学习的AI量子计算优化算法将在更多领域得到应用。除了量子化学、组合优化和机器学习等领域,还将应用于金融、医疗、交通等领域,为解决复杂的实际问题提供新的思路和方法。

挑战

- 硬件限制:目前,量子计算硬件还面临着许多挑战,如量子比特的稳定性、噪声和误差等问题。这些问题会影响量子计算的准确性和可靠性,限制了基于深度学习的AI量子计算优化算法的应用。未来需要不断改进量子计算硬件技术,提高量子比特的质量和稳定性。

- 算法复杂度:深度学习模型和量子算法的结合会增加算法的复杂度,导致计算量和内存需求的增加。如何在有限的计算资源下实现高效的算法优化是一个亟待解决的问题。

- 理论基础:深度学习和量子计算的结合还处于发展阶段,相关的理论基础还不够完善。需要进一步深入研究量子力学和深度学习的基本原理,建立更加完善的理论框架,为算法的设计和优化提供理论支持。

9. 附录:常见问题与解答

问题1:深度学习和量子计算的结合有什么优势?

深度学习具有强大的非线性建模能力和数据处理能力,而量子计算具有强大的并行计算能力。两者的结合可以充分发挥各自的优势,提高计算效率和准确性。例如,深度学习可以用于优化量子电路和量子态,量子计算可以加速深度学习模型的训练过程。

问题2:基于深度学习的AI量子计算优化算法适用于所有的量子计算问题吗?

不是的。基于深度学习的AI量子计算优化算法适用于一些复杂的、需要优化的量子计算问题,如量子化学模拟、组合优化问题等。对于一些简单的量子计算问题,可能不需要使用深度学习进行优化。

问题3:如何评估基于深度学习的AI量子计算优化算法的性能?

可以使用多种指标来评估算法的性能,如保真度、计算时间、误差率等。保真度用于衡量量子态与目标态之间的接近程度,计算时间用于评估算法的效率,误差率用于评估算法的准确性。

问题4:在实际应用中,如何选择合适的深度学习模型和量子算法?

选择合适的深度学习模型和量子算法需要考虑问题的特点和需求。例如,如果问题具有较强的非线性特征,可以选择深度神经网络;如果问题需要处理序列数据,可以选择循环神经网络。对于量子算法,可以根据问题的类型选择合适的算法,如Grover算法用于搜索问题,Shor算法用于因式分解问题。

10. 扩展阅读 & 参考资料

扩展阅读

- 《量子计算:从基础到应用》

- 《深度学习实战》

- 《量子机器学习导论》

参考资料

- Nielsen, M. A., & Chuang, I. L. (2010). Quantum Computation and Quantum Information. Cambridge University Press.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- Dunjko, V., & Briegel, H. J. (2018). Quantum Machine Learning. Reviews of Modern Physics, 90(2), 025002.

更多推荐

已为社区贡献273条内容

已为社区贡献273条内容

所有评论(0)