Token级式检测能力技术实现细节说明

**摘要:**Token级流式检测技术成为大模型安全防护的关键突破,通过逐令牌实时分析解决传统批量检测的延迟问题。该技术依托实时信号检测、并行处理架构和上下文感知能力,有效防御提示词注入等新型攻击。业界实践(如阿里云AI安全护栏、火山引擎防火墙)显示其能实现毫秒级响应,攻击检出率达99%+。未来将向专用微模型、多模态检测等方向发展,为AI应用提供实时安全保障,平衡安全性与用户体验。(150字)

深入解析大模型应用防火墙的Token级流式检测能力:实时守护AI安全的技术利器

随着大模型应用的普及,提示词注入、数据泄露等新型攻击手段层出不穷。传统的安全检测模式已无法满足实时交互需求,Token级流式检测技术应运而生,成为保障AI应用安全的关键防线。

一、为什么需要Token级流式检测?

在传统安全防护中,通常需要等待大模型生成完整响应后再进行内容审核。然而,研究表明:

- 当响应时间超过1秒,就会打断用户的思维流

- 超过10秒,用户往往会切换任务

- 一个中等长度的响应可能需要10-30秒才能完全生成

这种“完整响应后检查”的模式严重影响了用户体验,无法满足实时交互需求。更严重的是,攻击者可以利用防御阈值衰减(DTD) 机制,通过构造“先良性、后恶意”的提示词,诱导模型在生成大量安全内容后输出有害信息。

Token级流式检测技术正是在这样的背景下诞生,实现了在模型生成每个Token的瞬间就完成安全分析,从根本上解决了延迟与安全的矛盾。

二、Token级流式检测的核心技术原理

1. 基础架构:实时拦截与分析

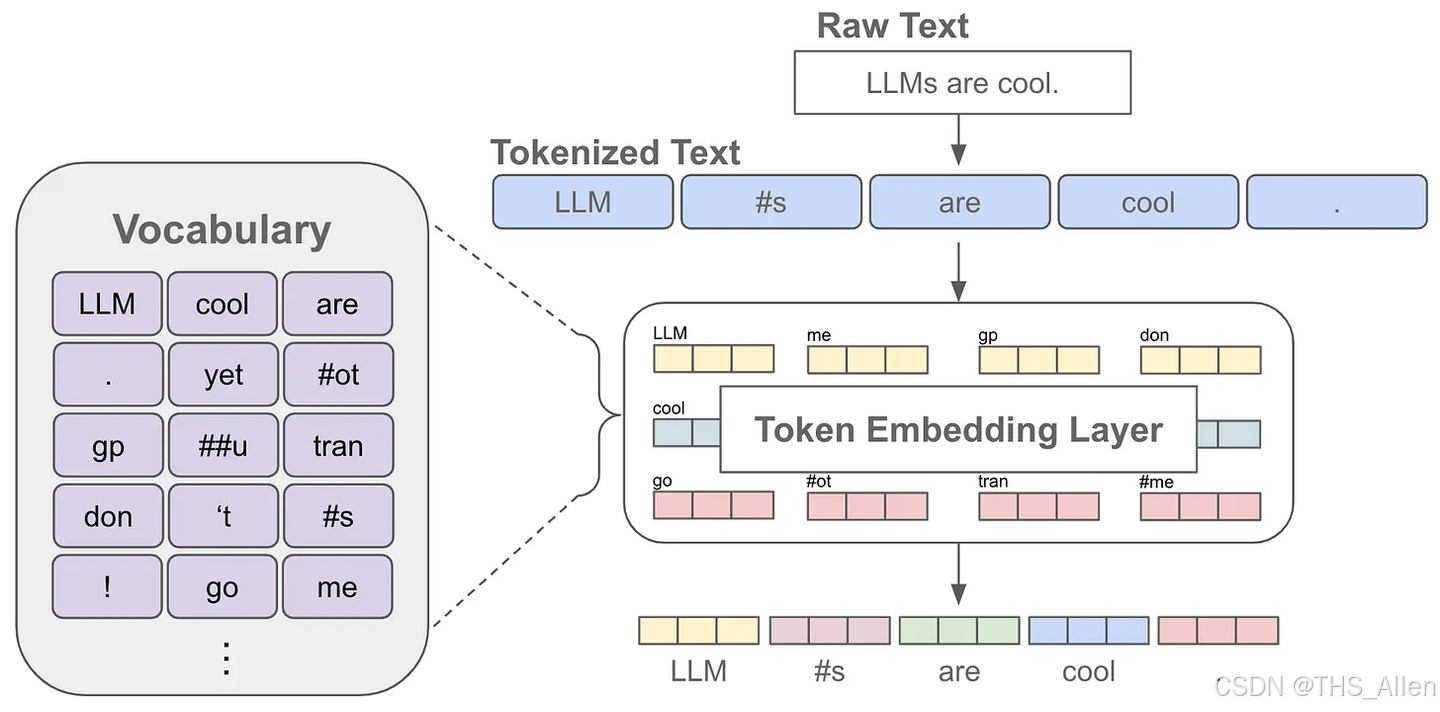

Token级流式检测的核心思想是逐令牌(token)进行实时分析和防护,而非等待完整响应。技术实现上主要包含三个关键组件:

- 实时信号检测:开发高效的检测算法,在毫秒级时间内分析单个生成的logits

- 并行处理架构:利用asyncio库实现并行处理,确保防护机制不会成为性能瓶颈

- 上下文感知:维持上下文感知能力,确保多令牌检测的准确性

2. 注意力机制与DTD防御

最新的研究表明,大模型在生成内容时存在防御阈值衰减(Defense Threshold Decay, DTD) 现象:

- 输入首尾注意力权重更高:模型对输入序列的首个和最后几个token分配显著更高的注意力权重

- 输入注意力随生成衰减:当生成内容达到512个token时,模型对输入的整体注意力权重下降,后半部分(尾部)从0.3骤降至接近0

- 生成内容注意力分布失衡:基尼系数从0.4升至0.8,表明模型越来越关注近期生成的token

针对DTD机制,研究人员提出了SCP(Sugar-Coated Poison)攻击,通过“语义反转”策略构造良性输入,诱导模型生成大量良性内容后无缝过渡到恶意输出,平均攻击成功率高达87.23%。

3. 流式检测的技术挑战与突破

实现高效的Token级流式检测需要解决几个关键技术挑战:

# 流式检测伪代码示例

async def stream_detection(token_stream):

risk_context = {} # 维持风险上下文

async for token in token_stream:

# 实时风险分析

risk_score = analyze_token_risk(token, risk_context)

if risk_score > threshold:

handle_risk(token, risk_context) # 立即处置风险

else:

yield token # 安全则放行

update_risk_model(risk_context) # 持续学习优化

- 准确性保障:通过实验验证逐令牌分析的准确性,确保防护效果不因流式处理而降低

- 延迟平衡:找到最优的检测频率,平衡延迟与安全性

- 长上下文感知:支持单轮问答、多轮问答等场景下的风险检测,通过融合历史对话信息,识别跨轮次诱导

三、业界实践与产品实现

1. 阿里云AI安全护栏

阿里云的解决方案体现了Token级流式检测的先进实践:

- 全链路流式审核:在模型逐段生成内容的过程中实时送检,显著降低从token生成到风险发现的延迟

- 智能双引擎:深度集成Qwen3-Guard与基于Qwen系列SFT的审核大模型,融合对抗检测与语义理解能力

- 动态性能优化:通过算法编排动态平衡精度、时延与成本

2. 火山引擎大模型应用防火墙

火山引擎通过轻量化架构实现了100ms内完成风险拦截,误判率较行业低一倍。其核心技术包括:

- 深度上下文引擎:可识别97%的隐式攻击

- 对抗样本训练:基于千万级对抗样本训练,覆盖20+提示词攻击场景,检出率达99%+

- 实时动态脱敏:对用户对话信息进行字段级加密,数据泄露风险降低98%

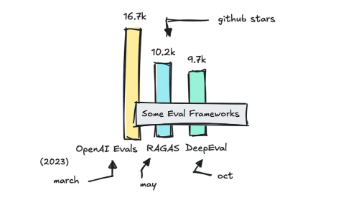

3. 开源方案LLM-Guard

LLM-Guard项目提供了开源的流式处理示例,展示了如何将防护层无缝集成到现有流式输出管道中。其核心贡献在于:

- 拦截每个到达的令牌并立即进行分析

- 维持上下文感知能力,确保多令牌检测的准确性

- 平衡延迟与安全性,找到最优的检测频率

四、技术对比与性能分析

| 技术指标 | 传统批量检测 | Token级流式检测 |

|---|---|---|

| 响应延迟 | 高(秒级) | 低(毫秒级) |

| 资源占用 | 集中式高负载 | 均衡分布 |

| 攻击拦截时机 | 事后处置 | 实时中断 |

| 用户体验 | 明显中断 | 近乎无感 |

| 复杂攻击识别 | 有限 | 基于上下文的深度识别 |

五、未来发展方向

Token级流式检测技术仍在快速发展中,未来趋势包括:

- 专用微模型(Micro-LLM)开发:专注于特定安全信号的超快速检测

- 混合架构设计:结合规则引擎与机器学习模型的优势

- 自适应检测阈值:根据应用场景动态调整严格程度

- 多模态流式检测:扩展至文本、图片、文件等模态的混合检测

结语

Token级流式检测技术代表了大模型安全防护的最新进展,它通过实时、细粒度的分析,在保障安全性的同时最大限度地维护了用户体验。随着SCP、GCG等新型攻击手段的不断演进,流式检测技术也需要持续创新,为企业级AI应用提供更加可靠的安全保障。

对于开发者而言,理解并合理应用Token级流式检测能力,已成为构建安全、可信AI应用的必备技能。这项技术不仅是大模型安全的防火墙,更是AI真正实现商业化落地的关键赋能器。

参考资料:

- 可攻可防,越狱成功率近90%!六大主流模型全中招 | EMNLP’25

- LLM-Guard项目中的流式输出安全防护技术解析

- Dify平台集成阿里云AI安全护栏,构建AI Runtime安全防线

- 火山引擎大模型应用防火墙发布 提供All in One安全防护能力

本文由技术博客原创,转载请注明出处。欢迎在评论区留言交流!

更多推荐

已为社区贡献61条内容

已为社区贡献61条内容

所有评论(0)