2025年SOC AI应用现状调研洞察:在告警洪流中寻找安全锚点

摘要:2025年,AI在SOC(安全运营中心)的渗透率达88%,成为应对日均近千条安全告警的“生存必需”。但现实困境凸显:40%告警因人力不足被搁置,61%团队曾遗漏关键威胁,AI落地面临高期望与低满意度、数据治理短板及人机权责失衡等矛盾。破局方向在于构建“人机协同”体系,明确AI辅助定位,分阶段落地,夯实数据基础,并培养“AI协同型”人才。未来SOC的竞争力取决于AI与流程、人才、数据的深度融合

当企业日均需处理近千条安全告警,而其中40%因人力不足被直接搁置,61%的团队曾在海量噪声中遗漏真正的入侵信号,AI已从SOC(安全运营中心)的“可选配置”转变为“生存必需”。2025年的行业调研数据显示,AI技术在SOC中的渗透率已达88%,但“部署即有效”的神话并未实现——在效率提升与落地困境的双重拉扯下,安全运营正经历一场深刻的智能化转型。

一、核心痛点:告警洪流与人力荒的致命绞杀

SOC的运营压力在2025年达到新高度,数据背后是安全团队难以承受的运营负荷,也成为AI技术加速渗透的直接推手。

1. 告警过载:40%信号石沉大海

根据SACR《2025年AI-SOC市场格局》报告,企业平均每天需处理约960条告警,大型企业更是要应对来自28种不同工具的日均3000余条告警。这些告警中混杂着大量误报——传统SIEM基于静态规则生成的告警,误报率常高达70%以上。在人力有限的情况下,40%的告警未经任何调查便被淹没,成为威胁潜伏的“暗区”。某金融机构SOC数据显示,其2024年漏报的3起数据泄露事件,均源于被搁置的“低优先级告警”。

2. 关键威胁遗漏:61%团队的共同伤疤

61%的安全团队承认曾忽视事后证实为关键的威胁,这一数据在制造业、零售业等传统行业中更是高达72%。根本原因在于传统运营模式的结构性缺陷:初级分析师耗费80%时间进行告警分诊,资深分析师被琐事拖累,难以开展深度威胁狩猎。Gartner调研发现,手工运营模式下,威胁平均检测周期长达22天,而攻击者往往能在72小时内完成数据窃取与撤离。

3. 人力缺口:技能断层加剧运营危机

安全人才短缺的问题在2025年进一步恶化。Gartner预测,到2028年,三分之一的SOC高级职位将空缺一年以上,而SANS《2024年SOC调查报告》显示,64%的组织将“缺乏熟练员工”列为运营最大障碍之一。更严峻的是,自动化工具的普及正在压缩初级分析师的成长空间——基础任务被AI接管后,新人难以获得实战经验,进一步加剧了高级人才断层。

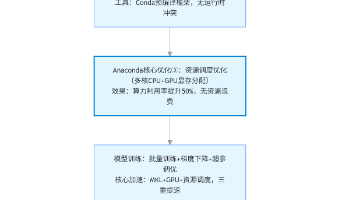

二、AI落地现状:从“试点尝鲜”到“规模化赋能”

2025年的SOC AI应用已从单一场景试点,演进为覆盖“检测-研判-响应-优化”全流程的能力体系,其中三大应用方向成效最为显著。

1. 告警分诊:AI成为“噪声过滤器”

告警降噪是AI在SOC中最成熟的应用场景。奇安信AISOC通过安全大模型与关联引擎双驱动,可自动识别1%的高价值告警,消除90%以上的告警噪声,使分析师从“淹没在告警中”转变为“聚焦关键威胁”。这类能力的核心在于AI对多源数据的关联分析——不仅能整合SIEM、EDR、NDR等工具的告警,还能结合威胁情报与资产重要性动态调整优先级。SANS调研显示,部署AI分诊系统的组织,分析师人均日处理告警量从150条降至32条,有效缓解了告警疲劳。

2. 自动调查与响应:将“天级处置”压缩至“分钟级”

AI正在重塑事件响应的效率边界。通过Agentic AI与思维链推理技术,现代SOC工具可自动完成线索搜集、攻击路径还原与影响面评估。例如,奇安信AISOC的“一键调查”功能,能将传统需1天完成的事件调查缩短至7分钟;Secureworks则通过AI编排引擎,实现了“检测-阻断-溯源”的自动化闭环,使分析师工作量减少50%。这类应用的关键突破在于AI对安全流程的深度理解——基于NIST应急响应框架训练的模型,能针对不同威胁类型推荐最优处置策略,甚至自动调用EDR、防火墙API执行遏制操作。

3. 生成式AI:赋能分析师“能力倍增”

生成式AI在2025年实现了从“辅助工具”到“核心伙伴”的跨越,其应用已渗透到SOC运营的细节场景:

- 人才培养:AI助理可实时解答新员工疑问,快速完成SIEM操作、威胁情报解读等基础培训,使新人上岗周期从3个月缩短至2周;

- 文档自动化:自动生成符合合规要求的事件报告,可根据受众调整内容深度——给管理层的摘要版、给技术团队的溯源版一键生成;

- 规则与脚本生成:分析师输入自然语言需求(如“检测异常RDP登录”),AI即可生成对应的SIEM规则或自动化脚本,降低对编码技能的依赖。

三、现实困境:AI赋能的“三重矛盾”

尽管成效显著,但2025年的SOC AI应用仍面临“理想与现实”的剧烈碰撞,三大矛盾制约着价值释放。

1. 高期望与低满意度的落差

企业对AI的期待与实际体验存在明显差距。SANS 2024年调研显示,AI/ML技术在SOC工具满意度排名中仍处于倒数位置,GPA得分远低于EDR/XDR。核心原因在于“功能夸大”与“效果不及预期”的错位:厂商宣称的“99%误报消除率”在复杂生产环境中常降至60%以下,而AI对0day攻击、文件less攻击等新型威胁的检测率不足30%。这种落差导致10.6%的组织放弃了AI扩展计划,较2023年的20.5%显著下降。

2. 数据治理的“基础短板”

AI的效能高度依赖数据质量,但67%的组织仍面临严重的数据治理问题。一是“数据孤岛”——不同厂商的安全设备输出格式各异,SIEM难以实现统一关联;二是“数据污染”——日志缺失、重复或错误导致AI模型训练偏差,误报率飙升;三是“合规限制”——金融、医疗等行业因数据隐私要求,无法将敏感日志用于AI训练,导致模型“营养不良”。某能源企业SOC负责人坦言:“我们花百万采购AI平台,却发现70%的日志无法用于分析,平台成了‘空转机器’。”

3. 自动化与人工的“权责失衡”

过度依赖自动化正在引发新的风险。部分组织将告警分诊、事件处置等核心环节完全交给AI,导致分析师逐渐丧失基础分析能力。Gartner警告,到2030年,75%的SOC团队将因过度依赖AI而面临基础安全技能下降。更危险的是“决策黑箱”问题——部分AI平台仅输出结论而不提供推理过程,分析师无法验证其准确性,可能导致误判关键威胁或误阻断正常业务。

四、破局方向:构建“人机协同”的AI SOC体系

2025年的行业实践证明,成功的AI SOC并非“用机器替代人”,而是构建“AI增强人类”的协同模式。调研显示,采用成熟人机协同策略的组织,威胁检测效率提升3倍,关键威胁遗漏率下降至12%。

1. 明确AI定位:“辅助者”而非“替代者”

Gartner的核心结论指出,永远不会有自主自治的SOC,AI的价值在于增强而非替代人。成熟的SOC会明确划分人机权责:AI负责重复性工作(如告警分诊、日志聚合、基础脚本生成),人类专注于创造性任务(如威胁狩猎、攻击溯源、策略优化)。例如,Netskope让AI处理防火墙规则编写等机械工作,分析师则聚焦于云环境的高级威胁分析,实现“1+1>2”的效能提升。

2. 分阶段落地:从“小场景”到“全流程”

避免“大而全”的建设误区,采用“小步快跑”的迭代模式是AI SOC成功的关键。安全牛调研显示,从单一精细场景(如勒索软件告警自动响应、员工异常行为分析)切入,可快速验证AI价值,增强团队信心。典型路径为:先通过告警分诊实现“降负荷”,再通过自动调查实现“提效率”,最后通过生成式AI实现“强能力”,每阶段设定可量化指标(如误报率降低35%、响应时间缩短60%),用数据证明价值以获取持续投入。

3. 夯实数据基础:建立“安全数据中台”

解决数据问题需从源头规划:一是明确数据需求,根据运营目标(如用户行为分析、云威胁检测)确定需采集的日志类型与字段;二是建立标准化体系,通过数据清洗、格式转换实现跨设备数据互通;三是保障合规安全,采用匿名化、脱敏等技术处理敏感数据,平衡AI训练需求与隐私保护。奇安信AISOC通过整合天眼、天擎EDR等内部工具数据,构建统一数据中台,为AI分析提供了高质量“燃料”。

4. 重构技能体系:培养“AI协同型”人才

应对技能断层需双管齐下:一方面,通过AI工具降低入门门槛——让初级分析师借助AI完成高级调查,在实践中积累经验;另一方面,加强现有团队培训,重点提升“AI模型监控”“自动化策略优化”“数据质量评估”等新兴技能。Gartner建议,SOC应设立“AI运营专员”岗位,负责模型调优、结果验证与流程迭代,成为人机协同的关键枢纽。

五、结语:AI SOC的“成熟度革命”

2025年的SOC AI应用,正从“技术驱动”转向“价值驱动”。40%的未处理告警与61%的威胁遗漏,既是痛点也是转型契机——它们推动企业放弃对“完美AI”的幻想,转而追求“适配自身的人机协同体系”。

未来的竞争差距,将不再取决于是否部署AI,而在于能否让AI与流程、人才、数据深度融合:当AI成为“不知疲倦的分诊员”“高效精准的调查员”“随叫随到的培训师”,当人类分析师成为“战略决策者”“威胁狩猎者”“规则制定者”,SOC才能真正突破告警洪流的桎梏,在复杂威胁环境中站稳脚跟。毕竟,安全运营的终极目标从来不是“零告警”,而是“零遗漏”——这需要AI的算力,更需要人类的智慧。

更多推荐

已为社区贡献252条内容

已为社区贡献252条内容

所有评论(0)